Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Все, что вы хотели знать о компонуемой инфраструктуре HPE Synergy, в вопросах и ответах |

Если понятие компонуемой инфраструктуры для вас в целом новое, рекомендуем ознакомиться с ним подробнее (например, на нашем сайте или скачав электронную книгу «HPE Synergy для начинающих»). К тому же, приглашаем посмотреть записи всех вебинаров, посвященных HPE Synergy. А теперь, собственно, вопросы и ответы с вебинаров:

1. Если нет потребности в 5 стойках (20 корзин), а достаточно 1 стойки (1-2 блэйд корзин), то есть ли смысл использовать HPE Synergy, особенно если в организации статичная инфраструктура, нет такого, что каждый день всё меняется?

Ответ: Synergy отлично подходит и для статичной, и для динамичной инфраструктур. Любая система в некоторой степени динамична – добавляются новые серверы, выводятся из эксплуатации старые. Две корзины – отличный пример для Synergy. Будет 2 мастер-модуля и 2 модуля-спутника. Даже одна корзина Synergy с 6-8 серверами – нормальное стартовое решение, вполне оправданное экономически. Для стоечных серверов мы также предлагаем систему управления на базе OneView. Ограничением по сравнению с Synergy/Blade будет невозможность настроить сетевые подключения (SAN и LAN).

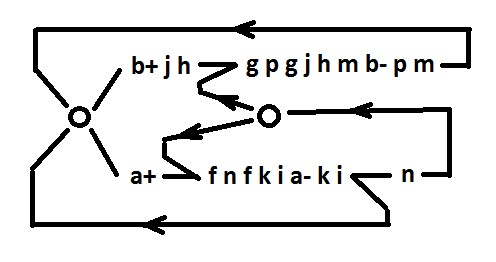

2. Для создания HCI на базе VMware vSAN на каждый серверный слот необходимо 2 выделенных порта 10GbE под трафик vSAN и vMotion. Возможно ли это в Synergy? Сколько сетевых портов на Вычислитель в корзине возможно в HPE Synergy, какие это порты?

Ответ: Если использовать одну пару коммутаторов или модулей Virtual Connect на корзину, то от каждого сервера будет идти по 2 порта 20 Гб/с. Каждый физический порт можно поделить на 4 виртуальных (4 физических функции) и для каждого задать его минимально гарантированную и максимально доступную пропускную способность, шаг 200 Мб/с. Выйти в сумме за 20 Гб/с по минимально гарантированной пропускной способности (МГПС) нельзя. То есть если вы хотите выдать и vSAN, и vMotion по 10 Гб/с МГПС, то это возможно, но больше свободной полосы на другие порты не останется. Если это обязательное условие, то необходимо ставить дополнительные коммутаторы в корзину. Если же будет достаточно, например, 4-5-6 Гб/с на каждый из этих видов трафика, то оставшуюся пропускную способность вы сможете выделить на сеть управления и на продуктивный трафик.

3. Если не предполагается использование внешней СХД, для создания виртуальных сред нужно использовать SDS (HPE StoreVirtual или VMware vSAN)?

Ответ: Если нужно общее дисковое хранилище, то да. Диски из дискового модуля в Synergy подключаются напрямую к выбранным серверам в эксклюзивное пользование.

4. Возможно ли установить в Synergy бездисковые лезвия?

Ответ: Да, можно не ставить диски в сервер. И можно выбрать модель сервера вообще без дискового бэкплейна.

5. По какому протоколу подключаются диски из дискового модуля D3940 к вычислителям (SAS, FC…)?

Ответ: По протоколу SAS с использованием коммутаторов SAS.

6. Подскажите сколько Virtual Connect мастеров можно объединить в IRF стек?

Ответ: IRF – это проприетарная технология для коммутаторов HPE Networking на базе ОС Comware. В VC используется протокол MLAG. Вышестоящие коммутаторы должны использовать протоколы IRF, vPC или аналог.

7. Что будет, если Virtual Connect мастер-модуль выйдет из строя?

Ответ: Каждый вычислитель (сервер) имеет 2 порта, которые подключены к разным мастер-модулям (ММ). Если один ММ вышел из строя, то коммутация и связь с «внешним миром» будет осуществляться через второй ММ.

8. Есть возможность подключить внутреннее хранилище одновременно к нескольким вычислителям?

Ответ: Диски в дисковых модулях можно распределить между всеми вычислителями в шасси, в котором стоит сам дисковый модуль. RAID-группы создает контроллер Smart Array, размещенный в каждом вычислителе. Один набор дисков в дисковом модуле может быть предоставлен только одному вычислителю.

9. Зачем в полностью компонуемой среде используется и 3PAR и StoreVirtual, последний же все равно будет располагаться на 3PAR?

Ответ: StoreVirtual VSA может располагаться на дисках в дисковых модулях самого шасси. Накладывать ограничения, запрещая подключение внешних массивов, смысла нет. Большинство компаний используют в своей ИТ-инфраструктуре внешние дисковые массивы. Пользователь сам вправе выбрать, по какому пути идти – SDS внутри Synergy или классические внешние массивы.

10. Почему сделали SAS хранилище? Почему не FC?

Ответ: Вопрос философский. SAS дешевле и универсальнее внутри корзины. FC или iSCSI может быть воссоздан, используя некоторые серверы, как контроллеры. Существующий пример – StoreVirtual VSA. Кроме того, FC требует использования коммутаторов сторонних производителей (Brocade, Cisco), что уменьшает гибкость общего решения.

11. Есть ли возможность использовать совместно диски NVME и SAS?

Ответ: Да, в варианте: NVMe – внутренние диски сервера, SAS – диски из дискового модуля.

12. Есть ли возможность расширения iSCSI фабрики за пределы стойки (логического шасси)

Ответ: Ограничений нет. Если логические шасси в подключены к одной сети, например, к коммутаторам ядра, трафик iSCSI можно пустить через внешнюю, с точки зрения логического шасси, сеть.

13. Если не планируются дисковые модули в шасси, SAS-коммутатор всё равно обязателен или можно занять слот чем-то другим?

Ответ: Если не планируются дисковые модули, SAS-коммутаторы совсем не нужны. Synergy – компонуемая архитектура. Можно брать только то, что нужно, и в том количестве, в котором нужно.

14. Правильно ли я понимаю, что на 1 сервер при полной нагрузке выходит 1 кВт электроэнергии?

Ответ: Нет. Энергопотребление можно проверить через сайзер для Synergy. Вычислитель Synergy – обычный сервер в своеобразном форм-факторе. Его энергопотребление не превышает потребление обычного сервера. Скорее всего, оно будет ниже за счет использования общих блоков питания для всей корзины, что повышает энергоэффективность решения в целом.

15. Можно ли изменить период в 4 минуты, в течение которых дисковый модуль может находится в открытом состоянии? То есть, если «перетянул»(случайно или намеренно), то шасси аварийно выключится?

Ответ: 4 минуты – гарантированное время, в течение которого дисковый модуль может быть открыт. Система выключится не через 4 минуты, а при достижении критической температуры внутри шасси. Поэтому поведение шасси будет зависеть не только от истечения 4 минут, но и от температуры в серверной, установленных в шасси модулей и т.д.

16. Диски из дискового модуля назначаются серверному профилю произвольно (разные места в дисковом модуле – модулях) или есть какая-то логика?

Ответ: По возможности, последовательно. Если после некоторого срока использования, станут свободны несмежные диски, то будут использованы они. Процесс можно сравнить с фрагментацией файловой системы. Вначале берутся последовательные блоки, со временем данные пишутся на свободные блоки, расположенные в разных местах диска.

17. При использовании дискового модуля с VSA, какие модули коммутации следует использовать? Обычно же для соединения серверов используются только коммутаторы Ethernet.

Ответ: HPE Virtual Connect SE 40Gb F8 Module или HPE Synergy 40Gb F8 Switch Module в качестве мастер-модулей. HPE Synergy 20G Interconnect Link Module или HPE Synergy 10Gb Interconnect Link Module, как модули-спутники. Для подключения дисков из дисковых модулей – HPE Synergy 12Gb SAS Connection Module.

18. Какое количество внутренних и внешних USB есть в вычислителе SY480?

Ответ: Один внешний и один внутренний USB 3.0

Цитата из QuickSpec:

Micro SDHC Slot – One (1) internal Micro Secure Digital High Capacity (Micro SDHC) card slot

USB 3.0 Port – One (1) internal USB 3.0 connector for USB flash media drive keys

NOTE: The above options are intended for integrated hypervisor virtualization environments.

USB 3.0 Port – One (1) external USB 3.0 connector for USB flash media drive keys

19. В каких сферах лучше применять Synergy? Например, есть ли смысл применять одно шасси Synergy в организации со стандартным набором сервисов: AD, DNS, 1C, СЭД и прочее? Или все-таки можно обойтись стандартными стоечными серверами?

Ответ: Сама архитектура Synergy спроектирована так, чтобы подходить под самый широкий круг задач, исключая узкоспециализированные. Например, для высокопроизводительных вычислений Synergy не будет хорошим выбором. Максимально раскрывается платформа при необходимости достаточно динамично перераспределять ресурсы под разнородные задачи. Однако для статических ландшафтов Synergy также отлично подходит. При использовании системы в связке с дисковым массивом 3PAR заказчик получает дополнительные преимущества за счет единой системы управления ИТ-инфраструктурой и полной автоматизации процесса развертывания ресурсов вычисления и хранения данных. С перечисленными в вопросе задачами Synergy отлично справится.

Но всегда стоит помнить об экономической целесообразности. Synergy оптимальна с финансовой точки зрения по сравнению со стоечными серверами, если заполнение шасси полное или почти полное. Также при сравнении со стоечными серверами надо учитывать особенности архитектуры, например, использование Ethernet 10/40 Гб/с и Fibre Channel 8/16 Гб/с. Перечисленные в вопросе сервисы, с большой вероятностью, не потребуют 12 серверов. Если же общее количество серверов составляет от 8 штук, и в дальнейшем планируется рост их количества, то стоит рассматривать Synergy, как основу вашей серверной инфраструктуры.

20. Возможно ли в Flex-20 получить Storage Network до 16Gb? И планируется ли возможность вывода Native FC 16Gb на порту с конвергентного коммутатора для Synergy?

Ответ: Нет. Модуль HPE Virtual Connect SE 40Gb F8 поддерживает только FC 8 Gb. Поддержка FC 16 Gb планируется в следующем поколении конвергентных модулей. Сейчас для подключения к сетям FC 16 Gb следует использовать либо модуль HPE Virtual Connect SE 16Gb FC, либо SAN коммутатор Brocade.

21. Планируются ли карты с Remote DMA (RoCE, iWARP)?

Ответ: Да, планируются. Во втором полугодии 2017 г.

22. Верно ли, что для того, чтобы все было идеологически правильно, нужно ставить как минимум 2 шасси? Это к вопросу использования резервируемых стримера и компоновщика.

Ответ: Для использования Раздатчика образов (Image Streamer) необходимо минимум 3 шасси для промышленной эксплуатации.

23. Где именно хранится созданный образ ОС?

Ответ: Золотые образы ОС и дельта-диски хранятся на внутренних дисках «Раздатчика образов» (Image Streamer). В Synergy «Раздатчики образов» устанавливаются парами. Библиотека образов синхронизируется между «Раздатчиками» для предотвращения потери данных при выходе одного из них из строя. Для синхронизации данных между «Раздатчиками» и создания снимков томов (дельта-дисков) используется функционал StoreVirtual, встроенный в «Раздатчик».

24. Есть ли запись семинаров, подробнее знакомящих с архитектурой HPE Synergy?

Ответ: Да, конечно. Записи вебинаров для технических специалистов доступны для просмотра on-demand после короткой регистрации:

• Часть 1. Обзор

• Часть 2. Инфраструктура управления

• Часть 3. Организация вычислений и хранения данных

• Часть 4. Сетевая инфраструктура

• Часть 5. Модуль доставки образов ОС – Image Streamer

Если же после этих FAQ и просмотра вебинаров у вас останутся вопросы по компонуемой инфраструктуре HPE Synergy, ждем их в комментариях!

|

Метки: author tonyafilonenko it- инфраструктура блог компании hewlett packard enterprise hpe hpe synergy вебинар компонуемая инфраструктура composable infrastructure |

Зачем нужен Kubernetes и почему он больше, чем PaaS? |

В большой production пришёл не только Docker, но и Kubernetes. И если даже с контейнерами далеко не всегда всё достаточно просто, то уж «кормчий» и подавно остаётся за гранью правильного понимания среди многих системных администраторов, DevOps-инженеров, разработчиков. В этой небольшой статье предпринята попытка ответить на один из вечных вопросов (в контексте Kubernetes) с помощью наглядного объяснения идеи и особенностей данного проекта. Возможно, именно этого вам не хватало для того, чтобы начать плотное знакомство с Kubernetes или даже его эксплуатацию?

Соучредитель и архитектор крупного онлайн-сервиса Box (около 1400 сотрудников) Sam Ghods в своём прошлогоднем выступлении на KubeCon указал на типовую ошибку восприятия Kubernetes. Многие рассматривают этот продукт как очередной фреймворк для оркестровки контейнеров. Но если бы всё действительно было так, то зачем его разработчики неустанно напоминают про «корни Kubernetes API, уходящие в архитектуру*, создаваемую более 10 лет в рамках проекта Google Borg»?..

Google Borg — это менеджер кластеров, предназначенный для параллельного запуска тысяч задач, распределённых по тысячам приложений, запускаемых на многочисленных кластерах. Именно эту архитектуру и унаследовал Kubernetes, перенося кластерные идеи на современную почву контейнеров. Чем же это отличается от многочисленных облачных платформ, существующих сегодня? Начнём с самого понятия платформы.

* Архитектура Kubernetes создана таким образом, что позволяет расширять эту платформу, но разработчиков при этом просят следовать основополагающим принципам.

Kubernetes как платформа

Архитектор Box даёт такой вариант определения: «Платформа предоставляет уровень абстракции, забирающий у вас какую-либо проблему, чтобы вы могли творить поверх неё [не думая о ней]». Примеры: платформа Linux даёт возможность исполнять системные вызовы вне зависимости от аппаратного обеспечения компьютера, а платформа Java — исполнять приложения вне зависимости от операционной системы. Какова же должна быть платформа для запуска приложений, созданных по принципам микросервисной архитектуры?

Ключевые характеристики такой платформы — портируемость и расширяемость. Каждая облачная платформа предлагает свои варианты для достижения этих целей. Например, для автоматического масштабирования у AWS имеются Auto Scaling Groups, у Google Cloud Platform — Autoscaler, у Microsoft Azure — Scale Set, у OpenStack — autoscaling API в Heat. Всё это само по себе неплохо, т.к. потребности выполняются, однако у конечного пользователя начинаются сложности. Чтобы разместить приложение, для каждого сервисного провайдера необходимо поддерживать его механизмы: добавлять поддержку API, учитывать специфику работы используемой реализации и т.п. Вдобавок, всем этим решениям не хватает системы обнаружения сервисов для по-настоящему удобного и автоматизированного развёртывания микросервисов. А если вам нужно быть гибким и иметь возможность размещать приложения в разных окружениях (в публичном облаке, в своём дата-центре, на серверах клиента…)?

В этом заключается первый плюс и суть Kubernetes как платформы, то есть по-настоящему универсальной системы для развёртывания приложений, физическое размещение которых может производиться где и как угодно: на голом железе, в публичных или частных облаках вне зависимости от их разработчиков и специфичных API. Но здорово в Kubernetes не только то, где запускать, но и что: ведь это могут приложения на разных языках и под разные ОС, они могут быть stateless и stateful. Поддерживается принцип «если приложение может запускаться в контейнере, оно должно отлично запускаться в Kubernetes».

Предназначение Kubernetes как платформы — предоставить базовую, абстрактную платформу как услугу (Platform as a Service, PaaS), сохранив гибкость в выборе конкретных компонентов этой PaaS.

Kubernetes и PaaS

О том, что Kubernetes не является традиционной PaaS, рассказывается в документации проекта, где поясняется, что авторы стремятся сохранить возможность пользовательского выбора в местах, где это важно. В частности, поэтому:

- Kubernetes не предлагает никаких встроенных служб для обмена сообщениями, обработки данных, СУБД и т.п.

- Kubernetes не имеет своего магазина с готовыми сервисами для деплоя в один клик.

- Kubernetes не деплоит исходный код и не собирает приложения. Процессы непрерывной интеграции (CI) поддерживаются, но их реализация оставлена для других инструментов.

- Аналогично для систем журналирования и мониторинга.

Таким образом, если в PaaS обычно делается акцент на предоставление функциональных возможностей, то в Kubernetes первичен универсальный, абстрактный подход. Несмотря на то, что Kubernetes предлагает ряд функций, которые традиционно присущи PaaS: развёртывание приложений, масштабирование, балансировка нагрузок, журналирование и т.п., — платформа является модульной и предлагает пользователям самим выбирать конкретные решения для тех или иных задач. Такой подход сделал Kubernetes базой для таких PaaS, как OpenShift от Red Hat и Deis.

Заключение

Kubernetes следует принципу, к которому обычно (впрочем, не всегда) стремятся в стандартах. Его хорошо проиллюстрировал Бьёрн Страуструп в своей классической книге «The C++ Programming Language»:

Что должно быть в стандартной библиотеке C++? Идеалом для программиста является возможность найти каждый интересный, значимый и разумно обобщённый класс, функцию, шаблон и т.п. в библиотеке. Однако вопрос не в том, «что должно быть в какой-то библиотеке», а в том, «что должно быть в стандартной библиотеке». И ответ «Всё!» — первое разумное приближение к ответу на первый вопрос, но не последний. Стандартная библиотека — то, что должен предоставлять каждый автор и делать это так, чтобы каждый программист мог на это положиться [т.е. действительно нуждался в этом — прим. перев.].

Применительно к Kubernetes можно сказать, что эта система — фундамент, та самая «стандартная библиотека» для построения PaaS и других подобных решений.

P.S. Если хотите разобраться в техническом устройстве и практике применения Kubernetes — смотрите видео из моего недавнего доклада «Наш опыт с Kubernetes в небольших проектах». Для более подробного и глубокого погружения мы готовим цикл статей по Kubernetes — подписывайтесь на хаб и ожидайте их уже в ближайшее время.

|

Метки: author distol анализ и проектирование систем open source it- стандарты блог компании флант kubernetes devops облачные сервисы микросервисы контейнеры paas |

«База знаний»: 100 практических материалов по безопасности, экономике и инструментарию IaaS |

/ фото Leonardo Rizzi CC

/ фото Leonardo Rizzi CCИнформационная безопасность

- Как не стать жертвой и защититься от трояна-шифровальщика WannaCry

- Как тестировать безопасности облачных решений и устранять проблемы

- На что обратить внимание при выборе услуги облачного PCI DSS хостинга

- Построение аттестуемых и защищенных инфраструктур на базе решений VMware

- VMware NSX: новый подход к обеспечению безопасности в области здравоохранения

- ТОП-12 угроз облачной безопасности по версии Cloud Security Alliance

- Как повысить уровень защищенности облачной инфраструктуры

- Как мы сертифицировали IaaS-облако по стандарту PCI DSS. Часть 1

- Как мы сертифицировали IaaS-облако по стандарту PCI DSS. Часть 2

- Как решить проблемы идентификации и доступа к веб-приложениям в облаке IaaS

- Облачные сервисы для бизнеса и защита от DDoS

- Облачная безопасность: самое интересное из отчета Spotlight Report

- Palo Alto Networks серии VM и VMware NSX: динамические политики безопасности

- Как защитить облачный ЦОД с помощью Palo Alto Networks VM-Series

- Как «ИТ-ГРАД» сертифицировал свое облако по стандарту PCI DSS

Процессы и экономика

- 7 нюансов облачных SLA: на что стоит обратить внимание

- Как мы проходили аудит Cisco Powered Cloud для IaaS-услуг

- Облачные сервисы: опыт использования IaaS российскими компаниями

- Подводные камни при сертификации по PCI DSS: CVV и запись телефонных разговоров

- Технико-экономическое обоснование использования IaaS на примере крупной компании

- Страхование облачных рисков с «ИТ-ГРАД» и AIG

- Облака и виртуализация в электронной коммерции

- Книга для тех, кто впервые сталкивается с облаками и понятием IaaS

- Книга: Экономическое обоснование миграции в облако для модели IaaS

- Сертификация PCI DSS: часто задаваемые вопросы

Сети и железо

- Все, что нужно знать о vCloud Networks: типы сетей в vCloud Director

- Как создать безопасное подключение между двумя организациями: vCloud Director

- Cisco ACI: новая модель организации работы для приложений ЦОД

- IaaS на практике (часть 1): работа с каталогом и сетью

- vCloud Availability: глубокое погружение в репликацию трафика

- DPI на службе облака

- vCloud Connector: гибридное облако на практике

- Функциональные возможности и настройка VMware vShield Edge

- Как устроено облако VMware: сети и сетевая связанность

- Подключение к корпоративному облаку

- Unboxing all-flash СХД NetApp AFF A300: технические характеристики и взгляд изнутри

- Самое интересное из серии тренингов о технологиях NetApp в «ИТ-ГРАДе»

- Unboxing серверов Cisco UCS M4308

- ЦОД DataSpace занял первое место в рейтинге доступности сертифицированных ЦОД

- ЦОД IaaS-провайдера: облачная платформа «ИТ-ГРАД» в SDN

Практические кейсы

- Как облако IaaS помогает предсказывать землетрясения

- Как применить IaaS для реализации международного проекта: Аэропорт Пулково

- ГК «КарОператор» использует IaaS для реализации проекта НБДА

- Первый российский проект c сертифицированным IaaS и управляемыми сервисами

- Новый оператор каршеринга BelkaCar использует облако IaaS

- Как IaaS подарил новую жизнь популярной игре Angry Birds

- Как DreamWorks решила проблему обработки больших объемов данных

- Первая российская BaaS-платформа Scorocode разместилась в IaaS-облаке

- Как облака в моделях IaaS и SaaS помогают разработчику YotaPhone

- Как применяли IaaS на Олимпийских играх 2016 года

- Российский облачный сервис eZWay открывает новый путь к вождению автомобиля

- Концерн «DMI Дятьково» разместил систему управления продажами в IaaS-облаке

- Использование IaaS компанией Zed Russia для предоставления мобильного контента

- SaaS-решения по управлению документооборотом «Андок» размещены в облаке IaaS-провайдера

- Сеть универсамов «АБК»: опыт использования облака IaaS

- Облако для тех, кто знает об облаках не понаслышке: IaaS для S7 Airlines

- Облачный кинотеатр: миграция инфраструктуры NETFLIX на IaaS

- Как облако IaaS помогает в организации сервиса по заказу доставки еды

- «Терра-авто»: 5 лет безупречного использования облака IaaS

- IaaS и Colocation для сети автосалонов

- Как облачные технологии нашли свое применение в автомобильном бизнесе Tata Motors

- Использование IaaS облачным провайдером для предоставления SaaS-сервиса

- PickPoint — первая в России сеть постаматов: 5 лет в облаке IaaS

- Как «Речевые технологии» работают из облака IaaS-провайдера

- Как Hotels.ru применил в работе IaaS

- Как облако становится стандартом размещения аудиоконтента

- Почему облако станет стандартом будущего в мире спорта

- Как облачная система проверки правописания находит применение в жизни

- Облачные технологии для решения задач в строительном бизнесе

- Технологии хранения в страховой сфере

Производительность

- Как справиться с пиковыми нагрузками при помощи IaaS

- Решение распространенных проблем в облаке IaaS на базе гипервизора VMware

- Оптимизация производительности в vSphere: решение основных проблем с CPU

- Сайзинг терминального сервера при развертывании в облаке IaaS-провайдера

- SSD-кеширование в облаке VMware

Аналитика и тренды

- Как использовать облака, не нарушая законы Российской Федерации

- Облачные технологии и российское законодательство: что нужно знать

- Производители оборудования и IaaS: гонка за облачным трендом

- Как облако IaaS влияет на развитие новых трендов

- Особенности выбора между частным, публичным и гибридным облаком

- ИТ-прогноз-2017: обзор ключевых технологий, которые ожидает значительный рост

- Тонкости облачного ERP-хостинга: как cloud-based-модель находит применение в бизнесе

- X-as-a-services: как не погрязнуть в аббревиатурах облачных услуг

- Отказ от on-premises-инсталляций в пользу облачных и гибридных решений

- По следам Enabling The Digital Enterprise: анонсы продуктов и технологий VMware

- Как облака и виртуализация влияют на трансформацию ЦОД

- Улучшение дизайна сервиса в модели IaaS

- Контейнеры или виртуальные машины — что лучше выбрать

- IaaS и SaaS для малых, средних и крупных организаций

- Восстановление как сервис: особенности услуги RaaS

Специализированные решения

- Тонкости импорта vApp в vCloud Director

- vCloud Director 8.10: для чего нужны Virtual Machine Affinity Rules

- Знакомство с vCloud Director 8.10: обзор функциональных изменений

- Три причины, почему использовать VMware vSphere 6.0 по-прежнему актуально

- Stretch Deploy для vCloud Connector: функциональные особенности и принцип работы

- Сравнение четырех топ-решений для аварийного восстановления

- Новая функциональность Commvault v11 для резервного копирования в облако

- Commvault v11: особенности резервного копирования в облако

- Облако IaaS в условиях гиперконвергированной инфраструктуры

- Обзор VM-инструментов VMware: разбираемся в особенностях

|

Метки: author it_man информационная безопасность блог компании ит-град ит-град iaas мегадайджест iaas- кейсы |

Платформа ServiceNow: Искусственный интеллект автоматизирует рабочие процессы |

Изображение Matthew Hurst CC

Изображение Matthew Hurst CCФункции искусственного интеллекта будут предоставляться с помощью грядущей платформы Intelligent Automation Engine, которую компания анонсировала на конференции Knowledge. По словам представителей компании, это решение укрепит позиции ServiceNow на рынке управления IT-сервисами и откроет путь к другим частям корпоративной сферы.

«Сферы обслуживания клиентов и управления персоналом хорошо поддаются автоматизации, — отмечает технический директор ServiceNow Аллан Лейнволд. — Но бизнес тратит большое количество времени на решение типовых, рутинных задач, например на запросы информации об отгулах к отделу кадров».

Алгоритмы Intelligent Automation Engine основаны на решениях компании DxContinuum, приобретенной ServiceNow и занимающейся разработкой технологий машинного обучения.

Новые сервисы будут направлены на решение следующих задач:

- Предотвращение простоев. Благодаря технологии выявления аномалий решение Intelligent Automation Engine определяет паттерны, которые с высокой долей вероятности ведут к простоям. Эта функция появится на платформе ServiceNow Jakarta, которая будет выпущена в конце года.

- Классификация и отслеживание работ. Функция будет классифицировать задачи, выбирать оптимальные методы их решения и прогнозировать вероятные результаты. Также появятся функции предсказательной аналитики.

- Прогнозирование эффективности. Алгоритмы будут работать с приложениями Performance Analytics от ServiceNow, способными отслеживать статистику в реальном времени. Они помогут компаниям определять момент достижения заданных уровней эффективности (например, времени ответа службой поддержки).

Помимо новых функций, которые появятся в нынешнем году, ServiceNow объявила о реализации возможности сравнительной оценки производительности в приложении Benchmarks. Для этого ServiceNow использует данные, предоставляемые клиентами на анонимной основе.

ServiceNow за последний год приобрела и несколько других компаний (помимо DxContinuum), включая поставщика средств IT-безопасности BrightPoint Security и компанию, занимающуюся разработкой инструментов для управления облаком ITapp.

«Покупая компанию, мы первым делом переписываем ее продукты под свою платформу, — рассказывает директор по стратегии ServiceNow Дэйв Райт (Dave Wright). — Такой подход исключает неразбериху с ворохом плохо интегрированных продуктов».

В компании надеются, что новые технологии и машинное обучение помогут владельцам организаций справиться с рабочей нагрузкой и постоянным ростом объемов данных, обрабатываемых облачными приложениями, а также автоматизировать рутинные задачи.

Пара наших хабрадайджестов:

- Знакомство с ServiceNow и управлением ИТ-инфраструктурой

- Немного о ServiceNow, ITSM и ServiceDesk в формате подборки полезных материалов

|

Метки: author it-guild help desk software блог компании ит гильдия ит гильдия servicenow |

Spark-in.me. Часть 4 — Базовое админство для обычных человеков |

У слова backup есть несколько значений, как и у других похожих слов, например setup — это еще и «прикид», а не только набор настроек, устройств и еще бог весть чего.

- Spark-in.me. Часть 1 — Зачем и почему?

- Spark-in.me. Часть 2 — Архитектура приложения и структура БД

- Spark-in.me. Часть 3 — DIY поддержка и админство сайта

- Spark-in.me. Часть 4 — Базовое админство для обычных человеков

- Spark-in.me. Часть 5 — Переход на HTTPS

- Spark-in.me. Часть 6 — Исходный код и настройка бекенда

- Spark-in.me. Часть 7 — Исходный код и настройка фронтенда

Бекап — это своего рода снимок или слепок вашей системы в некоторый момент времени, который позволяет в случае возникновения над вами купола сияющего медного таза вернуть все к тому состоянию, которое запомнил бекап. Обычно это то желанное состояние, в котором все хорошо и тазиков не предвидится.

Сами медные тазики бывают разными. Тазики, которые накрывают вас не по вашей воле или из-за вашей тупой ошибки, материализуясь прямо из воздуха; тазики, которые бренчат где-то, не пойми где, а потом вы дергаете ручку кладовки, в которую не заходили давно, и они засыпают вас с ног до головы, попутно оставляя добротные синяки — это далеко не полная классификация, но это самые отстойные из них. Второй вид отстойнее, потому что может оказаться, что копиться тазы начали сильно давно, и даже логи не помнят эти времена, не то что бекапы. И нельзя не только сдуть всю эту тазобратию одной командой, но и после ручного перетаскивания сияющего великолепия на помойку придется искать его источник и чинить. Ну или искать источник сначала, а потом уже таскать, — в зависимости от скорости генерации тазов в кладовке или предпочтений.

Купаться в тазиках можно по-разному...

Я уже успела упомянуть логи. Логи — это такие летописи всякой ерунды, происходящей в вашей системе. Ведут эти летописи как сама система, так и разного рода приложения. Приложения могут писать в отдельные файлы, а могут и в системные. Зачем нужны логи? Логи позволяют «найти все» — найти ошибку и подробности ее возникновения, что здорово помогает затем ее локализовать и устранить. Логи незаменимы, когда ошибку трудно воспроизвести и кажется, что условием возникновения ошибки является святой рандом. Есть целые энтерпрайз решения для хранения, структуризации и анализа логов it-систем, и, надо сказать, это очень удобно, здорово и дорого.

Бекапы бд Postgres

Данные, особенно если их собирали долго и упорно — с каждого клиента и его заказа, или из открытых источников при помощи чьих-то глаз и рук, парсинга и последующей чистки, терять очень больно. Данные — это информация, это клиенты, это месяцы и даже годы работы, это закономерности — скрытые или уже найденные. Всякий админ, даже не понимая всю значимость данных, имеет все-таки представление об этом и чахнет над базой словно царь Кащей над златом.

Мы не админы, мы обычные человеки, которые поставили себе прекрасную СУБД. Но данные терять не хотим и не хотим предоставить воле случая возможность испепелить наше детище. Что же делать? Настраивать бекапы и логи, конечно же. В самом простом и неказистом виде.

Расскажу, как делаю я. Как вы понимаете, правильнее открыть документацию, прочитать пару статей и сделать выбор. Но можно обойтись и так. Потом можно осознать, что вам нужно что-то другое, что у этого подхода есть свои минусы и перейти на что-то более соответсвующее именно вам.

Положим, я создала в кластере две базы данных. Я делаю бекап каждой из них и складываю бекапы в папку, папку называю текущей датой. Делается это так:

TIME=`date '+%m-%d-%Y'`

mkdir -p /path/to-your-db-backups/$TIME

pg_dump mydb1 > /path/to-your-db-backups/$TIME/mydb1.sql

pg_dump mydb2 > /path/to-your-db-backups/$TIME/mydb2.sql

Если у вас бекапы хранятся на отдельном диске, на котором рейд массив, это приемлемо. В противном случае бекапы лучше утащить куда-нибудь в более стабильное место. Если у вас есть такое стабильное место (например, отдельная помойка или сервер, на котором ничего потенциально деструктивного не происходит, потому что там торчит необновляющийся контент вашего древнего сайта) и туда есть доступ по ssh, то лучше перенести бекапы туда. Иначе тазик накроет вместе с системой и ваши бекапы тоже, и вы ничего не спасете.

Чтобы делать это автоматически, лучше настроить ssh без пассфразы (кому интересно, почитайте про Алису и Боба и RSA, стандартная штука). Хороший и простой гайд, который я периодически навещаю, — тут. Нужно только определиться, где вы будете выполнять скрипт бекапа. Делать это можно как на системе, которую вы бекапите, так и на системе, в которую вы складываете бекап. Для переноса файлов используйте secure copy — scp. После переноса не забудьте удалить файл из системы, которую бекапили, чтобы не захламлять. И будьте осторожны с удалением.

Вот пример скрипта, который бекапит одну из наших удаленных баз. Скрипт запускается по крону на домашнем сервере, выполняя ssh-команды на удаленном сервере.

TIME=`date '+%m-%d-%Y'`

mkdir -p /path/to/your/backups/local/backup-$TIME

ssh sshuser@remote "pg_dump mydb > /etc/postgresql/x.y/backups/backup-$TIME.sql"

scp sshuser@remote:/etc/postgresql/x.y/backups/backup-$TIME.sql /path/to/you/backups/local/backup-$TIME

sleep 2m

ssh rsshuser@remote "rm /etc/postgresql/x.y/backups/backup-$TIME.sql"

Вот пример скрипта, который бекапит одну из наших систем целиком. Скрипт запускается по крону на домашнем сервере, выполняя ssh-команды на удаленном сервере.

#START

# This Command will add date in Backup File Name.

TIME=`date +%b-%d-%y`

# Here i define Backup file name format.

FILENAME=some-system-backup-$TIME.tar.gz

# Backed up folder (system root) location

SRCDIR=/

# Destination of backup file

DESDIR=/home/backups

# exclude folder list

EXCLUDE='--exclude /home/backups --exclude=/another'

# Do not include files on a different filesystem

ONEFSYSPARAM='--one-file-system'

ssh sshuser@remote "tar -cpzf $DESDIR/$FILENAME $EXCLUDE $ONEFSYSPARAM $SRCDIR"

scp sshuser@remote:$DESDIR/$FILENAME /place/backup/here/

ssh sshuser@remote "echo 'WHOLE_SYSTEM_BACKUP is successful: $(date)' >> /home/bash-scripts/cron_log.log"

ssh sshuser@remote "rm $DESDIR/$FILENAME"

#ENDНемного о выборе системы, на которой выполнять скрипт. Я предпочитаю использовать систему, которая хранит бекапы. Во-первых, вы настроите порядок всех бекапов в кроне так, чтобы процессы не мешали друг другу (а системные бекапы жрут много и выполняются долго). Во-вторых, обязательно настраивайте ssh так, чтобы в случае, если система перестанет вам принадлежать, у нее не было безпарольного доступа на ваши сервера. То есть, если помойка всегда будет вашей, настройте безпарольный доступ с нее на условно чужую систему (арендованный сервер), не наоборот.

Ну и наконец не забывайте о порядке. Лучше всего делать бекапы автоматически и так же автоматически их удалять. Закиньте скрипты в крон (crontab -e). Храните не один последний бекап, храните несколько. Пример команды для автоматической чистки, которая удаляет все кроме последних 4 файлов в директории (настоятельно рекомендую прочесть, почему не надо парсить ответ ls и почему эта команда не подходит для бекапов с названиями, содержащими пробел):

DIR=/path/to-your-backups/somesystem/somedate

ls -dt $DIR/* | tail -n +5 | xargs rm -r --

И, конечно же, не забывайте просматривать свои бекапы вручную время от времени. Они могут перестать создаваться — смотрите на даты. Заглядывайте в папки на предмет отсутсвия содержимого. Еще рекомендую чекать размер бекапов. Если бекап три дня назад весил 14 гб, а сегодня 9 гб, при этом вы не помните масштабной чистки в системе, это повод задуматься. Если бекап маленький, можно даже заглянуть внутрь архива.

Разворачиваем бекапы

Я ни разу не восстанавливала систему из архива файлов, не пробовала. Знаю только, что для этого нужен загрузочный диск и физический доступ к серверу) Тут я ничего особо не смогу рассказать. Вероятно, cтоит как-нибудь научиться этому на примере распберри. Статьи, обязательные к прочтению, на эту тему — раз, два, три.

Сервер мы бекапим как раз созданием архива файлов, исключая из него совсем ненужные (файлы помойки, к примеру). Про параметры можно подробно прочесть документацию.

tar -cpzf /destination/directory/filename --exclude /exclude/directory1 --exclude /exclude/directory2 --one-file-system /source/directoryМне эти бекапы нужны в одном случае — когда мои бекапы (то есть бекапы базы данных) утеряны или не существовали никогда (было такое).

Обычные sql дампы разворачиваются очень легко. Надо заметить, что сначала нужно дропнуть остатки старой базы, чтобы не возникло конфликтов. Затем создать ее заново и развернуть в нее дамп:

psql mydb1 < /path/to-your-db-backup/mydb1.sqlЧто касается разворачивания базы из архива, то это можно сделать, надо лишь учесть несколько нюансов. Восстановите данные из /var/lib/postgresql, а настройки из /etc/postgresql (если ваши директории нестандартные — восстанавливайте оттуда). Если настройки утеряны — восстановите вручную, по сути, просто нужно поправить конфиг. Юзеров в моем случае приходится пересоздавать. Все файлы должны иметь соответсвующие настройки доступа (chmod в помощь) и оунером, конечно же, должен быть юзер postgres (поможет команда chown).

Логирование в postgres

Как я уже успела заметить, логирование — это полезно. Поэтому иметь логи бд не помешает.

В постгрес логи настраиваются очень просто, через postgresql.conf в разделе error reporting and logging. Вам просто нужно задать удобные для вас настройки. Лучше всего в таком случае открыть документацию и выбрать нужные настройки. Рекомендую настроить логи по дням, хранить неделю (в документации есть пример того, как это сделать), а дальше в зависмости от уровня паранойи и уровня загрузки базы: можно логировать любые входы, любые запросы, а можно логировать только запросы, которые выполняются долго. Еще можно логировать дедлоки (почитайте про взаимные блокировки). Такие штуки постгрес разруливает сам, но в общем, не забывайте про их существование.

Ну вот и все. Можно еще рассказать немного про юзеров, о том, как их настроить, чтобы не ломали в общем случае ничего. Ну и убийство зомби-коннектов.

Создать пользователя — минимум прав и чтение базы

Рано или поздно нужно делиться данными и работой с ними с кем-то еще. Приходится создавать новых пользователей в базе (никогда не шарьте одного и того же юзера на всех, потом не узнаете, кто это грохнул все и почему. Один человек = 1 или больше юзеров, 1 юзер = 1 человек). Есть много хороших статей, которые расскажут вам, как все сделать по канону. С группами, наследованием ролей, доступом в конкретную схему или конкретные таблицы. Все это можно сделать, если нужно.

Я расскажу про самый простой вариант, когда мы выдаем доступ на чтение пользователю и ограничиваем его так, чтобы не возникло кошмара. Для этого создаем пользователя без прав создания баз данных, ролей и т.д., ограничиваем количество коннектов к базе, которые он может создать, ограничиваем его по времени выполнения запроса (чтобы он не гонял запросы, которые выполняются по полчаса и роняют базу).

create role somerole nocreaterole nocreateuser nocreatedb noinherit login noreplication connection limit 5 password 'somepassword';

alter role somerole set statement_timeout=30000;

grant select on all tables in schema public to somerole;

Терминировать зомби-коннекты

Зачастую так бывает, что коннект был создан, но не был закрыт. Такие коннекты продолжают висеть некоторое время, потом постгрес сам их находит и предает праведному огню. Чтобы такие коннекты не плодились почем зря, мы и задали нашему юзеру ограничение по количеству коннектов. Тем не менее, может случиться так, что нужно все-таки вручную запустить чистку зомбаков. Я использую решение отсюда, его можно подредактировать под ваши нужды.

WITH inactive_connections AS (

SELECT

pid,

rank() over (partition by client_addr order by backend_start ASC) as rank

FROM

pg_stat_activity

WHERE

-- Exclude the thread owned connection (ie no auto-kill)

pid <> pg_backend_pid( )

AND

-- Exclude known applications connections

application_name !~ '(?:psql)|(?:pgAdmin.+)'

AND

-- Include connections to the same database the thread is connected to

datname = current_database()

AND

-- Include connections using the same thread username connection

usename = current_user

AND

-- Include inactive connections only

state in ('idle', 'idle in transaction', 'idle in transaction (aborted)', 'disabled')

AND

-- Include old connections (found with the state_change field)

current_timestamp - state_change > interval '5 minutes'

)

SELECT

pg_terminate_backend(pid)

FROM

inactive_connections

WHERE

rank > 1 -- Leave one connection for each application connected to the database

Остается только пожелать удачи и поменьше тазиков =)

|

Метки: author snakers4 серверное администрирование восстановление данных администрирование баз данных *nix postgresql tar администрирование бекапы |

Spark-in.me. Часть 1 — зачем и почему? |

Остальные статьи цикла будут посвящены вопросам «как» и деталям практической имплементации.

- Spark-in.me. Часть 1 — Зачем и почему?

- Spark-in.me. Часть 2 — Архитектура приложения и структура БД

- Spark-in.me. Часть 3 — DIY поддержка и админство сайта

- Spark-in.me. Часть 4 — Базовое админство для обычных человеков

- Spark-in.me. Часть 5 — Переход на HTTPS

- Spark-in.me. Часть 6 — Исходный код и настройка бекенда

- Spark-in.me. Часть 7 — Исходный код и настройка фронтенда

Посмотрите короткую вырезку из фильма Blade Runner по ссылке выше.

Это в принципе один из лучших фильмов в истории кинематографа, но не об этом речь. Очень глубокая мысль, заложенная в этом фрагменте (в моей проекции на реальный мир конечно) состоит в том, что:

- Не гены делают человека, а его поступки, мысли и вклад во что-либо значимое;

- Не факт наличия генов или юридические права делают человека человеком, а его вклад в некое дело и то, как он взаимодействует с обществом (посмотрите это кино, если вам интересна эта идея);

- В современном мире, который уже не так далек от фантастики людям зачастую важнее виртуальные и идеи, сообщества и общение. Вместо имплантантов в мозг вы просто носите с собой смартфон. Зачастую важнее бывает, что происходит с вашими друзьями далеко от вас, нежели чем в непосредственной близости;

- Очень многие люди являются мастерами своего дела и постоянно видят что-то прекрасное, удивительное, новое, свежее. Они создают что-то уникальное и новое, находят маленькие вещи, которые никто до них не видел;

- Иногда наоборот по жизни мы встречаем такие сгустки сконцентрированного треша и угара, что избегание такого же тоже является чем-то прекрасным — пример;

- Но мир работает таким образом, что зачастую вы не можете поделиться этим прекрасным даже в интернете, потому что каналы информации забиваются рекламой, информационным шумом, помоями, платным контентом, политикой, ложью. Список бесконечен;

- В интернете как нельзя прекрасно работает принцип 20-80 (закон Парето, распределение Пуассона — называйте как хотите). Простыми словами — чтобы докричаться до кого-то, нужно кричать в 10, 100, 1000, ..., 10^n раз громче каждый раз. Каналы информации нелинейны и монополизируются деньгами и шумом;

- По идее наука и научный подход должны решать такую проблему (на самом деле нет — это видео и канал про доказательную медицину намекают, какие части системы не работают в средне-срочной перспективе, но работают в долго-срочной). Но на практике, учитывая мой бекграунд и то, что в России не финансируются фундаментальные исследования и есть парадокс в том, что математики и люди «про сложные вещи и данные» или стоят дешево или нужны нескольким крупным компаниям, где неинтересно и нет свободы принятия решений, получается что можно получать очень очень мало и заниматься интересным с нулем перспектив или искать свой путь. Я за поиск своего пути;

- Вообще в более крупных и зрелых бизнесах как правило в определенный момент происходит подмена понятий (коммунисты по призванию сменяются коммунистами по названию =) ) — и фанаты своего дела сменяются безликими ремесленниками, которые правильно продали себя HR-ам, которые не понимают ничего в предмете;

- В принципе тот факт, что при общей «бедности» населения с точки зрения бизнеса то, что мне интересно (данные, алгоритмы, наука о данных, применение данных при принятии решений) нужно только крупным компаниями сразу накладывает ограничения на развитие в этом направлении;

Собрав это все воедино в голове несколько месяцев назад у меня в голове возник некий план:

- Нужно выкладывать все самое лучшее из своих наработок и из найденного в интернете на канал и на свой сайт, параллельно получая самообразование и делясь своими наработками, так, чтобы это в принципе не мешало основной работе;

- Содержимое канала в телеграме должно индексировать поисковиками. Спасибо этим людям за сервис постинга контента канала сюда (кстати есть уже второй автор на сайте со своей лентой тут);

- Чтобы было future-proof надо иметь свои АПИ, базу данных, CMS. Морду всегда можно поменять на новую. А подаренный другим платформам контент — тяжело вернуть;

- Плагины для комментариев, рассылки, онлайн аналитику лучше отдать условно бесплатным сервисам (ибо там работы настолько много, что ужас). Список таких сервисов, которые я использую: disqus, google analytics, tinyletter;

- Фронтенд конечно можно написать на PHP, но с точки зрения скорости и future-proof и собственного развития — я выбрал react.js;

Изначально предполагался такой список фич (гугл-док), но некоторая часть из них ушла в бой, часть показала свою бессмысленность. Краткое саммари, того что «прилипло к стене»:

| Список основых фич | Что в итоге с ними стало |

| База, структура |

|

| АПИ, проверки, логирование | Написал сам + взял свой код из прошлых проектов для АПИ |

| Сессии и запоминание юзера PHP, управление юзерами, права сессий | Написал сам + взял свой код из прошлых проектов для АПИ |

| Клиентская часть админки, CMS | Сделал через одно место сам (я ноль в JS и фронтенде) используя свои прошлые наработки и этот фреймворк |

| Шаблон блога | Взял отсюда |

| Морда на react.js | Заказал у этого разработчика . Был на 95% доволен работой. |

Фичи:

|

Все сделал сам сочетанием тулзов

|

| Интеграция с телеграмом |

|

| Комментарии, подписка, аналитика |

|

Изначально я хотел купить домен в .space (меня вдохновил лютый сайт spacemorgue.com), но потом когда я пропустил все самые классные домены, которые я нашел, я сменил решение.

Смеха ради список доменов, которые мы рассматривали есть тут. Я как-то все пропустил и не решился купить такие домены:

- name.it

- implo.de

- explo.de

- chri.st

- lemona.de

- voi.de

- sha.de

- fa.de

Итоговый домен spark-in.me я нашел случайно в последнюю минуту когда деплоил АПИ. Как оказалось, потом поиск выдал некий бизнес snake-oil проект по домену spark.me — вряд ли получится его купить.

Вот в принципе все про зачем и почему. Дальше уже будут более приземленные детали.

|

Метки: author snakers4 разработка веб-сайтов анализ и проектирование систем веб-сайт блогосфера разработка сайтов |

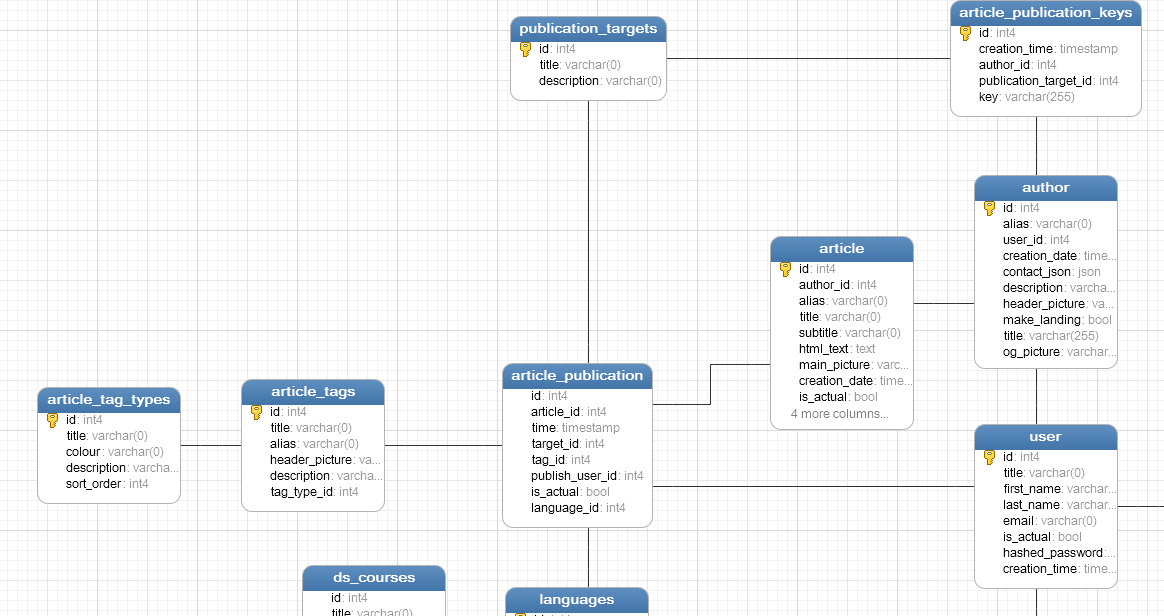

Spark-in.me. Часть 2 — Архитектура приложения и структура БД |

Статьи in a nutshell

Описав зачем и почему мы решились сделать свой фан-проект можно попробовать начать описывать как мы делали конкретные вещи.

В этой статье будет описана общая архитектура и структура данных сайта spark-in.me. Я также получал фидбек, что мол лучше делать более парцеллярные статьи про конкретные детали имплементации — про это будет вместе с публикацией кода на темы, которые больше всего заинтересуют народ.

- Spark-in.me. Часть 1 — Зачем и почему?

- Spark-in.me. Часть 2 — Архитектура приложения и структура БД

- Spark-in.me. Часть 3 — DIY поддержка и админство сайта

- Spark-in.me. Часть 4 — Базовое админство для обычных человеков

- Spark-in.me. Часть 5 — Переход на HTTPS

- Spark-in.me. Часть 6 — Исходный код и настройка бекенда

- Spark-in.me. Часть 7 — Исходный код и настройка фронтенда

0 Введение

Понятное дело, что в идеальном мире выбор инструментов должен трактоваться бизнес / какой-то потребностью и умные люди должны подолгу сидеть над табличкой архитектур, сделать рациональный выбор и потом команда должна пилить это долго и упорно.

На практике часто получается немного иначе:

- Мы умеем то-то и у нас есть небольшая кодовая база;

- Мы понимаем, что есть такие-то потребности в виде списка, но формализация всего по времени сопоставима с непосредственной имплементацией;

- Поэтому лучше планирование и исполнение заложить в несколько коротких итераций;

- Готовые решения не нравятся по причине отсутствия каких-либо фич или отсутствия владения контентом;

Сразу скажу, что с точки зрения дизайна самого приложения / архитектуры я частично вдохновлялся такими примерами:

- Админка медузы и сама медуза как самое прогрессивное с технической точки зрения СМИ (про контент молчу, он везде одинаковый);

- Тем, как работала публикация на моем прошлом месте работы;

- Принципом максимального отсутствия бизнес-логики в business tier и на клиенте — по сути большая часть новых вещей просто берется из базы и прокидывается в АПИ и на морду (зачем плодить уровни, если я один и контент простой?);

- Не возьмусь вспоминать где это сделано лучше всего, но все SEO фичи должны быть с самого начала (RSS, Sitemap, schema.org/ld+json, og-теги, мета-теги);

Из этого небольшого списка следуют такие принципы:

- Должно поддерживаться много авторов;

- Создание статей делается в простом WYSIWYG редакторе, картинки заливаются отдельно на страничке;

- Контент должен быть максимально отделен от формы, и желательно представим во всех возможных форматах без проблем (на практике, остался формат статей HTML, который всеяден, канал в телеграме, его веб-трансляция, и email-подборки статей с канала и сайта. От идеи мультипостинга я отказался, т.к. там слишком высокие пороги на вход и поддержку тучи социальных аккаунтов, хотя технически можно это сделать это хоть сейчас — собственно идея мультипостинга и породила мысль о том, чтобы использовать имеющуюся кодовую базу в таком формате);

- Контент должен быть представлен в такой форме, чтобы любой в интернете мог им поделиться, и при этом автоматически бы подтягивались open-graph теги;

- Нужно хранить минимально нужное количество SEO сущностей в базе, чтобы не пришлось потом их разделять;

- Принцип расширяемости и отделимости каждого компонента приложения от другого. Не совсем соблюдается, т.к. очень много завязано на PostgreSQL;

- Каждая единица контента должна иметь уникальный URL (главная, авторы, теги, статьи, фиксированные страницы). При этом никто не мешает делать автоматизированные подборки (сейчас есть теги и группы тегов + страницы авторов, по идее надо делать также страницы групп тегов);

- Добавление любой, даже самой лютой фичи, должно сводиться к простейшему набору из действий: i) Набор таблиц ii) Набор методов АПИ iii) Набор предобработок по крону или операций с данными (пока не нужно) iv) Прокидывание в админку или на морду

- Если нужно замутить какой-то динамический или нестандартный контент, то это должно делаться настройкой отдельного виртуального сервера и прокидыванием такого контента. Примеры раз и два

Несложно увидеть, что современные решения типа Medium, Tumblr или менее современные типа Wordpress не совсем этим принципам удовлетворяют. Самая главная проблема таких систем — по сути вы не владеете своим контентом или не можете ничего поменять или добавить. Я сталкивался с несколькими open-source минималистскими приложениями для блогов, которые в принципе можно использовать, но если они написаны на языке, который вам незнаком, то добавление, допустим, блока «похожие статьи» может стать путешествием в ад.

Имея эти требования в голове, выбор на такие технические решения:

- База PostgreSQL — возможно самая продвинутая open-source база в мире, которая сочетает в себе как реляционную базу так и много нереляционных фич;

- PHP для бекенда админки и для АПИ как самый простой, документированный и быстрый в применении и освоении инструмент;

- ReactJS для морды (хотя можно было бы на PHP все сделать). Изначально предполагалось сделать второй фановый проект, где нужны были приложения через React Native, но он отвалился;

Давайте теперь пройдемся по каждому компоненту отдельно. Я понимаю, что для части вещей сделанное может показаться overkill'ом, но часть этой кодовой базы у меня просто была, часть я дописывал с целью сделать тот же мультипостинг и иметь «правильное» АПИ и прошивку.

1 Статьи

- Изначально планировалось, что будет мульти-постинг, поэтому тут есть ключ для публикации и цели публикации. На практике используется только публикация на сайт (совершенству нет предела, но никто из нас, как мне кажется, не будет поддерживать паблики ВК и ФБ);

- Статья — основная сущность, она публикуется в теги на определенном языке;

- У тегов есть типы тегов;

- Также глобальные переменные хранятся в виде json в таблице;

- Автор имеет пользователя, от имени которого он входит в админку;

- Обратите внимание, что основные SEO-сущности хранятся в таблицах;

2. Пользователи, права и сессии пользователей

- У пользователя есть роли, которые объединяются в права. По сути получается, что любой пользователь может иметь любые права через роли;

- Проверка доступности методов делается по статической сессии;

- Для пользователей сайта статическая сессия создается заранее, пользователи работают по ключу (обратите внимание, я знаю про разные криптографические методы, динамические сессии, токены, protobuf и прочее — но я не использую это для простоты приложения — это же информационный контент, зачем его прятать?);

- При входе в админку у автора создается сессия и прописывается в cookies. При повторном заходе не нужно вводить пароль, если в браузере есть кука;

3. Методы АПИ

Самая неоднозначная вещь, поскольку по большей части состоит из legacy кода, написанного для другой цели. Архитектура вкратце написана для того, чтобы:

- Поддерживалась версионность методов АПИ с логами прошлых версий, чтобы не возиться с поддержкой;

- Добавление метода АПИ сводилось к:

- Внесению записей в таблицы и созданию прав;

- Прописыванию текста фиксированного запроса в таблицу или создании специальной кастомной функции;

- По сути структура выше описывает хранимые php-функции АПИ и тексты простых функций АПИ в виде запросов, хранимых в базе;

- Да, в базе хранятся права доступа к этой же базе. Но запросы с такими данными ходят только в локальной сети, поэтому это не должно быть проблемой;

- Значительная часть логики тут разнесена так:

- Большой класс apiHandler.php, который принимает внешние запросы, проверяет их на валидность, форматирование, верные параметры и выбрасывает ошибки, как в логи так и обратно;

- Большой класс apiExecutor.php, который в случае наличия валидного запроса этот запрос исполняет. Нетрудно догадаться, что изначально между этими двумя сущностями планировался балансировщик нагрузки, который просто пока не нужен;

- Работа с ошибками вынесена в отдельные классы и сущности, которые будут описаны ниже;

- Тут используются функции PostgreSQL по работе с json — многие конфиги и параметры хранятся в виде json, чтобы обеспечить развиваемость и обратную совместимость (и отсутствие геморроя для меня =) );

В общем случае работу АПИ можно представить так:

- Приходит запрос. Проходит простейший фаервол (все ненужные порты закрыты);

- В виде большой древовидной структуры запрос парсится и проверяется на:

- Валидность типа запроса и его содержимого;

- Валидность типов параметров и их содержимого;

- Наличие обязательных параметров;

- Наличие прав у запрашивающего;

- Если все проверки пройдены, в локальной сети отправляется запрос в apiExecutor.php (разделение сделано было в legacy коде с определенной целью), который делает ряд проверок, смотрит где найти запрос для функции или функцию на php, которую нужно исполнить;

- Естественно везде стоят проверки на SQL-инъекции, проверяется искейпинг и прочее;

- Функции, которые хранятся в виде запросов, естественно имеют экранированные параметры;

Пример параметров одного из запросов АПИ — я не большой фанат технических извращений, по мне простой json внутри POST запросов нормально работает.

{

"key": "very_secret_key",

"method": {

"name": "getTagByAlias",

"version": 1

},

"params": {

"targetId": 2,

"tagAlias": "not-buying-bs",

"getFullArticles": 1

}

}Статистика по вызовам запросов АПИ на момент написания статьи

- getSimilarArticlesByArticleAlias 25421

- getBlogObjects 17075

- getAuthorByAlias 12977

- getArticleByAlias 11412

- getArticleFeed 7124

- getTagInfo 3989

- getTagByAlias 1628

- getArticleById 717

- getBlogSearch 336

- getMyArticles 290

- getRussianDsCourses 278

- getArticlesByAuthor 271

Понятное дело, что в такой архитектуре рука так и просится спросить, а почему методы АПИ не являются хранимыми процедурами? Ответ прост — потому, что мне быстрее написать функцию на php или в примитивном случае запрос, чем хранимую процедуру. По идее наличие хранимых процедур увеличило бы независимость от СУБД, но это не же не коммерческое решение с командой разработчиков =).

Интересным образом я решил вопрос генерации SEO — обвеса страниц. По сути поставил себе пари — смогу ли я все запихать внутрь 1 SQL запроса, хоть и динамического? В итоге смог. При разбитии на языки навереное будет геморрой, но он может решиться простым разнесением на пару функций (да, я не программист, но я как-то не верю в идеальное ООП, мне больше скорее нравится идея микро-сервисов и «сгустков сути», а не красивого кода).

Вот пример самого извращенного SQL-запроса (вместе с php кодом, чтобы было понятно что к чему). Запрос выдает тег по алиасу и schema.org SEO обвес:

/*

{"params":{"targetId":"integer"}}

*/

function getTagByAlias($params){

/*

Check necessary param consistency

*/

if ( !isset($params['targetId']) ) {

try {

$erLogData = new ErLogData(

'API_INTERNAL_PARAM_TRANSMISSION_ERROR',

57,

get_class($e),

__FILE__,

__CLASS__,

__FUNCTION__,

__LINE__,

date('Y-m-d H:i:s')

);

$erLog = ErLogFactory::create($erLogData, $e);

$response = json_encode(array('response' => array('error' => ['message' => $erLog->_user_message, 'code' => $erlog->_code])), JSON_UNESCAPED_UNICODE);

throw $erLog;

}

catch (ErLog $ee) {

ErLog::full_log_v1($ee);

return $response;

}

}

if ( !isset($params['tagAlias']) ) {

try {

$erLogData = new ErLogData(

'API_INTERNAL_PARAM_TRANSMISSION_ERROR',

57,

get_class($e),

__FILE__,

__CLASS__,

__FUNCTION__,

__LINE__,

date('Y-m-d H:i:s')

);

$erLog = ErLogFactory::create($erLogData, $e);

$response = json_encode(array('response' => array('error' => ['message' => $erLog->_user_message, 'code' => $erlog->_code])), JSON_UNESCAPED_UNICODE);

throw $erLog;

}

catch (ErLog $ee) {

ErLog::full_log_v1($ee);

return $response;

}

}

if ( !isset($params['getFullArticles']) ) {

try {

$erLogData = new ErLogData(

'API_INTERNAL_PARAM_TRANSMISSION_ERROR',

57,

get_class($e),

__FILE__,

__CLASS__,

__FUNCTION__,

__LINE__,

date('Y-m-d H:i:s')

);

$erLog = ErLogFactory::create($erLogData, $e);

$response = json_encode(array('response' => array('error' => ['message' => $erLog->_user_message, 'code' => $erlog->_code])), JSON_UNESCAPED_UNICODE);

throw $erLog;

}

catch (ErLog $ee) {

ErLog::full_log_v1($ee);

return $response;

}

}

if ($params['tagAlias']=='all-tags') {

$whereClause = '';

} else {

$params['tagAlias'] = "'" . $params['tagAlias'] . "'";

$whereClause = 'AND at.alias =' . $params['tagAlias'];

}

if ($params['getFullArticles']==0) {

$fullClause = '';

} else {

$fullClause = '

,article.creation_date as created,

article.html_text as content,

article.main_picture as main_picture,

article.feed_picture as feed_picture,

article.title as title,

article.subtitle as subtitle,

article."alias" as "slug",

article.creation_date as published,

article.author_id as author_id

';

}

/*

Language - setting param by default

*/

if (!isset($params['language']) ) {

$params['language'] = 1;

}

if ( !is_int($params['language']) ) {

try {

$erLogData = new ErLogData(

'LANGUAGE IS NOT INT',

58,

get_class($e),

__FILE__,

__CLASS__,

__FUNCTION__,

__LINE__,

date('Y-m-d H:i:s')

);

$erLog = ErLogFactory::create($erLogData, $e);

$response = json_encode(array('response' => array('error' => ['message' => $erLog->_user_message, 'code' => $erlog->_code])), JSON_UNESCAPED_UNICODE);

throw $erLog;

}

catch (ErLog $ee) {

ErLog::full_log_v1($ee);

return $response;

}

}

if (is_file('../Credentials/db_credentials.php')){

include '../Credentials/db_credentials.php';

}

else {

exit("No ../Credentials/db_credentials.php credentials available");

}

$credentials =

[

'host' => $host,

'db' => $db,

'user' => $user,

'pass' => $pass,

];

/*

Create a new article

*/

try {

$queryString =

"

SELECT

to_json((a)) as tag_info

FROM

(

SELECT

to_json(\"array_agg\"(b)) as tag_data,

(SELECT publication_targets.title FROM publication_targets WHERE publication_targets.\"id\" = ".$params['targetId'].") as publication_target_title,

(SELECT publication_targets.\"id\" FROM publication_targets WHERE publication_targets.\"id\" = ".$params['targetId'].") as publication_target_id

FROM

(

SELECT

raw_data.*,

(SELECT to_json(array_agg(f)) FROM (

SELECT

article_list.*,

(SELECT to_json(array_agg(e)) FROM (

SELECT

author.\"id\" as author_id,

author.alias as author_alias,

author.contact_json as author_contacts,

author.description as author_description,

author.header_picture as main_picture

FROM

author

WHERE

author.\"id\" = article_list.article_author_id

) e) as author_info

FROM

(

SELECT DISTINCT

article.\"id\" as article_id,

article.author_id as article_author_id

".$fullClause."

FROM

article_tags

JOIN article_publication ON article_tags.\"id\" = raw_data.tag_id AND article_tags.\"id\" = article_publication.tag_id AND article_publication.is_actual = 't' AND article_publication.language_id = ".$params['language']."

JOIN article ON article.\"id\" = article_publication.article_id

) as article_list

) f) as article_list,

(

SELECT

count(article.\"id\") as article_count

FROM

article_tags

JOIN article_publication ON article_tags.\"id\" = raw_data.tag_id AND article_tags.\"id\" = article_publication.tag_id AND article_publication.is_actual = 't' AND article_publication.language_id = ".$params['language']."

JOIN article ON article.\"id\" = article_publication.article_id

) as article_count,

(SELECT to_json(array_agg(f)) FROM (

SELECT DISTINCT

article.author_id as author_id,

author.alias as author_alias,

author.contact_json::TEXT as author_contacts,

author.description as author_description,

author.header_picture as main_picture

FROM

article_tags

JOIN article_publication ON article_tags.\"id\" = raw_data.tag_id AND article_tags.\"id\" = article_publication.tag_id AND article_publication.is_actual = 't' AND article_publication.language_id = ".$params['language']."

JOIN article ON article.\"id\" = article_publication.article_id

JOIN author ON author.id = article.author_id

) f) as author_list,

array_to_json(

array[

json_build_object (

'type',

'rel',

'key',

'canonical',

'content',

'spark-in.me/tag/'||raw_data.tag_alias

),

json_build_object (

'type',

'name',

'key',

'title',

'content',

raw_data.tag_title

),

json_build_object (

'type',

'name',

'key',

'description',

'content',

raw_data.tag_description

),

json_build_object (

'type',

'property',

'key',

'og:site_name',

'content',

'Spark in me'

),

json_build_object (

'type',

'property',

'key',

'og:title',

'content',

raw_data.tag_title

),

json_build_object (

'type',

'property',

'key',

'og:url',

'content',

'spark-in.me/tag/'||raw_data.tag_alias

),

json_build_object (

'type',

'property',

'key',

'og:description',

'content',

raw_data.tag_description

)

]

) as tag_meta

FROM

(

SELECT DISTINCT

\"at\".\"id\" as tag_id,

at.\"alias\" as tag_alias,

at.title as tag_title,

at.header_picture as main_picture,

at.description as tag_description,

att.title as att_title,

att.colour as att_colour,

att.description as att_description,

att.sort_order as att_sort_order

FROM

article_tags at

JOIN article_tag_types att ON at.tag_type_id = att.id

JOIN article_publication ap ON at.\"id\" = ap.tag_id AND ap.language_id = ".$params['language']."

JOIN publication_targets pt ON pt.\"id\" = ap.target_id

WHERE 1=1

AND pt.\"id\" = ".$params['targetId']."

".$whereClause."

) raw_data

ORDER BY

7 DESC

) b

) a

";

} catch (Exception $e){

try {

$erLogData = new ErLogData(

'API_QUERY_CONSTRUCTION_ERROR',

59,

get_class($e),

__FILE__,

__CLASS__,

__FUNCTION__,

__LINE__,

date('Y-m-d H:i:s')

);

$erLog = ErLogFactory::create($erLogData, $e);

$response = json_encode(array('response' => array('error' => ['message' => $erLog->_user_message, 'code' => $erlog->_code])), JSON_UNESCAPED_UNICODE);

throw $erLog;

}

catch (ErLog $ee) {

ErLog::full_log_v1($ee);

return $response;

}

}

$result = queryWrapper ($credentials, $queryString);

return $result;

} 4. Обработка ошибок

Делается двумя способами:

- Есть класс Erlog, который расширяет классы php для работы с ошибками, рекурсивно прокидывает ошибки и логирует их — по идее он достоин отдельной статьи, но его автор смущается, что интернет-публика из всезнающих людей не воспримет адекватно;

- Если приложение не может подключиться к базе в локальной сети, то я получаю email (при отладке приложения были проблемы, по сути не хотелось поднимать нормальное АПИ 2 раза), то такой гениальный кусок кода отправляет аларму мне:

if (!$dbconn) {

$errorString = $appName . "\r\n". date('m/d/Y h:i:s a', time()) . "\r\n". $credentials['db'] . "\r\n". $queryString . "\r\n". implode(",", $queryParamArray);

error_log($errorString, 1, "aveysov@gmail.com");

$ret = file_put_contents('offline-errors.log', $errorString);

die('Could not connect (logged)');

} else {

/*

Continue executing code

*/

}

5. Сущности для прошивки админки

Тоже часть legacy-кода. Изначально проектировалась, чтобы позволить создавать новые странички в админке максимально быстро. По сути является просто веб-фреймворком, разобранным на зависимости.

HTML код и JS-инклюды библиотек собираются конкатенацией строк на php в большом классе из констант. Тупо, грубо, медленно (грузится 1-2 секунды), но зато работает. Естественно вся фронтенд логика сделана аяксом через одно место, т.к. на аякс и фронтенд ни знаний и усилий в свое время ну совсем не хватило.

По идее тут нет ничего интересного, кроме:

- Изначально даже была написана интеграция c АПИ redmine для отправки тикета в саппорт. По сути не пригодилось;

- У админки есть права на доступ к определенным страницам. Пользователь получает права на методы АПИ и доступ к страницам админки отдельно (они могут быть частью одной роли);

- Связь страниц и иерархия описаны в виде бинарного дерева в базе;

- У каждой страницы есть свой uuid по которому она собственно и собирается;

- Есть витиватая логика логина на php даже с минимальной криптографией;

Пишите в комментариях, если какая-то часть покажется вам достойной пошагового разбора.

|

Метки: author snakers4 разработка веб-сайтов анализ и проектирование систем postgresql php веб-сайт react.js |

Spark-in.me. Часть 3 — DIY поддержка и админство сайта |

Если вы не профессиональный админ, то зачастую деплой / саппорт / внесение правок в архитектуру может выглядеть для вас именно так.

В данной статье пойдет речь про наш подход к поддержке и админству нашего сайта https://spark-in.me. Дисклеймер — если будете пытаться повторить какие-то строки — сначала читайте документацию и разберитесь, что они значат.

- Spark-in.me. Часть 1 — Зачем и почему?

- Spark-in.me. Часть 2 — Архитектура приложения и структура БД

- Spark-in.me. Часть 3 — DIY поддержка и админство сайта

- Spark-in.me. Часть 4 — Базовое админство для обычных человеков

- Spark-in.me. Часть 5 — Переход на HTTPS

- Spark-in.me. Часть 6 — Исходный код и настройка бекенда

- Spark-in.me. Часть 7 — Исходный код и настройка фронтенда

Тут описан наш общий подход к админству наших проектов. Он не претендует на полноту, но работает для нас в комбинации с курением форумов и документации Ubuntu. Для начала несколько полезных ссылок на полезную копипасту, которую мы постили на канале и на сайте:

0. Покупка VDS

Загрузив в мозг общее описание архитектуры нашего сайта, вырисовываются такие кусочки системы и деплоя:

- Должна быть (в идеале отдельная при росте нагрузки) машина для базы;

- Должна быть (в идеале отдельная при росте нагрузки) машина для админки;

- Должна быть (в идеале отдельная при росте нагрузки) машина для фронтенда;

При росте нагрузки, понятное дело, основная нагрузка ложится на базу, т.к. на ней держится большая часть приложения. Фронтенд сделан на изоморфном реакте, он прожорлив, но он перекладывает нагрузку на клиент (браузер) пользователя. С учетом этого начнем нашу логическую цепочку. Пока пользователей мало (одновременно на сайте вряд ли бывает больше чем 10-20 человек), все можно задеплоить на одну машину. С учетом прожорливости ноды, у VDS, которую нужно купить для этого, должно быть 1-2 ГБ памяти. У Digital Ocean такое удовольствие стоит порядка 10 долларов в месяц. У Digital Ocean также есть отличные гайды по админству Linux, когда будете гуглить — ищите в том числе на их сайте.

Не вижу смысла останавливать на выборе провайдера VDS — есть провайдеры и дешевле, чем за 10 баксов, но тут все подкупает наличием дополнительных бекапов и простотой и интуитивностью их интерфейса. Могу только отметить:

- Чем чернее сервис и чем хреновее интерфейс, тем меньше гарантий и нет сервиса;

- Есть старые конторы типа Hetzer, которые дают dedicated сервера и VDS, там чуть дешевле, но вряд ли все так просто;

- Есть сервисы, которые сразу дают ячейки с установленным софтом, но они дороже в несколько раз и не поддерживают извращения;

1. Покупка доменов и прокидывание субдоменов

Первым шагом на нашей стороне будет покупка домена. Допустим мы купили домен spark-in.me и всю мелочевку, которая на него хоть как-то похожа. Далее нужно сделать редирект всех мусорных доменов на spark-in.me в кабинете регистратора. Далее мне кажется логичным завести такие субдомены через кабинет регистратора (это можно сделать через Apache или Nginx, но я выбрал самый простой способ) и направить их на машину.

- author.spark-in.me, который ведет на админку автора;

- api.spark-in.me, который ведет на АПИ;

- spark-in.me, который ведет на сайт;

- pics.spark-in.me, который ведет на микросервис по хранению картинок;

В начале это будут просто виртуальные хосты Apache или Nginx. Потом это уже могут быть отдельные машины, если потребуется. Соблюдение такой архитектуры в приложении потом позволит разнести части приложения без боли и без больших костылей.

2. Настройка сервера

Поскольку мы не ищем простых путей и в паре мест мы срезаем углы (мы делаем RSS и Sitemap по крону), то проще купить дешевую VDS и самому настроить деплой и поставить софт.

Базовые вещи, нужные для системы — апдейт пакетов и софт для мониторинга нагрузки. Это не заменяет такие вещи как Zabbix, но Digital Ocean к примеру предоставляет базовую статистику по нагрузке и так (потом при установке https оказалось, что что есть сервисы мониторинга, которые все таки настраиваются за 30 секунд).

# installation of the key software

sudo apt-get update

# server monitoring tool

sudo apt-get install glances

# just invoke glances to monitor the system

Есть явные spikes во время ночных бекапов по крону, но ничего критического пока нет.

Постгрес и апач (потом был заменен на nginx)

# postgresql

# installing contrib version via ppa

sudo apt-get install postgresql postgresql-contrib

# installing apache2

sudo apt-get install apache2

# checking syntax of apache2 config files

sudo apache2ctl configtest

sudo systemctl status apache2

# restarting apache2

sudo systemctl restart apache2

# apache2 specific mods

sudo a2enmod proxy # for reverse proxy

Php и node-js (все гуглится по ссылкам ниже или ключевым словам)

Также при использовании apache2 рекоммендуется сразу выключить directory listing мод, иначе будут видны папки на вашем сервере (было заменено на nginx).

В официальном репозитории Убунты на момент настройки была устаревшая нода — но в интернете также были гайды по апгрейду.

# checking ufw

sudo ufw app list

# disable apache2 directory listing mod

sudo a2dismod autoindex -f

# install php

# https://www.digitalocean.com/community/tutorials/how-to-install-linux-apache-mysql-php-lamp-stack-on-ubuntu-16-04

sudo apt-get install php libapache2-mod-php php-mcrypt

# install postgresql driver

sudo apt-get install php-pgsql

# install curl

sudo apt-get install php-curl

# locate the php.ini file ans set

# memory to 256m, time to 60s and error reporting to on

# installing node js and npm

sudo apt-get install nodejs

# this actually installs node 4.3

# do this to install 6.9+

wget -qO- https://deb.nodesource.com/setup_7.x | sudo bash -

sudo apt-get install -y nodejs

sudo apt-get install npm

# install yarn

# https://yarnpkg.com/lang/en/docs/install/#linux-tab

curl -sS https://dl.yarnpkg.com/debian/pubkey.gpg | sudo apt-key add -

echo "deb https://dl.yarnpkg.com/debian/ stable main" | sudo tee /etc/apt/sources.list.d/yarn.list

sudo apt-get update && sudo apt-get install yarn

# disable the apache2 default conf

sudo a2dissite 000-default.conf

sudo systemctl restart apache2

VSFTPD для быстрого доступа по ftp. Не рекоммендуется использовать для нормальных проектов, но у нас проект не бизнесовый

Сборник ссылок про vsftpd.

# vsftpd installation and config

sudo apt-get install vsftpd

sudo cp /etc/vsftpd.conf /etc/vsftpd.conf.original

sudo nano /etc/vsftpd.conf

# key changes

# uncomment local_umask=022

# local_enable=YES

# write_enable=YES

# anonymous_enable=NO

# chroot_local_user=YES

sudo adduser spark-in-me

sudo chown spark-in-me:spark-in-me /var/www/spark-in-me/

sudo usermod -d /var/www/spark-in-me spark-in-me

sudo chmod a-w /var/www/spark-in-me

sudo service vsftpd restart

chown spark-in-me:spark-in-me /var/www/spark-in-me/blog/

chown spark-in-me:spark-in-me /var/www/spark-in-me/admin/

# after this commands vsftpd should start properly working

Настройка файла крона

Ссылки про то, как начать использовать крон 1 2 3 4

# crontab setup and usage

crontab -e

# CRONTAB CONTENTS START HERE

# Borrowed from anacron

SHELL=/bin/sh

PATH=/usr/local/sbin:/usr/local/bin:/sbin:/bin:/usr/sbin:/usr/bin

MAILTO=aveysov@gmail.com

#End borrowed from anacron

# 0 1 * * * /home/snakers41/bash-scripts/WHOLE_SYSTEM_BACKUP.sh

# CRONTAB CONTENTS END HERE

Пример банального скрипта для бекапа системы (в итоге дергаем через ssh по ночам с другого сервера)

# backups

# plain backup script

mkdir /home/bash-scripts

mkdir /media/backups