Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Дайджест свежих материалов из мира фронтенда за последнюю неделю №267 (12 — 18 июня 2017) |

| Веб-разработка |

| CSS |

| Javascript |

| Браузеры |

| Занимательное |

Веб-разработка

Веб-разработка

- Подкаст devschacht, Выпуск №4: Обсуждаем прошедший HolyJS holyjs-piter.ru

- Подкаст «Пятиминутка React» #22 — News: React 15.6, webpack 3, Babel Notes, mobx-state-tree 0.7, Preact video on egghead.io

- Подкаст «Фронтенд Юность» (18+) #6: Шок! Вся правда об Ember.js

Все записи докладов с с JSConf EU 2017

Все записи докладов с с JSConf EU 2017  Grab Front End Guide — введение в стек современного фронтенда

Grab Front End Guide — введение в стек современного фронтенда Готовимся к Web Bluetooth!

Готовимся к Web Bluetooth! Использование Workbox + Webpack для предварительного кеширования с помощью Service Worker

Использование Workbox + Webpack для предварительного кеширования с помощью Service Worker Люди с ограниченными возможностями отвечают, что же для них самое сложное в вебе

Люди с ограниченными возможностями отвечают, что же для них самое сложное в вебе A11ycasts #19: доступные модальные окна

A11ycasts #19: доступные модальные окна- AMP/PWA:

PWA Directory — каталог прогрессивных веб приложений

PWA Directory — каталог прогрессивных веб приложений Что такое Accelerated Mobile Pages и чем они отличаются от отзывчивого веб-дизайна

Что такое Accelerated Mobile Pages и чем они отличаются от отзывчивого веб-дизайна Пожалуйста, сделайте Google AMP опциональным

Пожалуйста, сделайте Google AMP опциональным

- Tools:

topol.io — удобный генератор шаблонов писем, в том числе и отзывчивых

topol.io — удобный генератор шаблонов писем, в том числе и отзывчивых  Network Monitor в Firefox: Подробно о новых возможностях инструмента, работа с внутренним сервером и удаленным отладчиком

Network Monitor в Firefox: Подробно о новых возможностях инструмента, работа с внутренним сервером и удаленным отладчиком Введение в FuseBox — более быструю и легкрую альтернативу Webpack

Введение в FuseBox — более быструю и легкрую альтернативу Webpack Введение в Webpack: Entry, Output, загрузчики и плагины

Введение в Webpack: Entry, Output, загрузчики и плагины Представление Bonsai: open source анализатор Webpack от Pinterest

Представление Bonsai: open source анализатор Webpack от Pinterest

- Animation:

Желейный эффект для фигур в canvas — Юрий Артюх пишет код в прямом эфире с комментариями и пояснениями

Желейный эффект для фигур в canvas — Юрий Артюх пишет код в прямом эфире с комментариями и пояснениями Улучшаем SVG анимацию с помощью GSAP

Улучшаем SVG анимацию с помощью GSAP CSS Animations vs Web Animations API

CSS Animations vs Web Animations API Эффектный анимированный морской пейзаж на HTML/CSS

Эффектный анимированный морской пейзаж на HTML/CSS

CSS

CSS

5 возможностей LESS, о которых вы могли не знать

5 возможностей LESS, о которых вы могли не знать- Сатирические зарисовки на тему CSS, или Cюрпризы фронтенд-разработки

- CSS Grid Layout:

- Полное руководство по CSS Grid

- Большая статья про гриды (CSS Grid Layout)

Используем CSS Grid Layouts на продакшене уже сегодня

Используем CSS Grid Layouts на продакшене уже сегодня Введение в единицу CSS `fr`

Введение в единицу CSS `fr`

- Типографика:

- OpenType-фичи в вебе

Масштабирование отзывчивой типографики в CSS

Масштабирование отзывчивой типографики в CSS Типографический потенциал вариабельных шрифтов

Типографический потенциал вариабельных шрифтов

Практическое руководство по CSS переменным (пользовательские свойства)

Практическое руководство по CSS переменным (пользовательские свойства) Мысли по поводу самодокументированного CSS

Мысли по поводу самодокументированного CSS Создание минималистичной HTML карточки всего в 53 строки кода (с Flexbox)

Создание минималистичной HTML карточки всего в 53 строки кода (с Flexbox) Обработка длинного и неожиданного контента в CSS

Обработка длинного и неожиданного контента в CSS Результаты глобального CSS опроса 2017

Результаты глобального CSS опроса 2017 От CSS препроцессоров до CSS в JS

От CSS препроцессоров до CSS в JS Better-Less — кросс-совместимая подсветка синтаксиса для Less кода

Better-Less — кросс-совместимая подсветка синтаксиса для Less кода

JavaScript

JavaScript

New releases: ESLint v4.0.0, V8 Release 6.0, Node 8 и npm5

New releases: ESLint v4.0.0, V8 Release 6.0, Node 8 и npm5 Книга заклинаний современного веб-разработчика: большая картинка, тезаурус и таксономия современного веб-разработки JavaScript

Книга заклинаний современного веб-разработчика: большая картинка, тезаурус и таксономия современного веб-разработки JavaScript Реактивное программирование, блин. Это не о ReactJS

Реактивное программирование, блин. Это не о ReactJS Почему вы должны ограничить JavaScript — и как это сделать

Почему вы должны ограничить JavaScript — и как это сделать Выбор Jest вместо Mocha

Выбор Jest вместо Mocha Как отслеживать изменения в DOM-е с использованием Mutation Observer

Как отслеживать изменения в DOM-е с использованием Mutation Observer- Теория:

Коллбэк в JavaScript… Что за зверь?

Коллбэк в JavaScript… Что за зверь? Декораторы в JavaScript

Декораторы в JavaScript- Сигнатура типов функции в JavaScript

В чем разница между Null и Undefined?

В чем разница между Null и Undefined?

- Практика:

Работа с периферией из JavaScript: от теории к практике

Работа с периферией из JavaScript: от теории к практике 19+ методов сокращённого написания кода в JavaScript

19+ методов сокращённого написания кода в JavaScript Как я разработал и создал Fullstack JavaScript клон Trello

Как я разработал и создал Fullstack JavaScript клон Trello Использование HTML5 canvas для добавления водяных знаков на изображения

Использование HTML5 canvas для добавления водяных знаков на изображения Машинное обучение с JavaScript: часть 1

Машинное обучение с JavaScript: часть 1 Детальный курс по управлению памятью

Детальный курс по управлению памятью История о производительности JavaScript, часть 3: Рендереры всех форм и размеров

История о производительности JavaScript, часть 3: Рендереры всех форм и размеров

- Vue:

vue-styleguidist — стайлгайд для vue-компонентов

vue-styleguidist — стайлгайд для vue-компонентов XSS в Vue.js

XSS в Vue.js Создание приложения на Vue JS (webpack, axios, bootstrap 4, reddit и бесконечный скроллинг на vanilla javascript)

Создание приложения на Vue JS (webpack, axios, bootstrap 4, reddit и бесконечный скроллинг на vanilla javascript) Станет ли Vue.js таким же гигантом, как Angular или React?

Станет ли Vue.js таким же гигантом, как Angular или React? Расширение компонентов VueJS

Расширение компонентов VueJS

- Angular:

- Оптимизация сайтов на AngularJS для краулеров Google

PWAs с Angular: Being Reliable, Being Fast, Being Engaging

PWAs с Angular: Being Reliable, Being Fast, Being Engaging Angular 1.0 исполнилось пять лет

Angular 1.0 исполнилось пять лет Релиз Angular 4.2

Релиз Angular 4.2

- React:

Сокращаем использование Redux кода с помощью React Apollo

Сокращаем использование Redux кода с помощью React Apollo Видеокурс Начало работы с Preact

Видеокурс Начало работы с Preact Что такое React? Термины React на простом английском и в рисунках

Что такое React? Термины React на простом английском и в рисунках Почему я выбрал React вместо Vue

Почему я выбрал React вместо Vue Релиз Is-React 1.0.0 — Утилитарные методы для React

Релиз Is-React 1.0.0 — Утилитарные методы для React  React State или Redux State: когда что использовать?

React State или Redux State: когда что использовать?  Сделать React снова быстрым [часть 1]: временная шкала производительности

Сделать React снова быстрым [часть 1]: временная шкала производительности

- Libs & Plugins:

Подсветка текста в Textarea v2

Подсветка текста в Textarea v2 spected — низкоуровневая библиотека для валидации

spected — низкоуровневая библиотека для валидации js-joda — библиотека для работы с неизменяемыми временем и датой

js-joda — библиотека для работы с неизменяемыми временем и датой  dutier — небольшое (1Кб), асинхронное и простое решение для управления состоянием приложения

dutier — небольшое (1Кб), асинхронное и простое решение для управления состоянием приложения

Браузеры

Vivaldi 1.10 — маленькие радости широких возможностей

Vivaldi 1.10 — маленькие радости широких возможностей Вышел Firefox 54, который наконец получил поддержку многопроцессного режима. Подробности для разработчиков в блоге Марата Таналина

Вышел Firefox 54, который наконец получил поддержку многопроцессного режима. Подробности для разработчиков в блоге Марата Таналина- Доступна бета-версия Firefox 55

Chrome 60 Beta: Paint Timing API, CSS font-display, и улучшения Credential Management API

Chrome 60 Beta: Paint Timing API, CSS font-display, и улучшения Credential Management API- 10 самых полезных расширений Chrome

Как написать расширение для Chrome

Как написать расширение для Chrome

Занимательное

Занимательное

- SEMrush определил важные факторы ранжирования Google в 2017 году

- Вы — не Google

- Переобученные нейросети в дикой природе и у человека

Разработчики, использующие пробелы, зарабатывают больше денег, чем те, кто используют табы

Разработчики, использующие пробелы, зарабатывают больше денег, чем те, кто используют табы- Google запустит новую утилиту Backup and Sync взамен Google Диска

- Гибридная нейросеть превзошла человека в Ms. Pac-Man

- Verizon закрыла сделку по покупке Yahoo за $4,48 млрд

- Астрофизик Нил Деграсс Тайсон делает научно достоверную игру о космосе

- 12 уроков от 100 самых креативных людей 2017 года по версии Fast Company

- Amazon заинтересовалась покупкой Slack. Сервис оценивают в $9 млрд

- К 2021 году вещи станут главными пользователями интернета

- Уставший от рутины инженер Google написал приложения для случайного выбора путешествий и знакомств

Просим прощения за возможные опечатки или неработающие/дублирующиеся ссылки. Если вы заметили проблему — напишите пожалуйста в личку, мы стараемся оперативно их исправлять.

Дайджест за прошлую неделю.

Материал подготовили dersmoll и alekskorovin.

|

|

Технологии больших данных в работе с бактериями микробиоты. Лекция в Яндексе |

Под катом — расшифровка и основная часть слайдов.

Дмитрий Алексеев, директор по R&D биомедицинского холдинга «Атлас»:

— Вообще-то я микроб. Такое необычно слышать, ведь ты привык, что тебе люди что-то рассказывают. А я микроб. Нас много живет. И в тебе тоже.

Цифра такая примерная — 100 трлн на каждого. Можешь умножить на количество посетителей. Столько нас сегодня здесь. Я пришел кое-то важное тебе рассказать про нас, микробов, потому что в последнее время ты не очень обращаешь на это внимание, и ни к чему хорошему это не приведет. Важно, чтобы у тебя в голове остались две вещи, когда я закончу: что, во-первых, я хороший, а во-вторых, что данные, доступные тебе прямо сейчас из твоего ноутбука, могут рассказать еще больше про то, какие мы интересные.

Когда нас, микробов, много, нас называют микробиотой. И сейчас в вашей человеческой медицине есть большая надежда, что в ближайшем будущем вы опять сможете шалить, пить, курить и неправильно питаться, а мы, микробы, вас обратно спасем. И в целом это называется сейчас тераностика — когда мы диагностируем, что у тебя болит, и вылечим это тоже. Мы, микробы, вообще можем все. И понятно, что мы на этой планете гораздо дольше живем, чем ты. С самого того момента, как ты появился, еще будучи маленьким червячком, мы уже тебя заселили. И важно понимать, что все твои органы, особенно кишечник, про который мы будем говорить, — они развивались вместе с моими предками, хотя, по правде, у меня как у микроба нет предков. Мы делимся пополам. Чуть позже ты увидишь этот прекрасный процесс.

Если бы ты хотел узнать, стоит ли заниматься микробами, и в 2014 году залез в базу данных публикаций — это такая логарифмическая шкала — ты бы увидел, что микробами занимаются. Тысячи статей в год интересных, люди очень много интересного пишут и про иммунитет и микробов, и про раковые заболевания и микробов, и в целом про связь микробов или микробиоты, особенно кишечника, с заболеваниями. Горячая тема. И эта горячая тема — постгеномная эра. После того, как люди посчитали, вычислили, прочитали геном человека, те же самые технологии они обратили на микробов. И выяснили, что нас гораздо больше, чем раньше предполагалось.

Изучают нас из-за того, что в нас есть ДНК. Ты удивишься, но во мне ДНК такая же, как в тебе. Я себе просто эту мысль в тишине иногда думаю, что во мне такая же ДНК, как в людях. Это поражает. Все-таки мы супер-разные, а записано все ноликами и единичками. Хотя, может, тебе это очень знакомо. Почему? Потому что ты делаешь всякие эти приложения, и полезные приложения, и бесполезные. И полезное приложение из ноликов и единичек, и бесполезное. Тут главное — правильно выстроить порядок. Хотя я уверен, что мой порядок никто не выстраивал, за меня эволюция работала. Те мои братья, которые были посильнее, предки, они просто оставались. Те, которые как-то неправильно изменялись, они исчезали. Это то, что называется отбором. И совокупность наших генов называется мета-геном. Это то, что тебе — человеку, который анализирует данные, — подается в первую очередь как сырые данные. И эти гены можно найти в любой среде. Даже в ядерном реакторе или на космической станции есть мои друзья-микробы, и у них тоже есть гены, и они действуют по тем же правилам.

Если посмотреть в кишечник, можно увидеть разнообразие, то есть много есть таких ребят, как я. Но есть еще и другие виды. Они в другой кепке, в других очках, кто-то в кроссовках, кто-то в шортах. Примерно от 300 до 1000 видов таких ребят живет в каждом кишечнике. И удивительно: если так прикинуть, то мы не очень поймем, каких клеток больше: меня, то есть микробов, или твоих собственных. Но мы там все умещаемся в эти 1,5 кг сухого веса, который есть у тебя в кишечнике. Почему? Потому что мы реально меньше. Если ты не догадался, то я сейчас — всего лишь увеличенная копия микроба.

Поэтому число генов, каких-то функциональных участков ДНК, которые что-то могут делать, получается на пару порядков выше, так что на самом деле я могу гораздо больше, чем ты, и я твое эволюционное приспособление, чтобы ты мог хулиганить. Ты свой генетический код никогда не изменишь, и когда ты начинаешь есть нехорошую еду, в первую очередь я к этому учусь приспосабливаться. Сейчас я тебе прямо из данных покажу, как я это делаю.

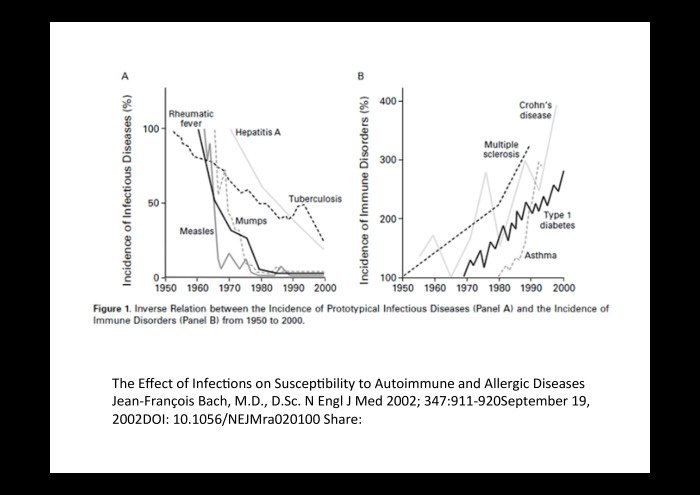

Хорошая картинка, очень старая. Тогда еще про гены никто не читал усиленно. Часть заболеваний на английском языке написана, заболеваемость падает. Это все инфекционные заболевания, причиной которых являются такие же ребята, как я, но они гопники с виду. А другие заболевания связаны с твоей иммунной системой. Например, диабет или астма. Что-то в ней не так работает. И это происходит прямо в наше время. В человечестве инфекционных заболеваний меньше, а заболеваний, которые связаны с иммунитетом, становится больше. Это интересно.

Что произошло, почему стало спадать количество инфекционных заболеваний? Потому что вы придумали антибиотики. Антибиотики — это такие маленькие вещества, которые не дают мне либо размножаться, либо двигаться, и тогда я умираю. И ты эти антибиотики принимаешь, чтобы от плохих ребят избавиться, но страдают все, потому что мы устроены практически одинаково, никакого специфичного лекарства от отдельной бактерии, от отдельного микроба, не существует. И поэтому хорошие ребята тоже умерли — иммунитет страдает.

Я вас, людей, изучаю в последние 10 лет: кандидат биологических наук — это то и значит, что я изучаю жизнь. Все это время я думаю, что иммунная система была создана у человека, чтобы вычислять, какие микробы есть, правильно их поддерживать. И в основном это происходит в кишечнике, и, опять же, по количеству клеток. То есть ты отлично умеешь контролировать, кто там должен находиться.

Вот тоже интересная история, пока не относящаяся к данным. С самого детства все зависит от того, как ты родился. Если это кесарево сечение, то к тебе первые микробы попадают в кишечник с кожи матери. Если это оригинальный, исконно человеческий способ рождения, то микробиота вагинальная, и оказывается, что наш кишечник привык за это время делаться правильным, вырастать, исходя из того, что вначале микробы от мамы передаются из ее влагалища. Если же они с кожи мамы, то это совсем другие микробы и начинает происходить не так. Часто это выражается у детей, например, в аллергиях. Подтверждением этого являются уже существующие рекомендации: если было кесарево сечение, то после этого ребенка обмазывают в материнском соке, и тогда правильные микробы попадают в кишечник, и дальше все происходит правильно.

У детей эти микробы сильно меняются: то те, то другие. Они болеют, и иммунитет привыкает. В какой-то момент, как мы думаем, окно возможностей закрывается. Ты запомнил всех хороших и всех плохих за счет своей иммунной системы. Это супервычислительная машина. Она может по одному маленькому элементу, просто по кепке, узнать меня как микроба и сказать, свой я или чужой. Поэтому если ты пьешь всякие кефиры с живыми бактериями, они у тебя останутся, но до трех-пяти лет нигде не записано, что они свои. Можно поразмышлять, что у тех детей, которые рождаются сейчас, уже встроен одинаковый код, потому что они с детства пьют эти синтетические бактерии. Возможно, это место для суперхакерских атак на будущих людей, потому что у всех них записан код одной и той же синтетической бактерии. Компанию, которая это делает, ты назовешь сам.

Во взрослом возрасте наша комбинация, наше соотношение примерно такое, как ты питаешься. Так устроено. Зачем нужно много разных? Потому что мы специалисты в разных вещах. Специалисты в том, чтобы переваривать разные полимеры в твоей еде. В основном ты раньше ел не так много животной пищи, много растительной, и мы, твои микробы, приспособились переваривать эту растительную пищу. Каждый из нас умеет делать что-то одно. Представь себе, что ты растительной пищи ешь немного, или получаешь ее сразу с завода. Она перемолота, нам почти ничего не остается. И специалисты уходят. Просто серые будни твоего кишечника — это всегда однотонная еда из одной и той же картонной упаковки.

Когда ты стареешь, мы, на самом деле, думаем что мы готовим тебя к смерти — чтобы ты снова переварился на более простые составляющие, и мы из тебя создали новую жизнь на этой планете. В принципе, мы так делали всегда.

Интересный способ понять, как это здорово устроено и как это встроено в человеческий организм. Есть такая теория, что через иммунные клетки из кишечника матери микробы передаются с молоком ее ребенку. Там, у него в кишечнике, открываются эти иммунные клетки. Таким образом мама с какого-то момента заселяет кишечник ребенка полезными микробами. Другими словами, пока создавалось это эволюционное тело человека, мы нашли способ проникать к твоим детям максимально быстро и безопасно.

Вот эта картинка на самом деле интересная. Когда-нибудь в реальности тебе понадобилось избавиться от большого количества плохих микробов. Ты сделал две вещи. Антибиотики я уже назвал. Второе — про гигиену: ты заставил всех мыть руки. Крайний вариант — Маяковский, который вообще боялся всего, и все мыл со своим тазиком. Это суперкультурное явление. Мы должны понимать, что ни в какой живой природе такого явления и мема нет, будто надо все мыть. Ты его создал, создал какие-то суперсказки, они причем в разных народностях могут быть разные. В моем детстве, в твоем детстве, в чьем-то детстве в 1980-е годы точно был этот персонаж Мойдодыр, и мальчику с грязными руками и грязными ногами просто было супермегастыдно. Сейчас, если ты наберешь «теория гигиены» в Википедии, то тут же найдешь теорию одного европейского врача о том, что количество аллергий у детей связано с тем, что они помещены в суперстерильные условия. За счет этого иммунная система не обучается, то есть она живет в стерильной коробке. И потом, столкнувшись с чем-то действительно враждебным или полезным, она на все это реагирует воспалением. А воспаление — это и есть аллергия.

Прикольная история про питание, про то, как это может быть интересно устроено. Например, ты ешь мясо, и один мой коллега — тоже микроб — может из этого мяса получать вещество, которое будет потом создавать холестериновые бляшки. Если такого коллеги у тебя не живет, то проблем с мясом у тебя нет. Если же он у тебя поселился, то хорошо бы по этому поводу подумать, как-то это отрегулировать. Потому что я понимаю, что одна из твоих целей — оставаться в этом теле как можно дольше, сохраняя при этом его работоспособность и радость к жизни. Нужно, чтобы тело было не просто оболочкой, которая путешествует сотни лет куда-то, а чтобы она была живой оболочкой. Поэтому интересно обращать внимание. И здесь уже начинаются всякие данные, которые есть в интернете.

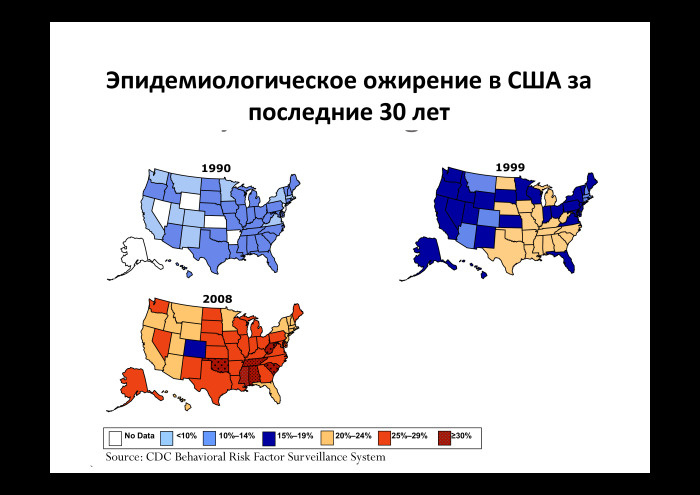

Ты начал меня активно изучать во время этой истории про эпидемиологическое ожирение в Соединенных Штатах Америки. С 1990 по 2008 год в некоторых штатах ожирение как диагноз с 10% выросло до 30%. На самом деле, это не очень похоже на те голливудские фильмы, которые ты смотрел. По улицам действительно ходят очень полные люди. У 30% из них стоит диагноз. При этом структура питания за эти 30 лет у американцев не менялась. И Джеффри Гордон, исследователь, обнаружил, что у людей, которые более стройные, slim, и у людей полных с диагнозом «ожирение» разные микробы. Более того, когда он этих микробов от людей с ожирением пересадил в мышей, выяснилось, что мыши быстрее набирают вес. То есть этот вариант микробов, который живет у людей с ожирением, производит больше калорий из того же количества пищи. И тогда ты понял, что состав микробов оказывает влияние на то, как ты будешь себя чувствовать.

Такая же интересная история происходит на пищевом рынке, когда люди получают мясо. Если субтерапевтические дозы антибиотиков давать животным, то они потихонечку набирают вес. Если ты в капиталистической стране, то чем больше ты из того же количества корма и того же количества времени получишь веса, который ты продаешь в долларах, тем тебе выгоднее. Естественно, в какой-то момент все производители животных стали пользоваться этим свойством. Когда эти животные попадают на стол и дальше внутрь человека, антибиотики как вещества практически никуда не деваются, и человек становится таким же потребителем субтерапевтических доз этих антибиотиков. И результат точно такой же — человек просто набирает вес. Субтерапевтические дозы — это здесь важно, потому что дозы такие маленькие, что ни Роспотребнадзор, ни Американпотребнадзор их просто не засекают. Есть какие-то пределы чувствительности.

Другая твоя история — действительно живой проект, можно на него посмотреть. Он назывался Happy Meal. Сам догадаешься, почему. На 137 день оставленная на воздухе еда выглядит примерно так же, как она выглядела в магазине. Почему она так выглядит? Потому что ни микробы, ни плесень эту еду не едят. Представь, что такая еда попадает внутрь тебя, и там такие же микробы. Они тоже не очень хотят ее есть. Говорят, потом «Макдональдс» выпустил опровержение, что там никакой химии специальной нет, просто очень много соли. Но если подумать, нам все равно, что там в большом количестве не дает микробам нормально расти.

Еще одна картинка, уже более сложная. И она уже прикольная — про данные, которые в разных экономических группах показывают, как растет подушевой доход, и что происходит с потреблением мяса, пустых калорий — это в основном алкоголь и сладости, — и вообще с количеством калорий. Вот экономическая группа А — самые богатые страны с 1961 по 2009 год. Доход вырос, потребление мяса выросло. В группе B начиналось ниже, но там то же самое происходит. И фактически всё, что мы видим во всех экономиках, — это если растет подушевой доход, то люди начинают есть больше мяса, больше пустых и диетарных калорий. Кроме Индии, там мясо не едят. То есть прямо from data видно, что чем больше мы зарабатываем, тем больше едим. И едим мы те самые пустые калорий, которые не суперполезны нашим микробам. А образ жизни — притом, что мы больше зарабатываем — становится не суперподвижный.

Мы когда-то смотрели этих микробов в России и обнаружили, что в больших городах — Новосибирске, Санкт-Петербурге — микробы такие же, как у европейцев и у американцев. Такие же комбинации. А в деревнях другие микробы, какие-то уникальные составы. И мы тогда поняли, что это прямо эффект глобализации, что когда человек приезжает из деревни в город, он попадает под фильтр антибиотиков, которые есть в еде, и простых консервантов, которые есть во всей еде. Ао всему миру одни и те же люди покупают продукты во всех магазинах. И это фильтрует и убирает какие-то одни микробы, и остаются только те, которые могут пережить такой геноцид. Тогда мы все становимся одинаковыми, мы не можем отличить европейца от американца и от русского, который живет в большом городе.

Еще одна маленькая история. Всё, что я сказал про антибиотики, относится и к ней тоже. Важно это знать, потому что это мировая тема, которую тоже можно отследить в данных. Вообще, ты выпускаешь все больше и больше антибиотиков, и та доза, от которой умирала первая бактерия, когда был сделан первый антибиотик, сейчас должна быть стократной, чтобы убить бактерию. Мы всегда приспосабливаемся из-за того, что можем поделиться раз в час, и нам несложно умирать. Мы приспосабливаемся гораздо быстрее. Есть вероятность, что возникнет такой нехороший парень среди нас, на которого не будут действовать ни одни твои антибиотики. Он будет передаваться быстро и будет смертелен. Это проблема антибиотикобезопасности. Антибиотики кружат во всей среде.

Мы с ребятами сделали такую картинку про то, какие бывают разные уровни резистентности к разным антибиотикам в разных странах. Ее можно найти онлайн или в этой статье. Интересно, что чем более страна индустриализована, как, например, Китай, тем больше резистентности. И у тех же самых китайцев мы видим резистентность еще и к химическим веществам. То есть микробы начинают обрабатывать какие-то неприятные химикалии, попадающие внутрь организма. Они уже приспосабливаются. Но не очень понятно, делается ли от этого китайцам лучше или нет.

Хороший проект, в котором мы участвуем с российской стороны — микробиота метрополитенов всяких городов. Сейчас здесь уже почти 100 городов. Началось все это с Нью-Йорка. Собрали ДНК со всех станций и посмотрели, какие там микробы. И, например, про данные — которые, кстати, тоже открыты, — мы решали недавно следующую задачу: можно ли по составу микробов определить, какая это станция метрополитена? Потому что от разных станций разные микробы едут в центр, и там уже на пересадке все смешиваются.

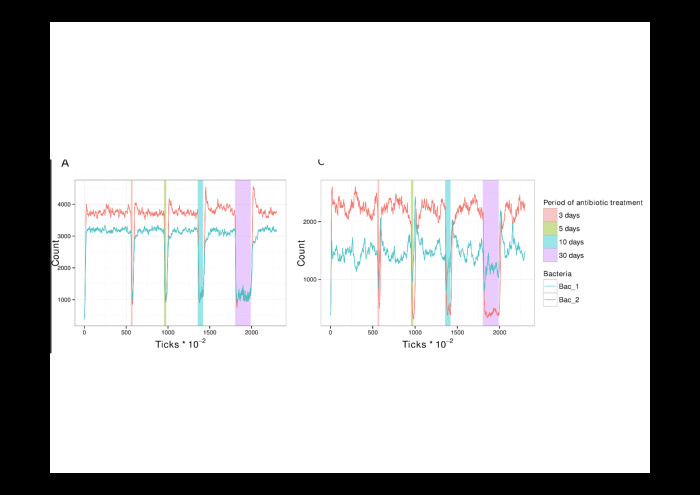

Вообще, мы воспринимаем эту тему про микробов как complexity science. Мне кажется, что гуру complexity science находится в Санта-Фе. Там есть такой Complexity University, Institute of Complexity Science, я когда-то там проходил стажировку. И один из способов изучения сложности… Сложностью мы называем состояние из простых объектов, между которыми есть какие-то связи. И молодежную систему мы создали уже из двух бактерий, трех веществ, которыми они обмениваются, какой-то еды, которая поступает, и кишечника. Мы даже в какой-то момент симулировали. Красные и синие бактерии — кишечник, и все это между собой общается. Это называется Agent Based Modeling. Можно эту историю запускать, а потом смотреть, получим ли мы что-то похожее на происходящее в реальной жизни. Например, мы получили систему с двумя стабильными точками, и точки отличаются в зависимости от того, как микробы распределены в кишечнике. На самом деле люди пока это померить не могут. Но мы тоже представляем, что одни живут ближе к стеночке, другие любят посерединке.

Потом мы за счет этой системы прием лекарств симулировали, и выяснили, что в каком-то случае вдруг вымирают все микробы, которые неустойчивы к лекарствам, и остаются только те, которые устойчивы. Таким образом резистентность может распространяться по планете.

Другая история — например, про ДНК. Я немножко расскажу вглубь про алгоритмы, про Data Science Day. Можно прям взять последовательности ДНК микробов. Мы работаем с последовательностью примерно в 200 букв. Попилим ее на k-меры —слова длиной k. Мы брали, по-моему, девятибуквенные слова. Можно дальше по этой подписи и частоте девятибуквенных слов пытаться сравнивать между собой микробный состав всех находящихся здесь людей. Что интересно, уже при таком подходе мы нашли таких людей, у которых было какое-то новое существо, и оно оставляло новый след из этих девятибуквенных слов. Про это даже где-то напечатали, в Bioinformatics. Тогда в указанном существе не было генома. Пока мы дописывали статью, геном появился, и мы явно доказали, что перед нами то самое существо, которое можно определить всего лишь по частоте букв, то есть по не очень сложной метрике.

Еще мы любим работать с графами. Я не очень понимаю, какой у тебя уровень. Я слышал предыдущее выступление. Понимаю, что уровень, наверное, какой-то супер-высоко-математическо-программистский, поэтому оставлю слово графы без объяснения.

Есть такие графы де Брёйна, в которых решается следующая задача: найти суперстроку, в которую будут входить все подстроки, и таким образом собрать геном маленького микроба, потому что люди могут его только по частям получать. И мы научились эти графы считать быстрее за счет того, что мы не обрезаем в них всякие хитрые разветвления, а оставляем их и умеем с ними работать в высокопроизводительных компьютерах. Кто бы мог подумать? И это тоже заслуга. То есть нерешенных задач с уже решенными методами здесь очень много.

Я специально привел обычного программиста, который пришел ко мне на работу два года назад, чтобы он от чистого сердца поделился тем, что он может сделать в биологии.

Анатолий Васильев, инженер-исследователь «Атласа»:

— Я пришел два года назад, у меня совсем не было биологического бекграунда. Мой опыт подсказывает: чтобы заниматься Data Science в биологии, необязательно иметь биологическое образование. Я хочу рассказать вам сегодня о том, чем я занимаюсь, на примере двух алгоритмов.

Первый — анализ уровня синтеза витаминов микробиоты человека, второй — text mining фактов про бактерии.

Что касается анализа уровней синтеза витаминов, задача может быть сформулирована так. На входе у нас есть множество матриц. Для начала, это так называемая матрица относительной представленности бактерий в образцах. Каждый образец — какой-то человек, микробиота конкретного человека. Таким образом, матрица говорит о том, какие бактерии у него есть в кишечнике. И затем это несколько справочных матриц из открытого проекта PICRUSt. Вот матрица о том, какие гены бактерий с какими ферментами связаны. Витамины состоят из ферментов. И на выходе мы хотим получить матрицу, в которой будет содержаться информация об уровнях синтеза витаминов в образцах. И, на самом деле, исходя из описания задачи уже видно, что она сводится к множеству операций агрегации и связывания матриц. И как data scientists — я один из них в числе этой команды — мы занимались реализацией алгоритма, проведением exploratory-анализа и всем, что связано с кодом. Но нам необходимо было руководство биолога для того, чтобы он преподнес нам концепцию алгоритма и помог понять, какие математические операции имеют и не имеют смысл с точки зрения биологии. Например, не всегда понятно, что корректно брать — медиану или среднюю.

Покажу вам heatmap. Он показывает способность микробиоты, образцов, к синтезу ферментов витамина B9. Чтобы микробиота могла его синтезировать, она должна также синтезировать все ферменты, из которых он состоит. Названия образцов немножко слились, но сейчас это не так важно. Исходя из этой heatmap мы можем увидеть некоторые группы образцов, у которых, например, все довольно хорошо с синтезом этого витамина. Почти все ферменты присутствуют. Но есть две группы образцов, у которых все хуже, и как data scientist я могу задать вопрос: что отличает группу этих образцов? Я могу сравнить эти образцы по их бактериальном составу или по каким-то метаданным. Может быть, все эти образцы принадлежат людям, которым за 40, например.

На самом деле у нас очень много матриц. В случае алгоритма анализа синтеза витаминов размер матрицы небольшой, он помещается в оперативной памяти, поэтому такой анализ легко провести у себя на ноутбуке. Но в случае, например, данных WGS (whole genome sequencing — полногеномные данные) у нас есть матрица о представленности 9 млн генов в 10 тыс. образцах, то есть это 9 млн столбцов и 10 тыс. строк. Такая матрица не помещается в оперативной памяти, поэтому нам нужны технологии для работы с Big Data, такие, например, как HBase — потому что он заточен под матрицы. Мы думаем, что с помощью Big Data-технологий мы можем собирать огромное количество биологических данных, накапливать их. Уже сейчас у «Кномикс» есть данные об относительной представленности бактерий и основанные на них результаты анализов. Например, уровни синтеза витаминов.

Дмитрий:

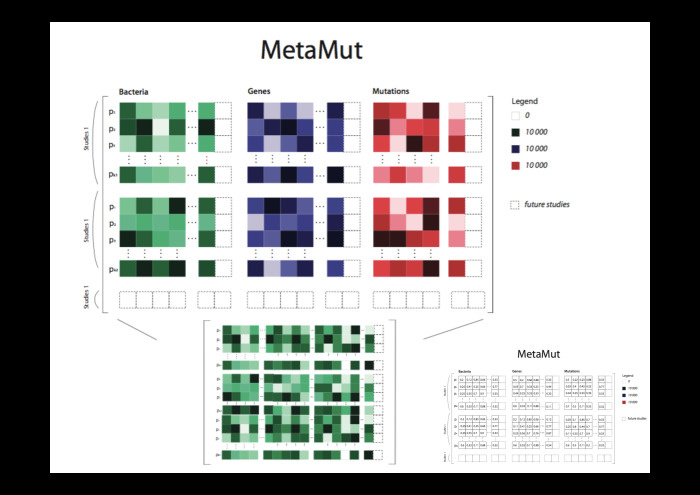

— Мы стали смотреть на все эти кучи матриц. У нас есть рабочее название MetaMut. Это такой проект, где мы можем представить в виде гигантской матрицы все исходные данные для биологических алгоритмов, которые мы используем в связи с микробами. Данные говорят, какие бактерии есть, какие гены, какие в этих генах мутации. Размерность матрицы мы прикидываем в районе 20 млн таких столбцов, а строк столько же, сколько образцов. И дальше каждый алгоритм, который люди официально выпускают в виде статьи, считающей что-то про микробов, мы на самом деле можем представить в виде набора матричных операций перемножений, сложений, транспонирований и т. ж. И тогда мы подходим не к биоинформатике, всей этой суперформализованной науке, а просто к правильному языку матричных операций. Если мы думаем и надеемся, что такую сложную историю про бактерии, гены, всякие обходы графов и так далее мы можем представить всего лишь в виде конечного набора матричных операторов… в этот самый момент описанный язык станет конструктором, с помощью которого любой data scientist, не погружаясь в смысл, сможет упражняться с матрицами. И когда он будет находить интересные свойства внутри матриц — с математическим образованием это не очень сложно, — у него всего останется лишь вопрос, есть ли здесь какая-то интерпретация. Он с этим вопросом будет возвращаться обратно к биологу.

Анатолий:

— Дальше я хотел рассказать про text mining фактов про бактерии. На входе этого алгоритма у нас есть корпус из 16 тыс. научных статей про микробиоту кишечника человека. И также у нас есть каталоги, они же словари названий бактерий, болезней, пробиотиков, еды. И мы хотим получить таблицу с предположительными фактами про бактерии. То есть это такие триплеты: бактерия, еда и как они между собой связаны. Среди наших инструментов для решения этой задачи были стандартные средства natural language processing —кстати, из пакета spaCy, а также ручная подготовка выборок. И именно здесь нам были необходимы биологи, чтобы они вычитывали предложения из этих статей, где мы ищем связи, и помечали их как positive или negative. Мы извлекали отношения между сущностями в этих предложениях, где сущность — это бактерия, еда. Оно у нас построено на поиске кратчайшего пути между словами в графе предложений. И у нас есть такая гипотеза, что по кратчайшему пути мы можем определить связь между двумя сущностями. Затем мы применяли transfer learning pipeline: это экстрактор фич и какой-то простой классификатор, simple classifier.

Я решил вставить небольшой пример кластеризации. Мы собрали много-много кратчайших путей из разных графов научных предложений, в которых встречалось какое-то название бактерий — например, Faecalibacterium prausnitzii — и какая-то еда или пребиотик инулин. Мы связывали эти две сущности в предложении, и получили много разных кратчайших путей в графах. И мы их кластеризовали, получив такую интересную картинку. На самом деле она нам говорит о том, что наша гипотеза, все эти кратчайшие пути в графах, возможно, действительно работают и как-то систематизируются. Это PCA.

Дмитрий:

— Здесь же есть другая важная история. Мы работаем с научными текстами. И люди, если честно, в научных текстах используют не всю глубину и выразительность английского языка. На самом деле, допустим, я как человек, который закончил физтех, могу определить человека, который закончил физтех по стандартным английским выражениям, которые он использует. Там в целом есть какой-то словарь-минимум. Для науки тоже существует такой словарь-минимум. И эта возможность классификации каких-то стандартных оборотов, которые сообщают нам факты, упрощает семантический анализ текста.

Мы дальше из Толиной работы взяли и построили граф заболеваний так, чтобы заболевания были ближе друг к другу, если сказано про то и про другое заболевание, если их связывает одна и та же бактерия. И это происходит чаще, чем в среднем. Оказывается, что просто проанализировав текст, связав заболевания с бактериями, а бактерии с заболеваниями, мы получаем граф связи заболеваний между собой. Какие-то воспалительные заболевания кишечника и диарея — вроде бы понятно, что они находятся вместе. Но когда здесь возникает болезнь Альцгеймера, которая вообще про другое, нежели диарея, то становится интересно. Вот яркий пример: биологи уже знают, что это может быть один и тот же процесс иммунитета, который приводит либо к нарушениям либо в кишечнике, либо в мозге. А эти — точно такие же — данные мы смогли получить просто посчитав, как тройки заданного формата связаны друг с другом.

Спасибо вам большое. Надеюсь, вы станете добрее относиться к нам, микробам, и к программистам, конечно.

|

|

[Из песочницы] Рисование толстых линий в WebGL |

Примеры подготовлены на базе движка OpenGlobus, который в данном случае используется как обертка над чистым Javascript WebGL.

— Пример для 2D случая

— Пример для 3D случая (используйте клавиши W,S,A,D,Q,E и курсор для перемещения)

Вступление

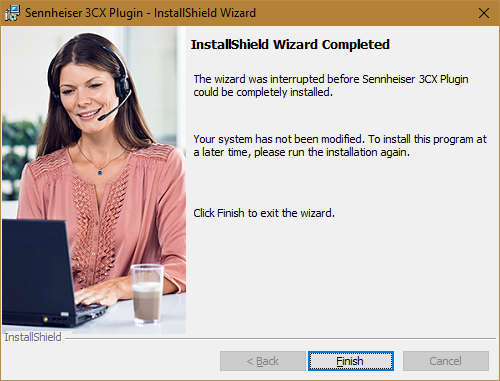

В процессе работы над картографической библиотекой мне потребовался инструмент позволяющий рисовать линии разной толщины. Конечно в WebGL есть механизм рисования линий, но задавать толщину линии к сожалению нельзя. Поэтому линии приходится рисовать полигонами, лучше сказать треугольниками. В интернете можно найти несколько отличных статей, как «триангулировать» линию, какие сложности при этом возникают и как их решать. К своему сожалению, я не нашел такую статью, из которой я мог бы скопировать код и использовать в своем шейдере.

После многочисленных часов проведенных с карандашом и бумагой за рисованием алгоритма, а затем многочисленных часов отладки совсем не сложного glsl шейдера, я наконец пришел к результату, которого можно было бы достичь гораздо быстрее. Надеюсь описанный далее подход рендеринга полигональных линий в WebGL сбережет время вашей жизни, которое в противном случае ушло бы на реализацию этой задачи!

Рисование линии в двухмерном пространстве

В моем движке для шейдеров рисования линий в двумерном и трехмерном пространствах используется практически один и тот же код. Разница лишь в том, что для трехмерного случая добавлено проецирование трехмерных координат линии на экран, затем тот же алгоритм.

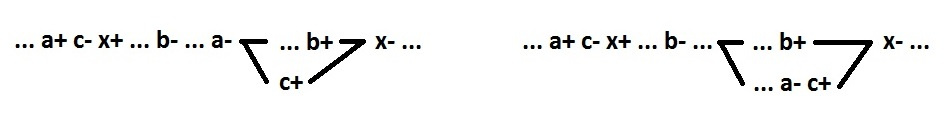

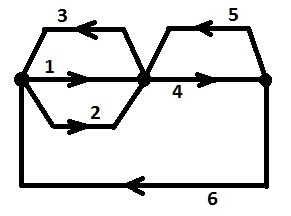

Существует расхожая практика для придания линиям толщины — представить каждый сегмент линии прямоугольником. Самое простое представление толстой линии выглядит так (рис. 1):

(рис. 1)

Чтобы избавиться от видимой сегментации в узловых точках, необходимо совместить смежные точки соседних сегментов, так чтобы сохранить толщину на обоих участках соседних сегментов. Для этого надо найти пересечение односторонних граней линии, сверху и снизу (рис. 2):

(рис. 2)

Однако угол между соседними сегментами, может быть настолько острым, что точка пересечения, может уйти далеко от точки соединения этих линий (рис. 3).

(рис. 3)

В таком случае этот угол необходимо как-то обработать (рис. 4):

(рис. 4)

Я решил, заполнять такие области соответствующими треугольниками. Мне на помощь пришла последовательность GL_LINE_STRING, которая при правильном порядке, должна в случае слишком острого угла (пороговое значение проверяется в вершинном шейдере) создавать эффект аккуратно обрезанного угла (рис. 5), либо совмещать смежные координаты соседних сегментов по правилу пересечения односторонних граней (рис. 2), как раньше.

(рис. 5)

Числа возле вершин — это индексы вершин, по которым происходит отрисовка полигонов в графическом конвейере. Если угол тупой, в этом случае треугольник для обрезания сольется в бесконечно тонкую линию и станет невидимым (рис. 6).

Про себя представляем последовательность таким образом(рис. 7):

(рис. 7)

Вот и весь секрет. Теперь давайте посмотрим, как это рендерить. Необходимо создать буфер вершин, буфер индексов и буфер порядка, который показывает в каком направлении от текущей вершины сегмента делать утолщение, а также, какая часть сегмента в данный момент обрабатывается вершинным шейдером, начальная или конечная. Для того, чтобы находить пересечение граней, кроме координат текущей точки, нам также необходимо знать предыдущую и следующую координаты от нее (рис. 8).

(рис. 8)

Итак, для каждой координаты в шейдере у нас должны быть, собственно, сама координата, предыдущая и следующая координаты, порядок точки т.е. является ли точка началом, или концом сегмента(я обозначаю -1, 1 — это начало и -2, 2 — конец сегмента), как должна она располагаться: сверху или снизу от текущей координаты, а также толщина и цвет.

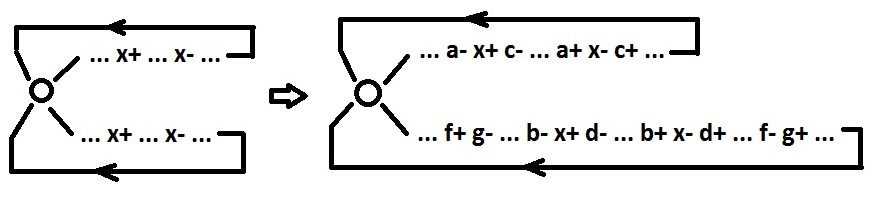

Т.к. WebGL позволяет использовать один буфер для разных атрибутов, то в случае, если элементом этого буфера является координата, при вызове vertexAttribPointer каждому атрибуту назначается в байтах размер элемента буфера, и смещение относительно текущего элемента атрибута. Это хорошо видно, если изобразить последовательность на бумаге (рис. 9):

(рис 9)

Верхняя строчка — это индексы в массиве вершин; 8 — размер элемента (координата тип vec2) т.е. 2х4 байта; Xi, Yi — значения координат в точках А, B, C; Xp = Xa — Xb, Yp = Yа — Yb, Xn = Xc — Xb, Yn = Xc — Xb т.е. вершины указывающие направление в пограничных точках. Цветными дугами изображены связки координат (предыдущая, текущая и следующая) для каждого индекса в вершинном шейдере, где current — текущая координата связки, previous — предыдущая координата связки и next — следующая координата связки. Значение 32 байт — смещение в буфере для того, чтобы идентифицировать текущее(current) относительно предыдущего (previous) значения координат, 64 байт — смещение в буфере для идентификации следующего(next) значения. Т.к. индекс очередной координаты начинается с предыдущего (previous) значения, то для него смещение в массиве равно нулю. Последняя строчка показывает порядок каждой координаты в сегменте, 1 и -1 — это начало сегмента, 2 и -2 — соответственно, конец сегмента.

В коде это выглядит так:

var vb = this._verticesBuffer;

gl.bindBuffer(gl.ARRAY_BUFFER, vb);

gl.vertexAttribPointer(sha.prev._pName, vb.itemSize, gl.FLOAT, false, 8, 0);

gl.vertexAttribPointer(sha.current._pName, vb.itemSize, gl.FLOAT, false, 8, 32);

gl.vertexAttribPointer(sha.next._pName, vb.itemSize, gl.FLOAT, false, 8, 64);

gl.bindBuffer(gl.ARRAY_BUFFER, this._ordersBuffer);

gl.vertexAttribPointer(sha.order._pName, this._ordersBuffer.itemSize, gl.FLOAT, false, 4, 0);

Так выглядит функция, которая создает массивы вершин и порядков, где pathArr — массив массивов координат по которым заполняются массивы для инициализации буферов outVertices — массив координат, outOrders — массив порядков и outIndexes — массив индексов:

Polyline2d.createLineData = function (pathArr, outVertices, outOrders, outIndexes) {

var index = 0;

outIndexes.push(0, 0);

for ( var j = 0; j < pathArr.length; j++ ) {

path = pathArr[j];

var startIndex = index;

var last = [path[0][0] + path[0][0] - path[1][0], path[0][1] + path[0][1] - path[1][1]];

outVertices.push(last[0], last[1], last[0], last[1], last[0], last[1], last[0], last[1]);

outOrders.push(1, -1, 2, -2);

//На каждую вершину приходится по 4 элемента

for ( var i = 0; i < path.length; i++ ) {

var cur = path[i];

outVertices.push(cur[0], cur[1], cur[0], cur[1], cur[0], cur[1], cur[0], cur[1]);

outOrders.push(1, -1, 2, -2);

outIndexes.push(index++, index++, index++, index++);

}

var first = [path[path.length - 1][0] + path[path.length - 1][0] - path[path.length - 2][0], path[path.length - 1][1] + path[path.length - 1][1] - path[path.length - 2][1]];

outVertices.push(first[0], first[1], first[0], first[1], first[0], first[1], first[0], first[1]);

outOrders.push(1, -1, 2, -2);

outIndexes.push(index - 1, index - 1, index - 1, index - 1);

if ( j < pathArr.length - 1 ) {

index += 8;

outIndexes.push(index, index);

}

}

};

Пример:

var path = [[[-100, -50], [1, 2], [200, 15]]];

var vertices = [],

orders = [],

indexes = [];

Polyline2d.createLineData(path, vertices, orders, indexes);

Получим:

vertices: [-201, -102, -201, -102, -201, -102, -201, -102, -100, -50, -100, -50, -100, -50, -100, -50, 1, 2, 1, 2, 1, 2, 1, 2, 200, 15, 200, 15, 200, 15, 200, 15, 399, 28, 399, 28, 399, 28, 399, 28]

orders: [1, -1, 2, -2, 1, -1, 2, -2, 1, -1, 2, -2, 1, -1, 2, -2, 1, -1, 2, -2]

indexes: [0, 0, 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 11, 11, 11, 11]

Вершинный шейдер:

attribute vec2 prev; //предыдущая координата

attribute vec2 current; //текущая координата

attribute vec2 next; //следующая координата

attribute float order; //порядок

uniform float thickness; //толщина

uniform vec2 viewport; //размеры экрана

//Функция проецирование на экран

vec2 proj(vec2 coordinates){

return coordinates / viewport;

}

void main() {

vec2 _next = next;

vec2 _prev = prev;

//Блок проверок для случаев, когда координаты точек равны

if( prev == current ) {

if( next == current ){

_next = current + vec2(1.0, 0.0);

_prev = current - next;

} else {

_prev = current + normalize(current - next);

}

}

if( next == current ) {

_next = current + normalize(current - _prev);

}

vec2 sNext = _next,

sCurrent = current,

sPrev = _prev;

//Направляющие от текущей точки, до следующей и предыдущей координаты

vec2 dirNext = normalize(sNext - sCurrent);

vec2 dirPrev = normalize(sPrev - sCurrent);

float dotNP = dot(dirNext, dirPrev);

//Нормали относительно направляющих

vec2 normalNext = normalize(vec2(-dirNext.y, dirNext.x));

vec2 normalPrev = normalize(vec2(dirPrev.y, -dirPrev.x));

float d = thickness * 0.5 * sign(order);

vec2 m; //m - точка сопряжения, от которой зависит будет угол обрезанным или нет

if( dotNP >= 0.99991 ) {

m = sCurrent - normalPrev * d;

} else {

vec2 dir = normalPrev + normalNext;

// Таким образом ищется пересечение односторонних граней линии (рис. 2)

m = sCurrent + dir * d / (dirNext.x * dir.y - dirNext.y * dir.x);

//Проверка на пороговое значение остроты угла

if( dotNP > 0.5 && dot(dirNext + dirPrev, m - sCurrent) < 0.0 ) {

float occw = order * sign(dirNext.x * dirPrev.y - dirNext.y * dirPrev.x);

//Блок решения для правильного построения цепочки LINE_STRING

if( occw == -1.0 ) {

m = sCurrent + normalPrev * d;

} else if ( occw == 1.0 ) {

m = sCurrent + normalNext * d;

} else if ( occw == -2.0 ) {

m = sCurrent + normalNext * d;

} else if ( occw == 2.0 ) {

m = sCurrent + normalPrev * d;

}

//Проверка "внутренней" точки пересечения, чтобы она не убегала за границы сопряженных сегментов

} else if ( distance(sCurrent, m) > min(distance(sCurrent, sNext), distance(sCurrent, sPrev)) ) {

m = sCurrent + normalNext * d;

}

}

m = proj(m);

gl_Position = vec4(m.x, m.y, 0.0, 1.0);

}

Пару слов в заключении

Данный подход реализован для рисования треков, орбит, векторных данных.

В заключении хочу добавить несколько идей, что можно сделать с алгоритмом, чтобы улучшить качество линий. Например, можно передавать для каждой вершины цвет в атрибуте colors, тогда линия станет разноцветной. Так-же каждой вершине можно передавать ширину, тогда линия будет меняться по ширине от точки к точке, а если рассчитывать ширину в точке (в вершинном шейдере) относительно удаленности от точки наблюдения (для трехмерного случая), можно добиться эффекта, когда часть линии расположенная ближе к точке наблюдения визуально больше, чем та часть линии, которая находится на отдалении. Еще можно реализовать сглаживание (antialiasing), добавив два прохода для каждого из краев толстой линии, в которых происходит рисование тонких линий (рамка по краям) с небольшой прозрачностью относительно центральной части.

|

Метки: author mgevlich webgl javascript glsl |

Игры на Scheme(Lisp) в среде DrRacket |

Для начала рассмотрим связь конечного автомата и игрового процесса.

Объект управления в игре можно представить в виде конечного автомата.

Рассмотрим программу, моделирующую светофор.

Этот пример был описан в предыдущей статье.

Переходом в другое устойчивое состояние является переключение сигнала светофора.

Диаграмму состояний можно изобразить в следующем виде.

Для того, чтобы создать светофор, нарисуем окружность в центре пустой сцены.

#lang racket

(require picturing-programs)

(define (DOT s) (circle 100 "solid" s))

s — это переменная, отвечающая за цвет. Переход в другое состояние можно представить

следующей конструкцией

(define (traffic-light-next s)

(cond

[(string=? "red" s) "green"]

[(string=? "green" s) "yellow"]

[(string=? "yellow" s) "red"]))

Для того, чтобы промоделировать переключение сигнала, используем функцию big-bang.

(big-bang "red"

[on-tick traffic-light-next 1]

[to-draw DOT])

Теперь светофор переходит в следующее устойчивое состояние 1 раз в секунду.

Управляющие воздействие в играх также могут оказывать платформы, препятствия, враги и т.д.

Например, в некоторых играх по ходу движения объект может «перескакивать»

на следующий канвас, т.е. приблизившись к границе канваса, объект исчезает

и появляется на противоположной границе. Условие перехода («перескакивания») определяется сравнением координат объекта и края канваса.

[(> (+ x DELTA) WIDTH) 0]

Если условие не выполнено, остаёмся на том же экране.

(cond

[(> (+ x dx) WIDTH) 0]

[else (+ x dx)] )

Движение определяется приращением DELTA к координате x

Напишем программу целиком

#lang racket

(require 2htdp/image)

(require 2htdp/universe)

(define WIDTH 100)

(define DELTA 1)

(define BALL (circle 5 "solid" "red"))

(define MT (empty-scene WIDTH 10))

(define (main x0)

(big-bang x0

[to-draw render]

[on-tick bounce]))

(define (bounce x)

(cond

[(> (+ x DELTA) WIDTH) 0]

[else (+ x DELTA)] ))

(define (render x)

(place-image BALL x 5 MT))

(main 50)

На этой странице представлены примеры программ, использующих big-bang. Запустить программы можно в режиме «Начинающий студент», добавив необходимые пакеты.

Далее напишем программу, в которой управление объектом осуществляется

клавишами «left» и «right».

Здесь нам понадобится функция для обработкой клавиш.

#lang racket

(require 2htdp/image)

(require 2htdp/universe)

(define BACKGROUND (empty-scene 100 100))

(define DOT (circle 10 "solid" "red"))

(define (place-dot-at x)

(place-image DOT x 50 BACKGROUND))

(define (change-func p k) ; обработка клавиш

(cond

[(string=? "left" k)

(- p 5)]

[(string=? "right" k)

(+ p 5)]

[else p]))

( big-bang 50

[to-draw place-dot-at]

[on-key change-func] )

Если же нам также необходимо обрабатывать нажатия клавиш «up», «down»,

то координаты объекта следует хранить в структуре вида

(define-struct posn (x y))

(define INIT-WORLD (make-posn 100 100))

Напишем программу, в которой объект может перемещаться по горизонтали и вертикали.

#lang racket

(require picturing-programs)

(define WIDTH 200)

(define HEIGHT 200)

(define BACKGROUND (empty-scene WIDTH HEIGHT))

(define obj1 (circle 10 "solid" "red"))

(define-struct posn (x y)) ;объявляем структуру

(define INIT-WORLD (make-posn 100 100) )

(define (change-current-world-key current-world a-key-event) ;обработка "событий" клавиатуры

(cond

[(key=? a-key-event "up")

(make-posn (posn-x current-world) (- (posn-y current-world) 5))]

[(key=? a-key-event "down")

(make-posn (posn-x current-world) (+ (posn-y current-world) 5))]

[(key=? a-key-event "left")

(make-posn (-(posn-x current-world)5) (posn-y current-world) )]

[(key=? a-key-event "right")

(make-posn (+(posn-x current-world)5) (posn-y current-world) )]

[else current-world]))

(define (redraw current-world)

(place-image obj1

(posn-x current-world)

(posn-y current-world)

BACKGROUND))

(big-bang INIT-WORLD

(on-key change-current-world-key)

(on-draw redraw) )

Да, но обычно в играх присутствует несколько объектов.

Напишем программу, в которой присутствует два объекта.

Используем две структуры: world и posn.

#lang racket

(require picturing-programs)

(define WIDTH 300)

(define HEIGHT 300)

(define BACKGROUND (empty-scene WIDTH HEIGHT))

(define obj1 (circle 10 "solid" "red"))

(define obj2 (circle 10 "solid" "green"))

(define-struct posn (x y))

(define-struct world [obj1 obj2])

; Инициализация параметров в структуре world

(define INIT-WORLD (make-world (make-posn 100 100) (make-posn 200 100)))

(define (draw-game world)

(place-image

obj1

(posn-x (world-obj1 world))

(posn-y (world-obj1 world))

(place-image

obj2

(posn-x (world-obj2 world))

(posn-y (world-obj2 world))

BACKGROUND)))

(big-bang INIT-WORLD

[to-draw draw-game])

Теперь для того, чтобы управлять одним из объектов, добавим функцию обработки клавиш.

#lang racket

(require picturing-programs)

(define WIDTH 300)

(define HEIGHT 300)

(define BACKGROUND (empty-scene WIDTH HEIGHT))

(define obj1 (circle 10 "solid" "red"))

(define obj2 (circle 10 "solid" "green"))

(define-struct posn (x y))

(define-struct world [obj1 obj2])

(define INIT-WORLD (make-world (make-posn 50 150) (make-posn 250 150)))

(define (change-current-world-key current-world a-key-event)

(make-world (change-obj1 (world-obj1 current-world) a-key-event)

(world-obj2 current-world)))

(define (change-obj1 a-posn a-key-event)

(cond

[(key=? a-key-event "up")

(make-posn (posn-x a-posn) (- (posn-y a-posn) 5))]

[(key=? a-key-event "down")

(make-posn (posn-x a-posn) (+ (posn-y a-posn) 5))]

[(key=? a-key-event "left")

(make-posn (-(posn-x a-posn) 5) (posn-y a-posn) )]

[(key=? a-key-event "right")

(make-posn (+(posn-x a-posn)5) (posn-y a-posn) )]

[else a-posn]))

(define (draw-game world)

(place-image

obj1

(posn-x (world-obj1 world))

(posn-y (world-obj1 world))

(place-image

obj2

(posn-x (world-obj2 world))

(posn-y (world-obj2 world))

BACKGROUND)))

(big-bang INIT-WORLD

(on-key change-current-world-key)

[to-draw draw-game] )

Более подробно о создании игр можно прочитать в книге How to Design Worlds.

|

Метки: author demser функциональное программирование программирование lisp создание игр scheme drracket htdp htdw |

[recovery mode] Пользовательские типы в PHP |

PHP 7 оснащён расширенной системой контроля типов аргументов, включающей не только классы, но и скаляры. Однако в том, что касается сложных структур данных, ничего не изменилось — для них существует единственный тип array, который в PHP может содержать всё, что угодно.

Я надеюсь, что новые версии PHP исправят ситуацию. А на данный момент я хочу поделиться с сообществом некоторыми своими наработками в этой области:

perspectea/typedef

perspectea/generics

typedef

Репозиторий на GitHub: https://github.com/perspectea/typedef

Версия PHP: 7.0

Эта библиотека предназначена непосредственно для работы с типами.

Вы можете определить собственный тип данных с помощью функции Tea\typedef:

function typedef(string $aName, IType $aType): IType;Вы можете как создать и инстанцировать собственный класс, реализующий интерфейс Tea\Typedef\IType, так и использовать встроенные.

Для обращения к типу предназначена функция Tea\type:

function type(string $aName): IType;Она принимает в качестве аргумента имя типа (аргумент aName функции typedef), и возвращает соответствующий объект.

Чтобы проверить значение на соответствие типу, воспользуйтесь функцией Tea\is:

function is($aValue, IType $aType): bool;или методом validate самого объекта типа:

function IType::validate($aValue): bool;Определены следующие встроенные типы (пространство имён Tea):

function bool(): BoolType;Логическое значение true/false.

function number(float $aMin = null, float $aMax = null): NumericType;

function int(int $aMin = null, int $aMax = null): IntType;

function uint(int $aMax = null): UIntType;Числовые типы.

Тип NumericType соответствует PHP-типам int и float.

Являющийся его наследником тип IntType соответствует только PHP-типу int.

Оба типа могут быть ограничены минимальным и максимальным значениями.

Тип UIntType, являющийся наследником IntType, соответствует целым числам без знака — его минимальным значением является 0, а максимальное может быть определено.

function string(int $aLength = null): StringType;Строковый тип, может быть ограничен по максимальной длине.

Вы можете использовать self-return метод fix, чтобы сделать ограничение по длине строгим — в этом случае будут допустимы только строки, длина которых равна заданной.

function regexp(string $aRegularExpression): RegExpType;Регулярное выражение.

function enum(...$aValues): EnumType;Перечислимый тип.

Ограничивает множество допустимых значений заданным набором.

function object(string $aClass = null): ObjectType;Объектный тип.

Значение может быть только объектом заданного класса (интерфейсы так же допустимы).

Я не до конца уверен, стоит ли для данного типа давать возможность проверки использования трэйта — на мой взгляд, это нарушило бы инкапсуляцию.

function nullable(IType $aType): NullableType;Nullable-тип.

Дополняет множество допустимых значений дочернего типа значением null.

function any(IType ...$aTypes): MultiType;Множественный тип.

Объединяет множества допустимых значений всех дочерних типов.

function lot(int $aLength = null): ArrayType;Массивный тип (ключевое слово array не допустимо в качестве имени функции), может быть ограничен по максимальной длине.

Значение может быть массивом или объектом, реализующим интерфейсы ArrayAccess, Countable и Traversable (вы можете дополнительно ограничить множество допустимых значений с помощью self-return методов acceptArray и acceptObject).

Чтобы задать допустимый тип значений массива, используйте self-return метод of(IType), а для ключей используйте self-return метод by(IType). Если вы зададите тип ключей, отличный от PHP-типов int и string, тип будет иметь смысл только в отношении объектов, поскольку у массивов PHP не может быть ключей других типов.

Так же, как и для строкового типа, вы можете использовать self-return метод fix, чтобы сделать ограничение по длине строгим.

function struct(IField ...$aFields): StructType;Структурный тип.

Значение, так же как и в случае массивного типа, может быть массивом или объектом с массивным доступом, и так же может быть дополнительно ограничено с помощью self-return методов acceptArray и acceptObject.

Членами структурного типа являются поля — объекты класса, реализующего интерфейс Tea\Typedef\IField. Переданное для валидации значение является валидным, если оно является массивом или объектом с массивным доступом (в соответствии с дополнительными ограничениями) и проходит валидацию всех полей.

Определены следующие встроенные виды полей:

function field(string $aName, IType $aType = null): Field;Обычное поле. Не является самостоятельным типом.

При валидации проверяется, содержит ли переданное значение ключ, соответствующий имени поля, а так же соответствует ли значение этого ключа указанному типу, если он задан.

function optional(IField $aField): OptionalField;Опциональное поле. Не является самостоятельным типом.

Допускает отсутствие в переданном значении ключа, соответствующего дочернему полю.

function union(IField ...$aFields): Union;Объединение. Является самостоятельным типом.

Для успешной валидации переданного значения необходимо, чтобы оно обязательно проходило валидацию только одного из дочерних полей.

Для наглядной демонстрации работы библиотеки рассмотрим следующий пример:

typedef('input', struct(

field('name', string()),

field('authors', any(

string(),

lot()->of(string())

)),

optional(union(

field('text', string()),

field('content', struct(

field('title', string(255)),

optional(field('annotation', string(65535))),

field('text', string()),

optional(field('pages', nullable(uint(5000))))

))

)),

field('read', enum(false, true, 0, 1, 'yes', 'no'))

));

if (PHP_SAPI === 'cli') {

$input = [];

parse_str(implode('&', array_slice($argv, 1)), $input);

} else {

$input = $_GET;

}

echo "Validation: " . (is($input, type('input')) ? 'success' : 'failed') . "\n";Этот код проверяет корректность переданного описания элемента книжной серии:

- Обязательный параметр name должен быть строкой произвольной длины.

- Обязательный параметр authors должен быть строкой произвольной длины или массивом таких строк.

- Может быть передан параметр text, являющийся строкой произвольной длины, либо составной параметр content.

- Обязательный параметр read должен иметь одно из указанных значений.

Такой набор параметров будет валидным:

name="The Lord of the Rings"

authors[]="J. R. R. Tolkien"

content[title]="The Return of the King"

content[text]=...

read=yesА такой не пройдёт проверку:

name="The Lord of the Rings"

authors[]="J. R. R. Tolkien"

text=...

content[title]="The Return of the King"

content[text]=...

read=yesgenerics

Репозиторий на GitHub: https://github.com/perspectea/generics

Версия PHP: 7.0

Эта библиотека вводит некоторое подобие дженериков. Основными являются два вида объектов-массивов:

Tea\Generics\IndexedArray(array $aValues = null, callable $aValueConstraintCallback = null);Обычный массив с упорядоченными индексами. Для него может быть задано ограничение значений элементов — функция со следующей сигнатурой:

function ($aValue): bool;Tea\Generics\AssocArray(array $aValues = null, callable $aKeyConstraintCallback = null, callable $aValueConstraintCallback = null);Ассоциативный массив. Для него аналогичным образом могут быть заданы ограничения значений ключей и элементов. Ключами ассоциативного массива могут быть любые значения, а не только целые числа и строки.

Так же определены следующие встроенные конструкторы (пространство имён Tea):

function values(...$aValues): IndexedArray;Индексированный массив с произвольными значениями.

function numbers(float ...$aValues): NumericArray;

function integers(int ...$aValues): IntArray;

function cardinals(int ...$aValues): UIntArrayИндексированный массив чисел. Соответственно любых (float и int), целых (int) и беззнаковых целых (int >= 0).

function strings(string ...$aValues): StringArrayИндексированный массив строк.

function objects(string $aClass, array $aValues = null): ObjectArray;Индексированный массив объектов заданного класса (интерфейса).

function map(array $aItems = null): AssocArray;Ассоциативный массив с произвольными ключами и значениями.

function dict(array $aItems = null): Dictionary;Ассоциативный массив со строковыми ключами и произвольными значениями.

function hash(array $aItems = null): StringDictionary;Ассоциативный массив со строковыми ключами и значениями.

function collection(IType $aType, array $aValues = null): Collection;Индексированный массив значений, соответствующих заданному типу (см. typedef).

Вместо заключения

Хотя всё это — в некоторой степени набор велосипедов, но я надеюсь, что он может кому-то пригодиться в работе. typedef может быть удобен для проверки параметров скрипта вместе с их преобразованием с помощью json_decode. А «дженерики» (хотя это не совсем дженерики в привычном понимании) могут пригодиться для ограничения типов массивов в аргументах с помощью уже готовых инструментов.

Можно было бы добавить типизированные свойства объектов, оформить библиотеки в виде расширений для улучшения производительности или сделать ещё что-нибудь необдуманное, но пока я не вижу в этом острой необходимости.

Так же я буду рад выслушать конструктивную критику и что-то улучшить в этих несложных инструментах или узнать про какой-нибудь silver-bullet, просвистевший мимо меня.

Благодарю за ваше внимание!

|

Метки: author altgamer php типы данных массивы дженерики |

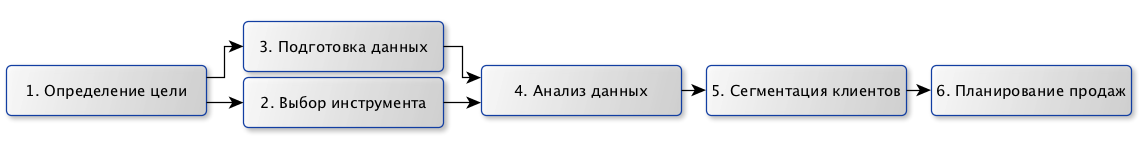

Дайджест интересных материалов для мобильного разработчика #208 (13 июня — 18 июня) |

|

Тестируем возможности ARKit. Создаем игру с дополненной реальностью |

|

May the Code Review be with you |

|

Как технологии Яндекс.Такси приближают будущее личного и общественного транспорта |

Дайджест доступен и в виде рассылки. Подписаться вы можете тут.

iOS

iOS- (+10) Работа с сервером с помощью Alamofire на Swift

- (+7) Туториал по AsyncDisplayKit 2.0 (Texture): автоматическая компоновка

- Фичеринг в App Store: нюансы сегодня и завтра

- Apple работает над возможностью хранения в iPhone медицинских данных

- Как зарабатывать $80,000 в месяц в App Store

- Apple разрешила чаевые и пожертвования через встроенные покупки

Как расширить свое приложение SiriKit

Как расширить свое приложение SiriKit Создаем нормальные пуш-уведомления

Создаем нормальные пуш-уведомления Портирование iOS-приложения на macOS

Портирование iOS-приложения на macOS Руководство по быстродействию скрола от OkCupid

Руководство по быстродействию скрола от OkCupid YapImageManager: быстрый загрузчик картинок

YapImageManager: быстрый загрузчик картинок Gagat: библиотека для красивого переключения между темами

Gagat: библиотека для красивого переключения между темами

Android

Android- (+20) Утечки памяти в Android и способы их локализации

- (+6) Android: динамически подгружаем фрагменты из сети

- Shortcuts в Android 7.1

- Google выпустил Play Billing Library для упрощения работы со встроенными покупками

- В Google Play появилась подборка Android Excellence

Android Instant Apps шаг за шагом: как Vimeo использует их

Android Instant Apps шаг за шагом: как Vimeo использует их Android Dialogs: App Shortcuts

Android Dialogs: App Shortcuts Пользовательское тестирование Android приложений

Пользовательское тестирование Android приложений Исследуем Android O: бейджи уведомлений

Исследуем Android O: бейджи уведомлений Анимация меню

Анимация меню Просто Android Things

Просто Android Things Обеспечиваем качественный код для Android

Обеспечиваем качественный код для Android Как применить Kotlin на существующем Java коде

Как применить Kotlin на существующем Java коде

Windows

Windows Разработка

Разработка- (+17) Дневник одной разработки, или Xamarin как он есть

- (+12) Самое простое руководство по иконографике

- (+11) Оптимизация использования памяти в Xamarin приложениях

- (+9) Топ 15 бесплатных Unity ассетов для начинающего 2D разработчика

- (+7) Адаптация Xamarin.Forms к разработке корпоративных и B2E приложений

- (+7) Создание VR-игры от третьего лица

- (+6) Дизайн как всемирный язык 21 века

- (+4) Лайфхаки редактора Unity 3D. Часть 1: Атрибуты

- Использование Cloud Functions в Firebase

- Что вам нужно знать о Firebase: 9 советов

- Samsung объявил победителей конкурса ШКОЛА VR 360

- Py учит программированию в стиле Duolingo

- Facebook нанял главу понимания речи Apple

- “Сети идей” – это платформы будущего

- Game Jam Mail.ru 2017: как это было, наше второе место и почему не первое

- LinkedIn: художники – самые популярные работники в игровой индустрии

- BlackBerry выпускает BBM Enterprise SDK

- “Руководство по SDK для мобильных приложений” от Appsee

- Google выпустил Blockly 1.0 для Android и iOS

- Кейс UTair: разработка мобильного приложения за полгода и рост продаж на 300%

Лучшие конференции Июня-Августа 2017

Лучшие конференции Июня-Августа 2017 Чему я научился за 2 года разработки и продвижения мобильных игр

Чему я научился за 2 года разработки и продвижения мобильных игр Видео конференции Facebook Data @Scale 2017

Видео конференции Facebook Data @Scale 2017

Аналитика, маркетинг и монетизация

Аналитика, маркетинг и монетизация- (+12) Мобильный ретаргетинг: как измерять эффективность

- (+12) Тест на знание мобильной рекламы в Facebook

- Tencent намеревается купить Rovio за $3 млрд

- Половина рекламы в мобильных приложениях получает отклик от пользователей

- Criteo Direct Bidder помогает издателям увеличить выручку от продажи рекламы

- Wargaming запустил мобильное издательство Wargaming Mobile

- Кейс Coffee Cup: продвижение кофейного приложения в социальных сетях

Геймификация в мобильных приложений: 5 вещей, которые надо помнить

Геймификация в мобильных приложений: 5 вещей, которые надо помнить

Устройства, IoT, AI

Устройства, IoT, AI< Предыдущий дайджест. Если у вас есть другие интересные материалы или вы нашли ошибку — пришлите, пожалуйста, в почту.

|

Метки: author EverydayTools разработка под ios разработка под android разработка мобильных приложений разработка игр блог компании everyday tools app store ark firebase яндекс |

Список доменов в зоне ru/su/tatar/рф/дети утек в публичный доступ из-за некорректной настройки DNS |

AXFR-запрос доступен на следующих серверах:

- a.dns.ripn.net

- b.dns.ripn.net

- d.dns.ripn.net

Чтобы получить все домены зоны, можно воспользоваться утилитой dig из состава BIND:

$ dig axfr su. @a.dns.ripn.net

; <<>> DiG 9.10.4-P8-RedHat-9.10.4-5.P8.fc25 <<>> axfr su. @a.dns.ripn.net

;; global options: +cmd

SU. 345600 IN SOA a.dns.ripn.net. hostmaster.ripn.net. 650170097 86400 14400 2592000 3600

SU. 345600 IN RRSIG SOA 8 1 345600 20170728095315 20170618085528 12810 su. AMqjxdOOp9rIVMk9gvH6TiXEB8FAWZn0xbqxxYxsQMYrqCUE49AXSUQ1 nESJ//bPE8g7mNa/KCqrt21icAOG6+gzwes+TZ2nu62dwbwH3IeEoxry GZ+uEIGlQfjPC6AxRuPELnaKRpLUy+Ir28ScJDLjIBewVs3J7zAHXw/K bYU=

SU. 345600 IN NS a.dns.ripn.net.

SU. 345600 IN NS b.dns.ripn.net.

SU. 345600 IN NS d.dns.ripn.net.

SU. 345600 IN NS e.dns.ripn.net.

SU. 345600 IN NS f.dns.ripn.net.

…

0--0.SU. 345600 IN NS ns1.shop.reg.ru.

0--0.SU. 345600 IN NS ns2.shop.reg.ru.

0--GDE-KUPIT-DOMEN-DESHEVO--RU--SU--COM--NET--ORG--INFO--ME--TV.SU. 345600 IN NS ns1.hostmonster.com.

0--GDE-KUPIT-DOMEN-DESHEVO--RU--SU--COM--NET--ORG--INFO--ME--TV.SU. 345600 IN NS ns2.hostmonster.com.

0-0.SU. 345600 IN NS dns1.yandex.net.

0-0.SU. 345600 IN NS dns2.yandex.net.

0-0-0.SU. 345600 IN NS ns1.shop.reg.ru.

0-0-0.SU. 345600 IN NS ns2.shop.reg.ru.

0-1.SU. 345600 IN NS dns1.elasticweb.org.

0-1.SU. 345600 IN NS dns2.elasticweb.org.

0-3.SU. 345600 IN NS ns1.timeweb.ru.

0-3.SU. 345600 IN NS ns2.timeweb.ru.

0-4.SU. 345600 IN NS ns.hostland.ru.

0-4.SU. 345600 IN NS ns3.hostland.ru.

…| Зона | Количество доменов |

|---|---|

| .ru | 5325898 |

| .su | 109719 |

| .tatar | 869 |

| .рф | 796707 |

| .дети | 1066 |

Зона .ru содержит в себе 5.1% всех мировых доменов, уступая только первой по популярности зоне .com.

Данная особенность DNS была обнаружена mandatoryprogrammer (Matthew Bryant), который давно занимается отслеживанием изменений всех доменных зон автоматизированными средствами. Зона .ru такая большая, что его ПО упало от недостатка оперативной памяти. В прошлом году он обнаружил возможность получения всех доменов северокорейской зоны .kp, используя этот же метод.

Дампы зон, сжатые xz, можно скачать через Bittorrent и I2P Bittorrent, torrent-файлом или по следующей Magnet-ссылке:

magnet:?xt=urn:btih:3457106ce62b2707639978d802e20567e278aa39&dn=Russian%20domain%20zones&tr=udp%3a%2f%2ftracker.leechers-paradise.org%3a6969&tr=udp%3a%2f%2ftracker.coppersurfer.tk%3a6969%2fannounce&tr=udp%3a%2f%2fp4p.arenabg.com%3a1337%2fannounce&tr=udp%3a%2f%2ftracker.zer0day.to%3a1337%2fannounceНе обязательно их распаковывать, можно работать с ними в сжатом виде. Используйте xzcat вместо cat, xzdiff вместо diff, xzgrep вместо grep, xzless вместо less.

|

Метки: author ValdikSS администрирование доменных имен dns домены axfr |

[Из песочницы] Система синтеза самосинхронных схем Petrify: проблемы и их решение |

В чем причина этих неудач? Я бы назвал 3 основные:

1. Увлеченность STG. Да, это красивая, забавная модель, очень интересно играть маркерами и т.п. Но, подумайте, процесс переключения сигналов схемы это такой же процесс как выполнение какой-либо программы. Мы используем для описания программы сети Петри? Для чего тогда они нужны при описании процессов, происходящих в схеме? В результате разработчики Petrify львиную долю своих усилий потратили на изучение свойств сетей Петри. А собственно задачи синтеза схем так и не были решены.

2. Упор на «вычислительность». Под этим я подразумеваю убежденность, что для синтеза схем обязательно нужно вычислять логические функции. Как результат, вместо решения задач синтеза, исследовались только возможности уменьшения таких вычислений.

3. Неспособность разобраться в причинах возникающих проблем. Но об этом ниже.

А есть ли в Petrify, что-либо хорошее? Да, есть! Это — ДЕКОМПОЗИЦИЯ. На самом деле это естественный, фундаментальный и прекраснейший метод. Важно только разобраться в причинах, почему обычно невозможна декомпозиция до минимальных двухвходовых элементов без нарушения спид-индепендед. А причина этого — кратные сигналы. Под этим я подразумеваю сигналы, которые переключаются более чем 2 раза за цикл, или же сигналы переключающиеся в двух и более альтернативных ветвях. Авторами Petrify этот факт установлен не был, чему свидетельство «жадный» алгоритм добавления дополнительных сигналов. При этом количество дополнительных сигналов уменьшается за счет увеличения числа переключений таких сигналов. Да, это уменьшает объем вычислений (которые, как я покажу ниже вообще не нужны), но создает дополнительные проблемы для декомпозиции.

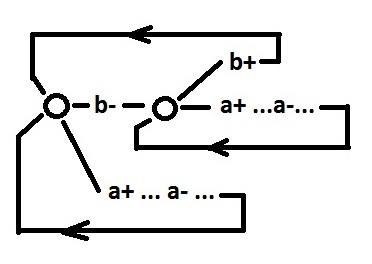

Покажу на примере что я имею ввиду. Рассмотрим поведение со следующими ограничениями:

1. нет выбора;

2. нет параллелизма;

3. нет входных сигналов;

4. поведение знакочередуемое, за "+" следует "-", за "-" — "+";

5. все сигналы переключаются строго по 2 раза.

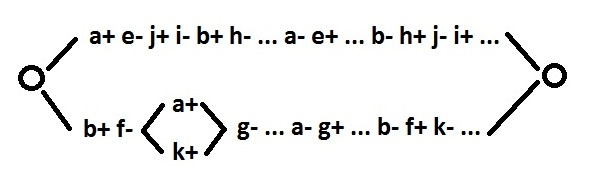

Устранение CSC противоречий, даже с сохранением выше перечисленных ограничений, ни у кого вызывать проблем не должно. Теперь каждый сигнал представим в виде триггера:

было:

стало:

После этого уравнение в общем виде для каждого сигнала выглядит так:

Поведение сигналов этого уравнения выглядит так:

Вычислять такое уравнение нет необходимости. Нужно на графе найти цепочку подхватов a, b, c, d (против часовой стрелки) от x-, перескакивающую через x+. CSC свойство это обеспечивает.

А теперь сделаем декомпозицию этого уравнения:

Поведение будет выглядеть так:

Как видно таким образом можно синтезировать спид-индепендент схему на двухвходовых элементах. Кажется что представление каждого сигнала в виде триггера выглядит громоздко, но далеко не для каждого сигнала в этом есть необходимость. Возникающие при этом нарушения знакочередуемости решаются очень легко, что я покажу ниже.

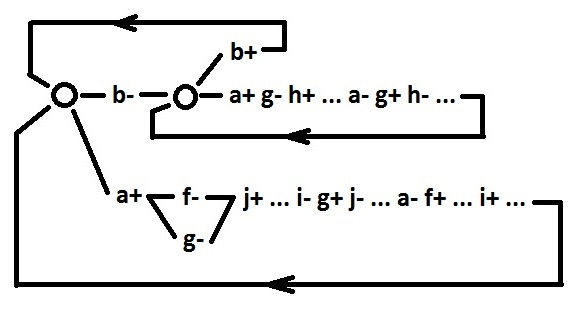

Итак, мы можем синтезировать схему на двухвходовых элементах для любого поведения, удовлетворяющего 5 выше перечисленным ограничениям. Начнем эти ограничения постепенно снимать.

Снимем ограничение 4 — требование знакочередуемости. В получающейся итоговой схеме все двухвходовые элементы имеют два вида поведения:

Отмена ограничения 4 может создать только одну проблему: рассогласованность направления переключений между сигналами a и b. Это исправляется введением инвертора (сигнал c). Опять же без нарушения спид-индепендед.

В связи с этим знаки можно расставить в самом конце процесса синтеза схемы (с целью минимизации количества дополнительных инверторов).

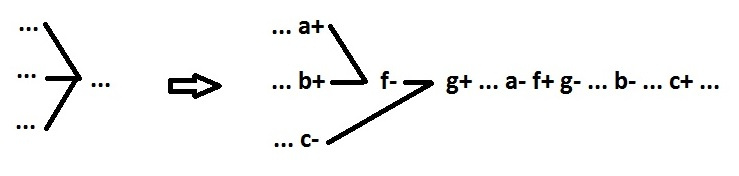

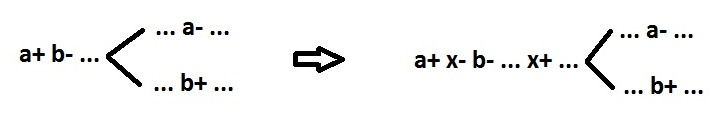

Снимем ограничение 3, введем входные сигналы. Так как переключение дополнительного сигнала делать причиной переключения входного сигнала плохая практика, мы это запретим. Всвязи с этим могут возникнуть проблемы, признаком которых является ситуация, когда переключение входного сигнала является причиной переключения входного сигнала. Всего выделяются 3 класса проблемных поведений.

1 класс. В упрощенном виде это переключение входного сигнала дважды подряд: