Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Как управлять SSH-ключами на уровне предприятия |

Как управлять SSH-ключами на уровне предприятия

Ключи используются для системной автоматизации и аутентификации, интеграции приложений, управления системой и других общих функций. Пользуясь ими, злоумышленник может продвинуться глубже в сеть компании. Поэтому сегодня мы говорим об управлении SSH-ключами.

/ Pexels / Caio / CC

Чем грозит слабый SSH-key-менеджмент?

SSH-ключи задуманы в качестве упрощенного способа входа на сервер без необходимости ввода пароля. Как рассказывает Тату Улёнен (Tatu Ylonen), создатель SSH и генеральный директор компании SSH Communications Security, специализирующейся на корпоративной защите, на одном сервере накапливаются от 50 до 200 ключей. В случае с крупными предприятиями их количество исчисляется сотнями тысяч, а иногда — миллионами.

Как правило, их создают разработчики и администраторы баз данных, чтобы упростить аутентификацию. В итоге, по словам Тату, около 90% ключей, созданных за годы, а порой и за десятилетия, не используются, но остаются активными. Более того, около 10% этих ключей предоставляют root-доступ. Что это означает для злоумышленников? В их распоряжении оказывается безграничное поле для маневров.

Опрос Ponemon Institute, проведенный в 2014 году среди 2,1 тыс. системных администраторов из числа компаний Global 2000, показал, что три из четырех предприятий уязвимы для атак из-за слабой защиты ключей для SSH.

Проблема заключается в том, что отдельные ключи открывают доступ не только к конкретному серверу, но и прокладывают путь к другим сетевым элементам. Это позволяет проводить затяжные, незаметные атаки, способные подорвать всю инфраструктуру предприятия. Имея в распоряжении ключи, можно установить вредоносное ПО в прошивку или стереть любые данные на серверах и системах хранения, включая все бэкапы.

Разумеется, недобросовестная политика управления ключами открывает возможности для корпоративного шпионажа. Например, атака на Sony Pictures в 2014 году с похищением конфиденциальной информации, как считается, произошла именно благодаря уязвимости SSH.

В контексте IoT есть и более серьезная опасность: SSH-ключи могут открыть доступ к аппаратным средствам. Тату Улёнен рассказал, что производители все чаще стремятся оптимизировать процесс и прибегают к удаленным технологиям управления, полагаясь на защищенность сетевого протокола. Тем временем ключевые файлы SSH продаются на «черных рынках», и с помощью них конкуренты могут получить доступ к камерам наблюдения или вызвать сбой в системе защиты компании. Сценариев атак достаточно много, а последствия их непредсказуемы.

«Для исправления этого нет универсального решения. Это даже не техническая проблема — это проблема управления», — утверждает Тату.

Разные ключи служат для осуществления различных функций: от восстановления резервных копий для дата-центров до исполнения транзакций. Поэтому грамотное управление SSH-ключами подразумевает под собой понимание значения каждого элемента, а значит, чем раньше будет взят на вооружение предприятием так называемый «key-менеджмент», тем эффективнее будет выстроена оборона.

Как выстроить управление SSH-ключами на предприятии

Тату Улёнен предлагает три основных направления работы с ключами: мониторинг, администрирование и автоматизация. В разговоре об уязвимости SSH он сетовал на то, что у большинства организаций до сих пор нет инструментов для отслеживания актуальных ключей. Соответственно, нет понимания того, кто и зачем их установил и когда их следует удалять.

Некоторые предприятия используют Excel для учета. Системы управления ключами на основе бумажных или электронных таблиц используются 57% компаний, согласно исследованию Global Encryption Trend Study от 2016 года. Однако, как отмечает специалист в области кибер-безопасности Майкл Кобб (Michael Cobb), такой подход подвержен ошибкам, оттого не может быть эффективным.

«Такой файл очень быстро теряет свою актуальность, часть ключей не вносят, часть не удаляют, информацию вовремя не меняют, а потом забывают. Это приводит к колоссальному расхождению с реальной картиной, — говорит начальник отдела развития проекта 1cloud Сергей Белкин. — Более того, сразу возникает соблазн организовать удаленный доступ к такому файлу. Были случаи, когда пользователи выкладывали его, например, в Dropbox. А за последние годы подобные сервисы не раз страдали от масштабных утечек данных».

Что касается автоматизации, Тату Улёнен приводит пример одного из трех крупнейших банков в США, в штате которого насчитывалось 200 системных администраторов. 10% команды занималась исключительно SSH-ключами. Кроме нерационального использования ресурсов, в такой ситуации повышается риск, связанный с человеческим фактором. Например, возможность случайного присвоения ключу root-доступа.

Согласно Тату, безопасность предприятия начинается с создания стратегии управления жизненным циклом ключей SSH, а затем перетекает в обязательное применение этой стратегии. Опрос Ponemon демонстрирует непопулярность такого подхода: около 74% респондентов заявили, что они позволяют администраторам самостоятельно контролировать и управлять ключами. В результате команды безопасности предприятия часто не видят масштабов проблемы.

Компаниям стоит адаптировать процессы по автоматизированному удалению ключей с уходом людей, которым они принадлежали. В то же время некоторыми компаниями активно используется метод учета ключей с момента запуска сервера. Так, 1cloud предоставляет доступ к панели управления, где в удобной форме хранятся все ключи, причем генерация секретных ключей осуществляется администратором самостоятельно, что гарантирует дополнительную безопасность. А о том, как подключиться к Linux-серверам, используя SSH-ключи, мы подготовили небольшое руководство.

Мэттью Маккенна (Matthew McKenna), коммерческий директор SSH Communications Security, советует сосредоточиться на том, какие ключи могут иметь root-доступ и насколько серьезными будут последствия утраты контроля над каждым из таких ключей. Поэтому следующий шаг — четкое распределение ответственности в сети с установлением каждого владельца ключа. Использование надежных криптографических стандартов и передовой практики в этой области — еще один гарант безопасности для организации.

Учитывать следует размер ключа, его «возраст» и алгоритм. К дополнительным компонентам относятся защита идентификационной фразы, связанной с элементами управления закрытым ключом, и устранение или ротация ключей SSH1. Управление конфигурацией системы предоставляет возможность стандартизировать местоположения ключей и обеспечить контроль элементов управления, связанных с доступом, например, запрет root-доступа и ограничение устаревших ключей.

/ Pixabay / Ashish_Choudhary / CC

Инженеры Facebook в своем блоге поделились опытом использования сертификатов при проектировании системы безопасности. Серверы ИТ-гиганта настроены таким образом, что все аутентификации проходят через центр сертификации для SSH с каталогом доступов. Так система определяет, имеет ли аутентифицированный клиент право на выполнение конкретного действия.

Кроме того, на службе у Facebook есть централизованная инфраструктура syslog, собирающая журналы в реальном времени, и инфраструктура, необходимая для ее поддержки. Синтаксические анализаторы интерпретируют и преобразуют журналы в табличные данные, которые отправляются в базы данных долгосрочного хранения, такие как Hive. В качестве совета сотрудники рекомендуют при проектировании собственного центра сертификации вести учет всех выданных сертификатов и рассмотреть возможность выдачи краткосрочных сертификатов.

Инструменты для управления SSH-ключами

Так как создатель SSH выступает за автоматизацию работы с ключами, и SSH Communications Security активно разрабатывает соответствующие продукты, мы собрали несколько полезных инструментов для key-менеджмента.

- PuTTY: клиент SSH, разработанный для платформы Windows. Он является программным обеспечением с открытым исходным кодом и позволяет генерировать новые ключи.

- Thycotic Secret Server: управление привилегированными пользователями. Позволяет связать генераторы ключей SSH с официальной системой управления учетными данными.

- Universal SSH Key Manager: разработка SSH Communications Security, которая предлагает комплексное управление ключами, в том числе полный учет и контроль доступа SSH, криптографические рекомендации и управление конфигурацией, непрерывный мониторинг, блокировку доступа в случае необходимости, восстановление и управление жизненным циклом ключей.

- PowerBroker Password Safe: инструмент для распределения прав в сети. Решение позволяет управлять паролями и сеансами, обеспечивая безопасный контроль доступа. Инструмент способен выборочно обрабатывать изменения паролей, проводить их проверку для определенных рабочих групп, поддерживать стандартные алгоритмы шифрования, такие как AES 256 и Triple DES, осуществлять автоматическую ротацию ключей и автоматически обновлять пароли на удаленных и мобильных устройствах.

- Venafi TrustAuthority: пригодится при развертывании сертификационного центра. Он способен обнаруживать внутренние сертификаты путем сканирования локальных систем и хранить ключи SSH для пользователей и хостов.

- GitWarden: инструмент для GitHub-команд, предоставляющий автоматическую синхронизацию локальных учетных записей пользователей, ключей SSH с командами организации. Это упрощает управление пользователями напрямую через пользовательский интерфейс GitHub.

Обсуждая лучшие способы управления SSH-ключами, ряд пользователей Hacker News отдали предпочтение физической защите, девайсам, которые обеспечивают аутентификацию при непосредственном контакте. Такие решения, как YubiKey 4 зачастую используются для двухфакторной аутентификации с соблюдением виртуальных мер безопасности.

P.S. Еще несколько материалов из нашего блога на Хабре:

|

Метки: author 1cloud системное администрирование серверное администрирование блог компании 1cloud.ru 1cloud ssh администрирование |

В гостях у сказки: патентные тролли |

В гостях у сказки: патентные тролли

Патентные тролли давно появились и до сих пор довольно часто появляются на первых строчках в новостях, когда иски направляются против индустриальных гигантов, таких как Apple, Microsoft, Samsung и другие. Однако от патентных троллей страдают не столько большие корпорации, сколько маленькие компании и стартапы. Это связано с тем, что у небольших и новых компаний просто нет ресурсов противостоять троллям, ведь помимо дороговизны судебных тяжб необходимо иметь возможность отстоять свои права на продукцию, что обычно сложно сделать стартапам в виду недостатка защиты интеллектуальной собственности (ИС).

Одна из хороших статей о стратегиях реагирования на письма-претензии от таких паразитов как тролли опубликована в блоге компании «Лаборатория Касперского» и основывается на опыте компании. В своей же статье, я хочу осветить тему с точки зрения помощи компаниям в этом непростом деле.

Поддерживающие сообщества

Понятное дело, что далеко не каждая компания отважится пойти против патентного тролля. Как же увеличить шансы малых предприятий в борьбе против троллей? Для этого были созданы разные сообщества, например PatentShield, LOT Network, The Law School Patent Troll Defense Network и другие.

Разработчики и малые предприятия получили возможность бесплатно воспользоваться услугами юридических вузов и юристов, которые участвуют в The Law School Patent Troll Defense Network. Для этого необходимо отправить запрос на сайте сообщества, описывая деятельность компании и сложившуюся ситуацию. Сообщество было сформировано и управляется на сегодняшний день объединением разработчиков приложений (Application Developers Alliance). Помощь малым предприятиям обойти ситуацию выплаты лицензионных отчислений патентным троллям способствует более глобальной цели, а именно сделать патентный троллинг менее прибыльным и вследствие заставить инвесторов отказаться от финансирования троллей.

PatentShield предоставляет доступ к коллекции патентных портфолио, которые понадобятся для борьбы с исками от патентных троллей. Стартапы смогут применить патенты, написанные опытными компаниями и исследовательскими институтами, против тролля при разбирательстве в суде. PatentShield находится под управлением компании Intertrust как часть холдинга и предлагает членство за определенную сумму, которая зависит от развитости бизнеса, продуктов компании и риска потенциальных судебных разбирательств. На сегодняшний день предлагаемые патенты принадлежат Intertrust и Google, но некоторые из них приобретены у других крупных компаний. Кроме того у членов данной организации будет доступ к рекомендациям по построению стратегии защиты ИС от команды специалистов по ИС компании Intertrust.

Интересным фактом является то, что Google является так же членом и другой сети по борьбе с патентными троллями: LOT (License on Transfer) Network. Принцип работы данной сети отличается и состоит в предотвращении возможных нападок. А именно при вступлении в сообщество подписывается соглашение и если патенты одного из членов сообщества попадают тем или иным способом патентному троллю, то остальные участники будут иметь автоматическое лицензирование данных патентов. Это означает, что они не смогут быть применены в суде против компаний подписавших соглашение. Лицензирование вступает в силу только в случае передачи ИС патентному троллю (обозначенных в соглашении как Patent Assertion Entity). Членство в таком сообществе тоже требует определенных затрат, однако не для стартапов с годовым оборотом менее $5 миллионов – для них вступление в сообщество является бесплатным.

Регулирование на законодательном уровне

В разговоре о патентных троллях многие высказывают мнение, что необходимо запретить патенты на программное обеспечение, подкрепляя это словами нет патентов нет проблем с троллями. Я же считаю по другому, патенты на программное обеспечение так же защищают интеллектуальную собственность разработчиков как и в других сферах изобретений. Проблема возникновения патентных троллей лежит не в самом факте существования защиты ИС, а в отсутствии регулирования таких манипуляций со стороны законодательства.

Например, в США в настоящее время все больше законопроектов находятся в Конгрессе на рассмотрении, 7 законодательных предложений выдвинутых Белым домом, не говоря уже об одном законе государственного уровня. Но к сожалению, ни один из них не решает конкретную проблему широты патентов на программное обеспечение и патентных троллей, а только доказывают несовершенство существующей патентной системы.

Организация Electronic Frontier Foundation (EFF – лидирующая некоммерческая организация в США защищающая гражданские свободы в цифровом мире) выступает за следующие меры для обеспечения надлежащего законодательного регулирования:

• Изменение пошлин – ввести требование на обязательный залог истцом в случае судебных разбирательств.

• Прозрачность:

o Реальные заинтересованные стороны — ответчики должны знать каждую сторону, которая финансово выигрывает от патентного иска;

o Отслеживание писем-претензий – доступные в открытом доступе письма помогут компаниям выявить тенденции и объединиться против одного тролля в определенной области;

o Четкость ходатайства – патентные притязания должны быть четкими и ясными, что и как конкретно нарушается. Бывают случаи, когда патентные тролли просто кидают пул патентов в компанию, заявляя, что она нарушает их все.

Пересмотр законности патента – согласно секции 18 American Invents Act, каждый, кому угрожают иском, может попросить пересмотр законности патентов определенных категорий у патентного ведомства. Однако это не распространяется на патенты о программном обеспечении, а так же является временным пунктом, а именно до 2020 года.

• Заявление по существу – патентование конкретного решения. Как известно патенты на программное обеспечение бывает весьма широки и покрывают множество решений одной проблемы. Предлагается сузить требования к патентованию ПО.

Проблема патентных троллей продолжает раздражать компании в электронной сфере, однако работа над решением идет полным ходом и появляются все больше сообществ и инициатив для поддержки малого бизнеса, оказавшихся в печальных ситуациях. Необходимо помнить, что нельзя опускать руки, а давать отпор паразитам используя все возможные способы.

|

Метки: author LKulakova патентование законодательство и it-бизнес блог компании parallels parallels патентные тролли интеллектуальная собственность право ит рунет |

[Перевод] Kotlin в продакшене, что мы получили, и что мы потеряли? |

Kotlin в продакшене, что мы получили, и что мы потеряли?

- Перевод

С того времени, как Google сделал Koltin новой любимой женой уже прошло достаточно времени. И сразу же после этого объявления наша команда начала новый проект полностью на Котлине. Проясню: не тестовый или просто внутренний проект, а новый модуль для живого приложения с 600+ тысячами активных пользователей в месяц. Какой опыт мы из этого извлекли? Что мы выиграли и что потеряли?

С того времени, как Google сделал Koltin новой любимой женой уже прошло достаточно времени. И сразу же после этого объявления наша команда начала новый проект полностью на Котлине. Проясню: не тестовый или просто внутренний проект, а новый модуль для живого приложения с 600+ тысячами активных пользователей в месяц. Какой опыт мы из этого извлекли? Что мы выиграли и что потеряли?Для начала, я не буду повторять обещания JetBrains на счет времени сборки, полноценного взаимодействия с Джавой и производительности. Это правда, что Котлин код практически так же быстр, и что оверхед не превышает размера типичной PNG картинки из ресурсов. Но зачем нам вообще нужен Котлин, и в чем все-таки разница?

Фан-фактор

Очевидно, Котлин надо сначала выучить. Даже несмотря на то, что кривая обучения не выглядит как гора К2, плоской она тоже не является: один из коллег заметил, что на выполнение задач на Котлине у него уходило примерно в два раза больше времени, тем не менее, никто ни разу не пожаловался. Наоборот, все были только рады возможности применить новую крутую игрушку со всеми ее свистелками в продакшене. Более того, для привлечения лучших кандидатов мы стали не сговариваясь упоминать в ходе интервью, что пишем на Котлине. Так что чистая победа в этой категории +100 очков Котлину.

Скорость

Работа с новым языком это не только изучение его синтаксиса, это — совокупность написания, чтения, рефакторинга, тестирования и т.д. Остановимся на этом немного детальнее.

Скорость написания

В среднем на то, чтобы почувствовать себя более-менее комфортно с Котлином ушло около двух недель. И еще примерно две недели понадобилось, чтобы начать писать на нем быстрее чем на Джаве. Тем, у кого был опыт Scala и Groovy было проще, так как авторы Котлина во многом вдохновлялись ими. Поддержка со стороны IDE все еще не идеальна: много удобных и привычных по Джаве рефакторингов и автоподстановок просто не работают сейчас. Но даже несмотря на эту проблему, в итоге мы все равно немного в плюсе по скорости. Слабая победа Котлина в этой категории, впрочем мы ждем большего от финальной версии Android Studio 3.0 (на момент написания статьи мы все еще пользовались бетой).

Скорость чтения

Хоть код на Котлине и получается ощутимо короче, разбирать пулл-реквесты на ГитХабе приходится дольше. Почему так? Во-первых, ни Google ни JetBrains не подготовили полноценный стайл-гайд, так что члены команды стали проводить больше времени за дискуссиями на тему «красоты». Даже официальные примера кода не во всем однородны. Во-вторых, некоторые новые (для Джавы) конструкции могут быть использованы во вред, в то время как на Джаве так написать попросту не получится. Итого: небольшой но все же проигрыш на этом направлении, хотя, опять же, мы ожидаем улучшений в ближайшем будущем, потому что по поводу 99% спорных кейсов уже пришли к согласию.

Инструменты и библиотеки

Страшная правда в том, что Checkstyle и Lint пока еще абсолютно бесполезны для Котлина, а мы их используем и активно, но тот же Dagger работает отлично. А еще мы получили Kotlin-X и собираемся втянуть в проект Anko. Тут опять проигрыш Котлина, и хоть Anko с Kotlin-X могут подсластить пилюлю, мы особо не ожидаем драматических улучшений в работе стайлчекеров в ближайшее время.

Тестирование

А вот тут мы неожиданно получили преимущество. С Котлином не поставляется никаких новых инструментов или библиотек для тестирования, но новые языковые фичи, особенно type inference, extensions, и reified-типы существенно сократили количество бойлерплейта в тестовых классах. Чистая победа тут, даже несмотря на то, что IDE иногда пытается запустить Espresso как будто это чистые JVM юнит-тесты и, очевидно, не справляется с задачей.

Саморазвитие

Новый язык программирования это не только куча новых ключевых слов, это — новые способы переписать давно знакомые паттерны, это — немного новых парадигм и, иногда, новых способов думать и выражать мысли в коде. Изучая Котлин, мы не только научились писать на другом языке, мы поняли как можно сделать лучше части кода на старом. И мы совершенно точно вытолкнули себя за границы зоны комфорта, что, если честно, тоже своего рода фан-фактор, но фан-фактор стоящий!

П.С. Изначально статья была написана на английском для корпоративного блога, но я решил, что она должна существовать и на русском языке, так что «совпадение» имен авторов не случайно.

|

Метки: author fo2rist разработка под android android android development kotlin |

Байки поддержки первой линии: отличная работа, если у вас крепкие нервы |

Байки поддержки первой линии: отличная работа, если у вас крепкие нервы

Мы поддерживаем офис одной сервисной компании и хотели бы немного рассказать про нашу работу. Для поднятия настроения, так сказать. В общем-то, наш день выглядит одинаково: приходим, логинимся в cisco agent, садимся за телефон и начинаем слушать хотелки юзеров. Что-то разруливаем сами, что-то передаём второй линии рядом. Несмотря на то, что офис заказчика состоит преимущественно из инженеров, тикеты не очень сильно отличаются от тикетов нефтегазовой компании или госкомпании. Конечно, без того, чтобы проехать 200 километров, чтобы включить принтер в розетку (реальный случай), но всё же.

Хотя, например, эта разница очень сильно проявилась, когда безопасники в очередной раз дали задачу пройтись по кабинетам и посмотреть, кто хранит записанные пароли на рабочих местах. Поначалу без сюрпризов — где-то каждый тридцатый записывает и клеит на монитор. Проблема была в том, что если в бухгалтерии это верные пароли («А откуда шпион узнает, что это пароль, а?»), то ушлые инженеры специально записывают какие-то случайные комбинации символов. Видимо, прикалываются над безопасниками.

Разумеется, техэксперты и техмены, обитающие в офисе, по большинству решают проблемы самостоятельно (ну или ставят очень понятные тикеты, где всё делается в пару кликов). Но есть ещё и различные «дополнительные службы», типа: столовая или спортзал. Некоторые из них вообще иногда доставляют нам море радости своими тикетами с просьбой установить World of Tanks на компьютер. Или: «Я слышу людей в мониторе, а меня никто не слышит!»

Но бывают и ситуации, когда обычные пользователи выдают что-нибудь неординарное. Например, мне особенно запомнился звонок с паникой про то, что окно не закрывается, а надо срочно. Удалённое соединение не прокинули. Ну ладно, наверное, личный ноутбук, что-то заглючило, пользователю срочно нужно. Мы отправили эникея. Оказалось, что там осталась девушка одна в большом кабинете, и она не могла дотянуться до ручки окна. А дул сильный ветер.

Пару раз выталкивали машины с парковки, один раз помогали качать колесо. Почему? Потому что к нам стучат тогда, когда не знают, к кому обращаться. Мы же поддержка. Мы всегда поможем. В ITSM рабочие часы на такие вещи списываются по графе «неподдерживаемый сервис» — раньше это были всякие штуки с прикладным ПО, которые не входят в наш SLA, а теперь по большей части — как раз вот эти вот странные запросы. Нет, конечно, мы их фильтруем, но всё равно иногда так или иначе делаем. Пользователю же очень сложно объяснить, что к нам, а что — нет. Самый яркий пример — когда человек не получает бутерброд в автомате на этаже, но не может вернуть деньги, он сначала бьёт автомат, а потом пишет тикет нам.

Естественно, всем всё нужно вчера — но это, думаю, данность у каждой первой линии.

Иногда бывают дни ада — это когда у пользователей приходит время плановой смены паролей. За такой день может поступить 70–80 звонков на сотрудника: всем нужно войти в учётки. Это ещё не считая обычных проблем вроде кончившегося тонера или сломавшегося блока питания.

Очень мало проблем с вирусами — в компании стоят хорошие NGFW и песочницы, поэтому все эпидемии проходят мимо. Единственное — опять же личные устройства. У подкованных они защищены, а вот та же охрана страдает. У меня был тикет про сходящего с ума охранника, который кликал на видео про Госдуму, а попадал на порнуху. На месте оказалось, что он смотрел какой-то отличный сайт, где блоки Ютуба были только нарисованы, а на деле это были IMG с реферальной ссылкой на порносайт. Психику человеку я тогда спас.

Ещё один человек чуть не снёс крышу нашему инженеру. Тикет такой: когда он копирует и вставляет логин и пароль, зайти получается. Когда вводит руками — нет. Искали долго. Потом почти случайно посмотрели в кодировщике — у него О в логине была русская, а не латинская, как все остальные. Кто и как это сделал — непонятно.

Часто к нам приносят личные ноутбуки на починку — перезалить после падения системы, что-то переставить и так далее. Поскольку пользователи всё равно на них в офисе работают, мы помогаем (полуофициально, опять же — «неподдерживаемый сервис»). Пользователи иногда благодарят. Опять же, если от девушек обычно бывают конфеты и тортики, то охрана всегда чётко и конкретно проставляется пивом. Одним и тем же. Как часы. Такое ощущение, что у них там внутренняя инструкция, сколько пива и за что давать.

Из-за автогенерации логинов «первая буква имени — фамилия» часто страдают невинные люди. Тикеты отличные — меньше всего везёт Евгениям. Хорошо хоть с фамилией Банный у нас никого нет. Тут мы выступаем в роли психологической поддержки и знакомим пользователя с каталогом на примерно сотню таких прекрасных логинов действующих сотрудников. Он понимает, что не одинок, и немного успокаивается.

Один раз девушку из бухгалтерии безопасники до того запугали, что она писала специальный тикет, чтобы мы подвинули монитор на столе на 11 сантиметров влево. Кстати, с мониторами частый вопрос от бухгалтерии при замене — это сохранятся ли ярлыки. Успокаиваем. Сохранятся.

Один раз просили включить Sony PlayStation4, причём в рамках поддерживаемого сервиса. Смотрим — он и правда поддерживаемый, теперь в комнате отдыха одна стоит.

Постоянно к нам стучат люди, которые застряли где-то в лифте (необязательно в офисе), когда есть проблемы с кондиционерами. Был однажды тикет «у нас тут репетиция в спортзале — нужны парни потанцевать».

Жалобы на отсутствие электричества — к нам. Экран надо поменять в корпоративном автобусе — к нам. Однажды сотрудник пошёл на балкон смотреть кабель и случайно закрылся. Позвонил на общую линию, пришлось писать как тикет. В общем, иногда отличаемся умом и сообразительностью.

Однажды связисты пожаловались на плохой приём вай-фая в кабинете. Повесили им новую точку доступа прямо внутри. Они взяли ноутбуки и пошли работать в столовую. На следующий день они притащили какой-то чемодан со склада, промерили везде поле, успокоились.

Есть забавные ситуации, когда люди не разлогиниваются, и их коллеги начинают писать дикие тикеты от их имени. «Приготовьте мне кофе» — это ещё самое простое. Один раз пользователь хотел научиться играть в настольный теннис, а у нас этажом выше как раз спортзал со столом для него. Ну и смотрим — тикет такой поставил. Потому что решил не звонить, видимо.

Есть пользователь-вампир: он уже 6 лет пишет заявки только после заката. Мы его не знаем, но тикеты закрываем. Наверное, какой-нибудь спец по поддержке линий связи Дальнего Востока. Кстати, да, для ночной смены самое интересное время — 4–5 часов утра, когда просыпается Иркутск и начинает ставить срочные задачи.

Пользователи жгут. Недавно я впервые столкнулся с человеком, который перекроил всю раскладку (в том числе на мышке) — левша, ему так удобнее. А мне было целое приключение. Когда новый человек знакомится со своим «админом», иногда бывает «а можно всех посмотреть и выбрать?». У некоторых пользователей висят рядом с рабочим местом прямые телефоны конкретных инженеров — это притом, что мы их не давали. Как-то я помог пользователю с хоткеями — показал чудный новый мир быстрой работы. В тот же день ещё несколько тикетов пришло — он с коллегами поделился, что мы обучаем.

Разумеется, мы тоже иногда становимся причинами инцидентов в офисе. Что-нибудь тестируем или паяем — приходят свои же пожарные прописывать люлей. Ещё один раз нам была целая выволочка от эйчаров — в офисе мыли окна, так мы этим парням напечатали голых баб и изнутри приклеили. Думали, им повеселее будет. Нет, накатали жалобу, мол, мы оскорбляем их человеческое достоинство. Хотели быть добрыми — не получилось.

Ну и сегодня, наверное, мы получим по башке от нашего коллеги Стаса. Потому что не рассказать эту историю я просто не могу. У нас две комнаты, мы в первой, а Стас с командой — во второй. Дело в том, что мы как-то месяц встречали каждого заходящего в гости пользователя, внимательно выслушивали и говорили, что именно на его вопросе специализируется Стас. И он лучше всех это решит. Юзер шёл в другую комнату и обращался лично к нему. Стас чуть с ума не сошёл, думая, почему все идут только по его душу. Ну, теперь, наверное, узнает.

|

Метки: author MVitoslavskiy системное администрирование it- инфраструктура блог компании крок техподдержка |

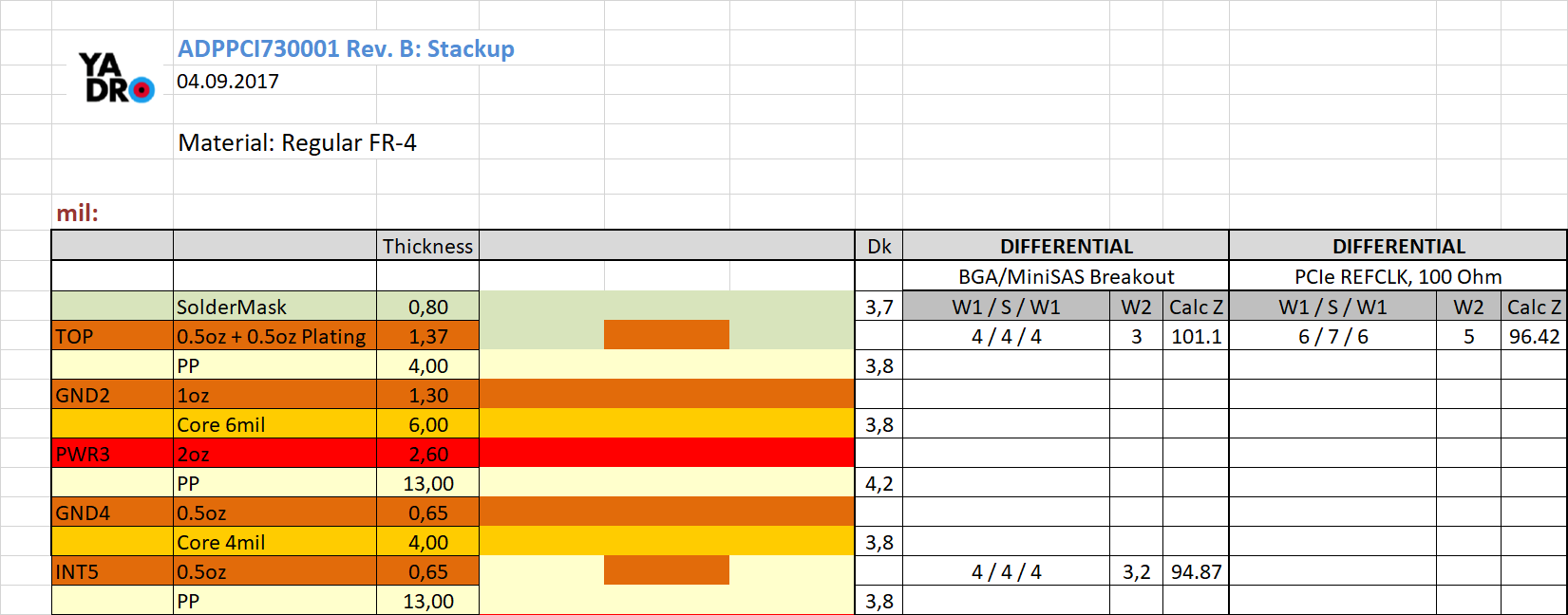

Наша методика расчета стека печатных плат |

Наша методика расчета стека печатных плат

Сразу к делу — вот о чём написано в этой статье:

- Материалы для производства печатных плат

- Учет изменения толщины препрега в процессе изготовления PCB

- Учет Etch Factor

- Особенности расчета толщины металлизации

- Учет паяльной маски

Все описанное ниже — это не Know How, а по сути, собранные воедино и систематизированные данные из разных источников. На абсолютное знание мы также не претендуем.

Итак, поехали.

Материалы для производства печатных плат

Преамбула (как обычно это происходит).

Обычно инженер примерно оценивает стек платы, передает его производителю PCB. В ответ ему приходит много китайских бланков с предложениями — на которые он обычно соглашается. Сводятся они к изменению толщин ядер/препрегов, а также проводников и зазоров в CAM редакторе.

Обычно оно и нормально. Но тут есть три минуса:

- Итоговое изделие отличается от того, что описано в вашей КД (иногда чуть более, чем полностью).

- Повторяемости результата при переходе к другому производителю — нет. Например у нас есть борд, который запускался на двух разных фабах с совершенно разными стеками (при этом исходные данные в обоих случая были одни и те же).

- Если толщины проводников на печатной плате находятся в зоне 4 mil — то любое изменение их ширины в сторону уменьшения весьма серьезно влияет на потери. Если между проводником 6 mil и 5 mil разница незначительна, то между 5 mil и 4 mil — весьма существенна, а 4 mil и 3 mil — это с точки зрения потерь разные вселенные. (Вообще на наш взгляд идеальные топологии дифференциальной пары — 6-6-6 или 7-7-7).

Поэтому мы предпочитаем сформировать стек так, чтобы его зависимость от особенностей конкретного производителя PCB сводилась к минимуму. Если вы работаете с одним и тем же вендором, то вполне реально сформировать стек так, чтобы его модификация производителем не требовалась совсем. Это экономия 1—2 недель при подготовке к производству.

Кстати оффтоп.

Наверняка кто-то нибудь захочет спросить — что лучше, сильносвязанные или слабосвязанные дифференциальные пары. Наше мнение: лучше слабосвязанные — их проще выровнять по длине. Можно позволить себе более серьезные бампы. Никаких особенных преимуществ сильносвязанных пар перед слабосвязанными (если не рассматривать странные топологии типа 5-14-5) c точки зрения SI на наш взгляд — нет. Для любителей формальных правил: одна-две ширины между проводниками в паре — нормально. Больше — уже не очень. Меньше — трудно выравнивать. Несмотря на то, что ЭМС показатели сильносвязанных пар сильно лучше, в абсолютном выражении это «сильно» — несущественно.

Для того, чтобы более-менее точно сформировать стек печатной платы — нужно знать параметры конкретных ядер и препрегов применяемого материала. В даташитах приводятся усредненные параметры для всей группы и для точного расчета эти данные не годятся. Данную информацию можно запросить как у производителя материала, так и у производителя PCB. Это таблица, которая выглядит это примерно так (у каждого производителя материала она своя):

Толщины разных типов препрегов — как правило одни и те же у разных производителей. Поэтому информация на приведенной картинке — актуальна и юзабельна безотносительно к производителю материала (Dk/Df, понятно, у всех разные).

При проектировании стека печатной платы необходимо учитывать, что производители PCB, как правило, делают поправку на ламинацию, снижая значения диэлектрической постоянной (Dk) как препрегов, так и «ядер» примерно на 0.2 по отношению к значениям, приведенным в документации производителя материалов.

Если значения Dk/Df приведены для разных частот, то рекомендуется использовать значения данных параметров для частоты, наиболее близкой к частоте Найквиста наиболее быстрого интерфейса на PCB. Например, если в PCB присутствует PCI Express Gen3, то следует использовать значения Dk/Df для частоты, наиболее близкой к 4 ГГц.

Кто-то возразит: как же, ведь полоса того же Gen3 простирается аж до 18 ГГц. Это правда — но спецификация PCIe регламентирует RL и IL до Найквиста, да и не пройдут все эти адовые гигагерцы через коннекторы, переходные отверстия и печатную плату — затухнут по дороге. А если пройдут — это большой вопрос, понравится ли Вам результат.

В ситуации, когда на PCB присутствует несколько разных высокоскоростных интерфейсов — не стоит в рамках стека одной платы использовать значения Dk/Df для разных частот. Несмотря на то, что такой подход является более верным с точки зрения расчета импеданса — он вызовет большие трудности при согласовании стека с производителем PCB (их тестовое оборудование настраивается на одну конкретную частоту).

В случае, если значения Dk/Df значительно варьируются с частотой, а контроль импеданса критичен — имеет смысл, получив значения импеданса для реальной частоты интерфейса, пересчитать его, взяв Dk для некоторой единой частоты (самого критичного интерфейса). «Отнормированное» таким образом значение импеданса — указать в качестве целевого для контроля производителем PCB.

Например вы делаете расчет 100 Омной трассы для частоты 4 ГГц, используете значение Dk для 4 ГГц, и в соответствии с полученными данными осуществляете трассировку. Далее, если у вас например есть интерфейсы, требующие расчета для 10 ГГц — подставьте значение Dk для более высокой частоты в исходный расчет. Допустим, при этом вы получите значение импеданса 105 Ом. Наш совет: вот 105 Ом и укажите производителю PCB для контроля. Не стоить морочить ему голову разными Dk для разных частот на одном и том же слое.

Также не повредит на берегу поинтересоваться с каким стеклом работает фаб, чтобы не было потом проблем со сроками поставки. Потому что есть популярные препреги и не очень. Обычно на складе у него всегда в достатке 3-4 типа, из которых и стоит выстраивать стек PCB. Материалов с низкими потерями обычно на складе не бывает, в силу ограниченного срока хранения — поэтому применение чего-то особенного это всегда вопрос не столько цены, сколько сроков изготовления.

Учет изменения толщины препрега в процессе изготовления PCB

В таблице ниже приведены абсолютные значения изменения толщины одного слоя препрега для разных условий применения. Допуск на все значения составляет 10%.

| Условия | Изменение толщины препрега при начальном значении | |

|---|---|---|

| Не более 2.3 mil | Более 2.3 mil | |

| Прилегание к меди 0.5 oz с 30% заполнением | 0.4 mil | 0.4 mil |

| Прилегание к меди 0.5 oz с 70% заполнением | 0.1 mil | 0.2 mil |

| Прилегание к меди 1 oz с 30% заполнением | 0.8 mil | 0.9 mil |

| Прилегание к меди 1 oz с 70% заполнением | 0.3 mil | 0.4 mil |

| Прилегание к меди 2 oz с 30% заполнением | 1.8 mil | 1.9 mil |

| Прилегание к меди 2 oz с 70% заполнением | 0.8 mil | 0.8 mil |

| Расположен между двумя слоями препрега | 9% | 10% |

| Прилегание к внешнему слою | не изменяется | не изменяется |

Для более точного расчета изменения толщины препрега можно использовать следующее выражение:

В случае, когда между слоями металлизации расположен один слой препрега — значения изменений толщины для соответствующих условий должны суммироваться, так как изменение толщины препрега на самом деле представляет собой вдавливание в него проводящего рисунка.

При формировании послойного описания PCB следует указывать финишное значение препрега. При этом порция препрега, вдавленная в рисунок металлизации, не должна включаться в значение финишной толщины в документации, передаваемой производителю PCB.

Пример

Необходимо рассчитать финишную толщину стека, приведенного на рисунке. На всех слоях металлизации используется медь 1 oz. Исходная толщина препрега 2116 равна 5.1 mil.

Результирующий стек будет иметь вид:

| Тип слоя | Начальная толщина | Изменение толщины | Финишная толщина |

|---|---|---|---|

| Внешний | 1.35 mil | — | 1.35 mil |

| Слой 2116 | 5.1 mil | — | 5.1 mil |

| Слой 2116 | 5.1 mill | 0.9 mil | 4.2 mil |

| Внутренний сигнальный | 1.35 mil | — | 1.35 mil |

| Core | 39 mil | — | 39 mil |

| Внутренний Plane | 1.35 mil | — | 1.35 mil |

| Слой 2116 | 5.1 mil | 0.4 mil | 4.7 mil |

| Слой 2116 | 5.1 mil | — | 5.1 mil |

| Внешний | 1.35 mil | — | 1.35 mil |

| Итого: | 63.5 mil ± 10% |

Учет Etch Factor

Выражение для расчета Etch Factor для процесса электрического осаждения меди представлено на рисунке:

В таблице приведены значения Etch Factor для разных типов металлизации для различных производителей. Как видите, они сильно разнятся. Поэтому значение EF — это первое, что вы должны уточнить у вашего PCB-партнера.

| Тип слоя | Фабрика 1 | Фабрика 2 | Фабрика 3 | Фабрика 4 | ||||

|---|---|---|---|---|---|---|---|---|

| EF | W2-W1 | EF | W2-W1 | EF | W2-W1 | EF | W2-W1 | |

| Внешний 0.5 oz | 3.4 — 4 | 1 mil | 3.4 — 4 | 1 mi | 3.4 — 2 | 1.5 mil | 2.6 | — |

| Внешний 1 oz | — | — | — | — | 1.66 | 2.4 mil | 2.6 | — |

| Внутренний 0.5 oz | 1.75 | 0.8 mil | 4.33 | 0.3 mil | 1.73 | 1.75 mil | 3 | — |

| Внутренний 1 oz | 2.4 | 1 mil | 4.33 | 0.6 mil | 2.6 | 1 mil | 3 | — |

| Внутренний 2 oz | — | 1.5 — 2 mil | 4.33 | 1.2 mil | 2.6 | 2 mil | 3 | — |

| Внутренний 3 oz | — | — | — | — | 2.6 | 3 mil | 3 | — |

| Внутренний 4 oz | — | — | — | — | 2.3 | 4.5 mil | 3 | — |

Для случаев, когда информация о значении EF от конкретного производства отсутствует – можно считать, что EF принимает следующие значения:

- внешние слои — 2.6

- внутренние слои — 3.7

Особенности расчета толщины металлизации

Металлизация внешних слоев

При расчете металлизации внешних слоев значение толщины меди весом 1 oz как правило принимается равным 1.37 mil. Рекомендуется отдельно задавать вес базовой меди и вес осаждаемой меди. Итоговое значение получается в результате суммирования этих двух параметров. Типовые значения приведены в таблице:

| Base copper | Plating copper | ||

|---|---|---|---|

| 0.7oz | 1oz | 2oz | |

| 0.5oz | 1.644 mil | 2.055 mil | 3.425 mil |

| 1oz | 2.329 mil | 2.74 mil | 4.11 mil |

| 2oz | 3.699 mil | 4.11 mil | 5.48 mil |

| 3oz | 5.069 mil | 5.48 mil | 6.85 mil |

Металлизация внутренних слоев

Для внутренних слоев значение толщины меди весом 1 oz, как правило, принимается равным 1.3 mil.

Учет паяльной маски

При учёте паяльной маски опираемся на следующую схему:

В случаях, когда явно не указано иное, можно считать, что паяльная маска имеет следующие параметры:

- Dk — 3.7

- Df — 0.025

- Толщина — 0.8 mil

Большинство производителей при учете влияния паяльной маски считает значения C1, C2 и C3 равными друг другу.

Некоторые фабрики считают значения C1 и C3 равными толщине металлизации (T1), а C2 – 0.8 mil. Правильность данного подхода приблизительно подтверждается реальными данными, полученными после производства PCB.

Один из наших PCB-партнеров считает толщину паяльной маски на сплошных участках меди 0.79 — 1.18 mil, на краях проводников 0.2 mil. Также данный производитель при расчете стека рекомендует не включать паяльную маску в расчет, так как при травлении внешних слоев происходит малейший перетрав (то есть увеличение значения импеданса), который маской компенсируется в номинал теоретического измерения импеданса внешних слоев без маски.

Это, кстати, хороший пример того, что при работе с данным производством — толщина трасс на вашей PCB будет меньше, чем заложено в рисунке печатной платы.

Итоги

Вот такие у нас внутренние рекомендации и правила, с которыми в обязательном порядке знакомим всех инженеров, проектирующих печатные платы. Надеюсь что данная статья будет полезна тем, кто рыщет по просторам интернета в поисках разрозненных рекомендаций и пытается угадать, как там получится в его конкретном изделии. Приглашаю делиться опытом в комментариях — будем рады дополнить свой. Если будет интерес, выложу ещё несколько подобных внутренних инструкций.

|

Метки: author asmolenskiy анализ и проектирование систем блог компании yadro pcb design pcb production печатные платы проектирование |

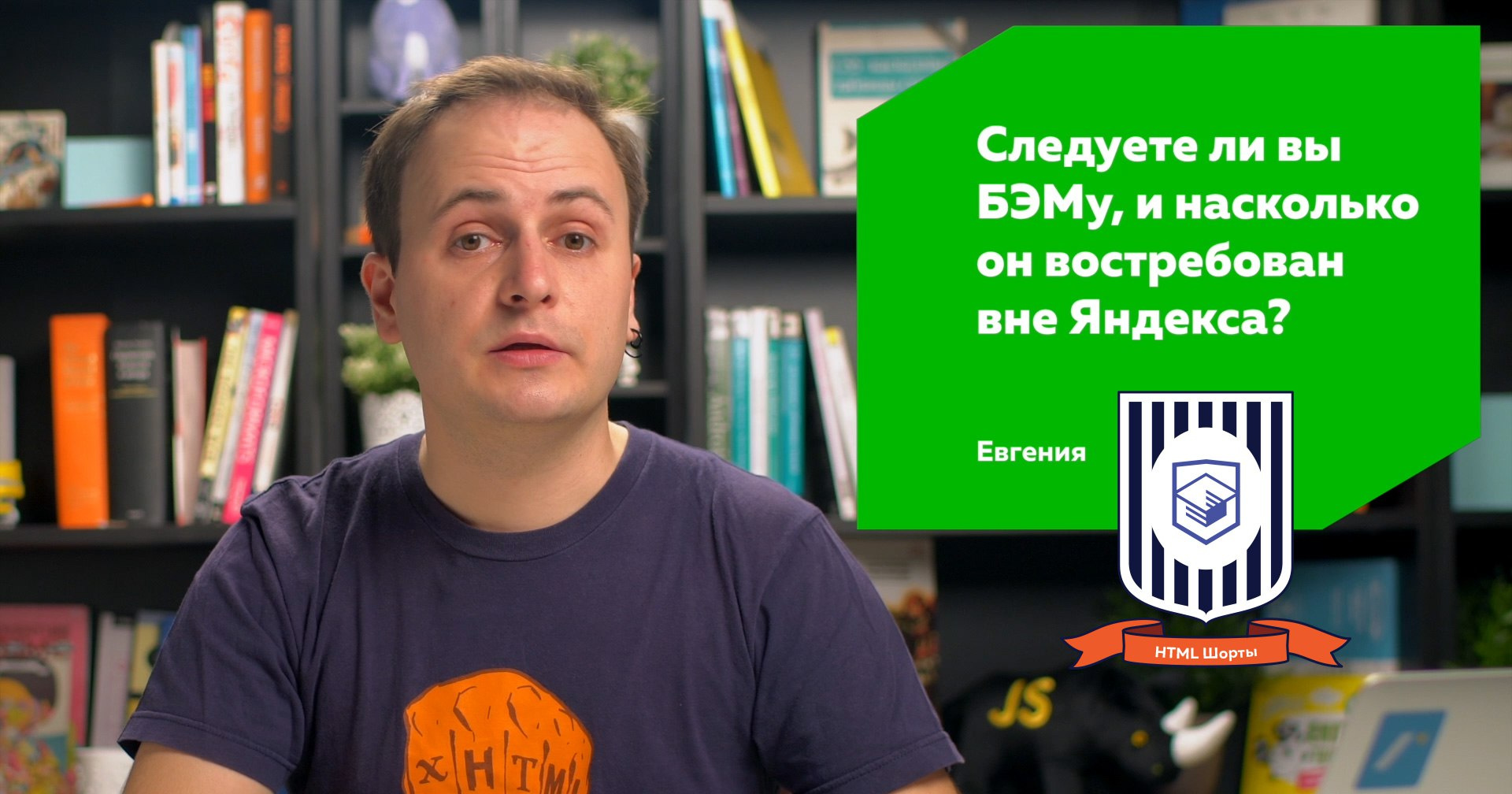

Зачем нужен БЭМ |

Зачем нужен БЭМ

Следуете ли вы БЭМу, и насколько он востребован вне Яндекса?

БЭМ расшифровывается как: блок, элемент, модификатор. Это такой набор абстракций, на который можно разбить интерфейс и разрабатывать всё в одних и тех же терминах. Как говорит сайт bem.info, БЭМ предлагает единые правила написания кода, помогает его масштабировать и повторно использовать, а также увеличивает производительность и упрощает командную работу.

Круто, да? Но зачем вам масштабируемость и командная работа, если вы один верстальщик на проекте, который не претендует на популярность Яндекса? Чтобы ответить на этот вопрос, нужно отмотать историю лет на 10 назад, когда это подход только начали формулировать.

В основу того, что мы сейчас называем БЭМом, легла идея независимых блоков, которую Виталий Харисов сформулировал и презентовал в 2007 году на первой российской конференции по фронтенду. Это было настолько давно, что тогда даже слова «фронтенд» ещё не было, тогда это называлось клиент-сайд.

Идея была в том, чтобы ограничить возможности CSS для более предсказуемых результатов. Использовать минимум глобальных стилей и каждый отдельный элемент страницы делать блоком со своим уникальным классом и стилями, которые полностью его описывают. Селекторы по элементам и ID, хрупкие связки вложенности — всё это заменялось на простые селекторы по классам. Каждый класс в стилях — это блок. Благодаря этому блоки можно легко менять местами, вкладывать друг в друга и не бояться конфликтов или влияния.

#menu ul > li {

color: old;

}

.menu-item {

color: bem;

}Потом появились абсолютно независимые блоки (АНБ), где у элементов внутри есть свой префикс с именем родителя, а состояния блоков снова дублируют класс, но уже с постфиксом. Подход обрёл черты современного БЭМа, одна из которых — многословность классов.

.block {}

.block_mod {}

.block__element {}

.block__element_mod {}Эта многословность гарантирует уникальность элементов и модификаторов в рамках одного проекта. За уникальностью имён блоков вы следите сами, но это довольно просто, если каждый блок описан в отдельном файле. Глядя на такой класс в HTML или CSS, можно легко сказать, что это, и к чему оно относится.

Изначально АНБ, а потом и БЭМ, решали задачу важную для вёрстки любых масштабов: предсказуемое поведение и создание надёжного конструктора. Вы же хотите, чтобы ваша вёрстка была предсказуемой? Вот и Яндекс тоже. Ещё это называется «модульность» — о ней хорошо написал Филип Уолтон в «Архитектуре CSS», ссылка на перевод в описании.

Через пару лет в Яндексе окончательно сформулировали нотацию БЭМ. Любой интерфейс предлагалось разделять на блоки. Неотделимые части блоков — элементы. У тех и других есть модификаторы.

Например, блок поиска по сайту. Он может быть в шапке и в подвале — значит это блок. В нём есть обязательные части: поле поиска и кнопка «найти» — это его элементы. Если поле нужно растянуть на всю ширину, но только в шапке, то блоку или элементу, который отвечает за это растягивание, даётся модификатор.

Для полной независимости блоков мало назвать классы правильно или изолировать стили, нужно собрать всё, что к нему относится. В проекте по БЭМу нет общего script.js или папки images со всеми картинками сайта. В одной папке с каждым блоком лежит всё, что нужно для его работы. Это позволяет удобно добавлять, удалять и переносить блоки между проектами. Потом, конечно, все ресурсы блоков при сборке объединяются в зависимости от задач проекта.

Когда БЭМ вышел за пределы Яндекса, сначала его воспринимали как магию и старались воспроизводить дословно, вплоть до префиксов b- у каждого блока. Такой смешной карго-культ.

.b-block {}

.b-block--mod {}

.b-block__element {}

.b-block__element--mod {}Некоторые неверно понимали идею и появлялись даже элементы элементов. Потом за нотацию взялись энтузиасты и появилась одна из самых популярных: блок отделяется двумя подчёркиваниями, а модификатор — двумя дефисами. Наглядно и просто — сам так пишу.

.block {}

.block--mod {}

.block__element {}

.block__element--mod {}А зачем вообще все эти нотации — я ведь один верстальщик на проекте, помните? Помню. А ещё помню, как сам верстал до БЭМа: в каждом проекте придумывал что-нибудь такое новенькое. А потом открывал код годичной давности и удивлялся — какой идиот это написал?

Возьмём, к примеру, русский язык. Мы же пишем с прописной имена людей, названия и прочее такое? Пишем. Чтобы легко потом считывалось: это Надя или надежда на лучшее? Уж не говоря про знаки препинания и другие полезные договорённости. Вот буква «ё», например, смягчает… так, о чём мы? Да, БЭМ.

До БЭМа были проекты с портянками стилей, которые нельзя трогать. Они копились годами, слой за слоем, как обои в древней коммуналке. Их просто подключали первыми, а потом перезаписывали что мешало. Когда у вас есть div { font-size: 80% } — это даже уже не смешно.

/* Не смешно */

div {

font-size: 80%;

}БЭМ продолжил развиваться в Яндексе и вырос за пределы вёрстки: появились уровни переопределения, богатый инструментарий, JS-библиотека для работы с БЭМ-классами, шаблонизаторы и целый БЭМ-стэк. БЭМу даже жест придумали, но это совсем другая история, специфичная для Яндекса.

Были и другие методологии: OOCSS Николь Салливан, SMACSS Джонатана Снука, вариации БЭМа и целые фреймворки. Даже у нас на продвинутом интенсиве можно было выбрать любую методологию для вёрстки учебного проекта.

Но выжил только БЭМ и его вполне можно назвать стандартом де-факто современной разработки интерфейсов. И что — это финальная ступень эволюции? Нет конечно. Как ни автоматизируй, многое в БЭМе приходится делать руками, и возможны конфликты.

Модульность и изоляцию стилей блока можно решить ещё лучше. Есть веб-компоненты, CSS-модули, куча решений CSS-в-JS и даже, прости господи, атомарный CSS. Но нет единого решения накопившихся проблем на следующие 10 лет, каким когда-то стал БЭМ. Что это будет? Посмотрим. Я ставлю на веб-компоненты.

А пока, если вы опишете интерфейс по БЭМу — код будет организован, предсказуем, расширяем и готов для повторного использования. Не только для вас, но и для других.

Видеоверсия

Вопросы можно задавать здесь.

|

Метки: author htmlacademy разработка веб-сайтов css блог компании html academy бэм для начинающих методологии разработки для новичков новичкам верстка |

[Из песочницы] Искусство создания диаграмм процессов |

Искусство создания диаграмм процессов

Поэтому несколько лет назад я разработал приложение, которое позволяет строить диаграммы процессов, чтобы планировать исполнение проектов или просто достигать каких-либо целей. Всё это время я тесно работал с пользователями, довольно часто и по разному поводу они присылали мне свои диаграммы. Изучая сотни различных схем, я замечал, что некоторые из них проще воспринимать и понимать, чем другие, и наоборот, отдельные схемы было чертовски сложно разобрать. Интересно то, что зачастую дело было не в сложности или простоте самого процесса, а в манере построения диаграммы. Проявив толику усердия, даже самый простой процесс можно проиллюстрировать путанной схемой, суть которой будет сложно понять без дополнительного изучения.

Анализируя свой опыт по построению диаграмм и систематизируя удачные находки и ошибки пользователей, я выработал набор принципов, которые позволяют строить хорошие диаграммы.

Пару слов о структуре статьи. Материал довольно обширный, поэтому я попробую разбить его на несколько частей и постараюсь излагать материал тезисно, избегая лишних разъяснений. Эта статья будет посвящена довольно общим принципам, вполне очевидным, но которые следует упомянуть. Последующие части будут ближе к конкретным практикам.

Итак, сначала договоримся об основном предмете статьи — диаграммах процессов (далее для лаконичности иногда просто диаграммы). Как правило, диаграмма процессов представляет собою набор графических объектов, поименованных текстом, которые связаны между собою стрелками. Объекты обозначают процессы, ресурсы, состояния и т. д. Стрелки же обозначают порядок перехода управления от одного объекта к другому. Следует отличать диаграммы процессов от внешне очень похожих структурных диаграмм, диаграммы процессов предполагают динамику, в то время когда структурные диаграммы носят статичный характер, описывая конструктивные взаимосвязи объектов, обычно это описание организационных иерархий, структур данных или “карты разума”.

Существует много нотаций описания диаграмм процессов, это IDEF0, BPMN, UML, EPC, CMMN и другие. Данная статья в равной степени относится к ним всем, в примерах использована нотация собственного приложения.

В статье словом “процесс” в зависимости от контекста может обозначаться как основной процесс, описываемый диаграммой, так и процессы, входящие в состав диаграммы. Слово “задача” может означать процесс, цель или ресурс, либо цельное сочетание ресурса, процесса и цели. В общем, смотрите по контексту.

Так как именно динамика является основной отличительной чертой рассматриваемых нами диаграмм, то, следовательно, ключевой частью такой диаграммы является её сценарий. Основные требования к сценарию — это непротиворечивость и непрерывность. Противоречия возникают при неверном порядке причин и следствий, а также в ситуации, когда один объект должен быть одновременно в разных местах (или два совмещаться в одном и том же месте). Непрерывность теряется, когда следствия не обусловлены причинами либо когда утерян существенный фрагмент повествования.

Вот здесь нужно осветить один важный момент касательно сценария и диаграммы в целом. Цель создания диаграммы не только в описании конкретного процесса, но и в передаче этого знания адресату. То есть на сюжет диаграммы влияет как описываемый ею процесс, так и её аудитория. К примеру, если вам нужно разъяснить пункт ПДД детям, вы воспользуетесь иной методикой изложения, нежели та, что использована в официально установленных правилах. Как правило, если сюжет не адаптирован к аудитории, то теряется его непрерывность, поскольку отдельные причинно-следственные связи неочевидны или непонятны адресатам.

Можно упомянуть много различных методов отладки диаграмм с целью устранения противоречий и соблюдения непрерывности. Но эффективнее будет сразу строить качественные диаграммы, и так как статья носит больше практический характер, то вместо описания методов анализа качества я просто приведу пошаговый алгоритм построения хороших диаграмм.

Шаг 1. Разместите свои цели как ресурсы в правом нижнем углу диаграммы.

Обычно процессы, которые имеет смысл описывать, имеют чётко выраженную конечную цель или группу целей. Такой целью может также служить состояние, после которого дальнейшее исполнение процесса не имеет смысла. Как правило, процессы создаются под конкретные цели, и зачастую очевидно, что написать в правом нижнем углу диаграммы. Однако иногда бывает дальновидным указать не только положительную цель, но перечислить состояния, в которых исполнение процесса прерывается, но исходная цель не достигнута или достигнута не полностью. Рекомендуется явно перечислять подобные негативные цели в случаях, если вероятность достижения основной цели ниже 60%.

Забегая вперёд, скажу, что рекомендация по размещению конечной цели справа внизу диаграммы (как и последующие подобные рекомендации) относится к композиции диаграммы, которая будет предметом рассмотрения другой статьи.

Шаг 2. Отметьте доступные ресурсы в виде объектов в верхней части диаграммы.

Очевидно, что перечислять следует не все возможные ресурсы, а только те, которые видятся полезными для достижения цели и ликвидность которых не вызывает сомнений. Перечень этих ресурсов будет являться исходными условиями начала процесса. Одним из таких ресурсов должен быть триггер, запускающий весь процесс, обычно это внешнее воздействие: заявка клиента, смена состояния индикатора, запрос от системы и т. д.

Шаг 3. Разместите предполагаемые промежуточные цели как ресурсы в средней части диаграммы.

Комплексные цели обычно состоят из набора компонентов, которые необходимо реализовать предварительно. Большие проекты удобно разбивать на этапы, результатом исполнения которых является получение одного из компонентов конечной цели. Мысленно расчлените конечную цель на такие компоненты и поместите их на диаграмму. В некоторых случаях вместо компонентов можно разбить конечный продукт на последовательность эволюций зрелости продукта или совмещать оба подхода.

Шаг 4. Перед целями, имеющимися на диаграмме, разместите процессы, которые приводят к достижению данных целей, и соедините новые процессы с их целями.

Заметьте, что пока на нашей диаграмме процессов не было ни одного процесса, это неслучайно. Специфика нашего мышления такова, что, начиная что-то делать, мы больше концентрируемся на процессах, немного забывая, что суть нашей деятельности в целях. Диаграммы процессов, состоящие из одних только процессов, — частое явление, однако следует помнить, что мы стремимся к непрерывности и ясности изложения, а зачастую указание целей исполнения процесса говорит о нём больше, нежели название процесса и его описание. Старайтесь всегда явно указывать цели процесса, на практике это означает, что стрелка от одного процесса к другому — это редкое явление, обычно между процессами располагается промежуточный ресурс, являющийся результатом исполнения одного процесса и исходным ресурсом для другого. В некоторых формализмах (например DFD) сама стрелка может являться описанием ресурса. Однако если такой промежуточный ресурс очевиден, то ради упрощения схемы его можно опустить и провести стрелку от одного процесса к другому. Например, если в прачечной после процесса “Сушка” следует процесс “Глаженье”, то в некоторых случаях промежуточный ресурс “Сухое бельё” можно пропустить.

Шаг 5. Проведите связи от имеющихся на диаграмме ресурсов к использующим их процессам; если необходимого для процесса ресурса нет на диаграмме, добавьте новую цель, вернувшись к Шагу 3 ^.

Очевидно, что если требуемого процессом ресурса нет, то это приводит к противоречию в исполнении задачи, так как соблюдены не все причины для желаемых следствий. Следовательно, необходимо исполнить критерий полноты — всё необходимое для исполнения каждого процесса должно быть в наличии. Впрочем, не всегда оправдано явно указывать очевидные ресурсы, например, при обработке детали станком одним из очевидных ресурсов является электроэнергия, явное выделение этого ресурса, скорее всего, не сделает диаграмму понятнее, однако без значимых причин усложнит её. Помните о своей аудитории: часть диаграммы зритель всегда достраивает мысленно, это неизбежно. Старайтесь, чтобы мнимая часть диаграммы касалась очевидных всем моментов, более того, слишком явные вещи, выписанные на диаграмме, могут утомлять и даже раздражать.

Шаг 6. Проведите связи между процессами, исполнение которых зависит друг от друга.

Попарно проверьте все процессы, размещённые на диаграмме, нет ли между ними неявных зависимостей или взаимного влияния. Например, часто полезно “грязные” процессы группировать вместе, чтобы экономить на очистке рабочей области. Также если два процесса конкурентно используют ограниченный ресурс, то их следует развести во времени, проложив связь от одного из них к другому. Заметьте, что ресурсы, которые мы не отображаем на диаграмме, тоже могут быть причиной скрытых зависимостей, к примеру, когда два процесса используют энергоёмкие станки, которые не следует включать одновременно.

Шаг 7. Убедитесь, что диаграмма легко читается и содержит не более 20 объектов; если это не так, сгруппируйте несколько контекстно связанных объектов в один объект подходящего типа с вложенной диаграммой, содержащей данную группу.

Практика показывает, что когда диаграмма содержит более 20 объектов (ресурсов или процессов), то схема перестаёт восприниматься цельно, а начинает выглядеть, как лабиринт, в котором зрителю нужно выискивать интересующие его пути. С другой стороны, редко какой проект или бизнес-процесс уложится в такое небольшое число объектов. К счастью, то, что не вместит одна диаграмма, поместится на нескольких, не стремитесь всё изложить сразу, помните: всегда можно сделать ещё одну диаграмму.

Итак, если схема получилась громоздкой, выделите группу объектов, по возможности слабо связанных с другой частью диаграммы, и замените их одним процессом. Удалённые объекты станут основой новой диаграммы, которая будет пояснять суть нового процесса.

Такая, казалось бы, чисто техническая задача на самом деле имеет большое значение, так как подобным образом выстраивается иерархия детализации задач и разделение контекстов исполнения процессов. Теперь с точки зрения основной диаграммы не важно, как реализован новый процесс, подробности его реализации вынесены в отдельную диаграмму, они существуют как бы в отдельном пространстве, на которое основная схема имеет ограниченное влияние. Это довольно полезное свойство: чем более независимы соседние задачи, тем меньше вероятность, что ошибки и проблемы одной из них будут влиять на другие.

Другим важным аспектом детализации диаграмм является возможность развести аудитории: как правило, диаграммы верхнего уровня интересны менеджерам, а вложенные диаграммы больше полезны техническим специалистам. Разбив диаграмму на уровни, мы можем каждую новую диаграмму проектировать с учётом её аудитории, формируя сюжет, понятный и увлекательный именно для неё.

Шаг 8. Убедитесь, что объекты имеют тип, соответствующий их сути, визуально разделите информационные и физические потоки. Если диаграмма содержит несколько контекстно связанных объектов, выделите их с помощью группы. В местах, требующих пояснений, разместите объекты типа комментарий.

В зависимости от выбранной нотации описания процессов нам будут доступны различные типы графических объектов, описывающих специфические аспекты задач, внимательно изучите перечень доступных объектов и используйте наиболее подходящее описание для каждой из задач. Иногда нотация позволяет отдельно выделить область на диаграмме, внутри которой можно расположить задачи, связанные каким-то общим признаком: исполнителем, местом исполнения и т. д.

Часто такие области оформляются как горизонтальные дорожки, после чего диаграмма выглядит, как бассейн, в котором каждый исполнитель плывёт по своей дорожке вдоль своих задач. Такая организация диаграммы довольно наглядна, но может иметь свои композиционные недостатки.

Шаг 9. Для процессов, не являющихся элементарными операциями, постройте вложенную диаграмму, начиная с Шага 1.

На Шаге 7 мы синтетически создавали новую задачу из группы объектов и детализировали её вложенной диаграммой. На этом шаге делается то же самое, но аналитически: мы пытаемся сложный объект разложить на более простые процессы и отобразить их во вложенной диаграмме. В управлении проектами этот процесс называют структурной декомпозицией работ. Разбивая задачи на более мелкие или объединяя их в более крупные, следует следить, чтобы задачи одного уровня, отображаемые в одной диаграмме, были приблизительно равны по значимости и трудоёмкости.

Шаг 10. Для отдельных ресурсов там, где это необходимо, добавьте вложенную диаграмму подготовки ресурса к использованию. Для избранных целей добавьте диаграмму по проверке требуемых качеств достигнутой цели.

Продолжаем работу по декомпозиции, но акцентируем внимание на ресурсах и целях.

Успешно завершив все десять шагов, мы должны получить набор процессных диаграмм, иллюстрирующих непротиворечивый и непрерывный сценарий по достижению запланированных целей. Однако эти диаграммы ещё не являются готовым продуктом, для каждой из них нужно найти подходящее композиционное решение и оформить их, соблюдая ряд визуальных формальностей и нюансов. Тому, как превратить нашу сырую руду в звонкий металл, будут посвящены следующие статьи, пока же подведём итог этой.

Итак, описание любого процесса начинается с составления сценария, который связывает объективную структуру процесса с аудиторией, для которой предназначено описание. В случае если адресатом является человек, удобно пользоваться компактными диаграммами процессов, организованными в иерархическую структуру, основанную на архитектуре процесса. Заметьте, что внедрённая в описание процесса иерархия может не быть частью самого процесса, она больше нужна для целей эффективного восприятия аудиторией — иногда, чтобы что-то сделать проще, сначала это нужно усложнить.

|

Метки: author Shortki управление проектами бизнес-модели gtd ecm/ сэд agile бизнесс-процессы управление задачами диаграммы диаграмма состояний |

[Из песочницы] Работа c Talend Open Studio на примере парсинга CSV файла |

Работа c Talend Open Studio на примере парсинга CSV файла

Меня несколько удивило отсутствие статей про работу с TOS на Хабре. Возможно, тому есть причины, мне непонятные. Как бы то ни было, постараюсь восполнить этот пробел.

Вероятно, при написании этой статьи я был излишне подробен в некоторых вопросах, поэтому некоторые инструкции я спрятал под спойлер.

Итак, TOS это Open Source решение для интеграции данных. Основным средством настройки процесса преобразования данных в TOS является специальный визуальный редактор, позволяющий добавлять и настраивать отдельные узлы преобразования данных и связи между ними.

Интересной особенностью и существенным плюсом TOS, на мой взгляд, является тот факт, что TOS преобразует наши компоненты и связи в код Java. По сути мы получаем библиотеку на Java с возможностью генерировать код на основе графа преобразования данных. Плюс мы можем собрать пакет и запустить его на любой машине, где есть Java и где может отсутствовать TOS.

Генерация кода дает нам еще один плюс — можно расширять возможности TOS путем написания собственного кода (для этого даже есть специальные инструменты).

Отдельное целостное преобразование данных в Talend называется задачей(job). Задача состоит из подзадач, которые, в свою очередь, состоят из компонент и связей. Компоненты непосредственно преобразуют данные либо занимаются вводом/выводом. Связи бывают нескольких типов. Основным средством обмена данными между компонентами являются связи типа “поток”(flow). Поток очень похож на таблицу в БД. У потока есть схема(названия, типы и атрибуты полей) и данные(значения полей). Как сами данные так и схема потока могут быть изменены в процессе обработки. Потоки в TOS не синхронизируются между собой. Они работают независимо друг от друга.

Далее, попробую на примере показать, как настраивается процесс обработки данных.

Предположим у есть нас CSV файл вида:

id,event_name,event_datetime,tag

1,"Hello, world!",2017-01-10T18:00:00Z,

2,"Event2",2017-01-10T19:00:00Z,tag1=q

3,Event3,2017-01-10T20:00:00Z,

4,"Hello, world!",2017-01-10T21:00:00Z,tag2=a

5,Event2,2017-01-10T22:00:00Z,

...

И мы хотим разделить данные по разным событиям(поле event).

Перед началом работы с данными нам потребуется создать задачу. Процесс создания не описываю по причине его тривиальности.

Итак, первое что нам надо сделать это прочитать и распарсить CSV. Для начала создадим запись метаданных для нашего входного CSV файла — это упростит дальнейшую работу (Metadata -> File delimited). Создание File delimited происходит более или менее интуитивно, поэтому подробное описание спрятано под спойлером.

Единственное, что заслуживает упоминания, это расстановка кавычек, при подстановке значений в поля форм. Это относится не только к созданию File delimited но и к большинству других полей в формах. Дело в том, что большинство значений во всевозможных полях будут подставлены в Java код “как есть”, т.е. должны являться выражением Java определенного типа. Если мы задаем строковую константу ее придется написать в кавычках. Это дает нам дополнительную гибкость. Получается что везде, где требуется значение, можно подставить значение параметра или выражения.

Далее необходимо задать имя и выбрать файл. Выбираем наш CSV файл с входными данными.

На следующем шаге необходимо настроить парсинг файла.

Интересные поля:

Разделитель полей — у нас запятая (comma).

В секции “Escape Char Settings” нас интересует поле “Text Enclosure”. Зададим значение “\”” — т.е. “двойная кавычка”. Теперь весь текст внутри двойных кавычек будет интерпретироваться как единое целое, даже если внутри есть разделитель(запятая).

В правой части можно настроить пропуск строк и ограничения. Нас это не интересует.

Поставим галочку “Установить строку заголовка в качестве имен столбцов” т.к. у нас в первой строчке находятся имена столбцов. Эти значения станут именами полей.

Кнопка “Refresh Preview” позволит обновить область предпросмотра. Убеждаемся, что все в порядке и идем дальше.

Далее от нас требуется настроить схему для выходного потока. Схема это набор типизированных полей. Каждому полю также могут быть назначены некоторые атрибуты.

Заголовки из CSV файла стали именами полей. Тип каждого поля определяется автоматически исходя из данных в файле. Здесь нас все устраивает, кроме формата даты. Дата в нашем файле выглядит примерно следующим образом 2017-01-10T22:00:00Z и для ее парсинга нужен шаблон «yyyy-MM-dd'T'HH:mm:ss'Z'». Обратите внимание на кавычки. Дело в том, что большинство значений во всевозможных полях будут подставлены в java код “как есть”, т.е. должны являться выражением Java определенного типа. Если мы задаем строковую константу ее придется написать в кавычках.

Теперь у нас есть шаблон парсера CSV файлов заданного формата.

Далее добавим компонент, который будет заниматься парсингом. Нужный нам компонент называется tFileInputDelimited.

Далее, настроим наш парсер. Для компонента tFileInputDelimited в настройках установим “Property type” в значение “Repository” и выберем ранее созданный шаблон.

Теперь парсер настроен на парсинг файлов нужного нам формата и если запустить работу то в логах мы увидим содержимое нашего исходного CSV файла. Проблема в том, что если парсер связан с шаблоном он жестко настроен на файл в шаблоне. Мы не можем указать другой файл такого же формата, что может быть не очень удобно, когда мы заранее не знаем что за файл собираемся обрабатывать.

Из этой ситуации есть два выхода. Первый — все время подменять файл из шаблона на нужный файл. Второй — развязать компонент парсера и шаблон. В этом случае настройки парсинга можно сохранить, но появляется возможность задать входной файл. Недостатки первого способа очевидны, к недостаткам второго относится отсутствие синхронизации между шаблоном и парсером. Если мы изменим шаблон то синхронизировать настройки парсера нужно будет вручную. Мы пойдем вторым путем и отвяжем парсер от шаблона. Для этого вернем значение “Build-In” в поле “Property type”. Настройки сохранились, но появилась возможность их менять.

Изменим имя входного файла на выражение context.INPUT_CSV. Обратите внимание, имя было в кавычках (строковая константа), а наше выражение без кавычек. Оно является параметром контекста. Также нужно создать этот параметр на вкладке контекста. Для отладки можно задать значение по умолчанию. Параметры контекста можно задавать как параметры командной строки (примерно так --context_param INPUT_CSV=path). Это относится к запуску собранного пакета Java.

Далее. Мы хотим разделить данные по именам событий.

Для этого потребуется компонент tMap и несколько tFilterRow. Давайте пока ограничимся двумя tFilterRow т.е. будем выделять только два разных события. Соединим их как показано на рисунке:

При соединении tMap и tFilterRow потребуется ввести имя для связи. Имя должно быть уникально. Далее нужно настроить компонент tMap. Для этого войдем в меню Map Editor либо дважды кликнув по иконке tMap, либо вызвав редактор из панели свойств компонента.

В нашем случае нам нужно только “скопировать” поток, поэтому просто перетащим все поля входящих данных (слева) в каждый из потоков вывода (справа).

В секции в середине можно задать внутреннюю переменную (можно использовать для генерации новых значений, например номеров строк, или подстановки параметров). В каждой ячейке редактора можно написать выражение. По сути то что мы сделали это и есть подстановка значений. row1 на скриншоте это имя входного потока. Теперь наш маппер будет делить входные данные на два потока.

Настройка фильтров tFilterRow не представляет из себя ничего особенного.

Параметр “Функция” в настройках компонента задает преобразование входных данных и задает функцию преобразования F. Тогда условия отбора будет: F(input_column) {comparator} value. У нас нет функции F,{comparator} это равенство, а value это «Hello, world!». Получаем в нашем случае input_column == «Hello, world!».

Добавим после фильтров пару tLogRow, запустим и увидим что данные делятся. Единственно, лучше установить Mode для tLogRow в что-то отличное от “Основной”, иначе данные перемешаются.

Вместо tLogRow можно добавить какой угодно другой компонент вывода данных, например tFileOutputDelimited для записи в CSV файл, или компонент базы данных для записи в таблицу.

Для работы с базой данных есть множество компонент. Многие из них имеют в настройках поля для настройки доступа к базе. Однако если предполагается много обращаться к базе из разных компонент лучше всего использовать следующую схему:

Компонент Connection задает параметры доступа к базе и устанавливает соединение. Компонент Close отключается от базы. В среднем блоке, где на рисунке находится единственный компонент Commit, можно использовать базу данных не устанавливая новых соединений. Для этого в настройках компонентов нужно выбрать опцию “Использовать существующее соединение” и выбрать нужный компонент Connection.

Здесь также используется еще один механизм TOS — подзадачи (subjob). Путем создания подзадач можно добиться, чтобы некоторые части задачи завершались прежде, чем начнутся другие. В данной примере компонент Commit не начнет работу пока не установится соединение. Между подзадачами проводится связь OnSubjobOk (в контекстном меню компонента доступен пункт Trigger, внутри которого есть эта связь). Существуют и другие связи, например, ObSubjobError для обработки ошибок.

Вернемся к нашему примеру с CSV файлом.

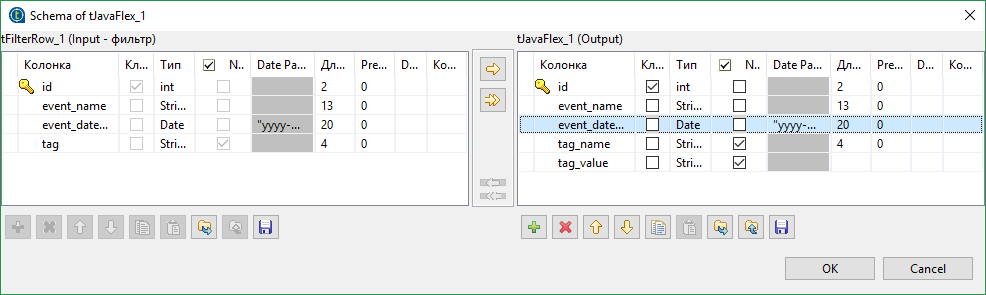

Поле tag у нас не очень подходит для записи в базу данных — tag2=a. Наверняка мы захотим разделить пару ключ-значение по разным полям в базе. Это можно сделать разными способами, но мы сделаем это при помощи компонента tJavaFlex. tJavaFlex это компонент, поведение которого можно описать на языке Java. В его настройках присутствуют три секции — первая выполняется до начала обработки данных (инициализация), вторая занимается обработкой данных и третья выполняется после обработки всех данных. Также, как и у остальных компонент есть редактор схемы. Удалим из схемы данных на выходе поле tag и добавить пару новых — tag_name и tag_value (типа String).

Далее, в средней секции компонента напишем

row4.tag_name = "";

row4.tag_value = "";

if(row2.tag.contains("="))

{

String[] parts = row2.tag.split("=");

row4.tag_name = parts[0];

row4.tag_value = parts[1];

}

Код тривиальный, и, пожалуй единственной что стоит пояснить, это конструкции вида row4.tag_value. tag_value это имя поля, созданного нами. Таким же образом можно обращаться к другим полям. row4 это имя исходящего потока (row2 входящего). Их можно поменять.

Таким образом, теги будут разделены на два поля. Однако нужно убедиться, что в настройках tJavaFlex стоит галочка “Авто-распространение данных”, иначе все остальные данные исчезнут. По сути мы просто дописали дополнительное преобразование. Прочие поля совпадают по названию и будут скопированы автоматически.

Далее я расскажу о двух чуть более сложных и конкретных вещах.

Предположим, что мы все же хотим сложить наши данные в базу данных. Соответственно, у нас есть табличка Event с полями: имя события, идентификатор события, дата события и ссылка на запись в таблице тегов. В таблице тегов два поля — ключ и значение. Мы хотим добавлять нашу пару ключ-значение в таблицу тегов только в том случае, если ее там нет. И хотим также добавлять связь между таблицами тегов и событий.

Т.е. мы хотим:

- проверить есть ли такая пара ключ-значение в таблице тегов и если нет добавить

- получить id записи в базе данных, соответствующей нашему тегу

- записать данные о событии, включая id записи в таблице тегов, в таблицу событий

Для того чтобы добавить запись только в том случае если ее нет в Postgres можно использовать конструкцию вида

INSERT

WHERE NOT EXISTS

Сделать это можно при помощи компонента tPostgresqlRow. Это компонент позволяет выполнить произвольный SQL запрос. Но нам придется подставить в наш запрос реальные данные. Это можно сделать, например, так

String.format("

INSERT INTO tag(tag_name, tag_value)

SELECT '%s', '%s'

WHERE NOT EXISTS

(SELECT * FROM tag

WHERE tag_name = '%s'

AND tag_value = '%s');",

input_row.tag_name, input_row.tag_value,

input_row.tag_name, input_row.tag_value)

Да, параметры перечисляются два раза одни и те же (возможно я слишком плохо знаю Java). Обратите внимание, что точка с запятой в конце кода на Java не нужна.

После этого нужно сделать тривиальный запрос, чтобы получить id записи в таблице.

Но в случае с Postgres можно пойти более простым путем, и использовать RETURNING id. Однако этот механизм вернет значение только если данные будут добавлены. Но при помощи подзапроса можно обойти это ограничение. Тогда наш запрос преобразуется во что-то подобное:

String.format("

WITH T1 AS (

SELECT *

FROM tag

WHERE tag_name = '%s'

AND tag_value = '%s'

), T2 AS (

INSERT INTO tag(tag_name, tag_value)

SELECT '%s', '%s'

WHERE NOT EXISTS (SELECT * FROM T1)

RETURNING tag_id

)

SELECT tag_id FROM T1

UNION ALL

SELECT tag_id FROM T2;",

input_row.tag_name, input_row.tag_value,

input_row.tag_name, input_row.tag_value)

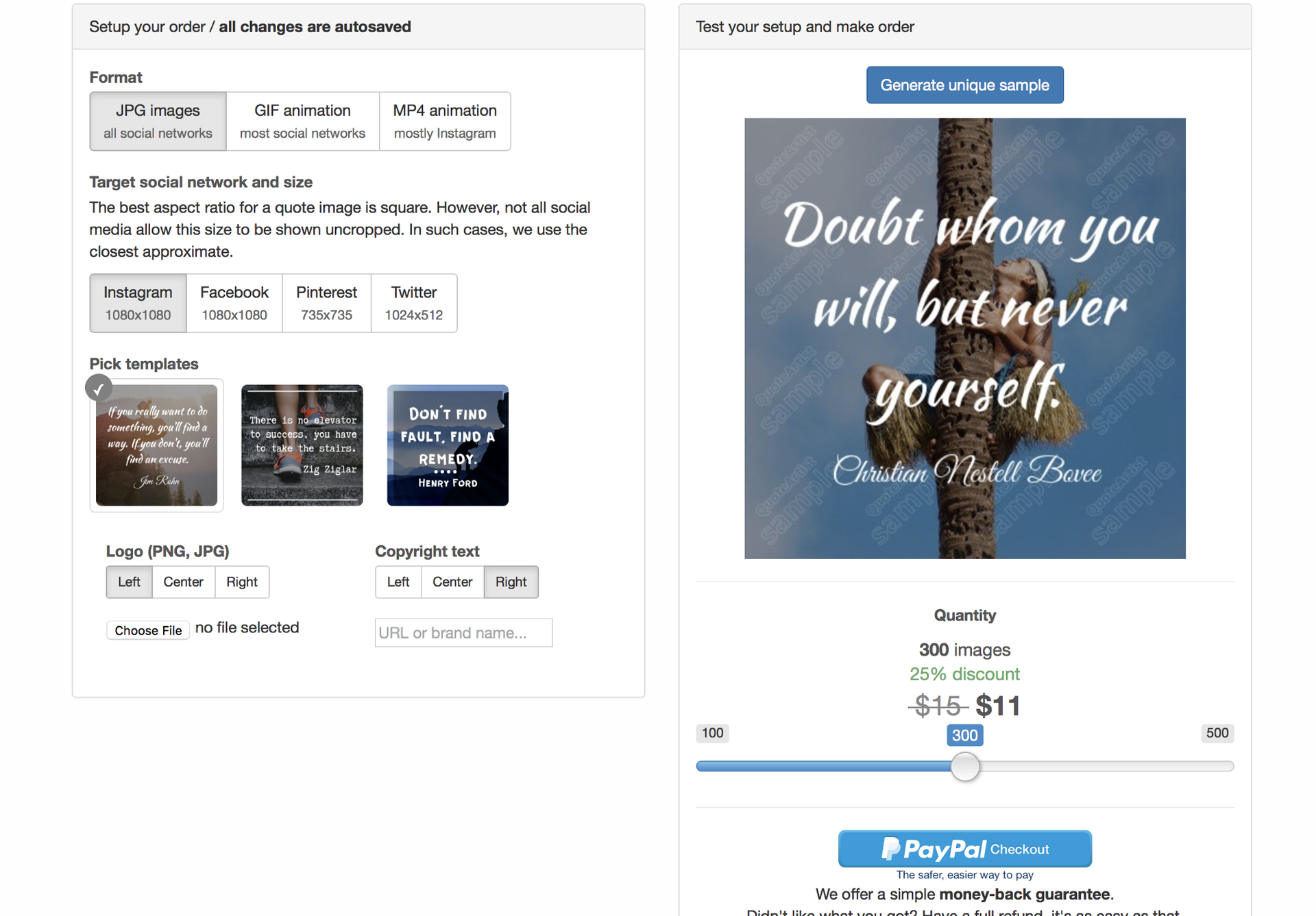

Должно получиться примерно следующее:

Т.е. все наши поля автоматически будут установлены в нужные значения, а новое поле dbtag_id типа int будет взят из результатов запроса по ключу “tag_id”. Сложить все в таблицу event можно при помощи того же tPostgresqlRow или tProstgresqlOutput.

В итоге получится примерно следующая схема:

Отдельного рассмотрения заслуживает случай, когда у нас возникает необходимость в создании замкнутой структуры. TOS не позволяет делать замкнутых структур, даже если они не являются циклическими. Дело в том, что потоки данных живут каждый сами по себе, не синхронизируются, и могут нести разное количество записей. Наверняка, почти всегда можно обойтись без образования замкнутых контуров. Для этого придется не делить потоки и делать все в одном. Но если очень хочется, то при желании можно обойти ограничение на создание замкнутых структур. Нам потребуется компоненты tHashInput и tHashOutput.

Эти компоненты позволяют сохранять потоки в памяти и после осуществлять к ним доступ. Можно, конечно, воспользоваться временным файлом, но хэш наверняка быстрее (если у вас хватит оперативной памяти).

Добавляем компонент tHashOutput и входящий поток, который хотим сохранить. Компоненту можно настроить на самостоятельную работу, либо на дописывание данных в другой tHashOutput компонент. В этом случае компонент будет работать подобно union из sql, т.е. данные будут записываться в один общий поток.Придется создать новую подзадачу, в которой будет осуществляться слияние. Не забудьте добавить связь OnSubjobOk.

Для каждого потока, работающего индивидуально, нужно создать компоненту tHashInput. У этой компоненты есть недостаток — даже после указания компоненты tHashOutput, из которой будут браться данные, схема не подгрузится автоматически. Далее все tHashInput нужно объединить при помощи tMap. Только один поток будет помечен как Main, по нему будут синхронизироваться остальные входящие потоки, а также исходящий, остальные входящие потоки будут Lookup. Кроме того нам надо задать связь между потоками, иначе мы получим Cross Join.

Теперь, несмотря на то что в левой части маппера много потоков, можно считать что у нас один входной поток и использовать для маппинга любые поля любых потоков.

На этом все, спасибо всем кто дочитал до конца.

|