Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Автопилот своими рукам. Добавляем электронное управление steer-by-wire на обычный автомобиль |

Автопилот своими рукам. Добавляем электронное управление steer-by-wire на обычный автомобиль

Всем привет. Любому автопилоту, очевидно, нужно не только принимать решения по управлению, но и заставлять автомобиль этим решениям подчиняться. Сегодня увидим, как весьма доступными средствами доработать обычный автомобиль полностью электронным рулевым управлением (steer-by-wire). Оказывается, сам авто для разработки не очень и нужен, а большинство функционала можно с комфортом отлаживать дома или в офисе. В главных ролях всем известные компоненты из хобби-магазинов электроники.

Задумаемся на секунду, что нужно для системы электронного управления? Сервопривод, который может поворачивать колёса, и контроллер, чтобы сервоприводом управлять. Внезапно, всё это в большинстве современных автомобилей уже есть, и называется "усилитель рулевого управления". Традиционные чисто механические (как правило, гидравлические) усилители стремительно исчезают с рынка, уступая место узлам с электронным блоком управления (ЭБУ). А значит, задача сразу упрощается: нам остается только "уговорить" имеющийся ЭБУ усилителя выдать нужные команды на сервопривод.

Очень удобным для доработки оказался KIA Cee'd начиная с 2015 модельного года (скорее всего аналогично и его соплатформенники от KIA/Hyundai). Сошлись одновременно несколько факторов:

- Усилитель руля полностью электрический, нет возни с гидравликой, стоит копейки (относительно) на разборках. Вся нужная проводка выведена наружу и легко доступна.

- Усилитель интегрирован с рулевой колонкой, поэтому к нему есть легкий доступ на автомобиле и любая дополнительная электроника останется в салоне в тепличных условиях (в отличие от усилителей, интегрированных в рулевую рейку).

- Очень важно — есть пример успешной доработки аналогичного KIA Soul. Американская PolySync разрабатывает апгрейд Soul до полностью drive-by-wire платформы для беспилотников, и на их гитхабе можно подсмотреть много полезного.

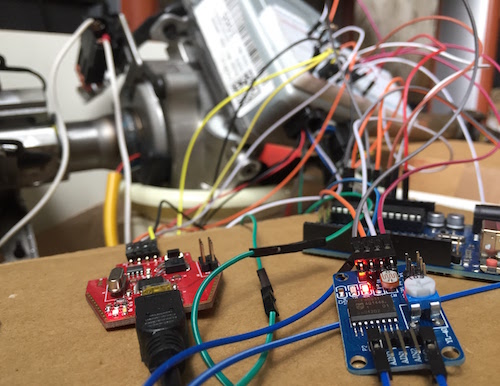

Итак, получена в распоряжение рулевая колонка в сборе:

Будем заставлять её крутиться. Для этого нужно создать у блока управления впечатление, что

- Он находится в автомобиле с работающим двигателем.

- Водитель прикладывает вращающее усилие к рулевому колесу.

Пойдем по порядку.

Симуляция автомобиля

Нужно понять интерфейс между электронным блоком управления (ЭБУ) усилителя и остальным автомобилем. Нагуглив электрическую схему видим картинку:

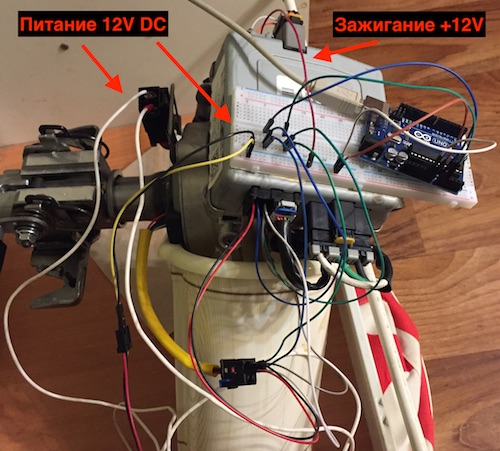

Из схемы видно, что физически интерфейс очень прост:

- Питание (12V постоянное) через разъем E29.

- Сигнал включенного зажигания (12V) через разъем M46.

- CAN-шина данных также через разъем M46.

Внешний вид и распиновки разъемов находим на том же сайте.

С питанием и зажиганием всё просто, берем 12V с обычного компьютерного блока питания. Но если просто подать питание и зажигание, усилитель полноценно не включится, и усиливать не будет. Дополнительно нужна информация от других блоков автомобиля: работает ли двигатель (чтобы не тратить энергию аккумулятора при выключенном), текущая скорость (чтобы делать руль "тяжелее" на скорости), наверняка что-то ещё.

Обмен данными между электронными блоками в современных автомобилях организован по шинам CAN (Controller Area Network). Это широковещательная (у пакетов нет адресов назначения) локальная сеть на витой паре, где каждый блок может публиковать свои данные. У каждого типа данных свой идентификатор. Например, в нашем случае усилитель руля рассылает значения угла поворота руля с ID 0x2B0. Часто бывает несколько физически разделенных шин, чтобы второстепенные блоки типа контроллеров стеклоподъемников не мешались обмену между критически важными компонентами. В Cee'd используется две шины: C-CAN и B-CAN (схема здесь, в части "Информация о канале передачи данных"). На C-CAN "висят" почти все блоки с ней и будем работать.

Выбор адаптера CAN-шины

Первым делом понадобится CAN интерфейс для компьютера. Детальный обзор возможных решений есть например здесь, цены варьируются от десятков до сотен долларов. По устройствам у нас относительно доступны:

- Адаптеры в сборе с алиэкспресса. Их не пробовал, по слухам довольно много брака и софт видимо только под Windows.

- Arduino шилды на MCP2515/MCP2551, в основном клоны дизайна от seeed в любом магазине ардуинной тематики. Но совмещать такой шилд надо не с Arduino (я так и не смог заставить связку работать на воспроизведение с нужной скоростью), а с Raspberry Pi. В приложении ниже подробная инструкция.

- USB адаптер CANHacker Baby, разработка Artemka86. Выгодно отличается от вариантов с алиэкспресса отличной поддержкой "из первых рук" от разработчика (проверено лично, Артём подходит к делу с душой). Также плюсом является поддержка стандартного протокола LAWICEL совместимого с широким набором софта.

Софта разного тоже много (за обзором опять сюда). Самый простой вариант — Linux c can-utils из SocketCAN, за который спасибо инженерам Volkswagen. Большой плюс SocketCAN в стандартизации — любое USB устройство с поддержкой протокола LAWICEL (pdf) видится системой как обычный сетевой интерфейс. Таким образом избегаем привязки к вендор-специфическому софту конкретного устройства. У текущей версии CANHacker есть небольшая несовместимость со стоковыми can-utils по работе с USB, поэтому берём патченную версию отсюда. Raspberry Pi с CAN шилдом работает со стоковым пакетом can-utils из Raspbian OS без проблем.

Подключение к шине, запись пакетов

С подключением к индивидуальному узлу на стенде всё просто: соединяем контакт CAN-High адаптера с CAN-High автомобильного узла, CAN-Low — c CAN-Low. По стандарту между CAN-High и CAN-Low должно быть 2 замыкающих резистора по 120 Ом, на практике обычно всё работает на довольно широком интервале сопротивлений, у меня например одно на 110 Ом.

На автомобиле замыкающий резистор не нужен (они там уже стоят, чтобы шина сама по себе работала). В зависимости от модели авто, возможно придется повозиться с физическим доступом к проводке шины. Самый удобный вариант — разъём OBD-II (on-board diagnostic), он обязателен на всех легковых автомобилях, выпущенных в Европе с начиная 2001-2004 года и находится не дальше 60 см от рулевого колеса. На Cee'd разъём слева под рулём, за пластмасовой крышкой блока предохранителей.

Распиновка OBD-II стандартизована и включает шину CAN (CANH на 6 контакте, CANL на 14). Нам повезло, корейцы пошли по пути наименьшего сопротивления и вывели C-CAN, на которой висят все важные узлы, прямо на диагностический разъём:

В результате на Cee'd можно прослушать весь внутренний трафик, ничего в авто не разбирая. Когда машина не твоя, а знакомые пустили повозиться — большой плюс. Но такая халява не везде. У Volkswagen например служебная CAN изолирована от OBD шлюзом, поэтому подключаться пришлось бы примерно так:

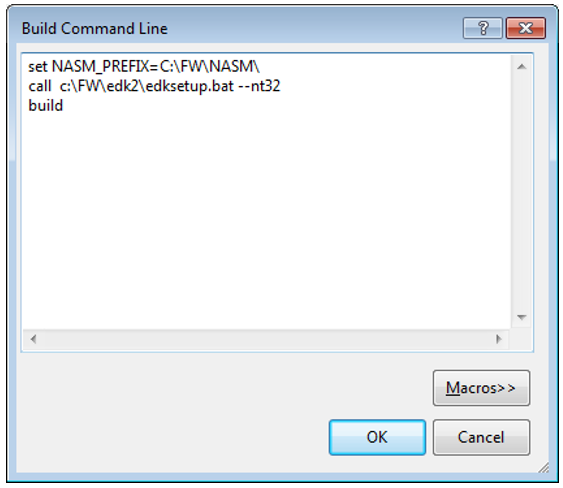

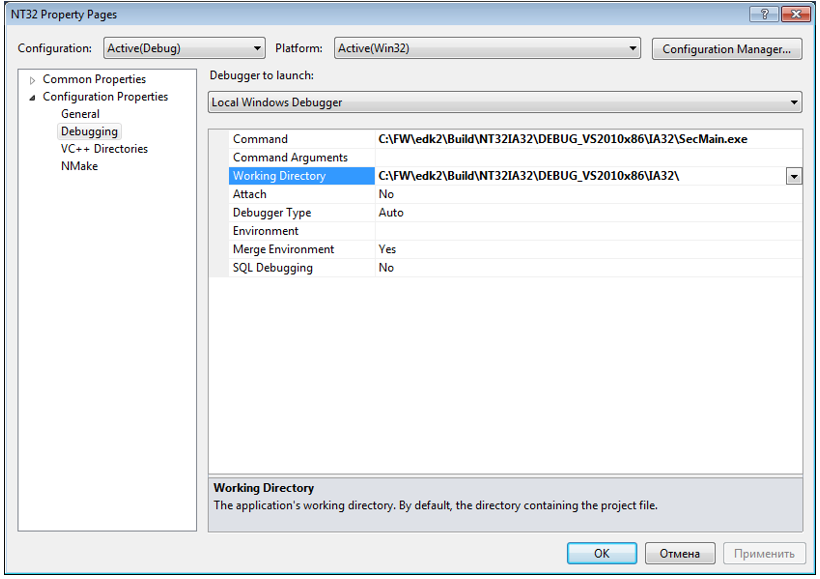

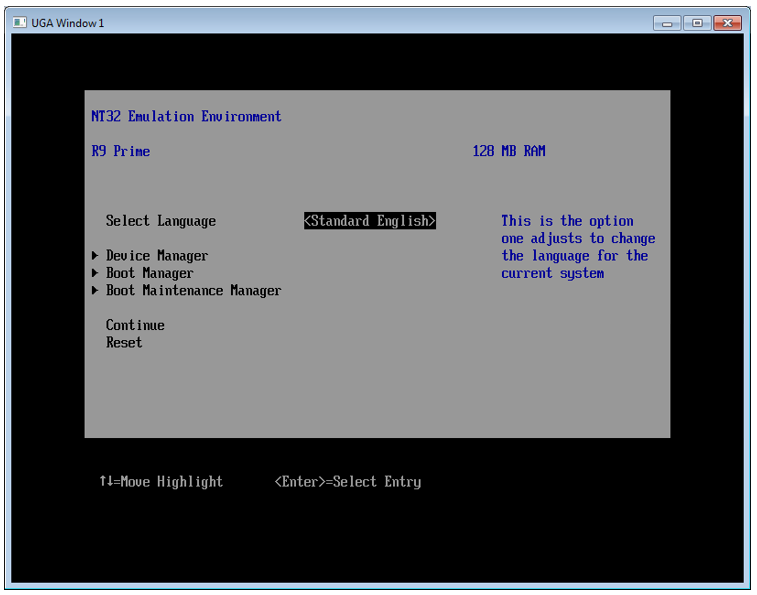

Подключив все контакты, поднимаем сетевой интерфейс:

$ sudo slcand -o -c -s6 -S 115200 ttyACM0 slcan0 && sleep 1 && sudo ifconfig slcan0 upПроверяем, что сеть работает и данные принимаются (включив зажигание):

$ cansniffer slcan0И наконец, если всё нормально, можно записывать лог:

$ candump -L slcan0 > real-car-can-log.txtЗдесь нужно запустить двигатель, т.к. усилитель руля включается на собственно усиление только при работающем двигателе, а нам на стенде надо, чтобы он усиливал.

Воспроизведение записи шины на стенде

С записанным логом с авто можно возвращаться на стенд и приступать к обману нашего одинокого усилителя. Первым делом вспомним, что в автомобиле стоит свой собственный усилитель, он тоже шлёт данные в CAN шину, и эти пакеты есть и в нашем логе. Отфильтруем их, чтобы избежать конфликтов. Подключаемся к усилителю на стенде, смотрим, что он выдает:

$ $ candump slcan0

slcan0 2B0 [5] 00 00 00 00 00

slcan0 2B0 [5] FF 7F FF 06 F1

slcan0 2B0 [5] FF 7F FF 06 C2

slcan0 2B0 [5] FF 7F FF 06 D3

slcan0 2B0 [5] FF 7F FF 06 A4

slcan0 2B0 [5] FF 7F FF 06 B5

slcan0 2B0 [5] FF 7F FF 06 86

slcan0 2B0 [5] FF 7F FF 06 97

slcan0 2B0 [5] FF 7F FF 06 68

slcan0 5E4 [3] 00 00 00

slcan0 2B0 [5] FF 7F FF 06 79

slcan0 2B0 [5] FF 7F FF 06 4A

....Видим, что рассылаются пакеты 2B0 (текущий угол поворота руля) и, реже, 5E4 (какой-то общий статус усилителя). Отфильтровываем их из общего лога:

$ cat real-car-can-log.txt | grep -v ' 2B0' | grep -v ' 5E4 ' > can-log-no-steering.txtФильтрованный лог можно подавать на воспроизведение:

% sudo ifconfig slcan0 txqueuelen 1000

$ canplayer -I can-log-no-steering.txtЕсли всё сработало успешно, усилитель заработает, крутить рукой рулевой вал станет гораздо легче. Итак, работать в штатном режиме мы узел заставили, можно переходить к симуляции усилий на руле.

Эмуляция усилия на руле

Крутящий момент на рулевом валу и угол поворота измеряются встроенным блоком датчиков, от которого идет жгут проводов к блоку управления усилителем:

Блок управления обрабатывает сигналы датчиков и выдаёт команды сервоприводу на создание дополнительного усилия на поворот рулевого вала.

Проверка формата сигнала датчиков

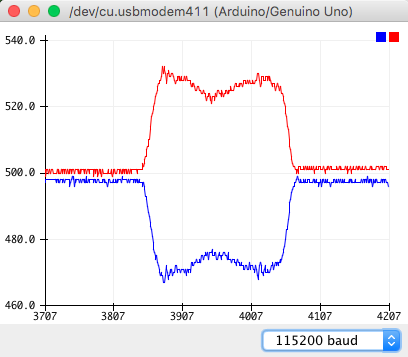

По информации PolySync, на Soul, у которого с Cee'd общая платформа, два аналоговых датчика крутящего момента. Cигнал каждого — отклонение уровня постоянного напряжения от базовых 2.5V, провода в жгуте — зеленый и синий. Проверим, что у нас то же самое:

- Размыкаем разъем на ЭБУ, пробрасываем нужные контакты через макетку и заводим на аналоговые входы arduino.

- Загружаем скетч, в цикле замеряющий напряжения и печатающий их в терминал.

- Запускаем Serial Plotter в Arduino IDE, поворачиваем рулевой вал. Видим результат на графике, схема совпадает с Soul:

- Радуемся сэкономленному времени.

Эмуляция сигнала датчиков

Переходим к эмуляции сигнала датчиков. Для этого поставим свой модуль в разрыв цепи между датиком и ЭБУ, будем транслировать настоящий сигнал с датчика и по команде сдвигать его на фиксированный уровень (изображая приложенное к рулевой колонке усилие). Силами одной arduino это не получится: там нет полноценного цифро-аналогового преобразователя, который мог бы выдавать постоянное напряжение. Аналоговые входы arduino нам тоже не очень подходят — хотя пинов для них целых 6, канал АЦП в контроллере только один, и его переключение между пинами занимает заметное время.

Нужно добавить к arduino внешние ЦАП/АЦП. Мне попались модули YL-40 (описание в pdf) на основе чипа PCF8591 — на каждой по 4 канала 8-бит АЦП и 1 8-бит ЦАП. Модуль может общаться с arduino по протоколу I2C. Потребуется небольшое допиливание (в буквальном смысле): китайские товарищи поставили на плату светодиод индикации напряжения на выходе ЦАП — его обязательно надо отсоединить. Иначе утекающий через диод ток не даст ЦАП поднять напряжение на выходе больше 4.2V (вместо штатных 5V). Диод отсоединяем, отковыривая резистор R4 с обратной стороны платы.

Также на входы распаяны игрушечные нагрузки (терморезистор, фоторезистор, ещё что-то), отсоединяем их, убирая перемычки, чтобы не мешались.

С интерфейсом к arduino есть нюанс — нам нужно 2 канала ЦАП, соотвественно 2 модуля, но у них одинаковые адреса I2C (зашиты в чип). Хотя чип позволяет менять свой I2C адрес, замыкая определенные ноги на +5V вместо земли, на плате эти перемычки не разведены. Вместо перепайки возьмем костыль — две разные библиотеки I2C на arduino (стандартная Wire и SoftI2CMaster), каждая на свою пару пинов. Получаем модули на разных шинах, конфликт пропадает.

Остальное прямолинейно — ставим модули в разрыв цепи от датчиков, соединяем с arduino, загружаем скетч. Подробности по распиновке подключения есть в комментариях в скетче. Остается включить всё в сборе, здесь важна последовательность:

- Включаем arduino, открываем Serial Monitor. Важно запустить arduino первой, не останавливать и не прерывать. Иначе напряжение на выходах ЦАПов сбросится, ЭБУ усилителя определит ошибку сигнала с датчиков, уйдет в безопасный редим и придется все перезапускать по новой.

- Запитываем усилитель, подключаем зажигание.

- Запускаем воспроизведение лога CAN-шины.

- Теперь по командам

lиrчерез Serial Monitor усилитель будет поворачивать рулевой вал. Объявляется победа.

На сегодня всё, на очереди доработка софта (интеграция с CAN шиной, чтение оттуда текущего угла поворота и динамическое управление крутящим усилием, чтобы внешний контроллер мог задать фиксированный угол поворота руля и система его выдерживала), отработка на автомобиле (на стенде не смоделируешь сопротивление от колёс). Возможно замена 8-битных ЦАП/АЦП на 10 или 12 бит (взял первое, что под руку попалось). Рулящая нейросеть тоже в процессе, надеюсь скоро сделать пост.

Спасибо Artemka86 за ценные консультации по работе с CAN и помощь с оборудованием.

Ресурсы для дальнейшего погружения

- Car Hacking: The definitive source. Начинать можно с Car Hacking for Poories, там отлично покрыты основы. Остальное тоже интересно, но с упором на несанкционированный доступ.

- The Car Hacker's Handbook: A Guide for the Penetration Tester. Больше деталей, чем в Car Hacking: The definitive source, тоже акцент на несанкционированный доступ. Если читать как первое введение в тему, надо приспособиться пропускать большие куски.

- Car Hacking 101: Tools of the Trade, MCD Software — обзоры инструментов. В основном малоинтересная экзотика на мой взгляд.

- Open Source Car Control — открытая платформа для KIA Soul, в процессе разработки. Они делают полное решение (руль, акселератор, тормоза), включвя доработки по "железу" на машине (в основном для тормозов — ставятся дополнительные тормозные приводы, что-то меняется в тормозной гидравлике итд). Релиза ещё не было, но многие вещи уже можно подсмотреть.

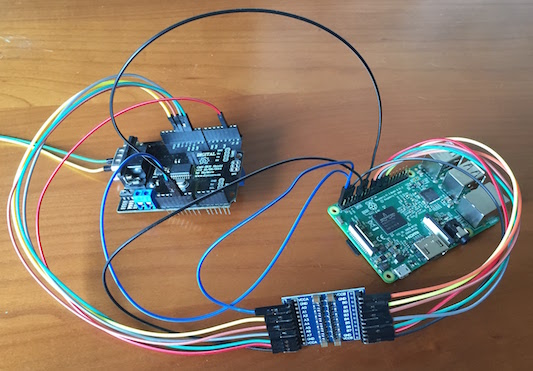

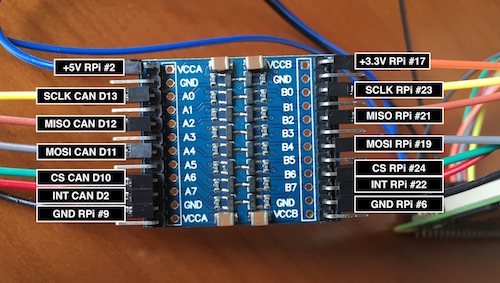

Бонус. Совмещаем Raspberry Pi и Arduino CAN shield

Прежде всего, внимание, CAN шилд и raspberry pi нельзя соединять напрямую, они не совместимы по напряжению. На Arduino UNO-совместимых платах напряжение логики 5V, а на raspberry pi только 3.3V, поэтому прямое соединение только сожжет задействованные пины.

Нам понадобятся:

- Raspberry Pi (проверялось на версии 3B).

- Arduino CAN шилд на MCP2515/MCP2551.

- Преобразователь уровня логики на 5 каналов или больше (можно 2 по 4 канала, но понадобится больше соединений). Мне попался этот

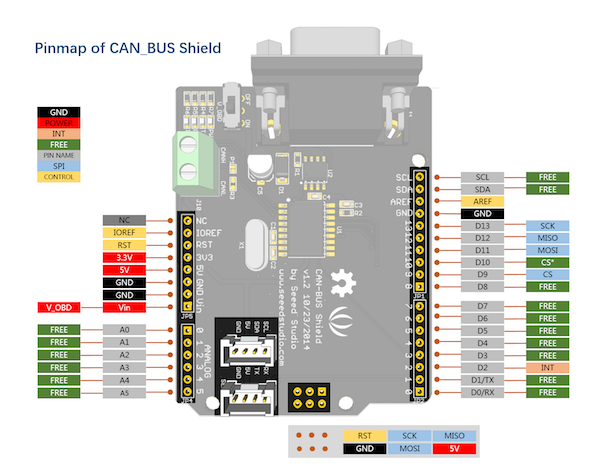

Нужно завести на CAN шилд питание (5V), соединения интерфейса данных SPI (4 пина: MOSI, MISO, SCLK, CS) и 1 пин сигнала прерывания. Всё, кроме питания, идет через преобразователь уровня, который в свою очередь тоже надо запитать.

На схемах ищем нужные пины.

Raspberry Pi:

CAN шилд:

Получаем результат:

- SPI на raspberry pi 19, 21, 23, 24 (MOSI, MISO, SCLK, CS) соответствуют D11, D12, D13, D9 (или на некоторых версиях D10) на CAN шилде.

- Прерывание с D2 на шилде можно завести на любой GPIO пин raspberry, у меня это пин 22 (GPIO 25). Номер пина укажем в софте при настройке.

Соединяем через преобразователь, заводим нужные напряжения питания на каждую сторону преобразователя, получается такая лапша:

Всё, кроме 5V питания и земли на шилд идёт через преобразователь:

Переходим к настройке софта (стандартный Raspbian).

Включаем поддержку SPI и CAN модуля. В

/boot/config.txtдобавляем

dtparam=spi=on dtoverlay=mcp2515-can0,oscillator=16000000,interrupt=25,spimaxfrequency=1000000 dtoverlay=spi0-hw-cs

Здесь

interrupt=25указывает пин, на который заведено прерывание с шилда. Индексация идёт по GPIO пинам, поэтомуinterrupt=25это GPIO 25, он же пин 22 по сквозной индексации всех пинов. Также важно указать частоту интерфейса SPIspimaxfrequency, т.к. значение по умолчанию — 10 МГц — слишком высокое для шилда, он просто не соединится.

Перезагружаем raspberry pi, проверяем соединение с шилдом:

$ dmesg ... [ 12.985754] CAN device driver interface [ 13.014774] mcp251x spi0.0 can0: MCP2515 successfully initialized. ...

Устанавливаем

can-utils:

$ sudo apt install can-utils

Запускаем виртуальный сетевой интерфейс:

$ sudo /sbin/ip link set can0 up type can bitrate 500000 $ sudo ifconfig can0 txqueuelen 1000

Вторая команда важна при воспроизведении большого количества данных с raspberry pi, то есть когда записанный на автомобиле полный лог CAN шины воспоизводим для изолированного узла на стенде. Без увеличения буфера он скорее всего переполнится, когда в логе встретится несколько CAN пакетов с маленькими интервалами, и тогда соединение зависнет.

- Готово, можно пользоваться

candump,cansnifferи всем остальным изcan-utils.

|

Метки: author waiwnf разработка робототехники программирование микроконтроллеров self-driving-car steer-by-wire |

Промо в чеке: Как без больших затрат построить программу лояльности для магазина |

Промо в чеке: Как без больших затрат построить программу лояльности для магазина

Программа лояльности — удобный инструмент, позволяющий ритейлерам привлечь и удержать покупателей. Однако сложно выбрать именно ту, которая окажется эффективной для конкретного магазина. Рассказываем, как с помощью промоакций провести первичное исследование покупательских предпочтений и сэкономить кучу денег.

Сегодня в России магазины практически всегда выбирают между двумя типами программ лояльности: бонусной и дисконтной. Первая подразумевает отсроченную выгоду для покупателя, вторая даёт ему мгновенную скидку. Кстати, маленькая тайна: магазинам выгоднее использовать бонусную программу. С её помощью проще удержать покупателя: он мотивирован на то, чтобы вновь прийти магазин за выгодой. Покупателям, конечно, зачастую интереснее дисконтная программа: проще сразу же получить скидку на товар, чем копить и потом впоследствии использовать баллы. Но речь не о том.

Внедрение любой из этих программ лояльности сопряжено с серьёзными вложениями. Во-первых, нужен специальный софт. Во-вторых, придется потратиться на выпуск пластиковых карт. Промолчим о том, что и покупатели уже откровенно устали от бесконечного пластика, который им пытаются впарить в каждом магазине.

И вот получается, что условный магазин электроники потратил много денег на внедрение дисконтной программы лояльности и выпуск пластиковых карт. А потом методом проб и ошибок выяснил, что для него выгоднее использовать бонусную. Тут ведь влияет множество факторов, например, географическое расположение магазина, его соседство с конкурентами, востребованность проводимых акций. В итоге нужны новые траты на смену программы лояльности и перевыпуск карт. Приятно? Не думаем.

Промо в чеке

Не попасть в эту ловушку можно потренировавшись на кошечках: примерно опробовав акции, которые можно запустить с помощью дисконтной и бонусной программ лояльности. Но сделав это за счёт системы грамотно спланированных промоакций.

Сегодня многие фронт-офисные системы позволяют ритейлерам запускать акции, определяющие применение скидок или иные воздействия на покупку, оформляемую на кассе без использования дисконтных или бонусных карт.

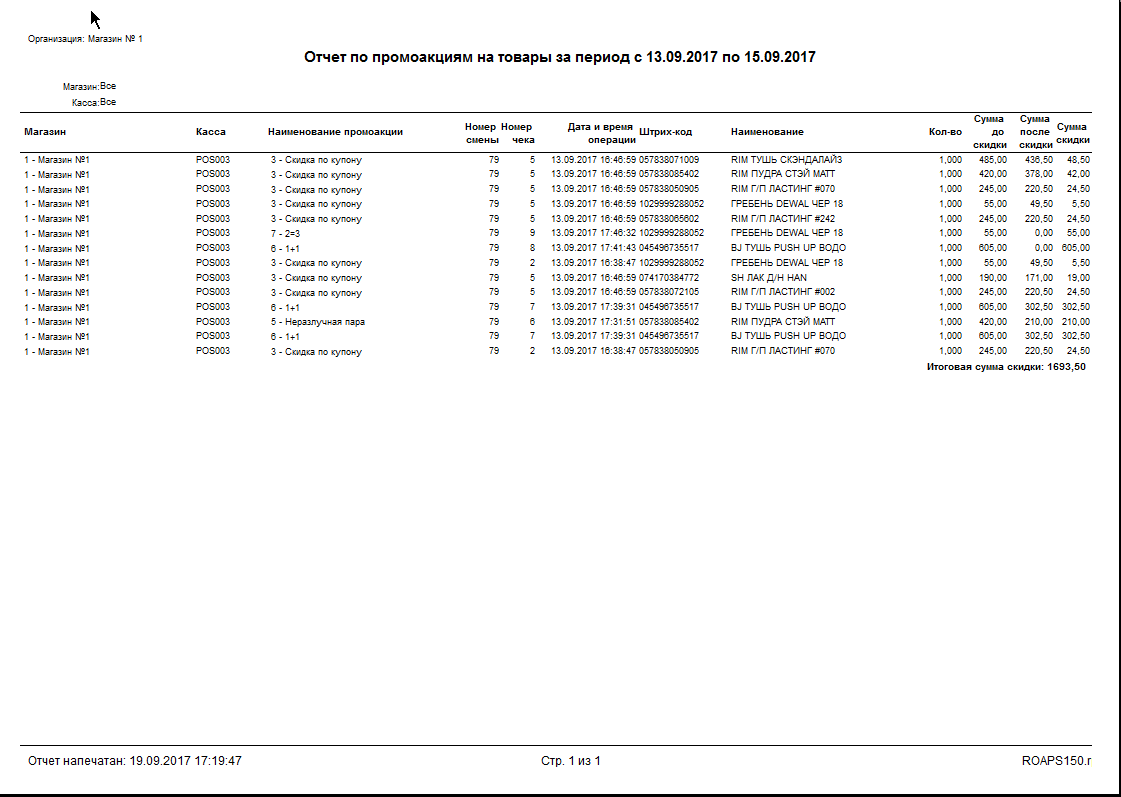

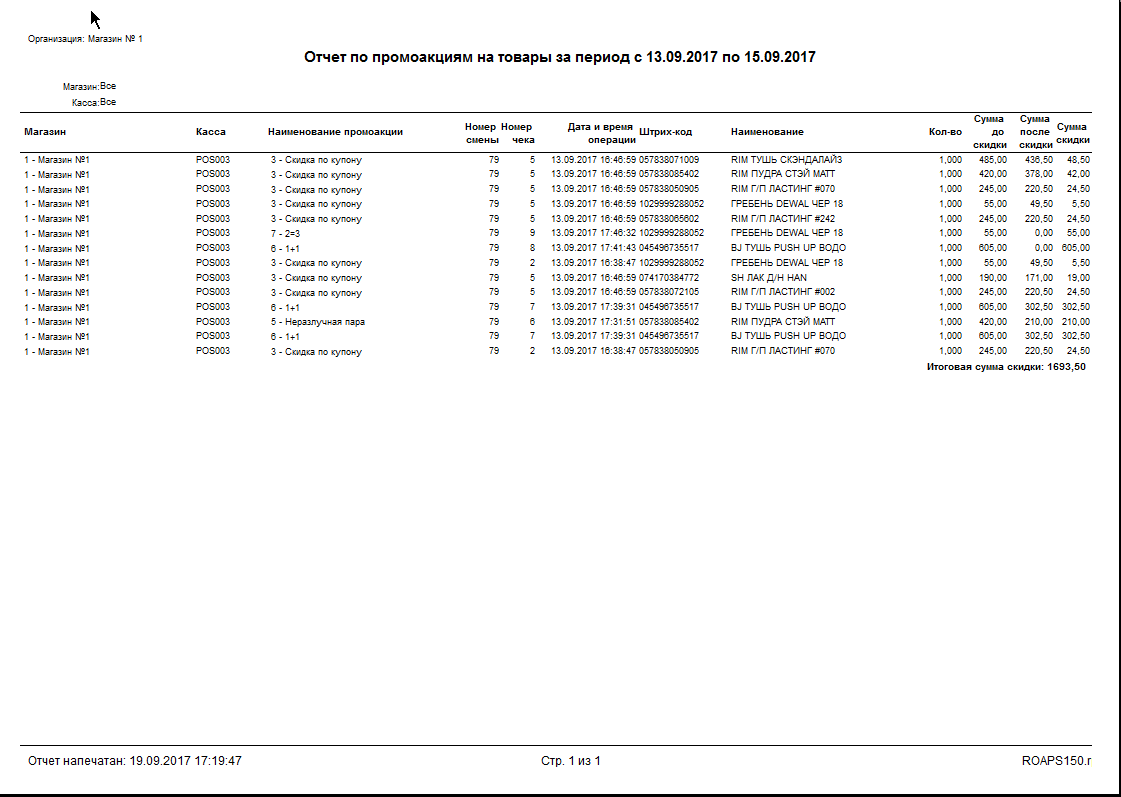

Например, в кассовом софте «Профи-Т» за эту задачу отвечает «Промо-Сервер» — конструктор промоакций. С его помощью маркетолог может легко создавать акции, условием срабатывания которых будет не предъявление покупателем дисконтной или бонусной карт, а покупка определенных товаров (из промо-списка, промо-группы) или купон на скидку (в том числе уникальный из чека). Кроме того, доступен «Отчёт по промоакциям на товары за период», позволяющий легко определить популярные промоакции и сумму скидки, предоставленной покупателям в рамках каждой из них. Таким образом, по анализу поступившей информации можно планировать полноценную систему лояльности.

Итак, условно все промоакции подразделяются на две категории:

- направленные на увеличение среднего чека (скидка на набор товаров, N+N, неразлучная пара, подарок за покупку);

- направленные на удержание покупателей (купон на скидку, рекламный текст, содержащий календарь скидок).

Задача фронт-офисной системы — не только обеспечить обработку запросов от касс на применение к оформляемым покупкам тех или иных промоакций, но и правильно распределить получаемую скидку между товарами и наглядно отразить её в чеке. То есть, оформить его таким образом, чтобы у покупателя не оставалось вопросов, за что и какую именно скидку он получил. Соответственно, фронт-офисная система должна при применении скидки рассчитать правильную стоимость товара, определить сумму скидки и указать её в чеке.

Как это выглядит? К слову, сразу отметим, что любой чек состоит из обязательной информации и дополнительных данных, которые могут редактироваться по желанию ритейлера, чтобы наглядно рассказать покупателям о планирующихся промоакциях.

Акции, направленные на увеличение среднего чека

Самыми распространенными и эффективными акциями, направленными на увеличение среднего чека, можно назвать:

- акция N+N стимулирует покупателя приобретать товар впрок по сниженной цене. Например, 1+1 — два товара по цене одного — подразумевает 50% скидку на товар;

- скидка на набор товаров — покупатель получает скидку/подарок при покупке определенного набора товаров. Например, если вы покупаете карандаш и ручку определенного производителя, то его ластик ритейлер готов отдать вам бесплатно. Или же, он подарит вам в подарок игрушку, если вы купили детской одежды на 2000 рублей;

В нашем примере при приобретении набора товаров «три по цене двух» — двух лаков для ногтей — покупатель получает в подарок гребень для волос. В чеке он идёт по нулевой цене.

- неразлучная пара — это фиксированный набор товаров, при покупке которого один (например, с наименьшей стоимостью) для покупателя будет со скидкой.

В этом примере в качестве «неразлучной пары» выступают пудра и тушь — на пудру, как на товар с меньшей стоимостью, покупатель получает скидку 50%.

- подарок за покупку — при приобретении определенных товаров покупатель получает подарок на кассе. В чеке может быть указан рекламный текст, рассказывающий о выгоде, доступной ему. Например, уведомляющий его, что при приобретении определённой группы товаров он сможет рассчитывать на подарок. Помимо этого, на кассовом ПО можно вывести напоминание для кассира, чтобы он не забыл отдать презент покупателю.

В этом примере на чеке отображается сообщение для покупателя о получении подарка за покупку — мыло Safeguard на кассе. Сообщение о подарке дублируется на мониторе кассиру при переходе в расчётную часть чека.

Фронт-офисной системе нужно проанализировать товарную часть чека, определить плавающую скидку и распределить её между товарами. А затем наглядно оформить в чеке, указав стоимость товара до, после применения скидки и общую скидку на чек.

Отметим, скидку можно распределить пропорционально между всеми товарами в чеке, либо применить её к одному товару, указав, что он продан по нулевой цене (показано на иллюстрации). При этом по законодательству так делать нельзя, но ритейлеры периодически идут на подобные нарушения.

Акции, направленные на удержание покупателей

Важно не только увеличить размер чека, но и привязать покупателя к магазину. Поэтому можно указывать в чеке информацию, направленную на удержание покупателей.

Самыми распространенными и эффективными мероприятиями, направленными на удержание покупателей, можно назвать:

- купонная акция;

- рекламный текст, содержащий календарь скидок.

Купонная акция состоит из двух обязательных этапов: печать купона и его применение (процентная или абсолютная скидка). Интервалы проведения акции могут быть различными: например, сегодня печатаем купон, а завтра применяем скидку. Либо всю неделю в будни печатаем купоны, а в выходные применяем их. Также ритейлер может указать зависимость купона (размера скидки) от суммы совершенной покупки. Например, в чеке на 500 рублей выводится купон на скидку в 5%, при 1000 рублей — на 10%. Уникальный купон формируется фронт-офисной системой динамически и содержит в себе информацию о номерах акции, магазина, кассы, кассовой смены и купона внутри чека. Применяется он единожды.

На примере покупатель получает купон на 10% скидку от суммы покупки, действующий в период с 1 по 30 сентября.

На этом примере покупатель использовал предоставленный ему купон на 10% скидку. В рамках этого же чека он получил новый купон на следующую покупку.

Однако фронт-офисная система может позволить ритейлеру создавать и неуникальные купоны, которыми могут воспользоваться все желающие. Так, «Промо-сервер» позволяет сгенерировать штрих-код в формате изображения, которое потом можно использовать в рекламных буклетах или листовках.

Ещё одна важная возможность для привлечения покупателей — это календарь скидок. Если ритейлер планирует, например, в течение недели проводить определенные промоакции для каких-то товаров, то можно уведомлять о них в чеке. Таким образом, покупатель будет точно знать, что, например, если он, придя в магазин в период с 15 по 30 сентября, сможет рассчитывать на 20% скидку на гели для душа.

Важно, чтобы фронт-офисная система позволяла не только проводить промоакции, но и анализировать их результаты. Ведь именно от этого напрямую зависит последующий выбор программы лояльности. Например, наш «Промо-Сервер» формирует отчёты, демонстрирующие, какие акции были наиболее популярны: сколько раз они сработали в магазине и сколько ими воспользовались. Помимо этого, он помогает контролировать суммарный уровень скидки: то есть, задать определенный порог, чтобы товар, участвующий в нескольких акциях, не превысил его и магазин не ушёл в минус.

|

|

Промо в чеке: Как без больших затрат построить программу лояльности для магазина |

Промо в чеке: Как без больших затрат построить программу лояльности для магазина

Программа лояльности — удобный инструмент, позволяющий ритейлерам привлечь и удержать покупателей. Однако сложно выбрать именно ту, которая окажется эффективной для конкретного магазина. Рассказываем, как с помощью промоакций провести первичное исследование покупательских предпочтений и сэкономить кучу денег.

Сегодня в России магазины практически всегда выбирают между двумя типами программ лояльности: бонусной и дисконтной. Первая подразумевает отсроченную выгоду для покупателя, вторая даёт ему мгновенную скидку. Кстати, маленькая тайна: магазинам выгоднее использовать бонусную программу. С её помощью проще удержать покупателя: он мотивирован на то, чтобы вновь прийти магазин за выгодой. Покупателям, конечно, зачастую интереснее дисконтная программа: проще сразу же получить скидку на товар, чем копить и потом впоследствии использовать баллы. Но речь не о том.

Внедрение любой из этих программ лояльности сопряжено с серьёзными вложениями. Во-первых, нужен специальный софт. Во-вторых, придется потратиться на выпуск пластиковых карт. Промолчим о том, что и покупатели уже откровенно устали от бесконечного пластика, который им пытаются впарить в каждом магазине.

И вот получается, что условный магазин электроники потратил много денег на внедрение дисконтной программы лояльности и выпуск пластиковых карт. А потом методом проб и ошибок выяснил, что для него выгоднее использовать бонусную. Тут ведь влияет множество факторов, например, географическое расположение магазина, его соседство с конкурентами, востребованность проводимых акций. В итоге нужны новые траты на смену программы лояльности и перевыпуск карт. Приятно? Не думаем.

Промо в чеке

Не попасть в эту ловушку можно потренировавшись на кошечках: примерно опробовав акции, которые можно запустить с помощью дисконтной и бонусной программ лояльности. Но сделав это за счёт системы грамотно спланированных промоакций.

Сегодня многие фронт-офисные системы позволяют ритейлерам запускать акции, определяющие применение скидок или иные воздействия на покупку, оформляемую на кассе без использования дисконтных или бонусных карт.

Например, в кассовом софте «Профи-Т» за эту задачу отвечает «Промо-Сервер» — конструктор промоакций. С его помощью маркетолог может легко создавать акции, условием срабатывания которых будет не предъявление покупателем дисконтной или бонусной карт, а покупка определенных товаров (из промо-списка, промо-группы) или купон на скидку (в том числе уникальный из чека). Кроме того, доступен «Отчёт по промоакциям на товары за период», позволяющий легко определить популярные промоакции и сумму скидки, предоставленной покупателям в рамках каждой из них. Таким образом, по анализу поступившей информации можно планировать полноценную систему лояльности.

Итак, условно все промоакции подразделяются на две категории:

- направленные на увеличение среднего чека (скидка на набор товаров, N+N, неразлучная пара, подарок за покупку);

- направленные на удержание покупателей (купон на скидку, рекламный текст, содержащий календарь скидок).

Задача фронт-офисной системы — не только обеспечить обработку запросов от касс на применение к оформляемым покупкам тех или иных промоакций, но и правильно распределить получаемую скидку между товарами и наглядно отразить её в чеке. То есть, оформить его таким образом, чтобы у покупателя не оставалось вопросов, за что и какую именно скидку он получил. Соответственно, фронт-офисная система должна при применении скидки рассчитать правильную стоимость товара, определить сумму скидки и указать её в чеке.

Как это выглядит? К слову, сразу отметим, что любой чек состоит из обязательной информации и дополнительных данных, которые могут редактироваться по желанию ритейлера, чтобы наглядно рассказать покупателям о планирующихся промоакциях.

Акции, направленные на увеличение среднего чека

Самыми распространенными и эффективными акциями, направленными на увеличение среднего чека, можно назвать:

- акция N+N стимулирует покупателя приобретать товар впрок по сниженной цене. Например, 1+1 — два товара по цене одного — подразумевает 50% скидку на товар;

- скидка на набор товаров — покупатель получает скидку/подарок при покупке определенного набора товаров. Например, если вы покупаете карандаш и ручку определенного производителя, то его ластик ритейлер готов отдать вам бесплатно. Или же, он подарит вам в подарок игрушку, если вы купили детской одежды на 2000 рублей;

В нашем примере при приобретении набора товаров «три по цене двух» — двух лаков для ногтей — покупатель получает в подарок гребень для волос. В чеке он идёт по нулевой цене.

- неразлучная пара — это фиксированный набор товаров, при покупке которого один (например, с наименьшей стоимостью) для покупателя будет со скидкой.

В этом примере в качестве «неразлучной пары» выступают пудра и тушь — на пудру, как на товар с меньшей стоимостью, покупатель получает скидку 50%.

- подарок за покупку — при приобретении определенных товаров покупатель получает подарок на кассе. В чеке может быть указан рекламный текст, рассказывающий о выгоде, доступной ему. Например, уведомляющий его, что при приобретении определённой группы товаров он сможет рассчитывать на подарок. Помимо этого, на кассовом ПО можно вывести напоминание для кассира, чтобы он не забыл отдать презент покупателю.

В этом примере на чеке отображается сообщение для покупателя о получении подарка за покупку — мыло Safeguard на кассе. Сообщение о подарке дублируется на мониторе кассиру при переходе в расчётную часть чека.

Фронт-офисной системе нужно проанализировать товарную часть чека, определить плавающую скидку и распределить её между товарами. А затем наглядно оформить в чеке, указав стоимость товара до, после применения скидки и общую скидку на чек.

Отметим, скидку можно распределить пропорционально между всеми товарами в чеке, либо применить её к одному товару, указав, что он продан по нулевой цене (показано на иллюстрации). При этом по законодательству так делать нельзя, но ритейлеры периодически идут на подобные нарушения.

Акции, направленные на удержание покупателей

Важно не только увеличить размер чека, но и привязать покупателя к магазину. Поэтому можно указывать в чеке информацию, направленную на удержание покупателей.

Самыми распространенными и эффективными мероприятиями, направленными на удержание покупателей, можно назвать:

- купонная акция;

- рекламный текст, содержащий календарь скидок.

Купонная акция состоит из двух обязательных этапов: печать купона и его применение (процентная или абсолютная скидка). Интервалы проведения акции могут быть различными: например, сегодня печатаем купон, а завтра применяем скидку. Либо всю неделю в будни печатаем купоны, а в выходные применяем их. Также ритейлер может указать зависимость купона (размера скидки) от суммы совершенной покупки. Например, в чеке на 500 рублей выводится купон на скидку в 5%, при 1000 рублей — на 10%. Уникальный купон формируется фронт-офисной системой динамически и содержит в себе информацию о номерах акции, магазина, кассы, кассовой смены и купона внутри чека. Применяется он единожды.

На примере покупатель получает купон на 10% скидку от суммы покупки, действующий в период с 1 по 30 сентября.

На этом примере покупатель использовал предоставленный ему купон на 10% скидку. В рамках этого же чека он получил новый купон на следующую покупку.

Однако фронт-офисная система может позволить ритейлеру создавать и неуникальные купоны, которыми могут воспользоваться все желающие. Так, «Промо-сервер» позволяет сгенерировать штрих-код в формате изображения, которое потом можно использовать в рекламных буклетах или листовках.

Ещё одна важная возможность для привлечения покупателей — это календарь скидок. Если ритейлер планирует, например, в течение недели проводить определенные промоакции для каких-то товаров, то можно уведомлять о них в чеке. Таким образом, покупатель будет точно знать, что, например, если он, придя в магазин в период с 15 по 30 сентября, сможет рассчитывать на 20% скидку на гели для душа.

Важно, чтобы фронт-офисная система позволяла не только проводить промоакции, но и анализировать их результаты. Ведь именно от этого напрямую зависит последующий выбор программы лояльности. Например, наш «Промо-Сервер» формирует отчёты, демонстрирующие, какие акции были наиболее популярны: сколько раз они сработали в магазине и сколько ими воспользовались. Помимо этого, он помогает контролировать суммарный уровень скидки: то есть, задать определенный порог, чтобы товар, участвующий в нескольких акциях, не превысил его и магазин не ушёл в минус.

|

|

Фьючерсы, индексы и IPO: как на самом деле устроены биржи и зачем они нужны |

Фьючерсы, индексы и IPO: как на самом деле устроены биржи и зачем они нужны

В нашем блоге мы много пишем о биржевых технологиях, IPO известных компаний и интересных новостях, однако уже довольно давно подробно не останавливались на общем устройстве финансового рынка. Поэтому сегодня мы простым языком объясним, зачем вообще нужны биржи, что такое фьючерсы, опционы и фондовые индексы, и зачем компании проводят IPO.

Как устроена биржа

Биржа – это наиболее удобное место проведения операций с ценными бумагами. Она должна иметь в своем составе:

- Торговую систему, где накапливаются заявки на покупку и продажу, происходит их «спаривание» в случае совпадения цены, т.е. регистрации сделок с различными инструментами и записями в соответствующие регистры учета (напр. ).

- Расчетную (клиринговую) палату, которая ведет учет денежных средств участников торгов, осуществляет поставку денег по каждой сделке продавцам бумаг и списывает денежные средства со счетов покупателей, осуществляет внешние и внутренние денежные переодв.

- Депозитарный центр, которые аналогично расчетной палате ведет учет ценных бумаг участников торгов, осуществляет поставку бумаг на счет покупателей, списывает бумаги со счетов продавцов, осуществляет клиринг ценных бумаг по результатам торгов в уполномоченных депозитариях.

Все эти операции производятся в автоматическом режиме. Другая важная роль, осуществляемая организованной биржевой площадкой, — это обеспечение ликвидности ценных бумаг.

Ликвидность – это возможность быстро и без существенных накладных расходов продать или купить ценную бумагу.

За счет большого количества участников торгов и большого количества ценных бумаг, одновременно продающихся и покупающихся, ликвидность может быть достаточно высока. Биржа обеспечивает условия ликвидности каждой конкретной бумаги двумя путями: разумной тарифной политикой, что привлекает частных инвесторов, и созданием института маркетмейкеров.

Маркетмейкер – это участник торгов, который по соглашению с биржей обязан поддерживать разницу цен покупки-продажи в определенных пределах. За это он получает от биржи определенные льготы – например возможность совершать операции с ценными бумагами, которые поддерживает маркетмейкер с уменьшенными комиссиями или вовсе без них.

Зачем это нужно

Ценные бумаги являются одной из форм существования капитала и обращаются на фондовом рынке. Все это несет в себе целый ряд функций.

Во-первых, ценные бумаги перераспределяют денежные средства:

- Между странами и территориями.

- Между отраслями промышленности и секторами экономики.

- Между отдельными предприятиями внутри одного сектора.

Необходимо понимать, что рынок устроен таким образом, что деньги перетекают туда, где могут принести наибольший эффект от своего использования. Этот принцип проявляется при перераспределении капитала всегда и везде – неважно, идет ли речь о частных компаниях или целых странах.

Во-вторых, благодаря ценным бумагам осуществляется перераспределение инвестиций в каждое конкретное предприятие между крупными, средними и малыми инвесторами. Этот процесс затрагивает почти любого гражданина страны, даже если тот об этом не подозревает. Так, условный обыватель, имеющий вклад в банке, может не знать и не думать о том, что банк, используя его деньги, мог купить, к примеру, корпоративных облигаций – именно так, конкретный человек, не подозревая об этом, становится источником средств развития конкретного предприятия и экономики в целом.

Третья важная функция ценных бумаг заключается в том, что они служат для фиксации прав владельцев на долю долга или собственности предприятий (в случае бумаг компании) или на долю долга целого государства (в случае бумаг государственных).

В зависимости от вида ценных бумаг и конкретного эмитента доход, который приносят ценные бумаги может быть разным, от, собственно, убытка, до астрономических сумм. Естественно, всегда есть риск получить убыток – например, в случае банкротства предприятия, выпустившего ценные бумаги, но на больших временных горизонтах – от 15 до 30 лет в среднем – ценные бумаги приносят доход, соответствующий или превышающий рост экономики.

При этом, важно понимать, что на фондовом рынке не действуют законы физики – в частности, сила притяжения. Часто многие полагают, что раз акции значительно выросли за небольшой промежуток времени, то их обязательно ждет падение. Это вовсе обязательно так.

Пример: На протяжении 10 лет акции Berkshire Hathaway выросли с $6 000 до $10 000. В этой точке многие решили, что рост и так уже довольно значительный, и упустили возможность заработать огромные деньги на цене, которая в последующие 6 лет выросла до $70 000 и даже выше.

В качестве платы за риск, который несет в себе подобное финансирование экономики, владельцы ценных бумаг получают дополнительный доход: купоны, процентные выплаты в случае долговых бумаг, дивиденды и рост курсовой стоимости в случае долевых ценных бумаг.

О том, почему фондовый рынок и регулируемые государством биржи не имеют ничего общего с так называемыми форекс-кухнями можно почитать в этом нашем материале.

Производные инструменты: фьючерсы, опционы и не только

Функционирование любой биржевой площадки сложно себе представить без так называемых производных инструментах или «вторичных ценных бумаг». Условно их можно разбить на следующие классы:

- Депозитарные расписки;

- Варранты на ценные бумаги;

- Фьючерсные контракты;

- Форвардные контракты;

- Опционные контракты.

Депозитарные расписки

По своей сути наиболее близки к обычным акциям. Часто бывает, что какая-то иностранная компания (условный Ростелеком) хочет разместить в депозитарии Bank of New York свои акции и заключает с ним соответствующее соглашение. Банк под эти акции в дальнейшем выпускает в свободное обращение сертификаты ценных бумаг – американские депозитарные расписки (АДР). Одна АДР может соответствовать как одной, так и нескольким акций. АДР имеют номинал, выраженный в долларах США, и свободно обращаются на американских биржах. Что важно – курсовая стоимость АДР в пересчете на одну акцию и курс нацвалюты страны компании-эмитента акций, соответствует курсовой (рыночной) стоимости акций, лежащей в основе такой АДР.

Варранты на ценные бумаги

Термин «варрант »произошел от английского слова warranty – гарантия. Варрант – это право выкупить определенное количество акций предприятия в достаточно далеком будущем (от года до 5 лет).

Владелец варранта гарантированно получает право на выкуп определенного количества акций по определенной цене в будущем, следовательно, держатель варранта застрахован от размытия своей доли в компании (и, к примеру, от своего вывода из состава ее руководства). Варранты не торгуются на бирже, а обращаются, что логично, на внебиржевом рынке. Чаще всего они используются акционерами, которые хотят уберечь свою долю в компании, в случае дополнительных эмиссий акций, при слияниях и поглощениях компаний.

Фьючерсные контракты

Фьючерсы (от англ. futures) – это обязательство купить или продать определенный актив (его называют базисным) по определенной цене в определенную дату в будущем. При этом каждый фьючерсный контракт характеризуется количеством базисного актива (напр. штук акций), датой исполнения контракта (датой экспирации) и, собственно, ценой (цена страйк), по которой покупатель соглашается купить базисный актив, а владелец продать.

График фьючерсного контракта из терминала SmartX

Таким образом, продавец обязуется продать определенное количество базисного актива в будущем по определенной цене, а покупатель по наступлении этого времени купить его по оговоренной цене. Гарантом сделки выступает биржа, которая берет с обоих участников сделки страховые депозиты. Базисным активом могут быть сами акции, фондовые индексы, валюта, товары и процентные ставки.

Историю возникновения фьючерсов и подробное описание принципов их работы можно найти в этом материале.

Форвардные контракты

«Форварды» — это обязательство купить или продать определенный товар в определенную дату в будущем по заранее оговоренной цене. На первый взгляд все очень похоже на фьючерсы, но есть существенная разница.

- Форвардные контракты заключаются только на внебиржевом рынке между двумя конкретными контрагентами – они же и несут риск неисполнения условий контракта (в случае фьючерсов этот риск лежит на бирже).

- Такой контракт может быть заключен на произвольную дату в будущем в отличие от фьючерса, который имеет стандартную дату исполнения.

- В качестве базового актива форвардного контракта может быть что угодно, а не только активы, допускающие биржевую стандартизацию.

- Такие контракты, как правило, не требуют гарантированных депозитов, и по ним не начисляется вариационная маржа.

Опционы

Это право купить или продать определенный базовый актив в будущем по определенной цене. Не обязательство, как в случае фьючерса, когда при наступлении оговоренной даты сделка обязательно состоится по определенным условиям. В случае опциона его исполнение – это выбор покупателя, он может своим правом воспользоваться, а может не реализовать его.

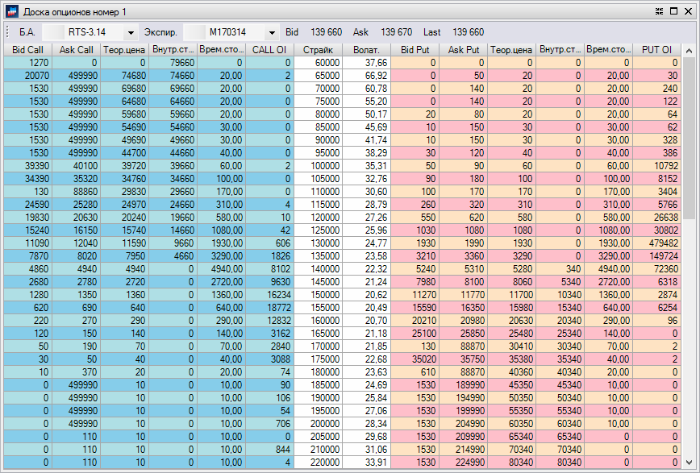

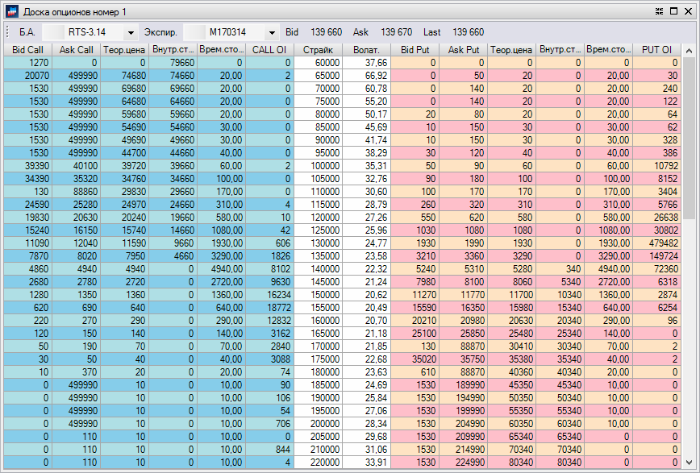

Доска опционов терминала SmartX

Опционы торгуются на тех же биржевых площадках и тех же секциях, где и фьючерсные контракты. У них также есть спецификация, куда входит и понятие базового актива. Что интересно, в качестве базового актива может использоваться и фьючерс. Есть у опционов и дата экспирация. Есть вариации на тему того, когда может быть исполнен опцион. Так называемые американские опционы могут быть исполнены в любой срок до даты экспирации, европейский – только в эту дату.

Подробнее об опционах и истории этого финансового инструмента мы рассказывали здесь.

Что такое фондовые индексы и зачем они нужны

Биржевой индекс — это показатель изменения цен определенной группы ценных бумаг. Можно представить биржевой индекс как «корзину» из акций, объединенных по какому-либо признаку.

Самое главное, при изучении индекса, это то, из каких акций или облигаций он сформирован. Именно набор ценных бумаг, входящих в список, на основе которого рассчитывается индекс, определяет то, какую информацию можно получить, наблюдая за динамикой этого индекса. В общем случае, главная цель составления фондового индекса заключается в создании показателя, с помощью которого инвесторы могли бы характеризовать общее направление и «скорость» движения биржевых котировок компаний определенной отрасли.

Изучение динамики индексов помогает участникам биржевых торгов понимать влияние на котировки тех или иных событий — если происходит, к примеру, рост цен на нефть, то, логично ожидать роста котировок всех нефтяных компаний. Однако, акции разных компаний растут с разной скоростью (а какие-то могут и вообще не расти) — индекс помогает понять общий тренд движения сегмента рынка без необходимости оценки положения множества разрозненных компаний. Сравнение индексов между собой дает понимание как на рынке торгуются разные сектора экономики в сравнении друг с другом.

Индексы могут быть «агентскими», когда их расчетом занимаются специальные агентства (пример — индексы S&P агентства Standard & Poor’s). Второй вариант — биржевые индексы, созданные, собственно, фондовыми площадками. В США это NASDAQ, а в России два основных биржевых индекса рассчитывались биржами ММВБ и РТС, которые теперь объединились в единую «Московскую биржу».

Помимо этого, составителем индексов может быть и брокерская компания. Например, ITinvest рассчитывает собственные индексы, среди которых есть, к примеру, индексы корреляции (фьючерса на индекс РТС и индекса ММВБ, фьючерса на индекс РТС и индекса S&P 500), которые применяются для торговли фьючерсом на индекс РТС, «склеенные» фьючерсы и другие индикаторы.

Подробнее о семействах индексов и их использовании можно почитать здесь.

IPO: зачем это нужно, плюсы и минусы

Конечно, в ходе разговора о современных биржах нельзя обойти вниманием тему IPO — настолько часто можно услышать эту аббревиатуру в различных СМИ.

Когда компания хочет предложить свои акции широкой общественности, она проводит IPO(Initial Public Offering – IPO). Соответственно, статус организации меняется — вместо частной (акционером не может стать любой желающий) она становится публичной (акционером может стать любой желающий).

У частных компаний могут быть акционеры, но их не так много, и такие компании сталкиваются с требованиями регулирующих органов, отличных от тех, которые предъявляются к публичным. Процесс подготовки первичного размещения акций IPO) занимает от нескольких месяцев до года и стоит компании довольно существенных средств.

Все дело в деньгах — компания хочет привлечь средства. После получения эти деньги могут использоваться для развития бизнеса или, к примеру, реинвестиций в инфраструктуру.

Еще один плюс наличия публично торгуемых акций компании — возможность предлагать топ-менеджерам опционы, переманивая лучших специалистов. Помимо этого, акции могут быть использованы в ходе сделок по слиянию и поглощению, покрывая часть оплаты — при покупке Facebook WhatsApp, основатели мессенджера получили значительную часть $19 млрд акциями социальной сети, которая уже вышла на биржу. Попадание в листинг крупнейших мировых бирж — NYSE или NASDAQ — это просто престижно.

Частные инвесторы никак не могут купить акции компании до официального старта торгов. Часто в первые дни торгов акции новых компаний подвержены сильным колебаниям, поэтому обычно аналитики советуют не торопиться с совершением сделок, а выждать пока цена установится на более или менее стабильном уровне.

Сам факт проведения IPO для компании обычно позитивен, ведь это означает, что она достаточно выросла, чтобы претендовать на привлечение капитала подобным способом — к нему прибегают только тогда, когда нужно действительно много денег на масштабное расширение. Кроме того, публичные компании привлекают куда больше внимания, что облегчает им найм персонала и процесс маркетинга.

Среди недостатков IPO можно отметить усиливающее после выхода на биржу внимание к компании со стороны регулирующих органов — существует большое количество требований как государства, так и самих биржевых площадок, которые компании, торгующиеся на них, должны исполнять. В частности это касается выпуска финансовой отчетности. Кроме того, основатели компании не всегда могут после IPO сразу продать свои акции и стать миллионерами, поскольку это может снизить их курс и капитализацию бизнеса.

Заключение: полезные ссылки и материалы для изучения фондового рынка

|

Метки: author itinvest финансы в it блог компании itinvest биржи фондовый рынок опционы |

Фьючерсы, индексы и IPO: как на самом деле устроены биржи и зачем они нужны |

Фьючерсы, индексы и IPO: как на самом деле устроены биржи и зачем они нужны

В нашем блоге мы много пишем о биржевых технологиях, IPO известных компаний и интересных новостях, однако уже довольно давно подробно не останавливались на общем устройстве финансового рынка. Поэтому сегодня мы простым языком объясним, зачем вообще нужны биржи, что такое фьючерсы, опционы и фондовые индексы, и зачем компании проводят IPO.

Как устроена биржа

Биржа – это наиболее удобное место проведения операций с ценными бумагами. Она должна иметь в своем составе:

- Торговую систему, где накапливаются заявки на покупку и продажу, происходит их «спаривание» в случае совпадения цены, т.е. регистрации сделок с различными инструментами и записями в соответствующие регистры учета (напр. ).

- Расчетную (клиринговую) палату, которая ведет учет денежных средств участников торгов, осуществляет поставку денег по каждой сделке продавцам бумаг и списывает денежные средства со счетов покупателей, осуществляет внешние и внутренние денежные переодв.

- Депозитарный центр, которые аналогично расчетной палате ведет учет ценных бумаг участников торгов, осуществляет поставку бумаг на счет покупателей, списывает бумаги со счетов продавцов, осуществляет клиринг ценных бумаг по результатам торгов в уполномоченных депозитариях.

Все эти операции производятся в автоматическом режиме. Другая важная роль, осуществляемая организованной биржевой площадкой, — это обеспечение ликвидности ценных бумаг.

Ликвидность – это возможность быстро и без существенных накладных расходов продать или купить ценную бумагу.

За счет большого количества участников торгов и большого количества ценных бумаг, одновременно продающихся и покупающихся, ликвидность может быть достаточно высока. Биржа обеспечивает условия ликвидности каждой конкретной бумаги двумя путями: разумной тарифной политикой, что привлекает частных инвесторов, и созданием института маркетмейкеров.

Маркетмейкер – это участник торгов, который по соглашению с биржей обязан поддерживать разницу цен покупки-продажи в определенных пределах. За это он получает от биржи определенные льготы – например возможность совершать операции с ценными бумагами, которые поддерживает маркетмейкер с уменьшенными комиссиями или вовсе без них.

Зачем это нужно

Ценные бумаги являются одной из форм существования капитала и обращаются на фондовом рынке. Все это несет в себе целый ряд функций.

Во-первых, ценные бумаги перераспределяют денежные средства:

- Между странами и территориями.

- Между отраслями промышленности и секторами экономики.

- Между отдельными предприятиями внутри одного сектора.

Необходимо понимать, что рынок устроен таким образом, что деньги перетекают туда, где могут принести наибольший эффект от своего использования. Этот принцип проявляется при перераспределении капитала всегда и везде – неважно, идет ли речь о частных компаниях или целых странах.

Во-вторых, благодаря ценным бумагам осуществляется перераспределение инвестиций в каждое конкретное предприятие между крупными, средними и малыми инвесторами. Этот процесс затрагивает почти любого гражданина страны, даже если тот об этом не подозревает. Так, условный обыватель, имеющий вклад в банке, может не знать и не думать о том, что банк, используя его деньги, мог купить, к примеру, корпоративных облигаций – именно так, конкретный человек, не подозревая об этом, становится источником средств развития конкретного предприятия и экономики в целом.

Третья важная функция ценных бумаг заключается в том, что они служат для фиксации прав владельцев на долю долга или собственности предприятий (в случае бумаг компании) или на долю долга целого государства (в случае бумаг государственных).

В зависимости от вида ценных бумаг и конкретного эмитента доход, который приносят ценные бумаги может быть разным, от, собственно, убытка, до астрономических сумм. Естественно, всегда есть риск получить убыток – например, в случае банкротства предприятия, выпустившего ценные бумаги, но на больших временных горизонтах – от 15 до 30 лет в среднем – ценные бумаги приносят доход, соответствующий или превышающий рост экономики.

При этом, важно понимать, что на фондовом рынке не действуют законы физики – в частности, сила притяжения. Часто многие полагают, что раз акции значительно выросли за небольшой промежуток времени, то их обязательно ждет падение. Это вовсе обязательно так.

Пример: На протяжении 10 лет акции Berkshire Hathaway выросли с $6 000 до $10 000. В этой точке многие решили, что рост и так уже довольно значительный, и упустили возможность заработать огромные деньги на цене, которая в последующие 6 лет выросла до $70 000 и даже выше.

В качестве платы за риск, который несет в себе подобное финансирование экономики, владельцы ценных бумаг получают дополнительный доход: купоны, процентные выплаты в случае долговых бумаг, дивиденды и рост курсовой стоимости в случае долевых ценных бумаг.

О том, почему фондовый рынок и регулируемые государством биржи не имеют ничего общего с так называемыми форекс-кухнями можно почитать в этом нашем материале.

Производные инструменты: фьючерсы, опционы и не только

Функционирование любой биржевой площадки сложно себе представить без так называемых производных инструментах или «вторичных ценных бумаг». Условно их можно разбить на следующие классы:

- Депозитарные расписки;

- Варранты на ценные бумаги;

- Фьючерсные контракты;

- Форвардные контракты;

- Опционные контракты.

Депозитарные расписки

По своей сути наиболее близки к обычным акциям. Часто бывает, что какая-то иностранная компания (условный Ростелеком) хочет разместить в депозитарии Bank of New York свои акции и заключает с ним соответствующее соглашение. Банк под эти акции в дальнейшем выпускает в свободное обращение сертификаты ценных бумаг – американские депозитарные расписки (АДР). Одна АДР может соответствовать как одной, так и нескольким акций. АДР имеют номинал, выраженный в долларах США, и свободно обращаются на американских биржах. Что важно – курсовая стоимость АДР в пересчете на одну акцию и курс нацвалюты страны компании-эмитента акций, соответствует курсовой (рыночной) стоимости акций, лежащей в основе такой АДР.

Варранты на ценные бумаги

Термин «варрант »произошел от английского слова warranty – гарантия. Варрант – это право выкупить определенное количество акций предприятия в достаточно далеком будущем (от года до 5 лет).

Владелец варранта гарантированно получает право на выкуп определенного количества акций по определенной цене в будущем, следовательно, держатель варранта застрахован от размытия своей доли в компании (и, к примеру, от своего вывода из состава ее руководства). Варранты не торгуются на бирже, а обращаются, что логично, на внебиржевом рынке. Чаще всего они используются акционерами, которые хотят уберечь свою долю в компании, в случае дополнительных эмиссий акций, при слияниях и поглощениях компаний.

Фьючерсные контракты

Фьючерсы (от англ. futures) – это обязательство купить или продать определенный актив (его называют базисным) по определенной цене в определенную дату в будущем. При этом каждый фьючерсный контракт характеризуется количеством базисного актива (напр. штук акций), датой исполнения контракта (датой экспирации) и, собственно, ценой (цена страйк), по которой покупатель соглашается купить базисный актив, а владелец продать.

График фьючерсного контракта из терминала SmartX

Таким образом, продавец обязуется продать определенное количество базисного актива в будущем по определенной цене, а покупатель по наступлении этого времени купить его по оговоренной цене. Гарантом сделки выступает биржа, которая берет с обоих участников сделки страховые депозиты. Базисным активом могут быть сами акции, фондовые индексы, валюта, товары и процентные ставки.

Историю возникновения фьючерсов и подробное описание принципов их работы можно найти в этом материале.

Форвардные контракты

«Форварды» — это обязательство купить или продать определенный товар в определенную дату в будущем по заранее оговоренной цене. На первый взгляд все очень похоже на фьючерсы, но есть существенная разница.

- Форвардные контракты заключаются только на внебиржевом рынке между двумя конкретными контрагентами – они же и несут риск неисполнения условий контракта (в случае фьючерсов этот риск лежит на бирже).

- Такой контракт может быть заключен на произвольную дату в будущем в отличие от фьючерса, который имеет стандартную дату исполнения.

- В качестве базового актива форвардного контракта может быть что угодно, а не только активы, допускающие биржевую стандартизацию.

- Такие контракты, как правило, не требуют гарантированных депозитов, и по ним не начисляется вариационная маржа.

Опционы

Это право купить или продать определенный базовый актив в будущем по определенной цене. Не обязательство, как в случае фьючерса, когда при наступлении оговоренной даты сделка обязательно состоится по определенным условиям. В случае опциона его исполнение – это выбор покупателя, он может своим правом воспользоваться, а может не реализовать его.

Доска опционов терминала SmartX

Опционы торгуются на тех же биржевых площадках и тех же секциях, где и фьючерсные контракты. У них также есть спецификация, куда входит и понятие базового актива. Что интересно, в качестве базового актива может использоваться и фьючерс. Есть у опционов и дата экспирация. Есть вариации на тему того, когда может быть исполнен опцион. Так называемые американские опционы могут быть исполнены в любой срок до даты экспирации, европейский – только в эту дату.

Подробнее об опционах и истории этого финансового инструмента мы рассказывали здесь.

Что такое фондовые индексы и зачем они нужны

Биржевой индекс — это показатель изменения цен определенной группы ценных бумаг. Можно представить биржевой индекс как «корзину» из акций, объединенных по какому-либо признаку.

Самое главное, при изучении индекса, это то, из каких акций или облигаций он сформирован. Именно набор ценных бумаг, входящих в список, на основе которого рассчитывается индекс, определяет то, какую информацию можно получить, наблюдая за динамикой этого индекса. В общем случае, главная цель составления фондового индекса заключается в создании показателя, с помощью которого инвесторы могли бы характеризовать общее направление и «скорость» движения биржевых котировок компаний определенной отрасли.

Изучение динамики индексов помогает участникам биржевых торгов понимать влияние на котировки тех или иных событий — если происходит, к примеру, рост цен на нефть, то, логично ожидать роста котировок всех нефтяных компаний. Однако, акции разных компаний растут с разной скоростью (а какие-то могут и вообще не расти) — индекс помогает понять общий тренд движения сегмента рынка без необходимости оценки положения множества разрозненных компаний. Сравнение индексов между собой дает понимание как на рынке торгуются разные сектора экономики в сравнении друг с другом.

Индексы могут быть «агентскими», когда их расчетом занимаются специальные агентства (пример — индексы S&P агентства Standard & Poor’s). Второй вариант — биржевые индексы, созданные, собственно, фондовыми площадками. В США это NASDAQ, а в России два основных биржевых индекса рассчитывались биржами ММВБ и РТС, которые теперь объединились в единую «Московскую биржу».

Помимо этого, составителем индексов может быть и брокерская компания. Например, ITinvest рассчитывает собственные индексы, среди которых есть, к примеру, индексы корреляции (фьючерса на индекс РТС и индекса ММВБ, фьючерса на индекс РТС и индекса S&P 500), которые применяются для торговли фьючерсом на индекс РТС, «склеенные» фьючерсы и другие индикаторы.

Подробнее о семействах индексов и их использовании можно почитать здесь.

IPO: зачем это нужно, плюсы и минусы

Конечно, в ходе разговора о современных биржах нельзя обойти вниманием тему IPO — настолько часто можно услышать эту аббревиатуру в различных СМИ.

Когда компания хочет предложить свои акции широкой общественности, она проводит IPO(Initial Public Offering – IPO). Соответственно, статус организации меняется — вместо частной (акционером не может стать любой желающий) она становится публичной (акционером может стать любой желающий).

У частных компаний могут быть акционеры, но их не так много, и такие компании сталкиваются с требованиями регулирующих органов, отличных от тех, которые предъявляются к публичным. Процесс подготовки первичного размещения акций IPO) занимает от нескольких месяцев до года и стоит компании довольно существенных средств.

Все дело в деньгах — компания хочет привлечь средства. После получения эти деньги могут использоваться для развития бизнеса или, к примеру, реинвестиций в инфраструктуру.

Еще один плюс наличия публично торгуемых акций компании — возможность предлагать топ-менеджерам опционы, переманивая лучших специалистов. Помимо этого, акции могут быть использованы в ходе сделок по слиянию и поглощению, покрывая часть оплаты — при покупке Facebook WhatsApp, основатели мессенджера получили значительную часть $19 млрд акциями социальной сети, которая уже вышла на биржу. Попадание в листинг крупнейших мировых бирж — NYSE или NASDAQ — это просто престижно.

Частные инвесторы никак не могут купить акции компании до официального старта торгов. Часто в первые дни торгов акции новых компаний подвержены сильным колебаниям, поэтому обычно аналитики советуют не торопиться с совершением сделок, а выждать пока цена установится на более или менее стабильном уровне.

Сам факт проведения IPO для компании обычно позитивен, ведь это означает, что она достаточно выросла, чтобы претендовать на привлечение капитала подобным способом — к нему прибегают только тогда, когда нужно действительно много денег на масштабное расширение. Кроме того, публичные компании привлекают куда больше внимания, что облегчает им найм персонала и процесс маркетинга.

Среди недостатков IPO можно отметить усиливающее после выхода на биржу внимание к компании со стороны регулирующих органов — существует большое количество требований как государства, так и самих биржевых площадок, которые компании, торгующиеся на них, должны исполнять. В частности это касается выпуска финансовой отчетности. Кроме того, основатели компании не всегда могут после IPO сразу продать свои акции и стать миллионерами, поскольку это может снизить их курс и капитализацию бизнеса.

Заключение: полезные ссылки и материалы для изучения фондового рынка

|

Метки: author itinvest финансы в it блог компании itinvest биржи фондовый рынок опционы |

Safari 11 и WebRTC: подводные камни видеозвонков |

Safari 11 и WebRTC: подводные камни видеозвонков

Итак, это свершилось. Кроме iPhone 8, который устарел ровно через полчаса после анонса iPhone 10, Apple обновила свой десктопный и мобильный браузер Safari. Среди прочих улучшений — реализация WebRTC (ходят слухи, что частично позаимствованная у Chromium. «Plan B» на это тоже намекает). Что это значит для разработчиков? Можно звонить через браузер как на десктопе, так и на айфонах. Голосом и видео. Я уже писал про обновленные инструменты разработчика в браузере, а сейчас хочу поделиться, как это все работает в релизе. Мы уже обновили SDK Voximplant, проверили, как Safari звонит в Microsoft Edge, и вот что я хочу рассказать…

Итак, это свершилось. Кроме iPhone 8, который устарел ровно через полчаса после анонса iPhone 10, Apple обновила свой десктопный и мобильный браузер Safari. Среди прочих улучшений — реализация WebRTC (ходят слухи, что частично позаимствованная у Chromium. «Plan B» на это тоже намекает). Что это значит для разработчиков? Можно звонить через браузер как на десктопе, так и на айфонах. Голосом и видео. Я уже писал про обновленные инструменты разработчика в браузере, а сейчас хочу поделиться, как это все работает в релизе. Мы уже обновили SDK Voximplant, проверили, как Safari звонит в Microsoft Edge, и вот что я хочу рассказать…Видео само не заиграет

Apple внимательно изучила опыт других браузеров, прежде чем добавить поддержку в свой собственный. Вместе с поддержкой было добавлено множество ограничений, которые призваны защитить пользователей от нежелательных баннеров, рекламы и прочих нехороших вещей, которые так любят многие сайты. Одно из таких ограничений: элемент video, в который WebRTC обычно выводит видеопоток с локальной камеры и/или со второго конца звонка, не будет проигрывать видео, пока пользователь в явном виде это не разрешит.

Как выглядит «явное разрешение от пользователя»? Это должен быть интерактивный элемент, в обработчике 'onclick' которого нужно вызвать метод 'play' для объекта видео. Вызов этого метода из другого места кода или программное нажатие на кнопку не включат воспроизведение видео. Помнится, много лет назад программисты Blizzard так же боролись с ботоводами в World of Warcraft, делая «protected» API, вызывать которые можно было только в ответ на действия пользователя.

Safari поддерживает только h.264 видеокодек

Когда два устройства договариваются об установке подключения, они обмениваются (с вашей помощью) текстовыми SDP пакетами. Где, кроме всего прочего, указаны поддерживаемые кодеки. h.264 поддерживают последние версии Chrome, Firefox и Edge — но в более старых версиях ее может не быть. Более того, кроме браузеров видеозвонки могут приходить и от других SIP-совместимых устройств: телефонов, программ-клиентов, мобильных приложений. И если там нет поддержки h.264 — то видеосвязи не будет.

Мелочи, о которых стоит знать

Chrome и Safari для описания медиапотоков в SDP-пакете использует «Plan B». А Firefox — «Unified Plan». Поэтому если больше одного медиапотока (например, при нескольких видеопотоках разного качества) — то кому-то придется выступать в роли переводчика. А про Edge я промолчу.

Также Safari накладывает ряд ограничений на использование WebRTC: только HTTPS, iframe’ы только с того же домена, что и сайт. И если первое требование не вызывает никаких проблем, то требования к iframe’ам сильно ограничивает использование встраиваемых виджетов. С другой стороны, Apple тоже можно понять — именно с таких виджетов чаще всего идет навязчивая видеореклама.

|

Метки: author eyeofhell разработка веб-сайтов программирование safari javascript блог компании voximplant voximplant webrtc |

Safari 11 и WebRTC: подводные камни видеозвонков |

Safari 11 и WebRTC: подводные камни видеозвонков

Итак, это свершилось. Кроме iPhone 8, который устарел ровно через полчаса после анонса iPhone 10, Apple обновила свой десктопный и мобильный браузер Safari. Среди прочих улучшений — реализация WebRTC (ходят слухи, что частично позаимствованная у Chromium. «Plan B» на это тоже намекает). Что это значит для разработчиков? Можно звонить через браузер как на десктопе, так и на айфонах. Голосом и видео. Я уже писал про обновленные инструменты разработчика в браузере, а сейчас хочу поделиться, как это все работает в релизе. Мы уже обновили SDK Voximplant, проверили, как Safari звонит в Microsoft Edge, и вот что я хочу рассказать…

Итак, это свершилось. Кроме iPhone 8, который устарел ровно через полчаса после анонса iPhone 10, Apple обновила свой десктопный и мобильный браузер Safari. Среди прочих улучшений — реализация WebRTC (ходят слухи, что частично позаимствованная у Chromium. «Plan B» на это тоже намекает). Что это значит для разработчиков? Можно звонить через браузер как на десктопе, так и на айфонах. Голосом и видео. Я уже писал про обновленные инструменты разработчика в браузере, а сейчас хочу поделиться, как это все работает в релизе. Мы уже обновили SDK Voximplant, проверили, как Safari звонит в Microsoft Edge, и вот что я хочу рассказать…Видео само не заиграет

Apple внимательно изучила опыт других браузеров, прежде чем добавить поддержку в свой собственный. Вместе с поддержкой было добавлено множество ограничений, которые призваны защитить пользователей от нежелательных баннеров, рекламы и прочих нехороших вещей, которые так любят многие сайты. Одно из таких ограничений: элемент video, в который WebRTC обычно выводит видеопоток с локальной камеры и/или со второго конца звонка, не будет проигрывать видео, пока пользователь в явном виде это не разрешит.

Как выглядит «явное разрешение от пользователя»? Это должен быть интерактивный элемент, в обработчике 'onclick' которого нужно вызвать метод 'play' для объекта видео. Вызов этого метода из другого места кода или программное нажатие на кнопку не включат воспроизведение видео. Помнится, много лет назад программисты Blizzard так же боролись с ботоводами в World of Warcraft, делая «protected» API, вызывать которые можно было только в ответ на действия пользователя.

Safari поддерживает только h.264 видеокодек

Когда два устройства договариваются об установке подключения, они обмениваются (с вашей помощью) текстовыми SDP пакетами. Где, кроме всего прочего, указаны поддерживаемые кодеки. h.264 поддерживают последние версии Chrome, Firefox и Edge — но в более старых версиях ее может не быть. Более того, кроме браузеров видеозвонки могут приходить и от других SIP-совместимых устройств: телефонов, программ-клиентов, мобильных приложений. И если там нет поддержки h.264 — то видеосвязи не будет.

Мелочи, о которых стоит знать

Chrome и Safari для описания медиапотоков в SDP-пакете использует «Plan B». А Firefox — «Unified Plan». Поэтому если больше одного медиапотока (например, при нескольких видеопотоках разного качества) — то кому-то придется выступать в роли переводчика. А про Edge я промолчу.

Также Safari накладывает ряд ограничений на использование WebRTC: только HTTPS, iframe’ы только с того же домена, что и сайт. И если первое требование не вызывает никаких проблем, то требования к iframe’ам сильно ограничивает использование встраиваемых виджетов. С другой стороны, Apple тоже можно понять — именно с таких виджетов чаще всего идет навязчивая видеореклама.

|

Метки: author eyeofhell разработка веб-сайтов программирование safari javascript блог компании voximplant voximplant webrtc |

ФРИИ: опыт акселлерации компаний участников ISDEF |

- Монетизация веб-сервисов,

- Монетизация IT-систем,

- Конференции,

- Growth Hacking,

- Блог компании Ассоциация ISDEF

ФРИИ: опыт акселлерации компаний участников ISDEF

- Монетизация веб-сервисов,

- Монетизация IT-систем,

- Конференции,

- Growth Hacking,

- Блог компании Ассоциация ISDEF

Чем для тебя полезен ISDEF в плане набора проектов в акселератор?

Дмитрий Калаев: Во-первых, ISDEF — достаточно качественное комьюнити, в котором есть уже состоявшиеся предприниматели. Может быть, они пока не построили свои Google или Apple, но по крайней мере это люди с управленческим опытом, весомым опытом продаж, в том числе продаж за пределами России. Это очень хороший багаж, с которым можно растить большую компанию. И второе, ISDEF — это площадка, в которой больше технологических предпринимателей. То есть, не тех, кто научился хорошо продавать, работая, например, в Microsoft, или в другой уважаемой компании с хорошо выстроенными продажами. А наоборот, тех кто, вырос из технологии. У них в качестве базы уже есть достаточно сложный продукт, который сложно скопировать. Эти компании имеют конкурентов, но у них по крайней мере есть, что масштабировать.

Благодаря чему компании-участники ISDEF привлекли твое внимание?

Дмитрий Калаев: Например, iSpring — большая компания со сложной структурой изменений, которая делает топовый мировой продукт в e-learning, находясь в Йошкар-Оле. Это достаточно крупный бизнес, в которым мы, как акселератор, меняем курс корабля. Если у тебя корабль, в котором только пять гребцов, то тебе достаточно просто повернуть руль. Когда у тебя на корабле 140 гребцов, тебе надо перестроить ритм стука в барабаны, тогда разворот корабля занимает другое время. Но в целом iSpring — самый интересный проект, в том числе потому, что у него больше выручка.

Есть команда, которую мы пока ещё не смогли убедить в присоединении к работе на три месяца в Москве, но она нам очень интересна. Iridium Mobile вызывает уважение тем, что команда делает продукт мирового уровня для IoT, находясь в Нижнем Тагиле. Все это переворачивает мнение о России и регионах. В удаленном регионе, оказывается, существуют и техническая экспертиза, и предпринимательский опыт, и понимание международных рынков, позволяющее продавать не только в России, но и за рубежом, быть на лидирующих позициях.

А как выглядит состав портфеля акселератора с точки зрения региональной привязки?

Дмитрий Калаев: На сегодняшний день в нашем портфеле 50% проектов — это Москва, 50% — всё, что за пределами Москвы. Хотя чаще это всё-таки города-миллионники. Напротив, Нижний Тагил и Йошкар-Ола — это даже не миллионики, а более неожиданные города для возникновения мировых лидеров. А так основной поток нам делают города типа Новосибирска, Екатеринбурга, Краснодара и других. Хотя, если говорить не про ISDEF, то меня за последние пару лет удивил Архангельск, который привел сразу три компании. На самом деле, это большая отдельная тема о том, что в регионах есть компании, которые могут делать бизнес на весь российский рынок или даже на мировой.

Я бы ещё отметил коллег из московской компании Driver Pack Solutions. Компания делает продукт, решая проблему, которую такой гигант как Microsoft на протяжении десятилетий не может решить. Надо отдать должное Артуру Кузякову, который строит компанию не на стороне денег, а на стороне клиента. Их конкуренты достаточно жестко ведут себя по отношению к пользователям — не спрашивая, ставят много левого софта, который они не планировали ставить. Это позволяет им, с одной стороны, зарабатывать больше, но, с другой стороны, относятся к своим пользователям совершенно неэкологично. Естественно, что есть большой уровень недовольства, и вот Артур строит свой бизнес как раз по другой модели, когда в открытую объясняет какой софт, и зачем его ставят. Выручка меньше, чем у “злых” конкурентов, но на мой взгляд это совершенно правильный подход. Ты привносишь в мир какие-то улучшения и на этом зарабатываешь.

Какие сильные и слабые стороны у этих проектов ты можешь выделить?

Дмитрий Калаев: По факту одновременно сильная сторона является слабостью. Компании построены разработчиками. Я не вижу в этом ничего плохого, потому что сам был разработчиком, но последний раз код писал лет 13-14 назад. Суть в том, что это компании, которые отлично разбираются в том, что делать с продуктом, но есть пробелы экспертизы в продажах, маркетинге, в общении с клиентом, выяснении потребностей клиента, потому что мы как программисты идём, скорее, из нашего ощущения прекрасного. Но это как раз то, в чем мы как акселератор, сильны. Мы не учим, как лучше программировать, планировать итерации, распределять задачи внутри команды. Мы помогаем выяснить ценность для клиента, сегментировать клиентов на тех, кто помогает нам зарабатывать, и тех, кто наоборот разрушает нашу выручку и наш бренд. Я бы сказал, что это получается идеальная стыковка компетенции основателей и наших компетенций.

Расскажи, как проходила акселерация проектов?

Дмитрий Калаев: Шаг номер один это то, что мы называем диагностикой. Команда хочет увеличить выручку в два раза, увеличить прибыль или, начать выстраивать внутри команды зоны ответственности. Надо понять, где сейчас компания находится, кто клиент, кому продаем, какие компетенции есть, и каких компетенций не хватает. Второй шаг — это изменение видения мира у основателя. Он уже не стартапер, который делает первый бизнес, а предприниматель, бизнес которого существует уже 3, 5, 10 лет. Это значит, что у основателя уже выработались определённые привычки принимать решения, делегировать задачи, способ думать про клиента. По большому счёту на втором шаге привычки приходится пересмотреть. Очень важно, чтобы сам основатель был к этому готов. Потому что без готовности менять что-то никакого результата не получится. К счастью, разработчики — очень гибкие люди, которые в жизни поменяли, скорее всего, не по одному языку программирования. И пересмотреть свой взгляд на жизнь эти люди очень часто готовы. В отличии от более консервативных основателей, которые приходят к нам из традиционных отраслей, например, автомобильного или строительного бизнеса.

Третий шаг — это скорость. У нас возникают гипотеза про увеличение цены, про сокращение триального периода, гипотезы про новые сегменты клиентов, которые надо тестировать. Не бывает таких гипотез, которые реализуются со стопроцентной вероятностью. Здесь очень важно, что вся компания начинает работать как тестовая лаборатория. Провели эксперимент, получили результаты, сделали выводы, повторили эксперимент и так далее. Наша лаборатория оказывается движима не метриками продуктановых функций или, метриками количества ошибок в конечном релизе, а метриками выручки. Таким образом мы перестраиваем компанию на увеличение прибыли. Теперь мы добавили функцию «прибыль увеличилась», «прибыль уменьшилась» или «прибыль такая же как была».