Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[recovery mode] Реализация системы доступа в собственном корпоративном мессенджере: часть первая |

Backend для мессенджера написан на Go, поэтому и примеры будут на этом языке. Не желая изобретать велосипед, мы решили взять за основу XACML — стандарт для ABAC (Attribute-Based Access Control) — и максимально упростили его, чтобы он подходил для нашей задачи. Хотим отметить, что мы не ставили перед собой цель написать собственную реализацию XACML. Он был взят как пример работающей системы, из которого мы могли бы извлечь нужный для нас опыт.

Для знакомства с XACML и ABAC есть отличные статьи:

Знакомство с XACML — стандартом для Attribute-Based Access Control

Подходы к контролю доступа: RBAC vs. ABAC

Базовые объекты системы и интерфейс AttributeCalculater

Сразу расскажем об интерфейсе AttributeCalculater, так как он будет встречаться далее. По сути, он состоит из трех других интерфейсов, но для краткости мы ограничимся тем, что просто запишем все его методы. Его должны реализовать все объекты модели приложения, которые взаимодействуют с системой доступа.

type AttributeCalculater interface {

Counter() (AttributeCalculater, error)

Equally(Getter) bool

Belong(Getter) bool

GetType() string

GetValue() (AttributeCalculater, error)

GetValueField(string) (AttributeCalculater, error)

GetInt() (int, error)

GetBool() (bool, error)

GetString() (string, error)

}В системе используются два основных типа объектов: Правила и Политики. Для нашей задачи этого достаточно, поэтому группы политик мы не стали использовать за ненадобностью.

Правило (rule)

Правило — это самый простой объект в системе, который используется для описания бизнес-правил. Вот его структура:

type rule struct {

Name string

Condition condition

Effect ruleEffect

}

func (r *rule) calculate(cntx *Context) calculateResult {}

Метод calculate вычисляет правило, то есть возвращает значение, которое говорит, может запрос быть выполненным или нет, или сообщает о возникшей ошибке. Для этого в метод передается контекст, в котором содержится вся необходимая информация для вычисления.

type Context struct {

Object AttributeCalculater

Subject AttributeCalculater

Target Action

}Контекст состоит из объекта (object) — сущности, которая реализует интерфейс AttributeCalculater и с которой система доступа выполняет какие-то действия, субъекта (subject) — сущности, которая так же поддерживает интерфейс AttributeCalculater и обычно является пользователем, желающим выполнить определенное действие в приложении. Цель (target) является enum'ом, в котором перечислены все возможные действия, поддерживающиеся системой доступа. Например: добавить пользователя в переписку, написать сообщение, назначить админа переписки и т.д.

Name (имя) правила нужно прежде всего для человека, который с ним работает — на сам процесс вычисления оно никак не влияет.

Effect (эффект) показывает, как будет обрабатываться результат вычисления условия. Эффект может быть разрешающим (permitEffect) или запрещающим (denyEffect). Скажем, если результат вычисления условия — true, а эффект задан как permitEffect, то результат вычисления правила также будет true. Если же эффект прописан как denyEffect, то результатом правила будет false.

Condition (условие) — самая главная часть правила, в которой, собственно, описывается и высчитывается условие для него.

type condition struct {

FirstOperand Attribute

SecondOperand Attribute

Operator conditionOperator

}

func (c *condition) calculate(cntx *Context) (bool, error) {}Метод calculate вычисляет условие. Он похож на аналогичный метод у правила, только возвращаемые значения у него другие. Условие может быть верно, неверно или же сообщать об ошибке.

Operator (оператор) отвечает за то, как сравниваются два операнда. Принимает следующие значения:

- equally - проверяет, равны ли операнды.

- notEqually — проверяет, не равны ли операнды.

- belong — проверяет, есть ли между операндами какое-то отношение. Конкретная логика зависит от реализации интерфейса AttributeCalculater, который должны реализовать объекты, работающие с системой доступа. Подробнее об этом расскажем ниже.

- notBelong — противоположность belong.

Как видно из структуры, условие может быть вычислено только для двух операндов, то есть в одном правиле не предполагается рассмотрение сложных use case'ов, которые возникают при работе с системой доступа. Для этого используются комбинации правил.

Тип данных операндов — это Attribute (атрибут). В нем находится информация вычисления условий.

type Attribute struct {

NameObject string

Field string

Type TypeAttribute

Object AttributeCalculater

}

func (a *Attribute) getValue(c *Context) (AttributeCalculater, error) {}Метод getValue возвращает значение атрибута. Возвращается оно в виде объекта, у которого реализован интерфейс AttributeCalculater.

NameObject (имя объекта), у которого при вычислении атрибута берется значение из поля Field. Сам же объект находится в поле Object.

Политика (politic)

Политики используются для описания бизнес-правил с одним или несколькими правилами.

type politic struct {

Name string

Target Action

Rules []rule

CombineAlgorithm combineAlgorithm

}

func (p *politic) calculate(cntx *Context) calculateResult {}Name (имя) у политики, как и у правила, нужно только для человека, который с ней работает.

Targer (цель) используется для поиска политик. Для простоты в нашей системе у каждой цели своя политика.

Rules (правила) — это набор простых правил, которые дополняя друг друга могут описывать сложные бизнес-правила.

CombineAlgorithm (алгоритм комбинирования) правил указывает на то, как обрабатывать результаты вычисления правил политики. В XACML эти алгоритмы могут быть достаточно сложными, но в нашем случае все эти изыски не нужны. Поэтому у нас пока всего два простых алгоритма permitIfAllPermitted (разрешить, если все разрешили) и permitIfOnePermitted (разрешить, если один разрешил). Например, если стоит алгоритм permitIfAllPermitted, то результат вычисления политики будет положительным только при том условии, что все правила в этой политике также имели положительный результат.

Вот основные части, из которых состоит наша система доступа. В следующей статье мы подробно рассмотрим, как это все работает.

|

Метки: author elder_cat системы обмена сообщениями go блог компании everyday tools мессенджеры |

[Перевод] Краткая история случайных чисел |

|

Метки: author tangro системное программирование программирование криптография анализ и проектирование систем блог компании инфопульс украина rand |

Проектирование и разработка шаблонного движка на C# и ANTLR |

Предыстория

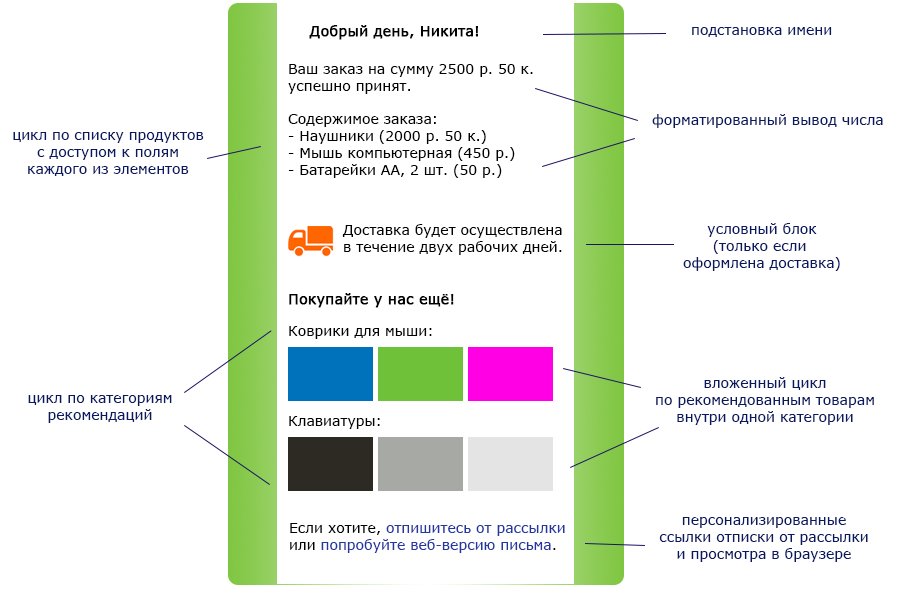

Уже много лет мы помогаем нашим клиентам отправлять потребителям хорошие, информативные и человеческие письма. В них вместо сухого “Добрый день” мы пишем “Здравствуйте, Никита!”, а вместо “Ваш баланс пополнился” сообщаем “вы получили 25 баллов”. Но маркетологи становятся все изобретательнее, и современное письмо от интернет-магазина должно выглядеть так:

И мы хотим уметь генерировать такие письма автоматически.

Наш старый, проверенный временем шаблонный движок умеет вставлять в нужные места письма параметры, подставлять вместо отсутствующего значения что-то по умолчанию и писать “1 рубль, 2 рубля, 5 рублей”, причем делает это хорошо. Но он не предназначен для сложных ветвлений, циклов и любой другой сложной логики. Поэтому для формирования сложных писем как на картинке нам приходилось прибегать к коду на C#, и выглядело это так:

Мы оказались в не очень приятной вселенной, где желание клиента выделить курсивом слово в письме приводит к тикету на программиста и выкладке на продакшн. Мы в этой вселенной задерживаться не хотели, и стало понятно, что нам нужен новый шаблонный движок, который должен уметь:

- вывод простых параметров

- вывод сложных многоуровневых параметров (Recipient.Address.City.Name)

- условия

- циклы

- арифметические операции

И это только бизнес-требования, основанные на реальных сценариях. А поскольку мы хотим, чтобы при заведении рассылки менеджеру было легко заводить рассылки и сложно ошибиться, нам нужны еще:

- внятные сообщения об ошибках

- валидация используемых в шаблоне параметров

- расширяемость (возможность добавлять свои функции)

А поскольку мы иногда шлем миллионы писем в час, нам необходима хорошая производительность, а значит:

- прекомпиляция шаблона

- возможность переиспользования шаблона и потокобезопасность

Мы рассмотрели несколько доступных шаблонных движков, начиная Liquid и заканчивая Mustache, и все они немного со странностями. Кто-то при ошибке не падает с исключением, а просто рендерит пустую строку. Где-то синтаксис такой, что мы, будучи программистами, не смогли понять, как написать условие. Мы всерьез подошли к безумной идее использовать близкий и понятный нам Razor для формирования писем, но отказались от неё из-за досадной мелочи: получалось, что составитель шаблона рассылки мог выполнять произвольный .NET-код в процессе, отправляющем письмо.

И конечно же, в итоге мы решили написать свой шаблонный движок. Со статической типизацией и цепочками фильтров.

Дизайн языка

Практически сразу мы приняли решение отказаться от совместимости с чем-либо. Отказались от обратной совместимости с предыдущим шаблонным движком: синтаксис должен быть таким, чтобы можно было органично расширять язык пять лет в будущем, а не подстраиваться под то, что разработано за пять лет в прошлом. Отказались от совместимости с каким-то стандартом де-факто, по которому все верстают шаблоны писем: его просто нет. Мы оказались перед абсолютно белой доской, на которой нужно было нарисовать синтаксис нашего языка, и сразу начали придумывать себе рамки, в которых можно творить.

Во-первых, язык должен встраиваться в HTML, а значит, должен предусматривать escape-последовательности, отделяющие блоки нашего кода от остальной разметки.

Мы остановились на таком варианте:

Идея разделять выводящие инструкции ${ … } и не выводящие, служебные инструкции @{ … } навеяна имплицитными и эксплицитными выражениями из Razor. Попробовали посмотреть, как это будет выглядеть в реальной HTML-вёрстке, и да, так оказалось лучше и нагляднее.

Позже вспомнили, что такой же синтаксис используется в TypeScript для string interpolation (а в C# – другой, но тоже похожий). Стало приятно: если Андерс Хейлсберг посчитал это хорошим синтаксисом, то мы на верном пути.

Во-вторых, мы подумали, кто будет пользоваться нашим языком шаблонов. С большой вероятностью вёрстку письма будет делать верстальщик, которому близок и понятен javascript. С другой стороны, дорабатывать вёрстку по мелочам и править мелочи в логике скорее всего будет менеджер, который не знает javascript, но знает английский язык и здравый смысл. Поэтому наш синтаксис в итоге получился больше похож на Паскаль, с нормальными человеческими словами and, or, not вместо закорючек и амперсандов.

В итоге остановились на таком синтаксисе:

Осталось всего ничего: сдуть пыль с “книги дракона” и реализовать лексический разбор, синтаксический анализ, семантический анализ, а потом обеспечить генерацию выходного результата – письма.

Парсинг и ANTLR

Всем должно быть очевидно, что придуманный нами язык по классификации Хомского описывается контекстно-свободной LL-грамматикой, для разбора которой, соответственно, достаточно реализовать LL(*)-парсер. И тут же мы столкнулись с небольшой проблемой: мы почти ничего в этом не понимаем и не умеем.

Мы хорошо умеем делать сложный веб-фронтенд с большим количеством javascript, делать сложную серверную валидацию, работать с терабайтными базами данных и решать проблемы производительности и многопоточности в условиях тысяч транзакций в минуту. А вот языковые грамматики – не совсем наша компетенция. А на разработку шаблонного движка у нас в идеале две недели.

На этом месте мы пошли и ввели в гугле в строку поиска чит-код: ANTLR. Эффект не был мгновенным, но после пары дней, потраченных на чтение документации и эксперименты, мы получили такой прогресс, на который при ручной разработке ушло бы несколько недель. Итак, что такое Antlr и что он берет на себя?

ANTLR (ANother Tool for Language Recognition) – открытая библиотека, написанная Терренсом Парром, преподавателем университета Сан-Франциско и автором десятка с лишним научных статей о формальных грамматиках и их разборе. Её понемногу используют для задач парсинга ребята из Google, Oracle и Microsoft (например, в ASP.NET MVC). Antlr полностью берёт на себя лексический и синтаксический разбор текста, руководствуясь формальным описанием грамматики языка.

Конечно, не всё было безоблачно. При близком знакомстве Antlr оказался java-утилитой, которую нужно запускать из командной строки, пытаясь подобрать правильные аргументы из противоречащих друг другу статей документации, чтобы она сгенерировала C#-код, на который будет ругаться StyleCop. Документация нашлась, но не всё, что реализовано в утилите, описано в документации, и – вот это было ударом – не всё, что описано в документации (официальной книге от автора библиотеки) уже реализовано в утилите. Поддержка C# оказалось не такой полной, как поддержка Java, а из работающих вспомогательных инструментов мы нашли только плагин к эклипсу.

На всё это можно смело закрывать глаза, потому что после того, как мы заставили эту дурацкую штуку работать, мы получили код, который принимает поток с текстом, а возвращает полностью готовое синтаксическое дерево и классы для его обхода.

Мы не стали писать парсер шаблона и никогда не планируем этим заниматься в будущем. Мы описали грамматику языка, доверив Antlr решение скучных бытовых проблем, связанных с его парсингом, себе оставили интересные и неожиданные проблемы, связанные со всем остальным.

Грамматика языка: лексические правила

Описание грамматики ANTLR складывается из набора рекурсивных правил. Любому, кто на первом-втором курсе познакомился с БНФ, диаграммами Вирта или другими способами описания формальных языков, эта идея будет близка и понятна.

Точно так же нам близка идея максимального отделения лексического разбора от синтаксического анализа. Мы с радостью воспользовались возможностью разнести по разным файлам правила, определяющие терминалы и примитивные токены языка, от синтаксических правил, описывающих более сложные составные и высокоуровневые конструкции.

Взялись за правила лексера. Самая важная задача – сделать так, чтобы мы распознавали наш язык только внутри блоков ${ ... } и @{ .... }, а остальной текст письма оставляли неизменным. Иными словами, грамматика нашего языка – островная грамматика, где текст письма – неинтересный для нас “океан”, а вставки в фигурных скобках – интересные “острова”. Блок океана для нас абсолютно непрозрачен, мы хотим его видеть одним крупным токеном. В блоке острова мы хотим максимально конкретный и мелкий разбор.

К счастью, Antlr поддерживает островные грамматики из коробки благодаря механизму лексических режимов. Сформулировать правила, по которым мы делим текст на “океан” и “острова” было не совсем тривиально, но мы справились:

Эти правила переводят парсер в режим “внутри инструкции”. Их два, потому что ранее мы решили иметь немного различный синтаксис для управляющих инструкций и инструкций вывода.

В режиме “внутри инструкции” симметричное правило, которое при встрече с закрывающей фигурной скобкой возвращает парсер в основной режим.

Ключевые слова “popMode” и “pushMode” намекают нам, что есть у парсера есть стек режимов, и они могут быть вложенными с какой-то внушительной глубиной, но для нашей грамматики достаточно переходить из одного режима в другой и потом возвращаться обратно.

Осталось описать в “океане” правило, которое будет описывать всё остальное, весь текст, который не является входом в режим инструкций:

Это правило воспримет как Fluff (ерунда, шелуха, незначительный мусор) любую цепочку символов, не содержащую @ и $, либо ровно один символ $ или @. Цепочку токенов Fluff потом можно и нужно склеить в одну строковую константу.

Важно понимать, что лексер пытается применять правила максимально жадно, и если текущий символ удовлетворяет двум правилам, всегда будет выбрано правило, захватывающее наибольшее число следующих символов. Именно поэтому, когда в тексте встретится последовательность ${, лексер воспримет её как OutputInstructionStart, а не как два токена Fluff по одному символу.

Итак, мы научились находить “острова” нашей грамматики. Это стерильное и контролируемое пространство внутри шаблона, где мы решаем, что можно, а что нельзя, и что означает каждый символ. Для этого понадобятся другие лексические правила, которые работают внутри режима инструкции.

Мы не пишем компилятор Python и хотим разрешать ставить пробелы, табуляции и переносы строк везде, где это выглядит резонным. К счастью, и это тоже Antlr позволяет:

Такое правило, конечно же, может существовать только в режиме “острова”, чтобы мы не вырезали пробелы и переносы строк в тексте письма.

Остальное несложно: смотрим на утвержденный пример синтаксиса и методично описываем все лексемы, которые в нем встречаем, начиная с DIGIT

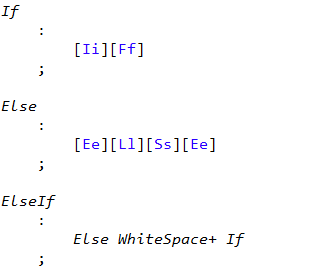

и заканчивая ключевыми словами (IF, ELSE, AND и другие):

Регистронезависимость выглядит страшновато, но в документации резонно написано, что лексический разбор – штука точная и подразумевающая максимально явное описание, и эвристике по определению регистра во всех алфавитах мира там не место. Мы не стали с этим спорить. Зато у нас else if воспринимается как один токен (что удобно), но при этом он не elsif и не elseif, как это бывает в некоторых языках.

Откуда-то из глубин воспоминаний о первом и втором курсе, растревоженных словами про БНФ и диаграммы Вирта, всплывает понимание, как описать IDENTIFIER так, чтобы идентификатор мог начинаться только с буквы:

Еще несколько десятков не самых сложных правил, и можно вынырнуть на уровень выше – в синтаксический разбор.

Грамматика языка: синтаксические правила

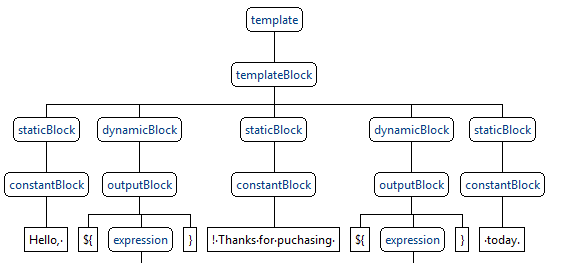

Структура любого письма в нашем шаблонизаторе проста и напоминает зебру: статические блоки вёрстки чередуются с динамическими. Статические блоки – это куски вёрстки с подстановкой параметров. Динамические – это циклы и ветвления. Мы описали эти основные блоки таким набором правил (приведен не полностью):

Синтаксические правила описываются таким же образом, как и лексические, но базируются они не на конкретных символах (терминалах), а на описанных нами лексемах (с большой буквы) или других синтаксических правилах (с маленькой буквы).

Разобрав текст этим набором правил, получили что-то подобное:

В статических и динамических блоках может быть набор инструкций произвольной сложности, начиная выводом одиночного параметра и заканчивая сложным ветвлением по результатам выполнения арифметических операций внутри цикла. Всего у нас получилось порядка 50 синтаксических правил такого вида:

Здесь мы описываем сложное условное высказывание, в котором обязателен блок if, может быть несколько блоков else if и может быть (но не обязательно) один блок else. В блоке If внутри знакомый нам templateBlock – тот самый, который может быть чем угодно, в том числе другим условием.

Где-то на этом месте наша грамматика начала быть по-настоящему рекурсивной, и стало жутковато. Поставив последнюю закрывающую фигурную скобку, мы сгенерировали при помощи ANTLR код парсера нашей грамматики, подключили его к нашему проекту и задумались, что со всем этим делать.

От дерева к дереву

Результат работы Antlr начиная с 4 версии – парсер, который превращает текст в так называемое concrete syntax tree, оно же парсерное дерево. Под concrete подразумевается, что дерево содержит в себе всю информацию о синтаксисе, каждое служебное слово, каждую фигурную скобку и запятую. Это полезное дерево, но не совсем то, которое нужно для наших задач. Основные его проблемы – слишком сильная связанность с синтаксисом языка (который неизбежно будет меняться) и совершенная неосведомленность о нашей предметной области. Поэтому мы решили обходить это дерево ровно один раз и строить на его основе своё дерево, которое ближе к abstract syntax tree и удобнее в дальнейшем использовании.

Требования к дереву такие:

- не должно содержать подробностей синтаксиса (нам важно, что идёт ветвление на три ветки, а слова

if,else ifиelseне интересны) - должно поддерживать все типовые сценарии обхода (рендеринг письма с подстановкой значений параметров, получение списка параметров и их типов)

Упрощенный интерфейс вершины нашего дерева в итоге выглядит примерно так (набор потомков и логика их обхода слишком разные для разных узлов, поэтому в общем интерфейсе их нет):

internal interface ITemplateNode

{

void PerformSemanticAnalysis(AnalysisContext context);

void Render(StringBuilder resultBuilder, RenderContext renderContext);

}Вдохновившись рассказами создателей Roslyn о красно-зелёных деревьях, решили, что наше дерево будет полностью immutable. Во-первых, с таким кодом просто удобнее и проще работать, не задаваясь вопросами о состоянии и последовательности изменений. Во-вторых, это самый простой способ обеспечить потокобезопасность, а значит – возможность использовать один прекомпилированный шаблон письма для отправки во многих потоках. В общем, красота, осталось его построить.

Обходить парсерное дерево, сгенерированное Antlr, предлагается при помощи паттерна Visitor. Сам Antlr предоставляет интерфейс визитора, а также базовую реализацию, которая обходит все вершины дерева в глубину, но ничего при этом не делает.

Конечно, есть вариант сделать один гигантский визитор, в котором будет реализован обход всех наших правил, которых вроде и не так много, а вроде как почти 50. Но гораздо удобнее оказалось описать несколько разных визиторов, задача каждого из которых – сконструировать одну вершину нашего результирующего дерева.

Например, для обхода условий внутри @{ if } … {else if } … {else } .. @{ end if } мы используем специальный визитор:

internal class ConditionsVisitor : QuokkaBaseVisitor

{

public ConditionsVisitor(VisitingContext visitingContext)

: base(visitingContext)

{

}

public override ConditionBlock VisitIfCondition(QuokkaParser.IfConditionContext context)

{

return new ConditionBlock(

context.ifInstruction().booleanExpression().Accept(

new BooleanExpressionVisitor(visitingContext)),

context.templateBlock()?.Accept(

new TemplateVisitor(visitingContext)));

}

public override ConditionBlock VisitElseIfCondition(QuokkaParser.ElseIfConditionContext context)

{

return new ConditionBlock(

context.elseIfInstruction().booleanExpression().Accept(

new BooleanExpressionVisitor(visitingContext)),

context.templateBlock()?.Accept(

new TemplateVisitor(visitingContext)));

}

public override ConditionBlock VisitElseCondition(QuokkaParser.ElseConditionContext context)

{

return new ConditionBlock(

new TrueExpression(),

context.templateBlock()?.Accept(

new TemplateVisitor(visitingContext)));

}

} Он инкапсулирует в себе логику создания объекта ConditionBlock из фрагмента синтаксического дерева, описывающего ветку условного оператора. Поскольку внутри условия может быть произвольный кусок шаблона (грамматика-то рекурсивная), управление для разбора всего внутри снова передается универсальному визитору. Наши визиторы связаны рекурсивно примерно так же, как и правила граммматики.

На практике с такими маленькими визиторами легко и удобно работать: в них определен обход только тех элементов языка, которые мы ожидаем увидеть в каждом конкретном месте, а их работа заключается либо в инстанцировании новой вершины дерева, которое мы строим, либо в передаче управления другому визитору, который занимается более узкой задачей.

На этом же этапе мы избавляемся от некоторых неизбежных артефактов формальной грамматики, таких, как избыточные скобки, конъюнкции и дизъюнкции с одним аргументом и прочие вещи, необходимые для определения лево-рекурсивной грамматики и абсолютно ненужные для прикладных задач.

И в результате получаем из такого дерева

такое

Это дерево гораздо лучше укладывается в голове, не содержит бесполезной информации, его узлы инкапсулируют реализацию конкретных инструкций, и вообще с ним можно работать.

Осталось совсем немного – обойти его несколько раз. И первый, обязательный обход – это обход для семантического анализа.

Получение списка параметров и типизация

Одна из ключевых задач нашего шаблонизатора – умение найти в тексте письма все используемые в нем параметры. Цель понятна: валидировать и не давать сохранить шаблон, в котором встречаются параметры, которые мы не сможем подставить в письмо. Например, Recipient.Email мы знаем, а Recipietn.Eamil – нет. Для нас важно, чтобы отправитель узнал об ошибке в шаблоне сразу при его сохранении, а не при попытке отправить письмо.

Однако это не единственное направление валидации параметров. Хотим ли мы давать написать в письме ${ Recipient.Email + 5 }, зная, что Email у нас в системе – строковое поле? Кажется, нет. Значит, мы должны не только найти все параметры в письме, но и определить их тип. На этом месте мы обдумали типизацию и поняли, что она у нас статическая (что хорошо), но при этом неявная (что удобно пользователю, но неудобно нам). Ощутили мимолетный импульс заставить менеджера декларировать в начале письма все параметры явно, указывая тип. Удобство пользователя победило, импульс подавили. Придется определять тип “на лету” исходя из контекста.

Система типов нашего шаблонизатора выглядит так:

- примитивный тип

- целое число

- дробное число

- логическое значение

- дата-время

- составной тип, содержащий именованные свойства любого типа

- множественный тип (массив, коллекция, список, как угодно), содержащий несколько значений одного определенного типа

Подход к решению задачи простой: для того, чтобы определить тип параметра, входящего в письмо, достаточно найти все его использования в тексте и попытаться определить непротиворечивый тип, удовлетворяющий всем вхождениям или же сообщить об ошибке шаблона. На практике это оказалось не самой простой задачей с кучей особенных случаев, которые надо учесть.

Оказалось, что у переменных цикла есть область видимости. Оказалось, что бывают вложенные циклы по списку списков. Оказалось, что можно проходить в цикле по одному и тому же списку в двух разных местах в шаблоне, и обращаться там к разным полям элементов списка. В общем, понадобился крепкий статический анализ, над которым пришлось как следует подумать, а также несколько десятков юнит-тестов, но результатом мы довольны.

Глядя на этот шаблон, мы можем сказать, что у потребителя должен быть массив продуктов, а каждый продукт имеет цену и массив категорий, а у каждой категории должен быть как идентификатор Id, так и название Name. Теперь достаточно спросить нашу систему, есть ли в ней параметры такой структуры, и никаких сюрпризов при отправке не будет. Или почти никаких.

Рендеринг

Финальное испытание уже не казалось сложным: к моменту отрисовки текста письма у нас на руках вся структура шаблона, и достаточно просто еще раз обойти дерево, предоставляя каждому узлу возможность что-то записать в поток (или вернуть строку).

На практике же пришлось здесь решить еще порцию задачек по программированию для начинающих: булева логика, арифметические вычисления и сравнения, вложенные области определения переменных, приведение типов и обработка ошибок.

Могут ли быть ошибки при рендеринге письма, если мы потратили столько усилий на статическую типизацию параметров и валидацию шаблона еще до отправки письма? К сожалению, да:

Вывод такого значения приведет к ошибке, если B = 0. Заманчивая идея – усилить систему типов для таких случаев, но легко вообразить и такой сценарий, где всё совсем-совсем непредсказуемо:

Мы смирились с тем, что ситуация, когда конкретный набор параметров в письме приводит к ошибке рендеринга, не предотвращается статическим анализом, и стали выбирать между двумя вариантами:

- Иметь reasonable defaults (при выводе null-значения выводить пустую строку, при использовании в условии null-значения возвращать false, при делении на ноль работать с NaN и так далее)

- Соблюдать принцип fail fast

Решили так: отправить кривое письмо гораздо хуже, чем не отправить никакое вообще. Отправленное уже не вернешь, а не отправленное можно исправить и повторить. Поэтому fail fast, понятный, простой и без эвристик, нам подходит гораздо лучше.

Раз мы не боимся ошибок и неудач во время отрисовки письма, теперь можно допустить к этому процессу и других программистов. Можно вообразить несколько десятков полезных функций, которые как-либо преобразуют примитивные значения: вычисление каких-нибудь криптографических хэшей для подстановки в письмо, округления дробей, добавление параметров в ссылку. Львиную долю этих возможностей мы оставили за бортом шаблонизатора, чтобы пользователи библиотеки расширяли его снаружи. К счастью, это не сложно, а типы аргументов и возвращаемого значения строго типизированы:

internal class ToUpperTemplateFunction : ScalarTemplateFunction

{

public ToUpperTemplateFunction()

: base(

"toUpper",

new StringFunctionArgument("string"))

{

}

public override string Invoke(string argument1)

{

return argument1.ToUpper(CultureInfo.CurrentCulture);

}

}Остаётся учесть мелкие детали: подставить уникальные ссылки для трекинга кликов и открытий, сгенерировать ссылки отписки и просмотра веб-версии письма, отвалидировать переданные параметры, и письмо готово к отправке.

Итоги

Приняв примерно сотню мелких и больших решений, мы наконец отрендерили своё первое письмо с циклами и условиями. Мы написали свой собственный шаблонный движок, практически с нуля, и в процессе поняли, что синдром Not invented here – плохо, но если правда не находится ничего, что удовлетворяет нашим требованиям, надо брать и делать своё.

Сейчас, отправив с его помощью несколько сотен миллионов сообщений и увидев, как наши менеджеры каждый день верстают письма в десятки раз сложнее, чем это казалось возможным, можно с уверенностью сказать, что он в итоге работает.

Как раз момент для того, чтобы проанализировать проделанную работу, сохранить куда-нибудь файл с несколькими сотнями доработок, которые хочется сделать, описать процесс в блоге и взяться за следующую задачу.

Ссылки:

|

Метки: author ivoninroman верстка писем c# .net блог компании mindbox antlr4 antlr шаблонизатор email- рассылки |

Почему стоило посетить OS Day 17 |

Читая комментарии к статье о конференции OS Day 2017, я как разработчик одной из представленных в России ОСРВ Embox, был немного в шоке. Нет, в России все знают, что кроме BolgenOS и каких-то очередных распилов у нас ничего не умеют!

Но во-первых, мероприятие проходило в главном здании РАН, и вряд ли такая солидная организация пропустила бы поделки школьников, а во-вторых, комментарии писали пользователи хабра, а значит, технически грамотные люди, и в отсутствии у них осведомлённости об Alt Linux, KolibriOS, PhantomOS, ReactOS вряд ли можно усомниться. Я решил не вмешиваться в обсуждение, а написать собственное мнение о происходившем по итогам этой конференции.

Статья ни в коем случае не официальная, все официальные отчеты и пресс-релизы сделают организаторы. Здесь будут освещены только запомнившиеся лично мне моменты.

Безопасность, безопасность и еще раз, безопасность

В первый день почти все говорили о проблемах безопасности и о путях ее решения. Для кого-то это использование СПО, для кого-то это внедрение и исполнение регламентирующих документов, кто-то предлагал свои методы решения проблем на уровне архитектуры.

Не буду рассказывать о нескольких докладах ФСТЭК, в том числе зам директора ФСТЭК Виталия Лютикова, поскольку не являюсь специалистом в области регламентирующих документов, но данные доклады вызвали довольно большой интерес у собравшихся, а значит, такие проблемы действительно интересны.

ИСП РАН сделал несколько докладов отдельно и в соавторстве с другими участниками конференции. В первый день почти все они были посвящены анализаторам кода. То есть, предлагаемый ИСП РАН подход к безопасности заключается в улучшении процесса разработки и использовании соответствующих технологий.

Товарищи из Лаборатории Касперского меня, как разработчика встроенных систем, порадовали тем, что показали работу на железке с процессором imx6 (ARMv7). Их доклад, как и следовало ожидать, был посвящен операционной системе KasperskyOS. Нам показали коробку с не очень понятным содержимым, зато объяснили идею предлагаемого решения.

Как я понял, она заключалась в следующем:

- На разрабатываемое ПО накладываются ограничения: по сути дела, прикладное ПО может предоставлять только некий сервис с заранее описанным интерфейсом. В принципе, под это подходит любая микроядерная архитектура.

- Выделяется некий сервер (сервис) безопасности, который пропускает через себя все IPC-сообщения, или, по сути, запросы к сервисам.

- В сервисе безопасности есть доступ к дескрипторам безопасности, которые можно наложить на любой публичный вызов в остальных сервисах. Ограничения для дескрипторов, разрабатываются на DSL (специализированном языке), отдельно от основной бизнес-логики.

СПО и кооперация

Одним из первых выступал директор ИСП РАН Арутюн Аветисян.

Мне доклад понравился, хоть там и были рекламные нотки. Один из ключевых тезисов доклада, как я понял, заключался в том, что институт имеет богатый опыт именно в работе с СПО. Поскольку системное ПО, да и не только системное, должно быть мирового качества, необходимо объединяться и совместно развивать СПО, так как отдельным компаниям и институтам это не под силу.

В принципе, большинство проектов и компаний, выступающих на конференции, а также большинство участников в той или иной степени связаны с СПО. Часто были слышны вопросы и доклады о том, как именно контрибьютят, в какие проекты и так далее.

Импортозамещение

Это, наверное, самое часто упоминаемое и наиболее провокационное направление!

Например, в своем докладе Сергей Аносов заявил, что Sailfish OS — отечественная система потому, что внесена в реестр отечественного ПО, и в подтверждение привёл сертификат (можно посмотреть в презентации). А Егор Васильев сообщил, что ГосЛинукс уже год не вносят в этот самый реестр! В принципе, это и не нужно, поскольку его невозможно купить, то есть он бесплатен, его можно скачать и, получив разрешительные документы, использовать.

Конечно, одними из самых активных и докладчиков и “вопросозадавателей” были сотрудники Базальта (бывший Альт Линукс). Порой они доходили до лёгкого троллинга, ведь у них оригинальная базовая платформа, а те, кто делает на Debian, CentOS и других, зависят от соответствующих комьюнити.

Вообще, на конференции присутствовали пользователи и разработчики большинства популярных семейств дистрибутивов Linux. Фишкой стала попытка некоторых компаний войти в кооперацию, например, компания Mellanox Technologies сделала прототип коммутатора на ОС ALT.

Ещё одной темой стала борьба с Windows. Точнее, не борьба, а как раз взаимодействие: кто-то жаловался на лицензионные шрифты и офисные программы, кто-то предлагал использовать Mono для запуска приложений, но, наверное, отмечу только доклад Алексея Коптева из компании РедСофт. Он рассказал про проблему с криптобиблиотекой под wine и как она была решена. Запомнился доклад тем, что разработчики предпочли не нарушать лицензионные соглашения, а нашли корректный способ решить эту проблему, написав соответствующий патч. Кроме того, выяснилось, что такая же проблема есть у многих компаний, и уже в кулуарах соратники по проблеме долго обсуждали данную тему.

Мобильные платформы и корпоративный сегмент

На конференции были представлены две “отечественные” платформы: Тайзен.ру и уже упомянутая ранее Открытая мобильная платформа (Sailfish Mobile OS RUS). Платформенность заключается в том, что на территории России развернута собственная инфраструктура и для приложений, и для сборки и разработки.

На мой взгляд, Тайзен выглядел сильно лучше. Это не удивительно, ведь за ним стоит вся мощь компании Samsung. Основная часть доклада была посвящена презентации новой части Tizen для IoT решений Tizen-RT. Презентовал её Вячеслав Тыртов, ведущий инженер Samsung R&D Institute RUS. То есть, сотрудник Самсунг, а не Тайзен. Новая ОС основана на NuttX, и часть доклада была посвящена именно ей.

Чтобы не быть уличённым в предвзятости, отмечу, что Sailfish OS предлагают корпоративные решения с закрытыми или не очень магазинами приложений и вообще частной инфраструктурой.

Наука, религия и бред сумашедшего

Эта секция, даже несколько секций, объединяли доклады, которые предлагали какие-то новые идеи и концепции в области операционных систем. Сама идея, что в ОСестроение можно привнести что то новое и строить ПО по другим принципам, время от времени возникает, ведь в этой области очень мало изменений со времен UNIX и микроядра.

Конечно, основное место в плане новых концепций у нас занимает PhantomOS. Было два доклада. Один от автора ОС Фантом Дмитрия Завалишина, он был посвящен особенностям архитектуры “Эльбрус-2000” (E2K), на которую сейчас происходит портирование данной ОС. Второй доклад был от профессора Иннополиса Евгения Зуева. Его доклад был посвящен возможным направлениям развития ОС Фантом. На основе ОС Фантом и платформы Эльбрус с помощью рабочей группы в Иннополисе планируется создать некий продукт, который можно будет внедрить не только в учебный процесс.

Очень порадовал

Станислав Братанов из компании Интел тоже представил оригинальную концепцию Ресурс-Владелец-Услуга (Resource-Owner-Service, ROS). Данная ОС был разработана в 1999 году и в 2009 получила своё новое развитие как ОС для сенсорных сетей. Я уже читал статью о данной разработке на хабре, но было интересно услышать об этом вживую. Правда, многие слушатели доклада сошлись на том, что в нём описывается Erlang.

Был и чисто научный доклад от Евгения Клименко, он предложил менеджер управления памятью для микроядер на основе оригинальной модели. Поскольку в двух словах передать это сложно, лучше посмотреть его тезисы и презентацию.

Бортовые системы

Как выразился один из докладчиков, данная секция возникла благодаря санкциям, то есть наши компании столкнулись с тем, что даже закупленные ОСРВ остались без поддержки. Пришлось что-то придумывать по ходу дела.

Представлены были JetOS от консорциума: ГосНИАС ( докладчик Юрий Солоделов), ИСП РАН (докладчик Николай Пакулин), Digital Zone. И МОС-ОП от компании Вайс-Техника (докладчик Алексей Фролов). Работу JetOS можно было посмотреть на стенде технологий.

Ещё немного новых ОС

Было представлено ещё две новых закрытых ОС.

Валерий Егоров из компании Криптософт представил QP ОС. И заявил, что компаний разработала не только ОС, но и гипервизор, компилятор и машину .NET.

Павел Бойко из компании АстроСофт представил ОСРВ МАКС для интернета вещей. Основной фишкой этой ОСРВ, по мнению докладчика, является распределённая общая память.

Поскольку обе представленные разработки являются проприетарными, у слушателей возник, как мне показалось, скепсис. Особенно к ОСРВ МАКС, в кулуарах даже прозвучало, что это хорошая студенческая работа, но предлагать её в качестве продукта, за который берут деньги, несколько странно.

Резюме

Закончить я бы хотел словами товарища из Самсунга,

“Хорошо, что в нашей стране хоть что-то в этой области стали делать”.

|

Метки: author abondarev системное программирование программирование open source блог компании embox embox osday операционные системы конференции |

Cisco Meraki MX: настройки безопасности на периметре в 4 клика |

Для требований большинства компаний – как малых и средних, так и крупных с географически распределенной инфраструктурой – отлично подойдут шлюзы безопасности Cisco Meraki MX. Они просты в настройке, не требуют присутствия администраторов безопасности в отдаленных филиалах и вместе с тем используют те же наборы сигнатур, что и топ-решения Cisco Firepower. ,

Рассмотрим несколько основных вариантов использования Meraki MX в организации. Их можно настроить всего в 4 клика мышкой на интуитивно понятной панели Meraki Cloud без сложных настроек и командной строки.

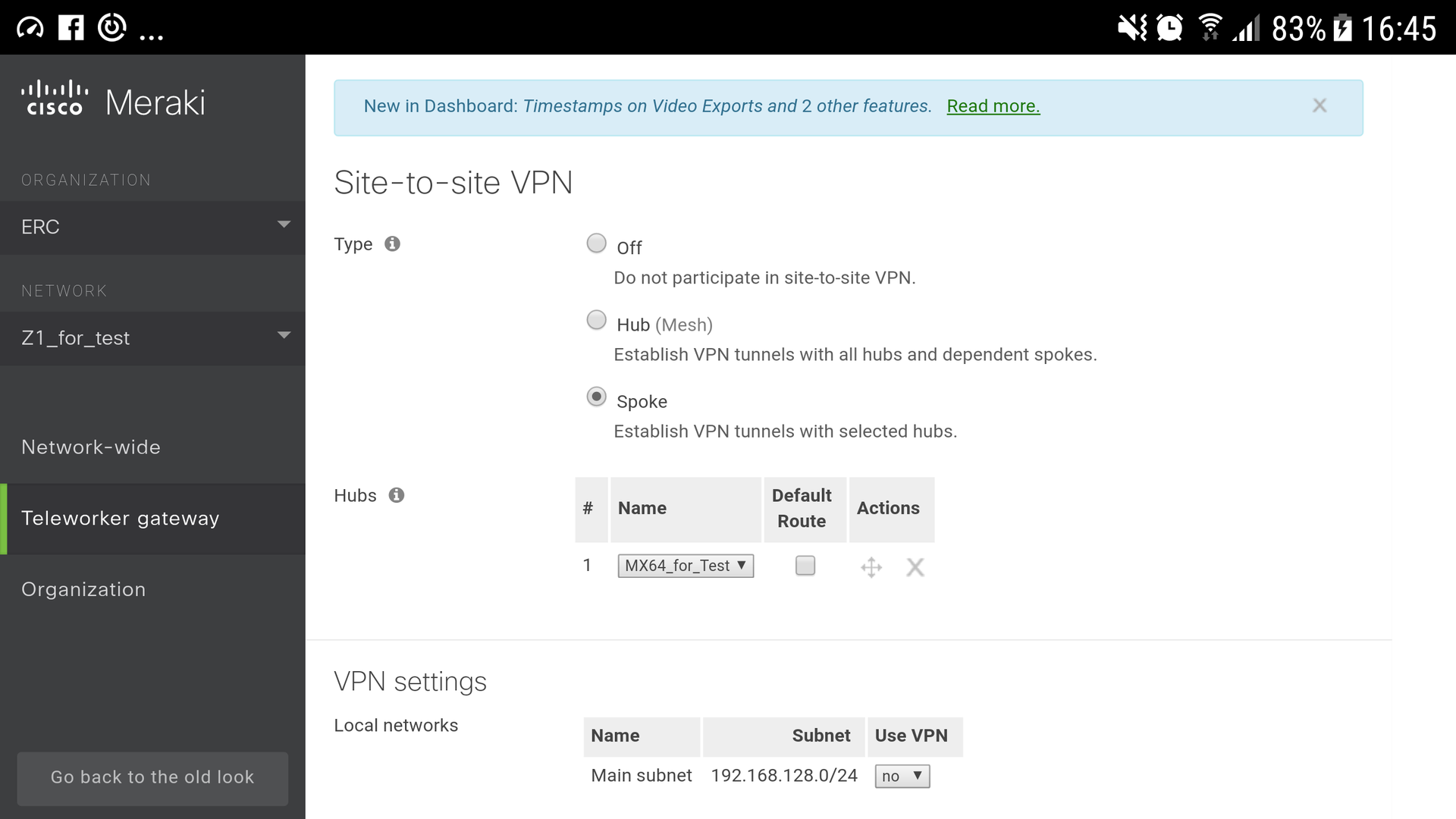

Связь с новым филиалом – AutoVPN

Один из наиболее типичных сценариев использования VPN – подключение удаленного сотрудника к корпоративной сети. Что позволяет пользователю ощутить себя как на работе и может без проблем пользоваться корпоративными сервисами. При этом не сможет просто так пронюхать, чем конкретно занят этот пользователь, какие данные он передает и получает.

Второй, не менее распространенный вариант использования схож с первым, только подключаются к корпоративной сети не отдельные пользователи, а целые офисы или здания. Цель та же — надежно и безопасно объединить географически удаленные элементы одной организации в единую сеть. При создании подобных соединений необходимо учитывать массу нюансов: метод аутентификации, протокол шифрования, сети и тип трафика, которые будут использовать туннель и многое другое.

Устройства семейства Meraki MX обладают необходимым набором инструментов для создания подобных VPN-туннелей в автоматическом режиме.

Настройка в 4 клика

1. Выбрать режим работы VPN-концентратора (в центре выбран режим Hub, так что нажимаем Spoke).

2. Для Spoke выбрать режим туннелирования Split, чтобы использовать VPN-туннель только для трафика в центральный офис, а интернет-трафик выпускать непосредственно «в свет».

3. Все подсети уже подсчитаны, необходимо только выбрать, какие могут использовать VPN (указать напротив yes/no).

4. Сохранить. Теперь облако Meraki само согласует адресацию и параметры туннелей IPsec AES128 и распространит данные о VPN-маршрутах на устройстве MX в сети (рис. 1).

Рисунок №1

Защита от угроз

Любая сеть являет собой мишень для вторжений и вредоносных атак. Подобные вторжения становятся виной утечек конфиденциальной информации, остановки критических для бизнеса приложений и даже аварийных остановок предприятий. Meraki MX оснащен продвинутыми и легконастраиваемыми инструментами для противостояния подобным угрозам. Тандем IPS на SourceFire Snort, Cisco Advanced Malware Protection и каждодневного обновление базы данных сигнатур, защитят корпоративную сеть от возможных рисков. А система ретроспективного анализа позволит предпринять меры даже в случае прохождения 0Day атак.

Настройка в 4 клика

1. Включить антивирусное сканирование (Malware prevention — enabled).

2. Включить защиту от несанкционированного доступа на базе SourceFire (Intrusion detection and prevention – выбрать Mode Prevention).

3. Выбрать из трех предустановленных наборов правил IPS от наиболее лояльного до рестриктивного (Connectivity/Balanced/Security).

4. Сохранить. Теперь вы защищены и можете просматривать аналитику (рис. 2).

Рисунок №2

Допустимое использование интернета

Система фильтрации контента дает обеспечивает безопасное использование интернета, пользователями внутри сети. Когда пользователь запрашивает какой-то URL, он проверяется в несколько этапов и может быть заблокирован к просмотру по причине наличия вредоносного или нежелательного контента.

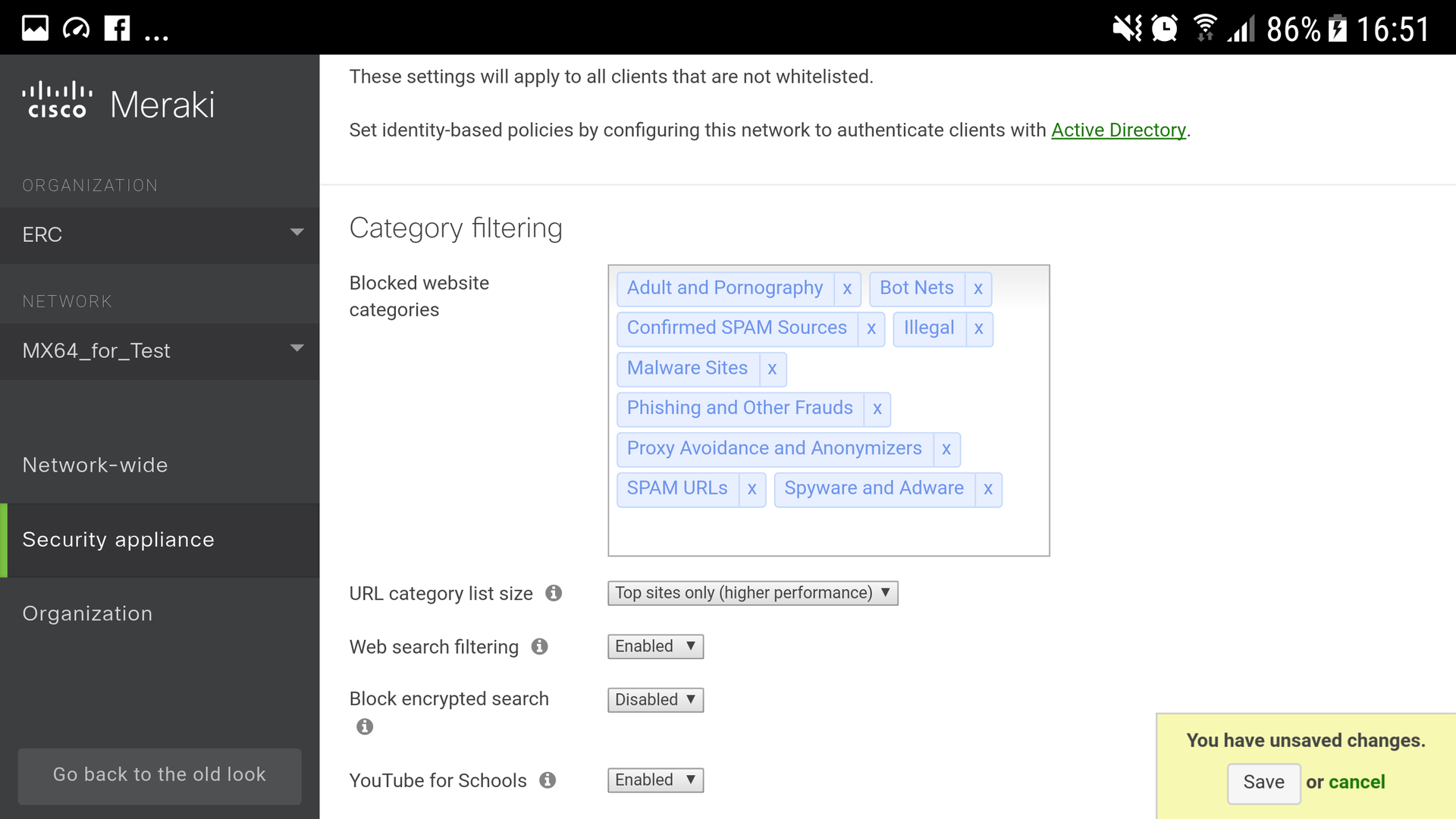

Настройка в 4 клика

1. Выбрать категории web-сайтов, которые необходимо заблокировать (рекомендуем блокировать Adult, Bot Nets, Confirmed SPAM Sources, Illegal, Malware Sites, Phishing, Proxy Avoidance, SPAM URLs, Spyware).

2. Включить фильтрацию поисковых запросов (Web search filtering – enabled).

3. Включить фильтрацию YouTube (YouTube for schools – enabled).

4. Сохранить. Теперь у сотрудников вашей компании (или учеников вашей школы) ограничен доступ к сайтам, которые непозволительно использовать на рабочем месте (рис.3).

Рисунок №3

Шейпинг и приоритезация трафика

В настоящее время вместе с планомерным увеличением скоростей передачи данных в телекоммуникациях увеличивается доля интерактивного трафика, крайне чувствительного к параметрам среды транспортировки. Поэтому задача обеспечения качества обслуживания (Quality of Service — QoS) становится все более актуальной. Нам необходимо, что бы бизнес-критические приложения имели приоритет над различными мультимедийными и не страдали от заполнения канала.

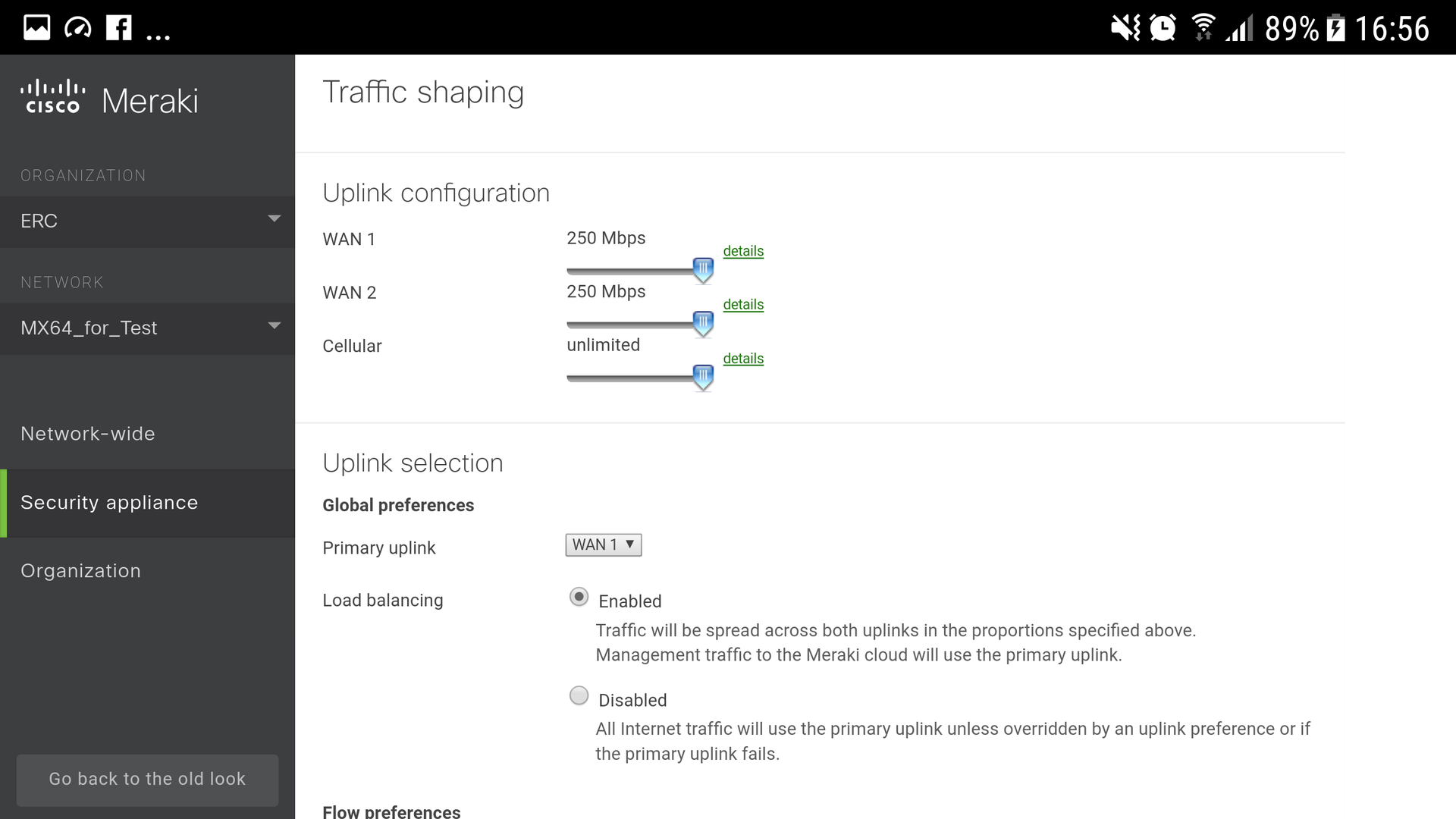

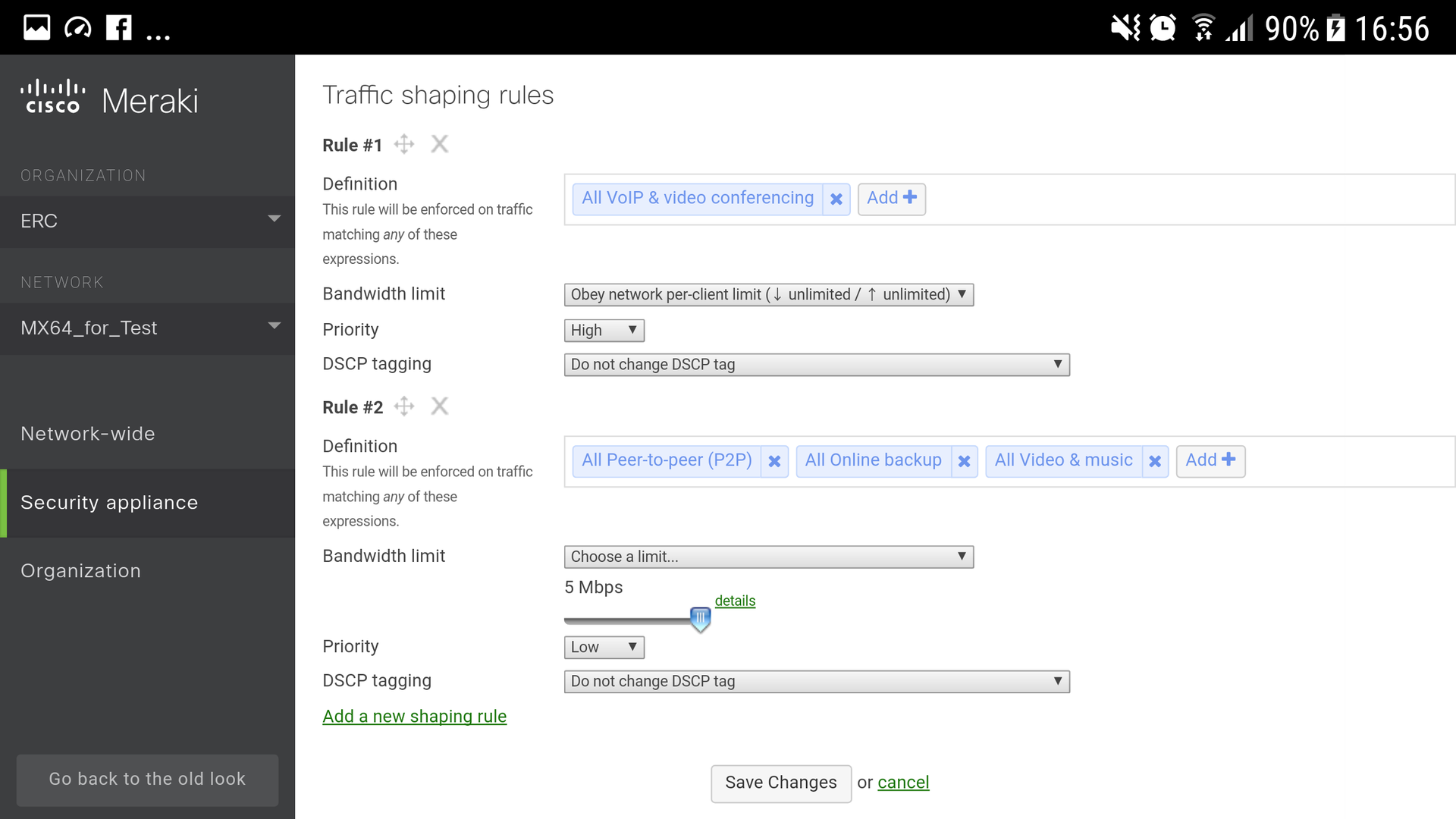

Настройка в 4 клика

1. Выбрать параметры допустимой загрузки входного и выходного трафика для обоих WAN-аплинков (у вас также есть возможность подключить 3G/4G-модем как дополнительный аплинк для обеспечения отказоустойчивости).

2. Включить уравнитель нагрузки между аплинками (Load Balancing – enabled).

3. Включить правила шейпинга трафика. Для VoIP and Videoconferencing установить приоритет High. Для категорий Peer-to-peer, Online backup, Video & Music выставить ограничение по полосе пропускания и приоритет Low.

4. С такими настройками даже в случае ограниченной пропускной способности канала ваши пользователи не заметят снижение скорости передачи данных: канал для бизнес-приложений не будет засоряться исходящим трафиком. Эти функции доступны на всех шлюзах безопасности Cisco Meraki MX, осталось лишь выбрать необходимую вам модель в зависимости от ваших нужд, наличия WiFi, PoE, специфических портов (рис. 4, 5).

Рисунок №4

Рисунок №5

В России решение Cisco Meraki в данный момент не доступно для заказа.

В Украине, Азербайджане, Грузии Cisco Meraki можно купить непосредственно у локальных партнеров Cisco.

|

|

Биометрия: не так сложно, как кажется |

Сегодня много говорят о многофакторной идентификации, как о способе качественно повысить уровень безопасности. При этом далеко не на каждом проекте рассматривают биометрические факторы, как дополнительный уровень защиты. А зря. Стоило бы! Потому что сегодня доступны надежные и достоверные способы работы с биометрической информацией, которые можно внедрить в существующую инфраструктуру без больших затрат.

При том, что системы контроля и управления доступом (СКУД) применяются сегодня в большинстве производственных компаний, государственных структур и бизнес-центров, в своей массе эти решения базируются на картах RFID старого поколения. Привычный всем пластмассовый бейдж HID Prox служит спутником сотрудников при перемещении по разным зонам, но для всех уже очевидно, что одна RFID-карта не обеспечивает надлежащего уровня безопасности, ведь ее можно украсть, потерять, забыть или просто подделать.

Да, существуют более совершенные карты, такие как многофункциональные iClass с поддержкой шифрования, и даже включающие в себя генератор случайных паролей. Вместе с сотовым телефоном они вполне могут обеспечить многофакторную идентификацию, но не отличаются теми преимуществами, которые дают биометрические методы – последние не позволяют украсть что-то у сотрудника, чтобы получить доступ. Отрубить руку, конечно, можно, но это будет уже куда более тяжкое преступление, а имитация 3Д-лица вообще пока что дело фантастических фильмов.

Именно потому, что карту можно украсть, многие компании используют методы фотоверификации. Обычно они реализованы в ручном режиме, когда сотрудник службы безопасности сверяет фотографию на документе с лицом человека, использующего данный пропуск. Но человеку требуется значительное время, чтобы проверить соответствие, да и ошибки не исключены. А по результатам исследований NIST (National Institute of Standards and Technology), текущий уровень развития алгоритмов автоматизированной фотоидентификации, вышедших из практики нейронных сетей, позволяет значительно повысить точность и свести к считанным долям секунды скорость распознавания.

Виды биометрической идентификации

Благодаря появлению доступных терминалов, биометрические технологии стали использоваться все чаще. Доказательство тому – наличие считывателей отпечатков пальцев в смартфонах. Если уж туда засунули датчик без особого удорожания устройства, для корпоративной инфраструктуры это не является проблемой. Сегодня вполне реальным выглядит создание трех типов систем биометрической идентификации:

- По отпечатку пальца – считыватель устанавливается на проходной или рядом с дверью и позволяет фиксировать вход и выход человека без каких-либо дополнительных документов

- По голосу – анализ голоса может происходить в любой точке помещения, либо от человека может потребоваться позвонить на определенный номер со своего телефона.

- По внешнему облику – полностью бесконтактный способ идентификации в результате сравнения изображения лица, полученного в видеопотоке, с хранящимся шаблоном.

Развитие данных технологий, и особенно последней, могут очень сильно изменить работу социальных объектов. Например, фотоверификация владельца единой транспортной карты с льготной стоимостью поездок позволит не пропустить через валидатор человека, которому не принадлежит карта, упростив контроль работы транспортных систем в столице и других городах. Аналогичные сценарии могут применяться на производстве и в бизнес-центрах.

Внедрять или не внедрять?

Как мы все хорошо знаем, для любого проекта актуальны технологический и организационный барьеры. Сегодня можно уверенно сказать, что с технологической точки зрения биометрические системы полностью готовы к работе в самом широком спектре применения. Но вот с организационным моментом возникают трудности.

Тем не менее, когда пользователи получают выбор, они начинают видеть и ценить преимущества биометрической идентификации. Например, в технопарке Набережных Челнов была реализована однофакторная идентификация, но с возможностью выбора – посетители могут использовать либо RFID-карту, либо отпечаток своего пальца. Наблюдая за этим проектом, мы заметили, что изначально вторым методом пользовалось лишь 5-10% посетителей, но через год соотношение оказалось 50x50. Возможно, это и есть лучший способ дать персоналу привыкнуть – предоставить ему выбор, пользоваться старой системой или новой.

Конвергентные системы

Но пока многие размышляют, как усилить многофакторную аутентификацию, технологии продолжают развиваться, и биометрия используется одновременно для систем СКУД и в информационных системах. Мы считаем, что инструменты IAM (Identity Access Management), скоро будут интегрированы со средствами обеспечения для физического доступа.

Как это будет работать? Сценариев существует достаточно много. В частности, при входе в офис можно сфотографировать себя мобильным устройством (например, средствами приложения HID Mobile), а в случае подтверждения соответствия лица, получает доступ к RFID-считывателю, чтобы приложить свою карту. Такой подход позволит вообще забыть о том, что такое бюро пропусков, одновременно увеличив безопасность доступа в разы.

Также имеется возможность настроить идентификацию по голосу для получения одноразовых паролей доступа к информационным системам. Что может быть проще – позвонить на нужный номер, повторить фразу вслед за роботом и принять код в SMS. При этом кража телефона ничего не даст – ведь авторизация происходит и по номеру, и по голосу пользователя.

Стоимость внедрения

Итак, если у вас уже есть СКУД, переход на биометрическую идентификацию, как правило, подразумевает замену считывающих устройств. Если вы задумываетесь о дактилоскопии, то вопрос решается в пределах $200 за один терминал, но зато пропадает необходимость поддерживать устаревшие пропуски и отвечать за риски безопасности.

С организационной точки зрения, посетителям нужно лишь оформить заявку заранее и согласиться на обработку персональных данных. После предоставления нужной информации прямо на сайте организации, человеку предоставляется доступ по тому биометрическому признаку, который используется в системе. Помимо датчиков считывания отпечатков пальцев можно установить видеокамеры, а если у вас уже развернута система видеонаблюдения – настроить аналитические инструменты для работы с картинкой. Таким образом, внедрение биометрии оказывается значительно проще, чем многие другие методы многофакторной аутентификации, одновременно делая жизнь сотрудников и посетителей более комфортной.

|

|

Защита от Вирусов-Шифровальшиков при помощи снепшотов |

Резервное копирование

Как в самых больших, так и в маленьких организациях рабочие файлы располагают на общедоступном файловом хранилище, чтобы все могли ими пользоваться. Централизация хранения даёт удобство для совместной работы нескольким людям над одними и теми же файлами, но это налаживает и ответственность по защите такой информации. Естественно для борьбы с вирусами-шифровальщиками необходимо регулярно выполнять резервное копирование по схеме 3-2-1. Резервные копии важно хранить отдельно от основной системы. Но полное восстановление, во-первых, может быть достаточно длительным, а во-вторых резервное копирование как не крути выполняется не каждый час, и теряется вся новая информация (большой RPO).

Снепшоты для спасения

И вот здесь становится понятно на сколько важной частью резервного копирования являются снепшоты, которые можно выполнять на много чаще нежели резервные копии на NAS хранилище и соответственно восстанавливать такие данные на много быстрее из снепшотов, таким образом существенно уменьшив значение RPO. И вот здесь становится понятно на сколько важно, чтобы такие снепшоты функционировали как часы, не тормозили работу всего хранилища, не имели архитектурных проблем по удалению и консолидации снепшотов. При этом снепшоты это не замена резервному кодированию, а отличное дополнение для полноценной стратегии резервного копирования. Так снепшоты можно выполнять достаточно часто, чтобы захватывать самые последние изменения вашей информации. Снепшоты это не полная копия данных, только разница новых данных на блочном уровне, своего рода обратный инкрементальный бэкап, который более рационально использует пространство хранилища, нежели полный бэкап. Но всё равно это пространство используется, чем больше изменений, тем больше попадает информации в снепшот. Настроенное расписания авто-удаления старых снепшотов позволит более рационально использовать ресурсы хранилища и не съесть всё доступное пространство на дорогостоящем NAS хранилище. А резервное, будет хранить на много дольше по времени копии более старых версий информации.

Как снепшоты не должны работать

Многие уже сталкивались с различными реализациями снепшотов и уже на практике знают, как снепшоты не должны работать:

- они не должны увеличивать нагрузку на дисковую подсистему просто от наличия снепшота

- они не должны увеличивать нагрузку просто от большего числа снепшотов

- они должны быстро создаваться и удалиться и этот процесс не должен влиять на производительность дисковой подсистемы

- они должны удаляться так чтобы не повредить основные данные

- им не должно быть разницы сколько данных, всё должно работать быстро, моментально и без малейшей возможности повредить информацию из-за удаления или консолидации снепшота.

Снепшоты в операционной системе ONTAP для хранилищ NetApp так не работают. Они были впервые реализованы в операционной системе ONTAP, как часть файловой системы WAFL в 1993 году, эти технологии апробированы временим и сотнями тысяч компаний по всему миру. Кстати само слово «снепшот» (Snapshot ™) является зарегистрированной торговой маркой компании NetApp, а эта технология снепшотирования запатентована. Чтобы удостовериться в том, как работают снепшоты WAFL можно бесплатно скачать на тестовый период виртуальную машину с образом хранилища ONTAP.

mysupport.netapp.com/NOW/cgi-bin/software/?product=ONTAP+Select&platform=Deploy+Install

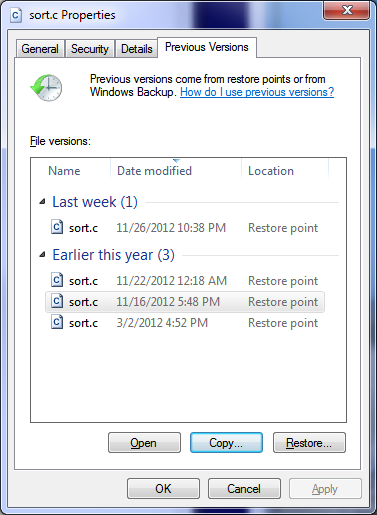

Автоматизация восстановления

Интеграция снепшотов хранилища с операционными системами позволит снять рутину с администратора хранилища по восстановлению отдельных файлов. Чтобы пользователи сами могли восстанавливать свои файлы из снепшотов прямо из своего компьютера стандартными срадствами ОС.

Репликация снепшотов

Просто удаление старых снепшотов, которые уже есть на хранилище и настроены в хорошо налаженной стратегии резервного копирования — это ужасная трата ресурсов. Ведь снепшоты можно использовать для их репликации на вторую систему хранения. Во-первых снепшоты уже есть, почему-бы их не использовать, во-вторых намного выгоднее передавать дельту нежели весь набор данных каждый раз, в третьих снепшоты работают на подобии обратных инкрементальных бэкапов, то есть не требуют времени на «склеивание в полный бэкап», в третьих снепшоты ONTAP подобны обратным инкрементальным бэкапам, но они не требуют склеивания или консолидации ни во время репликации ни во время восстановления, как это происходит с традиционными инкрементальным бэкапом или обратным инкрементальным бэкапом. Но магии не бывает, снепшоты при репликации данных всё равно вычитываются из целевой системы, чтобы быть отправленными на удалённую систему, это порождает дополнительные операции чтения во время реплики, но это на много лучше в сравнении с фулл-бэкапом, который каждый раз вычитывает заново все данные целиком.

Снепшоты как индикатор заражения Ransom

Как было сказано ранее снепшоты хранить в себе блочную дельту, разницу между предыдущим своим состоянием и между текущим, актуальным. И чем больше изменений внесено в актуальные данные, тем больше занимает снепшот. Кроме снепшотов стоит ещё упомянуть про технологии компрессии и дедупликации данных, которые позволяют сжимать оригинальные данные, экономя пространство на хранилище. Так вот некоторые данные не компрессируются и не жмутся. К примеру фото, видео или аудио данные, а какие данные ещё не жмутся? Правильно зашифрованные данные. И вот представьте вы настроили расписание снепшотов, у вас работает дедупликация и компрессия. Снепшоты снимаются, а более старые удаляются, данные жмутся, потребление пространства достаточно размеренное и стабильное. И вдруг снепшоты начинают занимать на много, на много больше нежели раньше, а дедуп и компрессия перестали показывать свою эффективность. Это и есть индикаторы молчаливой и вредоносной работы вируса-шифровальщика: ваши данные, во-первых, сильно изменяются (растут снепшоты в объёме, по сравнении юс тем как это было раньше), во-вторых дедуп и компрессия перестали давать результат (значит несжимаемая информация). Эти два косвенных показателя приводят к более не рациональному потреблению пространства на хранилище, и вы можете заметить это на графике потребления пространства, который внезапно начал геометрически расти вверх.

WORM

Технология Wright Once Read Many или WORM, таже известна и под другими названиями, к примеру SnapLock построенная на базе снепшотирования, позволяет залочить данные на длительный срок от изменений. К примеру можно хранить конфиги от разнообразных устройств, к примеру свичей, роутеров и прочее. Подобного рода файлы редко если вообще меняются в течении жизни устройства, а харнилища с поддержкой WORM надежное место для хранения фажных файлов-настроек для инфраструктуры.

Антивирусная защита NAS

Ну и конечно же возможность проверки файлов на строне хранилища тоже будет не лишней.

Вывод

Снепшоты это не замена, а важная часть стратегии резервного копирования, которая позволяют более быстро, более часто резервировать данные и быстрее их восстанавливать. Снепшоты WAFL являются базисом для репликации данных на резервную СХД, не тормозят систему, не требуют консолидации и склеивания, являются эффективным средством резервного копирования данных.

Сообщения по ошибкам в тексте прошу направлять в ЛС.

Замечания, дополнения и вопросы по статье напротив, прошу в комментарии.

|

Метки: author bbk хранилища данных хранение данных snapshot netapp ontap wafl |

Meine "Uberwachung-2: техника и технология |

Новый сервер? Автоматом

Одной из «больных» тем мониторинга является его потенциальная неполнота. В особо клинических случаях можно иметь развернутый сервер, настроенные и работающие на нем сервисы, и… узнать о каких-то проблемах на нем исключительно по факту «падения» сервиса-потребителя, потому что мониторинг знает про все это добро «ровно ничего».

Чтобы таких ситуаций не возникало, помимо служебных инструкций, мы постарались максимально использовать и технические средства контроля за ситуацией.

Когда админы разворачивают новый сервер, они подключают его в Spacewalk (бесплатный аналог Red Hat Network Satellite). Эта полезная штука разворачивает на сервере конфиги и ПО, включая все необходимое для мониторинга. В том числе устанавливает наш пакет sbis3mon-discovery-scripts – легковесную утилиту на Python, которая запускается «по крону» каждый час, сканирует сервер и отправляет данные о найденных сервисах в реестр обнаружения (Discovery Registry).

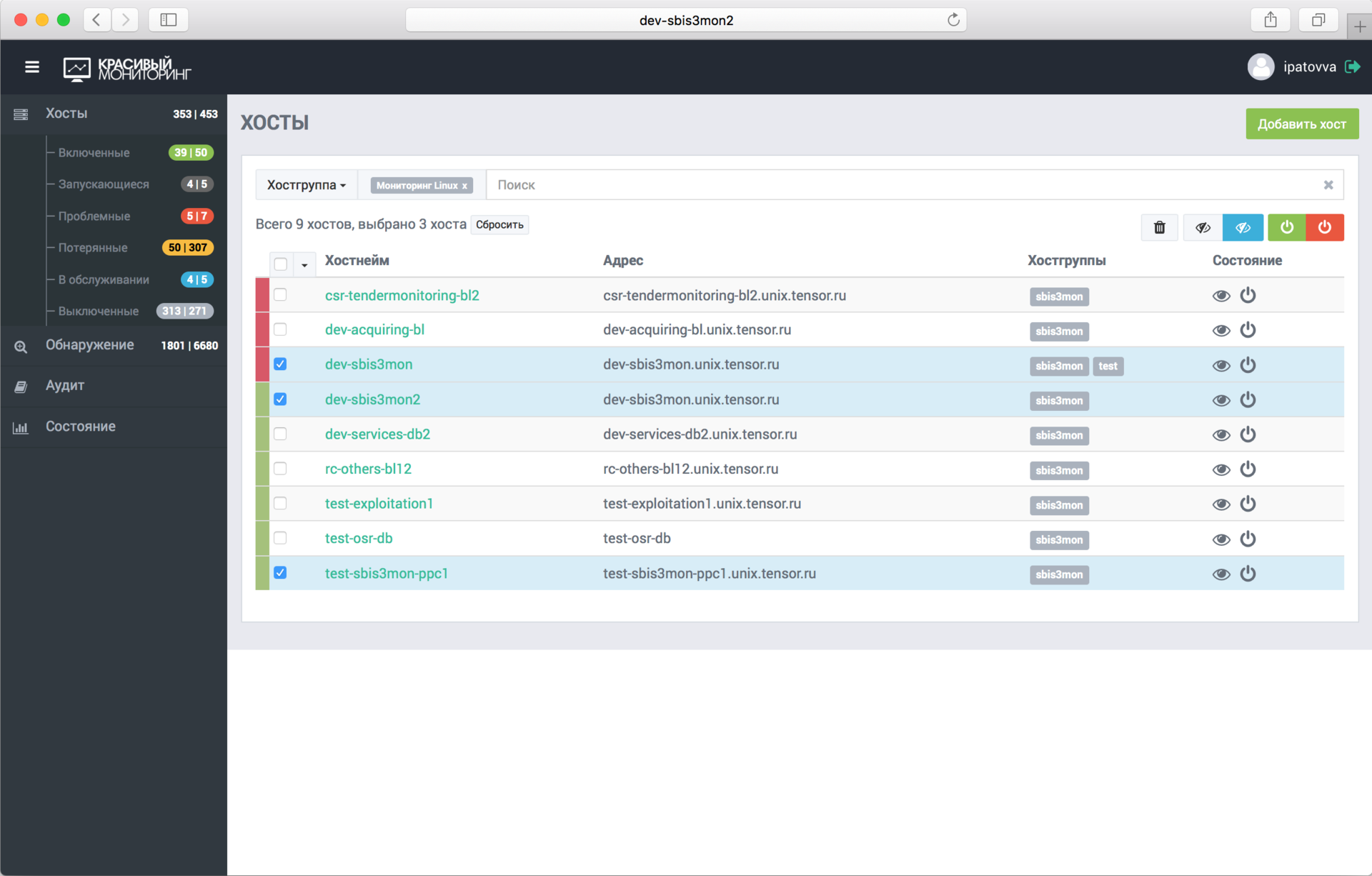

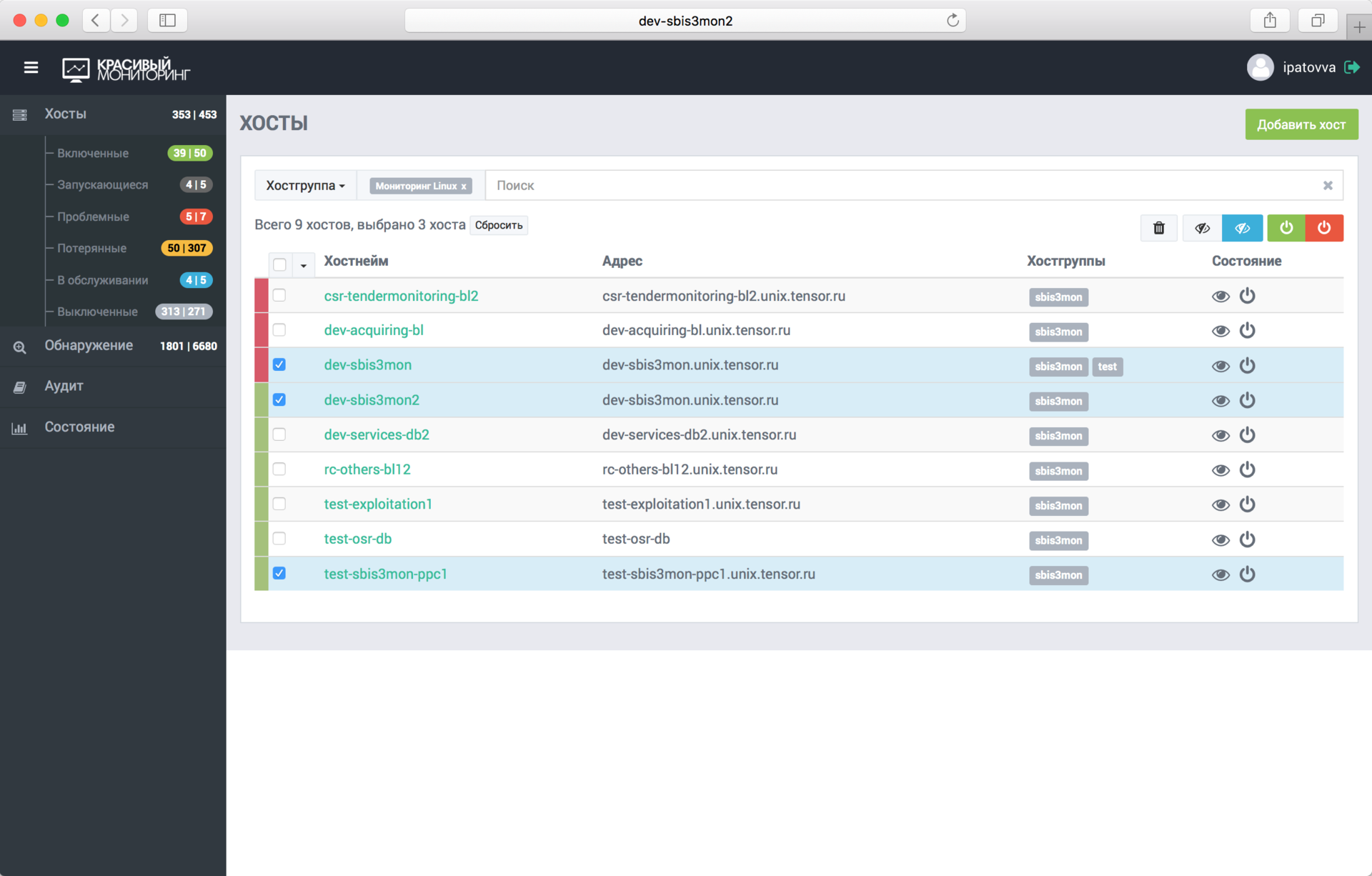

Таким образом, sbis3mon имеет возможность запрашивать из реестра данные о серверах и сервисах, которые можно мониторить. Теперь включить наблюдение за сервером и его сервисами можно в один клик, просто выбрав его из списка в админке.

Изображение кликабельно, открывается в текущей вкладке веб-браузера.

Автоматически подцепятся все найденные сервисы. Если в будущем на этом сервере будет развернут ещё какой-то сервис, он также добавится в мониторинг уже без участия админов.

Конечно же, есть возможность добавить сервер и вручную или клонированием.

Включаемся!

В тот момент, когда админ добавил сервер или подключил для наблюдения новый сервис, происходит запуск соответствующих плагинов и установка соединений управляющих транспортов:

- ssh – для сбора данных с Linux;

- postgresql – выполняет прямое подключение к базам через нативный протокол;

- redis – к redis;

- … и т.д.

В большинстве случаев это подключение – единственное устанавливаемое к сервису, и оно живёт либо до дисконнекта, либо до первой ошибки. В последнем случае попытка реконнекта происходит автоматически через заданный интервал.

Мы стараемся использовать доступные нативные интерфейсы сервисов для получения статистики. За исключением мониторинга Windows и IIS мы не используем агентов. Хотя сейчас есть идея, как избавиться и от них.

Плагин – основа конфигурации

После установки соединения плагин получает с сервиса конфигурацию: список его сущностей (список баз, перечень подмонтированных дисков, или активных сетевых интерфейсов, …).

Изображение кликабельно, открывается в текущей вкладке веб-браузера.

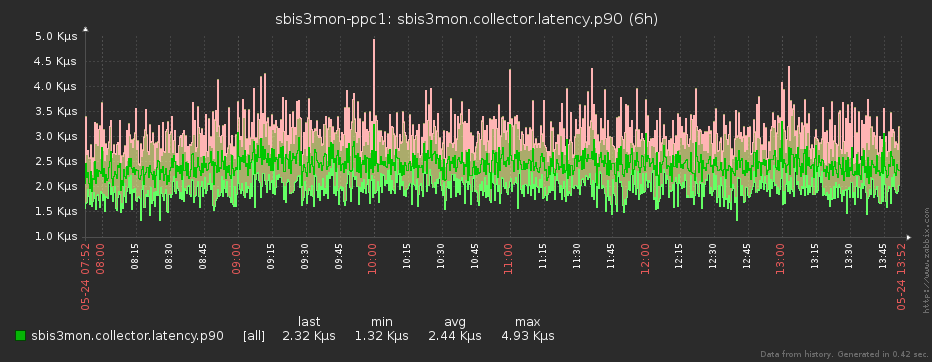

Список сущностей плагин отправляет в модуль zabbixSync, который отвечает за создание или синхронизацию в Zabbix’е «хоста» и описанных плагином структур: итемов, графиков, скринов (дашбордов) и триггеров. Да, вся визуализация и логика триггеров – тоже часть кода.

Для каждой сущности генерируется свой комплексный экран, позволяющий сразу визуально оценить наличие проблем или аномалий. Иногда также создаются сводные экраны, на которых может отражаться информация по группе сущностей – например, статистика суммарно по всем базам на конкретном инстансе PostgreSQL или загрузка CPU на каждом из юнитов бизнес-логики, обслуживающих один сервис.

В целом, у нас получилось, что на разработку, что конкретно и зачем мы хотим снимать, как это можно сделать наиболее эффективно, как все это вывести «красиво и понятно», времени тратится по каждому плагину даже больше, чем на саму реализацию сбора данных.

Изображение кликабельно, открывается в текущей вкладке веб-браузера.

Свет, камера… снова плагин!

Одновременно с синхронизацией с Zabbix через заданные интервалы начинается опрос заданных сервисов. Для каждого из соответствующих плагинов координатор формирует и отправляет на выполнение задачу.

Плагин может различным образом обрабатывать, агрегировать и преобразовывать полученную информацию, прежде чем отправить её дальше – всё зависит от заложенной в него логики.

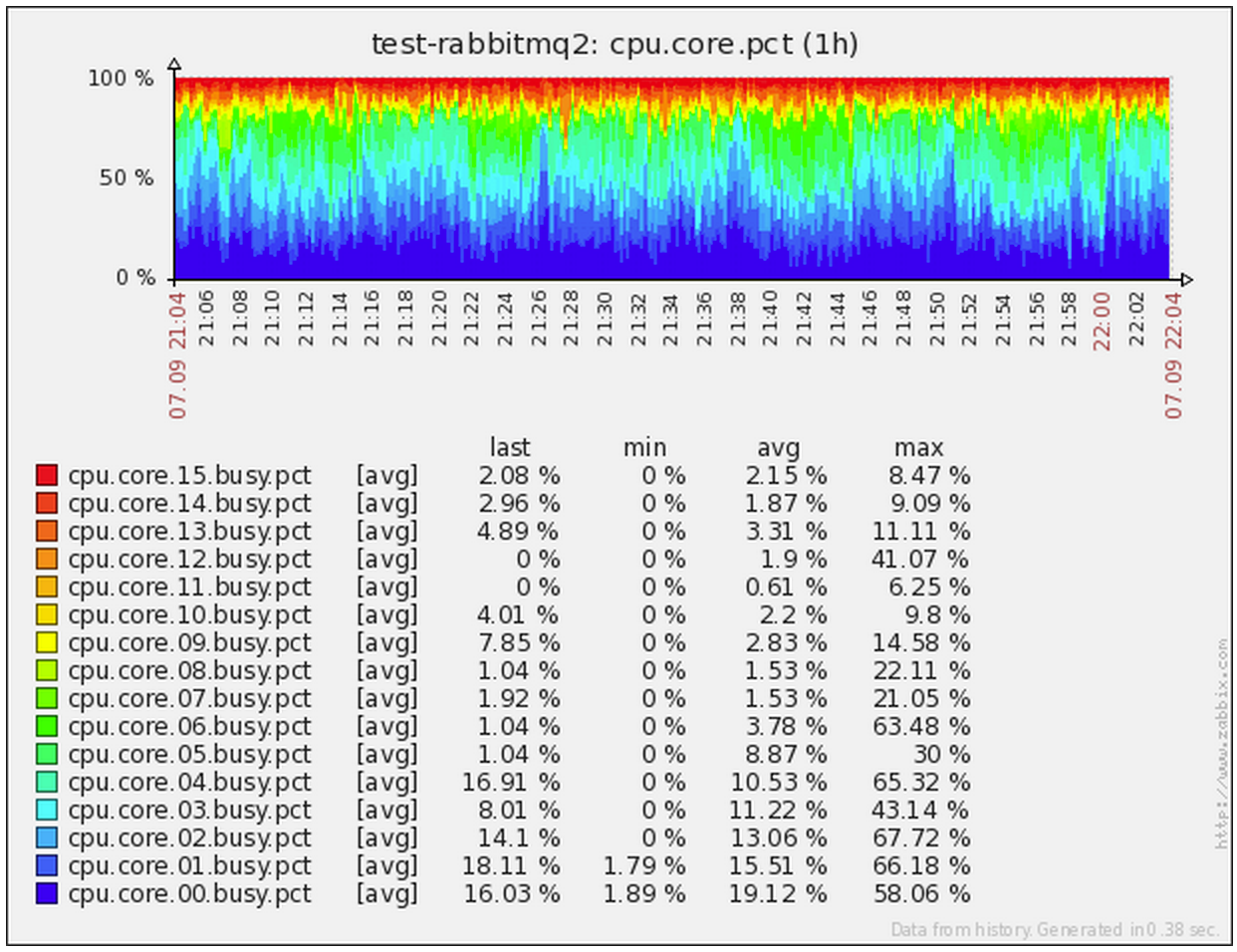

Например, плагин мониторинга linux-сервера устроен примерно следующим образом:

- при разворачивании сервера через spacewalk на него сразу «заливается» ключ sbis3mon для доступа по SSH;

- при активации мониторинга коллектор получает задачу для linux-плагина * плагин устанавливает SSH-соединение с помощью NodeJS-модуля ssh2;

- в установившейся сессии запускаем на выполнение команду, которая сама будет отдавать нам все данные с нужной частотой:

watch -n 1 cat /proc/meminfo # все, дальше парсим на приемнике

Правила съема. Метод sbis3mon

Обычно съем метрик практически в каждой системе происходит по принципу «спросил – узнал», и важно наличие самой возможности «спросить» что нужно. Когда же у вас высоконагруженная система, все меняется в корне.

Например, у нас была ситуация, когда в какой-то момент виртуальная машина, на которой жила база «под реальным highload’ом», критичным ко времени отработки каждого миллисекундного запроса, «вставала колом» на 2-3 секунды. Снимая данные по CPU раз в 15 секунд, мы просто не наблюдали этих проблем – они «проскакивали» между отсчетами.

Поэтому в особо критичных случаях мы считываем данные даже с минимальным квантом в 1 секунду. За счёт чего не пропускаем проблемы, которые возникали между соседними съёмами при меньшей частоте.

Мы стараемся сводить нагрузку на целевые серверы к минимуму, поэтому парсинг ответов проводим уже на стороне коллектора мониторинга. При этом за один запрос мы получаем сразу максимум необходимых данных, что также даёт синхронность метрик во времени. Но главное не заставлять целевую систему делать лишнего, что на самом деле не требуется.

Например, изначально мониторинг состояния и количества сетевых соединений у нас был реализован через netstat. И все было хорошо, пока не начали появляться серверы с десятками и сотнями тысяч активных соединений – диспетчеры на Nginx, шина сообщений на RabbitMQ, … В какой-то момент мы увидели, что выполнение команды «для мониторинга» просаживает CPU в разы относительно прикладной нагрузки! Пришлось срочно переделывать съем данных через ss.

«А вместо сердца – пламенный мотор!»

В качестве ядра нашей системы мы выбрали NodeJS – и это неспроста. Кроме легкости разработки, активного сообщества и большой библиотеки модулей на все случаи жизни, у нее есть большой и жирный плюс в виде асинхронности «из коробки», идеально подходящей к нашим задачам.

Из описания нашей методики съема данных видно, что большую часть времени каждый плагин «ничего не делает», ожидая поступления новой порции данных от источника в активном соединении. Получается, что в рамках одного процесса мы можем одновременно эффективно обслуживать большое количество таких подключений. И асинхронность ядра позволяет нам делать это легко и удобно!

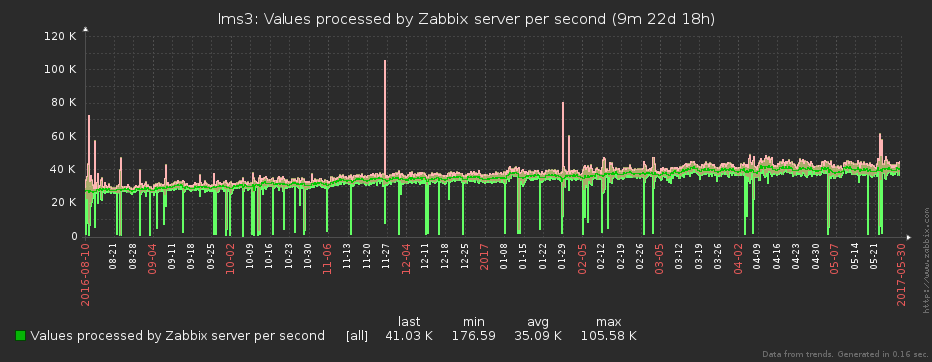

Конечно, чтобы не перегрузить eventloop процесса коллектора, мы его тоже постоянно мониторим (примерно как в этой статье), и перераспределяем задачи в соответствии с нагрузкой.

Изображение кликабельно, открывается в текущей вкладке веб-браузера.

Компрессия данных

В конечном счёте, полученные данные отправляются дальше – в модуль аппроксимации.

Понятно, что даже если мы снимаем данные посекундно, то ни Zabbix’у, ни смотрящему в него человеку, счастья от такой частоты нет совсем. Один «ляжет» под нагрузкой (мы ведь помним, что данные снимаются с нескольких тысяч серверов), у другого «вытекут глаза» от чехарды на графике.

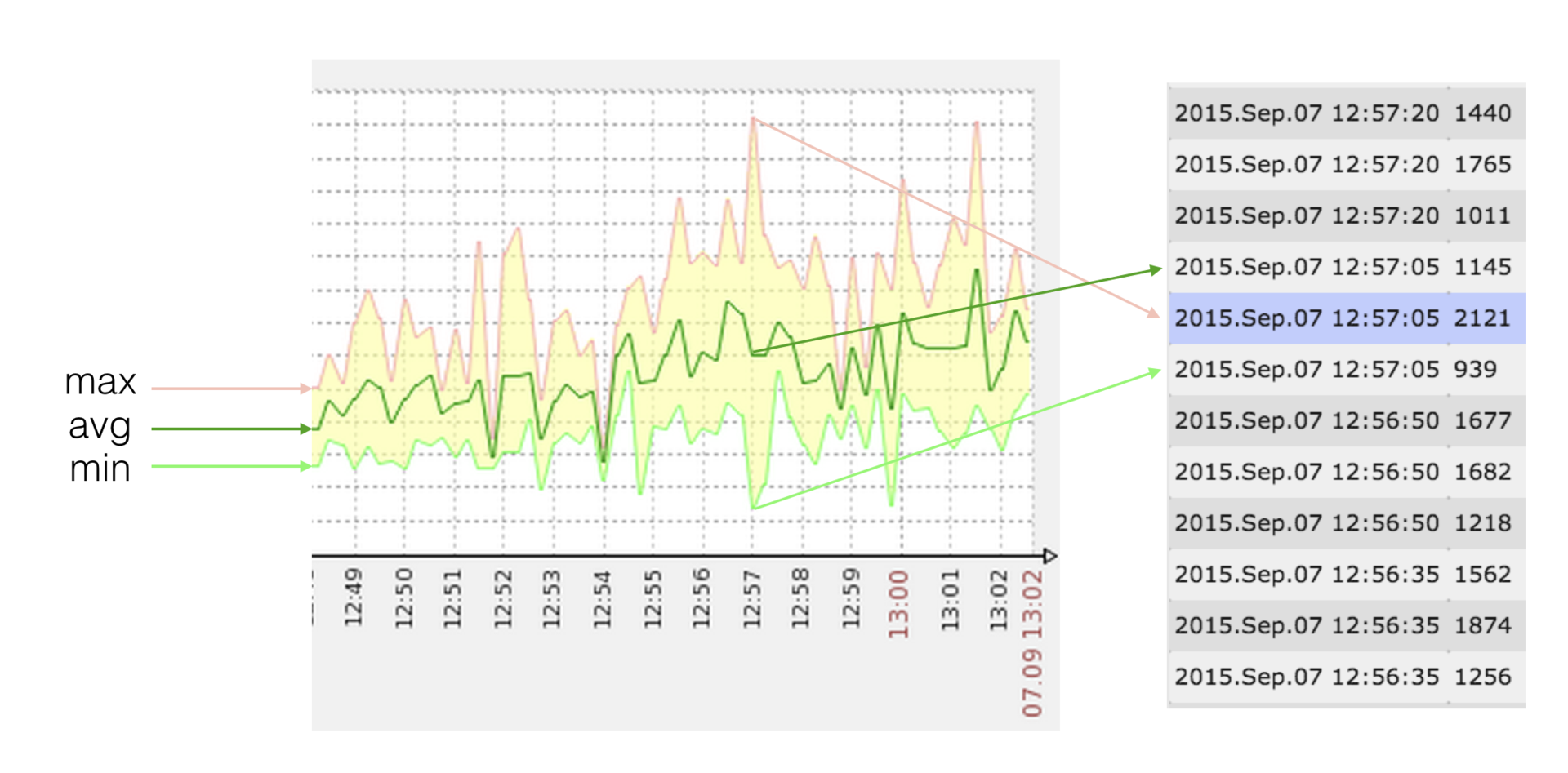

Чтобы всем было полегче, перед отправкой в Zabbix мы «сжимаем» полученный массив исходных отсчетов до интервала, заданного в плагине для конкретной метрики. Но это не просто усреднение значения – с ним мы безвозвратно потеряли бы информацию о максимумах и минимумах на интервале. Все несколько хитрее.

Поскольку на своих графиках Zabbix позволяет отображать min/max/avg-значения метрики, а значений в каждой точке (timestamp) может быть одновременно несколько, то этим мы и воспользовались.

Изображение кликабельно, открывается в текущей вкладке веб-браузера.

Допустим, у нас есть достаточно редко изменяющаяся метрика (объем занятого места на диске), которую мы снимаем поминутно, а видеть хотим одно значение в час:

[12345,12345,…,12345] -> {min = 12345, avg = 12345, max = 12345} -> zabbix = [12345]

в этом случае нам достаточно всего одного значения в точке

Теперь возьмем загрузку CPU, которую снимаем посекундно, а видеть новые точки хотим лишь раз в 10 секунд:

[10,20,30,40,50,50,40,30,20,10] -> {min = 10, avg = 30, max = 50} -> zabbix = [10,30,50]

в этом случае нам достаточно всего 3 значений вместо 10 исходных

В чем же сложность?

Мы должны послать в Zabbix такой набор значений, что {min,max,avg}(zabbix) = {min,max,avg}(source). Если с min/max все просто и понятно, то «целевую» avg приходится иногда «подбирать» как решение уравнения:

(A * min + B * max + q) / (A + B + 1) = avg

где A,B – целые; min <= q <= max

Инициализируем массив результата:

[10,10,30,10,50,10,40,10,20,10] -> {min = 10, avg = 20, max = 50} -> zabbix = [10,50,…], -> .push(min)

-> zabbix = [10,50,10,…], -> .push(min)

-> zabbix = [10,50,10,10]

в этом случае нам понадобилось уже 4 значения, но все равно не 10

Таким образом, мы не пропустим сильное отклонение величины от среднего, раз можем повесить триггер на max или min, а график от avg визуально будет выглядеть так же, как если бы мы отправляли «сырые» данные.

Пока существующее решение уже позволяет нам значительно экономить дисковые ресурсы и снизить нагрузку на СХД и сам Zabbix, мы пытаемся придумать, как здесь можно применить какой-либо алгоритм потоковой аппроксимации. Если есть идеи – делитесь в комментариях.

Оптимизация отправки метрик

Многие еще из первой части статьи уже догадались, что все наши метрики имеют тип trapper, раз данные для них мы собираем и отправляем сами через протокол zabbix sender.

Чтобы уменьшить «непрофильную» нагрузку (открытие соединения, запуск парсера, …) при обработке принимаемых значений, мы группируем отсчеты в пакеты – по таймеру, чтобы не допустить сильного отставания от realtime, и по количеству (примерно по 1000), чтобы не «заткнуть» trapper-процесс обработкой надолго.

Поскольку в рамках одного nodejs-процесса у нас активно сразу много поставляющих данные плагинов, их данные очень удобно пакетируются и отправляются одним потоком. Получается, что и количество независимых «отправителей», дергающих zabbix, у нас тоже достаточно мало.

Благодаря использованию такой схемы, мы уже давно забыли, что такое nodata-«дыры» на графиках, вызванные перегрузкой Zabbix – ведь для этого должны оказаться заняты все трапперы.

Масштабирование и отказоустойчивость

При подключении к кластеру сбора нового коллектора или при выходе из него (штатно или в результате аварии), задачи автоматически перераспределяются мастер-процессом в соответствии с заданными «весами» инстансов.

Мастер никак не работает с тем трафиком, который принимают или генерируют коллекторы поэтому нет никаких потерь на «бутылочном горлышке» или разрыва в выполнении активных задач при сбое самого координатора. В результате, мы получили эффект «настоящего» линейного масштабирования.

Сейчас у нас работает всего 2 инстанса сбора с загрузкой около 25%.

«Сделай мне красиво!»

При использовании в качестве ядра NodeJS становится очень удобно разрабатывать эффективный фронтенд на «хипстерских» инструментах: React+Redux, ES6, Babel, Webpack, …

Мы любим наших пользователей, поэтому стараемся сделать процесс их работы с системой максимально простым и удобным. Ведь если взаимодействовать с системой тяжело, то усиливается роль человеческого фактора, возрастает вероятность допустить ошибку.

Ошибки мы не любим и поэтому сделали некоторые полезные фишки:

- массовые операции;

- клонирование хостов;

- автодополнение по мере ввода, где это возможно;

- различные фильтры;

- realtime-статусы;

- …

Изображение кликабельно, открывается в текущей вкладке веб-браузера.

Через админку пользователи добавляют и удаляют хосты и сервисы, выводят их на обслуживание (когда данные продолжают идти, а алерты отключаются). Сюда выводятся все ошибки мониторинга (неверные реквизиты доступа, невозможность «достучаться» до сервера, …). Здесь же есть аудитлог (аналогичный Zabbix’у), в который записываются все действия пользователей, что бывает полезно при разборах полётов.

Фактически, админка самого Zabbix используется у нас уже только в каких-то нетипичных ситуациях, но не в оперативной работе.

Результаты

Таким образом, с помощью sbis3mon мы решили многие наболевшие проблемы, при этом, не травмировав пользователей и сохранив привычный для них Zabbix.

Теперь мы можем мониторить огромное количество хостов и сервисов. Большая часть работы автоматизирована. Мы получили в свои руки довольно гибкий инструмент, который хорошо зарекомендовал себя в работе и помогает отлавливать большинство известных (и не очень) нам проблем.

Чтобы сделать представление о системе более ясным, прикладываю ссылку на запись семинара 2015 года. С тех пор многое изменилось, но суть осталась.

Забегая вперёд

Сейчас мы работаем над тем, чтобы сделать систему более гибкой, не завязанной на нашу инфраструктуру, регламенты и привычки, и поделиться ей с сообществом, выложив в открытый доступ.

Следите за новостями в нашем блоге. До скорых встреч!

Авторы: kilor (Кирилл Боровиков) и vadim_ipatov (Вадим Ипатов)

|

|

Как выбрать тот самый PHP-фреймворк. Сравнительное тестирование |

|

Метки: author NIX_Solutions разработка веб-сайтов программирование php блог компании nix solutions выбор php-фреймворка php- фреймворк |

Dumb ways to die, или отчего “падают” дата-центры |

Эксплуатация дата-центра, серверной чем-то напоминает езду по автомобильной дороге. Когда дорога пустая, то можно рискнуть и ездить против правил, и ничего страшного не случится. Но как только на дороге появляется много машин, любой неверный маневр, незамеченная яма или колдобина могут привести к аварии. Похожая ситуация с дата-центрами и серверными: чем больше загруженность, тем выше цена ошибки.

Сегодня расскажу про ошибки в проектировании, строительстве и эксплуатации, из-за которых в дата-центре может произойти авария.

Ошибки на этапе проектирования и строительства

У меня была отдельная статья на тему ошибок в проектировании. Там в основном перечислены моменты, которые сделают эксплуатацию дата-центра неудобной, теперь же расскажу о том, из-за чего будет действительно больно.

В проекте не предусмотрены целые системы. Некоторые считают, что ЦОД вполне может обойтись без системы гарантированного питания. т. е. ДГУ. Как-то один из заказчиков, для которого я делал аудит проекта дата-центра, спросил, какой будет уровень отказоустойчивости по Uptime без ДГУ. Я не нашел ничего лучшего, чем назвать Tier 0.

Многие воспринимают ДГУ как резерв, которым можно пренебречь при необходимости, – запасное же. В действительности относиться к нему стоит как к основному, потому что только этим видом энергоснабжения мы можем полностью управлять.

Единая точка отказа. Здесь возможны варианты:

- резервирования нет вообще. Тогда поломка или плановое обслуживание будет означать полную потерю элемента системы.

- резервирование выборочное. Этот вариант весьма условно можно назвать надежным, так как уровень резервирования системы все равно будет считаться по минимально зарезервированному элементу. Например, у вас продублированы лучи питания, ДГУ, распределительные щиты, PDU в стойке, а ИБП – нет. Если этот ИБП откажет, то все, что было в цепочке после него, уже не спасет.

Ошибка в расчетах. Вот топ самых чувствительных просчетов в системе распределения энергоснабжения:

- неправильная селективность. Селективность защищает от перегрузок и коротких замыканий. Для соблюдения селективности номинал автоматов от источника питания к потребителю должен уменьшаться. Если замкнет компрессор в кондиционере, то отключится автомат внутри кондиционера, а не тот, что стоит в распределительном щите.

- Если селективность не соблюдается, то автомат не выполнит своих защитных функций, и неисправность пойдет выше по цепи. Так из-за перегруза или короткого замыкания при неправильной селективности в машинном зале можно потерять целый луч питания.

- несоответствие сечения кабеля и мощности автомата. Если номинал автомата не соответствует сечению кабеля, то при превышении нагрузки автомат не выбьет, а вот кабель начнет перегреваться или – хуже – плавиться. Выбирайте автоматы и кабели в соответствии с таблицей для расчета сечения кабеля, тока и мощности.

- нет резерва по мощности. Проектирование внатяг – плохая практика. Оборудование стало потреблять больше, чем вы рассчитывали по проекту, понадобилось подключить дополнительное оборудование, потери на линии питания из-за длины трасс – все это можно пережить, если вы добавите 30% резерва к проектной мощности.

- не учтены пусковые токи. Оборудование, имеющее на борту электродвигатели, насосы или компрессоры, при запуске дает бОльшую нагрузку на сеть, чем в процессе работы. Если не предусмотреть этого в проекте, то вы не сможете одномоментно запустить несколько кондиционеров или чиллеров. Система не справится с нагрузкой, и автоматы отключатся.

- не учтены токи заряда аккумуляторных батарей (АКБ). ИБП отдает порядка 10% своей мощности на подзаряд АКБ. Если не учитываем эту дополнительную нагрузку, то ИБП не смогут перейти с питания от батарей на “город”: каждый раз, когда ИБП будет возвращаться на городское электроснабжение и начинать подзаряжать АКБ, автоматы будет выбивать.

- неправильная прокладка кабелей в гильзах между помещениями. Не совсем про расчеты, но тоже к строительству. Тут два момента:

1. Все фазы (l1, l2, l3) нужно прокладывать в одной гильзе с нейтралью, иначе кабели начинают перегреваться.

2. Когда используется несколько одножильных кабелей (за одну фазу используется несколько кабелей), проследите, чтобы кабели на лотках лежали в правильной последовательности (см. соответствующий раздел в ПУЭ). Не нужно их перекручивать, заплетать в косы для красоты, если не хотите, чтобы это все перегревалось.

Теперь по холодоснабжению: