Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Из песочницы] Действия при приходе на работу — прием дел, актуализация, документирование, аудит |

Если у вас в организации процессы не построены — то этот текст для вас бесполезен. Если построены — то тоже бесполезен. Почти Rifleman's Creed — Without me, my rifle is useless. Without my rifle, I am useless.

Каких-то стандартных пакетов управления всей архитектурой и техникой я не видел — что не удивительно, учитывая постоянное расхождение отчетности по бухгалтерии и техники по факту и общую сложность систем. Хорошо если ведется схема сети, учет паролей и прочее необходимое, есть какой-то учет что когда (сертификаты, оплата домена) истекает, но порой этого нет. Просто одни забыли спросить, другие не волновались насчет этого. У третьих оно было, но они уже уволились, а четвертые забили, вот и имеем что имеем.

Управление жизненным циклом, SCOM/SCSM — это немного другое, а ITIL

Service Asset and Configuration Management — это благие пожелания, не содержащие некий функционал.

Соответственно, первым делом при приходе на работу нужен аудит «для себя»

— Какие устройства где стоят, за что отвечают, есть ли к ним доступ (к web панели управления/ssh/ilo), если нет — то как его восстановить. Живы ли эти устройства, или стоят для учета.

— Кто ответственный за СКУД, общую безопасность, электричество, кондиционирование (обслуживание), водопроводы, пожарную сигнализацию. Когда последний раз проводилось обслуживание тех же кондиционеров. Какова надежность (запас мощности) кондиционеров (N+0, N+1).

— ИБП и батареи. Сколько держат (в часах), когда менялись батареи, когда была калибровка, есть ли извещение о срабатывании и прочем блекауте. Какова надежность (запас мощности) ИБП — (N+0, N+1).

— Как выстроено взаимодействие с соседними отделами и бизнесом как заказчиком сервисов.

— Как работает сервис деск.

— Как работает мониторинг, мониторит ли он все устройства и необходимые параметры оборудования. Возможно что давно умер или избыточен. Или недостаточен.

— Как работает извещение о сбоях, особенно крупных — например, общий блекаут/отключение электричества, протечка водопровода / отопления.

Архивация и восстановление

Надо проверять все — что куда бекапится, какова глубина хранения, есть ли свободное место на системе хранения архивов, мониторится ли свободное место, попадает ли бекап в окно резервного копирования. Как идет восстановление — как выглядит процедура восстановления и вообще восстанавливается ли.

От имени какой УЗ идет архивация (особенно в случае агентов/сервиса бекапа в машинах), не многовато ли у нее прав (в каких группах состоит), есть ли у нее (и от нее) пароль и не стоит ли его сменить. Где она (в системе резервного копирования) прописана.

Есть ли регламент, в котором прописано и утверждено все вышеперечисленное.

Контроль прав, контроль служебных УЗ (учетных записей)

Кроме простой проверки «кто в группе доменных администраторов и почему», необходим контроль служебных УЗ. В том числе контроль какой сервис от какого имени стартует (если не стартует от системы), что со встроенными УЗ, что в какую группу включено и зачем, какие им (группам) делегированы права и куда.

AD

Роли AD — где (на каких серверах) лежат, что в журналах. Кто за какие сетевые сервисы (DHCP, DNS) отвечает. Аудит — есть ли, как устроен. Пересылка логов — каких, куда, и что там с ними происходит.

Готовьтесь изучать новый для вас предмет — инженерная археология / Конструкторско-технологическая археология (1)

Типовые дыры и костыли кривокурих админов локалхоста. Начиная от правленных host

ВНЕЗАПНО для меня выяснилось, что админы локалхоста не только правят файлы etc/host (ну ладно, кто не правил в детстве?), но еще этим и гордятся, и пишут об этом статьи.

Впрочем, с настройками DNS на DC бывает тот же стыд.

Не, ну как можно не прочитать технет?? (2)

ЗАПОМНИТЕ, ГРАЖДАНЕ!

Писать в \host\etc в продакшене надо тогда и только тогда, когда ты уже прочитал инструкцию, для Оракла и Veritas netbackup, дожав инструкциями по Veeam.

Вторая очередь проверки

По приходу на работу, кроме аудита физики (начиная от кондиционеров и срока жизни батарей в ИБП и времени работы ИБП от батарей, заканчивая что и как числится по учету — и что из этого есть по факту) — надо проверять три вещи:

— Задачи в Tash scheduler и автозагрузке по серверам

— файлы HOST в частности и настройки DHCP и DNS в целом

— кому, как, куда и какие даны права в AD и Exchange.

Если с первым пунктом понятно, скачиваем Sysinternals Autoruns for Windows и поехали, то с вторым и третьим пунктом все сложней.

Внезапно для многих, в Microsoft Windows server нет кнопки «сделать хорошо». Даже скрипта makegood.ps1 нет — MS WS и AD как сервис не имеет каких-то встроенных готовых графических решений для отображения кому и куда делегированы права в AD, а использование powershell огорчает инфобезопасника и любителя GUI.

С другой стороны, необходимый инструментарий для этого есть —

Для просмотра делегирования прав по organizational unit (OU) — Active Directory OU Permissions Report:

This script generates a report of all Active Directory OU permissions in the domain. I would advise all Active Directory shops to review this report on a quarterly basis to make sure there are no surprise administrators lurking in your domain.

Лежит традиционно на технете.

Для просмотра раздачи прав Exchanhe вот — на том же технете

RBAC Role Group Membership Reporting

This PowerShell script will generate a report of the Role Based Access Control (RBAC) role groups in an Exchange Server organization.

Для начала аудита всего вышеперечисленного должно хватить, но до его проведения переходить к чтению документов «как сделать хорошо» не стоит, потому что скорее всего придется много раз хвататься за голову.

Ссылки:

(1)

Индустриальная археология «Мценского уезда». Часть 1.

Индустриальная археология «Мценского уезда». Часть 2.

Корпоративная память и обратная контрабанда.

Копия этой же статьи со ссылками.

Оригинал в web.archive

Конструкторско-технологическая археология

(2)

Ссылка 1

Ссылка 2

или

Ссылка 3

и наконец собственно:

DNS: DNS servers on should include the loopback address, but not as the first entry

Impact

If the loopback IP address is the first entry in the list of DNS servers, Active Directory might be unable to find its replication partners. См. по ссылке

Вообще с доступностью первого DNS для CSV есть много интересного, но о этом может быть будет позже.

|

Метки: author Scif_yar it- инфраструктура системное администрирование windows |

Какие языки наиболее востребованы в сфере финансов: мнения рекрутеров с Уолл-стрит |

Специалисты портала Efinancial Careers попросили рекрутеров инвесткомпаний рассказать им о том, какие языки программирования являются сейчас наиболее востребованными Уолл-стрит. В нашем блоге — адаптированная версия этой заметки.

Java

Java — это наиболее востребованный язык программирования на Уолл-стрит в течение долгих лет.

«Специалисты по Java нужны для выполнения разных задач: от разработки систем высокочастотной торговли и управления заявками до создания собственных платформ риск-менеджмента финансовых компаний», — говорит Джаред Батлер, глава финансово-технологического рекрутинга для Северной Америки в Selby Jennings. Язык Java также хорош для проведения симуляций и моделирования работы торговых стратегий, считает Джон Рид, старший исполнительный директор Robert Half Technology.

Кроме того, распространению Java и JavaScript в финансовом секторе способствует тренд на создание простых в использовании, быстрых и защищенных сайтов — так считает вице-президент Jay Gaines & Company Джина Шиллер.

Повышенный интерес компаний финансового сектора к Java-разработчикам связан с жесткой нехваткой квалифицированных специалистов этого профиля. «В конце прошлого года в нашей базе было только семь кандидатов на каждую должность, этот показатель гораздо ниже, чем в случае других языков программирования». Также Рид сказал о том, что разработчики Java могут требовать зарплату, которая на 10% выше по сравнению с другими специалистами на рынке.

Python

Этот язык программирования прошел долгий путь до того, как был впервые использован в программе Quartz Банка Америки и в системе Athena от J.P. Morgan. Python просто незаменим при создании аналитических инструментов и квантовых моделей, которые являются, по мнению Шиллер, важнейшими средствами, способствующими созданию эффективных торговых стратегий инвестиционных банков и хедж-фондов.

Кроме того, «Python применяется все больше из-за своей простоты, в отличие от традиционных языков», — говорит Батлер, который привел ряд аргументов, почему этот язык может вытеснить вышеупомянутые Java и JavaScript в деятельности инвестиционных банков.

«Программисты могут сделать при помощи десяти строк кода Python то же самое, что и двадцатью строчками С++, с гораздо меньшей вероятностью ошибки», — убежден рекрутер.

Банки Merrill Lynch и J.P. Morgan нанимают огромное количество Python-разработчиков. «Bank of America и J.P. Morgan построили большинство своих трейдинговых систем на Python и продолжают привлекать специалистов данного профиля. Другие банки и инвесткомпании начинают обращать больше внимания на Python-программистов», — сказал Ник Вермайер, главный технический рекрутер Pencom Systems.

C++/C#

«С++ остается популярным языком программирования в высокочастотной торговле хотя бы потому, что это наиболее эффективный инструмент для создания хорошо оптимизированных систем бэктестинга и торговых движком для обработки большого объема данных», — говорит Батлер.

Шиллер согласилась с этими словами, но также добавила, что С++ часто используется еще и для создания приложений, работающих с устаревшими банковскими системами. «Из-за высоких затрат на внедрение новых технологий по-прежнему сохраняется спрос на специалистов, способных работать со старыми системами», — сказала она.

Как и Java, С# может использоваться для решения разных задач, в том числе и для создания финансовых моделей. Этот язык находится на втором месте по степени «дефицитности» квалифицированных специалистов, что дает им привилегию и возможность получения большей заработной платы. Рид сказал, что разработчики С# могут получать на 9-10% больше денег относительно своих коллег-экспертов в других языках.

«С# все еще используется, часто квантами и при разработке быстродействующих торговых систем», — поясняет Кристиан Гловер Уилсон, вице-президент технологий и стратегии в Tigerspik.

Другие языки

Под другими языками программирования в этом материале имеются в виду SQL, PHP и ETL.

«Мы видим, что инвесткомпании нанимают и специалистов, обладающих разными навыками, от знания более старых технологий ETL, таких как Informatica, и до более современных инструментов для работы с большими данными, вроде Hadoop, HBase, HDFS, MapReduce, Pig, Hive, Impala, Flume», — говорит Батлер. «Технологии ETL по-прежнему важны для хранения данных, а также для хранения крупных финансовых массивов информации, используемых, в частности, инвестиционными банками в глобальных масштабах».

С другой стороны, спрос на Microsoft Windows Presentation Foundation (WPF) снижается, а HTML5, вместе с Hadoop, Cassandra и Scala, становятся более востребованными на Уолл-стрит…

«Популярность технологий для обработке данных, такие как Hadoop, Cassandra и Scala растет, мы видим, что все больше и больше финансовых организаций внедряют их», — сказал Вермейр. «C++ и C#, как правило становятся основными средствами разработки, интерес к работе с WPF ослабевает, а к использованию HTML5 — растет».

Вермайер поддержал эту позицию: «Мы также наблюдаем рост спроса на технологии по передаче крупных массивов данных, поскольку компании ежедневно сталкиваются с огромными объемами информации. Очень часто они необходимы в качестве сопутствующих технологий в дополнение к основным языкам программирования, таким как Java или Python. Наиболее востребованными крупными технологиями по работе с данными являются Cassandra, Spark и Hadoop».

Другие материалы по теме финансов и фондового рынка от ITinvest:

- Образовательные ресурсы ITinvest

- Аналитика и обзоры рынка

- Инфраструктура и торговые роботы: Какие языки программирования используются в сфере финансов

- Что должен уметь программист, чтобы получить работу в сфере финансов

- Использование FPGA и языка DSL для ускорения HFT-торговли

- Каким может быть стек технологий для высокочастотного трейдинга

|

Метки: author itinvest программирование блог компании itinvest языки программирования биржа финансы торговые роботы |

[Из песочницы] Flat Cubik (развертка кубика Рубика на плоскость) |

Идеей стало не повторять многочисленные имитации реального кубика в 3D, а сделать его развертку на плоскость, чтобы было видно сразу все шесть граней:

В качестве среды разработки был выбран фирменный Xcode, а в качестве языка — Swift. К тому времени у меня уже был опыт работы с этой средой и языком, поэтому особых сложностей само кодирование вызывать было не должно. Хотя, некоторые моменты алгоритмического характера требовали пеших прогулок и раздумывания над ними. Вот только один пример: на каждом шаге (ходе) пользователя нужно проверять собранность кубика. Если решать задачу в лоб, то можно просто пробегать по элементам массивов и сравнивать их на одинаковость.

Исходный массив (кубик собран, как в самом начале игры) представлен в виде:

var Tnew = [

[[1, 1, 1], [1, 1, 1], [1, 1, 1]], // синий

[[2, 2, 2], [2, 2, 2], [2, 2, 2]], // белый

[[3, 3, 3], [3, 3, 3], [3, 3, 3]], // зеленый

[[4, 4, 4], [4, 4, 4], [4, 4, 4]], // желтый

[[5, 5, 5], [5, 5, 5], [5, 5, 5]], // оранжевый

[[6, 6, 6], [6, 6, 6], [6, 6, 6]] // красный

]То уже после сборки можно получить перестановки строк в любом порядке, например, вот так:

var Tnew = [

[[5, 5, 5], [5, 5, 5], [5, 5, 5]], // оранжевый

[[3, 3, 3], [3, 3, 3], [3, 3, 3]], // зеленый

[[1, 1, 1], [1, 1, 1], [1, 1, 1]], // синий

[[4, 4, 4], [4, 4, 4], [4, 4, 4]], // желтый

[[2, 2, 2], [2, 2, 2], [2, 2, 2]], // белый

[[6, 6, 6], [6, 6, 6], [6, 6, 6]] // красный

]Но при этом расположении надо считать, что кубик так же успешно собран.

Для лучшего погружения в задачу на рынке был куплен простенький и дешевый вариант кубика. И творчество началось… с исследования реального кубика. Граням присвоены номера, строкам и столбцам на гранях — координаты.

При этом движение строки или столбца должно приводить в движение «связанные» с ним строки или столбцы. Все как во взрослом кубике — перемещаете одно — в движение вовлекаются и «соседи».

Но при использовании %device% мы, если и задумываемся над этим, то весьма мимолетно и не особо глубоко. Для нас это как часть картины мира, которая особо и не удивляет. Другое дело — программная модель! Тут уже надо создать искусственную реальность, а потому понимать «реальную реальность» надо достаточно полно.

Были изрисованы и исписаны десятки листов. Иногда заметки или идеи приходилось записывать просто на том, что есть под рукой, чтобы потом уже не потерять их насовсем. И где-то к началу апреля получился работающий прототип программы. Кубик можно было собирать. Но и правило 20 на 80 (или его вариант 30 на 70) работало по полной. Надо было доделать массу сервисных мелочей: таймер сборки, счетчик ходов, какую нибудь сигнализацию об окончании сборки, подключить Game Center. И подумать о возможной монетизации. Это было бы весьма приятным бонусом.

В итоге где то к середине мая программа была готова к тому, чтобы ее можно было начинать тестировать не только на устройстве разработчика. Был оплачен аккаунт разработчика и несколько избранных из разных городов и сёл планеты получили возможность «покрутить» плоский кубик на своих устройствах (программа распространялась через Test Flight).

Что касается локализации, то я сразу решил не делать никаких надписей на экране и тем самым уйти от этой проблемы. Пока это удается.

Экран весьма минималистичен. Пользователь видит классическую развертку кубика на плоскость в виде креста, четыре кнопки: собрать кубик, запутать кубик, сменить фон и показать Game Center. Ну а вверху два счетчика: ходы и время. Время стартует только после нажатия кнопки «Запутать». Если пользователь запутал кубик сам и потом собрал — считаются только ходы.

Впечатления от программы у «аудитории»

Естественно, что меня всегда интересовало мнение тех, кто тестировал программу. Кто-то говорил, что кубик надо делать в 3D, на что я отвечал, что такие варианты кубика в АппСторе уже есть и делать их очередной клон у меня нет никакого интереса. Видимо само магическое слово «3D» уже как то привлекало людей и они считали это хорошей идеей. Кто-то сразу понимал идею развертки. Однако, наблюдения за тестерами показали, что переход «3D -> 2D» у большинства нормальных людей вызывает не иллюзорные сложности. Даже те, кто довольно легко умеют собирать реальный кубик, не могли сразу собрать правильно даже одну грань. Не говоря уже о дальнейшей сборке. Впрочем, каждый может сам попробовать это на себе.

Забавно наблюдать за Game Center. Точнее за появление в нем новых пользователей. Эта штука просто нереально крута! Я сделал в GC две таблицы: время сборки и количество ходов. В них попадает любой, кто соберет кубик полностью. А если при дальнейших сборках какой то результат будет улучшаться, то он будет оставаться в соответствующей таблице. Довольно долгое время в таблицах были только мои результаты, записанные с устройств разных тестеров под их именами. И я потихоньку начал разочаровываться в человечестве. И вот не так давно в таблицы попал совершенно не известный мне персонаж. Сначала он находился в обоих таблицах в нижних строчках. Затем начал уверенно двигаться вверх. Примерно через пару суток он занял верхние строчки обоих таблиц с довольно потрясающими результатами: 1 минута 40 секунд и 80 шагов. Впрочем, его рекорд до сих пор никем не побит в рамках Flat Cubik.

И еще совсем недавно появился второй (!) собравший, который собрал Flat Cubik за 25 минут 01 секунду и 254 хода. И занял пока шестое место в рейтинге. При этом упорства в улучшении своих достижений он не проявляет. По крайней мере лучших результатов от него не появляется.

Что сейчас и дальнейшие планы

Первая версия программы попала в App Store в последних числах июня.

Первой ошибкой было ставить на программу цену в 1$. Первый день принес 6 платных скачиваний, потом число скачиваний упало до 2.

Можно ли считать это провалом? Очень на то похоже… Позже игра стала бесплатной и в настоящее время набрала около 200 скачиваний.

Рекламы нигде не было. Если не считать короткое сообщение в конференции iXBT (внутри одной из тем MacLife).

В дальнейшем планируется добавить баннер AdMob. Была идея сделать undo для ходов пользователя. А так же определенные варианты подсказок ходов. Пока с подсказками все находится на той же стадии прогулок и размышления. Те, кто знает, как собирать кубик, понимают, что от текущего состояния можно прийти к собранному совершенно разными путями.

Да вот хотя бы маленький пример: перестановка 3-х угловых элементов: я знаю вариант в 22 хода и вариант в 8 ходов. Сам использую 8-ми ходовку.

Или вот сама стратегия сборки: самая простая — послойная. Начиная, например, с белого креста, затем углы, затем второй слой, а затем и третий. Но рано или поздно, можно попытаться пойти по варианту: 6 крестов (все грани), а затем 8 углов. В общем путей много.

В разработке сейчас версия для Андроид. Ну, а сейчас программа полностью бесплатна и доступна в АппСторе для всех устройств с установленной iOS 10. Буду рад появлению в таблицах GC новых людей.

P.S.: iOS 10 была выбрана после потери нескольких дней на поиск проблемы во внутренних библиотеках Apple (может потом напишу про это отдельную заметку). Обнаружилось, что проблема отсутствует в версиях iOS, начиная с 10. Чтобы не обходить проблему в более ранних версиях iOS и было принято решение, что Flat Cubik будет работать на устройствах с iOS10+.

|

Метки: author abcdsash я пиарюсь flat cubik развертка кубика кубик рубика app store apple ios ipad iphone developing |

[Перевод] Увольнять, нанимать, повышать — культура вашей компании |

Автор статьи: Dr. Cameron Sepah

Источник

«Настоящие, а не фейковые ценности компании можно увидеть, посмотрев на то, кого повышают, награждают и с кем расстаются»

– Культура Netflix: Свобода и Ответственность

Каждый раз, когда меня приглашают консультировать новую компанию, я обнаруживаю набор отлично звучащих благородных ценностей, вывешенных на стенах. С первого момента я стараюсь абстрагироваться от них и наблюдать за тем, как в реальности ведут себя сотрудники компании, ведь это именно то, что помогает мне понять реальное положение дел.

Дело не в том, что большинство компаний лицемерны в отношении ценностей, которые они промотируют. Одной из «вожделенных ценностей» Энрона была целостность, и это отлично отражало устремление компании в самом начале ее существования. Однако спустя некоторое время это никак не отразилось в «практикуемых ценностях» компании, которая стала известна благодаря одному из крупнейших мошенничеств в истории.

«Разрыв между вожделенными и практикуемыми ценностями показывает, насколько культура вашей компании нуждается в улучшении. Действия, которые вы предпринимаете для устранения этого разрыва, показывают, насколько это улучшение возможно»

Почему поведение сохраняется (Делай, как я делаю, а не так, как я говорю)

Так почему же существует разрыв между вожделенными и практикуемыми ценностями в компаниях? Можно подумать, что для смягчения когнитивного диссонанса большинство сотрудников должны чувствовать реальную потребность в том, чтобы вести себя согласно ценностям, которые они проповедуют. Проблема в том, что большинство вожделенных ценностей практически всегда спускаются сверху.

«Несмотря на то что большинство сотрудников заморачивается о том, что думают о них лидеры компании, в реальности им важно то, как ведут себя лидеры, а не то, что они говорят»

Согласно теории Бихевиоризма ни одно поведение в компании не может существовать в долгосрочной перспективе без влияния одной из двух сил: либо позитивного подкрепления (похвала, повышение, признание), либо негативного (наказание, перевод на испытательный срок). Таким образом, при создании компании лидеры определяют набор ценностей не по тому, что они пишут на стенах, а по тому, как они ведут себя в повседневной жизни. Например, задерживаются ли они на работе или уезжают домой в 18-00 для того чтобы побыть с семьей? Согласно теории социального научения, такие виды поведения быстро становятся популярными в компании, и рядовые сотрудники очень легко считывают соответствующие сигналы от лидеров, можно сказать, что эти ценности просачиваются сверху вниз.

Со временем компания увеличивается до того размера, когда наблюдать за ее лидерами становится сложно, с этого момента сотрудники начинают вести себя согласно рамкам, которые определяют менеджеры: либо активно поддерживают одни линии поведения, хваля и повышая сотрудников, либо пассивно допускают существование других линий поведения. Через некоторое время сотрудники начинают понимать причины увольнений, найма и повышений среди своих коллег. Они наняли Джо, потому что в рекомендации с предыдущих мест работы были блестящими? Джилл уволили, потому что она не была командным игроком? Джейми повысили, потому что он много тусуется вместе с лидерами компании? Сотрудники компании довольно быстро разучивают эти «правила игры», это нужно для того чтобы выживать и быть успешным в компании, для этого достаточно лишь вести себя соответствующим образом, и далеко не факт, что это поведение будет хоть сколько-то похоже на то, что написано на постерах с ценностями.

«Сотрудники вашей компании практикуют то поведение, которое ценится в компании, а не ценности, в которые вы верите»

Оценка по ценностям (найм на работу)

Для того чтобы не превратить вашу компанию в корпоративную версию «Голодных игр», лидеры должны делать одну очень важную штуку: ставить акценты на то поведение, которое соответствует ценностям компании.

Во-первых, вы должны удостовериться, что все финальные кандидаты на открытые позиции соответствуют ценностям компании. Например, я оцениваю кандидатов по 7 характеристикам: упорство, тщательность, влияние, работа в команде, владение, любопытство, учтивость (я рекомендую заменить их вашими корпоративными ценностями).

Другая ключевая характеристика (точнее ее отсутствие) была популяризирована профессором Стенфорда Бобом Саттоном. Правило «Без редисок» (прим. Это наш вольный перевод более яркого слова asshole ) диктует нам следующее: неважно, как крут и экспертен кандидат, если он ведет себя как редиска, то это автоматически означает отказ в найме. Я называю это «правилом одного красного флага». Оно базируется на наблюдении, что патологические элементы поведения проявляются спорадически, т.е. время от времени, а не постоянно.

Например, нарциссически настроенный кандидат может не вести себя высокомерно все время, однако может делать высказывания, которые будут звучать в 10 раз более высокомерно, чем у кого-то без такой характеристики (например несколько раз в день vs несколько раз в месяц).

Проблема в том, что оценка этих характеристик во время быстрого интервью может быть сложной и неточной. Поэтому я рекомендую делать максимально тщательные референс-чеки: есть мнение, что лучший прогноз будущего поведения сотрудника базируется на его поведении в прошлом. Базируясь на передовую практику ведущего инвестора, Андреесена Горовица, я собираю до 6 рекомендаций с предыдущих мест работы, чтобы четче оценивать «попадание в ценности».

Один стартап из Сан-Франциско (Webby, 300 чел) пошел еще дальше: они устраивают «проб

ную неделю» для нанимаемых сотрудников, во время которой полностью оплачивают отработанные часы. Почему? Все просто: практически невозможно подавлять несовместимые по ценностям линии поведения, когда сотрудник долго взаимодействует с коллегами.

Их CEO формулирует это так:

«Редиски могут легко замаскироваться во время интервью, но, что бы ни случилось, они не смогут маскироваться всю неделю. Не знаю почему, но за неделю все становится на свои места»

Как поощрять

Не важно насколько крутые у вас интервьюеры, любое собеседование может закончится либо ложным срабатыванием (вы думали, что кандидат подходит под ваши ценности, но поняли, что это не так по результатам найма), либо упущенной возможностью (вы думали, что кандидат не подходит под ваши ценности, но он подошел бы, если был бы нанят). Компании, для которых культура приоритетна, соглашаются упускать некоторые возможности для того, чтобы не допускать ложных срабатываний. Если ложное срабатывание все же произошло, то решение максимально простое – уволить максимально быстро. Очень мало людей настолько готовы психологически, что могут самостоятельно подать заявление об увольнении, понимая, что они не подходят под ценности компании. Особенно если они очень хотят эту работу. Проблема, которую я наблюдал в ряде стартапов, можно характеризировать следующим образом: несмотря на принятое в компании правило «без редисок», они ему не следуют. Включаются оправдания вроде таких: «Мы решили не увольнять его потому что он суперпродуктивный» или «на эту одну плохую черту у него есть пять хороших» или «таких нишевых специалистов ооочень сложно заменить — будем терпеть».

«Момент, в который лидеры компании начинают выбирать между тем, можно ли вести себя только согласно ценностям или нет, является моментом, в который ценности компрометируются»

Лучшим способом, для того чтобы избежать этой ловушки, является включение оценки сотрудников по ценностям в ваш стандартный процесс performance management.

Вот простая система, которую я создал и внедрил в своей компании. Все начинается с оценки каждого сотрудника по двум шкалам: Производительность и Ценности. Неважно, какую систему оценки вы используете, сотрудники должны быть оценены и по производительности и по соответствию ценностям. Обе шкалы должны быть оцифрованы в стандартном формате 1-10, но я упростил эту систему до матрицы 2х2, чтобы она была более наглядной. Обычно я стараюсь быть политкорретным, но в данном случае использование ярких выражений позволяет сделать историю более понятной:

1) Некомпетентные редиски (сразу увольнять)<

Некомпетентные редиски являются не только неэффективными с т.з. производительности, кроме этого их поведение в корне противоречит ценностям вашей компании. В матрице они располагаются в нижнем левом углу и они могут заработать максимум 25% от общей оценки. Хотелось бы верить, что в вашей компании таких сотрудников практически нет, но случается, что такие сотрудники умудряются задержаться в компании из-за ошибок рекрутмента либо из-за затянувшейся деградации производительности и соответствия ценностям. Важно отметить, что они подрывают мотивацию коллег, т.к. не приносят никакой пользы, а кроме того токсичны с т.з. морали коллектива. Конечно же, задачей каждой компании является как можно быстрее выявить некомпетентных редисок и уволить их.

2) Компетентные редиски

Компетентные редиски обычно очень эффективны с т.з. производительности, но при этом они зачастую демонстрируют поведенческие характеристики, которые полностью не соотносятся с вашими корпоративными ценностями. Принимая это во внимание, «редиска» — не клинический термин в данном случае, я бы определил его как кого-то, кому не хватает эмпатии в поведении, что вызывает межличностные конфликты. Наибольшей ошибкой, которую я вижу в компаниях, является то, что они сохраняют компетентных редисок, потому что считают их критичными для успеха компании, либо считают трудно заменимыми. Однако, делая так, они не только пассивно поддерживают поведение компетентных редисок соглашаясь с ними и повышая их, но также неявно дают сигнал всей остальной компании о том, что «вы можете вести себя как угодно, пока руководство считает вас необходимым». Вы можете себе представить, какая культура вырастет в такой компании через некоторое время. В клиническом случае компетентный редиска может получить всего 50% от максимально возможной оценки, т.к. вторые 50% напрямую завязаны на совпадение с ценностями.

Причина по которой правило называется «без редисок» проста: не должно быть исключений. Иначе ваши ценности являются в лучшем случае желаемыми. Решением для проблемы компетентных редисок является то, что я называю «исправлять или отделять». Несмотря на то что эти ребята максимально хороши с т.з. производительности, им должно быть четко донесено, что поведение, несоответствующее ценностям, неприемлемо, и они должны будут внести изменение в свое поведение в ближайшее время.

Иначе говоря, компетентные редиски должны получить то, что я называю «Планом улучшения ценностей». Опросы 360, в которых участвуют менеджеры, коллеги и прямые подчиненные, отлично подходят для того, чтобы оценивать улучшение. Причина, по которой я предпочитаю давать шанс таким людям в том, что в основном они не настолько негибкие, чтобы совсем не меняться, особенно когда они понимают, что их работа зависит от этого изменения. В большинстве случаев это изменение требует серьезной терапии и коучинговой поддержки с компетентным специалистом, что является особенно ценным, если сотрудник хочет меняться.

3) Некомпетентные милаши

Некомпетентные милаши являются примером для подражания с т.з. культуры вашей компании, их все любят, но к сожалению, они крайне неэффективны с т.з. производительности. Как и компетентные редиски, некомпетентные милаши могут получить максимум 50% от общей оценки. Все потому что, с моей т.з. практически так же грешно терпеть некомпетентных сотрудников, как терпеть редисок. Дать кому-то карт-бланш на то чтобы быть неэффективным, просто потому что они милы в общении, дает вашей компании четкий сигнал о том, что здесь нет места меритократии. Достаточно просто быть подкованным в социальном плане и все будет ок. Однако решение в данном случае иное, чем в ситуации с компетентными редисками. Правильной линией поведения будет управлять ими или переместить на другую задачу.

Некомпетентные милаши должны пройти стандартную «Программу повышения эффективности», получая постоянный фидбек и необходимый набор тренингов для повышения квалификации. Одним из решений является переброска такого сотрудника на другую роль, где его компетенции будет достаточно для того, чтобы быть эффективным.

4) Компетентные и выдающиеся милаши

Хочется верить, что большинство сотрудников вашей компании и компетентны, и милы, и важно отметить, что в матрице Производительность-Ценности вы должны проецировать и то, и другое чтобы находится в правом верхнем квадрате. Компетентные милаши могут получить до 75% оценки, и конечно же их нужно хвалить публично, и давать возможности к росту внутри компании. Но, для того чтобы держать планку высоко сотрудники должны быть в состоянии получить 100% оценки, только если они демонстрируют выдающиеся результаты как по производительности, так и по соответствию ценностям. Принимая во внимание, как редки такие сотрудники, владельцы компании должны не мешать им и делать все для того, чтобы увлечь и удержать их внутри компании. Это текущие или будущие лидеры вашей компании, и их нужно холить и лелеять, принимая во внимание то, что они являются основной производительности и культуры для вашей компании.

Стоит отметить, что несмотря на то что я разделяю компетентных и выдающихся милашей, я не делаю того же самого с редисками. Причина проста: я считаю, что практически невозможно быть выдающимся редиской.

Что же с этим делать

Культура любой компании может развиваться или деградировать в зависимости от вектора ее развития. Индексы вовлеченности в компаниях снижаются по мере их масштабирования, нанимать сотрудников нужно в условиях постоянной спешки и ограниченного пула талантов, а увольнять сложно из-за большой загрузки – все это не является не берущейся задачей. Культура может улучшаться только в случае наличия базового уровня открытости, когда люди чувствуют, что они могут поделиться своими соображениями о том, как можно улучшить мир вокруг. Если вы хотите создавать целостную и честную культуру в компании, соответствующую благородным заявлениям с постеров на стенах, вы должны постоянно оценивать поведение сотрудников на соответствие ценностям, а также стремиться устранять разрыв между желаемым и практикуемым поведением.

«Как говорится в старой поговорке, что посеешь, то и пожнешь. Лидеры получают то поведение, которое они вознаграждают»

|

Метки: author Sherbinin управление проектами управление персоналом блог компании райффайзенбанк управление людьми культура сотрудники компании |

[Перевод] Постмортем Super Meat Boy |

Когда я учился в средних классах, то рисовал эскизы для потрясающей видеоигры, полной крови, огромных боссов, эпичных миров и сюжета, ведущего бессмертного героя сквозь ад, конец мира и дальше.

Потом я вырос… но мало что поменялось.

Super Meat Boy начинался как простой прототип на Flash, который мы в свободное время с моим другом из Интернета Джоном Макэнти (Jon McEntee) создали за три недели. Я не представлял, что он станет одной из моих самых популярных игр на Flash, не говоря уже о выпуске полномасштабной консольной игры.

В 2008 году меня наняли Microsoft и Nintendo, чтобы я создал что-нибудь для их Интернет-магазинов. Изначально я хотел сделать для Microsoft Gish 2, а Nintendo больше заинтересовала расширенная версия Aether, но главным фактором, повлиявшим на меня, стала случайно завязавшаяся дружба.

Я познакомился с Томми Рефенесом в 2008 году. За долгие годы я успел поработать с множеством программистов, и отношения между художниками и программистами всегда были немного отчуждёнными. Работа с Томми напоминала общение с лучшим другом из колледжа, мы чудили и выкидывали трюки, бесившие всех вокруг. Я сразу понял, что любой наш совместный проект будет интересным, именно так и получился Super Meat Boy.

Мы просто хотели сделать что-то интересное и развлекались, создавая эту игру.

Контракт на создание консольной игры стал большим прорывом, нашим шансом показать всем, кто мы такие и на что способны. Без всякого давления.

Что у нас получилось хорошо

1. Мы использовали собственный движок и инструменты

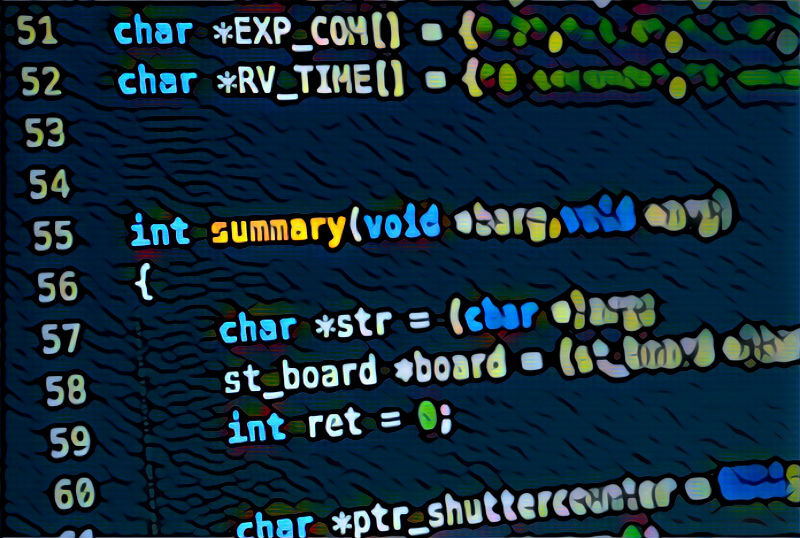

Томми: Когда я говорю людям, что сделал движок и инструменты сам, большинство спрашивает: «Зачем?» Мои друзья из FlashBang в каждом разговоре пытались убедить меня использовать Unity, но я твёрдо придерживался решения создать собственные инструменты разработки и движок.

Важнейшая причина для этого — уровень контроля. Когда доходит до кода, я одержим контролем: я хочу понимать всё, что происходит в моей кодовой базе. Тогда, если что-нибудь сломается, я буду точно знать, где это случилось и как это исправить. Кроме того, я занялся играми, чтобы писать их, а не скрипты. Мне нравятся все аспекты программирования игр, от движка до геймплея. Мы инди и можем делать всё, что захотим, а благодаря своим навыкам я буквально наслаждаюсь разработкой движка.

На создание Super Meat Boy ушло 18 месяцев, от первой строки кода движка до последней строки кода сообщений об ошибках перед отправкой на сертификацию XBLA. Лично мне кажется, что это рекордное время для игры с таким объёмом контента и для двух разработчиков. Я уверен, что мы смогли справиться с этим, потому что я занимался кодом. Когда возникала ошибка, я немедленно отслеживал её, вне зависимости от платформы, на которой она обнаруживалась.

Для Super Meat Boy использовалось не так много инструментов. Бесценным оказался внутриигровой редактор уровней, потому что он позволил Эдмунду создавать уровни визуально, без возни с кодом.

Ещё одним инструментом стал созданный мной Flash Exporter. В целом это был скрипт, упаковывающий все символы Flash в одну текстуру и экспортирующий информацию об анимации со звуковыми метками. Он оправдал себя ещё при первом экспорте сделанного Эдом Meat Boy. Мы получили звуки, анимации и всё необходимое за одну быструю операцию экспорта, которой движок мог легко управлять и вызывать её при необходимости.

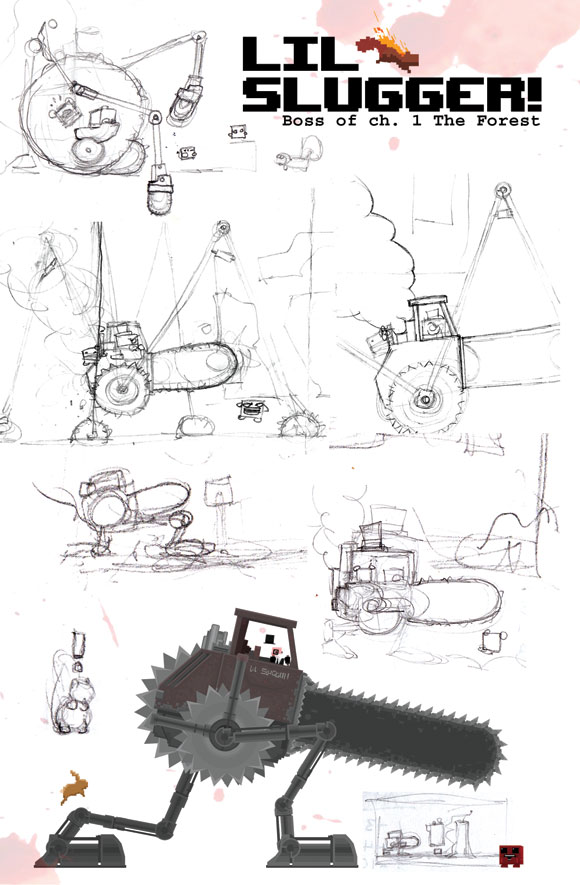

2. Дизайнерская среда

Эдмунд: Почти с самого начала и меня, и Томми немного напрягала та очень строгая рабочая среда, которой нам советовало придерживаться большинство разработчиков, чтобы нас воспринимали серьёзно и мы смогли достичь успеха.

Помню день, когда мы получили письмо от Nintendo, в котором нас попросили сделать фотографии разработчиков и написать наши биографии. Нам показалось безумием то, как серьёзно все воспринимают индустрию, цель которой — развлекать.

Мы с Томми в тот день купили самые смешные свитера, которые смогли найти, зашли в Sears Photos и сделали там снимок, который стал фотографией нашей команды. Кажется, мы ещё сочинили совершенно смехотворные биографии разработчиков, которые Nintendo потом публиковала в своих пресс-релизах вместе с нашей фотографией.

Томми Рефенес и Эдмунд Макмиллен

Я хочу сказать, что самым главным в нашей работе были веселье и интерес. Для нас было важно, чтобы мы всегда наслаждались тем, что делаем, и мы передавали любовь к своей работе в интервью, видео, на конференциях, да и в самом дизайне игры.

Мы с Томми стали очень близки в процессе разработки, и Super Meat Boy стал результатом этого. Мы получали удовольствие при работе над этой игрой, и не могли сдержать своих чувств, когда дело доходило до принятия решений. Super Meat Boy была шуткой «для своих», которая внезапно отбилась от рук. Думаю, привлекательнее всего в SMB то, что любой игрок в видеоигры сможет понять эту шутку.

3. Инновация в дизайне: назад к истокам

Эдмунд: Когда мы с Томми говорили о возможности ремейка формулы Mario, мы никогда не упоминали этого на публике. Нельзя было говорить о Марио, даже близко его вспоминать, но как дизайнер я хотел хотя бы попробовать.

Super Meat Boy — это Super Mario Bros, но сделанный мной и Томми. Если бы мы писали диздок, то в нём было бы только это.

То есть с этой точки зрения у дизайна игры был очень солидный фундамент, но за предыдущие 20 лет игры очень сильно изменились. Разработчики отказались от сложности, простота и доступность стали превыше всего.

Мы стремились вернуть сложность той ретро-эпохи, а также заново изобрести саму идею сложности. Самой большой частью сложности старых игр было раздражение, от которой, как мы считали, нужно всеми способами избавиться, чтобы дать игрокам чувство завершённости, не разочаровывая их.

По своей сути эта идея была очень простой: уберём жизни, уменьшим время респауна, сделаем уровни короткими, а цели — всегда видимыми. Поверх всего этого мы добавили постоянную положительную обратную связь, даже смерть становилась чем-то интересным, ведь после того, как игрок всё-таки осиливает уровень, он может наблюдать за эпичной демонстрацией всех предыдущих смертей. Функция реплея позволила напомнить игроку, что благодаря собственным действиям он совершенствуется. Кроме того, она подкрепляла чувство завершённости, победы в сложном состязании.

4. Саундтрек

Эдмунд: Дэнни Барановски — потрясающий музыкант, но по моему мнению одной из причин соответствия его музыки игре стала внутренняя работа системы.

С самого начала я считал важным, чтобы Дэнни обладал всеми правами на музыку, которую он создал для игры. Казалось логичным, что художник будет больше вкладывать в свою работу, если он чувствует, что она отражает его самого. Мы хотели, чтобы Дэнни получил все доходы за свою работу, и это казалось логичным.

Работа Дэнни стала выражением его собственной личности. Музыка сумасшедша, одержима, сложна и полна жизни. Именно все эти элементы нужны были для нам для саундтрека SMB, и этого удалось достичь: мы просто дали Дэнни создавать музыку, которой он мог бы гордиться.

Саундтрек SMB стал потрясающий дополнением к игре — он усиливает сердцебиение, обогащает все аспекты геймплея и долго не забывается. Я считаю, всё это вышло благодаря тому, что мы доверяли Дэнни как художнику и просто позволили ему делать то, что у него хорошо получается.

5. Steam

Томми: Steam — потрясающая платформа, и я не могу найти слов, чтобы выразить своё восхищение полностью. Возможность быстро выпускать обновления в течение всего нескольких часов после обнаружения ошибки сильно упростила выпуск на PC. Если бы у Steam была другая система обновления кода, всё оказалось бы сложнее.

Кроме того, Steam прислушивается к своим разработчикам. Команда Steam учитывала наши предложения о том, как развивать продажи, а мы, в свою очередь, прислушивались к ним. Работа со Steam никогда не была похожа на традиционные отношения издателя и разработчика, она напоминала взаимное сотрудничество, чтобы заработать больше денег и выпустить качественную игру.

Мы любим Steam.

Что пошло не так

1. Личные расходы

Эдмунд: Нельзя сказать, что наши личные расходы были какой-то серьёзной ошибкой, потому что они стали огромным мотиватором к завершению игры, но они определённо представляли проблему в несколько последних месяцев разработки.

В какой-то момент мне нужно было провести экстренную операцию на желчном пузыре, которая проделала в моём бюджете дыру в 50 тысяч долларов, потому что я не мог позволить себе страховку.

У нас совсем не было живых денег, даже все комиксы, которые мы печатали для GDC и PAX, удалось получить благодаря бартеру: моя жена делала плюшевые игрушки для продажи в магазине Newgrounds в обмен на стоимость печати.

Ситуация была критичной в нескольких ключевых точках разработки, но я был на грани бедности последние 10 лет, поэтому для меня это не стало большой проблемой. Да и, честно говоря, у нас были проблемы гораздо серьёзнее.

Томми: Был период, когда мой счёт в банке составлял -800 долларов. Плохо, когда заходишь в супермаркет купить Coke Zero и тебе приходит отказ. Выяснилось, что каждая из этих банок Coke Zero стоила мне примерно 40 долларов.

2. Упущенный WiiWare

Томми: Когда мы изначально объявили о выпуске Super Meat Boy для WiiWare, то планировали не более 100 уровней, без катсцен и открываемых персонажей. Мы хотели сделать прямой порт Flash-игры с некоторыми дополнениями, и ничего больше. Потом нас понесло, но не думаю, что это плохо, потому что мы сделали как раз ту игру, которую хотели. Плохо было то, что мы не смогли бы опубликовать игру для Wii.

В процессе создания игры и добавления контента нам стало ясно, что будет почти невозможно уместиться в ограничения по размеру WiiWare. Я всегда подсознательно стремился к изданию, но урезание игры до 50 МБ означало удаление кучи контента, который составлял неотъемлемую часть игры.

Эдмунд: Меня всё ещё печалит то, что мы не выпустились на Wii, и мне хотелось бы этого. Когда публикация в WiiWare стала невозможной, мы рассматривали варианты продаж SMB в розничных магазинах Wii, но увы, никто из встреченных нами издателей не рассматривал Wii как выгодную инвестицию на том этапе разработки. Поэтому мы закончили историю с Wii.

3. Выпуск на PC

Томми: Издавать игру на нескольких платформах командой из двух человек довольно сложно. Выпуск на PC был немного проблемным из-за тестирования. Мне казалось, что у нас есть достаточный набор тестовых машин. У нас были компьютеры от минимально подходящих для игры (нетбук Acer) до мощных четырёхъядерников. Я считал, что мы учли все варианты: у нас были видеокарты ATI и NVidia. Но, очевидно, этого было недостаточно.

В день выпуска на PC нас завалило кучей отчётов об ошибках, сбоях при запуске и выходе и многом другом. За несколько первых дней после выпуска я ответил примерно на две тысячи писем. Я чувствовал себя так же, как во время последнего рывка перед выпуском на XBLA: каждый раз, когда я что-то чинил, ломалось что-нибудь другое.

Было очень сложно перейти в течение одного месяца от стресса выпуска в XBLA к выпуску на PC. У нас было чувство завершённости, немедленно сменившееся ощущением провала. Следующую игру мы будем тщательнее тестировать на PC, а скорее всего, отдадим эту задачу на аутсорс компаниям, специализирующимся в тестировании.

4. Последние два месяца напряжённой работы перед выпуском в XBLA

Эдмунд: В конце августа 2010 года нам позвонил наш продюсер из Microsoft. Он рассказал нам, что предстоит осенняя рекламная кампания, похожая на Summer of Arcade. В тот момент нам оставалось до завершения ещё четыре месяца, но чтобы успеть выпуститься во время этой кампании, нам нужно было пройти сертификацию за два месяца.

Такой срок выглядет невозможным. Нам сказали, что если мы не успеем к осенней кампании, то нам придётся отложить игру до весны или попробовать выпустить её самостоятельно, без особой поддержки. При этом мы рисковали значительными потерями. Microsoft объяснила, что все игры в кампании получат собственную неделю выпуска, очень активное освещение, обзоры Major Nelson и демонстрацию на PAX и других мероприятиях. Эта рекламная кампания должна была называться Game Feast.

На тот момент наше финансовое положение становилось опасным и нам казалось, что если мы не попадём в эту осеннюю кампанию, то для нас не останется надежды. Мы не могли откладывать до весны, а выпуск без поддержки Microsoft был похож на самоубийство, поэтому мы решили поставить на кон всё и попробовать успеть за два месяца то, что запланировано на четыре. Эти два месяца были худшими в моей жизни.

Давление, объём работы и общий стресс разработки чрезвычайно выматывали. В те два месяца у нас обоих не было ни одного выходного дня, мы ежедневно работали по 10-12 часов. В конце разработки получилось так, что в течение нескольких недель я спал меньше чем по пять часов в сутки. Помню свой срыв в сентябре, когда мне казалось, что мы застряли в каком-то кошмаре, где один день повторяется снова и снова.

Томми: Из-за таких сжатых сроков мы добавляли новые функции параллельно с исправлением ошибок, то есть каждый раз, когда я включал компьютер и проверял базу данных ошибок, вся работа, которую я сделал предыдущим вечером, оказывалась бесполезной. Я работал и исправлял 100 ошибок вечером, снижал их количество до 50, а на следующее утро ошибок оказывалось уже 200.

Это длилось долгими неделями. Я был слаб, зол и напряжён. Родители приносили мне еду, потому что я в буквальном смысле не выходил из дома в течение этих двух месяцев. Помню как постоянно повторял себе: «Не умри, пока не сделаешь игру», потому что я действительно этого опасался. Я чувствовал себя жалким, уровень сахара в крови скакал [прим. пер.: Томми Рефенес — диабетик], но мне приходилось пахать и исправлять ошибки. Не знаю, сделало ли это меня сильнее… но, по крайней мере, мне как-то удалось выжить!

Эдмунд: Думаю, мы скрывали друг от друга сложность всей ситуации, чтобы не давить ещё больше.

По вечерам я часто говорил своей жене, что больше не могу, не хочу больше делать эту игру, она того не стоит, и я с готовностью уйду и переживу все потери просто чтобы вернуться к нормальной жизни. Она отвечала: «давай поговорим, когда ты успокоишься», я ложился спать, вставал через пять часов и снова проживал один и тот же день.

5. Выпуск в XBLA

Эдмунд: Процесс разработки был закончен, Super Meat Boy получила на PAX несколько наград, и пресса начинала уже нацеливать на нас свои софиты. Многие веб-сайты и журналы сказали, что Super Meat Boy запросто станет хитом Feast, а возможно и новым крупным инди-хитом, но бизнесмены из Microsoft не были в этом уверены.

Нам сказали, что цена слишком высока, графика слишком грубая, да и не цепляет взгляд, как другие игры для Game Feast: Comic Jumper и Hydrophobia. У нас сердце ушло в пятки, когда нам сообщили, что по прогнозам наша игра будет продаваться так же, как Hydrophobia, если не хуже, а ведь она по их мнению, станет второй по доходам игрой в Feast.

Эти прогнозы ещё больше разочаровали после выпуска Hydrophobia: по статистике, за первую неделю в неё поиграло меньше 10 тысяч человек. Если прогнозы Microsoft были верны, то мы были в полной…

Через неделю выпустили Comic Jumper, на которую публика отреагировала примерно так же, хотя продажи были чуть лучше, но всё равно недостаточными по стандартам XBLA. Game Feast казалась огромной бомбой, и некоторые сайты уже писали о ней, как о провале

Super Meat Boy выпустили 20 октября, вместе с Costume Quest. В течение четырёх дней она рекламировалась третьей. Мы не получили никаких рекламных бонусов при выпуске, как предыдущие игры Game Feast (эксклюзивная неделя выпуска, первое рекламное место и обзор Major Nelson), но нам сказали, что если оценка на Metacritic и продажи будут хорошими, нас начнут рекламировать активнее.

К третьему дню после выпуска мы уже обогнали суммарные результаты Hydrophobia и Comic Jumper за неделю, на Metacritic наша игра была на втором месте в списке игр XBLA, а «сарафанное радио» распространяло информацию о ней с безумной скоростью.

Нас разместили на первом месте в рекламе на пятый день, и никогда уже оттуда не снимали. Мы так и не получили обзора Major Nelson, как и объяснения тому, зачем Microsoft выпустила SMB вместе с Costume Quest. Нам не рассказали, почему, несмотря на то, что мы превзошли все ожидания, с нами по-прежнему не обходились так, как обещали, даже когда продолжилась активная реклама других игр Game Feast, например Comic Jumper.

Поэтому мы были сбиты с толку и нам казалось, что нас используют. Я по-прежнему не понимаю, почему всё получилось именно так. Может быть, Microsoft просто хотела отстраниться от Game Feast? Возможно, они не верили в наш успех? А может быть, нам сильно не повезло в самое конкурентное время года для видеоигровой индустрии?

Как бы то ни было, самой большой ошибкой в разработке SMB было то, что мы убивались ради рекламы, от которой в сущности ничего не получили.

Самое мясо

Томми: Сложно говорить о каком-то разочаровании… мы ведь ещё не закончили! Нам нужно было доделать редактор, портал и версию для Mac. Это было трудно, ведь мы уже чувствовали, что всё закончилось, как будто мы пересекли финишную черту. Но тут как будто кто-то сказал: «Хотите поучаствовать в ещё одной гонке?», а мы такие: «Да, наверно, будет весело».

Эдмунд: А потом ты понимаешь, что это будет та же гонка, никакого приза в конце не будет, и в этот момент тебя начинает тошнить.

По-моему, всё это стоило того, ведь я делал игру с другом. Если бы я делал её с каким-то чужаком, с тем, с кем нельзя пошутить, то весь процесс был бы очень печальным и я жалел бы обо всём.

Томми: В целом я чувствую, что игра стоила всего этого стресса. Мы начинали как два простых парня без единой готовой игры, а закончили созданием четвёртой по рейтингу игры для PC 2010 года, продавшейся тиражом 400 тысяч и получившей больше 15 наград «Игра года».

Эдмунд: Для меня было честью создавать игру, в которую мы вложили так много души, и которую оценили очень многие. Приятно быть живым доказательством того, что два бросивших колледж парня без денег смогут сделать многоплатформенную консольную игру ценой всего лишь небольшой мозговой травмы.

Технические данные

Разработчик: Team Meat

Количество разработчиков: 1 Эдмунд, 1 Томми, 1 Дэнни

Время разработки: 18 месяцев

Дата выпуска: 20 октября 2010 года (XBLA), 30 ноября 2010 года (Steam)

Платформа: Xbox 360, PC

|

Метки: author PatientZero разработка игр super meat boy team meat xbla игры для xbox игры для pc |

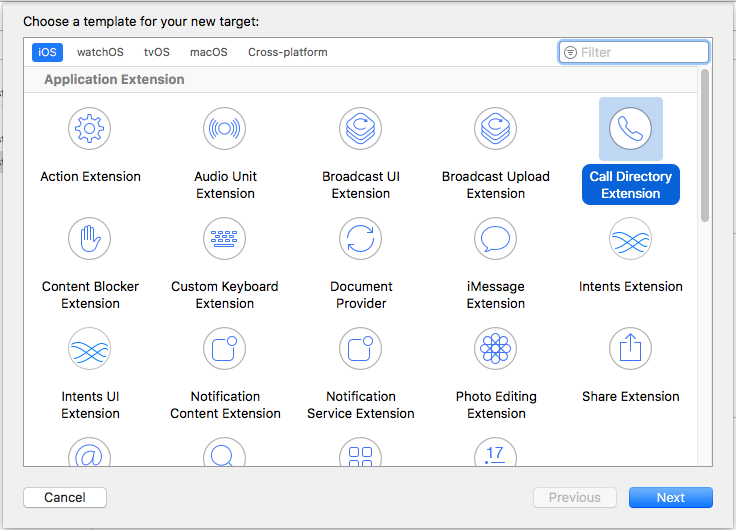

Определяем номера с помощью CallKit |

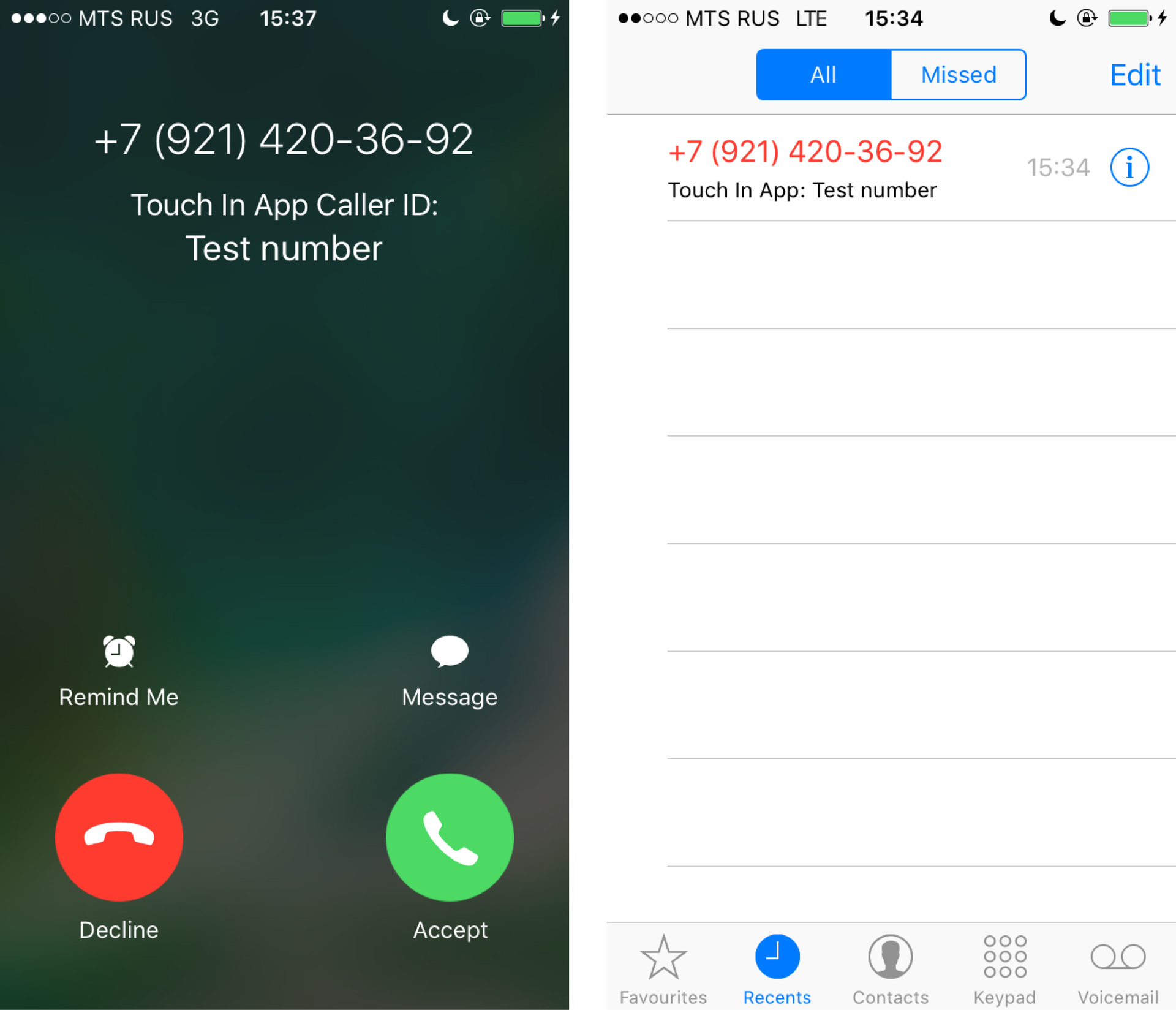

Когда в CRM 57000 контактов, людям совсем не хочется записывать их в айфон вручную. Надо найти решение поизящней, которое позволит не просто искать контакты в отдельном приложении, но и отображать имя человека при входящем звонке. Мы долго гуглили, а потом вспомнили про анонс фреймворка CallKit с WWDC. Информации по этой теме оказалось не так много: немногословная документация, статья на Хабре и ни одного пошагового руководства. Хочу восполнить этот пробел. На примере создания простого приложения покажу, как научить CallKit определять тысячи номеров.

Определяем один номер

Для начала попробуем определить один единственный номер.

Начнем с пустого проекта. Создадим Single View Application с именем TouchInApp.

Добавим extension для определения номеров. В меню Xcode выберите File > New > Target… В разделе Application Extension выберите Call Directory Extension, нажмите Next.

В поле Product Name введите TouchInCallExtension, нажмите Finish. В появившемся алерте нажмите Cancel.

Надеюсь, вы уже подготовили тестовый телефон, с которого будете звонить. Если нет, то сейчас самое время.

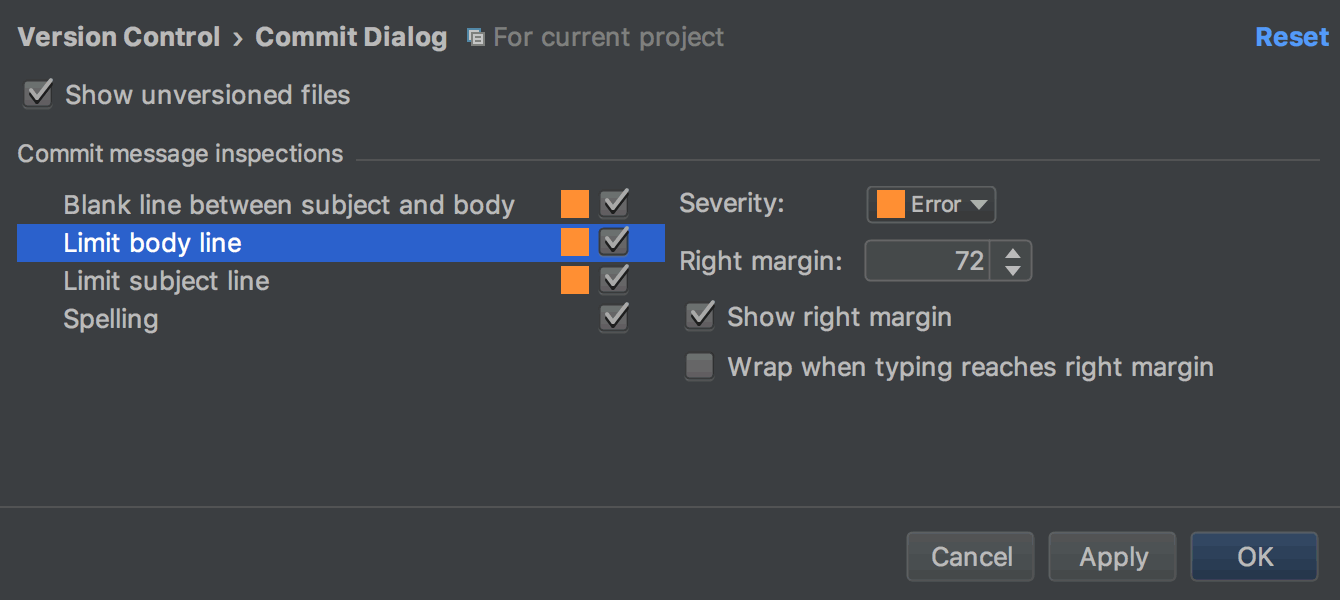

В Project navigator раскройте TouchInCallExtension и откройте CallDirectoryHandler.swift. Найдите функцию

addIdentificationPhoneNumbers. Там вы увидите массивы phoneNumbers и labels. Удалите номера из phoneNumbers, впишите туда тестовый номер. Удалите содержимое массива labels, впишите туда «Test number».У вас получится что-то вроде этого:

private func addIdentificationPhoneNumbers(to context: CXCallDirectoryExtensionContext) throws {

let phoneNumbers: [CXCallDirectoryPhoneNumber] = [ 79214203692 ]

let labels = [ "Test number" ]

for (phoneNumber, label) in zip(phoneNumbers, labels) {

context.addIdentificationEntry(withNextSequentialPhoneNumber: phoneNumber, label: label)

}

}CXCallDirectoryPhoneNumber — просто

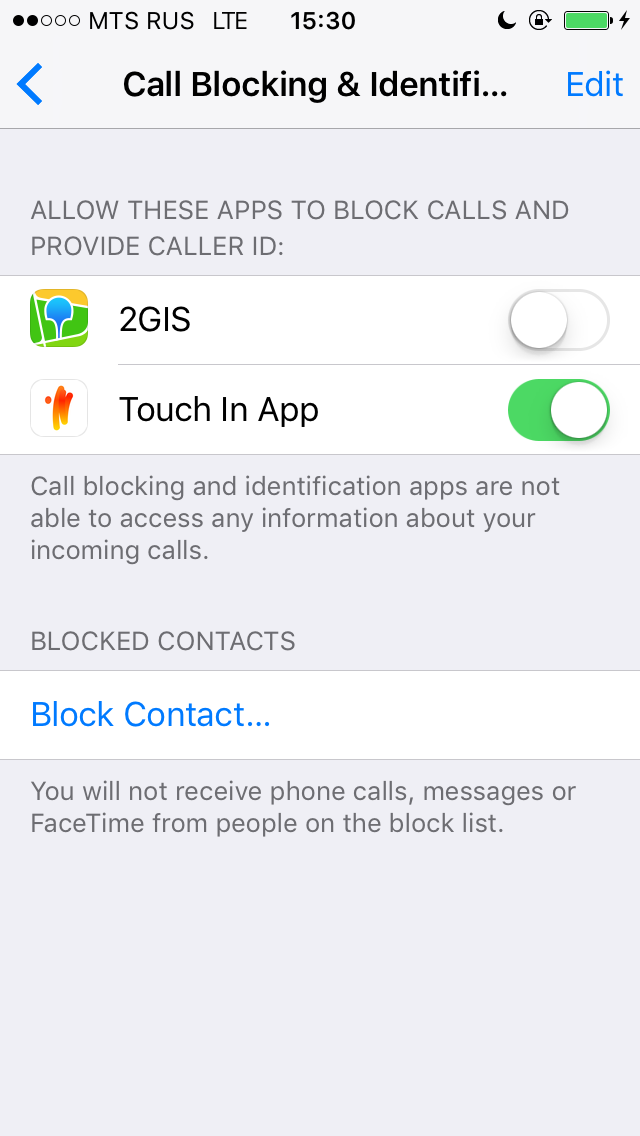

typealias для Int64. Номер должен быть в формате 7XXXXXXXXXX, то есть сначала код страны (country calling code), потом сам номер. Код России +7, поэтому в данном случае пишем 7.Поставьте приложение на устройство и тут же закройте. В нем пока нечего делать. Зайдите в настройки телефона > Phone > Call Blocking & Identification. Найдите там приложение TouchInApp и позвольте ему определять и блокировать вызовы. Бывает, что приложение не сразу появляется в списке. В таком случае закройте настройки, откройте и закройте еще раз приложение и попробуйте снова.

Когда вы переводите Switch в состояние On, вызывается

addIdentificationPhoneNumbers из ранее добавленного расширения и считывает оттуда контакты.Позвоните с тестового номера на ваше устройство. Номер должен определиться.

Определяем тысячи номеров

Все это, конечно, здорово, но это всего лишь один номер. А в начале статьи речь шла о тысячах контактов. Очевидно, что мы не будем их все вручную переписывать в массивы

phoneNumbers и labels.Итак, контакты мы должны добавлять в расширении. Из приложения мы это сделать не можем. Мы можем лишь вызвать функцию

reloadExtension, вызов которой приведет к вызову addIdentificationPhoneNumbers. О ней я расскажу чуть позже.Так или иначе, приложение будет иметь доступ к контактам. Либо они сразу будут с ним поставляться в определенном формате, либо мы будем получать их по запросу к API, либо как-то еще — неважно. Важно, что расширение должно каким-то образом получить эти контакты.

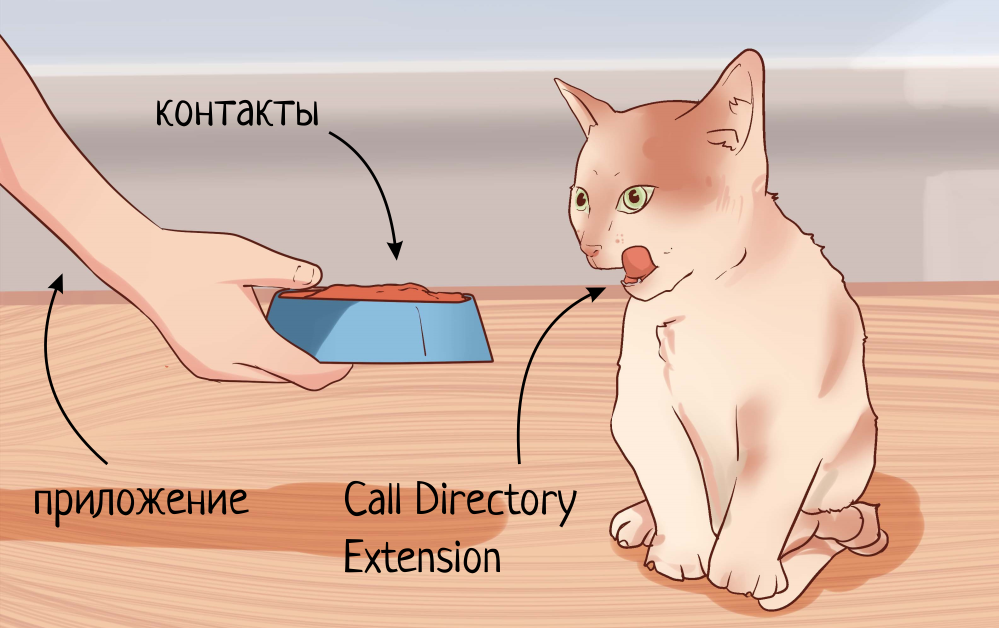

Давайте на секунду отвлечемся и проведем небольшую аналогию. Представьте, что у вас есть кот. Если есть, можете не представлять. Вы просыпаетесь утром и собираетесь его покормить. Как вы будете это делать? По всей вероятности, насыпете корм в миску. А уже из нее кот покушает.

А теперь представьте, что Call Directory Extension — это кот, а вы — приложение. И вы хотите накормить контактами Call Directory Extension. Что в нашем случае будет исполнять роль миски, которую мы должны наполнить контактами и из которой extension впоследствии будет их потреблять? К сожалению, вариантов у нас не так много. Мы не можем использовать Core Data или SQLite, так как очень сильно ограничены в ресурсах во время работы расширения.

Когда вы редактировали функцию

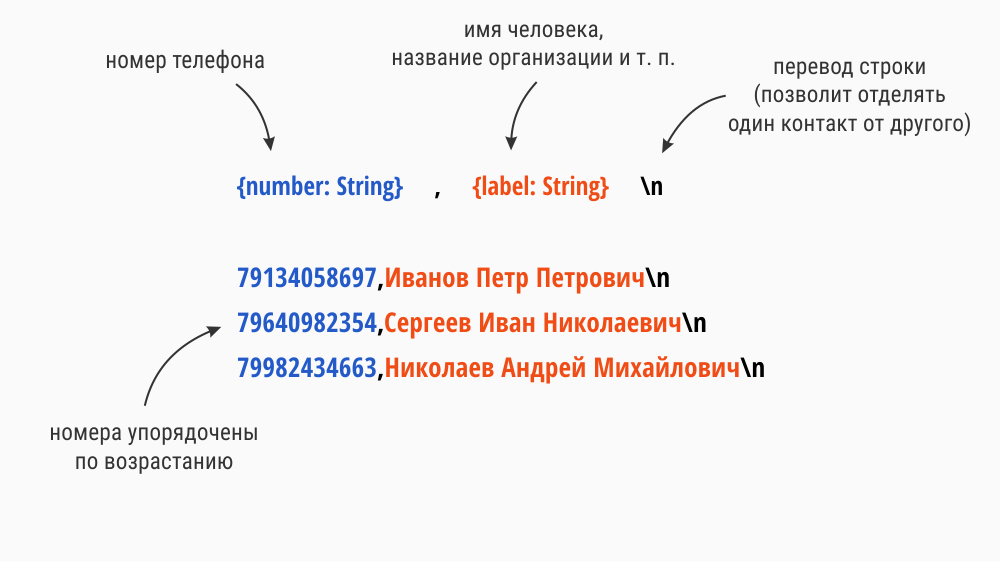

addIdentificationPhoneNumbers, вы наверняка заметили комментарии. Там говорится о том, что «Numbers must be provided in numerically ascending order.». Сортировка выборки из базы слишком ресурсоемка для расширения. Поэтому решение, использующее БД, нам не подходит.Все, что нам остается — использовать файл. Для простоты реализации будем использовать текстовый файл следующего формата:

Использование этого формата не ведет к оптимальной производительности. Но это позволит сделать акцент на основных моментах, вместо того, чтобы погружаться в работу с бинарными файлами.

Увы, мы не можем просто так взять и получить доступ к одному файлу как из приложения, так и из расширения. Однако, если воспользоваться App Groups, это становится возможным.

Делимся контактами с помощью App Groups

App Group позволяет приложению и расширению получать доступ к общим данным. Более подробно написано в документации Apple. Если вы никогда с этим не работали — не страшно, сейчас я расскажу, как это настроить.

В Project navigator кликните по вашему проекту. Выберите target приложения, перейдите на вкладку Capabilities, включите App Groups. Добавьте группу «group.ru.touchin.TouchInApp». Логика тут та же, что и с bundle identifier. Просто добавьте префикс group. У меня bundle identifier — «ru.touchin.TouchInApp», соответственно, группа — «group.ru.touchin.TouchInApp».

Перейдите к target'у расширения, перейдите на вкладку Capabilities, включите App Groups. Там должна появиться группа, которую вы вводили ранее. Поставьте на ней галочку.

Если мы используем опцию «Automatically manage signing», App Groups настраиваются достаточно легко. Как видите, я уложился в пару абзацев. Благодаря этому я могу не превращать статью о CallKit в статью об App Groups. Но если вы используете профайлы из аккаунта разработчика, то нужно в аккаунте добавить App Group и включить ее в App ID приложения и расширения.

Записываем контакты в файл

После включения App Group можем получить доступ к контейнеру, в котором будет храниться наш файл. Делается это следующим образом:

let container = FileManager.default

.containerURL(forSecurityApplicationGroupIdentifier: "group.ru.touchin.TouchInApp")«group.ru.touchin.TouchInApp» — это наша App Group, которую мы только что добавили.

Назовем наш файл «contacts» и сформируем для него

URL:guard let fileUrl = FileManager.default

.containerURL(forSecurityApplicationGroupIdentifier: "group.ru.touchin.TouchInApp")?

.appendingPathComponent("contacts") else { return }Немного позже вы увидите полный код, сейчас я просто хочу пояснить некоторые моменты.

Теперь нужно записать в него номера и имена. Предполагается, что они у вас уже подготовлены в следующем виде:

let numbers = ["79214203692",

"79640982354",

"79982434663"]

let labels = ["Иванов Петр Петрович",

"Сергеев Иван Николаевич",

"Николаев Андрей Михайлович"]Напомню, что номера должны быть с правильным кодом страны и отсортированы в порядке возрастания.

Теперь сформируем из контактов будущее содержимое файла:

var string = ""

for (number, label) in zip(numbers, labels) {

string += "\(number),\(label)\n"

}

Каждую пару номер-имя записываем в одну строку, разделяя запятой. Завершаем символом перевода строки.

Записываем все это дело в файл:

try? string.write(to: fileUrl, atomically: true, encoding: .utf8)А теперь самое интересное. Нужно сообщить расширению, что миска наполнена и пора подкрепиться. Для этого вызовем следующую функцию:

CXCallDirectoryManager.sharedInstance.reloadExtension(

withIdentifier: "ru.touchin.TouchInApp.TouchInCallExtension")Параметр функции — bundle identifier расширения.

Полный код:

@IBAction func addContacts(_ sender: Any) {

let numbers = ["79214203692",

"79640982354",

"79982434663"]

let labels = ["Иванов Петр Петрович",

"Сергеев Иван Николаевич",

"Николаев Андрей Михайлович"]

writeFileForCallDirectory(numbers: numbers, labels: labels)

}

private func writeFileForCallDirectory(numbers: [String], labels: [String]) {

guard let fileUrl = FileManager.default

.containerURL(forSecurityApplicationGroupIdentifier: "group.ru.touchin.TouchInApp")?

.appendingPathComponent("contacts") else { return }

var string = ""

for (number, label) in zip(numbers, labels) {

string += "\(number),\(label)\n"

}

try? string.write(to: fileUrl, atomically: true, encoding: .utf8)

CXCallDirectoryManager.sharedInstance.reloadExtension(

withIdentifier: "ru.touchin.TouchInApp.TouchInCallExtension")

}

Читаем контакты из файла

Но это еще не все. Мы не подготовили расширение к тому, чтобы оно могло этот файл прочесть. Попросим его читать файл по одной строчке, вычленять из строки номер и имя. Дальше поступаем так же, как с тестовым номером.

Увы, iOS не предоставляет возможность читать текстовые файлы построчно. Воспользуемся подходом, предложенным пользователем StackOverflow. Скопируйте к себе класс

LineReader вместе с расширением.Вернемся к файлу CallDirectoryHandler.swift и внесем изменения. Сначала получим URL нашего файла. Делается это точно так же, как и в приложении. Затем инициализируем

LineReader путем к файлу. Читаем файл построчно и добавляем контакт за контактом.Код обновленной функции

addIdentificationPhoneNumbers:private func addIdentificationPhoneNumbers(to context: CXCallDirectoryExtensionContext) throws {

guard let fileUrl = FileManager.default

.containerURL(forSecurityApplicationGroupIdentifier: "group.ru.touchin.TouchInApp")?

.appendingPathComponent("contacts") else { return }

guard let reader = LineReader(path: fileUrl.path) else { return }

for line in reader {

autoreleasepool {

// удаляем перевод строки в конце

let line = line.trimmingCharacters(in: .whitespacesAndNewlines)

// отделяем номер от имени

var components = line.components(separatedBy: ",")

// приводим номер к Int64

guard let phone = Int64(components[0]) else { return }

let name = components[1]

context.addIdentificationEntry(withNextSequentialPhoneNumber: phone, label: name)

}

}

}

Функция должна использовать минимум ресурсов, поэтому заверните итерацию цикла в

autoreleasepool. Это позволит освобождать временные объекты и использовать меньше памяти.Все. Теперь после вызова функции

addContacts телефон будет способен определять номера из массива numbers.Окончательную версию проекта можете скачать в репозитории на GitHub.

Что дальше?

Это лишь один из вариантов решения задачи. Его можно улучшить, используя бинарный файл вместо текстового, как сделал 2GIS. Это позволит быстрей записывать и читать данные. Соответственно, придется продумать структуру файла, а также переписать функции для записи и чтения.

Когда у вас есть представление о том, как это работает, все в ваших руках.

|

Метки: author ivan1911 разработка под ios разработка мобильных приложений программирование swift блог компании touch instinct callkit ios |

Android Architecture Components. Часть 3. LiveData |

Компонент LiveData — предназначен для хранения объекта и разрешает подписаться на его изменения. Ключевой особенностью является то, что компонент осведомлен о жизненном цикле и позволяет не беспокоится о том на каком этапе сейчас находиться подписчик, в случае уничтожения подписчика, компонент отпишет его от себя. Для того чтоб LiveData учитывала жизненный цикл используется компонент Lifecycle, но также есть возможность использовать без привязки к жизненному циклу.

Сам компонент состоит из классов: LiveData, MutableLiveData, MediatorLiveData, LiveDataReactiveStreams, Transformations и интерфейса: Observer.

Класс LiveData, являет собой абстрактный дженериковый класс и инкапсулирует всю логику работы компонента. Соответственно для создания нашего LiveData холдера, необходимо наследовать этот класс, в качестве типизации указать тип который мы планируем в нем хранить, а также описать логику обновления хранимого объекта.

Для обновления значения мы должны передать его с помощью метода setValue(T), будьте внимательны поскольку этот метод нужно вызывать с main треда в противном случае мы получим IllegalStateException, если же нам нужно передать значение из другого потока можно использовать postValue(T), этот метод в свою очередь обновит значение в main треде. Интересной особенностью postValue(T) является еще то, что он в случае множественного вызова, не будет создавать очередь вызовов на main тред, а при исполнении кода в main треде возьмет последнее полученное им значение. Также в классе присутствует два калбека:

onActive() — будет вызван когда количество подписчиков изменит свое значение с 0 на 1.

onInactive() — будет вызван когда количество подписчиков изменит свое значение с 1 на 0.

Их назначение соответственно уведомить наш класс про то, что нужно обновлять даные или нет. По умолчанию они не имеют реализации, и для обработки этих событий мы должны переопределить эти методы.

Давайте рассмотрим как будет выглядеть наш LiveData класс, который будет хранить wife network name и в случае изменения будет его обновлять, для упрощения он реализован как синглтон.

public class NetworkLiveData extends LiveData {

private Context context;

private BroadcastReceiver broadcastReceiver;

private static NetworkLiveData instance;

public static NetworkLiveData getInstance(Context context){

if (instance==null){

instance = new NetworkLiveData(context.getApplicationContext());

}

return instance;

}

private NetworkLiveData(Context context) {

this.context = context;

}

private void prepareReceiver(Context context) {

IntentFilter filter = new IntentFilter();

filter.addAction("android.net.wifi.supplicant.CONNECTION_CHANGE");

filter.addAction("android.net.wifi.STATE_CHANGE");

broadcastReceiver = new BroadcastReceiver() {

@Override

public void onReceive(Context context, Intent intent) {

WifiManager wifiMgr = (WifiManager) context.getSystemService(Context.WIFI_SERVICE);

WifiInfo wifiInfo = wifiMgr.getConnectionInfo();

String name = wifiInfo.getSSID();

if (name.isEmpty()) {

setValue(null);

} else {

setValue(name);

}

}

};

context.registerReceiver(broadcastReceiver, filter);

}

@Override

protected void onActive() {

prepareReceiver(context);

}

@Override

protected void onInactive() {

context.unregisterReceiver(broadcastReceiver);

broadcastReceiver = null;

}

} В целом логика фрагмента следующая, если кто то подписывается, мы инициализируем BroadcastReceiver который будет нас уведомлять об изменении сети, после того как отписывается последний подписчик мы перестаем отслеживать изменения сети.

Для того чтоб добавить подписчика есть два метода: observe(LifecycleOwner, Observer

Выглядит это приблизительно так:

public class MainActivity extends LifecycleActivity implements Observer {

private TextView networkName;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

networkName = (TextView) findViewById(R.id.network_name);

NetworkLiveData.getInstance(this).observe(this,this);

//NetworkLiveData.getInstance(this).observeForever(this);

}

@Override

public void onChanged(@Nullable String s) {

networkName.setText(s);

}

} Примечание: Этот фрагмент только для примера, не используйте этот код в реальном проекте. Для работы с LiveData лучше использовать ViewModel(про этот компонент в следующей статье) или позаботиться про отписку обсервера вручную.

В случае использования observe(this,this) при повороте экрана мы будем каждый раз отписываться от нашего компонента и заново подписываться. А в случае использование observeForever(this) мы получим memory leak.

Помимо вышеупомянутых методов в api LiveData также входит getValue(), hasActiveObservers(), hasObservers(), removeObserver(Observer

Класс MutableLiveData, является расширением LiveData, с отличием в том что это не абстрактный класс и методы setValue(T) и postValue(T) выведены в api, тоесть публичные.

По факту класс является хелпером для тех случаев когда мы не хотим помещать логику обновления значения в LiveData, а лишь хотим использовать его как Holder.

void update(String someText){

ourMutableLiveData.setValue(String);

}

Класс MediatorLiveData, как понятно из названия это реализация паттерна медиатор, на всякий случай напомню: поведенческий паттерн, определяет объект, инкапсулирующий способ взаимодействия множества объектов, избавляя их от необходимости явно ссылаться друг на друга. Сам же класс расширяет MutableLiveData и добавляет к его API два метода: addSource(LiveData

Для примера создадим еще один класс LiveData, который будет хранить название нашей мобильной сети:

public class MobileNetworkLiveData extends LiveData {

private static MobileNetworkLiveData instance;

private Context context;

private MobileNetworkLiveData(Context context) {

this.context = context;

}

private MobileNetworkLiveData() {

}

@Override

protected void onActive() {

TelephonyManager telephonyManager = (TelephonyManager) context

.getSystemService(Context.TELEPHONY_SERVICE);

String networkOperator = telephonyManager.getNetworkOperatorName();

setValue(networkOperator);

}

public static MobileNetworkLiveData getInstance(Context context) {

if (instance == null) {

instance = new MobileNetworkLiveData(context);

}

return instance;

}

} И перепишем наше приложение так чтоб оно отображало название wifi сети, а если подключения к wifi нет, тогда название мобильной сети, для этого изменим MainActivity:

public class MainActivity extends LifecycleActivity implements Observer {

private MediatorLiveData mediatorLiveData;

private TextView networkName;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

networkName = (TextView) findViewById(R.id.network_name);

mediatorLiveData = new MediatorLiveData<>();

init();

}

private void init() {

final LiveData network = NetworkLiveData.getInstance(this);

final LiveData mobileNetwork = MobileNetworkLiveData.getInstance(this);

Observer networkObserver = new Observer() {

@Override

public void onChanged(@Nullable String s) {

if (!TextUtils.isEmpty(s))

mediatorLiveData.setValue(s);

else

mediatorLiveData.setValue(mobileNetwork.getValue());

}

};

Observer mobileNetworkObserver = new Observer() {

@Override

public void onChanged(@Nullable String s) {

if (TextUtils.isEmpty(network.getValue())){

mediatorLiveData.setValue(s);

}

}

};

mediatorLiveData.addSource(network, networkObserver);

mediatorLiveData.addSource(mobileNetwork,mobileNetworkObserver);

mediatorLiveData.observe(this, this);

}

@Override

public void onChanged(@Nullable String s) {

networkName.setText(s);

}

}

Как мы можем заметить, теперь наш UI подписан на MediatorLiveData и абстрагирован от конкретного источника данных. Стоит обратить внимание на то что значения в нашем медиаторе не зависят напрямую от источников и устанавливать его нужно в ручную.

Класс LiveDataReactiveStreams, название ввело меня в заблуждение поначалу, подумал что это расширение LiveData с помощью RX, по факту же, класс являет собой адаптер с двумя static методами: fromPublisher(Publisher

compile «android.arch.lifecycle:reactivestreams:$version»

Класс Transformations, являет собой хелпер для смены типизации LiveData, имеет два static метода:

map(LiveData

, где T — это типизация входящей LiveData, а P желаемая типизация исходящей, по факту же каждый раз когда будет происходить изменения в входящей LiveData она будет нотифицировать нашу исходящую, а та в свою очередь будет нотифицировать подписчиков после того как переконвертирует тип с помощью нашей реализации Function. Весь этот механизм работает за счет того что по факту исходящая LiveData, является MediatiorLiveData.

LiveData location = ...;

LiveData locationString = Transformations.map(location, new Function() {

@Override

public String apply(Location input) {

return input.toString;

}

}); switchMap(LiveData

LiveData location = ...;

LiveData getPlace(Location location) = ...;

LiveData userName = Transformations.switchMap(location, new Function>() {

@Override

public LiveData apply(Location input) {

return getPlace(input);

}

});

Базовый пример можно посмотреть в репозитории: git

Также полезные ссылки:

https://developer.android.com/topic/libraries/architecture/livedata.html

https://developer.android.com/reference/android/arch/lifecycle/LiveData.html

|

|

Правила хорошего тона для API |

О том, какие принципы и инструменты мы используем для добавления REST API к проектам, читайте под катом.

Существует множество фреймворков, ориентированных на разработку API. Особенно их много на NodeJS, но и на других языках – достаточно. Тем не менее, когда задача состоит в использовании существующего функционала и данных проекта, то менять его архитектуру в корне, переписывать всё на другом языке или фреймворке – нерационально. Мы пишем на своём фреймворке ZeroEngine, который ориентирован на высоконагруженные проекты и работает по принципу plug-in’ов. Кратко принцип работы ZeroEngine можно описать так: новый «модуль» можно встроить в любой уже существующий, а также перехватить управление выдачей в нужный момент.

Резюмируем вводные данные

Требуется написать REST API для сайта. Архитектура позволяет внедрить роутер и использовать существующий функционал полностью или частично.

При разработке в целом и, в частности, API, мы стараемся следовать законам логики и придерживаться семантических названий, методов и параметров. Вот примерный перечень внутренних требований, принятых в команде ZeroTech:

ДЕЙСТВИЕ /объект/идентификатор/метод

Метод и URL должны чётко описывать выполняемую методом API функцию. Строго говоря, при именовании метода API, метод запроса (GET, POST, PUT, DELETE) является в предложении «глаголом», а адрес представляет собой «путь» от общего к частному.

Например:

- GET /images («получить изображения») – вернёт список изображений;

- POST /image – опубликует изображение;

- PUT /image/123 – «положит» переданное значение в изображение номер 123.

Мы сознательно разделяем image и images, чтобы было сразу понятно, что именно придёт в ответ на запрос – массив или единичный объект.

Семантические ошибки

Для сообщения об ошибке мы не назначаем свои коды, а пользуемся стандартным набором HTTP-кодов. Чтобы упростить обработку на стороне приложения, код дублируется в теле ответа и дополняется описанием. Мы убеждены, что снабжать разработчика приложения длинным описанием всех ошибок не стоит выгоды в трафике во время отладки.

Меньше методов — меньше запросов

Когда вопрос касается читаемости кода и его повторного использования, лучше использовать большее количество независимых методов. Но при разработке API стоит минимизировать количество обращений к серверу, насколько это возможно. Проще говоря: данные, которые в приложении должны показываться вместе, отдавать нужно тоже вместе.

Не тестировать дважды

Разумеется, речь идёт о дублировании функциональных тестов модульными. Как и в остальных случаях, мы стараемся использовать инструменты по их назначению: юнит-тестами мы покрываем модули сайта и роутера, а сам API тестируем с помощью dredd и API Blueprint.

Разработка через документацию

Именно для этого мы используем API Blueprint и сервис apiary. Сначала мы описываем то, что хотим получить в итоге. Далее – продумываем структуру методов, их возвращаемые значения, варианты ошибок и прочее. Только после этого пишем API. Такой подход имеет множество преимуществ, и позволяет разработчикам API оперативно получать комментарии от разработчиков приложения, исключая двойную работу.

Версионность