Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

EBU R128/BS.1770-3: Пакетная нормализация громкости аудио/видео файлов, ч2 |

Настала пора выложить реализацию этой идеи.

Решение получилось гибкое и масштабируемое.

Для использования необходимо запастись знаниями матчасти звука и видео, мануалами по SoX — Sound eXchange, FFmpeg, а так же моим любимым пакетом AutoIt.

Реализация состоит в следующем:

Довольно не сложный скрипт (autoit) слушает ini файл, секциями которого являются папки, которые нужно слушать.

На каждую секцию открывается свой воркер (экземпляр скрипта), который считывает конфиг перед каждым прохдом по медиа файлу.

При удалении секции, воркер закрывается.

При закрытии главного воркера, все открытые воркеры закрываются.

Конфиг воркера имеет вид

[\\host\path\]

destination=\\host\path\

bak=\\host\path\

stmp=tmp\

tmp1=tmp\

tmp2=tmp\

otmp=tmp\

destinationExtension=.avi

threads=16

prepare_ffmpeg_cmd=-flags +ilme+ildct -deinterlace -c:v copy -c:a copy

ffmpeg_cmd=-flags +ilme+ildct -deinterlace -c:v copy -c:a copy

sox_cmd=compand 0.1,0.3 -90,-90,-70,-55,-50,-35,-31,-31,-21,-21,0,-20 0 0 0.1

Мануал:

1) destination

Куда складировать итоговые файлы.

2) bak

Куда складировать исходные файлы.

У меня исходные файлы лежат в сетевой корзине, файлы бекапятся в ту же корзину, в отдельную папочку.

3) временные каталоги

Подразумевается что на машине, которая выполняет обработку видеофайлов есть несколько физических носителей.

Например, у меня исходные файлы лежат в одной сетевой корзине, готовые файлы лежат во второй сетевой корзине, а обработку производит третья машина.

В третью машину я воткнул три жестких диска для временных файлов.

stmp

$sFile = $stmp & $tempFile & $sExtensionФайл с сетевой корзины прилетает на хард0

tmp1

$audioInputSox = $tmp1 & $tempFile & "_sox.wav"

$audioOutput = $tmp1 & $tempFile & "_norm.wav"Если в конфиге присутствует значение sox_cmd, то аудиоданные считываются с хард2 на и результат обработки записывается хард1

При нормализации громкости аудиоданные считываются с хард2 или хард1 (sox_cmd?) и записываются на хард1

tmp2

$audioInput = $tmp2 & $tempFile & ".wav"Исходный аудио поток видеофайла читается с хард0 на хард2

otmp

$outFile = $otmp & $tempFile & "_out" & $destinationExtensionПри сборке готового видеофайла видеопоток считывается с хард0 (stmp), аудиопоток считывется с хард1(tmp1), а результат записывается на хард2

4) destinationExtension

Контейнер результирующего видеофайла

5) threads

Записывает в командную строку сборки результирующего видеофайла threads=(threads) из конфига.

6) prepare_ffmpeg_cmd

Если не пусто, то выполняется

ffmpeg -y -ss 0:0:0.0 -r 25 -i [bak] [prepare_ffmpeg_cmd] [stmp]Иначе, исходный файл копируется из bak в stmp

7) ffmpeg_cmd

Считывается имя файла.

Если в конце имени файла присутствует конструкция вида {HH MM SS mm ss}, то начиная с кадра HH MM SS хвост файла будет приведен к хронометражу mm ss методом ускорения/замедления без искажения аудиодорожки.

Выполняется сборка результирующего файла командой

ffmpeg -i [stmp(video)] -i [tmp1(normalized -23LUFS audio)] [ffmpeg_cmd] -map 0:v -map 1:a -threads [threads] [otmp] -ysox_cmd

Перед нормализацией звука будет применен аудиофильтр

sox [tmp2] [tmp1] [sox_cmd]Вот, собственно, и весь нехитрый скрипт.

Очень удобно.

Папочки создает сам, файлы отслеживает, обрабатывает, складирует как надо, глючит очень редко, почти никогда.

Память не жрет, ведет себя достойно )))

Пользуйтесь на здоровье!

#Region ;**** Directives created by AutoIt3Wrapper_GUI ****

#AutoIt3Wrapper_Icon=C:\Program Files (x86)\AutoIt3\Icons\MyAutoIt3_Blue.ico

#AutoIt3Wrapper_Compile_Both=y

#AutoIt3Wrapper_UseX64=y

#EndRegion ;**** Directives created by AutoIt3Wrapper_GUI ****

#include

#include

Func randomString($digits)

Local $pwd = ""

Local $aSpace[3]

For $i = 1 To $digits

$aSpace[0] = Chr(Random(65, 90, 1)) ;A-Z

$aSpace[1] = Chr(Random(97, 122, 1)) ;a-z

$aSpace[2] = Chr(Random(48, 57, 1)) ;0-9

$pwd &= $aSpace[Random(0, 2, 1)]

Next

Return $pwd

EndFunc

$iniFile = "watch.ini"

Dim $run[0][2]

Dim $newRun[0]

Func TerminateChilds()

For $i = 0 to UBound($run) - 1

ProcessClose($run[$i][0])

Next

EndFunc

Local $source

If $CmdLine[0] == 0 Then

Local $i, $j, $exists, $pid

OnAutoItExitRegister ( "TerminateChilds" )

While 1

$source = IniReadSectionNames($iniFile)

For $i = 0 To UBound($run) - 1

$exists = False

For $j = 1 To $source[0]

If $source[$j] == $run[$i][1] Then $exists = True

Next

If Not $exists Then

ProcessClose($run[$i][0])

_ArrayDelete($run, $i)

ContinueLoop

EndIf

Next

For $i = 1 To $source[0]

$exists = False

For $j = 0 To UBound($run) - 1

If $source[$i] == $run[$j][1] Then $exists = True

Next

If Not $exists Then

$pid = Run(@ScriptName & " """ & $source[$i] & """")

Dim $temp[1][2] = [[$pid, $source[$i]]]

_ArrayAdd($run, $temp)

ContinueLoop

EndIf

Next

For $i = 0 To UBound($run) - 1

If ProcessExists($run[$i][0]) == 0 Then

$pid = Run(@ScriptName & " """ & $run[$i][1] & """")

$run[$i][0] = $pid

ContinueLoop

EndIf

Next

Sleep(1000)

WEnd

EndIf

MsgBox($MB_SYSTEMMODAL, $CmdLine[1], "I am started " & @CRLF & $CmdLine[1], 10)

Func Terminated()

MsgBox($MB_SYSTEMMODAL, $CmdLine[1], "I am terminated " & @CRLF & $CmdLine[1], 10)

EndFunc

OnAutoItExitRegister ( "Terminated" )

TraySetToolTip($CmdLine[1])

$tools = "bs1770gain-tools\"

Local $source = $CmdLine[1]

Local $destination = IniRead($iniFile, $source, "destination", Null)

Local $bak = IniRead($iniFile, $source, "bak", Null)

Local $stmp = IniRead($iniFile, $source, "stmp", Null)

Local $tmp1 = IniRead($iniFile, $source, "tmp1", Null)

Local $tmp2 = IniRead($iniFile, $source, "tmp2", Null)

Local $otmp = IniRead($iniFile, $source, "otmp", Null)

Local $ffmpeg_cmd = IniRead($iniFile, $source, "ffmpeg_cmd", Null)

Local $destinationExtension = IniRead($iniFile, $source, "destinationExtension", Null)

Local $threads = IniRead($iniFile, $source, "threads", Null)

Local $sox_cmd = IniRead($iniFile, $source, "sox_cmd", Null)

If Not FileExists($source) Then DirCreate($source)

If Not FileExists($bak) Then DirCreate($bak)

If Not FileExists($destination) Then DirCreate($destination)

If Not FileExists($stmp) Then DirCreate($stmp)

If Not FileExists($tmp1) Then DirCreate($tmp1)

If Not FileExists($tmp2) Then DirCreate($tmp2)

If Not FileExists($otmp) Then DirCreate($otmp)

Local $tempFile

Local $sFile

Local $descriptionFile

Local $audioInput

Local $audioOutput

Local $outFile

Local $sTitr

Local $eTitr

While 1

Local $files = _FileListToArray($source, "*", $FLTA_FILES, False)

Local $i = 1

For $i = 1 To Ubound($files) - 1

Local $f = $files[$i]

Local $sDrive = "", $sDir = "", $sFileName = "", $sExtension = ""

Local $aPathSplit = _PathSplit($f, $sDrive, $sDir, $sFileName, $sExtension)

Local $h = FileOpen($source & $sFileName & $sExtension, $FO_APPEND)

If $h == -1 Then ContinueLoop

FileClose($h)

Sleep(50)

Local $h = FileOpen($source & $sFileName & $sExtension, $FO_APPEND)

If $h == -1 Then ContinueLoop

FileClose($h)

Sleep(50)

Local $h = FileOpen($source & $sFileName & $sExtension, $FO_APPEND)

If $h == -1 Then ContinueLoop

FileClose($h)

Sleep(50)

Local $h = FileOpen($source & $sFileName & $sExtension, $FO_APPEND)

If $h == -1 Then ContinueLoop

FileClose($h)

$bak = IniRead($iniFile, $source, "bak", Null)

$destination = IniRead($iniFile, $source, "destination", Null)

$stmp = IniRead($iniFile, $source, "stmp", Null)

$tmp1 = IniRead($iniFile, $source, "tmp1", Null)

$tmp2 = IniRead($iniFile, $source, "tmp2", Null)

$otmp = IniRead($iniFile, $source, "otmp", Null)

$ffmpeg_cmd = IniRead($iniFile, $source, "ffmpeg_cmd", Null)

$destinationExtension = IniRead($iniFile, $source, "destinationExtension", Null)

$threads = IniRead($iniFile, $source, "threads", Null)

$sox_cmd = IniRead($iniFile, $source, "sox_cmd", Null)

$pre_cmd = IniRead($iniFile, $source, "prepare_ffmpeg_cmd", Null)

$tempFile = randomString(8)

$bak &= $sFileName & $sExtension

$sFile = $stmp & $tempFile & $sExtension

$descriptionFile = $tmp1 & $tempFile & $sExtension & ".ini"

$audioInput = $tmp2 & $tempFile & ".wav"

$audioInputSox = $tmp1 & $tempFile & "_sox.wav"

$audioOutput = $tmp1 & $tempFile & "_norm.wav"

$outFile = $otmp & $tempFile & "_out" & $destinationExtension

If FileMove($source & $sFileName & $sExtension, $bak, $FC_OVERWRITE) == 0 Then ContinueLoop

If Not $pre_cmd Then

If FileCopy($bak, $sFile, $FC_OVERWRITE) == 0 Then ContinueLoop

Else

$cmd_pre = $tools & "ffmpeg -y -ss 0:0:0.0 -r 25 -i """ & $bak & """ " & $pre_cmd & " " & $sFile

RunWait($cmd_pre)

EndIf

Sleep(100)

;$log = FileOpen($tempFile & ".bat", $FO_OVERWRITE + $FO_UTF8 + $FO_CREATEPATH)

$cmd_info = "cmd /c """ & $tools & "ffprobe -v quiet -print_format ini -show_format -show_streams " & $sFile & " > """ & $descriptionFile & """"

;FileWriteLine($log, $cmd_info)

RunWait($cmd_info)

$dur = Number(IniRead($descriptionFile, "streams.stream.0", "duration", Null))

$cmd_AudioInput = $tools & "ffmpeg -ss 0:0:0 -i " & $sFile & " -t " & $dur & " -vn -c:a pcm_s16le -af ""pan=stereo| FL < FL + 0.5*FC + 0.6*BL + 0.6*SL | FR < FR + 0.5*FC + 0.6*BR + 0.6*SR"" -ac 2 " & $audioInput & " -y -threads " & $threads

;FileWriteLine($log, $cmd_AudioInput)

RunWait($cmd_AudioInput)

Sleep(100)

$audioOutput = "tmp\" & $tempFile & ".flac"

If IsString($sox_cmd) And $sox_cmd <> "" Then

$audioOutput = "tmp\" & $tempFile & "_sox.flac"

$cmd_Sox = $tools & "sox " & $audioInput & " " & $audioInputSox & " " & $sox_cmd

;FileWriteLine($log, $cmd_Sox)

RunWait($cmd_Sox)

$audioInput = $audioInputSox

EndIf

$cmd_BS1770gain = "bs1770gain --ebu """ & $audioInput & """ -ao ""tmp"""

;FileWriteLine($log, $cmd_BS1770gain)

RunWait($cmd_BS1770gain)

Sleep(100)

$a = StringRegExp($sFileName, "^.+{(\d{2}) (\d{2}) (\d{2}) (\d{2}) (\d{2})}$", $STR_REGEXPARRAYGLOBALMATCH)

If @error Then

$cmd_Output = $tools & "ffmpeg -i " & $sFile & " -i " & $audioOutput & " " & $ffmpeg_cmd & " -map 0:v -map 1:a -threads " & $threads & " " & $outFile & " -y"

;FileWriteLine($log, $cmd_Output)

RunWait($cmd_Output)

Else

$titr_h = Number($a[0])

$titr_m = Number($a[1])

$titr_s = Number($a[2])

$dur_m = Number($a[3])

$dur_s = Number($a[4])

$dur = $dur - ($titr_h*60*60 + $titr_m*60 + $titr_s)

$dstDur = $dur_m*60 + $dur_s

$outDur = $titr_h*60*60 + $titr_m*60 + $titr_s + $dur_m*60 + $dur_s

$speed = $dstDur / $dur

$codec = IniRead($descriptionFile, "streams.stream.0", "codec_name", Null)

$sTitr = $tmp1 & $tempFile & "_stitr" & $sExtension

$eTitr = $tmp1 & $tempFile & "_etitr" & $sExtension

$cmd_ETirt = $tools & "ffmpeg -y -ss " & $titr_h & ":" & $titr_m & ":" & $titr_s & " -i " & $sFile & " -filter:v ""setpts=" & $speed & "*PTS"" -t 00:" & $dur_m & ":" & $dur_s & " -c:v " & $codec & " -qscale:v 0 -flags +ilme+ildct -deinterlace -an " & $eTitr

$cmd_STitr = $tools & "ffmpeg -y -ss 0:0:0 -i " & $sFile & " -t " & $titr_h & ":" & $titr_m & ":" & $titr_s & " -c:v copy -an " & $sTitr

$cmd_Output = $tools & "ffmpeg -y -i concat:""" & $sTitr & "|" & $eTitr & """ -i " & $audioOutput & " -t " & $outDur & " " & $ffmpeg_cmd & " -map 0:v -map 1:a -threads " & $threads & " " & $outFile

;FileWriteLine($log, $cmd_ETirt)

;FileWriteLine($log, $cmd_STitr)

;FileWriteLine($log, $cmd_Output)

RunWait($cmd_ETirt)

RunWait($cmd_STitr)

RunWait($cmd_Output)

EndIf

;FileClose($log)

FileMove($outFile, $destination & $sFileName & $destinationExtension, $FC_OVERWRITE)

Sleep(100)

FileDelete($sFile)

FileDelete($descriptionFile)

FileDelete($sTitr)

FileDelete($eTitr)

FileDelete($tmp2 & $tempFile & ".wav")

FileDelete($tmp1 & $tempFile & "_sox.wav")

FileDelete($tmp1 & $tempFile & "_norm.wav")

FileDelete($audioOutput)

;Exit

Next

Sleep(1000)

WEnd|

Метки: author AntonCheloshkin обработка изображений занимательные задачки open source ebu r128 bs.1770-3 bs1770gain sox ffmpeg |

Программисты-коммунисты всех стран, соединяйтесь |

Здравствуйте, товарищи.

Уже много коммунистов и людей, приближающихся к коммунистическим взглядам в разных странах, объединились в Техноком, чтобы полностью перестроить весь мир, создать всемирный технокоммунизм. Чтобы вместе создать систему, которая будет максимально эффективно управлять роботизированными производствами, транспортно-логистическими системами и т. д., для того чтобы освободить людям время для занятия самым важным: изучением космоса, семьёй, развитием, творчеством, путешествиями и многим другим.

Нам нужны и вы.

Вот тут на Гиктаймсе предыдущий материал с предыдсторией проекта, где есть все ссылки. Бывает, что я пишу так много букв, что читаешь и сам чувствуешь что многовато, с одной стороны хочется сразу и больше рассказать, с другой стороны хочется, чтобы материал был как бы просторнее, без лишнего нагромождения букв, так, чтобы были формулировки, картинки / видео, на которых можно остановится, посмотреть, задуматься. В общем, в этой статье постараюсь уменьшить количество букв. Ведь действительно продуманную, четко сформулированную идею, мысль, можно выразить любым количеством слов.

Что такое Техноком?

Не успел опомниться, как руки уже начали молотить три абзаца описания про роботизированные производства, освобождение людей и так далее. Но сдержимся. Техноком — это путь к технокоммунизму через создание всемирной автоматизированной системы. Технокоммунизм — это коммунизм, а так называется, чтобы подчеркнуть, что это делается через максимальное внедрение передовых технологий во все сферы жизни людей, в одну из первых очередей в сферу образования, а не при помощи волшебных заклинаний типа: «Олигархия уйди», не при помощи волшебных грибов и т.д. Дальше сначала опишу основную концепцию, потом будет схема, картинки, видео.

Задачи и ресурсы

Светлое будущее мы построим, постепенно объединив ресурсы всего мира и создав всемирное планирование всего и вся. Для того чтобы помочь людям объединяться здесь и сейчас, а не ждать, когда это вдруг само по волшебству случится, первым блоком Технокома создаётся умная социальная сеть с функционалом управления проектами, ресурсами и т.д.

Работает это так. Человек заходит на главную страницу «Поехали!» умной социальной сети (первая картинка этой статьи — это её скриншот), читает призыв присоединится или выбирает свой язык; если он определился неправильно (уже несколько языков есть), нажимает на кнопку «Да, я с вами» и … и сейчас нормально не доделано, сейчас человек просто заполняет информацию о себе и всё, дальше попадает в социальную сеть. Ну ещё текст на странице «Поехали!» меняется, там появляются ссылки на разные сообщества, ссылка на вступление в команду Технокома. Потом мы вручную его добавляем в разные чаты и системы, и только после этого человек видит, как много тут всего интересного. А будет по-другому, автоматизировано.

Сначала человек будет попадать на страницу, где ему в общих словах рассказывается, как именно мы видим светлое будущее, там будет и про устройство управления мира через различные электронные Советы, и про сохранение биологической семьи, где мужчина, женщина, дети, и про сохранение баланса экосистемы планеты, и важность космической экспансии и некоторые другие аспекты. Под каждым абзацем чекбокс «Я согласен». Это чтобы никто не тратил своё время, ошибочно полагая, что мы за фантазийный мир, где летают добрые драконы, нет общей идеологии, где люди просто живут и мир сохраняется без специальной системы образования и контроля. По нашему мнению, это бред, ну в смысле фэнтази, а в реальном мире только общая идеология, направляющая система образования и много других антианархичных вещей, могут сохранять мир и дать счастье людям. Здесь и сейчас нужно, чтобы объединялись миллиарды наших единомышленников, а наши “пока не единомышленники” пусть занимаются своими делами, смотрят, как по миру поднимаются наши роботизированные красные флаги, как улучшается жизнь людей, кто-то безуспешно противостоит эволюционному переходу к коммунистическому обществу, потом постепенно пропитываются нашими идеалами и вливаются в наши ряды. В общем, я думаю, вы понимаете, что сейчас мы не хотим отвлекать от дел какого-нибудь человека либерального настроя, которого мучают галлюцинации про невидимую руку рынка, которая что-то там организовывает и так далее.

Дальше люди присоединяются к разным типам сообществ, описывают свои ресурсы, задачи и т.д. На странице «Поехали!» видят, что они могут сделать здесь и сейчас, чтобы достичь различных важных целей. Ресурсы (в том числе компетенции) людей и организаций автоматически концентрируются в ближайших Советах и так далее. Человеку выдаётся информация на основе умных методологий, что и как он может сделать. Например: “В вашей местности проживает ещё 681 человек, которые хотят создать народное предприятие, где все работники являются собственниками, у вас указаны необходимые компетенции, вы хотите узнать больше и присоединиться?” В общем, не буду долго расписывать, суть вы поняли, будем делать так, что только человек нажал на главной странице на кнопку “Да, я с вами” и через 30 минут он объединяется с кучей людей по разным направлениям, добавлен в нужные образовательные курсы, вступил в профсоюз и создаёт народное предприятие или уже подал заявку на работу в существующее народное предприятие. Тут и автоматическая генерация всех документов и так далее.

Сейчас на рабочей версии Задачи выглядят плохо, но уже доделывается новая версия, на основе которой будут сделаны и ресурсы, и личные медицинские задачи и многое другое, в отображении общим выводом в общественном проекте выглядит примерно вот так.

Сообщества

Сейчас реализованы два типа сообществ: Общественные проекты и группы. Наши дизайнеры постепенно заполняют сообщества индивидуальными аватарами и обложками в соответствии с тематикой, делают картинки-коллажи в описания. Общественные проекты — это одна из верхних частей общего планирования, в которые будут вливаться групповые и личные проекты по различным направлениям. Общественные проекты есть разные, по разной теме, в конечном итоге должны охватывать все основные направления развития человечества. Ниже я дам чуть больше информации по некоторым Общественным проектам.

Есть в Технокоме люди, которые очень хорошо разбираются в различных вопросах, они ведут различные информационные группы.

Когда будет доделан функционал задач (в том числе действий по ним) и функционал ресурсов в Общественных проектах, тогда клонировав их и добавив другой функционал, будет создан функционал Советов. В Советы, как я говорил выше, будет автоматически агрегироваться ресурсы, компетенции и т.д. Всё это будет собираться на основе ресурсных конфигураций разных уровней, от небольших устройств, до ресурсов для создания крупных производств, принадлежащих всему обществу.

После Советов будет создан функционал Организаций, там будет тоже специфический функционал, будет возможность выстраивать цепочки между организациями. В самом простом моменте функционал Организаций поможет людям автоматически создать кооператив, народное предприятие, профсоюз. Все документы будут сгенерированы автоматически, новые люди будут автоматически присоединиться, также будет создана юридическая платформа чтобы людям даже не пришлось вначале что-то регистрировать, какие-то юр. лица, будут внешние юр. лица, которые будут выполнять функцию коннекторов с юридическими пространствами государств, а внутри будет общее всемирное пространство, в рамках которого люди смогут эффективно и надёжно между собой сотрудничать. Также будет система электронного управления организациями и т.д. Ну на первом этапе будет всё попроще, то что я написал в начале.

Я думаю, многие читали и думали, а где они собираются деньги для этого брать? И тут увидели написанное про организации и подумали, что будут какие-то платные услуги, проценты или что-то такое. Нет, всё бесплатно, мы строим технокоммунизм. А ресурсы мы берём и будем брать из множества источников. Сейчас просто делаем то, что нам нравится, во что верим. Часто в свободное от основной работы время, кто-то может себе позволить заниматься этим большую часть времени. А дальше будут созданы различные Организации, где все мы сможем принимать участие в работе, постепенно будет внедряться безденежное общество и так далее. Об этом подробнее будет ниже.

На чём делается

Изначально, поскольку кругом было нытьё о том, что это сделать “неееевозможно”, задача была показать, что можно делать на чём угодно, чтобы пройти первые шаги, своим примером помочь многим другим людям поверить в свои силы, поэтому был выбран самый показательный путь в виде WordPress и куча плагинов для него, в том числе сейчас пишутся свои. Постепенно собирается конфигурация из разных движков, мониторим, чтобы это не умерло, а наоборот развивалось и на следующий этап развития для создания уже максимально производительного решения накапливаем компетенции. Исходя из текущего развития событий, того, какими навыками обладают вновь присоединившиеся члены команды Технокома, получается, что мы будем делать новый более производительный движок в основном на Python. Но мы ожидаем что развитие текущей конфигурации, центральное звено которой на PHP ещё долго послужит нам. В общем, нам нужны PHP-шники и любые другие программисты, нам нужны админы, нам нужны все. Ничто в техническом плане не догма, если придёт толпа супер-спецов по Ruby, то и им найдётся место. Всё по всей работе Технокома делается и будет делаться в рамках открытых лицензий, это касается и ПО, и железа. Знания должны быть свободны и доступны всем людям.

Вот такая конфигурация, многое находится в тестовом режиме, недоступно пользователям, сейчас проводится интеграция, а это как всегда отдельная головная боль. Специалисты которые усилят наше интеграционное направление, тоже будут полезны.

Наши в городе

Если говорить о людях, то народу уже много, ниже карта городов активных участников, это называется первый круг — те, кто регулярно проявляют активность; иногда люди уходят во второй круг, их активность снижается. Вначале это приводило к тому, что из-за этого какие-то направления глохли, но по мере увеличения количества людей, волновая динамика активности одних людей, пересекается с активностью других людей, поэтому сейчас в целом активность нарастает почти без падений. Если говорить об активности программистов, есть такая проблема, что программисты в Технокоме не хотят быть программистами. Ну они и так весь день что-то где-то там пишут, а Техноком для них возможность переключиться, отдохнуть от капиталистического мира и от кодерства, поэтому они активно вовлечены в какие-нибудь проекты электронных теплиц, обсуждения космической экспансии и т.д., а программистких мощностей не хватает. Технокому нужно больше программистов, которые хотят программировать.

Постепенно продвигаемся в медиа-сфере, в Сербии по государственному телевизору Воеводины показали про Техноком (вот запись), на YouTube каналах инфа выходит. Сейчас готовимся к новому рывку. Общаюсь, налаживаю контакты с некоторыми медиа-известными людьми. Весело получилось с Константином Сёминым. Мы обозначили круг идеологически близких нам медиа-лиц, с которыми хотим познакомится, в том числе с Константином. Узнал его контактные данные через общих знакомых, списались, договорились, что как он разгребётся, можем записать с ним видео. Прошло полтора месяца, он всё по командировкам ездил, я как-то на очередном нашем общем разговоре озвучил, что можно ему напомнить про нас, в шутку говорю, что можно к нему кого-то послать, сказать что-то типа: «У Технокома длинные руки». И только я это сказал, через несколько дней, Константин Сёмин приехал в Крым, в гостинице шёл в свой номер, тут его видит один из наших сторонников, который там случайно оказался, ну и подошёл,

Ещё интересный случай получился. У Технокома в Мариуполе даже первый партизан нашёлся. Я однажды случайно заметил, что один человек активно поддерживает нашу инфу во ВКонтакте, написал ему, предложил присоединятся к Технокому, а он рассказал, что он уже давно для Технокома разрабатывает автоматизированную систему аналитики и поиска новых единомышленников через социальные сети, решил, что пока не сделает не будет в команду Технокома вступать, в общем, партизанил отдельно пока альфу-версию не сделал, сейчас вступил в команду, будем это доделывать и расширять наши мощности по привлечению людей в стройные ряды Технокома.

Эффективность

В начале с эффективностью было совсем плохо. Система работы, взаимодействия была не отлажена, и вообще брррр. Собрались люди с разной ИТ-религией, кто-то про одно говорит, кто-то про другое. И сейчас ещё переходное состояние, не всё отлажено. Получалось как в известной басне «Лебедь, Рак и Робот». Лебедь рвется в облака, Рак пятится назад, а Роботу это всё надоело, он пострелял их лазером и сказал, что пока не сделали то крутое специализированное решение, которое мы задумали в Технокоме, будет Redmine.

Сейчас с эффективностью действий намного лучше, хоть и всё равно ещё хуже, чем хочется. Но постоянно ищем способы делать больше, эффективнее. Вот пример с документами, точнее с различными правилами, лицензионными соглашениями и так далее. Раз мы делаем ресурс, куда будут со всего мира мощным потоком засасываться люди, чтобы помочь им действовать сообща на основе умных методологий, нужно соблюдать различные юридические нормы, нужно себя защищать через различные юридические механизмы. Когда перед запуском активной работы по созданию Технокома я об этом рассказывал в разных местах, был один из пунктов, который мне озвучивали люди про то, что без бесконечного количества миллионов долларов одной агрессивной северо-американской страны, ничего не получится. В перечислении говорили и: "… а ещё вы хоть понимаете, что вот их (ВКонтакте, Фейсбук и т.д.) всякие лицензионные соглашения, правила, уведомления, это всё прорабатывалось кучей дорогих юристов, на разных языках, одно это стоит много миллионов? Вы понимаете, что вы не можете просто взять их документы, они вас засудят?". Ну вот когда дошло дело до этого вопроса, я просто написал во ВКонтакте и просил: “Можно мы возьмём у вас все ваши документы и для себя адаптируем?”. Они ответили, что можно. Конечно, такие большие документы и адаптировать под себя не совсем просто, но опыт есть и юристы к команде Технокома уже тоже присоединяются. Получается, что мне дольше рассказывали о том, что это невозможно, чем у меня заняло время написать спросить и получить ответ, что можно. Это не означает, что всё у нас получается так легко, это означает что не нужно себе придумывать лишние преграды. И это, кстати, снова ответ на вопрос о том, где мы собираемся брать ресурсы для такого большого дела. Поскольку у нас не стоит задача освоить государственный бюджет или деньги инвесторов себе в карман, у нас всё получается очень экономно и даже бесплатно.

В общем, повышаем автоматизацию, а пока в разных местах, разными способами взаимодействуем. Вот скриншот перечня некоторых чатов в Телеграме.

Новый Ленинград

Выше я говорил в общем про Общественные проекты Технокома. Теперь опишу несколько, по которым сейчас постоянно повышается активность, начну с Нового Ленинграда — это высокотехнологичный город будущего, который проектируется уже сейчас. Повсеместное внедрение автоматизации, высочайшие экологические стандарты. Определено перспективное место для строительства на берегу Чудского озера: Псковская область, Гдовский район, Юшкинская волость. Центральный ориентир устье реки Куна. Для этой местности и началась постепенная разработка проекта. Основная специализация производственных и научных мощностей Нового Ленинграда будет робототехника, в том числе промышленная и медицинская. По большинству показателей, в том числе производству растительных продуктов питания город будет автономным. Важная часть проработки проекта — это его возможность реализовать здесь и сейчас, в рамках текущих экономических и политических реалий. Сейчас, когда готовится очередное переизбрание Владимира Путина, удачный момент для популяризации проекта. По этой ссылке краткая версия футуристичного агитационного видео по Новому Ленинграду выполненного в форме обращения к Путину, там есть ссылка на полную версию.

В центре Нового Ленинграда будут находится пять университетов: Университет Технокоммунизма, Университет космоса, Университет бессмертия, Университет природы и Университет культуры. Здания показаны пока условно, их предполагаемый архитектурный облик описан, но пока почти не реализован. Нужно больше архитекторов, проектировщиков городской среды и так далее.

Общий вид первой очереди Нового Ленинграда на реальной местности приблизительно вот такой.

Платформа Робот-1

Задача — с нуля создать всемирную сеть роботизированных производств. У нас накопилось уже несколько чатов людей, которые прорабатывают различные вопросы автоматизации (в том числе программистов, которые не хотят быть программистами), предлагают свои схемы, паяют разные устройства. Теперь мы объединим всё это в один проект.

Это важный вопрос и есть классные идеи, как раскрутить этот проект. Начнётся с одной мигающей лампочки, потом будут прирастать модули, будет создано первое роботизированное производство модульных развивающих детских игрушек, потом модульное производство еды, чтобы освободить людям больше времени жизни для развития и так далее. Важная часть платформы Робот-1 в том, чтобы использовать те технологии, что есть здесь и сейчас. Много написано в различных проектах о том, что вот когда будет создана, например более продвинутая робо-рука манипулятор, вот тогда можно будет создать компактные производства и т.д. Ну пусть они будут не компактные. У Технокома есть всё, что нужно для обеспечения текущего шага. Есть земля, есть помещения. Народу много, многие нахомячили себе много всего интересного и сейчас всё идёт на благо создания светлого будущего. Создание сети роботизированных производств — это основа для создания безденежного общества, люди смогут получать блага просто потому, что они им нужны, потому что мы все живём в одном обществе и у нас общие главные цели.

А вообще когда стал вопрос о том, что пришло время в Технокоме поднимать направление автоматизации, я в нашей лаборатории собрал с полок кучу вещей и записал первое видео, в стиле “Как это можно приспособить”, после чего начали набираться люди по этой теме. Тут главное не молчать, озвучить идеи, подходы, а народ подтянется.

Справедливая криптовалюта

Долго нам со всех сторон говорили, что нам нужно запустить свою криптовалюту, подкрепленную нашими возможностями, в том числе производственными, которые мы будем запускать, чтобы люди вместо того чтобы покупать какие-то абсолютно виртуальные токены, поддерживали наше развитие. Постепенно набрался целый чат по этой теме в 22 человека. Долго не было понятной концепции, достаточного количества компетенций. Этот вопрос назревал, в конечном итоге когда прояснилась возможная концепция создания справедливой криптовалюты Инмо (Inmo — Internacia mono — Международные деньги, на международном языке эсперанто), нашлись программисты с нужными скилами и даже присоединился к Технокому директор коммерческого центра в Луганске и рассказал, как они там мучаются, организовывая платежи между людьми в рамках их зависшего в воздухе правового статуса, в нескольких валютах, с поставками товаров из разных противоборствующих государств и т.д., тогда пришло время запускать предпроектную работу по этому вопросу. В записи видео-конференции, которая ниже, более подробно рассказывается, кратко лишь могу сказать:

1. Техноком пока не запускает криптовалюту, мы в первую очередь сосредоточены на создании безденежного общества, в частности для этого важно развитие платформы Робот-1, а нужен ли на пути к этому такой шаг как создание своей криптовалюты, этот вопрос всесторонне рассматривается. На данный момент мы склоняемся к тому что это можно сделать, когда будут решены все организационные и технические вопросы, для того чтобы качественно поддерживать это решение, нужно больше технических специалистов — программистов, которые глубоко разбираются в этом вопросе, “криптоэкономистов” конечно уже дофига, но лучше, если их будет ещё больше;

2. Поскольку скилы были по Dash, сейчас клонируется он и на нём будут обкатываться различные модели. Также хотим посмотреть другие движки, возможно тот же Ethereum, когда по ним будут скилы;

3. Не будет дикого майнинга для зашибания бабла. Есть много предложений, в частности я предложил, что даже если будет какой-то сторонний майнинг, для начала 99% полученного майнерами будут идти в различные фонды и 1% майнеру. При разных обстоятельствах это пропорция может двигаться, но концепция останется неизменной, майнеру будет доставаться очень мало. Мотивация майнеров будет в том, что значительная часть отчислений будет идти в Фонд стабилизации и развития, задача которого будет в том чтобы сначала сформировать ликвидность с другими криптовалютами, как минимум, а потом на создание производств, чтобы криптовалюта обеспечивалась реальной товарной ликвидностью. Также будут реализовываться социальные программы, даже выплаты пенсий и пособий, чтобы и в этом вопросе дать ответ фиатным государственным деньгам. Вообще много других вещей запланировано (чат бурный, идеями искрит, только успевай записывать), чтобы если будем делать Инмо, чтобы это был не ещё один клон, а совершенно новое, интересное для разных стран и сообществ и самое главное полезное для общества.

Модульные передвижные дома

Новый интересный Общественный проект Технокома, который вот только начал оживать, потому что накопились люди, которые интересуются этой темой и даже что-то шарят в ней.

Сейчас запланировано:

— Объединить множество отдельных проектов модульных передвижных домов, в первую очередь домов-трансформеров и разработать новые, создать единую платформу;

— Создать в разных местах производственные мощности;

— Создать базу существующих площадок и возможностей для размещения там передвижного дома и создать новые площадки.

В этой платформе собираемся реализовать варианты не только с максимальной мобильностью, но и варианты с ограничением по мобильности, с высоким удобством. Например, перечень прицепов-комнат, которые можно состыковать в длинный большой дом, перевозить сразу быстро это не получится, но можно в новый город перевезти за несколько рейсов, для тех, кто хочет жить в нескольких городах. Например я когда нахожусь в России живу в Санкт-Петербурге, но на лето перевозил бы свой дом из нескольких прицепов куда-нибудь в Краснодарский край или в Абхазию.

Своего пока ничего не нарисовали, и тем более не спроектировали, сейчас занимаемся сбором информации, вот 3 видео той концепции, которую планируем реализовать. Только нужно будет хорошо подумать над тем, как это сделать сильно недорого, как это приспособить и для относительно северных погодных условий. Также к основным модулям будут технические модули, для повышения автономности: с большим баком для воды, с генератором, туда же и баню можно встроить.

Вариант из нескольких блоков, там расставляются основания под упоры, это не подготовленный фундамент

Одноблочный вариант, это видео тестирования, где показано, что и куда движется

Вариант сильно проще

Резюмирую

Призываю всех присоединяться к команде Технокома, пишите мне в личку и я всё расскажу. Мы в чём-то ещё в начале пути, а в чём-то уже хорошо продвинулись. Нам не нужно меньшее, чем всемирный технокоммунизм, и шаг за шагом мы к нему идём. То, на что мы нацелились, ещё пока никто не делал и нам бывает совсем не легко, но чем больше нас становится, чем больше у нас сил, тем быстрее и легче получаются новые шаги.

Присоединяйтесь к команде Технокома и вы получите возможность делать невероятное под вдохновляющий крик толпы о том, что у нас ничего не получится и мы придурки. На вас будут показывать пальцем, возможно даже Word, когда вы будете писать «технокоммунизм» будет над вами издеваться и спрашивать: «Возможно вы имели ввиду технолиберализм?». Но вы справитесь, станете сильнее, когда вас будут посылать, научитесь не обижаться, а спрашивать точные спутниковые координаты этого места. У нас есть ответы на многие вопросы, в том числе и на вопрос: «С чего вы взяли, что вам дадут это сделать?». Ответы на вопросы это тема другого материала. Сейчас я только озвучу ответ на вопрос: «Когда это всё получится?». У нас ответ на этот вопрос вызвал бурную дискуссию, которая ещё продолжается, я отвечаю, что, во-первых, многое уже получается, поскольку большая цель состоит из множества небольших задач и многие из этих задач мы уже решили, а во-вторых, мы поставили себе дату 01 октября 2026 года (10-летие запуска Технокома), к которой мы должны достичь максимального результата, например, более половины людей планеты перевести на единую систему планирования, работы, взаимодействий и теперь напрягаем мозг и другие части тела, чтобы придумать, как этого достичь. Это может получится, но даже если мы достигнем несколько процентов от этой цели, это будет уже значительное достижение.

В общем, обещать можем только то, что мы не остановимся в нашем пути к цели, и что у нас интересно.

|

|

[Из песочницы] Создание Angular 2+ компонентов с возможностью переключения темы |

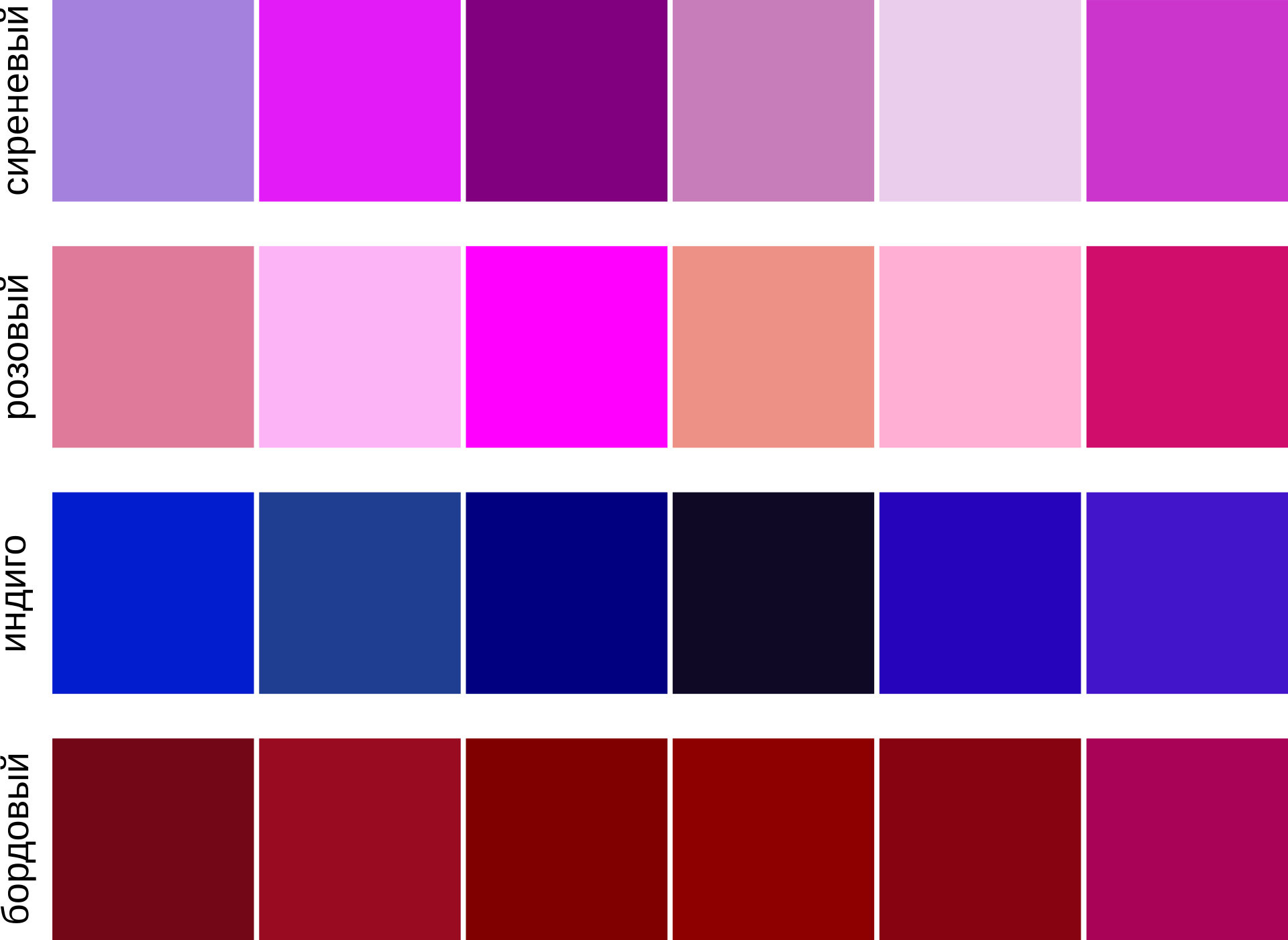

Итак, допустим мы пишем сайт, на котором нужно реализовать возможность динамического переключения настроек внешнего вида, или, проще говоря, темы. Темой (theme) будем называть набор свойств, определяющих внешний вид компонентов (да и вообще всего сайта).

Допустим, у нас есть одностраничное приложение на Angular, и пусть в нем будет ооочень много компонентов, и один из них — ButtonComponent (к компоненту подключим стили из button.component.css), на примере которого и рассмотрим весь механизм. И нужно реализовать возможность переключения между двумя темами: «dark» и «light», которые у нас будут отличаться только цветами (а в общем случае можно выносить в тему что угодно, размеры там, шрифты, картинки бэкграунда и т.п. — все, чем можно управлять из css).

Исходные стили «light» выглядели так, например:

.my-button {

padding: 10px;

font-size: 14px;

color: midnightblue;

border: 1px solid mdnightblue;

background: white;

cursor: pointer;

}

my-button:disabled {

pointer-events: none;

cursor: default;

color: grey;

border: 1px solid grey;

}

А для «dark» вот так:

.my-button {

padding: 10px;

font-size: 14px;

color: lightblue;

border: 1px solid lightblue;

background: midnightblue;

cursor: pointer;

}

.my-button:disabled {

pointer-events: none;

cursor: default;

background: grey;

color: lightgrey;

border: 1px solid lightgrey;

}

Выделим общую часть и сохраним ее в отдельный файл. Пусть он лежит там же, в папке с нашим компонентом, и называется button-core.component.css. Так же создадим по одному файлу для каждой темы, назовем их соответственно button-light.component.css и button-dark.component.css. Уже понятно, что в них будет, но для полноты все же приведу код (кто не хочет его видеть — смело скролльте):

button-core.css:

.my-button {

padding: 10px;

font-size: 14px;

cursor: pointer;

}

.my-button:disabled {

pointer-events: none;

cursor: default;

}

button-light.css:

.my-button {

color: midnightblue;

border: 1px solid mdnightblue;

background: white;

}

my-button:disabled {

color: grey;

border: 1px solid grey;

}

button-dark.css:

.my-button {

color: lightblue;

border: 1px solid lightblue;

background: midnightblue;

}

.my-button:disabled {

background: grey;

color: lightgrey;

border: 1px solid lightgrey;

}

И в конце концов, сам button.component.css будет выглядеть вот так:

@import 'button-core.css'

@import 'button-light.css'

@import 'button-dark.css'

Отметим, что сначала стоит подключить общие настройки для всех тем, затем файл с дефолтной темой, а потом уже все остальные.

А теперь посмотрим, как же мы можем переключиться с одной темы на другую, в том числе из кода.

Для этого нам понадобится селектор :host-context(). Что он делает? Этот селектор ищет определенный css — класс, пробегая по всем родителям элемента, до самого корня. И если он этот класс встречает, то применяет описанные изменения. А лучше немного отвлечемся от нашей кнопки и рассмотрим его работу на примере. Вот пусть у нас есть два вложенных компонента: parent-component и child-component. Стили их изолированы друг от друга, спасибо Angular, и это хорошо, но мы хотим иногда изменять вид child-component в зависимости, скажем, от того, наведен ли курсор на parent-component (событие hover). Можно было бы, конечно, убрать инкапсуляцию при помощи ViewEncapsulation: none, или завести в child-component для этих целей Input — переменную, но намного проще и правильней поступить так:

:host-context(.parent-component:hover) .child-component {

background: lightcoral;

}

Вернемся к нашей кномке. Можно в качестве маркера для хост-контекст поставить какой-нибудь стиль (:host-context(.some-style)), что нам и нужно сделать. Теперь файлы light-темы будет выглядеть так:

button-light.css:

:host-context(.light-theme) .my-button {

color: midnightblue;

border: 1px solid mdnightblue;

background: white;

}

:host-context(.light-theme) my-button:disabled {

color: grey;

border: 1px solid grey;

}

Для dark-theme аналогично.

Что мы получили? Теперь, стоит нам только у одного из родительских элементов нашей кнопки установить класс light-theme или dark-theme, как она изменит свой вид, подключив соответствующие классы из наших файлов. Чаще всего, тема применяется сразу ко всему приложению, а это значит, что переключать тему стоит на корневом элементе, например на внешнем div из app-component (ну или того компонента, который вы прописываете в bootstrap вашего приложения). Можно завести в нем флажок theme и на внешний элемент навесить

[ngClass]="{'light-theme': theme === 'light', 'dark-theme': theme === 'dark'}".Ну да что уже дальше рассказывать, вроде и так все ясно.

Вот такой простенький способ создания тем без использования css — препроцессоров. Способ несовершенен, т.к. предполагает много копипасты. С препроцессорами типа sass возможно более лаконичное создание тем. Однако, этот способ тоже имеет право на жизнь.

Всем спасибо за внимание, надеюсь, кому-нибудь это окажется полезным. За основу взята статья, все идеи, в общем то, оттуда.

|

Метки: author sunnywhale css angularjs angular2 angular angular4 component theme |

Делаем приложения с поиском на Go |

Однажды в рассылке Golang Weekly мне попался проект Bleve. Это полнотекстовый поиск, который написан на Go. Проект интересный, и появилось бешеное желание получить с ним опыт работы.

Bleve может хранить данные в разных embedded БД:

- BoltDB (использует по умолчанию)

- LevelDB

- RocksDB

- Goleveldb

- forestdb

- Gtreap

Работать с Bleve просто:

import "github.com/blevesearch/bleve"

func main() {

// Откроем новый индекс

mapping := bleve.NewIndexMapping()

index, err := bleve.New("example.bleve", mapping)

// Положим не много данных

err = index.Index(identifier, your_data)

// Найдем что-нибудь

query := bleve.NewMatchQuery("text")

search := bleve.NewSearchRequest(query)

searchResults, err := index.Search(search)

}Все просто и понятно. Но выглядит оно не с реального мира. Чтобы быть ближе к реальному миру, сделаем бота для Slack, который будет хранить историю.

Архитектура бота

Сервис для работы со slack;

Сервис индекс. Для хранения и поиска сообщений.

План

- Берем https://api.slack.com/methods/channels.history для работы со слаком;

- Берем Bleve для поиска и хранения истории;

- Если к нам пришло сообщение не по меншну бота — кладем в индекс;

- Если пришло сообщение с меншном — чистим и ищем по текущему каналу;

Slack

Со слаком все просто и пример по сути будет чуть сложнее, чем пример из репо

Единственное, что нам потребуется — два метода, чтобы проверить, адресовано ли боту сообщение и очистить его от имени бота

import "strings"

func isToMe(message string) bool {

return strings.Contains(message, fmt.Sprintf("<@%s>", ss.me))

}

func cleanMessage(message string) string {

return strings.Replace(message, fmt.Sprintf("<@%s> ", ss.me), "", -1)

}Bleve

Учитывая то, что я люблю использовать goleveldb как встраиваемую БД для своих проектов. В этом проекте решил использовать ее же.

Хранить в Bleve будем данные посложнее в виде:

type IndexData struct {

ID string `json:"id"`

Username string `json:"username"`

Message string `json:"message"`

Channel string `json:"channel"`

Timestamp string `json:"timestamp"`

}Создадим индекс с Goleveldb в качестве БД:

import (

"github.com/blevesearch/bleve"

"github.com/blevesearch/bleve/index/store/goleveldb"

)

func createIndex() (bleve.Index, error) {

indexName := "history.bleve"

index, err := bleve.Open(indexName)

if err == bleve.ErrorIndexPathDoesNotExist {

mapping := buildMapping()

kvStore := goleveldb.Name

kvConfig := map[string]interface{}{

"create_if_missing": true,

}

index, err = bleve.NewUsing(indexName, mapping, "upside_down", kvStore, kvConfig)

}

if err != nil {

return err

}

}и метод buildMapping, который создаст нам mapping для хранения:

func (ss *SearchService) buildMapping() *bleve.IndexMapping {

ruFieldMapping := bleve.NewTextFieldMapping()

ruFieldMapping.Analyzer = ru.AnalyzerName

eventMapping := bleve.NewDocumentMapping()

eventMapping.AddFieldMappingsAt("message", ruFieldMapping)

mapping := bleve.NewIndexMapping()

mapping.DefaultMapping = eventMapping

mapping.DefaultAnalyzer = ru.AnalyzerName

return mapping

}С поиском все чуть сложнее:

func (ss *SearchService) Search(query, channel string) (*bleve.SearchResult, error) {

stringQuery := fmt.Sprintf("/.*%s.*/", query)

// NewTermQuery создает Query для нахождения значений в индексе, которые строго совпадают с запросом

ch := bleve.NewTermQuery(channel)

// Создаем Query для совпадений фраз в индексе. Анализатор выбирается по полю. Ввод анализируется этим анализатором. Токенезированные выражения от анализа используются для посторения поисковой фразы. Результирующие документы должны совпадать с этой фразой.

mq := bleve.NewMatchPhraseQuery(query)

// Создаем Query для поиска значений в индексе по регулярному выражению

rq := bleve.NewRegexpQuery(query)

// Создаем Query для поиска документов, результаты которого удовлетворят поисковой строке.

qsq := bleve.NewQueryStringQuery(stringQuery)

// Создаем составную Query Результат должен удовлетворять хотя бы одной Query.

q := bleve.NewDisjunctionQuery([]bleve.Query{ch, mq, rq, qsq})

search := bleve.NewSearchRequest(q)

search.Fields = []string{"username", "message", "channel", "timestamp"}

return ss.index.Search(search)

}Соединив все вместе, мы получим бота, который сохраняет историю и может искать по ней без тяжеловесной жавы на примерах ElasticSearch, Solr.

Полный код проекта доступен на Github

|

Метки: author Gen1us2k поисковые технологии go пщ bleve поиск blevesearch bleve search |

А ну-ка, девушки! Аде Лавлейс посвящается |

Источник

О том, что подвигло Аду посвятить себя науке и заниматься доработкой изобретения, предвосхитившего появление компьютера, написано немало. Самые полные и интересные статьи на эту темы можно почитать здесь и здесь.

В знак уважения к Аде Лавлейс в этом посте мы хотим рассказать о тех в ЛАНИТ, кто выбрал для себя ее путь, несмотря на то, что в России у ИТ до сих пор мужское лицо.

Бонусом – для всех, кто упрекнет наш блог в отсутствии бородатых инженеров, – представим старшего разработчика Антона. Пусть сегодня он окажется в «малиннике» и поделится взглядом на проектные команды, в которых трудятся женщины.

Очаровательные разработчики ЛАНИТ

Марина:

«В ЛАНИТ я занимаюсь проектированием системы электронного документооборота. Чаще всего пишу на T-SQL.

Программист – творческая профессия. Постоянно узнаешь что-то новое, общаешься с умными и интересными людьми. Любознательность привела меня в профессию.

Люди нередко удивляются, узнав, кем я работаю. Видимо, в сознании многих программист должен выглядеть несколько иначе.

За время работы в ЛАНИТ я успела поучаствовать в разных проектах, связанных с организацией хранения информации и электронным документооборотом. Приятно осознавать свой вклад и видеть результаты работы».

Алина:

«Сейчас я работаю с платформой Pega, в которой используется язык программирования Java. Также имею опыт на С++.

Программистом решила стать потому, что понравилось название факультета — факультет кибернетики. Шутка :) Если серьезно, то информатика и математика нравились еще со школы, да и давались легко. Поэтому, выбирая, кем быть, совершенно не колебалась. Дополнительный плюс — востребованность профессии.

Иногда мне кажется, что разработка — это возможность сохранить ощущение студенчества на долгие годы. В новых проектах всегда есть чему поучиться. Например, мне было очень любопытно поработать над решением для распознавания уровня эмоциональности текста в социальных сетях. Сейчас я создаю приложения для финансовых учреждений».

Софья:

«Мои языки — C++ и Java. В ЛАНИТ специализируюсь на решениях для крупнейших банков России: разрабатываю различный функционал для кредитных процессов, занимаюсь интеграцией решений со сторонними системами финансовых учреждений.

По своему опыту работы в команде могу сказать, что девушек-разработчиков отличает от парней скрупулезная точность в мелочах и чувство прекрасного при проектировании пользовательского интерфейса».

Альфия:

«В ЛАНИТ я участвую в проектах, связанных с базами данных. Прекрасно «говорю» на языке PL/SQL, создавая объекты баз данных, формы запросов и функции. Я сама долго выбирала профессию. Привычные врачи, адвокаты, бухгалтеры и т.д. казались скучными. В выборе помогла книга «SQL для чайников», которая случайно попалась на глаза. После нее я поняла, чем хотела бы заниматься. Мне кажется, что женщины гармонично себя чувствуют в ИТ-сфере: они меньше раздражаются на рутинную работу и более внимательны».

Мадина:

«Специализируюсь на Java и C++. В ЛАНИТ работаю над решениями для автоматизации процессов в юридических службах банков и судебных учреждениях, а в нерабочее время мы с коллегой из любопытства можем засесть за создание продукционных систем с троичной логикой или сборщик мусора для языка C++.

В университете завкафедрой порой шутил, что девушек-программистов не существует, но это только укрепило желание создать что-то, чем можно гордиться».

Галина:

«В ЛАНИТ я работаю с Pega – платформой для разработки корпоративных приложений. До этого писала на C++, который изучала самостоятельно еще со школы, и C#, с которым познакомилась в студенческие годы. На нем позже написала программу для тестирования знаний студентов в области объектно-ориентированного программирования. Проекты, в которых я участвую, связаны с упрощением и автоматизацией бизнес-процессов банковских систем.

Меня часто спрашивают, с какими стереотипами я сталкиваюсь в работе. Не припомню, чтобы сталкивалась с ними, исключение разве что сам вопрос».

Наталья:

«С базами данных столкнулась сразу после окончания института. Несколько лет я работала в телекоммуникационной компании. Наш отдел поддерживал биллинговые системы. Работа была динамичной, поскольку клиентам требовалось решение для быстрой и качественной обработки потребленных ими услуг. Мы постоянно дорабатывали системы, которые использовали операторы.

В дальнейших проектах базы данных меня не покидали. Последнее время работаю с Oracle и PostgreSQL, а начинала с MS SQL и VBA. Занимаюсь поддержкой и развитием систем анализа и принятия решений.

Мне кажется, что для профессионального роста обязательно нужна хорошая команда: работая со знающими людьми, можно у них учиться и быстро наращивать навыки. Пока мне с командой везёт».

Обещанный бонус

Антон, старший разработчик:

«Мне кажется, что в сфере ИТ с женщинами иметь дело гораздо проще: у них больше терпения, понимания, они умеют выстраивать отношения, тоньше чувствуют ситуацию. Именно поэтому количество приглашенных в ИТ-проекты женщин увеличивается. Они работают техническими писателями, инженерами по тестированию, бизнес- и системными аналитиками, консультантами по внедрению разнообразных систем, специалистами по поддержке пользователей.

В то же время квалифицированные женщины-программисты пока редкость. Мне кажется, в командах разработчиков их не больше 5 %. На некоторых должностях я женщин вообще не встречал. Например, сервисных инженеров.

Особенно приятно, что среди разработчиков в ЛАНИТ есть девушки».

Кстати, сейчас у нас открыта вакансия разработчика JAVA. Мы ждем ваши резюме!

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

|

Метки: author IrinaB управление разработкой блог компании гк ланит женщины разработка ланит кадры профессия |

[Перевод] Что нового в Swift 4.0 |

Swift 4.0 — это новая версия многими любимого языка программирования с новыми функциями, которые позволяют нам писать более простой и безопасный код. Вы с удовольствием узнаете, что это не так драматично как эпичные изменения в Swift 3.0 и большинство изменений имеют обратную совместимость с вашим сущетсвующим кодом на Swift. Конечно вам потребуется некоторое время для внесения изменений, но это не должно занять много времени.

ПРЕДУПРЕЖДЕНИЕ: Swift 4 на момент написания и подготовки перевода статьи находится в активной разработке и автором оригинала были выбраны только некоторые из наиболее интересных и полезных новых функций для обсуждения. Пожалуйста, имейте в виду, что больше возможностей будет доступно ближе к релизу.

Swift'овое кодирование и декодирование

Мы знаем, что типы значений велики, но еще мы знаем, что они ужасно взаимодействуют с Objective-C API, такими как NSCoding — вам нужно писать некую прослойку или использовать классы, при этом оба варианта неприятны. Хуже того, даже если вы переключаетесь на классы вам нужно писать методы кодирования и декодирования вручную, написание которых является болезненным и подверженным ошибкам.

Swift 4 вводит новый протокол Codable, который позволяет вам сериализовать и десериализовать собственные типы данных без написания дополнительного кода и не беспокоиться о потере ваших типов данных. Более того, вы можете выбрать как вы хотите сериализовать данные: использовать классический формат property list или JSON.

Да, вы все прочитали правильно: Swift 4 позволяет вам сериализовать ваши собственные типы данных в JSON без написания специального кода.

Давайте посмотрим насколько это прекрасно. Во-первых вот пользовательский тип данных и некоторые его экземпляры:

struct Language: Codable {

var name: String

var version: Int

}

let swift = Language(name: "Swift", version: 4)

let php = Language(name: "PHP", version: 7)

let perl = Language(name: "Perl", version: 6)

Как вы можете видеть, к структуре Language я подключил протокол Codable. С этим крошечным дополнением мы можем конвертировать это в JSON, представленный как Data следующим способом:

let encoder = JSONEncoder()

if let encoded = try? encoder.encode(swift) {

// сохраняем `encoded` где-нибудь

}

Swift автоматически кодирует все свойства внутри вашего типа данных, вам не нужно делать дополнительных действий.

Теперь вы, если также как и я долгое время использовали NSCoding, вероятно несколько сомневаетесь: действительно ли это то, что нам нужно и как мы можем быть уверены, что это работает? Давайте добавим немного кода чтобы попробовать преобразовать объект Data так чтобы мы могли отобразить это в консоли, тогда нам нужно декодировать это назад в новый экземпляр структуры Language:

if let encoded = try? encoder.encode(swift) {

if let json = String(data: encoded, encoding: .utf8) {

print(json)

}

let decoder = JSONDecoder()

if let decoded = try? decoder.decode(Language.self, from: encoded) {

print(decoded.name)

}

}

И JSONEncoder и PropertyListEncoder имеют множество вариантов настройки. Для получения дополнительной информации о других вариантах смотрите предложения по развитию этой новой функциональности.

Многострочные строковые литералы

Написание многострочных строк в Swift всегда означало добавление \n внутри ваших строк для добавления переноса строки, там где вы этого хотите. В коде это выглядит не очень хорошо, но по крайней мере корректно отображает информацию для пользователей. К счастью, Swift 4 добавляет новый синтаксис для многострочных строковых литералов, который позваляет добавлять переносы строк и использовать кавычки без экранирования, в то же время доступна такая полезная функциональность, как строковая интерполяция.

Чтобы начать строковый литерал, вам нужно: написать три двойных кавычки """ и нажать [Enter]. Тогда вы можете продолжить писать строку сколько хотите включая переменные и разрывы строк, до завершения вашей строки нажатием [Enter] и написанием трех двойных кавычек """.

Я хотел бы уточнить о нажатии переноса строки потому что строковый литералы имеют два важных правила:

1) когда вы открываете строку используя """ содержимое вашей строки должно начинаться на новой строке;

2) когда вы закрываете строку используя """ это обозначение также должно быть в начале новой строки.

Здесь это в действии:

let longString = """

When you write a string that spans multiple

lines make sure you start its content on a

line all of its own, and end it with three

quotes also on a line of their own.

Multi-line strings also let you write "quote marks"

freely inside your strings, which is great!

"""

Это создает новую строку с несколькими разрывами строк прямо в определении — гораздо проще читать и писать.

Для дополнительной информации смотрите предложения по развитию этой новой функциональности.

Улучшенные пути (keypaths) в KVC (Key-Value Coding)

Одной из самых любимых особенностей Objective-C является способность ссылаться на свойство динамически, а не напрямую — то есть, иметь возможность сказать «вот объект X, здесь его свойство, которое я хотел бы прочитать», не читая его вообще. Эти ссылки, названные keypaths, отличаются от прямых доступов к свойствам, потому что они фактически не читают или не записывают значение, они просто скрывают их чтобы использовать позже.

Если вы ранее не использовали keypaths позвольте мне показать вам аналогию того как они работают с использованием обычных методов Swift. Мы собираемся определить структуры Starship и Crew, затем создать по одному экземпляру каждой:

// структура для примера

struct Crew {

var name: String

var rank: String

}

// другая структура, в этот раз с методом

struct Starship {

var name: String

var maxWarp: Double

var captain: Crew

func goToMaximumWarp() {

print("\(name) is now travelling at warp \(maxWarp)")

}

}

// создаем экземпляры наших структур

let janeway = Crew(name: "Kathryn Janeway", rank: "Captain")

let voyager = Starship(name: "Voyager", maxWarp: 9.975, captain: janeway)

// захватываем ссылку на `goToMaximumWarp()` метод

let enterWarp = voyager.goToMaximumWarp

// вызываем ссылку

enterWarp()

Поскольку функции в Swift являются типами первого класса последние две строки могут создать ссылку на метод goToMaximumWarp() и вызвать позже когда нам это понадобится. Проблема в том, что мы не можем сделать то же самое для свойств — мы неможем сказать «создай ссылку на свойство имени капитана, которое я смогу проверить когда произойдет неизбежный бунт», потому что Swift просто прочитает свойство напрямую и вы просто получите исходное значение.

Это исправлено с помощью keypaths: они являются ссылками на свойства как наш код enterWarp(). Если вы вызываете ссылку сейчас вы получаете текущее значение, но если вы вызываете ссылку позже, вы получите самое последнее значение. Вы можете добраться через любое количество свойств и Swift использует свой тип вывода, чтобы гарантировать, что вы вернете правильный тип.

Сообщество развивающее Swift потратило много времени на обсуждение правильного синтаксиса для keypaths потому что это должно быть что-то визуально отличное от другого Swift кода и в конце концов этот синтаксис использует обратные косые черты: \Starship.name, \Starship.maxWarp, и \Starship.captain.name. Вы можете присвоить эти значения переменным и использовать тогда когда вы этого хотите любому экземпляру структуры Starship. Например:

let nameKeyPath = \Starship.name

let maxWarpKeyPath = \Starship.maxWarp

let captainName = \Starship.captain.name

let starshipName = voyager[keyPath: nameKeyPath]

let starshipMaxWarp = voyager[keyPath: maxWarpKeyPath]

let starshipCaptain = voyager[keyPath: captainName]

Это сделает starshipName как String, а starshipMaxWarp — Double потому что Swift способен правильно выводить типы данных. Третий пример берет свойство свойства и Swift также корректно определяет его.

Для дополнительной информации смотрите предложения по развитию этой новой функциональности.

Улучшенная функциональность словарей

Одним из самых интригующих предложений для Swift 4 было добавление некоторой новой функциональности в словари, чтобы сделать их более мощными, а также сделать их поведение более предсказуемым в определенных ситуациях.

Давайте начнем с простого примера: фильтрация словарей в Swift 3 не возвращает новый словарь. Вместо этого в результате фильтрации мы получаем массив кортежей (tuples) с метками «ключ-значение». Например:

let cities = ["Shanghai": 24_256_800, "Karachi": 23_500_000, "Beijing": 21_516_000, "Seoul": 9_995_000];

let massiveCities = cities.filter { $0.value > 10_000_000 }

После того как это код выполнится вы не можете использовать для получения нужных данных такую запись:

massiveCities["Shanghai"]потому что это уже не словарь. Вместо этого вам нужно использовать такой код:

massiveCities[0].valueи это не очень-то здорово.

Начиная с Swift 4 этот код ведет себя так как вы ожидали бы — фильтрация вернет новый словарь.

Да, очевидно, что это сломает любой существующий код, в котором используется массив кортежей как возвращаемое значение.

Точно также метод map() со словарями не работал так, как надеялись многие люди: вы получали переданный кортеж вида «ключ-значение» кроме того это могло быть одно значение добавленное в массив. Например:

let populations = cities.map { $0.value * 2 }

На данный момент это не изменено в Swift 4, но появился новый метод mapValues(), который должен быть значительно полезнее, потому что этот метод позволяет преобразовывать значения и помещать их обратно в словарь с использованием исходных ключей.

Например, этот код будет преобразовывать числовое значение и преобразовывать в строку данные о населении городов и складывать назад в новый словарь с такими же ключами: Shanghai, Karachi, и Seoul:

(В случае если вам интересно, делать маппинг ключей словаря небезопасно, т.к. можно случайно создать дубликаты.)

Мое любимое дополнение для словаря это инициализатор группировки, который преобразует последовательность в словарь последовательностей, которые сгруппированы по вашему желанию. Продолжая наш пример с городами мы могли бы использовать cities.keys, чтобы вернуть массив имен городов, а затем сгруппировать их по первой букве:

let groupedCities = Dictionary(grouping: cities.keys) { $0.characters.first! }

print(groupedCities)

Это выведет в консоль следующее:

["B": ["Beijing"], "S": ["Shanghai", "Seoul"], "K": ["Karachi"]]

Или мы могли бы сделать группировку городов на основе длин их имен:

let groupedCities = Dictionary(grouping: cities.keys) { $0.count }

print(groupedCities)

Это выведет в консоль следующее:

[5: ["Seoul"], 7: ["Karachi", "Beijing"], 8: ["Shanghai"]]

Наконец, сейчас возможно получение доступа к ключу словаря и предоставить значение по умолчанию, если указанный ключ отсутствует:

let person = ["name": "Taylor", "city": "Nashville"]

let name = person["name", default: "Anonymous"]

Сейчас любой опытный разработчик возможно будет утверждать что аналогичного результата можно добиться проще и я с этим согласен. Мы могли бы написать это таким образом в текущей версии Swift:

let name = person["name"] ?? "Anonymous"

Однако это не работает, если вы изменяете значение словаря, а не просто получаете его. Вы не можете сразу изменить значение словаря, потому что доступ по этому ключу возвращает опциональный тип — ключ может не существовать. С помощью значений словаря по умолчанию в Swift 4 вы можете написать более сжатый код, например:

var favoriteTVShows = ["Red Dwarf", "Blackadder", "Fawlty Towers", "Red Dwarf"]

var favoriteCounts = [String: Int]()

for show in favoriteTVShows {

favoriteCounts[show, default: 0] += 1

}

Этот цикл перебирает каждую строку в favoriteTVShows и использует словарь favoriteCounts чтобы отслеживать как часто появляется каждый элемент. Мы можем менять словарь в одну строку кода, потому что мы знаем что он всегда будет иметь значение: или 0 как значение по умолчанию или некоторое большее число основанное на предыдущем подсчете.

Для дополнительной информации смотрите предложения по развитию этой новой функциональности.

Строки снова коллекции!

Это маленькое изменение, но гарантировано сделает многих людей счастливыми: строки снова являются коллекциями. Это означает, что теперь вы можете их обратить, перебрать по символам, использовать map() и flatMap() и т.д. Например:

let quote = "It is a truth universally acknowledged that new Swift versions bring new features."

let reversed = quote.reversed()

for letter in quote {

print(letter)

}

Это изменение было внесено как часть набора поправок, называнный «Манифест строк».

Односторонние диапазоны

Последнее, но не менее важное — в Swift 4 появляется Python-подобная односторонняя нарезка коллекций, где недостающая сторона диапазона автоматически определяется как начало или конец коллекции. Это не влияет на существующий код, потому что это новый подход к существующему оператору, таким образом вы можете не беспокоиться о потенциальной поломке в коде. Примеры:

let characters = ["Dr Horrible", "Captain Hammer", "Penny", "Bad Horse", "Moist"]

let bigParts = characters[..<3]

let smallParts = characters[3...]

print(bigParts)

print(smallParts)

Этот код выводит в консоль сначала это:

["Dr Horrible", "Captain Hammer", "Penny"]

а затем это:

["Bad Horse", "Moist"]

Для дополнительной информации смотрите предложения по развитию этой новой функциональности.

Еще больше впереди...

На момент перевода статьи разработчикам уже доступен Xcode 9 Beta 3 (с 10.07.2017) вместе с iOS 11, tvOS 11, watchOS 4, и новой версией macOS. То что мы видели уже многообещающе, потому что понятно, что команда усердно трудится чтобы сделать Swift 4 как можно лучше. Речь идет прежде всего о добавлении новых функций, а не об изменении существующих и это должно сделать легче переход на новую стабильную версию языка.

Не смотря на то, что развитие Swift иногда может быть хаотичным, Swift 4 снова подтверждает подход сообщества Apple. Я добавил несколько предложений, каждое из предложений было широко обсуждено сообществом чтобы достичь согласия — это не просто инженеры Apple, которые форсируют изменения просто потому что они могут, вместо этого они отличаются разумным и продуманным подходом, чтобы улучшить то что уже является умным и элегантным языком.

Одной из функций, которая была отложена, является совместимость с ABI, которая позволила бы разработчикам распространять скомпилированные библиотеки — одну из немногих ключевых недостающих функций, которые остаются в Swift сегодня. Надеюсь, мы доберемся до этого в Swift 5…

|

Метки: author AKhatmullin разработка под ios swift swift 4 ios разработка ios development |

[Перевод] K-sort: новый алгоритм, превосходящий пирамидальную при n <= 7 000 000 |

|

Метки: author stranger777 алгоритмы внутренняя сортировка равномерное распределение средняя временная сложность статистический анализ статистическая оценка |

[Из песочницы] 3D Блокчейн. Доказательство на лицо (PoF) |

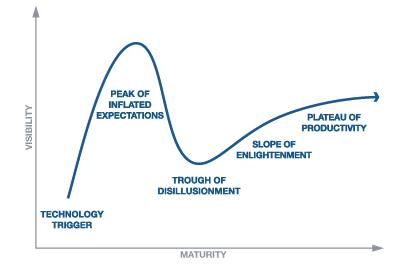

Моя склонность — всё подвергать сомнению и блокчейн[1] не оказался исключением. Давайте взглянем на Цикл зрелости технологии (Gartner Hype Cycles). Где по Вашему находится Блокчейн? Естественно каждый для себя определит своё нахождение на том или ином цикле, которое свойственно проекту на каком-то из стадий разработки. Кто-то во всю развивает бизнес приложение и видит будущие горизонты, а кто-то только начинает знакомство. Но если взглянуть шире? Блокчейн неоспоримо засел в мысли и показал большой потенциал по трансформации многих сегментов взаимоотношения людей. Но у меня остаётся доля сомнения в отношении некоторых текущих принципов его работы. В итоге, я вижу эту стадию где-то на уровне пика завышенных ожиданий (Peak of inflated expectations) — общественный ажиотаж с чрезмерным энтузиазмом и нереалистичными ожиданиями. Что означает, впереди ещё ждать такие циклы как: Избавление от иллюзий, Преодоление недостатков, Плато продуктивности.

Моя склонность — всё подвергать сомнению и блокчейн[1] не оказался исключением. Давайте взглянем на Цикл зрелости технологии (Gartner Hype Cycles). Где по Вашему находится Блокчейн? Естественно каждый для себя определит своё нахождение на том или ином цикле, которое свойственно проекту на каком-то из стадий разработки. Кто-то во всю развивает бизнес приложение и видит будущие горизонты, а кто-то только начинает знакомство. Но если взглянуть шире? Блокчейн неоспоримо засел в мысли и показал большой потенциал по трансформации многих сегментов взаимоотношения людей. Но у меня остаётся доля сомнения в отношении некоторых текущих принципов его работы. В итоге, я вижу эту стадию где-то на уровне пика завышенных ожиданий (Peak of inflated expectations) — общественный ажиотаж с чрезмерным энтузиазмом и нереалистичными ожиданиями. Что означает, впереди ещё ждать такие циклы как: Избавление от иллюзий, Преодоление недостатков, Плато продуктивности. Поэтому, если Вам интересна критика и предположение иного подхода в определении консенсуса, то добро пожаловать под кат.

Обратимся к Биткоину[2]. Это одноранговая денежная система, в которой электронные транзакции совершаются участниками напрямую, минуя финансовые институты (доверенного лица/посредника). Где защита от двойной траты достигается путём консенсуса в пиринговой сети, основанном на доказательстве проделанной работы (Proof of Work[3]). В качестве стимула для поддержания системы эмиссируется криптовалюта и начисляется совместно с комиссией майнерам, которые данную работу выполняют. Возникает закономерный вопрос, а это не посредники? Да, с них убрали принцип доверия, в следствии чего уходит и ответственность (не кого будет винить), но ведь они и есть третья сторона, которым участники транзакций оплачивают за предоставленную услугу (обеспечение надёжности). Более того, огромная часть вознаграждения сейчас происходит за счёт эмиссии, а это означает, что те кто сейчас приобретает криптовалюту, сами того не подозревая (или подозреваете?), оплачивают за уже совершенные транзакции предшественников. Например, данный вопрос поднимался в 9 пункте от Gartner. В дальнейшем, когда эмиссия прекратится, то получаемая из этого ранее сумма распределится в качестве комиссии, что существенно взвинтит стоимость транзакции. С технической стороны этот вопрос может решиться увеличением размера блока или иными решениями типа SegWit[4] (только, на как долго решится?). Но экономическая сторона всё равно страдает. Надёжность обеспечивается тогда, когда кол-во майнеров огромно, ведь подразумевалось «один процессор — один голос». А в итоге они попадут в конкурентную среду, где единственным средством в перетягивании одеяла будет размер комиссии, в общем кто-то вырастет и останется на плаву, а кто-то уйдёт, либо будет поглощён. И от сюда возникает следствие — себестоимость транзакции. Чем система более децентрализована, тем стоимость транзакций будет выше. Чем она более централизована — тем ниже. Это обычные экономические реалии, подобная мысль уже была, только в отношении энергоэффективности, например здесь.

Следующий момент заключается в том, что хоть это и денежная система, но она замкнута сама в себе, иными словами блокчейн взаимодействует с миром через среду основанной на доверии. Также любой блокчейн зависит от собственной криптовалюты, обеспечивающая стимулирование надежности данной сети и осуществление транзакций. Соответственно, с одной стороны — это единая расчётная единица, что хорошо, с другой стороны — это прямая зависимость для функционирования приложений (уже не связанных с деньгами, но задействовавшие данный блокчейн) от судьбы её криптовалюты и стоимости транзакций. Дополнительно эффект замкнутости порождает вопрос, по какому правилу осуществлять эмиссию? Ведь тут уже, кто на что горазд: кто-то ограничивает, кто-то нет, а кто-то и вовсе применил принцип сжигания, как например в Proof of Burn (доказательство сжигания).

Обратимся к Ethereum[5]. Примечательно, что необходимость в собственной криптовалюте в Ethereum более оправдана, т.к. необходима для осуществления смарт-контрактов и работы приложений. Эмиссия здесь не ограничена, но со временем стремится к нулю. В итоге экономическая сторона в отношении майнеров здесь такая же. Но на сколько данный способ эмиссии обладает гибкостью в отношении экономических процессов? Ведь уровень денежной массы является одним из основных элементов функционирования денежной системы и экономики в целом. С другой стороны, если предположить, что весь мир перешёл на блокчейн, тогда например бесконечная эмиссия, которая будет привязана допустим к интенсивности транзакций, то своим ускорением покажет рост экономики, а при спаде кол-ва транзакций наоборот, спадает соответственно интенсивность эмиссии, то такая модель кажется жизнеспособной.

Вернёмся к блокчейн — это цепочка блоков с записями о транзакциях, формирующихся непрерывно, защищенность обеспечивается криптографией. Каждый блок содержит информацию о предыдущем блоке. Блокчейн представляет собой распределённый реестр данных, полная копия которой или её части одновременно хранится на множестве компьютеров. Формирование новых блоков осуществляется по определённому алгоритму консенсуса, как описывал выше, например, основанной на доказательстве проделанной работы (Proof of Work) или иных. При этом, частым явлением является ветвление цепи, это когда одновременно формируется несколько новых блоков, каждый из которых считают предыдущим один и тот же блок. Ветвление прекратится, как только будет найден новый блок, который продолжит любую из ветвей. Все узлы переключатся на ту цепь, которая имеет самую длинную версию и продолжат работать над её удлинением. Т.е. блокчейн представляется линейным. Теперь представьте, на сколько такой блокчейн перегружен лишней работой? Полная актуальная версия цепи хранится на специальных узлах сети, называемые полными нодами, остальные узлы (лёгкие кошельки, используемые пользователями) обращаются к полным в случае необходимости проверить что-либо. Полную версию блокчейна может скачать любой желающий. Но с учётом того, что блокчейн развивается уже не только для транзакций, но и в качестве реестра различных событий, и также даёт возможность работы различных приложений. А в графическом виде блокчейн представляется линейным, то на сколько увеличится размер такой цепи в будущем? Ведь огромный размер приведёт к риску централизации. Лишь единицы смогут держать полную ноду исчисляемую Тб, а значит единицы смогут вступить в сговор и навязывать правила.