Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

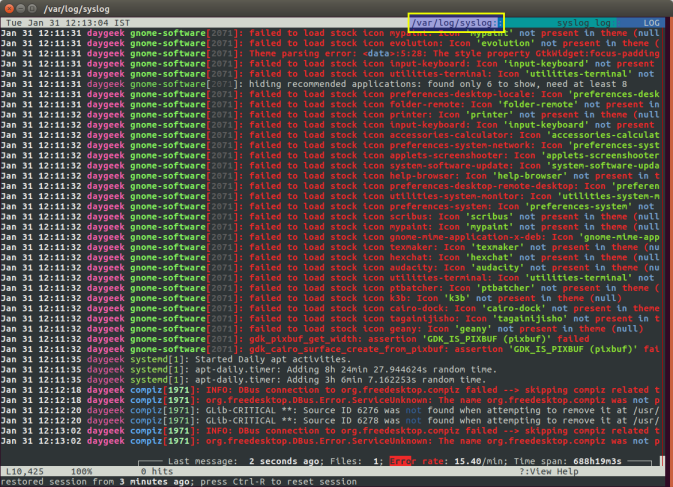

Лог файлы Linux по порядку |

Невозможно представить себе пользователя и администратора сервера, или даже рабочей станции на основе Linux, который никогда не читал лог файлы. Операционная система и работающие приложения постоянно создают различные типы сообщений, которые регистрируются в различных файлах журналов. Умение определить нужный файл журнала и что искать в нем поможет существенно сэкономить время и быстрее устранить ошибку.

Журналирование является основным источником информации о работе системы и ее ошибках. В этом кратком руководстве рассмотрим основные аспекты журналирования операционной системы, структуру каталогов, программы для чтения и обзора логов.

Основные лог файлы

Все файлы журналов, можно отнести к одной из следующих категорий:

- приложения;

- события;

- службы;

- системный.

Большинство же лог файлов содержится в директории /var/log.

- /var/log/syslog или /var/log/messages содержит глобальный системный журнал, в котором пишутся сообщения с момента запуска системы, от ядра Linux, различных служб, обнаруженных устройствах, сетевых интерфейсов и много другого.

- /var/log/auth.log или /var/log/secure — информация об авторизации пользователей, включая удачные и неудачные попытки входа в систему, а также задействованные механизмы аутентификации.

- /var/log/dmesg — драйвера устройств. Одноименной командой можно просмотреть вывод содержимого файла. Размер журнала ограничен, когда файл достигнет своего предела, старые сообщения будут перезаписаны более новыми. Задав ключ

--level=можно отфильтровать вывод по критерию значимости.

Поддерживаемые уровни журналирования (приоритеты):

emerg - система неиспользуемая

alert - действие должно быть произведено немедленно

crit - условия критичности

err - условия ошибок

warn - условия предупреждений

notice - обычные, но значимые условия

info - информационный

debug - отладочные сообщения

(5:520)$ dmesg -l err

[1131424.604352] usb 1-1.1: 2:1: cannot get freq at ep 0x1

[1131424.666013] usb 1-1.1: 1:1: cannot get freq at ep 0x81

[1131424.749378] usb 1-1.1: 1:1: cannot get freq at ep 0x81- /var/log/alternatives.log — Вывод программы

update-alternatives, в котором находятся символические ссылки на команды или библиотеки по умолчанию. - /var/log/anaconda.log — Записи, зарегистрированные во время установки системы.

- /var/log/audit — Записи, созданные службой аудита

auditd. - /var/log/boot.log — Информация, которая пишется при загрузке операционной системы.

- /var/log/cron — Отчет службы

crondоб исполняемых командах и сообщения от самих команд. - /var/log/cups — Все, что связано с печатью и принтерами.

- /var/log/faillog — Неудачные попытки входа в систему. Очень полезно при проверке угроз в системе безопасности, хакерских атаках, попыток взлома методом перебора. Прочитать содержимое можно с помощью команды

faillog. - var/log/kern.log — Журнал содержит сообщения от ядра и предупреждения, которые могут быть полезны при устранении ошибок пользовательских модулей встроенных в ядро.

- /var/log/maillog/ или /var/log/mail.log — Журнал почтового сервера, используемого на ОС.

- /var/log/pm-powersave.log — Сообщения службы экономии заряда батареи.

- /var/log/samba/ — Логи файлового сервера

Samba, который используется для доступа к общим папкам Windows и предоставления доступа пользователям Windows к общим папкам Linux. - /var/log/spooler — Для представителей старой школы, содержит сообщения USENET. Чаще всего бывает пустым и заброшенным.

- /var/log/Xorg.0.log — Логи X сервера. Чаще всего бесполезны, но если в них есть строки начинающиеся с EE, то следует обратить на них внимание.

Для каждого дистрибутива будет отдельный журнал менеджера пакетов.

- /var/log/yum.log — Для программ установленных с помощью

Yumв RedHat Linux. - /var/log/emerge.log — Для

ebuild-ов установленных изPortageс помощьюemergeв Gentoo Linux. - /var/log/dpkg.log — Для программ установленных с помощью

dpkgв Debian Linux и всем семействе родственных дистрибутивах.

И немного бинарных журналов учета пользовательских сессий.

- /var/log/lastlog — Последняя сессия пользователей. Прочитать можно командой

last. - /var/log/tallylog — Аудит неудачных попыток входа в систему. Вывод на экран с помощью утилиты

pam_tally2. - /var/log/btmp — Еже один журнал записи неудачных попыток входа в систему. Просто так, на всякий случай, если вы еще не догадались где следует искать следы активности взломщиков.

- /var/log/utmp — Список входов пользователей в систему на данный момент.

- /var/log/wtmp — Еще один журнал записи входа пользователей в систему. Вывод на экран командой

utmpdump.

(5:535)$ sudo utmpdump /var/log/wtmp

[5] [02187] [l0 ] [ ] [4.0.5-gentoo ] [0.0.0.0 ] [Вт авг 11 16:50:07 2015]

[1] [00000] [~~ ] [shutdown] [4.0.5-gentoo ] [0.0.0.0 ] [Вт авг 11 16:50:08 2015]

[2] [00000] [~~ ] [reboot ] [3.18.12-gentoo ] [0.0.0.0 ] [Вт авг 11 16:50:57 2015]

[8] [00368] [rc ] [ ] [3.18.12-gentoo ] [0.0.0.0 ] [Вт авг 11 16:50:57 2015]

[1] [20019] [~~ ] [runlevel] [3.18.12-gentoo ] [0.0.0.0 ] [Вт авг 11 16:50:57 2015]И другие журналы

Так как операционная система, даже такая замечательная как Linux, сама по себе никакой ощутимой пользы не несет в себе, то скорее всего на сервере или рабочей станции будет крутится база данных, веб сервер, разнообразные приложения. Каждое приложения или служба может иметь свой собственный файл или каталог журналов событий и ошибок. Всех их естественно невозможно перечислить, лишь некоторые.

- /var/log/mysql/ — Лог базы данных MySQL.

- /var/log/httpd/ или /var/log/apache2/ — Лог веб сервера Apache, журнал доступа находится в

access_log, а ошибки — вerror_log. - /var/log/lighthttpd/ — Лог веб сервера lighttpd.

В домашнем каталоге пользователя могут находится журналы графических приложений, DE.

- ~/.xsession-errors — Вывод

stderrграфических приложений X11.

Initializing "kcm_input" : "kcminit_mouse"

Initializing "kcm_access" : "kcminit_access"

Initializing "kcm_kgamma" : "kcminit_kgamma"

QXcbConnection: XCB error: 3 (BadWindow), sequence: 181, resource id: 10486050, major code: 20 (GetProperty), minor code: 0

kf5.kcoreaddons.kaboutdata: Could not initialize the equivalent properties of Q*Application: no instance (yet) existing.

QXcbConnection: XCB error: 3 (BadWindow), sequence: 181, resource id: 10486050, major code: 20 (GetProperty), minor code: 0

Qt: Session management error: networkIdsList argument is NULL- ~/.xfce4-session.verbose-log — Сообщения рабочего стола XFCE4.

Чем просматривать — lnav

Почти все знают об утилите less и команде tail -f. Также для этих целей сгодится редактор vim и файловый менеджер Midnight Commander. У всех есть свои недостатки: less неважно обрабатывает журналы с длинными строками, принимая их за бинарники. Midnight Commander годится только для беглого просмотра, когда нет необходимости искать по сложному шаблону и переходить помногу взад и вперед между совпадениями. Редактор vim понимает и подсвечивает синтаксис множества форматов, но если журнал часто обновляется, то появляются отвлекающие внимания сообщения об изменениях в файле. Впрочем это легко можно обойти с помощью <:view /path/to/file>.

Недавно я обнаружил еще одну годную и многообещающую, но слегка еще сыроватую, утилиту — lnav, в расшифровке Log File Navigator.

Установка пакета как обычно одной командой.

$ aptitude install lnav #Debian/Ubuntu/LinuxMint

$ yum install lnav #RedHat/CentOS

$ dnf install lnav #Fedora

$ emerge -av lnav #Gentoo, нужно добавить в файл package.accept_keywords

$ yaourt -S lnav #ArchНавигатор журналов lnav понимает ряд форматов файлов.

- Access_log веб сервера.

- CUPS page_log

- Syslog

- glog

- dpkg.log

- strace

- Произвольные записи с временными отметками

- gzip, bzip

- Журнал VMWare ESXi/vCenter

Что в данном случае означает понимание форматов файлов? Фокус в том, что lnav больше чем утилита для просмотра текстовых файлов. Программа умеет кое что еще. Можно открывать несколько файлов сразу и переключаться между ними.

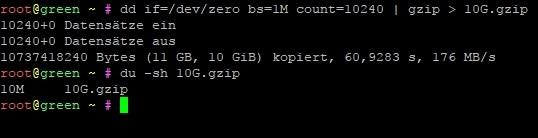

(5:471)$ sudo lnav /var/log/pm-powersave.log /var/log/pm-suspend.logПрограмма умеет напрямую открывать архивный файл.

(5:471)$ lnav -r /var/log/Xorg.0.log.old.gzПоказывает гистограмму информативных сообщений, предупреждений и ошибок, если нажать клавишу . Это с моего syslog-а.

Mon May 02 20:25:00 123 normal 3 errors 0 warnings 0 marks

Mon May 02 22:40:00 2 normal 0 errors 0 warnings 0 marks

Mon May 02 23:25:00 10 normal 0 errors 0 warnings 0 marks

Tue May 03 07:25:00 96 normal 3 errors 0 warnings 0 marks

Tue May 03 23:50:00 10 normal 0 errors 0 warnings 0 marks

Wed May 04 07:40:00 96 normal 3 errors 0 warnings 0 marks

Wed May 04 08:30:00 2 normal 0 errors 0 warnings 0 marks

Wed May 04 10:40:00 10 normal 0 errors 0 warnings 0 marks

Wed May 04 11:50:00 126 normal 2 errors 1 warnings 0 marksКроме этого поддерживается подсветка синтаксиса, дополнение по табу и разные полезности в статусной строке. К недостаткам можно отнести нестабильность поведения и зависания. Надеюсь lnav будет активно развиваться, очень полезная программа на мой взгляд.

Использованные материалы

- lnav — An Advanced Log File viewer for Linux

- What Are Linux Logs? How to View Them, Most Important Directories, and More

- Как посмотреть логи в Linux

|

Метки: author temujin системное администрирование настройка linux *nix logs linux |

Забронируйте ваше место на БИТ-пикнике HPE |

На мероприятии ждем технических специалистов, которым будет интересно узнать о новых продуктах и решениях HPE и поучаствовать в практикумах. Среди них:

- Системы хранения HPE 3PAR и технология HPE Nimble InfoSight

- Онлайн-демонстрация быстрой настройки гостевой WiFi сети с СМС авторизацией с помощью облачной системы управления Aruba Central; подключение к облачной системе управления Aruba Central, регистрация точек доступа, настройка гостевого портала и параметров доступа, подключение клиентов к гостевой WiFi сети, сбор и анализ статистики.

- Процессоры Intel и вычислительные технологии HPE

- Гиперконвергентная система HPE SimpliVity 380: вычисления, хранение, бэкап, отказоустойчивость и много другое в одной системе.

- Теория и практика использования компонуемой инфраструктуры HPE Synergy

- HPE OneView — платформа управления серверной инфраструктурой.

В демо-зоне можно будет пообщаться с нашими специалистами и посмотреть на интересное железо – компонуемую инфраструктуру HPE Synergy, серверы HPE Moonshot, гиперконвергентные системы HPE SimpliVity.

Ознакомьтесь с полной программой и зарегистрируйтесь до 10 июля. Ждем вас!

|

Метки: author tonyafilonenko системное администрирование it- инфраструктура блог компании hewlett packard enterprise hpe мероприятие москва |

Семинар «Облака и реальность: кейсы, грабли, хорошие новости», 13 июля, Санкт-Петербург |

Привет, Хабр! Мы готовим к запуску новый курс Университетов DataLine. На этот раз про наши знания в делах облачных. Первый семинар пройдет в Санкт-Петербурге 13 июля – для нас это двойная премьера :-)

На вводном семинаре курса расскажем про практику IaaS в России и в мире, поделимся лайфхаками в области миграции и поговорим об облаке будущего.

У нас осталось всего несколько мест, и мы будем рады видеть ИТ-директоров, инженеров и всех тех, кто занимается обслуживанием ИТ-инфраструктуры.

О чем поговорим:

- Кому в облаках жить хорошо, а кому не очень: российская и мировая IaaS-практика в контексте размещения критичных для бизнеса систем и ИТ-сервисов.

- Миграция в облако: типичные ошибки и лайфхаки.

- Облако завтрашнего дня: наш взгляд на ключевые тренды в развитии технологий и сервиса в целом.

После семинара для всех участников вкусный фуршет.

Ознакомиться с подробной программой и зарегистрироваться на семинар можно по ссылке.

Если вы в Петербурге, заходите в гости!

|

Метки: author 5000shazams виртуализация it- инфраструктура блог компании dataline виртуальные сервера облачные сервисы облако облачные технологии dataline даталайн |

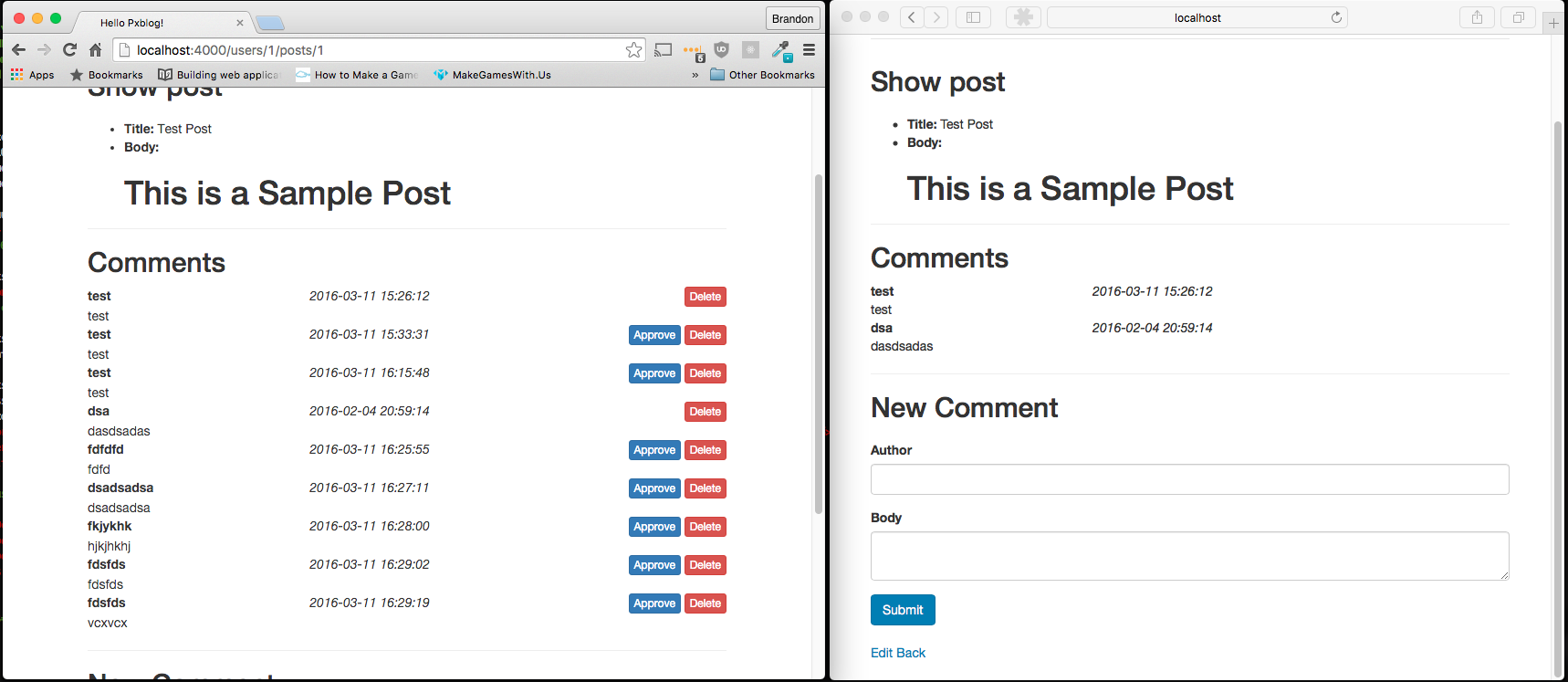

[Перевод] Как создать билборд-текстуру растительности в Unreal Engine 4 |

Растительность в Unreal Engine 4

В Unreal Engine 4 по умолчанию есть встроенный инструмент для работы с растительностью под названием Foliage tool. Он добавляет клонированные статические меши (в более общем смысле слова – бесскелетные модели). Каждый ассет с растительностью можно добавить на карту тысячи раз с разными настройками поворота, расположения и т. д. для всех экземпляров.

При относительно небольших (до 10 000 экземпляров) и простых (менее 100 полигонов) ассетах всё будет отлично работать даже с тенью и хорошим освещением растений. Но нужно разумно настроить расстояние отсечения, чтобы графические аппаратные средства не пытались отобразить все 10 000 экземпляров сразу.

Впрочем, для относительно больших скоплений растительности (к примеру, целых лесов) это может стать проблемой.

Рассмотрим пример из моей игры. На севере карты – большой лес, игрок может войти в него с юга. Всё, что находится за пределами южной стороны леса, – это неигровая зона. Но ее всё равно нужно рендерить, чтобы создать у игрока впечатление обширного и необъятного леса.

Если бы мы решили рендерить весь лес, даже при использовании низкополигональных моделей деревьев это понизило бы производительность на слабых компьютерах.

Именно в этом случае на помощь приходят билборды.

Билборд это что-то из области рекламы?

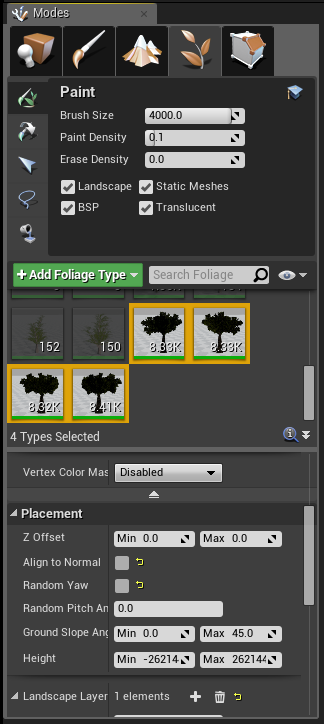

Unreal Engine 4 в базовой комплектации поддерживает компонент Billboard Material Component. Он хорошо подходит для работы с единичными или немногочисленными мешами в уровне, как показано на примере выше. К сожалению, его нельзя использовать для инструмента Foliage tool, который поддерживает только размещение статических мешей. Чтобы использовать компонент Billboard Component, он должен находиться внутри класса Actor, который не поддерживается данным инструментом.

Нужно сделать собственный Billboard Material. О том, как это сделать, можно почитать в документации по ссылке здесь, в разделе о стилизованном рендеринге (некоторые не сразу находят нужную информацию, потому рекомендую читать внимательнее).

Я не буду пересказывать этот документ. Взамен я добавлю скриншот моего материала, созданного по документации, и расскажу, как использовать его в игре.

Для начала импортируйте простые 2D текстуры, которые будут выполнять роль спрайта с билбордом. С этой целью я сделал скриншоты модели дерева на прозрачном фоне. Если смотреть с определенного расстояния, они очень похожи на высокополигональные модели.

Важно оставить немного разнообразия: я создал 4 варианта одного дерева, чтобы модели не выглядели одинаково.

Подготовка материала

Следующий шаг – создать материал, который будет отвечать за то, чтобы вершины статического меша были всегда обращены к камере. В качестве статического меша возьмем четырехугольник, образованный двумя треугольниками (об этом немного позже).

Перейдите в панель Content Browser, кликните правой кнопкой мышки и создайте новый Material.

Выберите следующие настройки:

- Blend Mode: Masked;

- Shading Model: Unlit;

- галочка напротив параметра Two Sided.

Затем можете поместить узлы на графическую панель материала.

Сделаем несколько важных уточнений. Материал настраивает положение вершин так, чтобы они были повернуты к камере. За счет привязанных к World Position Offset узлов материал настраивает положение своих вершин так, чтобы они были повернуты к камере.

Узел 'Custom' содержит внутри секции, отвечающей за эффекты билборда, специальный HLSL-код. Он нужен для вычисления правильного поворота четырехугольника. Параметры этого узла выглядят так: напротив 'Inputs' нужно выбрать одно значение и назвать его 'In', а напротив ‘Output Type’ – CMOT Float 2. В документации это описано иначе, но там неправильные названия параметров:

float2 output;

output = atan2 (In.y,In.x);

return (output);Узлы, привязанные к PivotPosition, отвечают за то, чтобы прямоугольник переносился в трехмерное пространство в соответствии с координатами и вращался вокруг исходной точки.

Но этот материал не предназначен для прямого использования. Текстура была преобразована в Material Parameter, который будут использовать экземпляры материала.

После сохранения материала кликните по нему правой кнопкой на панели Content Browser и сделайте несколько экземпляров. Каждый из них должен использовать правильную текстуру вашего билборда. Так код не будет дублироваться, а ресурсы будут расходоваться эффективнее.

Определив материал, загрузим в Unreal Engine 4 простой прямоугольник, который будет использоваться как статический меш для Foliage tool.

Создание и загрузка меша

Для модели билборда нужен только прямоугольник, состоящий из двух треугольников. Создайте такой ассет с помощью программы Blender либо загрузите тот, который использовал я. Он доступен для скачивания по ссылке, смело используйте его в любых проектах.

Возможно, при импорте треугольника вам придется настроить его перенос и поворот, чтобы он изначально был обращен к камере и располагался на поверхности. Если этого не сделать, материал повернется к камере боком или перевернется вверх ногами (или то и другое сразу) и будет неправильно переносить свое положение в трехмерное пространство. В результате материал всегда будет повернут в неверном направлении.

Я использовал для четырехугольника следующие настройки:

- Roll: 270 градусов.

- Pitch: 180 градусов.

- Yaw: 0 градусов.

- Import Uniform Scale: Настройте в соответствии с размером вашей карты, сам по себе четырехугольник достаточно большой.

- Import translation, Z axis: Настройте в соответствии с ландшафтом. Я выставил на 190 единиц.

По завершении импорта дайте четырехугольнику имя (я свой назвал TreeBillboard_Quad_1) и присвойте четырехугольник материалу билборда.

Теоретически мы уже могли бы поместить четырехугольник на карту и убедиться, что при движении камеры он всегда повернут к зрителю. Но разумнее будет перетащить этот статический меш в Foliage tool и поработать над его размещением:

Добавляя меш в Foliage tool, убедитесь, что опции Align to Normal и Random Yaw отключены: они поворачивают меш и нарушают эффект материала.

Этот меш всегда нужно располагать за пределами игровой зоны, где игрок не сможет к нему приблизиться или обойти, иначе вся иллюзия нарушится, и это будет смотреться, мягко говоря, плохо.

Когда вы добавите несколько тысяч таких деревьев, получится лес. Качество результата напрямую зависит от качества изначальных текстур:

Внешний вид

Обратите внимание: в своей игре я использую модель дерева низкого качества – только такую можно было найти в открытом доступе на сайте OpenGameArt. Повторюсь, результат зависит от качества и детализации меша, по которому создаются изображения, а также от разрешения этих изображений.

Ниже приведены для сравнения деревья с тенью и освещением и простые неосвещенные билборды:

А дальше показано, как выглядят эти деревья в том разрешении и размере, в котором лучше всего подходят для отображения. На изображении представлены как меши (ближе), так и билборды (дальше). На первый взгляд их трудно различить, а с более качественными мешами и изображениями это будет смотреться еще эффектнее:

Производительность

Поскольку мы рисуем только 2 треугольника для каждого дерева, производительность при таком подходе более чем приемлемая для современных компьютеров. Мне удалось заполнить деревьями всю карту без заметного снижения производительности средней видеокарты (AMD R9 270X). Метод также отлично подходит для работы с тростником, травой или другими мелкими растениями. Игрок не заметит, что они плоские, даже если подойдет ближе.

К билбордам непросто применить освещение или тень, поэтому в моей игре у них нет тени.

Игрок вряд ли заметит это с большого расстояния, но если он подойдет достаточно близко, недостаток обнаружится.

Правда, производительность в данном случае неидеальна. Узел 'Custom', который мы используем для материала, не позволяет движку оптимизировать шейдер. Сейчас это не играет роли, но у вас может быть по-другому. Если сомневаетесь, воспользуйтесь профайлером.

Альтернативы

Есть и другой подход – применять низкополигональные LOD-цепочки, которые генерируются с помощью таких инструментов, как Simplygon или Meshlab. В качестве растительности можно также использовать импостеры. А еще лучше совместить 3 подхода, используя высокополигональную модель дерева (например, с speedtree.com) и наименее детализированную модель в вашей LOD-цепочке. Так вы экономите ресурсы. Когда дерево находится далеко, оно не отличается от плоского спрайта по части детализации и теней. Поэтому необязательно прорисовывать его полностью.

Вывод

Надеюсь, эта статья принесет пользу вашей игре и позволит не тратить целое состояние на дорогостоящие видеокарты. Есть много способов рендерить растительность, и это только один из них.

|

Метки: author Plarium работа с 3d-графикой компьютерная анимация дизайн игр cgi ( графика) блог компании plarium unreal engine 4 trees деревья игры создание графики |

Тюнинг типовых ролей Windows. Часть первая: Файлы и печать |

Начинаем небольшой цикл статей, посвященных тюнингу производительности сервера Windows и его типовых ролей. Материал будет полезен как при попытке выжать из старого сервера максимум (помимо покраски в красный цвет), так и при планировании новых высоконагруженных систем без покупки топовых серверов (как это советуют интеграторы).

Общие рекомендации по железу

Процессор - он как сердце сервера, поэтому от него зависит очень много в плане производительности. Благодаря маркетологам мы знаем - чем больше ядер и мегагерцев, тем круче. На самом деле всё не совсем так:

Выбирайте 64-битный процессор. Современные серверные Windows не поддерживают 32-битные процессоры, да и памяти он может адресовать намного больше.

Количество ядер не имеет большого значения. Не все приложения и сервисы могут использовать несколько ядер, и в общем случае одно ядро с большой частотой будет эффективнее, чем два с меньшей.

Hyperthreading - гиперпоточность - когда одно физическое ядро процессора определяется как два логических. Функция процессора позволяет обрабатывать два разных потока на одном ядре, что в общем случае увеличивает производительность. Но бывает, что производительность наоборот снижается из-за того, что кэш процессорного ядра один.

Кэш процессора. Тут все просто: чем он больше, тем лучше, и часто больший кэш дает большую производительность, чем частота процессора.

Не нужно сравнивать процессоры разных поколений и производителей по частоте: скорость обработки данных зависит и от многих других факторов вроде кэша и частоты шины.

- Для Hyper-V важно, чтобы процессор поддерживал SPLAT (Second Level Address Translation). В терминологии Intel возможность называется Extended Page Tables (EPT), у AMD - Nested Page Tables (NPT). Проверить наличие этой функции процессора можно с помощью утилиты systeminfo.exe.

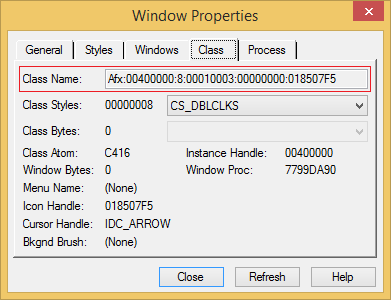

Проверка процессора под требования Hyper-V.

С оперативной памятью все довольно просто: чем она больше и быстрее, тем лучше. Чуть интереснее становится, если оперативной памяти недостаточно и системе необходимо использовать файл подкачки. Тут можно ограничиться следующими рекомендациями:

файл подкачки стоит положить на отдельный физический диск. Чем он быстрее, тем лучше. Если такой возможности нет, то лучше разместить его на диске, к которому меньше файловых обращений;

- лучше не хранить файл подкачки на отказоустойчивом массиве вроде RAID1- он проигрывает по скорости одному диску. Хорошей идеей будет поместить файл подкачки на RAID0 или несколько файлов подкачки на разных физических дисках.

Размещение файла подкачки на системном диске - не лучший вариант.

Теперь о сетевых адаптерах. Из интересных особенностей можно отметить:

Только адаптеры с поддержкой 64-разрядных систем имеют DMA (Direct Memory Access) - технологию прямого доступа к памяти по сети. Если нужна действительно быстрая сеть между нодами кластера - на это стоит обратить внимание.

- Многопортовые адаптеры удобны для распределения нагрузки и отказоустойчивости. Но 2 адаптера с одним портом будут быстрее, чем один адаптер с 2 портами. Также нужно иметь в виду, что устанавливать больше сетевых адаптеров, чем ядер в сервере чревато падением быстродействия.

HPE ProLiant DL360 Gen7 обладает изначально четырьмя сетевыми портами.

На этом закончу небольшую вводную и перейду непосредственно к оптимизации ролей сервера. Начнем с самого простого - с файлового сервера.

Файловый сервер

Обычно при установке и работе файлового сервера вопрос быстродействия не стоит. Но только до тех пор, пока на обычной файлопомойке на заводятся базы данных, чудовищные файлы Excel и им подобные «интересные» вещи. Расскажу про параметры, которые могут улучшить или ухудшить быстродействие SMB.

Отдельно отмечу вопрос быстродействия сервера, который обрабатывает не только клиентов внутри локальной сети, но и удаленных - например, по VPN. Лично я сталкивался с ситуацией, когда в сети на Windows XP\2003 начали появляться компьютеры на Windows 7\2008. Тогда мы столкнулись с тем, что быстродействие сети новых компьютеров оставляет желать лучшего при общении со старыми ОС. Начитавшись интернетов, выполнили на новых машинах следующий скрипт:

netsh int tcp set global autotuning=disabled

netsh int tcp set global autotuninglevel=disabled

netsh int tcp set global rss=disabled chimney=disabled

Сеть заработала, скрипт был добавлен в разворачиваемые образа систем.

И все было хорошо, пока в сети не появился удаленный сегмент с повышенным требованием к скорости работы сети. Файлы передавались по VPN не быстрее 2 Мб/с. Проблему локализовали: оказалось, что специально для работы в LAN\WAN сетях в новых операционных системах добавили функцию autotuning. С помощью нее системы определяют скорость соединения и договариваются о размерах кадра TCP для оптимального быстродействия. Чтобы VPN работала быстро, и сервера не тормозили при обращениях к WIndows 2003, достаточно было не отключать autotuning, а ограничить его командой:

netsh int tcp set global autotuninglevel=highlyrestricted

Но перейдем к более специализированным параметрам.

Помним, что изменения параметров реестра и настроек служб могут привести к чему угодно. Поэтому делаем все аккуратно.

Начнем с тюнинга клиентов файловых серверов. За подключение к серверу SMB отвечает служба LanmanWorkstation. Большинство параметров находятся в следующей ветке реестра:

HKLM\System\CurrentControlSet\Services\LanmanWorkstation\Parameters

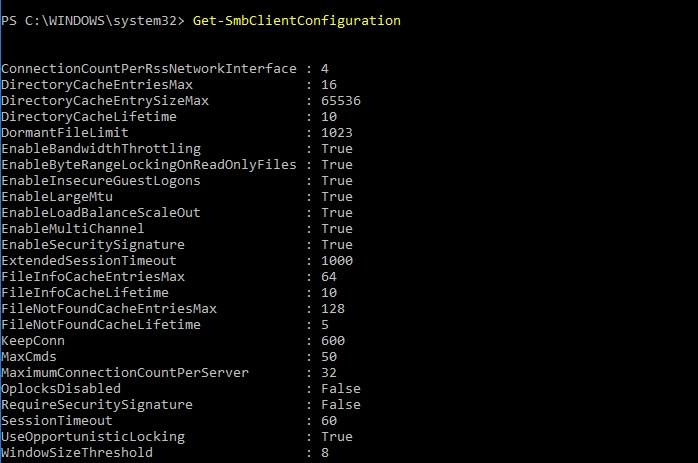

В большинстве своем параметры имеют тип REG_DWORD. В современных Windows управление частью настроек возможно через командлет Set-SmbClientConfiguration. Просмотреть текущие значения - соответственно, Get-SmbClientConfiguration.

Значения параметров клиента SMB.

Параметры, на которые стоит обратить внимание в первую очередь при вопросах быстродействия:

| Имя параметра | Значение по умолчанию | Варианты значений | За что отвечает | Комментарий |

| DisableBandwidthThrottling | 0 | 0-1 | Включение - отключение троттлинга для сетей с высокой задержкой | Включение параметра может повысить пропускную способность сетей с высокой задержкой (WAN) |

| FileInfoCacheEntriesMax | 64 | 1-65536 | Максимальное количество значений в кэше метаданных файлов | Увеличение параметра уменьшает трафик и повышает пропускную способность сети при обращении к большому количеству файлов |

| DirectoryCacheEntrySizeMax | 64 | 1-65536 | Максимальный размер кэша для каталогов | Измеряется в килобайтах |

| FileNotFoundCacheEntriesMax | 128 | 1-65536 | Максимальное количество значений в кэше информации о файлах | Увеличение параметра уменьшает трафик и повышает пропускную способность сети при обращении к большому количеству файлов |

| MaxCmds | 50 | 1-65536 | Максимальное количество команд в сеансе | Увеличение параметра увеличит расход памяти, но поднимет быстродействие. Только для SMB v1 |

| DormantFileLimit | 1023 | 1-65536 | Максимальное количество файлов, которые могут быть открыты, после того как «отпущены» приложением | |

| ScavengerTimeLimit | 10 | 0-127 | Как часто запускается «мусорщик», очищающий кэш дескрипторов файлов | Измеряется в секундах, актуально для Windows XP\2003 |

В качестве примера тюнинга, можно привести следующие значения:

DisableBandwidthThrottling = 1;

FileInfoCacheEntriesMax = 32768;

DirectoryCacheEntriesMax = 4096;

FileNotFoundCacheEntriesMax = 32768;

MaxCmds = 32768;

DormantFileLimit = 32768;

- ScavengerTimeLimit = 60.

Разумеется, конкретно эти значения - не панацея. Параметры должны подбираться индивидуально.

Параметры, настраиваемые через powershell и реестр:

| Имя параметра | Значение по умолчанию | Варианты значений | За что отвечает | Комментарий |

| ConnectionCountPerNetworkInterface | 1 | 1-16 | Максимальное количество подключений к серверу с интерфейсом без поддержки RSS | MS не рекомендует изменять значение по умолчанию |

| ConnectionCountPerRssNetworkInterface | 4 | 1-16 | Максимальное количество подключений к серверу с интерфейсом c поддержкой RSS | |

| ConnectionCountPerRdmaNetworkInterface | 2 | 1-16 | Максимальное количество подключений к серверу с интерфейсом с поддержкой RDMA | |

| MaximumConnectionCountPerServer | 32 | 1-64 | Максимальное количество подключений к одному серверу | |

| DormantDirectoryTimeout | 600 | Максимальное количество времени обработки каталога | Измеряется в секундах |

|

| FileInfoCacheLifetime | 10 | Время хранения информации о файле в кэше | ||

| DirectoryCacheLifetime | 10 | Время хранения метаданных каталога в кэше | ||

| FileNotFoundCacheLifetime | 5 | Время хранения кэша не найденных файлов | ||

| CacheFileTimeout | 10 | Время хранения кэша для файла, после того как файл «отпущен» приложением | ||

| DisableLargeMtu | 0 (Win8) | 0-1 | Включение-отключение большого размера MTU | С включенным параметром размер запроса ограничен 64 КБ, с включенным - 1 МБ. |

| RequireSecuritySignature | 0 | 0-1 | Включение-отключение обязательной подписи SMB | Включение этого параметра замедляет скорость работы, но повышает защиту от атаки MITM |

| DirectoryCacheEntriesMax | 16 | 1-4096 | Максимальное количество значений в кэше информации о каталогах | Увеличение параметра уменьшает трафик и повышает пропускную способность сети при обращении к большим каталогам |

| MaxCredits | 128 | Максимальное количество команд в сеансе | Тоже самое, что и MaxCmds, но для SMB v2 |

Параметры, настраиваемые через powershell:

| EnableMultiChannel | 1 | 0-1 | Включение-отключение использования нескольких физических адаптеров | |

| EnableByteRangeLockingOnReadOnlyFiles | True | True\False | Включение-отключение блокировки файлов «только для чтения» | |

| EnableInsecureGuestLogons | True | True\False | Включение-отключение гостевого входа на ресурс | Отключение не позволит заходить без авторизации на расшаренные для всех папки на недоменном сервере (NAS) |

| EnableLoadBalanceScaleOut | True | True\False | Включение-отключение поддержки распределения нагрузки при подключении к кластеру | |

| EnableSecuritySignature | True | True\False | Включение-отключение возможности подписи SMB | |

| ExtendedSessionTimeout | 1000 | Время ожидания ответа от сервера | Измеряется в секундах | |

| KeepConn | 600 | Время до закрытия неактивной сессии | Измеряется в секундах, применимо только к SMB v1 | |

| OplocksDisabled | False | True\False |

Переключается автоматически в зависимости от значения параметра UseOpportunisticLocking | |

| SessionTimeout | 60 | Время до закрытия неактивной сессии | Измеряется в секундах | |

| UseOpportunisticLocking | True | True\False | Включение-отключение режима гибких блокировок (oplock) файлов с их буферизацией | Включенный механизм сильно увеличивает быстродействие, но в ненадежных сетях может привести к повреждению файлов |

| WindowSizeThreshold | 1 для серверных систем, 8 для клиентских | Минимальный размер окна до включения режима Multichannel |

Если же говорить уже непосредственно про файловый сервер, то вот несколько общих рекомендаций:

Для лучшего быстродействия не используйте ненужные функции вроде мини-фильтров файловой системы, IPSec, шифрование и сжатие NTFS, шифрование SMB и другие. Включение антивируса может существенно подпортить быстродействие, и если периметр сети защищен, лучше его и не устанавливать.

Регулярно стоит проверять актуальность драйверов, особенно на сетевые карты. Встречались ситуации, когда из-за кривых драйверов сетевая карта стабильно работала только при принудительном выставлении сто мегабит. И только с выходом свежих драйверов удалось выжать полноценный гигабит.

- Копирование файлов - довольно регулярная операция для файлового сервера. При копировании по сети предпочтительнее использовать утилиту robocopy.exe с ключом /mt, включающим многопоточность для большого количества мелких файлов. Немного быстродействия добавит и отсутствие вывода в консоль - ключ /log для robocopy и /q для xcopy.

Для оценки быстродействия работы протокола SMB можно использовать счетчики производительности, которые существуют как для сервера, так и для клиента.

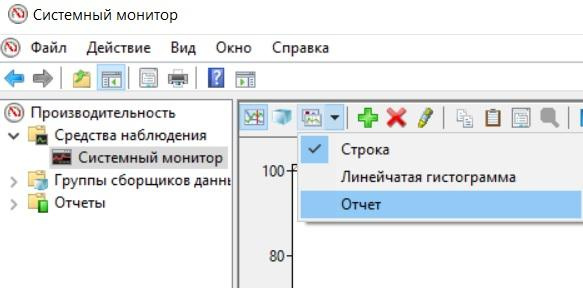

Тут поможет утилита perfmon.exe. После запуска удобно переключить отображение в режим «отчет»:

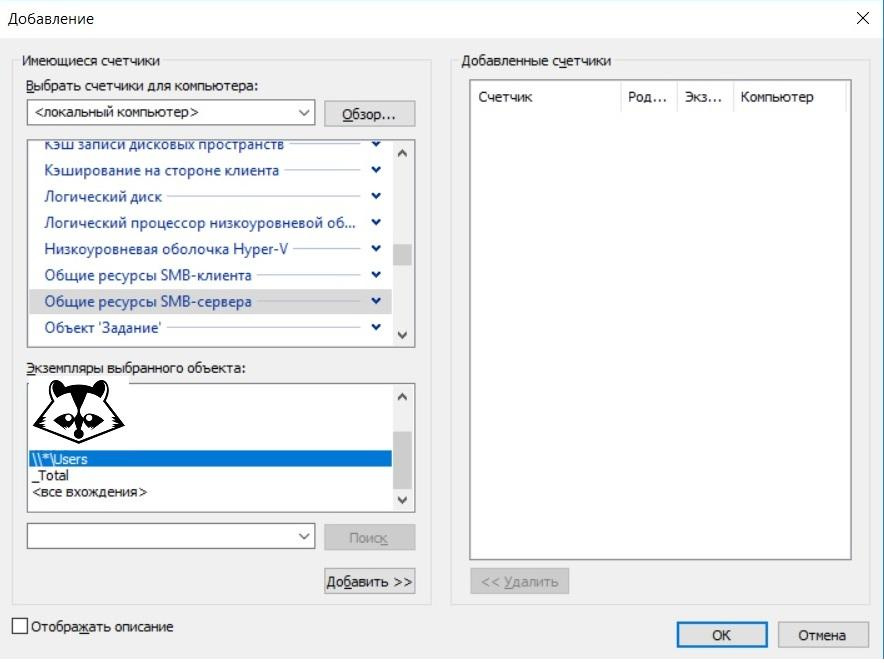

Потом необходимо добавить нужные счетчики производительности. Для примера добавим счетчик «Общие ресурсы SMB сервера», нажав на зеленый плюс, выбрав нужный нам счетчик и общий ресурс:

И наслаждаемся результатом:

Более полно с процедурой использования счетчиков производительности, сбора и анализа результата рекомендую ознакомиться в блоге Microsoft.

Перейдем к тюнингу. За работу сервера SMB отвечает служба Lanmanserver, поэтому часть параметров можно изменить в соответствующей ветке реестра:

HKLM\System\CurrentControlSet\Services\LanmanServer\Parameters.

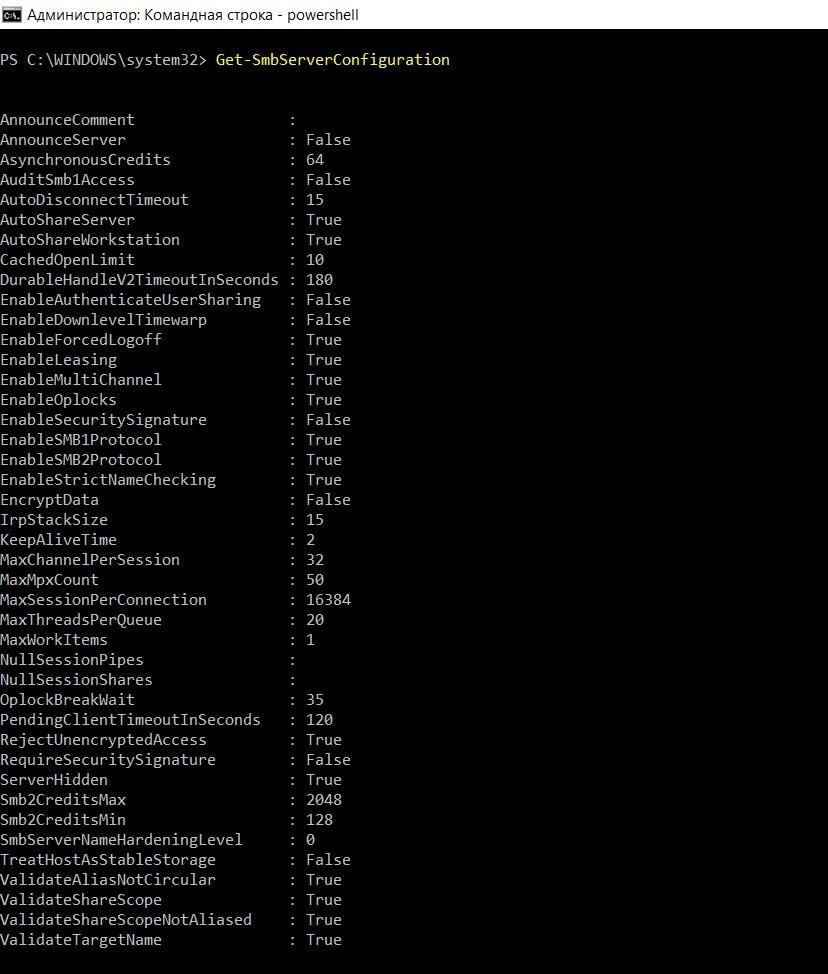

Удобнее, конечно, использовать командлет Set-SmbServerConfiguration.

Вывод значений параметров с помощью командлета Get-SmbServerConfiguration.

Параметры, на которые стоит обратить внимание в первую очередь:

| Имя параметра | Значение по умолчанию | Тип параметра | За что отвечает | Комментарий |

| Smb2CreditsMax | 8192 | uint32 | Максимальное количество команд SMB v2 | Эти два параметра позволяют динамически распределять нагрузку. Иногда при использовании скоростных каналов с высокой задержкой (WAN) изменение этих параметров увеличит скорость. Посмотреть, есть ли проблемы, поможет счетчик производительности «Общие ресурсы SMBклиента - Задержек кредита/c» |

| Smb2CreditsMin | 512 | uint32 | Минимальное количество команд SMB v2 | |

| MaxThreadsPerQueue | 20 | unit32 | Максимальное количество потоков сервера при обработке одновременных запросов | Увеличение параметра влияет на аппаратную загрузку, но увеличивает производительность. Показателем к изменению параметра может служить значение счетчика производительности «Рабочие очереди сервера - Длина очереди - SMB2 NonBlocking» становится больше 100. |

| AsynchronousCredits | 512 | uint32 | Максимальное количество одновременных асинхронных команд в одной сессии | В ряде случаев, например, при использовании нагруженного веб-сервера, увеличение значения параметра увеличивает производительность |

| MaxMpxCt | 50 | uint32 | Максимальное количество невыполненных клиентских запросов для каждого клиента | Влияет только на клиентов SMB v1 |

Существует еще один параметр реестра, не контролируемый командлетом powershell:

путь: HKLM\System\CurrentControlSet\Control\Session Manager\Executive;

параметр: REG_DWORD c именем AdditionalCriticalWorkerThreads;

- значение по умолчанию: 0.

Этот параметр отвечает за дополнительные рабочие процессы, отвечающие за процедуры записи и чтения в системном кэше файловой системы. По умолчанию дополнительных процессов нет, и изменение этого параметра может существенно ускорить работу файлового сервера. Особенно при наличии многоядерных процессоров и производительной дисковой системы. Задумываться об увеличении этого параметра можно при росте счетчика производительности «Кэш - «Грязные» страницы».

В качестве примера тюнинга можно привести следующие значения параметров:

AdditionalCriticalWorkerThreads = 64;

MaxThreadsPerQueue = 64;

- MaxMpxCt = 32768.

Значения также должны подбираться индивидуально.

| Имя параметра | Значение по умолчанию | Тип параметра | За что отвечает | Комментарий |

| AnnounceComment | null | string | Представление сервера | |

| AnnounceServer | False | boolean | Включение - отключение представления сервера | |

| AuditSmb1Access | False | boolean | Включение - отключение аудита доступа по протоколу SMB v1 | Параметр появился только в Windows 10\2016 |

| AutoDisconnectTimeout | 15 | uint32 | Время, после которого отключается неактивная сессия | |

| AutoShareServer | True | boolean | Включение - отключение сетевых ресурсов сервера по умолчанию | |

| AutoShareWorkstation | True | boolean | Включение - отключение сетевых ресурсов рабочей станции по умолчанию | |

| CachedOpenLimit | 10 | uint3 | Максимальное количество открытых файлов в кэше | |

| DurableHandleV2TimeoutInSeconds | 180 | uint32 | Время отключения неактивного дескриптора | |

| EnableAuthenticateUserSharing | False | boolean | Включение - отключение возможности общего доступа к соединению | |

| EnableDownlevelTimewarp | False | boolean | Включение - отключение низкоуровневого искажения времени | |

| EnableForcedLogoff | True | boolean | Включение - отключение принудительного выхода | |

| EnableLeasing | True | boolean | Включение - отключение аренды | |

| EnableMultiChannel | True | boolean | Включение - отключение использования нескольких физических адаптеров | |

| EnableOplocks | True | boolean | Включение - отключение гибких блокировок (oplock) | |

| EnableSecuritySignature | False | boolean | Включение - отключение возможности подписи SMB | |

| EnableSMB1Protocol | True | boolean | Включение - отключение протокола SMB v1 | |

| EnableSMB2Protocol | True | boolean | Включение - отключение протокола SMB v2+ | |

| EnableStrictNameChecking | True | boolean | Включение - отключение проверки имени входящего подключения | |

| EncryptData | False | boolean | Включение - отключение поддержки шифрования данных | |

| IrpStackSize | 15 | unit32 | Размер стека IRP (запросов ввода - вывода) | |

| KeepAliveTime | 2 | unit32 | Частота TCP запросов keepalive для подключения SMB | |

| MaxChannelPerSession | 32 | unit32 | Количество каналов в одной сессии | |

| MaxMpxCount | 50 | unit32 | Максимальное количество команд в сессии | Параметр должен быть настроен так же, как и параметр MaxCmds клиента |

| MaxSessionPerConnection | 16384 | unit32 | Максимальное количество сессий в одном соединении | |

| MaxWorkItems | 1 | uint32 | Максимальное количество рабочих элементов | Параметр влияет только на SMB v1 |

| NullSessionPipes | null | string | Каналы, доступные в нулевой сессии | |

| NullSessionShares | null | string | Сетевые ресурсы, доступные в нулевой сессии | |

| OplockBreakWait | 35 | uint32 | Время ожидания до прерывания блокировки | |

| PendingClientTimeoutInSeconds | 120 | uint32 | Время ожидания клиента | |

| RejectUnencryptedAccess | True | boolean | Включение - отключение незашифрованных запросов на доступ | |

| RequireSecuritySignature | False | boolean | Включение - отключение обязательной подписи SMB | Включение этого параметра замедляет скорость работы, но повышает защиту от атаки MITM |

| ServerHidden | True | boolean | Включение - отключение представления сервера | По умолчанию сервер не представляет себя |

| SmbServerNameHardeningLevel | 0 | uint32 | Уровень упрощения имени сервера | |

| TreatHostAsStableStorage | False | boolean | Включение - отключение надежного дискового хранилища | Включение этого параметра говорит серверу о надежности дискового хранилища, стоит включать его при работе с диском с энергонезависимым кэшем на запись. Тогда сервер не будет дожидаться подтверждения записи на диск, что ускорит быстродействие. |

| ValidateAliasNotCircular | True | boolean | Включение - отключение использования псевдонимов | |

| ValidateShareScope | True | boolean | Включение - отключение проверки имени ресурсов при создании нового ресурса | |

| ValidateShareScopeNotAliased | True | boolean | Включение - отключение проверки псевдонимов ресурсов при создании нового ресурса | |

| ValidateTargetName | True | boolean | Включение - отключение проверки имени целевого ресурса при создании псевдонима |

Повторюсь: изменение параметров может привести к неработоспособности сервера. Поэтому лучше сначала «потренироваться на кошках». Или хотя бы делать бэкапы.

Перейду к следующей, казалось бы, простой роли - сервер печати.

Сервер печати

Помимо рекомендаций вида «быстрее, выше, сильнее» в плане аппаратной части, нужно отметить несколько других интересных моментов.

Перенос очереди печати на несистемный диск довольно сильно увеличит производительность сервера. Это делается в свойствах сервера печати, на вкладке «дополнительные параметры».

Настройка размещения очереди печати.

По возможности лучше отрисовывать задачи на клиенте. В таком случае клиент будет сам переводить документ в специальный формат для печати (PDL). Сервер же не будет тратить ресурсы на это преобразование.

По умолчанию эта возможность уже включена, включить-выключить можно групповой политикой для всех принтеров. Индивидуальную настройку принтеров можно провести с помощью команды

printui /Xs /n "printer" ClientSideRender disabled

Отключать отрисовку на клиенте имеет смысл при достаточном запасе производительности сервера печати для разгрузки клиентов.

Принтеры с поддержкой XPS (OpenXPS) меньше нагружают сервер, чем принтеры без нее. Принтеры с поддержкой PCL 6 и Postscript чуть менее эффективны из-за векторного формата. Поэтому при выборе принтера лучше подбирать с поддержкой XPS, и устанавливать соответствующий драйвер.

С выходом Windows 8\2012 появилась поддержка драйверов печати v4. Драйвера 4-й версии более производительны, но Windows 7 будет печатать на драйвере четвертого типа, отрисовывая задачи на клиенте. Поэтому если в сети еще встречаются старые Windows, стоит установить и драйвера третьего типа. Посмотреть на тип драйвера можно в свойствах сервера печати на вкладке «Драйверы»:

Окно установки дополнительных драйверов.

Если говорить о возможностях драйверов четвертого типа, то к ним можно отнести:

использование видеокарты для отрисовки задач печати. Да, теперь для повышения быстродействия при отрисовке задач на сервере можно установить в принтсервер видеокарту;

- упрощенная система подключения «расшаренного» принтера: теперь не нужно ставить драйвера под разные архитектуры процессора.

Заслуживает внимания и технология Branch Office. С ее помощью клиент работает с принтером напрямую, минуя какую-либо обработку на сервере печати. Правда, понадобятся принтеры с поддержкой TCP\IP или WSD. Подробнее ознакомиться с технологией можно на сайте Microsoft, а включить или отключить для конкретного принтера можно с помощью командлета powershell:

Set-Printer -name -ComputerName -RenderingMode BranchOffice

Технология не работает, если используется обработка печати на сервере.

Для диагностики узких мест при печати обратите внимание на три процесса:

Spoolsv.exe;

Printfilterpipelinesvc.exe;

- Printisolationhost.exe;

А также смотрите на расход этими процессами памяти, процессора и нагрузки на жесткий диск. Для более тонкого поиска узких мест помогут специальные счетчики производительности.

Набор типовых счетчиков производительности подсистемы печати.

| Название | Описание |

| Всего заданий напечатано | Количество напечатанных заданий |

| Всего напечатано страниц | Количество напечатанных страниц |

| Вызовов добавления сетевого принтера | Количество подключений к расшаренному принтеру с момента последнего перезапуска службы |

| Заданий | Количество напечатанных заданий с момента последнего перезапуска службы |

| Заданий, обрабатываемых диспетчером печати | Текущее количество заданий в службе печати |

| Максимум заданий, обрабатываемых диспетчером | Максимальное количество заданий в службе печати |

| Максимум ссылок | Максимальное количество обращений к очереди печати |

| Ошибок заданий | Количество ошибок заданий |

| Ошибок «Отсутствует бумага» | Количество ошибок, вызванных отсутствием бумаги |

| Ошибок «Принтер не готов» | Количество ошибок принтера |

| Печатаемых байт/c | Скорость текущей печати в байтах, позволяет приблизительно оценить время занятости принтера |

| Ссылок | Текущее количество обращений к очереди печати |

В общем, подобрав параметры под конкретную ситуацию, можно повысить производительность этих простых ролей до 50%. А refurbished сервер еще даст прикурить современным монстрам с настройками «по умолчанию».

Расскажите в комментариях, про повышение быстродействия каких ролей Windows вам было бы интересно почитать. Приходилось ли вам заниматься тюнингом ролей и сервисов? Каких результатов достигли?

|

Метки: author Tri-Edge системное администрирование серверное администрирование серверная оптимизация блог компании сервер молл оптимизация windows производительность |

Как собрать базу данных для рассылок и не превратиться в спамера? |

Мы неоднократно поднимали здесь тему смс-уведомлений, push, омниканальных коммуникаций и видели очень разную реакцию в комментариях и рейтингах. И если бизнес погружается в эту тему, потому что ищет эффективные каналы, то обычный пользователь может “наложить” минус, потому что имеет негативный опыт неправильного использования технологии против него.

И это явно проявляется на уровне обсуждения технологии и на таком сайте, где люди, в целом, понимают грани между адекватным и неправильным использованием инструментов. Что же говорить о ситуации “в полях”, где эта грань еще тоньше? SMS-рассылки действительно могут быть уникальным инструментом, а могут закрепить за компанией репутацию спамера. Чтобы этого не случилось, важно быть ответственным на каждом этапе.

Мы периодически сталкиваемся (к счастью, уже реже) с расхожим взглядом, что достаточно лишь приобрести где-то базу данных телефонных номеров, и можно тут же сделать рассылку и получить массу новых клиентов. На самом деле, плохо составленная база принесет бизнесу только убытки.

Во-первых, неизвестно, какой в ней будет процент целевой аудитории, а какое количество сообщений уйдет вхолостую или даже вызовет раздражение получателя. Во-вторых, база должна быть обязательно актуальной, без недействительных номеров или номеров, сменивших владельца. Наконец, потенциальный клиент должен быть расположен к тому, чтобы обратиться к вам как можно быстрее, иначе он быстро забудет о вашем предложении.

Идея покупки базы данных, собранной кем-то другим, может звучать заманчиво. Но мы категорически не рекомендуем прибегать к такому методу. Наибольшую эффективность даст база, собственная вами собственноручно, хотя это может оказаться не так быстро и просто.

Есть несколько способов собрать действительно качественную базу для рекламных рассылок, где аудитория одобрит их получение, а у вас будет возможность ее сегментации. Хотя ни один из них не является секретом, почему-то часто компании забывают о них. Попробуем напомнить.

Первый, и самый распространенный способ – это опросники, которые заполняют клиенты, и в которых они не просто оставляют контактные данные, но и фактически представляют себя компании, рассказывают о том, что их интересует. Кроме того, они подтверждают, что уже знакомы с вами и вашим продуктом, а значит, ваша реклама не будет для них чем-то неожиданным и непонятным. Чтобы мотивировать клиентов заполнять опросник, предложите им одноразовую скидку или какой-то другой бонус.

Второй способ – регистрация на веб-сайте компании. Если клиент готов оставить вам личные данные, значит, он уже заинтересован в сотрудничестве с вами. Остается только подобрать предложение, от которого ему не захочется отказываться. Многие используют т.н. лид-магнит (Lead Magnet) — ценное и бесплатное предложение для потенциального клиента, которое он может получить в обмен на совершение целевого действия. Это могут быть книги, отчеты, доставка… На эту тему есть огромное количество руководств в сети и мы не будем на них заострять внимание.

Третий способ заключается в размещении в рекламе вашей компании номера для приема SMS от клиентов, в ответ на которое вы отправляете более детальную информацию. Это очень удобно и ему, и вам. Ему не придется искать информацию самому, а вы получите контакт с человеком, который интересуется вашим продуктом и может стать вашим клиентом.

Наконец, попробуйте мотивировать людей оставлять вам свои данные, приглашая их участвовать в разнообразных конкурсах. Если хорошо продумать условия конкурса, то на него обязательно отзовется ваша целевая аудитория. Вашей задачей будет ее не отпустить.

Продумывая способы пополнения базы своих потенциальных клиентов, помните самое главное: она должна соответствовать вашей целевой аудитории. Ваша целевая аудитория – это люди, которые проявляли интерес к вашему продукту, возможно, даже уже его покупали, и которые имеют возможность его приобретать и в дальнейшем. И эти люди должны предоставлять вам личные контакты сознательно и добровольно. Только тогда коммуникация с помощью SMS будет честной, оправданной и взаимовыгодной.

|

|

Рынок систем детекции и распознавания: Эмоции и «эмоциональные вычисления» |

/ Flickr / Britt Selvitelle / CC

/ Flickr / Britt Selvitelle / CCСистемы распознавания эмоций (EDRS)

Рынок систем детекции и распознавания эмоций (EDRS) активно развивается. По оценкам ряда экспертов, он продемонстрирует среднегодовой рост в 27,4% и достигнет планки 29,1 млрд долларов к 2022 году. Такие цифры вполне оправданны, поскольку программное обеспечение для распознавания эмоций уже позволяет определять состояние пользователя в произвольный момент времени при помощи веб-камеры или специализированного оборудования, параллельно анализируя поведенческие паттерны, физиологические параметры и изменения настроения пользователя.

Системы, считывающие, транслирующие и распознающие данные эмоциональной природы, можно разбить на группы по типу определения реакций: по физиологическим показателям, мимике, языку тела и движениям, а также по голосу [о последних двух вариантах определения реакций мы более подробно поговорим в последующих материалах].

К физиологии как источнику информации об эмоциях человека нередко прибегают в клинических испытаниях. Например, этот способ детекции эмоций был встроен в метод БОС (биологической обратной связи), когда пациенту на экран монитора компьютера «возвращаются» текущие значения его физиологических показателей, определяемых клиническим протоколом: кардиограмма, частота сердечных сокращений, электрическая активность кожи (ЭАК) и др.

Подобные приемы нашли применение и в других сферах. Например, определение эмоций по физиологическим данным является ключевой функцией устройства MindWave Mobile от NeuroSky, которое надевается на голову и запускает встроенный датчик мозговой активности. Он фиксирует степень концентрации, расслабления либо беспокойства человека, оценивая ее по шкале от 1 до 100. MindWave Mobile адаптирует способ регистрации ЭЭГ, принятый в научных исследованиях. Только в этом случае система оснащена всего одним электродом, в отличие от лабораторных установок, где их количество превышает десять.

Примером детекции эмоциональных реакций по мимике может служить сервис FaceReader нидерландской компании Noldus Information Technology. Программа способна интерпретировать микроэкспрессии лица, распределяя их по семи основным категориям: радость, грусть, гнев, удивление, страх, отвращение и нейтральная (neutral). Кроме того, FaceReader умеет с достаточно высокой точностью определять по лицам возраст и пол человека.

Принципы работы программы базируются на технологиях компьютерного зрения. В частности, речь идет о методе Active Template, заключающемся в наложении на изображение лица деформируемого шаблона, и методе Active Appearance Model, позволяющем создавать искусственную модель лица по контрольным точкам с учетом деталей поверхности. По словам разработчиков, классификация происходит посредством нейронных сетей с тренировочным корпусом в 10 тыс. фотографий.

В этой области заявили о себе и крупные корпорации. Например, компания Microsoft занимается развитием собственного проекта под названием Project Oxford — набора готовых REST API, реализующих алгоритмы машинного зрения (и не только). Программное обеспечение умеет различать по фотографии такие эмоции, как гнев, презрение, отвращение, страх, счастье, грусть и удивление, а также сообщать пользователю об отсутствии каких-либо зримо выраженных эмоций.

Важно отметить тот факт, что над системами распознавания эмоций работают и российские компании. Например, на рынке представлена EDR-система EmoDetect. Программное обеспечение решения способно определять психоэмоциональное состояние человека по выборке изображений (или видео). Классификатор выявляет шесть базовых эмоций — уже упомянутые выше радость, удивление, грусть, злость, страх и отвращение.

Распознавание ведется на основе 20 информативных локальных признаков лица, характеризующих психоэмоциональное состояние человека (ASM). Также производятся расчет двигательных единиц и их классификация по системе кодирования лицевых движений П. Экмана (FACS Action Units). Помимо этого, решение строит графики динамического изменения интенсивности эмоций испытуемого во времени и формирует отчеты о результатах обработки видео.

Кроме того, в рамках этого поста нельзя обойти стороной и тему отслеживания эмоций по данным глазодвигательной активности. Это направление называется окулографией, или в более привычных терминах — айтрекингом. Идея заключается в фиксации моментов задержки взгляда в определённом месте или точке пространства (зрительной сцены), а также регистрации его скорости. В окулографии имеется и свой высокотехнологичный инструментарий — айтрекеры, задействованные в сложных экспериментальных исследованиях.

Так, компания Neurodata Lab совместно с командой разработчиков из Ocutri создала прототип софтового айтрекера Eye Catcher 0.1, позволяющего извлекать данные движений глаз и головы из видеофайлов, записанных на обычную камеру. Эта технология открывает новые горизонты в изучении движений глаз человека в естественных условиях и ощутимо расширяет исследовательские возможности. Помимо этого, линейки айтрекинговых устройств выпускают такие компании глобального значения, как SR Research (EyeLink), Tobii, SMI (приобретенная на днях корпорацией Apple), а также GazeTracker, Eyezag, Sticky и др. Основным рабочим инструментом последних тоже является веб-камера.

К сегодняшнему дню окулография применяется как в науке, так и в игровой индустрии и онлайн-маркетинге (нейромаркетинге). Решающее значение при покупке в онлайн-магазине играет месторасположение информации о продукте, способствующей конверсии. Требуется и досконально учитывать позиции баннеров и прочей визуальной рекламы.

Например, Google работает над оформлением поверхностей отображения на странице выдачи с использованием айтрекинга, чтобы генерировать максимально эффективные предложения для рекламодателей. Окулография предлагает обоснованный, корректный метод анализа, оказывающий значительную практическую помощь веб-дизайнерам и способствующий тому, чтобы информация above the fold лучше воспринималась пользователями.

Affective computing — «эмоциональные вычисления»

Ключевой вектор развития внедряемых в жизнь человека новых информационных технологий — это улучшение человеко-машинного взаимодействия — human-computer interaction (HCI). Появление EDR-систем привело к возникновению такого понятия, как эмоциональные вычисления, или же по устоявшейся англоязычной терминологии — affective computing. Affective computing — это вид HCI, при котором устройство способно детектировать и соответствующим образом реагировать на чувства и эмоции пользователя, определяемые по мимике, позе, жестам, речевым характеристикам и даже температуре тела. Любопытны в связи с этим и решения, обращающиеся к подкожному кровотоку (как это делает канадский стартап NuraLogix).

Количество проводимых исследований и объемы финансирования говорят о том, что это направление является чрезвычайно перспективным. По данным marketsandmarkets.com, рынок affective computing вырастет с 12,2 млрд долларов в 2016 году до 54 млрд долларов к 2021 году при среднегодовом темпе роста 34,7%, хотя львиная его доля, как и ранее, останется за ведущими игроками рынка (Apple, IBM, Google, Facebook, Microsoft и др.).

Признание статуса эмоциональных вычислений как самостоятельной научно-исследовательской ниши и рост публичного интереса к этой сфере наблюдается приблизительно с 2000 года, когда Розалинд Пикард (Rosalind Picard) опубликовала свою книгу под знаковым названием «Affective Computing» — именно эта монография положила начало профильным исследованиям в MIT. Позднее к ним подключились ученые и из других стран.

Информация в нашем мозгу эмоционально предопределена, и мы часто принимаем решения просто под воздействием того или иного эмоционального импульса. Именно поэтому Пикард в своей книге представила идею конструирования машин, которые были бы непосредственно связаны с человеческими эмоциями и даже способны оказывать на них воздействие.

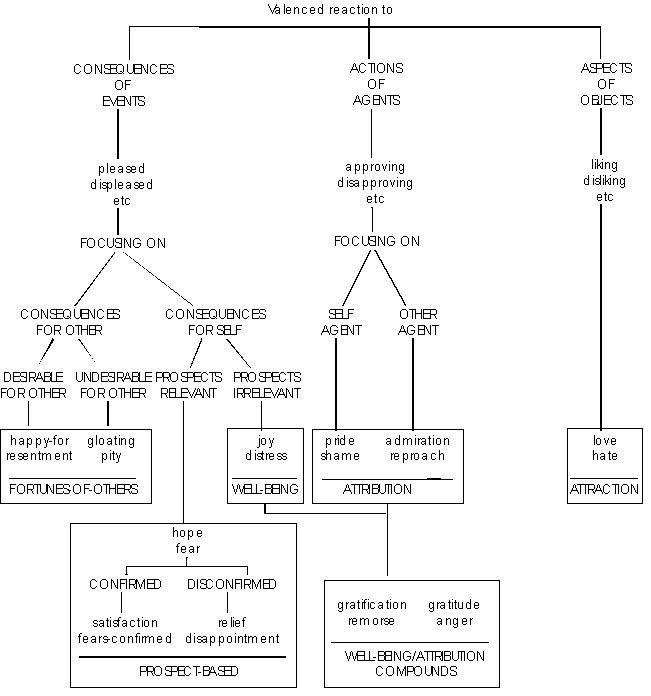

Наиболее обсуждаемым и распространенным подходом к созданию приложений affective computing является построение когнитивной модели эмоций. Система генерирует эмоциональные состояния и соответствующие им экспрессии на основании набора принципов [формирования эмоции], вместо строгого набора пар «сигнал — эмоция». Её также часто объединяют с технологией распознавания эмоциональных состояний, которая ориентируется на признаки и сигналы, проявляющиеся на нашем лице, теле, коже и т. д. На изображении ниже представлены несколько эмоций, классифицируемых по мимическому каналу:

Эмоции считаются определяемыми процессами. Поэтому задачей affective computing становится достижение взаимодействия с пользователем в манере, приближенной к обыденному человеческому общению — машина должна подстраиваться под эмоциональное состояние пользователя и влиять на него. Для такого подхода были даже придуманы правила, сформулированные американскими исследователями Ортони, Клором и Коллинзом (Ortony, Clore and Collins).

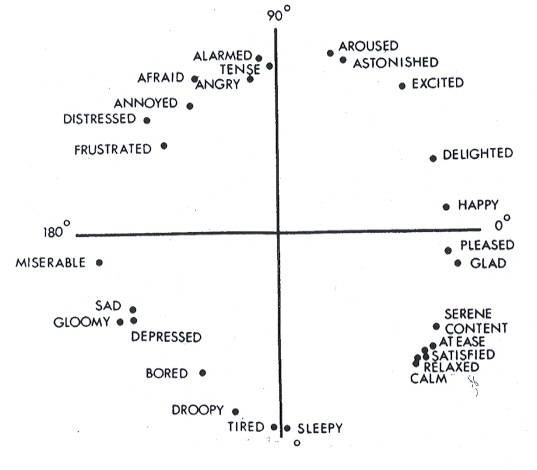

Среди релевантных примеров систем «эмоциональных вычислений» стоит выделить работу Розалинд Пикард и её коллег. С целью повышения результативности обучения студентов учеными была предложена оригинальная эмоциональная модель, построенная на базе циклической модели Рассела. В конечном счете они хотели создать электронного компаньона, отслеживающего эмоциональное состояние студента и определяющего, необходима ли ему помощь в процессе освоения новых знаний.

Интересным применением программных решений, разрабатываемых группой Пикард в MIT, является обучение детей, страдающих аутизмом, определению собственных эмоций и эмоциональных состояний окружающих людей. Все это послужило стимулом к возникновению компании Empatica, которая предлагает потребителям (в том числе больным эпилепсией) носимые браслеты под брендом Embrace, регистрирующие кожно-гальванический рефлекс (GSR) и позволяющие в реальном времени мониторить качество сна, а также уровни стресса и физической активности.

Еще одна компания, у истоков которой стояли Розалинд Пикард и её аспирантка из MIT Рана Эль Калибу (Rana el Kaliouby), носит название Affectiva. Разработчики компании выложили свой SDK на платформе Unity, открыв доступ сторонним разработчикам для экспериментов, тестов и реализации всевозможных микропроектов. В активе у компании на текущий момент крупнейшая в мире база проанализированных лиц — более пяти миллионов экземпляров, а также опыт первопроходца в ряде индустрий, где до того технология распознавания эмоций практически не принималась в расчет, однако анализ по-прежнему ведется только в пределах шести базовых эмоций и одного канала (микроэкспрессии лица).

В этом русле в наши дни развиваются многие лаборатории и стартапы. Например, Sentio Solutions разрабатывает браслет Feel, отслеживающий, распознающий и собирающий данные об испытываемых человеком эмоциях в течение дня. Одновременно мобильное приложение предлагает рекомендации, которые должны сформировать у пользователя положительные, с эмоциональной точки зрения, привычки. Встроенные в браслет сенсоры мониторят сразу несколько физиологических сигналов, таких как пульс, кожно-гальванические реакции, температуру кожи, а алгоритмы системы переводят биологические сигналы на «язык» эмоций.

Стоит упомянуть и компанию Emteq. Их платформа Faceteq не только способна отслеживать состояние водителя автомобиля [усталость], но и используется в медицинских целях — специальное приложение оказывает практическое содействие людям, страдающим от паралича лицевого нерва. Ведутся работы и по внедрению решения в сферу виртуальной реальности, что позволит VR-шлему проецировать эмоциональные реакции пользователя на аватар.

Будущее

Сегодня, в 2017 году, стратегической целью исследований в области «эмоциональных вычислений» и EDRS является выход за пределы узких рамок моно- или биканальной логики, что позволит приблизиться к реальным, а не сугубо декларируемым (положим, механически объединяющим микроэкспрессии с носимыми биодатчиками или айтрекингом), сложным мультимодальным технологиям и методам распознавания эмоциональных состояний.

Компания Neurodata Lab как раз и специализируется на разработке высокоинтеллектуальных технологических решений по распознаванию эмоций и внедрении технологий EDRS в различные отрасли экономики: масс-маркетные проекты, интернет вещей (IoT), робототехнику, индустрию развлечений, интеллектуальные транспортные системы и цифровую медицину.

При этом наблюдается плавный переход от анализа статических фотографий и изображений к динамике аудиовидеопотока и коммуникативной среды в разнообразных её проявлениях. Все это задачи нетривиальные, решающие многие узловые проблемы отрасли и требующие проведения углубленных исследований, сбора огромных массивов данных и комплексной интерпретации реакций человеческого тела (вербальных и невербальных).

Людям неинтересно общаться с неэмоциональными агентами, со стороны которых нет никакой эмоциональной отдачи, никакого отклика. Ученые прикладывают значительные силы, чтобы кардинально изменить ситуацию, однако они сталкиваются с определёнными сложностями. Одна из них — отсутствие в вычислительных системах нейронов. Внутри таких систем имеются только алгоритмы, и это объективная данность.

Человечество пытается понять, каким образом формируются те или иные психологические феномены, чтобы воспроизвести их внутри вычислительных систем. Например, этим занимается правительство США, разрабатывая архитектуру TrueNorth, в основе которой лежат нейробиологические принципы. Процессор имеет неклассическую архитектуру, то есть не придерживается архитектуры фон Неймана, а вдохновлен некоторыми моделями работы неокортекса (о чем подробно рассказывает в своих текстах Курцвейл).

В будущем [а оно может оказаться и не столь далеким, как кажется на первый взгляд] прогресс подобных технологий даст возможность сконструировать самообучающиеся системы, не нуждающиеся в программировании. К ним придется применять совершенно иные техники обучения. И нельзя исключать того, что в результате развитие вычислительной техники пойдет совсем в другую сторону.

P.S. В наших последующих материалах мы планируем затронуть такие темы, как распознавание речи и распознавание лиц, поговорить о влиянии физиологических особенностей на распознавание эмоций и о том, какие задачи решают современные нейросистемы. Подписывайтесь на наш блог, чтобы не пропустить, друзья!

|

Метки: author alinatestova машинное обучение блог компании neurodata lab neurodata lab affective computing edrs |

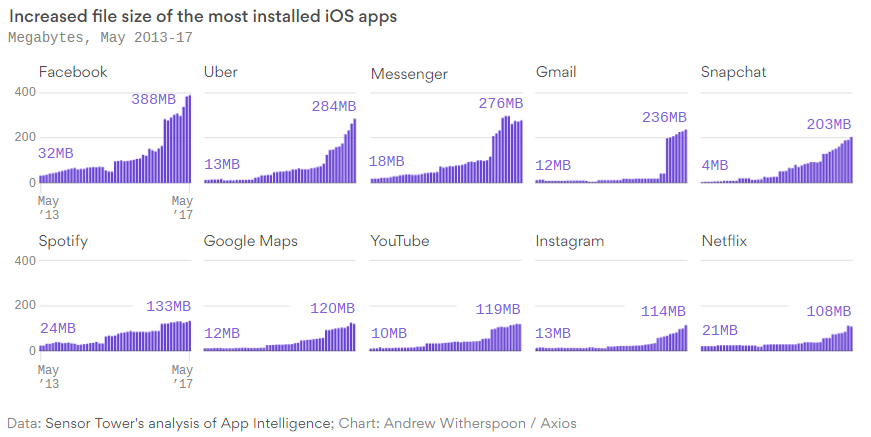

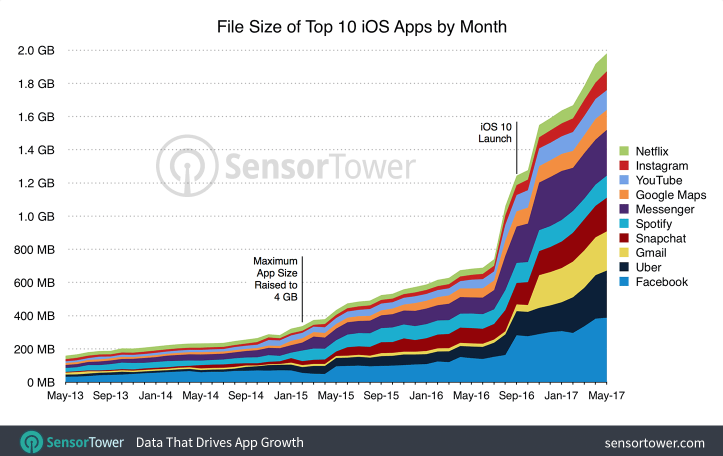

[Из песочницы] Почему мобильные приложения занимают все больше места |

Совсем недавно в интернете появилось несколько интересных инфографик, о том, что популярные приложения для телефонов за пару лет выросли в размере в 12 раз. В этой заметке делается попытка разъяснить некоторые неочевидные причины роста размера мобильных приложений.

Авторы инфографик в оригинальных статьях выделяют две причины такого роста:

- повышение максимального допустимого размера приложений AppStore

- оснащение телефонов все большим объемом памяти

На мой взгляд, указанные тезисы являются только предпосылками и до конца не отвечают на вопрос "почему приложения становятся больше?".

Конечно, в первую очередь дело в добавлении новых функций. Развитие функциональности приложений требует большего размера.

Вот только размер приложений в отличие от их функциональности растет в десятки раз и обычно у этого роста совсем другие причины. Далее на базе разных источников с конкретными примерами я попробую систематизировать разные причины:

Лишние копии ресурсов в приложении

Как ни банально звучит, но в приложениях часто сохраняются одни и те же внутренние ресурсы (картинки, библиотеки, и так далее) по нескольку копий. Это происходит из-за того, что крупные приложения разрабатываются несколькими командами разработчиками, отвечающими за свой конкретный функционал программы. Бывает так, что команда тащит для своего модуля те же ресурсы, что и другая, вызывая задвоение.

В одной из статей автор решил детально разобрать внутреннее строение приложения Facebook для iOS после того, как оно увеличилось за полгода с 165 до 253 мегабайт. Он обнаружил, что в приложении содержалось свыше 40 мегабайт избыточных дублирующих данных. В основном это были картинки, но также были и абсолютно идентичные внутренние программные файлы. Таким образом, просто удалив дубликаты, можно было бы уменьшить размер приложения на 15% процентов. Что, кстати, Facebook впоследствии и сделал.

А/Б тестирование и внедрение новых функций

Распространенной практикой при разработке приложения является добавление новой функциональности и по умолчанию отключение ее. Это позволяет в дальнейшем постепенно включать ее для тестовых или пилотных групп и по необходимости корректировать или обратно выключать. Но даже по прошествии длительного времени, как правило, возможность отключить новый функционал и восстановить старый не убирается и все равно остается в приложении на всякий случай и для экономии времени.

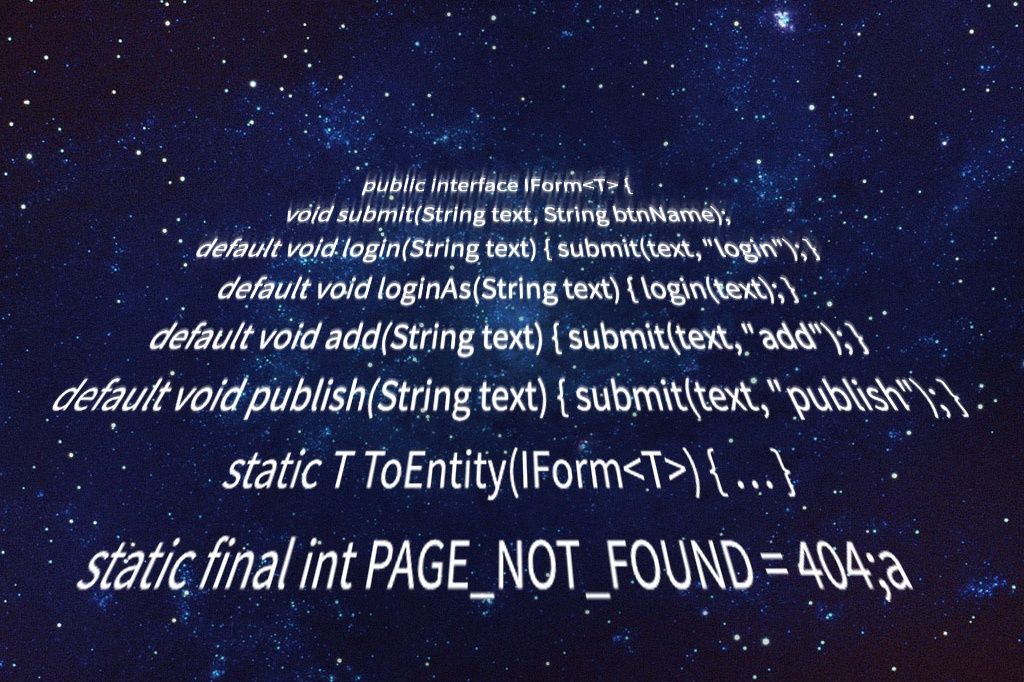

Переход на более комфортные языки программирования

В случае с приложениями под iOS переход с Objective-C на Swift может дать увеличение размера скомпилированного кода приложения в 3-4 раза. Это происходит из-за того, что ради удобства и скорости разработки новые языки могут:

- использовать большие типы данных по умолчанию, которые занимают больше места

- вводить дополнительные тесты и проверки в код при компиляции

- использовать большую стандартную библиотеку функций

Сюда же можно отнести переход приложений на новые фреймворки, которые тащат с собой много необходимых им файлов.

Включение в программы собственных функций, заменяющих стандартные операционной системы

Одним из трендов мобильной разработки под несколько платформ является стремление минимизировать зависимость от конкретной операционной системы. У этого подхода есть свои плюсы. Во-первых, это позволяет не переписывать много кода при изменении внешних системных библиотек. Во-вторых, это позволяет удержать пользователя в своем приложении и обеспечить более консистентный пользовательский опыт (хотя часто бывает так, что своя реализация визуально не отличима от стандартной).

Среди наиболее популярных "велосипедов", заменяющих стандартные средства ОС, можно выделить:

- Браузеры

- Работа с камерой

- Ввод текста и обработка жестов

- Проверка орфографии

Рост требований к приложениям

По мере развития телефонов владельцы экосистем (Apple, Google) начинают предъявлять к программам новые требования по поддержке системных появляющихся возможностей телефонов, которые требуют больше места:

- После появления Retina разработчиков обязали добавлять картинки с большей детализацией и соответственно размеров.

- Переход iOS с 32 на 64 бита впоследствии заставил всех разработчиков выпускать именно 64-битные приложения.

К слову в AppStore для борьбы с ростом размера приложений по таким требованиям потом была представлена технологий App thinning, по которой на конкретный телефон скачивается адаптированная версия приложения без избыточных ресурсов для других версий телефонов.

|

Метки: author OlegPyatakov исследования и прогнозы в it мобильные приложения мобильная разработка ios разработка app store google play |

Снимаем и вносим наличные в банкомате с помощью смартфона. Впервые в мире |

Сказано – сделано.

С чего все началось

Мысли о том, что неплохо бы постепенно переводить процессы оплаты на бесконтакт, пришли к нам еще во время первого фестиваля Alfa Future People. Тогда эта затея хорошо укладывалась в концепцию о том, что на территории фестиваля не должно быть наличных денег. Расплачиваться предлагалось с помощью браслета.

Гость фестиваля на входе получал браслет и привязанную к нему карту (MasterCard). В браслет была встроена смарт-карта, которая и позволяла расплачиваться касанием на торговых точках фестиваля. Таким образом получался и пропуск на фестиваль, и кошелек.

Это был 2014-й, и затем возможность вносить или снимать наличные в банкомате была распространена с браслетов на наши карты MasterCard PayPass, после чего доработали и VISA.

Новый виток развития платежей касанием был задан, когда к делу активно подключились вендоры. Apple 9 сентября 2014-го представила Apple Pay, который не только доказал свою состоятельность, но и задал очередной тренд. Samsung решил не отставать, в результате чего мир увидел Samsung Pay, а сейчас в РФ работает и Android Pay.

Пользователи, оценившие удобство такой оплаты на кассах, не могли не начать задавать вопросы о возможности взаимодействия смартфона и банкомата.

Переговоры

Мы пообщались с ребятами из Apple и объяснили им, что и как хотим сделать. Идея была воспринята с энтузиазмом.

На Apple Pay обкатывались все доработки процессинга, поэтому после выхода Samsung Pay и Android Pay каких-то технических сложностей не возникало, и по сути все подключение новой системы к банкоматам зависело только от успешности переговоров с вендором.

Когда ты делаешь что-то с расчетом на то, чтобы запуститься первым в мире, скорость работы будет играть довольно важную роль. В представлении большинства все процессы, связанные с банковской деятельностью и внедрением чего-то нового, должны быть довольно неторопливыми – тут и сама специфика банковской сферы, и присущая ей бюрократия, и множество других факторов, каждый из которых так или иначе тормозит ход работы.

В нашем же случае все происходило так быстро, что мы сначала что-то делали, внедряли и тестировали, а уже потом писали всю необходимую документацию и вносили возможные корректировки от вендора.

Здесь надо отдать должное нашему подрядчику, БПЦ Банковские технологии, который делал свою часть работы с максимальной оперативностью.

В итоге на все про все в случае с подключением Apple Pay у нас ушел месяц. В апреле 2017-го мы едем в Apple, а уже в начале мая проводим первые живые тесты на банкоматах.

На каких смартфонах это работает и насколько это безопасно

Ответ на оба эти вопроса, по сути, прост – все зависит от самой платежной системы вендора.

То есть если ваш смартфон поддерживает Apple Pay, Samsung Pay или Android Pay, то вы можете снять или внести наличные в одном из наших новых банкоматов с помощью смартфона. Если оплата на пинпаде в магазине работает с помощью часов – то получится использовать их и с банкоматом.

То же касается и безопасности – все, что связано с безопасным хранением токена банковской карты на устройстве, обеспечивается силами самого вендора.

Дополнительная защита от несанкционированного доступа к вашему счету со стороны банкомата – это необходимость вводить пин-код от соответствующей карты при любой операции. К примеру, если в кафе вы можете расплатиться за чашку кофе простым касанием, без пин-кода, то взаимодействие с банкоматом потребует ввода кода даже в том случае, если вы хотите снять со счета 100 рублей.

Где можно попробовать в действии

На начало июля в Москве у нас пока установлено 20 таких терминалов, по России суммарно – 300. Приоритет в установке отдается отделениям Альфа-Банка, но банкоматы ставятся и в бизнес-центрах.

Для того чтобы найти такой банкомат на карте, мы сделали дополнительный фильтр на сайте. В скором времени он должен появиться и в мобильных приложениях.

Эти банкоматы будут выделяться визуально с помощью специальных наклеек, также будет заметно, что под прорезью для карты установлен ридер.

Здесь не обходится без курьезов, потому что люди привыкают ко внешнему виду банкоматов, и начинают что-то подозревать, если вдруг на их любимом аппарате вдруг появляется какая-то дополнительная деталь. Будь это ридер или антискиммер – для пользователя это все равно что-то новое, а значит – подозрительное. Нам уже звонили пару раз по поводу того, что «на банкомате кто-то установил какую-то странную фигню, которая сейчас точно снимет у деньги вообще со всех моих карт». На самом деле, это даже хорошо, что пользователи проявляют бдительность и звонят нам, потому что случаи бывают разные.

К концу 2017-го мы планируем довести число таких банкоматов до 700. Сама перестройка банкоматной сети проводится двумя способами – это и установка новейших моделей банкоматов, и апгрейд текущих (соответствующий софт + ридер). При этом в случае апгрейда стоимость такой доработки составляет примерно 5% от цены нового банкомата.

Сейчас с момента официального запуска прошла пара недель, поэтому показать какую-то подробную статистику использования данной функции будет затруднительно, но общие сведения дают понять, что этим начинают пользоваться все активнее. Причем не столько в тестовом режиме «Дай-ка попробую снять тысячу смартфоном», но и на довольно больших суммах – были снятия около 100 000 рублей с использованием Apple Pay. Пока мы склонны считать, что именно этот Pay станет самым популярным у пользователей, но время покажет.

Что дальше

В планах есть ввод в банкоматный парк так называемых топлесс-банкоматов. Вопреки ожиданиям, у такого банкомата рядом не будет симпатичной ассистентки, помогающей вам снять или внести наличные, это просто банкомат без верхней части (без экрана и без клавиатуры). Подобные банкоматы уже используются в ряде некоторых стран.

Как это работает – все операции (выбор нужного действия, конкретной суммы и прочего) осуществляются на экране смартфона через приложение банка. После уточнения всех деталей остается лишь поднести смартфон к ридеру банкомата и получить или внести наличные. Сам банкомат представляет собой прямоугольный ящик, у которого есть только ридер и отделение для приема и выдачи купюр.

Это, кстати, дает небольшой плюс в плане безопасности. Если раньше над клавиатурой под конкретным углом могли устанавливать камеры, записывающие для злоумышленника ваш пин-код (или вообще использовать подложную клавиатуру в тех же целях), то ввод пин-кода и других данных с экрана вашего смартфона такую уязвимость отсекает. Как и проблему скиммеров – нет прорези для карт = никто не клонирует магнитную полосу вашей карты.

Конечно, есть ненулевая вероятность, что со временем и ростом популярности бесконтакта появятся и миниатюрные NFC-скиммеры, это неизбежно, как вечное противостояние меча и щита. Но, прямо скажем, уровень защиты данных в токене и в магнитной полосе сильно отличается.

Само собой, ожидаем появление подобных банкоматов и у наших коллег по банковскому делу.

А вот насчет распространения подобного по миру пока наблюдается следующая тенденция. Сильнее всего банкоматы развиваются в Азии. Какие-то новые функции и эксперименты чаще всего появляются там (но в случае с пополнением и снятием через смартфон первыми в мире все же стали мы).

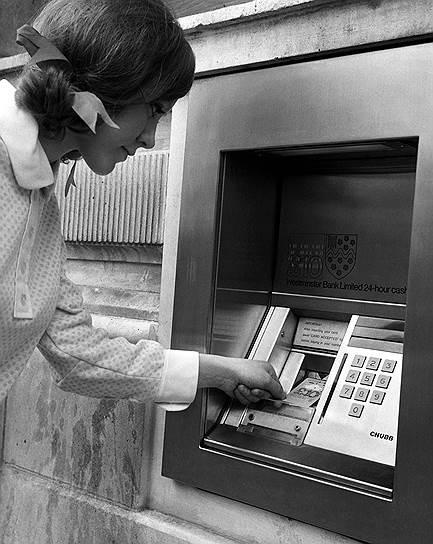

Запад же, несмотря на то, что банкоматы впервые появились именно там, прогрессирует в плане банкоматов не так активно. По большей части это связано с тем, что у них парк банкоматов прошел все ступени эволюции, от первых банкоматов, которые обрабатывали чеки (их именно для этого и придумали) до банкоматов, которые вы можете видеть в США сейчас.

Barclays Bank, 1967-й год, фото – AP.

Вот эта штуковина была первым в мире автоматом по выдаче наличных денег населению. Пользователь вставлял в прорезь чек и получал наличку. Наличка при этом была ограничена суммой в 10 фунтов, потому что в то время не было возможности проверить, сколько денег у клиента на счете в принципе. Зато уже в то время боролись с подделками, и эти чеки, которые выдавал банк, были помечены изотопом углерода-14. Для человека изотоп довольно безвреден, а банкомат мог понять, правильный чек в него вставили, или кто-то решил обогатиться за счет банка не самым законным способом.

Сейчас же в США ситуация сложилась так, что большая часть используемых карт – с магнитными полосами, а не с чипами, не говоря уже о бесконтакте. Кстати, именно по этой причине клонированные карты везут на обнал из РФ в США. Допустим, у вас есть карта с чипом. Каким-то образом в установленном не в самом надежном месте банкомате вы попали на скиммеры, которые считали магнитную полосу и пин-код, после чего злоумышленник с помощью болванки сделал клон вашей карты.