Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

О дизайне в мобильных приложениях (глазами, умом и сердцем разработчика) |

Я нередко слышу, что дизайн для мобильного приложения по сути не так уж и важен. Важна функциональность, качество кода и общая архитектура в проекте и другие технические нюансы, а дизайн не так уж важен в конце концов это просто внешний вид приложения и я с этим не согласен. На мой взгляд дизайн не менее важен.

В этой публикации я хочу поделиться с вами своим мнением на этот счет и тем как на мой взгляд должно быть построено взаимодействие между командами разработки и дизайна.

На мой взгляд, дизайн оказывает влияние если не на все, то на многие другие аспекты приложения, что в конечном итоге сказывается на качестве разрабатываемого продукта. И тут, да простит меня читатель, я не могу не привести эту цитату:

Дизайн — это не то, как продукт выглядит и воспринимается. Дизайн — это то, как он работает. Steve Jobs

Я предлагаю вместе пройтись по некоторым аспектам приложений и подумать как влияет дизайн на тот или иной аспект.

Функциональность

Итак, почему же мы используем программные продукты в целом и мобильные приложения в частности? Ответ прост — потому что нам нужны какие-либо функции того или иного приложения.

Какзалось бы ну как дизайн может определять функциональность? Да никак! Все функции приложения должны быть описаны в требованиях, ТЗ или спецификации.

Но давайте не будем спешить и посмотрим на это с другой стороны. Предположим в приложении есть некий прекрасный функционал (для примера пусть это будет отправка отзыва о полученной услуге в каком-то приложении-агрегаторе), но вы не можете найти тот раздел приложения где это можно сделать. Но ведь те возможности приложения, которые пользователь в приложении так и не нашел — это, по сути, возможности, которых нет в этом приложении для этого пользователя. А что если таких пользователей не один а 5 человек или 10%?

Рассмотрим еще один момент. Существует два приложения со схожим функционалом (пусть это будет какая-нибудь карта или навигатор) и в одном приложении кнопки масштабирования и возврата к местоположению пользователя расположены так, что вы без труда их используятолько большой палец руки, которой смартфон и держите, а у второго приложения эти кнопки расположены менее удобно. Какое приложение выберет пользователь? Вам ведь важно, чтобы люди пользовались именно вашим приложением?

Архитектура

Большинство людей так или иначе учавствующих в процессе разработки сойдутся во мнении, что очень важно грамотно продумать архитектуру приложения. Эта архитектура станет неким каркасом или фундаментом, который поможет предугадать и недопустить некоторых проблем при разработке. Конечно далеко не всех, но от этого хорошая архитектура не становится менее важной. И я тоже согласен что продуманная архитектура крайне важна.

При чем тут дизайн? Так ведь эти вещи связаны напрямую. Что будет в основе самого приложения: вкладки внизу или боковая панель с разделами? Какие данные нам будет передавать серверная часть? А в каком виде она будет передавать те или иные данные?

Я уверен, что человеку ответственному за проектирование архитектуры будет полезно знать что мы будем показывать пользователю в каких разделах. И конечно ему лучше бы сразу увидеть весь дизайн и может даже оценить кликабельный макет иначе какая-нибудь мелочь может спровоцировать взрыв эмоций и необходимость больших правок в уже почти готовой архитектуре.

А как все это в дальнейшем масштабировать?

И многое другое...

Честно говоря не знаю как это выразить или донести до тех кто все еще сомневается в важности качественного дизайна. Успех проекта зависит не только от того насколько чист код в этом проекте и на сколько мало в нем багов. Да, конечно, если вы разрабатывали приложение по заказу, то это важно. Но в таком случае заказчик должен понимать, что будущим пользователям приложения, которое вы для него разрабатываете нет дела до того насколько чист код в этом проекте. Да, критические ошибки расстроят пользователя, но если оно удобное и функциональное, то пользователь возможно подождет пока вы исправите самые неприятные из оплошностей. А в случае если ваше приложение написано идеально и в коде нет ни единой ошибки, но пользователь просто не может разобраться как им пользователем, то он не станет им пользваться.

По этим причинам я считаю что дизайн — это половина приложения.

Как с этим быть?

На мой взгляд избежать описанных выше ошибок можно благодаря максимальному взаимодействию между разработчиками и дизайнерами.

Что должно быть первым шагом в создании дизайна?

Что должен сделать дизайнер когда он начинает работу над новым проектом?

На мой взгляд это не вайрфреймы. В первую очередь дизайнер должен быть пользователем той платформы/устройства под которую ему поручили нарисовать макет. К примеру если это приложение для iPhone, то желательно, чтобы дизайнер использовал это устройство в повседневной жизни.

Отлично, дизайнер пользователь этой платформы. Что дальше?

Может ли теперь дизайнер наконец приступить к созданию вайрфреймов? Нет, не может. Для начала дизайнеру необходимо взять этот гаджет, найти и установить несколько современных приложений и изучить их дизайн. Для начала нужно найти некоторые идеи и, как бы банально это не звучало, вдохновение.

Теперь приступаем к созданию вайрфреймов

На мой взгляд, дизайнеры и разработчики должны быть в постоянном контакте и взаимоейдствии наиная с этого этапа работы над приложением и до самого завершения проекта. Если дизайнер постоянно задает некоторые вопросы о своих идеях и набросках, то он будет получать обратную связь на раннем этапе что поможет разработчику раньше начать продумывать структуру проекта что является важным для качества кода.

У нас есть одобренные вайрфреймы

Отлично, мы можем приступить к самому дизайну. Здесь дизайнер уже точно должен постоянно взаимодействовать и консультироваться с разработчиками. Взаимопомощь никогда не будет лишней в команде, верно? Разработчики по своему опыту могут предсказать потенциальные недочеты в дизайне или слишком нетривиальные места и сложности в разработке. Кроме того разработчики знают о каких-то интересных инструментах (конечно, имеются в виду инструменты для создания UI), которые помогают делать классные приложения и должны делиться этими знаниями с дизайнерами.

Разработчики и дизайнеры вместе должны думать о каждом разделе приложения. Допустим дизайнер подготовил наброски для какого-то списка. Как он будет выглядеть если для отображения нет данных? Или наборот слишком много данных? Как это будет выглядеть на экране больше/меньше?

Дизайн готов

Что же дальше? На мой взгляд теперь разработчик, который будет заниматься этим проектом должен провести ревью макетов. Некоторые из ошибок можно избежать тщательно изучив и продумав все что было создано дизайнером. Теперь когда дизайнер и разработчик помогли друг другу не наделать глупостей готовые макеты можно отдавать на утверждение.

Дизайн утвержден

Отлично. На мой взгляд сейчас и только сейчас можно приступать к разработке проекта. Иногда, дизайн необходимо немного подредактировать, потому что какие-то нюансы проявились только в процессе разработки. И снова разработчики должны постоянно взаимодействовать с дизайнерами. Да, конечно разработчики могут и сами использовать какие-то типовые решения для внесения этих изменений самостоятельно. Но давайте уважать труд друг друга. Наверняка у дизайнера была какая-то глобальная идея или концепция общего вида приложения. Каждая мелкая правка неуместная в рамках этой идеи может испортить внешний вид приложения. И наверняка разработчик этого может просто не заметить, у него голова занята другим. Такие изменения должны быть одобрены командой дизайна, чтобы все мелкие правки были в рамках выбранной изначально идеи или концепции. Это очень важно для первого впечатления пользователя о приложении.

Вместо заключения

Вот такие мысли о важности дизайна в мобильной разработке сформировались у меня по мере появления опыта в создании разнообразных приложений. Я ни в коем случае не стану утверждать что именно такой подход к дизайну и разработке может являться правильным. Тем не менее все выводы появились в результате того или иного опыта в разработке так что возможно мои умозаключения кому-то помогут избежать некоторых ошибок.

|

Метки: author AKhatmullin разработка под ios разработка мобильных приложений анализ и проектирование систем дизайн мобильных приложений проектирование мобильных приложений |

Getsploit: поиск и загрузка эксплойтов по агрегированной базе данных |

Когда я думал над дальнейшим вектором развития Vulners, я обратил внимание на наших старших братьев — базу данных Exploit-DB. Одной из основных утилит в их арсенале является searchsploit. Это консольная утилита, которая позволяет искать эксплойты по пользовательским поисковым запросам и сразу же получать их исходные коды. Она является базовой частью Kali Linux и оперирует данными по эксплойтам из базы Exploit-DB. Что самое "вкусное", что утилита умеет работать с локальной базой и ты можешь всегда взять ее с собой. Так чем же мы хуже? Мы собрали в Vulners не только коллекцию эксплойтов из Exploit-DB, но и Packet Storm, 0day.today, Seebug, Zero Science Lab и многих других. Что же, давайте изобретем новый велосипед с преферансом и поэтессами.

Смотрим внимательнее на searchsploit

И видим внутри bash скрипт длиною 711 строчек. Он скачивает с публичного репозитария exploit-database копию данных и ищет уже по ней. Но где же Google-style синтаксис и прочие прелести современного поиска? Увы, в их подходе нашлись и плюсы и минусы. Плюсы оказались в том, что они способны находить эксплойты по критериям применимости. Минусы — довольно бедный функционал для неточного поиска. На этом идея интегрироваться с ним была отброшена и решение писать свой форк стала доминирующей.

Что должен делать getsploit?

Начнем с того, что определимся с функциональностью.

- Поиск эксплойтов по всей коллекции Vulners с применением Full Text Search и Lucene

- Сохранение исходных кодов эксплойтов на диск

- Offline-поиск с локальной базой данных

- Кроссплатформенность и минимум зависимостей

- Быть Open source

Let there be code

В итоге утилита была реализована на Python с совместимостью от Python 2.6 до Python 3.6. Основные ключи я постарался сохранить идентичными searchsploit для того, что бы не приходилось привыкать заново.

isox$ git clone https://github.com/vulnersCom/getsploit

isox$ cd getsploit

isox$ ./getsploit.py -h

usage: Exploit search and download utility [-h] [-t] [-j] [-m] [-c COUNT] [-l]

[-u]

[query [query ...]]

positional arguments:

query Exploit search query. See https://vulners.com/help for

the detailed manual.

optional arguments:

-h, --help show this help message and exit

-t, --title Search JUST the exploit title (Default is description

and source code).

-j, --json Show result in JSON format.

-m, --mirror Mirror (aka copies) search result exploit files to the

subdirectory with your search query name.

-c COUNT, --count COUNT

Search limit. Default 10.

-l, --local Perform search in the local database instead of

searching online.

-u, --update Update getsploit.db database. Will be downloaded in

the script path.Основная механика поиска строится на базе Vulners API. Таким образом вы всегда получите актуальные данные на момент "здесь и сейчас". Что же, поищем эксплойты под Wordpress?

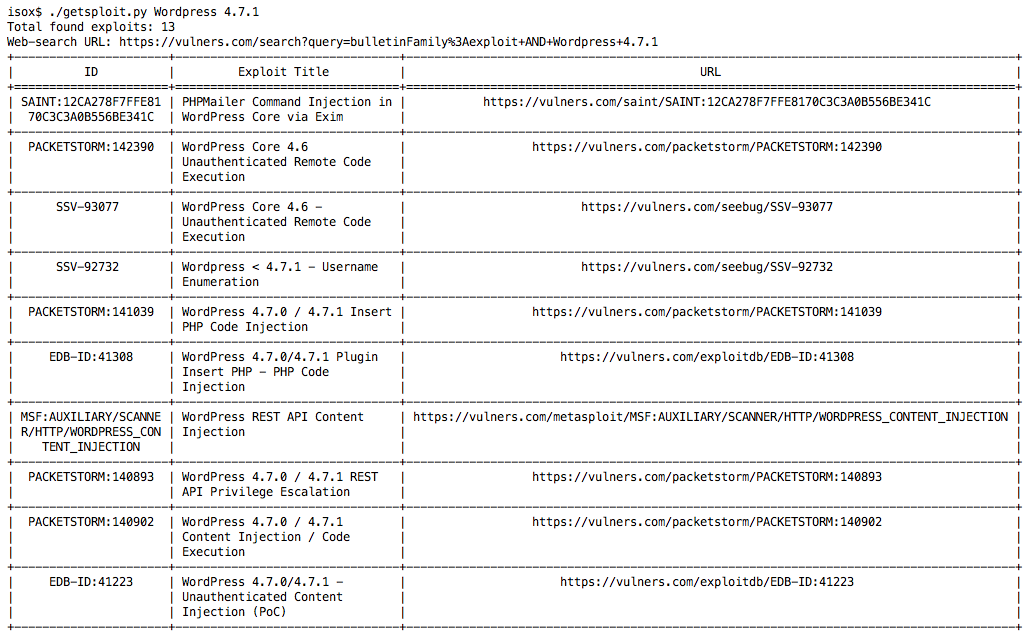

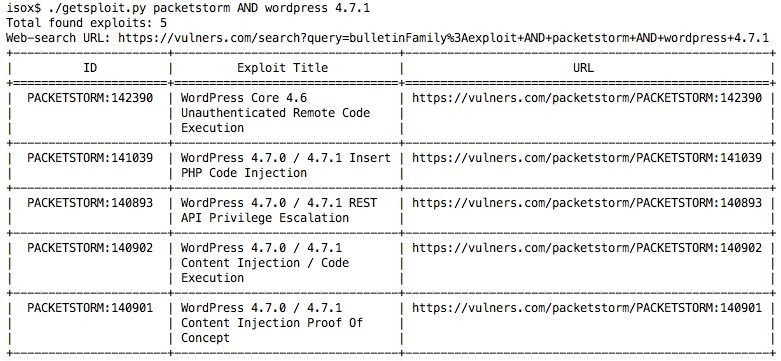

Довольно неплохо, да? Попробуем теперь ограничить нас только коллекцией Packet Storm. Синтаксис выражений полностью совпадает с поисковой строкой сайта и его можно подглядеть на страничке help.

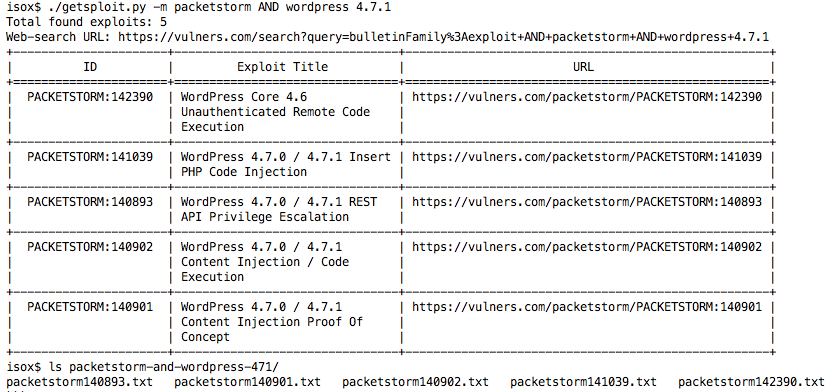

Так, нужные нам эксплойты найдены. Теперь их нужно сохранить для последующего использования. Для этого нужно использовать ключик "-m". После этого утилита создаст папку с вашим поиском и загрузит эксплойты туда.

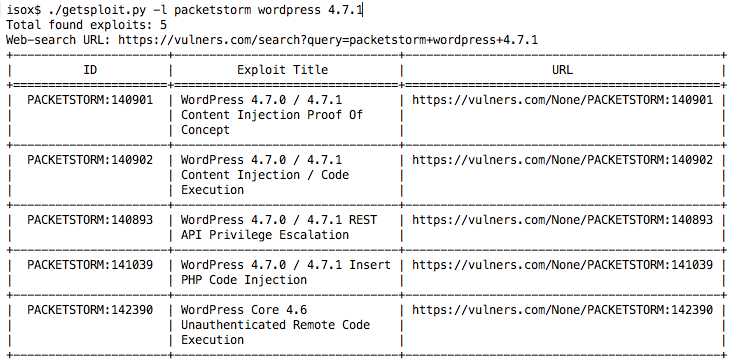

Но что же делать, если у нас нет онлайн подключения к интернету? Вспомнить об этом пока он еще доступен и сделать "--update"!

isox$ ./getsploit.py --update

Downloading getsploit database archive. Please wait, it may take time. Usually around 5-10 minutes.

219686398/219686398 [100.00%]

Unpacking database.

Database download complete. Now you may search exploits using --local key './getsploit.py -l wordpress 4.7'При таком запросе getsploit скачает SQLite базу данных со всей коллекцией эксплойтов. Это порядка 594 мегабайт данных на момент написания статьи.

Обратите внимание, что если у вас Python скомпилирован без поддержки sqlite3 (что в принципе редкость), то локальная база, увы, работать не будет.

Здесь пришлось пожертвовать совместимостью ради скорости работы и возможности полнотекстового поиска с FTS4 модулем SQLite.

Но все не так плохо, основная масса сборок Python по умолчанию идет с модулем sqlite3. Попробуем найти эксплойты локально?

Отлично! Теперь можно взять с собой всю коллекцию эксплойтов с Vulners и использовать ее в оффлайне без регистрации и смс.

Ну и конечно же, исходные коды лежат на нашем GitHub.

Pull-request'ы крайне приветствуются.

|

Метки: author isox информационная безопасность python exploit exploitdb hacking |

Superjob PHP-meetup. Прямая трансляция |

Спикеры и темы:

Алексей Коротин, старший разработчик Superjob, с докладом «Внедрение RESTful в mature проект»

В своём докладе я расскажу, как мы в Superjob разрабатываем лаконичный и чистый RESTful API для проекта с многолетней историей, как автоматизируем документацию и тестирование нашего API и как облегчаем жизнь программисту.

— Как мы внедрили чистый и прозрачный REST поверх легаси

— Как нам удалось привести зоопарк технологий к единому виду

— Как отвязались от структуры хранения и перестали писать тонны DTO

— Как распараллелили разработку между командами благодаря единым стандартам

— Как стандарт помог нашим автотестам и документации

— Как сократили время на разработку нового и перестали думать о рутине

— Как при этом удалось соблюсти баланс между автоматизацией и эффективностью

— Как при всем этом оставили свободу действий программисту

Антон Довгаль, Senior C Developer Badoo, с докладом «Как мы разрабатываем модули в Badoo»

Документация на тему архитектуры языка PHP скудна и разрозненна, несмотря на то что тема интересна многим. В моем докладе я постараюсь заполнить этот пробел и рассказать о модулях PHP: как они работают, зачем и как их пишут. В процессе мы рассмотрим опыт Badoo в этой сфере на примерах двух модулей. И еще напишем очень небольшой собственный модуль.

— Что такое модули PHP, как они работают

— Как начать писать свой модуль PHP

— Скелет модуля — Функции, классы, методы

— Разбор параметров функции

— Сборка модуля

— Подгрузка модуля

— Простой пример модуля из Badoo

— Сложный пример модуля из Badoo

Надежда Рябцова, Senior DevOps Engineer Skyeng, с докладом «Как медиа сервисы Skyeng переехали на Symfony 4»

Я расскажу, как мы приняли решение и внедрили в продакшн новый инструмент для сборки бекенда приложений – Symfony Flex – менее чем за один месяц. О преимуществах и недостатках подхода для сборки бандлов с помощью рецептов. Сейчас нам удалось укротить зоопарк подключаемых бандлов, и оформить схему переезда на Symfony 4 для последователей внутри компании и за ее пределами.

В своем проекте мы реализовали легковесное api для браузерных расширений и сопровождаем его стопроцентным покрытием автотестами. И я расскажу, как вписать Symfony Flex в процессы непрерывной интеграции, схожие с нашими. А также, как развивать и эксплуатировать проект на альфа версии фреймворка в продакшне.

Василий Грудистов, руководитель департамента производства QSOFT, с докладом «Как построить SOA в связке laravel и 1C-Битрикс. Опыт большого проекта»

В ходе доклада я расскажу, как мы достигли увеличения производительности международного портала с 1млн. пользователей в сутки, до 50 млн., при этом сильно расширив функционал.

— Как спроектировать сервисно-ориентированную архитектуру (SOA);

— Как создать отказоустойчивую/катастрофоустойчивую платформу;

— Как реализовать совмещение предыдущей разработки на 1С-Битрикс и не потерять взаимосвязь пользователей в SOA;

— Как организовать совместную работу 1С-Битрикс и сервисов на PHP Framework laravel в рамках одного портала, исключив необходимость внесения дублирующего кода;

— Как закэшировать ВСЁ, при этом не потерять динамические функции портала.

Александр Макаров, активный участник OpenSource проектов, один из разработчиков PHP-фреймворка Yii и его представитель в PHP-FIG, с докладом «Yii. Что дальше?»

— Что происходит с PHP: стоит ли с ним работать или пора переходить на другие языки?

— Ошибки 2.0. Что мы сделали не так и почему. Для понимания этого нужно знать историю Yii, так что немного нырнём и в неё.

— Планы на 2.1. Как мы будем исправлять ошибки и что будет нового в следующей версии.

— Планы на 3.0. Если он будет. О том, что мы никому не показываем, но потихоньку пилим.

Официальная группа Superjob IT-meetup в Facebook.

|

|

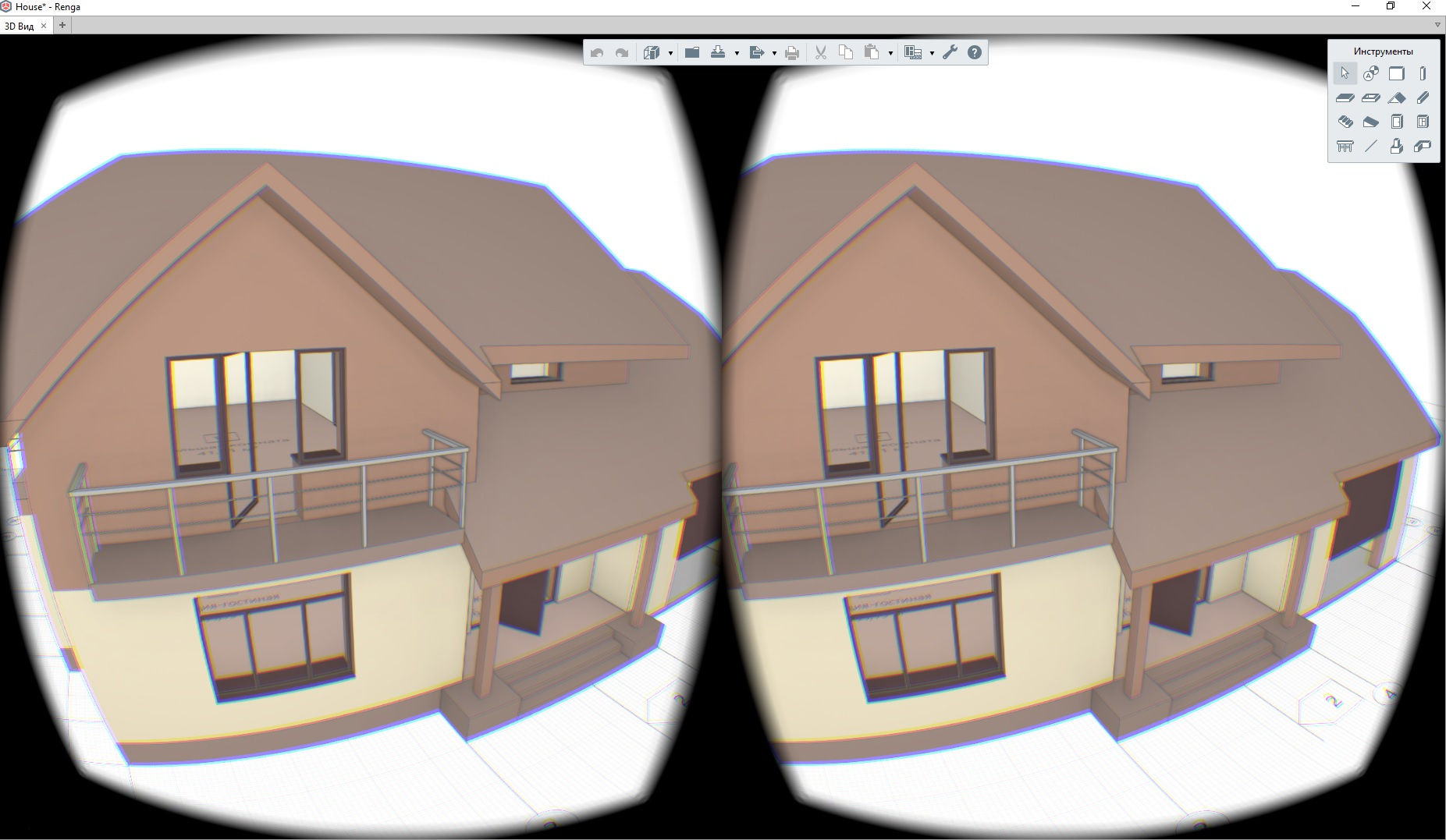

Интеграция Oculus Rift в десктопное Direct3D приложение на примере Renga |

Архитектурная визуализация — очень благодатная тема для различного рода экспериментов. Мы решили не отставать от тренда. В одной из следующих версий наших BIM-систем (напомню, что я работаю в компании Renga Software, совместном предприятии АСКОН и фирмы «1С»): Renga Architecture — для архитектурно-строительного проектирования и Renga Structure — для проектирования конструктивной части зданий и сооружений, появится возможность хождения по проектируемому зданию в шлеме виртуальной реальности. Это очень удобно для демонстрации проекта заказчику и оценки тех или иных проектных решений с точки зрения эргономики.

На сайте разработчика шлема доступно для скачивания SDK. На момент написания статьи последняя доступная версия 1.16. Существует еще OpenVR от Valve. Сам я эту штуку не пробовал, но есть подозрения, что она работает хуже, чем нативный для Oculus SDK.

Разберем основные этапы подключения шлема к приложению. Вначале необходимо инициализировать устройство:

#define OVR_D3D_VERSION 11 // in case direct3d 11

#include "OVR_CAPI_D3D.h"

bool InitOculus()

{

ovrSession session = 0;

ovrGraphicsLuid luid = 0;

// Initializes LibOVR, and the Rift

ovrInitParams initParams = { ovrInit_RequestVersion, OVR_MINOR_VERSION, NULL, 0, 0 };

if (!OVR_SUCCESS(ovr_Initialize(&initParams)))

return false;

if (!OVR_SUCCESS(ovr_Create(&session, &luid)))

return false;

// FloorLevel will give tracking poses where the floor height is 0

if(!OVR_SUCCESS(ovr_SetTrackingOriginType(session, ovrTrackingOrigin_EyeLevel)))

return false;

return true;

}

Инициализация завершена. Теперь у нас есть session — это указатель на внутреннюю структуру ovrHmdStruct. Его мы будем использовать для всех запросов к oculus runtime. luid — это идентификатор графического адаптера, к которому подсоединился шлем. Он необходим для конфигураций с несколькими видеокартами или ноутбуков. Приложение должно использовать для отрисовки этот же адаптер.

Процесс создания кадра в обычном режиме и для шлема Oculus Rift отличается не очень сильно.

Для каждого глаза нам нужно создать текстуру вместе с SwapChain и RenderTarget.

Для создания текстур Oculus SDK предоставляет набор функций.

Пример обертки для создания и хранения SwapChain и RenderTarget для каждого глаза:

struct EyeTexture

{

ovrSession Session;

ovrTextureSwapChain TextureChain;

std::vector TexRtv;

EyeTexture() :

Session(nullptr),

TextureChain(nullptr)

{

}

bool Create(ovrSession session, int sizeW, int sizeH)

{

Session = session;

ovrTextureSwapChainDesc desc = {};

desc.Type = ovrTexture_2D;

desc.ArraySize = 1;

desc.Format = OVR_FORMAT_R8G8B8A8_UNORM_SRGB;

desc.Width = sizeW;

desc.Height = sizeH;

desc.MipLevels = 1;

desc.SampleCount = 1;

desc.MiscFlags = ovrTextureMisc_DX_Typeless;

desc.BindFlags = ovrTextureBind_DX_RenderTarget;

desc.StaticImage = ovrFalse;

ovrResult result = ovr_CreateTextureSwapChainDX(Session, pDevice, &desc, &TextureChain);

if (!OVR_SUCCESS(result))

return false;

int textureCount = 0;

ovr_GetTextureSwapChainLength(Session, TextureChain, &textureCount);

for (int i = 0; i < textureCount; ++i)

{

ID3D11Texture2D* tex = nullptr;

ovr_GetTextureSwapChainBufferDX(Session, TextureChain, i, IID_PPV_ARGS(&tex));

D3D11_RENDER_TARGET_VIEW_DESC rtvd = {};

rtvd.Format = DXGI_FORMAT_R8G8B8A8_UNORM;

rtvd.ViewDimension = D3D11_RTV_DIMENSION_TEXTURE2D;

ID3D11RenderTargetView* rtv;

DIRECTX.Device->CreateRenderTargetView(tex, &rtvd, &rtv);

TexRtv.push_back(rtv);

tex->Release();

}

return true;

}

~EyeTexture()

{

for (int i = 0; i < (int)TexRtv.size(); ++i)

{

Release(TexRtv[i]);

}

if (TextureChain)

{

ovr_DestroyTextureSwapChain(Session, TextureChain);

}

}

ID3D11RenderTargetView* GetRTV()

{

int index = 0;

ovr_GetTextureSwapChainCurrentIndex(Session, TextureChain, &index);

return TexRtv[index];

}

void Commit()

{

ovr_CommitTextureSwapChain(Session, TextureChain);

}

};

С помощью этой обертки создаем для каждого глаза текстуру, куда мы будем отрисовывать 3D-сцену. Размер текстуры необходимо узнать у Oculus Runtime. Для этого нужно получить description устройства и с помощью функции ovr_GetFovTextureSize получить необходимый размер текстур для каждого глаза:

ovrHmdDesc hmdDesc = ovr_GetHmdDesc(session);

ovrSizei idealSize = ovr_GetFovTextureSize(session, (ovrEyeType)eye, hmdDesc.DefaultEyeFov[eye], 1.0f);

Еще удобно создать так называемую Mirror Texture. Эту текстуру можно показывать в окне приложения. В эту текстуру Oculus Runtime будет копировать объединенное для двух глаз изображение после постобработки.

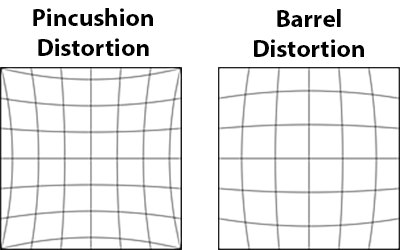

Если не делать пост обработку, то человек увидит в шлеме изображение, полученное с помощью оптической системы с положительной дисторсией (изображение слева). Для компенсации oculus накладывает эффект отрицательной дисторсии (изображение справа).

Код создания mirror texture:

// Create a mirror to see on the monitor.

ovrMirrorTexture mirrorTexture = nullptr;

mirrorDesc.Format = OVR_FORMAT_R8G8B8A8_UNORM_SRGB;

mirrorDesc.Width = width;

mirrorDesc.Height =height;

ovr_CreateMirrorTextureDX(session, pDXDevice, &mirrorDesc, &mirrorTexture);

Важный момент при создании текстур. При создании SwapChain с помощью функции ovr_CreateTextureSwapChainDX мы передаем желаемый формат текстуры. Этот формат используется в дальнейшем для постобработки рантаймом Oculus.

Чтобы все правильно работало, приложение должно создавать swap chain в sRGB цветовом пространстве. Например, OVR_FORMAT_R8G8B8A8_UNORM_SRGB. Если вы в своем приложении не делаете гамма-коррекцию, то необходимо создавать swap chain в формате sRGB. Задать флаг ovrTextureMisc_DX_Typeless в ovrTextureSwapChainDesc. Создать Render Target в формате DXGI_FORMAT_R8G8B8A8_UNORM. Если этого не сделать, то изображение на экране будет слишком светлым.

После того, как мы подключили шлем и создали текстуры для каждого глаза, нужно отрисовать сцену в соответствующую текстуру. Это делается обычным способом, который предоставляет direct3d. Тут ничего интересного. Нужно только получить от шлема его положение, делается это так:

ovrHmdDesc hmdDesc = ovr_GetHmdDesc(session);

ovrEyeRenderDesc eyeRenderDesc[2];

eyeRenderDesc[0] = ovr_GetRenderDesc(session, ovrEye_Left, hmdDesc.DefaultEyeFov[0]);

eyeRenderDesc[1] = ovr_GetRenderDesc(session, ovrEye_Right, hmdDesc.DefaultEyeFov[1]);

// Get both eye poses simultaneously, with IPD offset already included.

ovrPosef EyeRenderPose[2];

ovrVector3f HmdToEyeOffset[2] = { eyeRenderDesc[0].HmdToEyeOffset,

eyeRenderDesc[1].HmdToEyeOffset };

double sensorSampleTime; // sensorSampleTime is fed into the layer later

ovr_GetEyePoses(session, frameIndex, ovrTrue, HmdToEyeOffset, EyeRenderPose, &sensorSampleTime);

Теперь при создании кадра нужно не забыть для каждого глаза задать правильную матрицу вида с учетом положения шлема.

После того, как мы отрисовали сцену для каждого глаза, нужно передать получившиеся текстуры на постобработку в рантайм Oculus.

Делается это так:

OculusTexture * pEyeTexture[2] = { nullptr, nullptr };

// ...

// Draw into eye textures

// ...

// Initialize our single full screen Fov layer.

ovrLayerEyeFov ld = {};

ld.Header.Type = ovrLayerType_EyeFov;

ld.Header.Flags = 0;

for (int eye = 0; eye < 2; ++eye)

{

ld.ColorTexture[eye] = pEyeTexture[eye]->TextureChain;

ld.Viewport[eye] = eyeRenderViewport[eye];

ld.Fov[eye] = hmdDesc.DefaultEyeFov[eye];

ld.RenderPose[eye] = EyeRenderPose[eye];

ld.SensorSampleTime = sensorSampleTime;

}

ovrLayerHeader* layers = &ld.Header;

ovr_SubmitFrame(session, frameIndex, nullptr, &layers, 1);

После этого в шлеме появится готовое изображение. Для того чтобы показать в приложении то, что видит человек в шлеме, можно скопировать в back buffer окна приложения содержимое mirror texture, которую мы создали ранее:

ID3D11Texture2D* tex = nullptr;

ovr_GetMirrorTextureBufferDX(session, mirrorTexture, IID_PPV_ARGS(&tex));

pDXContext->CopyResource(backBufferTexture, tex);

На этом все. Много хороших примеров можно найти в Oculus SDK.

|

|

[Из песочницы] Wi-Fi адаптер через OTG |

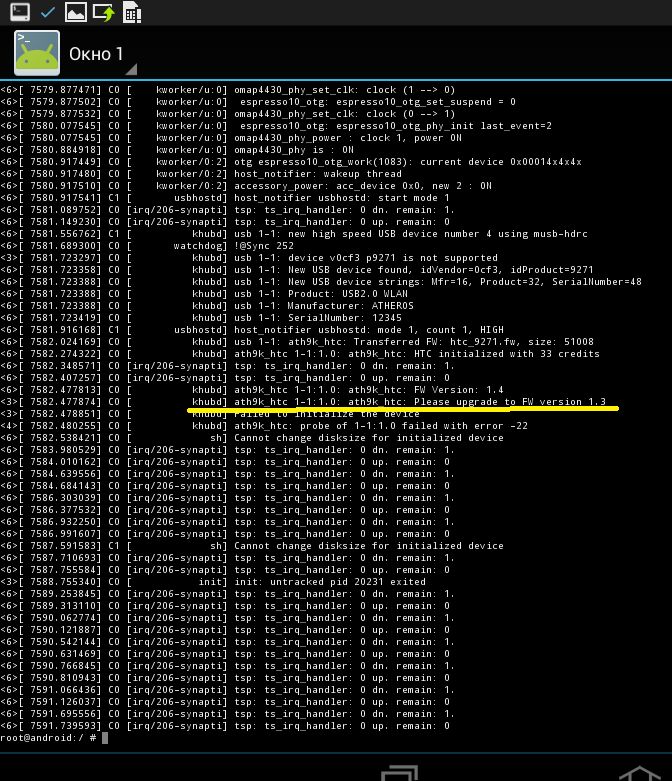

Идея перевести сетевую карту телефона в режим монитора разрушилась по причине собственной наивности и незнания элементарной информации о том, что подавляющее большинство мобильных сетевых карт этот самый режим монитора и не поддерживают.

Идея реализации задумки с помощью внешнего беспроводного Wi-Fi адаптера или «свистка», поддерживающего желанный режим монитора, рушилась десятки раз из-за новых и новых ошибок и потери веры в то, что это вообще возможно, но переросла в данную статью.

Итак, как подключить внешний Wi-Fi адаптер к устройству на Android или бег с препятствиями на дистанции «вставил — netcfg wlan0 up»:

Должно быть в наличии:

- Телефон на Android

- Поддержка OTG и сам OTG

- Terminal Emulator

- ROOT

- Исходники ядра

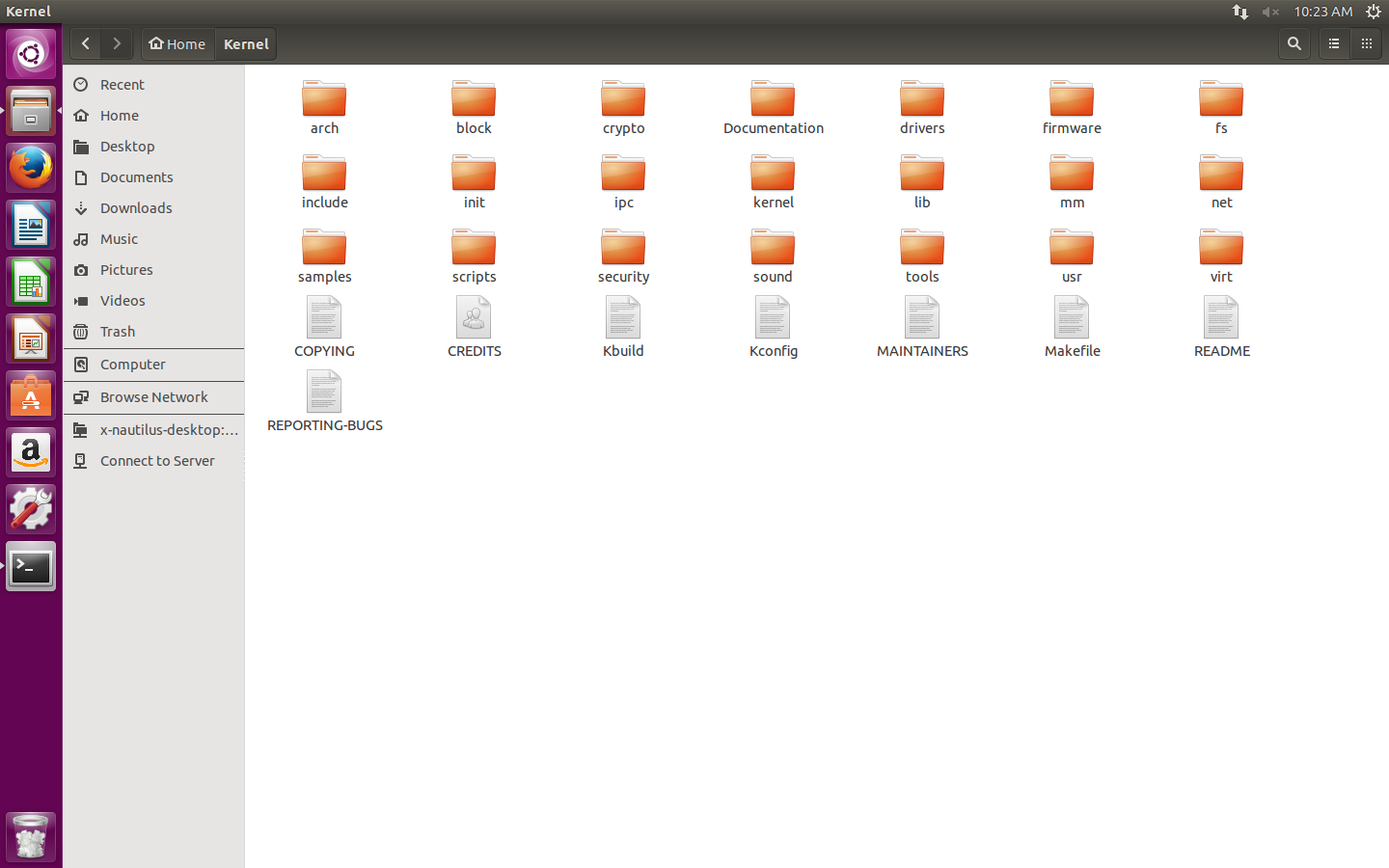

FAQ — структура выглядит так:

Скриншот

- Внешний Wi-Fi адаптер («свисток»)

- Его firmware

- Linux дистрибутив

- ADB (не обязательно, но так удобнее)

Мой случай:

- Samsung GT-P5100 Galaxy Tab 2 10.1, Андроид 4.2.2

- OTG «30-pin — USB»

- Terminal Emulator for Android

- ROOT

- Исходники стокового ядра 3.0.31-1919150 с сайта Самсунг

- Адаптер TP-LINK TL-WN722N на чипсете AR9271

- ath9k_htc/htc_9271.fw

- Дистрибутив Ubuntu 15.04 в VMware

- android-tools-adb

Начну. Но попрошу учесть, что далее все рассматривается для вышеперечисленного набора и алгоритм, скорее всего, не является универсальным, но отклонения незначительны.

I. Старт

Первым делом необходимо добыть фирмварь вашего адаптера. Вставляю адаптер в компьютер и выполняю команду

dmesg. Нахожу:...

[ 256.815266] usbcore: registered new interface driver ath9k_htc

...Где слово правее слова driver — искомая информация. У меня это — ath9k_htc. Гуглю для него firmware. Качаю. Закидываю .fw-файл на телефон в /system/etc/firmware

Затем устанавливаю ADB:

apt-get install android-tools-adbТретьим этапом качаю тулчейн (компилятор под ARM) отсюда. Там большой архив, мне нужна лишь папка android-platform_prebuilt-android-sdk-adt_r20-0-ga4062cc.zip\android-platform_prebuilt-a4062cc\linux-x86\toolchain\arm-eabi-4.4.3, которую я распаковываю в произвольное место.

II. Разгон

Для начала пишу терминале:

export ARCH=arm

export CROSS_COMPILE=~/тот самый произвольный путь/arm-eabi-4.4.3/bin/arm-eabi-Затем перехожу в терминале в каталог с исходниками ядра, загруженными ранее, пишу

make help и получаю тучу информации, среди которой нужно найти нечто, заканчивающееся на _defconfig, у меня это:...

android_espresso10_omap4430_r02_user_defconfig - Build for android_espresso10_omap4430_r02_user

...Скопировал, затем:

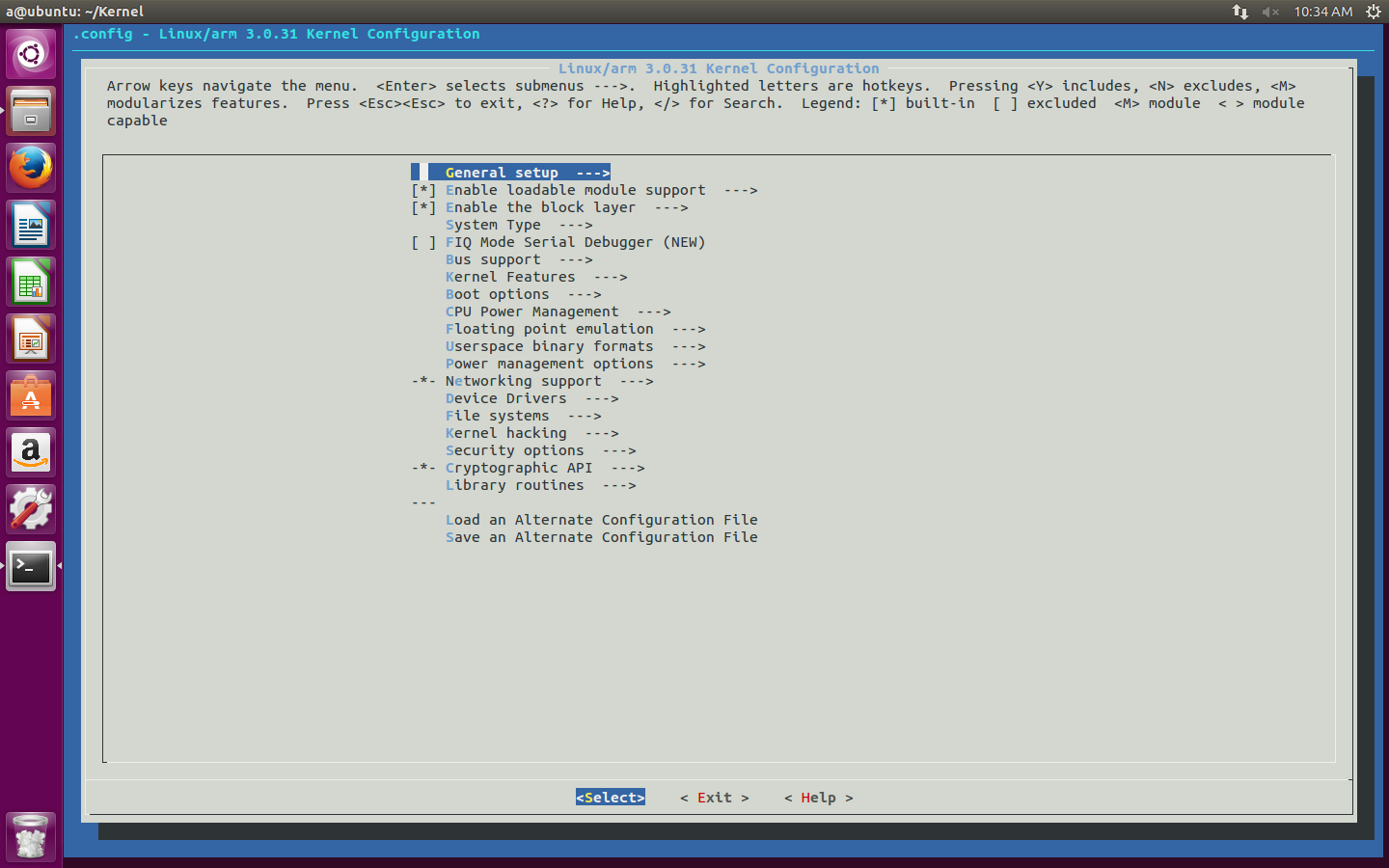

make android_espresso10_omap4430_r02_user_defconfigИ в завершении запускаю графическую конфигурацию ядра:

make menuconfigПоявляется вот такое окно:

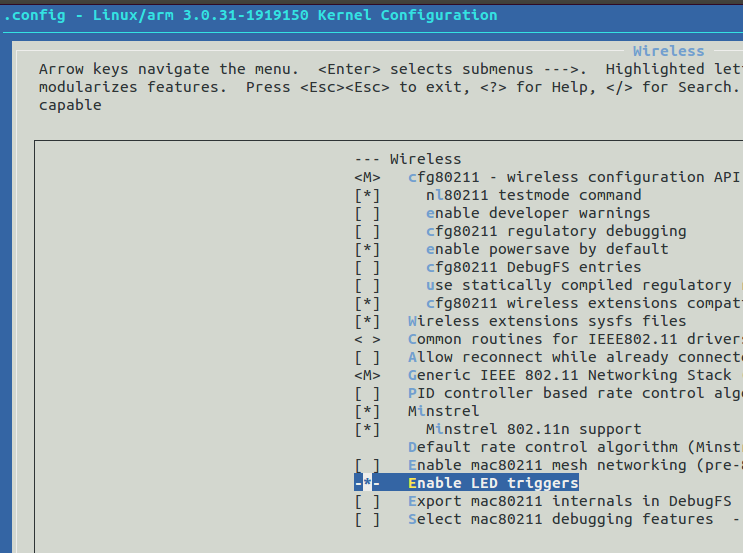

Продвигаюсь по маршрутам:

- Networking support -> Wireless

Спускаюсь к Generic IEEE 802.11 Networking stack (mac80211) и нажимаю на пробел, наблюдая появление значка М перед этим пунктом

- Device Drivers -> Network device support -> Wireless LAN

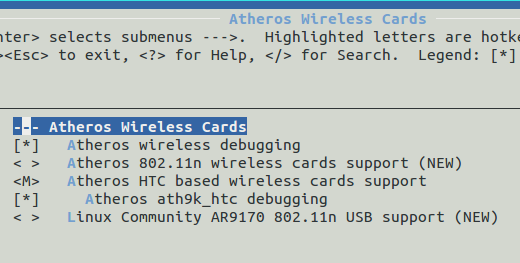

Ставлю М у своего чипсета, в моем случае — Atheros Wireless Cards

Затем перехожу в сам этот раздел и внутри отмечаю все тем же пробелом и знаком M нужный мне пункт.

Скриншот

- Exit -> Do you wish to save your new configuration? -> Yes

Далее захожу в папку с исходниками ядра и открываю файл Makefile. Нахожу строку CFLAGS_MODULE = и дописываю туда -fno-pic так, чтобы получилось:

CFLAGS_MODULE = -fno-picСохраняю. Возвращаюсь в терминал, а если вы его закрыли, то в и каталог с исходниками тоже, и выполняю сначала

make modules_prepare, а следом просто make. Результат потребует ожидания. Мой итоговый набор:MODPOST 8 modules

CC drivers/net/wireless/ath/ath.mod.o

LD [M] drivers/net/wireless/ath/ath.ko

CC drivers/net/wireless/ath/ath9k/ath9k_common.mod.o

LD [M] drivers/net/wireless/ath/ath9k/ath9k_common.ko

CC drivers/net/wireless/ath/ath9k/ath9k_htc.mod.o

LD [M] drivers/net/wireless/ath/ath9k/ath9k_htc.ko

CC drivers/net/wireless/ath/ath9k/ath9k_hw.mod.o

LD [M] drivers/net/wireless/ath/ath9k/ath9k_hw.ko

CC drivers/net/wireless/bcmdhd/dhd.mod.o

LD [M] drivers/net/wireless/bcmdhd/dhd.ko

CC drivers/scsi/scsi_wait_scan.mod.o

LD [M] drivers/scsi/scsi_wait_scan.ko

CC net/mac80211/mac80211.mod.o

LD [M] net/mac80211/mac80211.ko

CC net/wireless/cfg80211.mod.o

LD [M] net/wireless/cfg80211.ko

Потребуются модули (.ko-файлы), включающие слово ath и mac80211.ko. Переношу их на телефон.

Можно использовать adb, работая через компьютер, а можно не использовать и работать через терминал телефона, печатая команды пальцами по экрану. Я выбрал adb.

Напомню, как он работает. Подключаю телефон через USB (отладка, естественно, включена) и выполняю:

adb start-server

adb shell

suЯ в телефоне и под рутом.

Смотрю, какие модули уже есть командой

lsmod и выгружаю их все, если это возможно, командой rmmod имямодуляЗатем перехожу в каталог с вышеперечисленными модулями:

cd /sdcard/ваш путь/Можно убедиться в их наличии командой

ls. a@ubuntu:~/Kernel$ adb start-server

* daemon not running. starting it now on port 5037 *

* daemon started successfully *

a@ubuntu:~/Kernel$ adb shell

shell@android:/ $ su

root@android:/ # cd /sdcard/temp

root@android:/sdcard/temp # ls

ath.ko

ath9k_common.ko

ath9k_htc.ko

ath9k_hw.ko

mac80211.ko

Загружаю их командой

insmod имямодуля в такой и только такой последовательности (иначе просто не загрузится, выдавая ошибку):ath.ko

ath9k_hw.ko

ath9k_common.ko

mac80211.ko

ath9k_htc.ko

III. Препятствия

В этом и вся соль, без которой статья была бы слишком простой.

1. Версии

Естественно, первая ошибка возникает на первом этапе.

insmod ath.koinsmod: init_module 'ath.ko' failed (Exec format error)Смотрю, что скажет об этом буфер сообщений ядра, выполнив команду

dmesg:... ath: version magic '3.0.31 SMP preempt mod_unload modversions ARMv7 p2v8' should be '3.0.31-1919150 SMP preempt mod_unload modversions ARMv7 p2v8'Не совпадают версии. 3.0.31 не есть 3.0.31-1919150.

Решение:

Открываю тот самый Makefile в исходниках ядра и в самом верху файла нахожу:

VERSION = 3Дописываю к EXTRAVERSION = недостающий кусок версии -1919150 так, чтобы получилось:

PATCHLEVEL = 0

SUBLEVEL = 31

EXTRAVERSION =

NAME = Sneaky Weasel

VERSION = 3И сохраняю.

PATCHLEVEL = 0

SUBLEVEL = 31

EXTRAVERSION = -1919150

NAME = Sneaky Weasel

Заключительный этап пройдет в каталоге /include/config, где в файле kernel.release я поменяю 3.0.31 на 3.0.31-1919150

Снова

make modules_prepare, make и далее по предыдущему пункту.2. ewma

Загружая mac80211.ko снова имею ошибку, о которой

dmesg скажет следующее:<4>[ 3491.160949] C1 [ insmod] mac80211: Unknown symbol ewma_add (err 0)

<4>[ 3491.161865] C1 [ insmod] mac80211: Unknown symbol ewma_init (err 0)

Решение:

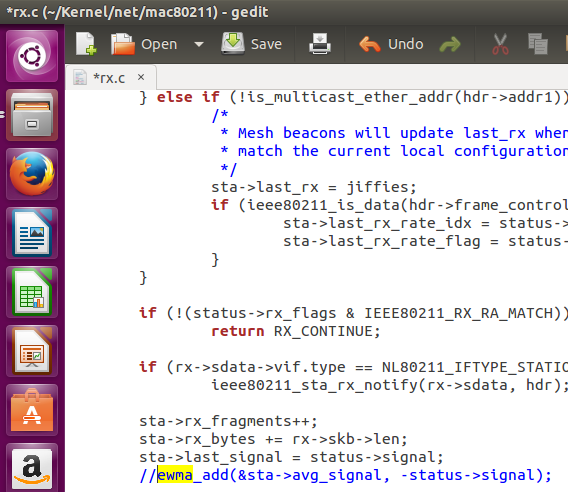

Чудом прочитав на одном из англоязычных форумов опасное, но единственное в интернете, «решение», я перехожу в /net/mac80211/ и в файлах rx.c и sta_info.c и просто удаляю [либо комментирую (//)] строки ewma_add(&sta->avg_signal, -status->signal); и ewma_init(&sta->avg_signal, 1024, 8); соответственно.

Опять перекомпилирую модули и двигаюсь дальше.

3. Светодиод

При загрузке ath9k_htc.ko и mac80211.ko очередные ошибки, у mac80211.ko это:

<4>[ 2435.271636] C1 [ insmod] mac80211: Unknown symbol led_trigger_unregister (err 0)

<4>[ 2435.271820] C1 [ insmod] mac80211: Unknown symbol led_brightness_set (err 0)

<4>[ 2435.271972] C1 [ insmod] mac80211: Unknown symbol led_blink_set (err 0)

<4>[ 2435.272033] C1 [ insmod] mac80211: Unknown symbol led_trigger_register (err 0)

<4>[ 2435.272155] C1 [ insmod] mac80211: Unknown symbol led_trigger_event (err 0)

А у ath9k_htc.ko это:

<4>[ 2709.396392] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_start_tx_ba_cb_irqsafe (err 0)

<4>[ 2709.396972] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_free_hw (err 0)

<4>[ 2709.397155] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_alloc_hw (err 0)

<4>[ 2709.397216] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_start_tx_ba_session (err 0)

<4>[ 2709.397369] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_register_hw (err 0)

<4>[ 2709.397430] C1 [ insmod] ath9k_htc: Unknown symbol led_classdev_unregister (err 0)

<4>[ 2709.397491] C1 [ insmod] ath9k_htc: Unknown symbol __ieee80211_create_tpt_led_trigger (err 0)

<4>[ 2709.397766] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_get_buffered_bc (err 0)

<4>[ 2709.397827] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_find_sta (err 0)

<4>[ 2709.398284] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_stop_tx_ba_cb_irqsafe (err 0)

<4>[ 2709.398376] C1 [ insmod] ath9k_htc: Unknown symbol wiphy_to_ieee80211_hw (err 0)

<4>[ 2709.398498] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_queue_delayed_work (err 0)

<4>[ 2709.398712] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_rx (err 0)

<4>[ 2709.398895] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_wake_queues (err 0)

<4>[ 2709.399230] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_tx_status (err 0)

<4>[ 2709.399291] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_stop_queues (err 0)

<4>[ 2709.399505] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_iterate_active_interfaces_atomic (err 0)

<4>[ 2709.399597] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_unregister_hw (err 0)

<4>[ 2709.399749] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_beacon_get_tim (err 0)

<4>[ 2709.399871] C1 [ insmod] ath9k_htc: Unknown symbol led_classdev_register (err 0)

<4>[ 2709.399932] C1 [ insmod] ath9k_htc: Unknown symbol ieee80211_queue_work (err 0)

Если ieee80211_-ошибки от ath9k_htc.ko это потому что я пытаюсь его загрузить до mac80211.ko, то led_-ошибки от обоих модулей от того, что телефон не понимает, что делать со светодиодом на моем адаптере. Тут два варианта развития событий.

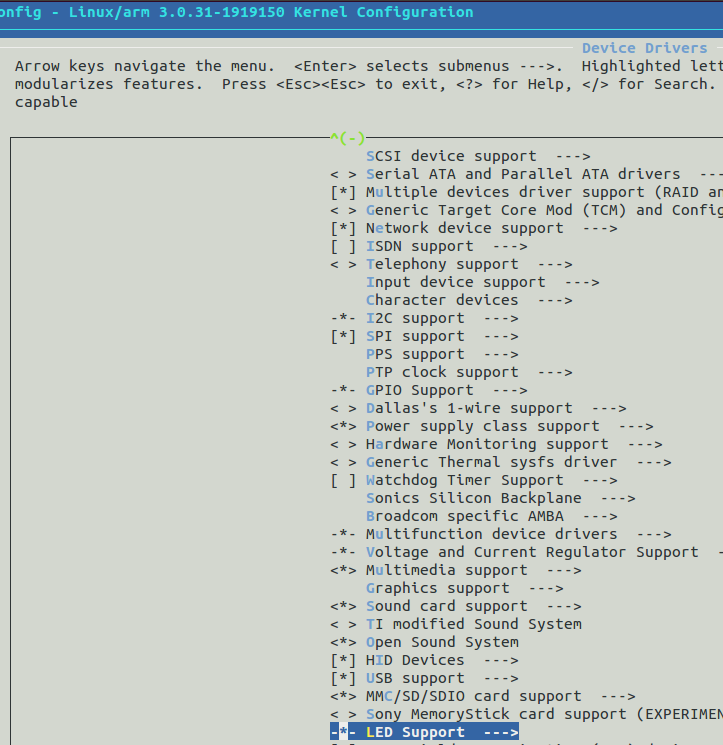

В первом просто убирается в графической конфигурации ядра значок [] напротив

Networking support -> Wireless -> Enable LED triggers и Device Drivers -> LED Support.

А во втором этот самый значок заморожен и снять его нельзя. Это значит, что при выборе моего адаптера, автоматически выбирается «поддержка» светодиода, убрать которую нельзя. Конечно же, это мой случай:

Решение:

Кнопка помощи по Device Drivers -> LED Support выводит следующую информацию по разделу:

Меня интересует:

Defined at drivers/leds/KconfigА значит все настройки хранятся в данном файле. Долго я мучал Kconfig в /drivers/leds/ пока не додумался посмотреть такой же файл в своем /drivers/net/wireless/ath/ath9k, где нашел ответ на свой вопрос:

…Сходу удаляю строки, включающие страшное слово LED, получаю

config ATH9K_HTC

tristate «Atheros HTC based wireless cards support»

depends on USB && MAC80211

select ATH9K_HW

select MAC80211_LEDS

select LEDS_CLASS

select NEW_LEDS

select ATH9K_COMMON

...

…и сохраняю. Теперь можно снимать галочки:

config ATH9K_HTC

tristate «Atheros HTC based wireless cards support»

depends on USB && MAC80211

select ATH9K_HW

select ATH9K_COMMON

...

Здесь и вовсе исчез пункт:

Опять и снова перекомпиляция, новые модули и т.п.

Вуаля. Все модули загружены. Выключаю Wi-Fi на телефоне и подключаю адаптер. Но светодиод на нем, как вы уже догадались, работать не будет. Оно и не нужно.

4. Версия firmware

Если все необходимые модули загрузились, но после подключения адаптера к телефону вы не наблюдаете ничего нового в выводе команды

netcfg, то на помощь приходит все тот же dmesg. …

[ 7582.477874] C0 [ khubd] ath9k_htc 1-1:1.0: ath9k_htc: Please upgrade to FW version 1.3

...

Решение:

Просто качаем другой фирмварь, но уже требуемой версии, и кладем его вместо прошлого.

IV. Финиш

Теперь никаких проблем быть не должно. Выключаю родной Wi-Fi, все модули загружены, фирмварь нужной версии. Вставляю адаптер и netcfg впервые приносит счастье. Устанавливаю для появившегося сетевого интерфейса режим монитора и поднимаю его. Успех!

Ну а как и зачем зачастую используется режим монитора, вы и так все знаете. Спасибо за внимание!

|

Метки: author Rechnoy разработка под android android wifi otg monitor |

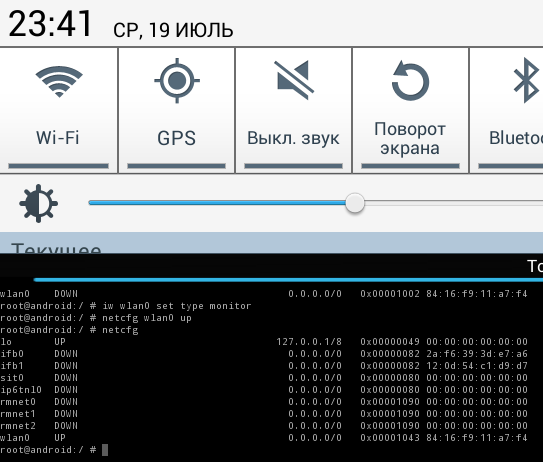

Stantinko: масштабная adware-кампания, действующая с 2012 года |

Stantinko специализируется на рекламном мошенничестве, но выделяется на общем фоне технической сложностью. Шифрование кода и оперативная адаптация для защиты от обнаружения антивирусами позволили операторам Stantinko оставаться вне зоны видимости как минимум на протяжении пяти лет. Кроме того, внимание привлекает масштаб Stantinko – это одна из наиболее распространенных в России киберугроз, в составе ботнета около 500 000 устройств.

Обзор

Для заражения системы операторы Stantinko вводят в заблуждение пользователей, которые ищут пиратское ПО и загружают исполняемые файлы, иногда замаскированные под торренты. Далее FileTour, начальный вектор заражения, демонстративно устанавливает множество программ, чтобы отвлечь внимание пользователя от скрытой установки первой службы Stantinko в фоновом режиме. В видео 1 показано, как пользователь запускает вредоносный файл.ехе.

Видео 1. Пользователь загружает и запускает вредоносный файл

Операторы Stantinko управляют ботнетом и монетизируют его, в основном, путем установки вредоносных расширений браузера для несанкционированного внедрения рекламы и кликфрода. Проблема в том, что на этом они не останавливаются. Вредоносные службы позволяют исполнить на зараженной системе все, что угодно. Мы наблюдали отправку полнофункционального бэкдора, бота для массового поиска в Google, а также утилиты для брутфорс-атак на панели управления Joomla и WordPress (предназначена для взлома и возможной перепродажи).

На рисунке ниже представлена полная схема киберкампании Stantinko – от вектора заражения до постоянных сервисов и соответствующих плагинов.

Рисунок 1. Полная схема угрозы Stantinko

Ключевые параметры

Характерная особенность Stantinko – обход обнаружения антивирусом и противодействие реверс-инжинирингу, определяющему вредоносное поведение. Для проведения всестороннего анализа угрозы необходимо несколько компонентов – загрузчик и зашифрованный компонент. Вредоносный код скрыт в зашифрованном компоненте, который находится либо на диске, либо в реестре Windows. Код загружается и расшифровывается безвредным на первый взгляд исполняемым файлом. Ключ генерируется для каждого из заражений. Некоторые компоненты используют идентификатор бота, другие – серийный номер тома жесткого диска ПК жертвы. Детектирование по незашифрованным компонентам – крайне сложная задача, поскольку артефакты, хранящиеся на диске, не показывают вредоносного поведения до выполнения.

Кроме того, в Stantinko предусмотрен механизм восстановления. После успешного заражения на машину жертвы с операционной системой Widnows устанавливаются две вредоносные службы, которые запускаются вместе с системой. Службы могут переустанавливать друг друга в случае удаления одной из них. Таким образом, чтобы успешно устранить угрозу, необходимо одновременно удалить две службы. Иначе C&C-сервер направит новую версию удаленной службы, которая еще не была обнаружена, либо содержит новую конфигурацию.

Основные функциональные возможности Stantinko – установка в зараженной системе вредоносных расширений браузера The Safe Surfing и Teddy Protection. На момент анализа оба расширения были доступны в Chrome Web Store. На первый взгляд, это легитимные браузерные расширения, блокирующие нежелательные URL-адреса. Но при установке в рамках схемы Stantinko расширения получают иную конфигурацию, содержащую правила кликфрода и несанкционированного показа рекламы. В видео 2 показан процесс установки расширения The Safe Surfing. Кликнув по ссылке, пользователь перенаправляется в поисковик Rambler.

Рисунок 2. Teddy Protection в Chrome Web Store

Рисунок 3. The Safe Surfing в Chrome Web Store

Видео 2. Переадресация трафика на сайт Rambler

Stantinko – модульный бэкдор. Его компоненты включают загрузчик, позволяющий выполнять любой исполняемый Windows-файл, передаваемый C&C-сервером напрямую в память. Эта функция реализована в виде гибкой системы плагинов, которая позволяет операторам выполнить в зараженной системе все, что угодно. В таблице ниже приведено описание известных нам плагинов Stantinko.

Монетизация

Разработчики Stantinko используют методы, которые чаще встречаются в APT-кампаниях. Тем не менее, их главная цель – деньги. Операторы предлагают свои услуги на самых доходных рынках компьютерных преступлений.

Во-первых, кликфрод сегодня является крупным источником доходов в экосистеме киберпреступников. Исследование, проведенное компанией White Ops и Национальной ассоциацией рекламодателей (США), оценило мировые издержки от кликфрода в 2017 году в 6,5 млрд долларов США.

Как уже описывалось выше, Stantinko устанавливает два расширения браузера – The Safe Surfing и Teddy Protection, которые показывают рекламу или осуществляют редирект. Это позволяет операторам Stantinko получать деньги за трафик, который они обеспечивают рекламодателям. На рисунке ниже показана схема переадресации.

Рисунок 4. Кликфрод, процесс переадресации

Традиционные схемы кликфрода строятся на серии переадресаций между несколькими рекламными сетями, чтобы «отмыть» трафик. Но в случае со Stantinko операторы ближе к рекламодателям – в некоторых случаях (см. рисунок 4) пользователь попадает на сайт рекламодателя сразу из сети Stantinko. Это означает, что злоумышленники, стоящие за кампанией Stantinko, могут не только эффективно скрывать вредоносное ПО, но и нарушать традиционную рекламную экономику, и это сходит им с рук.

Во-вторых, операторы Stantinko пытаются получить доступ к панелям управления сайтов на Joomla и WordPress. Атака построена на брутфорсе с перебором логинов и паролей по списку. Цель – угадать пароль, испробовав десятки тысяч комбинаций. Взломанные аккаунты могут быть перепроданы и далее использоваться для переадресации посетителей сайтов на набор эксплойтов или для размещения вредоносного контента.

В-третьих, наше исследование раскрыло, как Stantinko работает в соцсетях. Мы уже описывали этот тип мошенничества в отчете по Linux/Moose. Схема действительно приносит прибыль – 1000 лайков на Facebook стоят около 15 долларов (даже если их генерируют фейковые аккаунты в составе ботнета).

Операторы Stantinko разработали плагин, взаимодействующий с Facebook. Помимо всего прочего, он может создавать аккаунты, ставить лайк на странице и добавлять друзей. Для обхода капчи в Facebook он использует специальный сервис (на рисунке 5). Масштаб сети Stantinko является преимуществом операторов, поскольку позволяет им распределять запросы между всеми ботами – это усложняет задачу Facebook по распознаванию мошенничества.

Рисунок 5. Сервис по обходу капчи, используемый Stantinko

Заключение

Stantinko – это ботнет, который специализируется на рекламном мошенничестве. Продвинутые технологии, включая шифрование кода и хранение кода в реестре Windows, позволяли операторам оставаться незамеченными на протяжении пяти лет.

Кроме того, операторам Stantinko удалось выложить в Chrome Web Store два расширения для браузера, которые выполняли несанкционированное размещение рекламы. Одно из них впервые появилось в Chrome Web Store в ноябре 2015 года.

Пользователь вряд ли заметит присутствие Stantinko в системе, поскольку угроза не перегружает ЦП. С другой стороны, Stantinko приносит убытки рекламодателям и значительный доход – операторам. Кроме того, присутствие полнофункционального бэкдора позволяет злоумышленникам следить за всеми зараженными машинами.

Основные выводы:

- Около 500 000 компьютеров скомпрометировано Stantinko

- Основные цели – Россия (46%) и Украина (33%)

- Операторы Stantinko монетизируют ботнет, устанавливая расширения браузера для несанкционированного показа рекламы

- Компоненты, остающиеся на диске, используют кастомный обфускатор кода, который усложняет процесс анализа угрозы

- В большинстве компонентов Stantinko вредоносный код скрыт внутри легитимного бесплатного ПО с открытым исходным кодом, которое было модифицировано и перекомпилировано

- Stantinko устанавливает несколько перманентных служб, которые могут восстанавливать друг друга, предотвращая удаление из системы

- Наиболее распространенное использование Stantinko – рекламное мошенничество. Тем не менее, его возможности значительно шире. Мы наблюдали отправку полнофункционального бэкдора для удаленного администрирования, бота для массового поиска в Google и утилиты для брутфорс-атак на панели управления Joomla и WordPress

Индикаторы заражения доступны в нашем аккаунте на GitHub. По любым вопросам, связанным с Stantinko, включая передачу образцов, пишите на threatintel@eset.com.

|

Метки: author esetnod32 антивирусная защита блог компании eset nod32 stantinko adware сlick fraud |

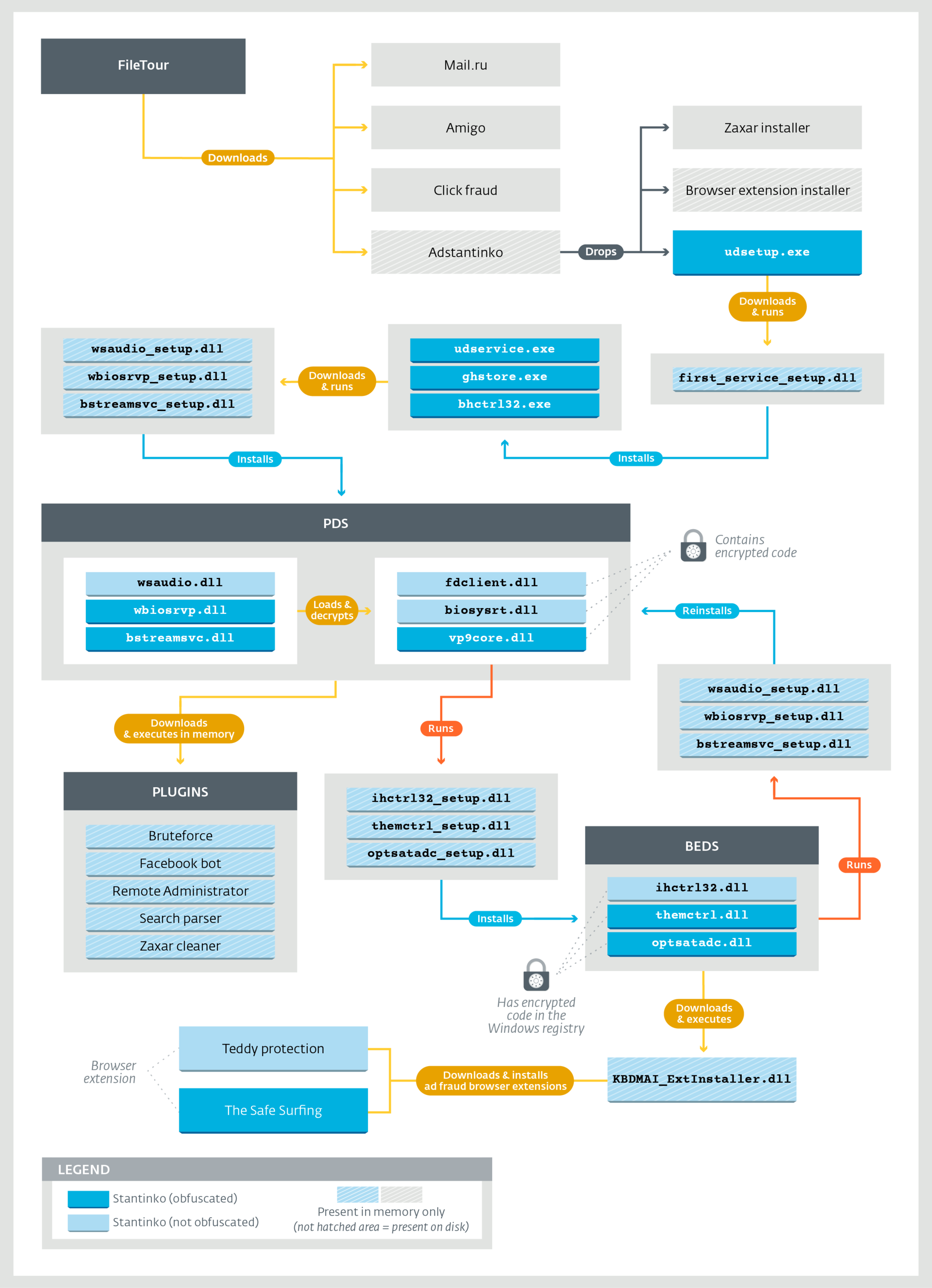

Компания HPE начала продажи новых серверов HPE ProLiant Gen10 |

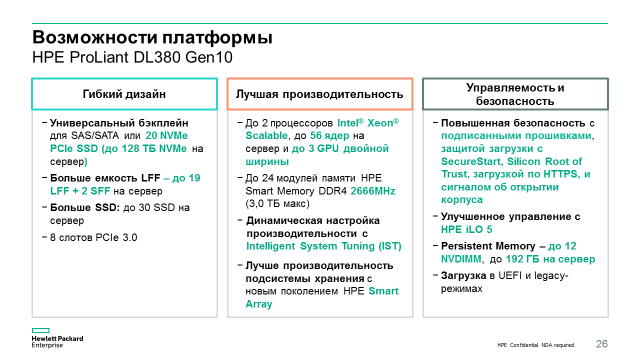

Хотя выпуск нового поколения серверов и совпал с выпуском процессоров Intel Xeon Scalable Family, это была далеко не единственная причина для обновления. Предпосылками стали новые задачи заказчиков HPE. Среди них: появление новых классов нагрузок (в т.ч. требующих обработки больших объемов данных в памяти и высокой производительности дисковой подсистемы), улучшение управляемости аппаратной инфраструктуры (переход на управление через REST API, интеграция с различными средствами автоматизации ИТ, поддержка шаблонов и сценариев), новые модели потребления ИТ-ресурсов (например, финансовые услуги и оплата по мере использования), а также, не в последнюю очередь, новые угрозы в информационной безопасности, связанные с уязвимостью низкоуровневых компонентов серверов (BIOS и прошивок).

Что же нового появилось в серверах HPE ProLiant Gen10 в ответ на все эти задачи. Разберемся по порядку.

Процессоры

Во главе угла стоит повышение производительности сервера с помощью собственных технологий HPE под общим названием Intelligent System Tuning:

— Workload Matching (настройка под задачу) – это набор преднастроек сервера под различные конкретные задачи, которые в каждом случае повышают отдачу за счет тонких изменений конфигурации памяти, процессоров, питания, дисковой подсистемы и т.д. (всего существует около 30 регулируемых настроек, поэтому настроить сервер под конкретную задачу самостоятельно может быть непросто)

— Jitter Smoothing (сглаживание дрожания). С включением этой технологии, сервер начинает отслеживать «дрожание» частоты процессора в режиме TurboBoost, и сглаживать перепады частоты для устранения задержек обращения к разным уровням памяти, которые возникают при резком изменении частоты. В результате, в требовательных к частоте и задержкам задачах (например, ОС реального времени и некоторые Java-приложения) мы получаем прирост производительности даже сверх обычного прироста в турбо-режиме. Почитать подробно об этой технологии можно здесь: h20565.www2.hpe.com/hpsc/doc/public/display?docId=a00018313en_us

— Core Boosting (ускорение ядер). Эта технология станет доступной в серверах Gen10 в ближайших релизах (осень 2017 – весна 2018), для некоторых процессоров Intel Xeon Scalable семейств 6000 и 8000. Она предназначена для повышения частоты активных ядер в процессорах Intel Xeon в режиме TurboBoost сверх «обычной» доступной частоты в этом режиме. В результате таких настроек можно оставаться на том же уровне производительности, например, в БД Oracle, работая при этом на меньшем числе ядер. А это прямая экономия денег на лицензиях.

Для включения Jitter Smoothing и Core Boosting на сервере должна быть активирована лицензия iLO Advanced или выше. Core Boosting, кроме того, будет работать не на всех процессорах и конфигурациях сервера. Кратко обо всех трех технологиях – здесь: www.hpe.com/h20195/v2/Getdocument.aspx?docname=a00018328enw

Память

Также были доработаны механизмы обеспечения отказоустойчивости памяти. В современных системах, где объем памяти исчисляется сотнями гигабайт, вероятность появления ошибок в каких-то чипах памяти очень высока. Поэтому применение инструментов для обеспечения надежности памяти (RAS) становится все более обоснованным. С поколением Gen10 HPE представила еще один такой инструмент – технологию SmartMemory Fast Fault Tolerance (FFT). С включением FFT упреждающие алгоритмы анализируют состояние чипов памяти, и в случае появления риска для данных в какой-то области памяти в чипе, назначают ей «запасные» области сравнимого объема на том же канале памяти. В результате запись и чтение данных в защищаемой области идет с контролем целостности, и пропускная способность и общий объем падают только для этой маленькой области.

В чем отличие это технологии, например, от механизма Lockstep с DDDC от Intel, который используется в процессорах Xeon E7 сейчас? В том, что с тонким контролем HPE Advanced Error Detection и Fast Fault Tolerance, мы снижаем производительность только при появлении вероятности потери данных и только для малой области памяти, в отличие от Lockstep, где производительность снижается на всех модулях памяти. В результате с FFT в целом по системе пропускная способность падает в среднем не более, чем на 1%. Эта технология также уникальна для HPE и не появится в серверах других производителей еще 2 года по лицензионному соглашению с Intel. В целом, применение современных технологий RAS в серверах HPE, по статистике HPE, снижает число «падений» системы в год (Annual Crash Rate) на 85%. Еще один ответ на вопрос почему память от HPE называется Smart Memory.

Видео об этой технологии можно посмотреть ниже, а подробный технический документ будет выпущен в ближайшее время.

Другой набор инноваций по работе с памятью – это две технологии энергонезависимой оперативной памяти HPE NVDIMM и HPE Scalable Persistent Memory. Первая – это существующие уже более двух лет модули оперативной памяти, совмещенные с энергонезависимой флешкой (на том же модуле) с питанием от батарейки в сервере. Такие модули видны обычным ОС (Windows и Linux) как очень быстрое блочное устройство — см. эксперименты вот здесь: habrahabr.ru/company/hpe/blog/282395. А некоторым приложениям (например, Microsoft SQL Server 2016) такой модуль виден как особое устройство с побайтной адресацией (как в RAM), но с устойчивостью к отключению питания. При размещении на таких модулях, хвоста лога транзакций (Tail of transaction log) MS SQL Server'а, мы видим прирост производительности базы данных до 4 раз по сравнению с размещением хвоста лога на SSD. Новые модули HPE NVDIMM теперь имеют емкость 8 и 16 ГБ, в то время как для БД SQL размером в несколько сотен гигабайт в большинстве случаев достаточно 1 модуля NVDIMM для размещения хвоста лога транзакций.

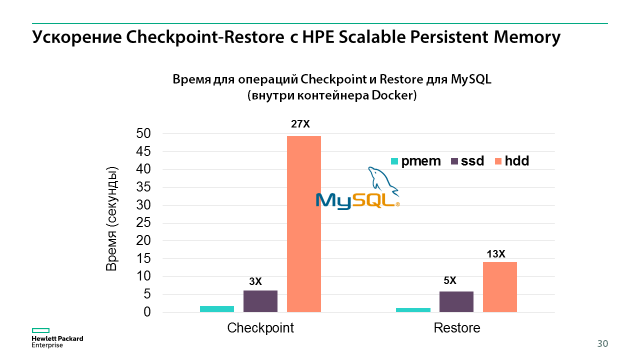

HPE Scalable Persistent Memory – это комплексные устройства, построенные на базе серверов HPE ProLiant DL380 Gen10, обычных модулей памяти DDR4 и особого механизма защиты RAM от потери питания с помощью NVMe-накопителей и резервного блока питания с внутренним ИБП в самом сервере. С этим устройством вы можете разместить в памяти до 1 ТБ данных без риска потерять их при отключении электричества, и таким образом многократно ускорить работу многих приложений. Например, во внутренних тестах с MySQL операции Checkpoint (сохранения данных БД из памяти на энергонезависимый носитель) на HPE Scalable Persistent Memory выполнялись в 27 раз быстрее, чем на HDD и в 3 раза быстрее, чем на SSD. А Restore (обратная операция – возвращение данных в память после сбоя) происходила в 13 и 5 раз быстрее соответственно. И кроме того, с такой системой практически любую БД можно превратить в in-memory, многократно повышая ее производительность.

Использование NVMe-накопителей также получило очень глубокое развитие. Теперь в каждый сервер можно установить в разы больше NVMe-накопителей (до 20 штук в DL380 Gen10, например), и в одну и ту же дисковую корзину в сервере можно устанавливать и NVMe, и SAS/SATA диски (продолжают существовать и обычные корзины без поддержки NVMe, если она вам не нужна). Плюс, появилась поддержка нового формата накопителей – uFF (micro-Form Factor), которых помещается 2 на место одного SFF-накопителя (объемы 120 и 340 ГБ, SATA). uFF-SSD могут использоваться как загрузочные или кэширующей диски для целого ряда задач, и экономят место в сервере для более емких накопителей под продуктивные данные.

Обновилась и линейка контроллеров. Теперь они быстрее (до 1,6 млн IOPS с контроллера) и могут работать одновременно в HBA и RAID-режиме (какие-то диски на контроллере в одном режиме, какие-то в другом). Полная линейка контроллеров в Gen10 на данный момент выглядит так:

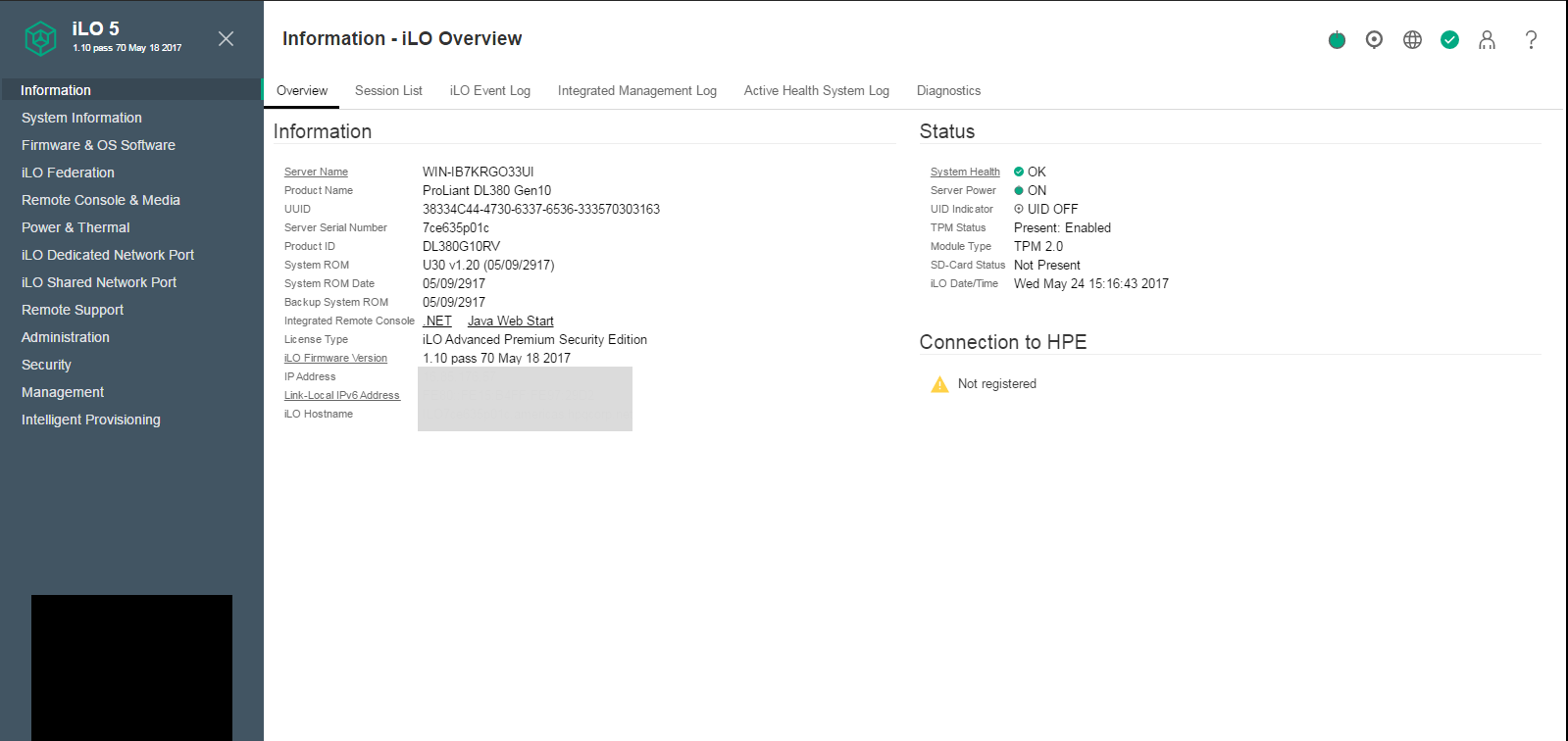

iLO 5

Одна и самых мощных новинок поколения Gen10 – усовершенствованная система удаленного управления HPE iLO 5. Кроме более быстрого чипа iLO, который ускоряет операции с удаленной консолью и виртуальными накопителями, появился целый ряд новых возможностей:

Технология HPE Silicon Root of Trust – это проверка прошивки iLO на наличие в ней вредоносного кода или повреждений с помощью сверки контрольной суммы с аппаратным чипом внутри системы iLO. Когда прошивка iLO проверена, это средство управления само проверяет прошивки всех остальных компонентов сервера, включая BIOS на предмет вторжения злоумышленников или другие нарушения целостности. В случае обнаружения проблемы, iLO может автоматически или по команде восстановить конкретную прошивку в последнее рабочее состояние из защищенного репозитория прошивок, вернуть сервер к заводским настройкам или не реагировать.

Зачем эта технология? Во-первых, прошивка компонента может повредиться в процессе обновления вручную или просто из-за сбоя в микросхеме. Во-вторых, аналитики угроз ИБ с каждым годом обнаруживают все больше уязвимостей в прошивках и другом низкоуровневом коде серверов. Последний громкий пример – найденная уязвимость в патчах для прошивок серверов SuperMicro, которые закупила себе компания Apple (ссылка: arstechnica.com/information-technology/2017/02/apple-axed-supermicro-servers-from-datacenters-because-of-bad-firmware-update). Этот уровень практически не контролируется привычными антивирусами, поэтому и угроза там скрывается значительная.

Зачем эта технология? Во-первых, прошивка компонента может повредиться в процессе обновления вручную или просто из-за сбоя в микросхеме. Во-вторых, аналитики угроз ИБ с каждым годом обнаруживают все больше уязвимостей в прошивках и другом низкоуровневом коде серверов. Последний громкий пример – найденная уязвимость в патчах для прошивок серверов SuperMicro, которые закупила себе компания Apple (ссылка: arstechnica.com/information-technology/2017/02/apple-axed-supermicro-servers-from-datacenters-because-of-bad-firmware-update). Этот уровень практически не контролируется привычными антивирусами, поэтому и угроза там скрывается значительная.Уникальность подхода HPE здесь: а) полный контроль над производством прошивок компонентов; все компоненты под брендом HPE имеют специально разработанную, либо проверенную и поставляему только через канал HPE прошивку и, начиная с поколения Gen10, поставляются с цифровой подписью HPE. И б) только HPE разрабатывает и производит собственную систему управления iLO, от софта до микросхем, благодаря чему может встроить в нее средство проверки подписей прошивок.

Еще одно небольшое, но полезное улучшение безопасности – датчик открытия корпуса сервера, при срабатывании которого iLO может заблокировать работу сервера до выяснения причин инцидента.

Функциональное улучшение в iLO 5 – теперь средство настройки сервера, включая настройки RAID, под названием Intelligent Provisioning можно запускать прямо из консоли iLO, а не только при загрузке сервера по нажатию F10. Благодаря этому можно избежать лишних перезагрузок сервера.

Быстрее стала проходить и сама процедура загрузки при использовании UEFI-режима BIOS – в среднем загрузка в 3 раз быстрее. Изменился и стал более удобным интерфейс настройки BIOS RBSU, и запустить его тоже можно из Intelligent Provisioning (а его – из iLO).

Большой плюс для пользователей различных средств автоматизации, в том числе в многовендорных окружениях – iLO теперь поддерживает большинство инструкций Open IPMI. И к тому же HPE продолжает лидировать в наполнении стандарта управления «железом» через интерфейс REST API (читайте здесь: habrahabr.ru/company/hpe/blog/268885). Теперь REST API от HPE полностью соответствует стандарту DMTF Redfish, кроме части управления RAID-контроллерами (там пока собственные REST API). Для управления через REST API есть как собственное средство, так и масса вспомогательных средств (например, для Python и PowerShell).

Еще одно новшество – на этот раз в части диагностики неисправностей. Если раньше Active Health System Log (запись «бортового самописца» сервера) можно было только выгрузить через iLO и отправить в Центр поддержки HPE для анализа, то сейчас его можно выкачать на флешку через спецальный USB-порт на лицевой стороне сервера и проанализировать самостоятельно с помощью бесплатного сервиса Active Health System Viewer (http://www.hpe.com/servers/ahsv). Сервис показывает и предлагает решение для 25% возможных уязвимостей, а для остальных – просто значительно облегчает обращение в поддержку, сокращая время на анализ неисправности.

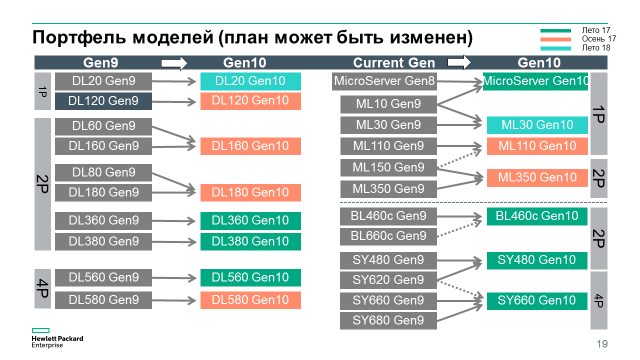

Новые модели HPE ProLiant Gen10

Вторая часть нашего обзора – о моделях, которые уже доступны к заказу сегодня. Вот так будет выглядеть весь основной портфель серверов HPE (здесь мы не говорим о линейках Apollo, Integrity и некоторых других):

Зеленым выделены те модели, которые можно заказать сейчас. Краткий обзор моделей в картинках:

ProLiant DL360 Gen10

ProLiant DL380 Gen10

ProLiant DL560 Gen10

ProLiant BL460c Gen10 – да, мы продолжаем выпуск блейдов в текущем шасси!

MicroServer Gen10

Кроме того, сейчас доступны к заказу новые серверы для платформы Synergy– SY480 Gen10 и SY660 Gen10, а сама платформа Synergy получила поддержку 25/50 GbE фабрики Mellanox, мощные графические опции и расширение вариантов конфигурации внутренних дисковых полок.

Плюс, существенно обновилась линейка продуктов для высокопроизводительных вычислений (НРС). Представлен новый флагман суперкомпьютерного мира – система HPE SGI 8600 с жидкостным (водяным) охлаждением. Отвечая стремительному прогрессу в мире НРС и потребностям заказчиков HPE, полностью переработана 6000-ная серия – представлена новая высокоинтегрированная система HPE Apollo 6000 Gen10 (узлы XL230k Gen10 и шасси k6000). Для решения широкого спектра задач в области искусственного интеллекта и некоторых других нагрузок, было представлено новое семейство узлов HPE Apollo 10-series, поддерживающих самые современные технологии ускорения вычислений Intel Xeon Phi 7000 и NVIDIA Tesla P100 на шине NVLink.

На этом мы заканчиваем эту статью, и ждем ваших пожеланий – какие технологии, сферы применений и модели серверов нам затронуть в ближайших обзорах и вебинарах? Мы запланировали 4 вебинара на октябрь – вам решать, о чем они будут. Отвечайте в комментариях, пожалуйста.

А пока, много отличных видео о Gen10 можно посмотреть здесь:

www.youtube.com/user/HewlettPackardVideos/videos

|

|

[Из песочницы] Система электронной очереди в банковском бизнесе |

О неоспоримой пользе внедрения IT в финансовый сектор и невероятных преобразованиях, которые способны возникнуть в результате модернизации банковского дела после введения технологических новшеств было уже сказано немало, поэтому без лишних слов приступим к делу.

Начало начал

На первый взгляд, конфигурация системы управления очередью для банковских отделений стандартна. Основные ее аппаратные компоненты:

- терминал регистрации для выбора посетителем требуемой услуги и получения талона с номером;

- общее информационное табло отображающее все номера клиентов, вызванных к операторам одной зоны обслуживания;

- табло на рабочем месте сотрудника, на котором обозначаются номер клиента, вызванного непосредственно к этому сотруднику банка;

- пульт вызова посетителей чаще всего реализуется в программном виде как приложение, устанавливаемое на компьютер оператора. Также важным моментом для банков, в случае если политика безопасности запрещает устанавливать стороннее программное обеспечение непосредственно на компьютере, пульт оператора может быть установлен на планшете, подключенном к рабочему месту оператора

Но под достаточно простой аппаратной конфигурацией скрываются серьезные программные возможности, позволяющие автоматизировать процесс обслуживания.

12 функциональных возможностей системы, актуальных для банков

Специализация рабочих мест. Суть этой функции заключается в том, что клиент, выбравший необходимую услугу, будет направлен к определенному сотруднику банка, который специализируются именно на этом вопросе. Специализация рабочих мест предполагает возможность использовать принцип приоритетности в распределении клиентского потока. Если рассматривать на деле, то можно привести наипростейший пример. Представим, что основной услугой окна № 1 является оплата коммунальных платежей (высокий приоритет). Соответственно в первую очередь к окну обслуживания №1 будут вызываться клиенты, желающие заплатить за коммунальные услуги. При этом, в случае необходимости, для этого же окна обслуживания можно добавить услугу пополнения счета (присвоив ей низкий приоритет). Тогда при отсутствии клиентов на оплату коммунальных платежей, в окно № 1 будут вызваться клиенты с услугой второго приоритета. Аналогично можно добавлять другие услуги, задавая значение приоритета в числовом выражении.

Маршрутизация услуг. Последовательное автоматическое направление клиента в несколько окон, если это необходимо для получения услуги. Например, открытие вклада требует оформления договора у оператора, затем внесения денег в кассу, затем возврата к оператору для получения документов. После регистрации клиента на услугу открытия вклада он будет вызван к оператору окна, занимающемуся оформлением документов. Принцип маршрутизации предполагает, что после выполнения своих функций, сотруднику банка не нужно выбирать, в какое окно направить клиента далее, – он просто нажимает кнопку «По маршруту», и система уже сама вызывает посетителя банка во все окна, соответствующие заданному для этой услуги маршруту.

Откладывание обслуживания клиента. Может возникнуть такая ситуация, когда уже вызванному для обслуживания клиенту требуется заполнить какие-либо документы, например, анкету на кредит или форму денежного перевода. В этом случае, оператор имеет возможность отложить обслуживание клиента на 5, 10 минут или любое другое время, и в образовавшемся промежутке обслужить следующего по очереди человека. По истечении времени, на которое был отложен вызов первого посетителя, система вызовет его к тому же оператору автоматически.

Выбор нескольких услуг. Если клиенту необходимо за один визит в отделение осуществить несколько банковских операций, существует возможность выбора всех требуемых услуг сразу и регистрации на них по одному номеру талона. В этом случае, клиент будет вызван на услугу, оператор которой освободится в первую очередь, а затем, по мере возможности, на все остальные. Здесь нужно отметить два момента. Первое, пока оказывается одна услуга, система блокирует данный номер клиента для вызова по другим вопросам, то есть клиент не может быть вызван одновременно в два окна. Второе, посетитель, вызванный на одну банковскую операцию, не теряет свою очередь по другим услугам, система встроит его номер в очередь именно на то порядковое место, которое было у него в момент регистрации.

Приоритет клиентов. Определенным категориям VIP-клиентов в системе может быть задан приоритет обслуживания (например, держателям карт Gold и Platinum). Таких посетителей система будет автоматически ставить в начало очереди на выбранную услугу. Идентификация может производиться путем считывания банковской карты, в этом случае терминал регистрации должен быть оснащен карт-ридером. Помимо этого, идентификация карты может быть осуществлена путем ввода ее номера с помощью виртуальной клавиатуры или с применением биометрических технологий.

Предварительная запись. Клиент может записаться на обслуживание заранее с помощью интернет-сайта банка или мобильного приложения и подойти в отделение в удобное для него время. Активация предварительной записи осуществляется на терминале регистрации с помощью ввода уникального кода или сканирования штрих-кода.

СМС-оповещение. Если при выборе услуги на терминале прогнозируемое время ожидания обслуживания превысит заданную величину (например, 1 час), клиенту будет предложено ввести номер телефона для дополнительного СМС-информирования формата «Ваш номер … будет вызван через 15 мин. Пожалуйста, подойдите в отделение». Помимо этого, есть возможность считать QR-код с полученного талона и при помощи смартфона отслеживать свою очередь в режиме онлайн. Это позволит клиенту не сидеть долгое время в зоне ожидания.

Мультиязычность. Для международных банков, а также для отделений, расположенных в субъектах РФ, которые имеют свой национальный язык, можно использовать мультиязычный интерфейс системы. При регистрации на терминале или при предварительной записи, в первую очередь, клиенту предлагается выбрать язык. Именно на этом языке будут отображаться наименования услуг, текст распечатанного талона, текст СМС-сообщений, а также будет озвучен голосовой вызов на обслуживание.

Рекламные возможности. На главном информационном табло кроме отображения вызванных номеров, можно демонстрировать рекламные ролики или же давать объявления в формате бегущей строки. Помимо рекламы на информационном табло, есть возможность показа рекламных баннеров на самом терминале. Например, при выборе основного раздела «Кредиты», клиент попадает в подменю операций, относящихся к данному разделу, в котором будет отображаться информация о специальных предложениях по кредитам. Также рекламную информацию в текстовом виде можно печатать на талоне, здесь она будет зависеть от выбранной клиентом услуги.

Сбор статистических данных. Система управления очередью обладает широкими возможностями для сбора и визуализации статистической информации о процессе обслуживания клиентов. Отчеты формируются в формате Excel в табличном и графическом виде. Из них можно получить данные:

- о количестве обслуженных клиентов по каждой услуге, каждому оператору и в совокупности по всему отделению;

- среднем времени обслуживания и ожидания;

- количестве клиентов с показателями времени ожидания, превышающими норму;

- списки предварительной регистрации и другие показатели

Статистические отчеты в автоматическом режиме по заданному расписанию отправляются на электронную почту ответственного лица.

Централизация. Для банков, которые имеют разветвленную филиальную сеть, актуально использование модуля централизации, позволяющего управлять настройками системы управления очередью в каждом отделении из центрального офиса. Модуль централизации позволяет осуществлять обмен данными (обновление списка оказываемых услуг, рекламных роликов, текстов бегущих строк, курсов валют, статистической информации об обслуживании, а также программного обеспечения системы управления очередью) в автоматическом режиме по расписанию или вручную. Дополнительный модуль оперативного мониторинга позволяет отслеживать информацию о процессе обслуживания в отделениях в режиме онлайн, включая выделение превышения критических показателей процесса обслуживания и данные с камер видеонаблюдения.

Оценка качества. Часто система управления очередью дополняется модулем оценки качества обслуживания. Оценка качества может осуществляться с помощью кнопочного пульта (балльная оценка) или в развернутом виде с помощью заполнения анкеты на планшете. Модуль оценки качества также позволяет получать статистику обслуживания в различных разрезах. Для балльной оценки по временным периодам и операторам, для анкетирования по любому из вопросов анкеты (например, по полу, возрасту или доходу).

И это только основные функции системы. На самом деле потенциал реализации возможностей практически безграничен. Имея опыт сотрудничества с заказчиками из различных сфер бизнеса, мы можем с уверенностью сказать, что практически любые поступающие к нам запросы, мы рассматриваем в частном порядке и зачастую придумываем какие-то нестандартные решения, которые позволяют использовать систему по максимуму функционально.

Из новенького

Программное обеспечение системы управления очередью постоянно совершенствуется и дорабатывается в соответствии с требованиями рынка и запросами клиентов. Некоторые из последних доработок, применимых к банковской сфере:

QR код. Удаленный просмотр информационного табло. На распечатанном талоне с номером очереди присутствует сгенерированный QR-код, позволяющий отслеживать состояние очереди с помощью смартфона. Клиент, считывая этот QR-код любым мобильным приложением для его распознавания, получает ссылку, переход по которой отображает страницу с данными о вызванных номерах клиентов. Эти данные аналогичны отображаемым на информационном табло в отделении. Таким образом, становится необязательным присутствие клиента непосредственно в зоне видимости табло.

Фиксация валютного курса. Мы создали возможность фиксации курса в момент печати талона. Зафиксированный курс, отображенный на талоне будет отображаться в интерфейсе пульта оператора в привязке к номеру клиента. Данные о курсах валют импортируются из банковской информационной системы в автоматическом режиме. Эта услуга может быть необходима в случае обновления валютного курса в середине рабочего дня, для избегания ситуаций, когда во время регистрации клиента в очереди курс один, а к моменту обслуживания – другой.

Режим явки. Для банков важно правильное определение не только времени ожидания, но и времени обслуживания клиентов. Если время ожидания фиксируется достаточно точно (период от момента регистрации до момента вызова на обслуживание), то время обслуживания раньше учитывалось не совсем корректно. До внедрения доработок, этот показатель рассматривался как период с момента вызова клиента до момента подтверждения окончания обслуживания. В отделениях с большим количеством операторов и сложной конфигурацией зоны ожидания посетитель не всегда может сразу сориентироваться где расположено окно, в которое его вызвали. На поиск тратится определенное количество времени, которое не должно учитываться как время обслуживания. Для решения этого вопросы мы создали возможность задать определенное значение средней величины времени, которое требуется клиенту, чтобы дойти до окна. Соответственно это время не включается в общий показатель по времени обслуживания.

Рабочее место без оператора. Бывает, что потенциальный клиент приходит в отделение не для осуществления финансовой операции, а для того, чтобы получить профессиональную консультацию. Для оказания такой услуги не требуется полноценное рабочее место оператора, консультацию можно провести в переговорной комнате или просто за отдельным столом в зоне ожидания. Такое рабочее место присутствует в системе управления очередью, которая вызывает туда клиента, а оператором может стать любой свободный консультант. Факт оказания услуги именно этим консультантом фиксируется в системе или администратором зала на ресепшен, либо же руководителем отделения. Данная возможность также востребована, если консультирование проводит специалист, не состоящий в штате данного подразделения банка. Например, клиент через систему предварительной записи регистрируется в удобное ему отделение на консультацию по инвестициям, а в этом отделении финансового советника нет, тогда он приедет специально из центрального офиса и встретится с клиентом в переговорной.

Отложенный визит. Если клиент приходит в отделение банка в момент пиковой загрузки и видит большое количество ожидающих, он может при выборе услуги на терминале воспользоваться возможностью предварительной регистрации на текущий день. Например, указать время визита через час или два. В этом случае, он может быть уверен, что раньше, чем через указанное время его номер не будет вызван.

Доступная среда. Реализация государственной программы «Доступная среда» не обошла стороной и системы управления очередью. Все чаще в программное и аппаратное обеспечение системы внедряются решения для людей с ограниченными возможностями. Это и отображение интерфейса выбора услуг в контрастных цветографических схемах, режим экранной лупы, голосовое оповещение с встроенной индукционной петлей, дополнительные кнопки на терминале со шрифтом Брайля, голосовое меню, переменная высота терминала и другие возможности.

Интеграция со СКУД. Система управления очередью может интегрироваться с системой контроля и управления доступом, если существуют зоны обслуживания, доступ в которые должен быть ограничен, например, депозитные ячейки. Подтверждение разрешения доступа может осуществляться сканированием штрих-кода на талоне с номером клиента (подтверждение вызова), а также дополнительно с помощью биометрических технологий (подтверждение личности).

Технологии биометрии. Технологии биометрии используются для идентификации VIP-клиентов в момент регистрации их на терминале очереди для подтверждения приоритета обслуживания. Для этого терминал дополнительно оснащается камерой для распознавания лица или сканером отпечатка пальца.

Также подобные технологии применяются в случае интеграции системы управления очередью со СКУД для подтверждения личности при доступе в специальные хранилища. В этом случае могут использоваться не только определение личности по снимку лица или отпечатку пальца, но голосовая идентификация или сканирование радужной оболочки.

Здесь нужно отметить, что никакие персональные данные клиента не сохраняются в базе данных системы управления очередью, вся идентификационная информация передается напрямую в банковскую информационную систему, от которой приходит только подтверждение приоритета этого клиента.

То есть как мы можем видеть, потенциал для разработок и внедрения новейших технологий масса. Все зависит от конкретных потребностей людей с которыми мы сотрудничаем. А уж использовать стандартный набор функций системы или же поломать голову и создать что-то новое, это уже вопрос стремления развить свой бизнес и желание сделать его максимально эффективным.

|

Метки: author TehnologiiBudushego финансы в it электронная очередь банковский бизнес it в финансовой сфере |

VAX — инструмент для визуального программирования, или как написать SQL мышкой |

Я хочу рассказать про созданный мною web редактор для «визуального программирования» и его историю создания.

Случилось как-то мне столкнуться с одной очень надоедливой задачей на работе в компании PimPay, в которой я занимаю должность технического директора. Есть у нас отдел, занимающийся претензионной деятельностью с Почтой России. Ребята ищут потерянные/не оплаченные/не доставленные отправления. В сухом остатке для разработчиков эта задача сводилась к написанию очень большого количества разнообразных и огромных (>150 строк) SQL запросов на диалекте PostgreSQL, которые ОЧЕНЬ часто менялись и дополнялись в силу активного появления новых гипотез, а также поступления новых сведений о заказах.

Естественно, нам, как программистам, это дело очень быстро надоело, и сразу захотелось предложить

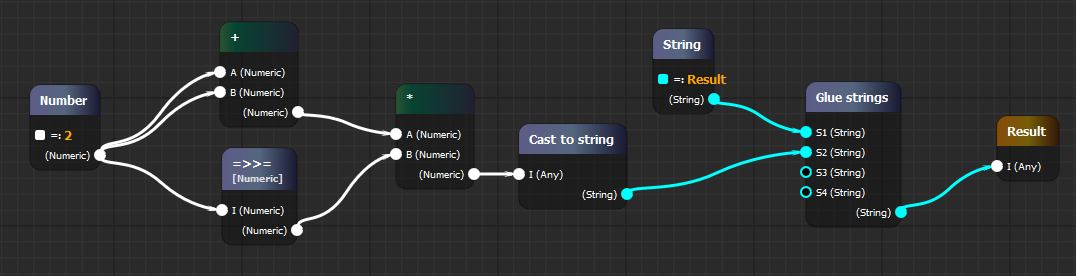

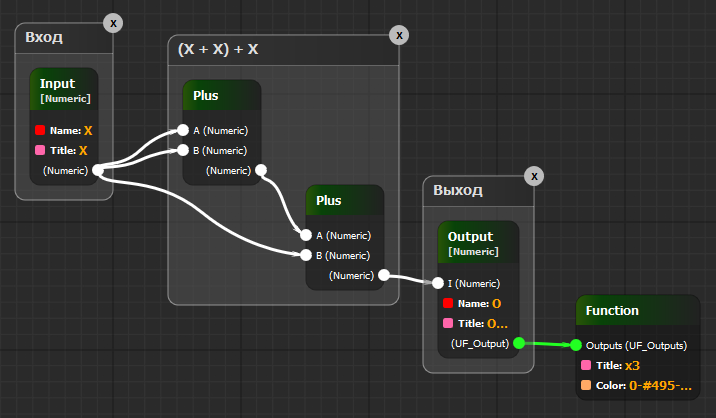

И тут, как в фильме «Проблеск гениальности» («Flash of Genius»), у меня перед глазами всплыла картина визуального редактора схем (blueprints) из UE4 (Unreal Engine 4), с помощью которых персонажи запускали файрболы в своих врагов:

Прибежав в тот же вечер домой, я взял первую попавшуюся JavaScript библиотеку, умеющую рисовать красивые прямоугольники и сложные линии — ей оказалась Rapha"el от нашего соотечественника DmitryBaranovskiy. Нарисовав пару прямоугольников и подёргав их с помощью библиотечных drag-and-drop, я сразу написал автору библиотеки с вопросом поддерживает ли он её. И не дождавшись ответа (до сих пор), я в ту же ночь наплодил более 1000 строк кода на JavaScript, и моя мечта на глазах почти стала явью! Но предстояло ещё много работы.

В итоге, что же захотелось сделать: