Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Coco Framework — блокчейн по-крупному |

Однако для того, чтобы стать профессиональным инструментом, блокчейн должен соответствовать жестким требованиям по производительности и безопасности, иметь хорошую репутацию и открытый код. Осознавая это, два компьютерных гиганта, Intel и Microsoft, решили «с нуля» создать принципиально новую блокчейн-систему, Coco Framework. Ее принципиальная особенность – поддержка технологии Intel Software Guard Extensions (Intel SGX) для аппаратного ограничения доступа к данным блокчейна и ускорения процесса их обработки.

По обещаниям разработчиков, исходный код Coco Framework будет выложен на GitHub в начале 2018 года. Под катом вы найдете инфографику о преимуществах Intel SGX с точки зрения блокчейна.

Читать дальше ->

|

Метки: author saul анализ и проектирование систем open source блог компании intel coco framework |

Как мы участвовали в первом Лигалтех хакатоне СНГ и почему решили делать ещё один в Москве |

Пока ехали в поезде, думали, с каким проектом пойдём. Хотели сделать бота для налоговых вычетов, но вроде сбертех это делал, да и профита там мало. Была идея сделать личного помощника по всем юр.вопросам, некий мост между клиентами и биржами юристов. В итоге остановились на системе автоматизации работы m&a-юриста венчурного фонда. Так сказать и задачка интересная, и mvp поможет супруге на работе, избавив от рутины и необходимости в помощнике.

Погуляв по Киеву, расписали MVP и легли спать. Взбодрившись ирландским кофе с утра, пошли на открытие. Победа для меня не была самоцелью, но я чувствовал наше превосходство ;) Мы практики, с большим опытом, с опытом запуска бизнеса, привлечения инвестиций, а тут студентики какие-то. Так я думал до представления команд. Самооценка падала постепенно, но уверенно ))) Те самые «студенты» предлагали интересные продукты, к некоторым из команд я сам бы с удовольствием подключился. Единственное, что вселяло в меня веру в успех — наше трудолюбие. Не каждый выдерживает сутки работы без сна, а себе я периодически устраиваю такие встряски.

К нашему проекту присоединилось 3 человека — 2 юриста и разработчик. Сначала я думал, что оно нам не надо, но я сильно ошибался. Ребята взяли на себя работу по презентации, часть кода и много поддерживали. Вдвоём я вообще не уверен, что мы бы справились.

В качестве mvp мы решили показать путь подписания документов при привлечении инвестиций для стартапа, шаблонизировать их, предлагая юристу или стартапу заполнить анкету и загрузить фотографию своих подписей. Заполнив анкету и загрузив подпись, система сама генерила docx-договоры (NDA, dd, ts и т.п.) с уже проставленными подписями и данными. Это лишь одна из задач будущей системы, но для суточного хакатона вполне подойдёт.

Накидали бэклог для канбана, оставалось порядка 20 часов. Я прикинул, что на фронт нам потребуется порядка 3-4 часов, поставил пару будильников и мы приступили к бэкенду.

Редбул лился, код мутился. Ближе к утру стало понятно с чем мы успеваем, с чем не очень, с какими проблемами столкнулись и что в итоге у нас получается. Мы закончили бэкенд, успев реализовать 99% задумок, было 7 утра. Я поставил будильник на час и улёгся на пуфик. В 8 утра народ начал стягиваться обратно на площадку, а мы сели за фронт. У нас был готов код для шаблонизации вордовских документов, был написан небольшой CV для поиска и «вычленения» подписи с фотки, однако, наш шаблонизатор не умел вставлять картинки туда, куда нам надо. Это немного печалило, но время шло и мы решили не отвлекаться на это. Покажем при демонстрации MVP, что мы это сделали, но в готовый документ не встанет, жаль, но ладно. Спасибо Ангуляру и Бутстрапу — мы достаточно быстро накидали интерфейс как для юриста фонда, так и для стартапа.

Презентация 5 минут. И тут началось самое интересное ) Ребята показывали хорошие проекты, хорошие и разные, близкие к потребителю, явно ближе, чем наш b2b-инструмент. Тут уже я начал нервничать, я понимал, что победа не главное, но победить-то хотелось ) Были, конечно, и промахи. Например, одна из команд приехала уже с готовым проектом, в чём честно признались.

Мы посмотрели все проекты и судьи удалились обсуждать, организаторы выкатили вертушки и пошла подготовка к афтепати. Я уже порядком сидел на измене, т.к. помимо прочего наш поезд отходил через 2 часа. Мы уже не попадали на афтепати, но ждали решения уважаемых судей.

Ииии…

Как оказалось, мы победили с неплохим отрывом, что было очень приятно. Мы получили небольшой денежный приз, уважение и признание ) Деньги поделили среди команды и быстро поскакали на вокзал. После полутора суток без сна мы превосходно себя чувствовали в поезде.

После хакатона в Киеве мы задумались о развитии лигалтех-движения в России и в Москве. Оказалось, его не так много, почти нет. Нам очень понравился формат, участие и участники. Лигалтех из «какого-то там направления» стал для нас очень интересным вектором.

Захотелось провести свой хакатон, но перед ним нужно заявить о себе, что мы и сделаем 30 августа на первом мероприятии нашего лигалтех-движения в Москве. Мы уже договорились с топ-3 юридическими вузами о прямой поставке студентов, договорились с СМИ, нашли чумовую площадку для проведения ивента и активно набираем ЦА для проведения первой встречи. Мероприятие бесплатное, наша задача — развитие лигалтеха, а не моментальная прибыль. Поэтому если кому покажется интересным провести 30 августа (среда) в компании единомышленников, пообсуждать лигалтех, его будущее и узнать наши планы по хакатону, пишите в личку, отвечу всем.

Обращаясь к Киевским ребятам, которые двигают там лигалтех, хочется ещё раз сказать спасибо! Вы все большие молодцы. И то, что вы делаете для лигалтеха — бесценно.

|

Метки: author mobilz законодательство и it-бизнес хакатон лигалтех юристы amp;a legaltech |

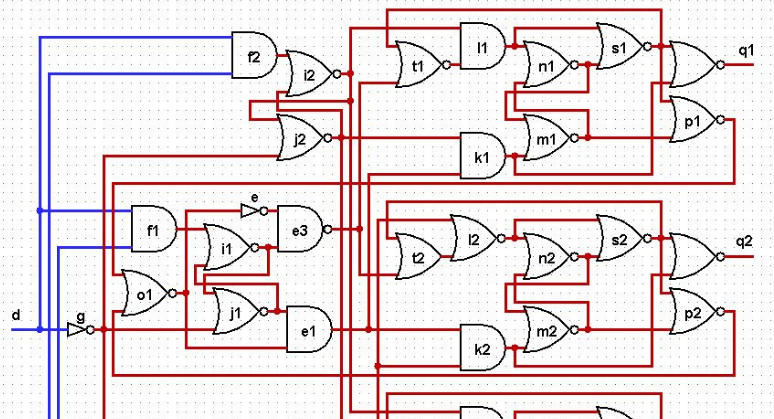

Исследование асинхронной схемы в ModelSim |

Прочитал статью FPGA/Асинхронный дешифратор от ajrec.

Я сперва прочитал и ничего не понял, а потом прочитал еще раз и опять ничего не понял. На самом деле я прочитал уже все статьи ajrec про асинхронные схемы и должен констатировать, что мало понимаю, что это вообще такое (хотя считаю, что опыт проектирования в FPGA у меня есть).

В комментариях к статьям автор в основном получает минусы, народ посмеивается и кажется так же не понимает, как и я.

Честно говоря, я всегда с любопытством смотрю на проекты, которые «не такие, как все». Я считаю, что только такие проекты имеют шанс либо глубоко провалиться, либо высоко взлететь. Если делаешь что-то так же, как и сотни других разработчиков, то идешь проторенной дорогой, здесь легко и комфортно. Сделать шаг в сторону и пойти своей тропой могут далеко не все.

Я попробовал разобраться в проекте асинхронного дешифратора и по крайней мере сделать временную симуляцию кода в ModelSim. Далее о том, что из этого получилось.

Честно говоря, изложенное в статье "Асинхронный дешифратор" и "Система синтеза самосинхронных схем Petrify: проблемы и их решение" плохо влазит в мою голову. Я основательно «испорчен методикой синхронного дизайна».

Кроме того, в статье есть странности, которые режут глаз. Вот, например, цитата:

Выходные сигналы:

q1 — переключается если r1=1 и r2=1;

q2 — переключается если r1=1 и r2=0;

q3 — переключается если r1=0 и r2=1;

q4 — переключается если r1=0 и r2=0.

Я наверное придираюсь, но с трудом представляю себе программиста, который пишет нумерацию сигналов начинающуюся с единицы и чтобы q4 переключается, когда r1=0 и r2=0. В моей голове все строго по шаблону: { 0, 0 } — соответствует сигналу q0. { 0, 1 } — соответствует сигналу q1. { 1, 0 } — соответствует сигналу q2 и { 1, 1 } — соответствует сигналу q3. Но это, конечно, мелочи, которые не относятся к делу.

Основная же претензия с моей стороны: автор не проверяет свои гипотезы/исследования/проекты в ПЛИС или любым другим способом. Он пишет: «У меня нет возможности проверить схему в реальном воплощении.» Ну как так то?

Собственно это и подтолкнуло меня к мысли попробовать просимулировать логику описанного ajrec дешифратора. Временная симуляция — это достаточно хорошая модель, которая будет показывать поведение схемы в реальной ПЛИС. Правда… тут есть нюанс — у меня нет полной уверенности, что ModelSim сможет достоверно симулировать асинхронные схемы: симулятор ModelSim предназначен прежде всего для «традиционного» синхронного дизайна.

Итак. Исходный код из статьи FPGA/Асинхронный дешифратор у нас не знаю на каком языке и выглядит следующим образом:

e=NOT(o1); e1=AND(o1,j1); e2=AND(o2,h1); e3=NAND(e,i1);

e4=OR(o2,h1); f1=AND(d,r1); f2=AND(d,r2); g=NOT(d);

h1=NOR(g,r1); h2=NOR(g,r2); i1=NOR(f1,j1); i2=NOR(f2,j2);

j1=NOR(g,i1); j2=NOR(g,i2); k1=AND(e1,j2); k2=AND(e1,h2);

k3=AND(e2,j2); k4=AND(e2,h2); l1=AND(t1,i2); l2=NOR(t2,h2);

l3=AND(t3,i2); l4=NOR(t4,h2); m1=NOR(k1,n1); m2=NOR(k2,n2);

m3=NOR(k3,n3); m4=NOR(k4,n4); n1=NOR(l1,m1); n2=NOR(l2,m2);

n3=NOR(l3,m3); n4=NOR(l4,m4); o1=NOR(p1,p2); o2=NOR(p3,p4);

p1=NOR(m1,s1); p2=NOR(m2,s2); p3=NOR(m3,s3); p4=NOR(m4,s4);

s1=NOR(n1,l1); s2=NOR(n2,l2); s3=NOR(n3,l3); s4=NOR(n4,l4);

t1=NOR(e3,s1); t2=OR(e3,s2); t3=NOR(e4,s3); t4=OR(e4,s4);

q1=NOR(s1,k1); q2=NOR(s2,k2); q3=NOR(s3,k3); q4=NOR(s4,k4).Далее в статье идет эквивалентная схема этой штуки и говорится о том, что вообще-то сигналы m1, m2, m3, m4 нужно еще сбрасывать в исходное состояние перед началом работы. Хорошо, перепишу все это на язык Verilog вот так:

module test(

input wire d,

input wire r1,

input wire r2,

input wire set0,

output wire q1,

output wire q2,

output wire q3,

output wire q4,

output wire [3:0]qq

);

wire e, e1, e2, e3, e4;

wire f1, f2;

wire g;

wire i1, i2;

wire j1, j2;

wire h1, h2;

wire k1, k2, k3, k4;

wire l1, l2, l3, l4;

wire m1, m2, m3, m4;

wire n1, n2, n3, n4;

wire o1, o2;

wire p1, p2, p3, p4;

wire s1, s2, s3, s4;

wire t1, t2, t3, t4;

function NOT;

input s;

begin

NOT=~s;

end

endfunction

function AND;

input s1,s2;

begin

AND=s1&s2;

end

endfunction

function NAND;

input s1,s2;

begin

NAND=~(s1&s2);

end

endfunction

function OR;

input s1,s2;

begin

OR=s1|s2;

end

endfunction

function NOR;

input s1,s2;

begin

NOR=~(s1|s2);

end

endfunction

assign e=NOT(o1); assign e1=AND(o1,j1); assign e2=AND(o2,h1); assign e3=NAND(e,i1);

assign e4=OR(o2,h1); assign f1=AND(d,r1); assign f2=AND(d,r2); assign g=NOT(d);

assign h1=NOR(g,r1); assign h2=NOR(g,r2); assign i1=NOR(f1,j1); assign i2=NOR(f2,j2);

assign j1=NOR(g,i1); assign j2=NOR(g,i2); assign k1=AND(e1,j2); assign k2=AND(e1,h2);

assign k3=AND(e2,j2); assign k4=AND(e2,h2); assign l1=AND(t1,i2); assign l2=NOR(t2,h2);

assign l3=AND(t3,i2); assign l4=NOR(t4,h2);

assign m1=NAND( set0, OR(k1,n1)); /* NOR(k1,n1); */

assign m2=NAND( set0, OR(k2,n2)); /* NOR(k2,n2); */

assign m3=NAND( set0, OR(k3,n3)); /* NOR(k3,n3); */

assign m4=NAND( set0, OR(k4,n4)); /* NOR(k4,n4); */

assign n1=NOR(l1,m1); assign n2=NOR(l2,m2);

assign n3=NOR(l3,m3); assign n4=NOR(l4,m4); assign o1=NOR(p1,p2); assign o2=NOR(p3,p4);

assign p1=NOR(m1,s1); assign p2=NOR(m2,s2); assign p3=NOR(m3,s3); assign p4=NOR(m4,s4);

assign s1=NOR(n1,l1); assign s2=NOR(n2,l2); assign s3=NOR(n3,l3); assign s4=NOR(n4,l4);

assign t1=NOR(e3,s1); assign t2=OR(e3,s2); assign t3=NOR(e4,s3); assign t4=OR(e4,s4);

assign q1=NOR(s1,k1); assign q2=NOR(s2,k2); assign q3=NOR(s3,k3); assign q4=NOR(s4,k4);

assign qq = 1 << {r2,r1};

endmodule

Я постарался в исходный код вносить минимальные изменения, чтобы случайно не нарушить логику, которую я не понимаю. Поэтому я определил Verilog функции AND, OR, NOR, NAND, чтобы они делали то, что должны делать. Присвоение значения сигнала в Verilog делается через assign. Если кому нужно, то вот Краткое описание языка Verilog.

Таким образом, в модуле test имеются входные сигналы декодируемого адреса r1 и r2, а так же сигнал сброса set0 и сигнал d — команда на операцию дешифрации адреса (в терминологии автора). Выходные сигналы q1, q2, q3 и q4.

Кроме этого, я добавил отсебятину, четырехбитный выходной сигнал qq, который вычисляется традиционным дешифратором, вот так: assign qq = 1 << {r2,r1};

Модуль test был вставлен в проект Intel Quartus Prime Lite Edition v16.1 для микросхемы ПЛИС Cyclone IV E.

Проект был скомпилирован. Предварительно в настройках проекта Assignments=> Settings => EDA Tools Settings => Simulation нужно выбрать Tool Name => ModelSim-Altera. Тогда, после компиляции будет создана папка simulation/modelsim в которой будут находиться модули *.sdo и *.vo, которые нужны для временной симуляции.

Теперь нужен testbench. Я написал его по простому:

`timescale 1ns / 1ns

module tb();

reg r1_;

reg r2_;

reg d_;

reg set_;

wire q1_,q2_,q3_,q4_;

wire [3:0]qq_;

test test_inst(

.d(d_),

.r1(r1_),

.r2(r2_),

.set0(set_),

.q1(q1_),

.q2(q2_),

.q3(q3_),

.q4(q4_),

.qq(qq_)

);

initial

begin

$dumpfile("out.vcd");

$dumpvars(0,tb);

//reset m1-m4 signals using "set_"

r1_=0;

r2_=0;

d_=0;

set_=0;

#100;

set_=1;

#100;

//check addr 00

r1_=0;

r2_=0;

#100;

d_=1;

#100;

d_=0;

#200;

//check addr 01

r1_=1;

r2_=0;

#100;

d_=1;

#100;

d_=0;

#200;

//check addr 10

r1_=0;

r2_=1;

#100;

d_=1;

#100;

d_=0;

#200;

//check addr 11

r1_=1;

r2_=1;

#100;

d_=1;

#100;

d_=0;

#200;

//--------------------

//check addr 00

r1_=0;

r2_=0;

d_=1;

#100;

d_=0;

#200;

//check addr 01

r1_=1;

r2_=0;

d_=1;

#100;

d_=0;

#200;

//check addr 10

r1_=0;

r2_=1;

d_=1;

#100;

d_=0;

#200;

//check addr 11

r1_=1;

r2_=1;

d_=1;

#100;

d_=0;

#200;

end

endmoduleЗдесь сигналы адресов r1 и r2 поочередно устанавливаются во все четыре возможные значения 2'b00, 2'b01, 2'b10 и 2'b11, при этом еще вырабатывается этот сигнал d, который активизирует декодирование.

Это все происходит два раза, причем первые четыре сигнала активации дешифрации d происходят при установившихся сигналах r1 и r2, а во второй группе сигналов d приходит одновременно с сигналами r1 и r2. Честно говоря я не знаю, как это на самом деле должно быть по замыслу автора. Именно по этому я рассматриваю вот такой крайний случай, приход сигнала активации d в момент установления сигналов r1 и r2.

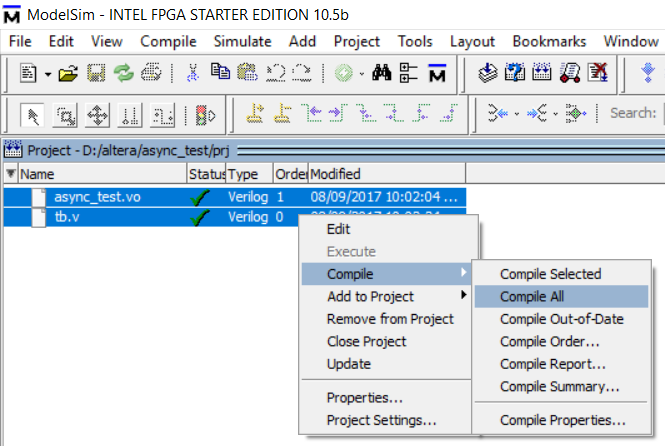

Теперь запускаю ModelSim-Altera (или теперь уже Intel). Создаю проект и воркспейс. Добавляю в него два существующих файла: тестбенч tb.v и скомпилированный квартусом проект async_test.vo:

Их теперь еще нужно откомпилировать уже с помощью ModelSim. Правая кнопка мыши и выбираю из меню Compile All. Нужно чтобы появились зеленые чек-марки возле каждого файла. Иногда бывает странность и ModelSim находит синтаксические ошибки там, где их не видит квартус. Это так, к слову.

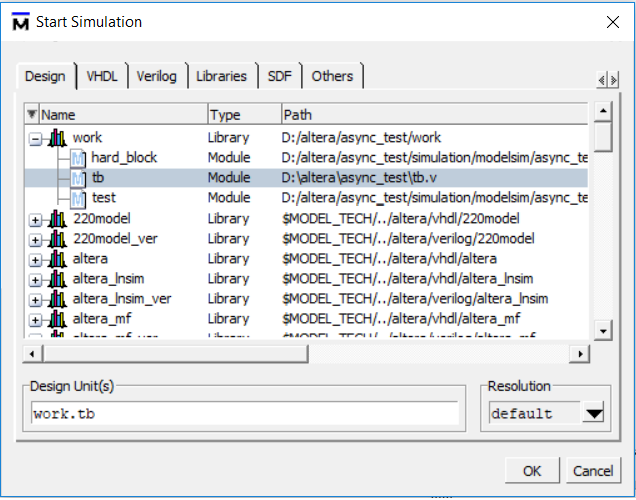

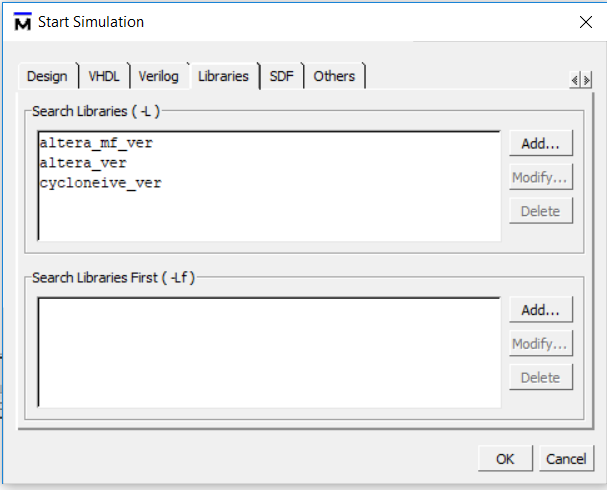

Теперь можно начинать симуляцию через меню ModelSim, Simulate-> Start Simulation…

Тут появляется диалоговое окно где нужно:

1) выбрать топ модуль и сейчас это тестбенч

2) добавить библиотеки альтеры

3) добавить скомпилированный SDF файл, из которого все временные параметры пойдут

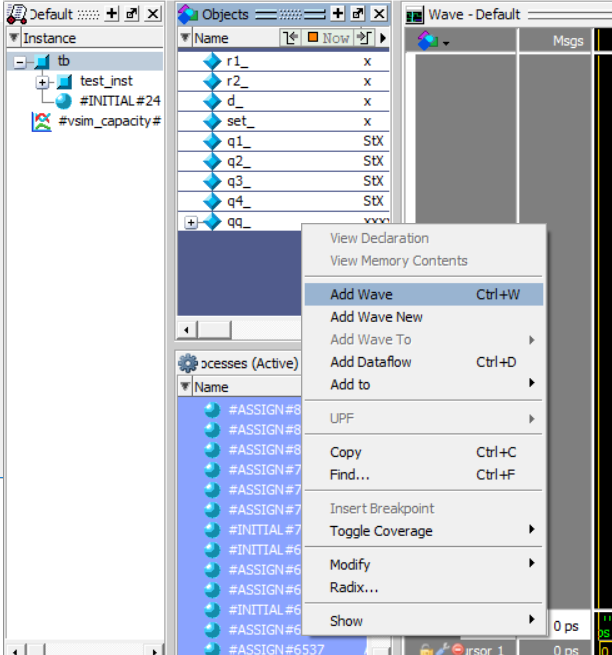

После успешной подгрузки всех нужных для симуляции файлов и модулей нужно добавить интересующие нас сигналы в окно временных диаграммм.

Нажимаем OK и далее меню Simulate => Run => Run-all

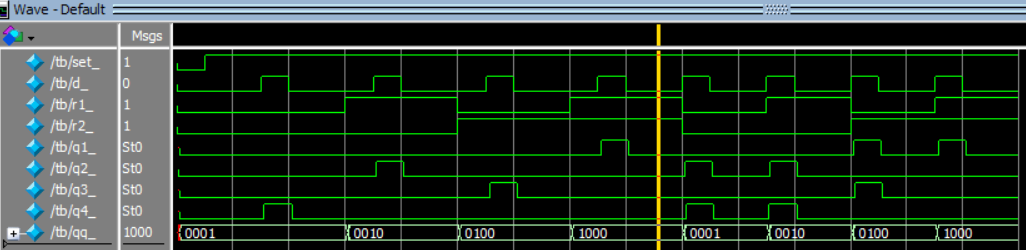

Вот оно и получилось — заработало!

Что я вижу:

Во-первых, проект похоже почти работает и декодирует адреса, как и обещано — вот только для первой группы четырех импульсов d. Как-то перепутаны выходы дешифратора, при {r2,r1} = 2'b01 зажигается q2. Но я про эту странность выше уже говорил. Честно говоря, я был сильно удивлен, что это вообще работает при каких-то условиях.

Вторая группа из 4х импульсов d не работает правильно. Это тот момент когда сигнал d приходит одновременно с изменяющимися r1 и r2.

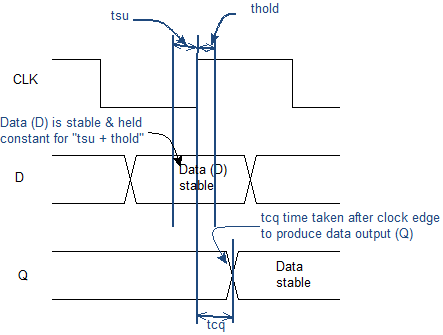

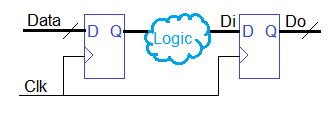

Здесь хотелось бы точнее понять роль сигнала d. В синхронной логике я знаю есть тактовая частота, которая защелкивает данные пришедшие от одного регистра к другому через комбинационные функции. При этом разработчик обязан обеспечить так называемые временные параметры tsu и thold. Вот первая попавшаяся картинка по теме из гугла:

Защелкиваемый в регистре сигнал обязан быть стабильным некоторое время tsu (setup time) до фронта тактовой частоты и некоторое время после фронта тактовой частоты thold (hold time). Если это условие не выполняется, то синхронная схема не работает или работает не надежно (ну то есть фактически не работает).

Что такое стабильный сигнал? Вот есть регистр, в котором запоминаются входные данные. Далее идет логическая функция, которая из входных данных (это может быть несколько разрядов) вычисляет следующее значение, которое запоминается в следующем регистре. Так вот логическая функция должна вычислить результат за время меньшее, чем длительность периода тактовой частоты. Не только успеть вычислить. Поскольку разрядов несколько, то результат еще должен успеть вовремя прибежать по проводникам каждый к своему защелкивающему регистру.

Теперь, возвращаясь к асинхронной схеме и сигналу d я понимаю, что вторая группа из четырех импульсов d в этой асинхронной схеме во время симуляции видимо не работает правильно точно по той же причине, по которой может не работать и синхронная схема. А именно, не выдержан tsu. Сигнал d приходит, когда сигналы r1 и r2 еще не пришли или не стабильны.

Мне кажется, что автору асинхронной схемы не удастся избежать временного анализа. Обязательно нужно позаботиться о стабильности сигналов r1 и r2 до прихода d. Это нужно как-то контролировать и учитывать. Честно говоря, сам импульс d чем-то напоминает синхроимпульс тактовой частоты. У сигнала d есть длительность, значит она, эта длительность чем-то обеспечена, каким-то генератором? Получается, что для работы асинхронной схемы все таки нужны времязадающие цепи, те которые определяют длительность и позицию сигала d? Вообще, происхождение этого сигнала d не очень понятно…

Хотел обратить внимание еще на несколько моментов в моей симуляции. Даже когда схема работает (первые 4 импульса d на симуляции) выходные сигналы q1, q2, q3, q4 сдвинуты относительно сигнала d и каждый сдвинут на разное время. Самое интересное, что ширина импульсов q1, q2, q3 и q4 всегда больше ширины импульса d и все они разные по ширине. Я не знаю, как автор собирается комбинировать такие схемы одну с другой. Если предположить, что выходной сигнал q1 для последующих схем становится сигналом d, то получится, что через цепочку схем сигнал d становится шире и шире — но это уже мои фантазии. Повторюсь, я не очень понимаю как такие схемы будут собираться в бОльшие.

Еще одна мысль не покидает меня.

Мне кажется, что традиционный дешифратор вроде такого, как у меня выше assign qq = 1 << {r2,r1}; займет в чипе гораздо меньше места по числу транзисторов, чем описанная автором асинхронная схема. А число транзисторов в ASIC напрямую влияет на производительность, ведь получается большая площадь чипа занята и более длинные трассы между элементами, большее энергопотребление. Об этом обязательно нужно подумать, как это оценить и как это посчитать.

У меня иногда у самого возникают странные «прорывные» идеи о том, как сделать электронику быстрее или задействовать «иной принцип» работы. Закон Мура уже как-то не очень работает и для увеличения быстродействия электроники требуются новые идеи. В случае с микропроцессорами это может быть некая принципиально иная архитектура (хм… она есть у меня). Или нужны свежие технологии и идеи об устройстве базовых элементов чипов.

Я как-то делал эксперименты по реализации схемы на Double-Edge-Trigger. Идея заключалась в том, чтобы использовать для обычной синхронной логики оба фронта тактовой частоты. Я думал, что использование DET триггера позволит в чипе для той же скорости вычислений иметь рабочую частоту в два раза меньше и значит как минимум снизится энергопотребление. Я просимулировал свой проект и даже запустил его в ПЛИС — он работал. Подробности об этом проекте здесь.

Далее я попытался оценить необходимое число транзисторов и пришел для себя к неутешительным выводам: похоже схема с DET триггерами потребует в чипе транзисторов гораздо больше, чем обычно.

Асинхронная логика, как идея, интересна. Но, к сожалению, требует глубокой проработки. До реального применения еще слишком далеко и неочевидно. И нужно обязательно проверять результат хоть в ПЛИС, хоть в симуляции — это не трудно и не дорого. Похоже ModelSim вполне справляется с симуляцией асинхронных схем.

Симуляция — бесплатна! Пробуйте господа!

|

Метки: author nckma fpga асинхронные схемы modelsim verilog |

Чат-бот своими руками: история одного велосипеда |

Привет, хабр! Сегодня я расскажу о том, как своими руками с нуля собирались мозги для чат-бота, умеющего создавать резюме на основе беседы с человеком. Речь пойдет о том, как развивался написанный для этого дела велосипед, какие трудности встречал на своем пути и как изменялся в целях преодоления этих трудностей. Все описанные события происходили в процессе моего обучения в Школе программистов HeadHunter в 2017 году. Кому интересно — добро пожаловать под кат. Читать дальше ->

|

Метки: author Trympyrym программирование анализ и проектирование систем java блог компании headhunter headhunter development обучение |

Избранное: ссылки по reverse engineering |

Всем привет!

Сегодня мы хотели бы поделиться своим списком материалов по тематике reverse engineering (RE). Перечень этот очень обширный, ведь наш исследовательский отдел в первую очередь занимается задачами RE. На наш взгляд, подборка материалов по теме хороша для старта, при этом она может быть актуальной в течение продолжительного времени.

Данный список ссылок, ресурсов, книг мы уже лет пять рассылаем людям, которые хотели бы попасть в наш исследовательский отдел, но не проходят пока по уровню знаний или только начинают свой путь в сфере информационной безопасности. Естественно, этому перечню, как и большинству материалов/подборок, через некоторая время потребуется обновление и актуализация.

Забавный факт: нам показывали, как некоторые компании рассылают наш список материалов от себя, но только в очень старой редакции. И вот после этой публикации они, наконец, смогут использовать его обновленную версию с чистой совестью ;)

Итак, перейдем к списку материалов!

- Тематики

a. Реверс

b. Поиск уязвимостей (fuzzing)

c. Эксплуатация уязвимостей

d. Анализ вредоносного кода - Инструменты

a. IDA Pro

b. Radare2

c. WinDBG (Ollydbg / Immunity Debugger / x64dbg)

d. GDB

e. DBI

f. SMT

g. Python для автоматизации

h. BAF (Binary Analysis Frameworks) - Архитектуры

a. x86-x86_64

b. ARM - ОС

a. Windows

b. Linux

c. Mac OS(OSX) / iOS

d. Android - Форматы файлов

a. PE

b. ELF

c. Mach-O - Программирование

a. C/C++

b. Assembler - Практика

a. War games

1. Тематики

В данном разделе мы рассмотрим основные направления применения RE. Начнем непосредственно с самого процесса обратной разработки, перейдем к поиску уязвимостей и разработке эксплоитов, и, конечно, доберемся до анализа вредоносных программ.

1.a Reverse engineering

- "Искусство дизассемблирования" от Крис Касперски — не новая, но очень хорошая и до сих пор актуальная книга от Криса с хорошей систематизацией знананий и отличным материалом;

- "Practical Reverse Engineering: x86, x64, ARM, Windows Kernel, Reversing Tools, and Obfuscation" — "новая" книга от нескольких известных специалистов по ИБ, покрывающая некоторые новые моменты и темы, что отсутствуют в книге Криса;

- "Реверсинг для начинающих" от Дениса Юрьевича — полностью бесплатная книга, переведенная уже на множество языков мира. Здесь, наверное, самое примечательное — это наличие интересных заданий после каждой главы, при этом — для нескольких архитектур сразу;

- "Practical RE tips" — отличный webinar на английском языке от Gynvael Coldwind, содержащий много полезных советов и скриптов про RE;

- Ресурс "OPENSECURITYTRAINING.INFO" содержит хорошие обучающие лекции и видеоролики по RE на английском;

- "Digging Through the Firmware" — неплохая серия статей Practical Reverse Engineering — полезные статьи для тех, кто только собирается погрузиться в мир реверсинга прошивок устройств;

- "Training: Security of BIOS/UEFI System Firmware from Attacker and Defender Perspectives" — если вы хотите окунуться в мир firmware security, UEFI BIOS, то вам определенно нужно ознакомиться с данными слайдами, которые ранее были в платном тренинге на ведущих конференциях по безопасности;

- CRYPTO101 — немного введения в криптографию, без которой не обойтись.

1.b Поиск уязвимостей

- "Fuzzing: Brute Force Vulnerability Discovery" — хоть и не новая книга, но в качестве понимания основ фаззинга подходит в самый раз. Есть перевод на русский язык, но содержит довольно смешные ляпы;

- "Автоматический поиск уязвимостей в программах без исходных текстов" — хороший вводный материал на русском языке, представленный на PHDays 2011;

- "The Evolving Art of Fuzzing" — статья про развитие фаззинга;

- "Modern Security Vulnerability Discovery" — компиляция разных техник поиска уязвимостей в одном документе;

- "(State of) The Art of War: Offensive Techniques in Binary Analysis" — all-in-one документ обо всех существующих техниках поиска уязвимостей;

- "The Art of Software Security Assessment: Identifying and Preventing Software Vulnerabilities" — далеко не новая, но до сих пор актуальная книга про разные подходы к поиску уязвимостей.

1.c Примеры эксплуатации найденных уязвимостей

- "Exploit Writing Tutorials by Corelan Team" (перевод) — известная серия постов по написание эксплоитов и шеллкодов, начиная с основ;

- "Exploit Development Community" (перевод частичный) — цикл статей по написанию боевого эксплоита для IE 10 и 11 версий;

- "Modern Binary Exploitation" — материалы от команды RPISEC с учебного курса, который они проводили в Rensselaer Polytechnic Institute;

- "Web-архив блога компании Vupen" — канувший влету блог с примерами эксплуатации сложных уязвимостей в VirualBox, XEN, Firefox, IE10, Windows Kernel, Adobe Flash, Adobe Reader;

- "Project Zero" — блог от исследовательской команды Google, где их специалисты частенько делятся интересными историями по эксплуатации разных крутых уязвимостей;

- "Browser mitigations against memory corruption vulnerabilities" — технологии защиты, используемые в популярных браузерах:

- "SoK: Eternal War in Memory" — отличный документ, в котором показана модель атаки и описаны различные механизмы предотвращения эксплуатации на разных стадиях для различных типов уязвимостей, связанных с повреждением памяти;

- "Writing Exploits for Win32 Systems from Scratch" — подробная статья по написанию эксплоита с нуля для уязвимости в программе SLMAIL;

- Phrack — знаменитый хакерский журнал Phrack. Рекомендуем почитать, в первую очередь, статьи категории "The Art of Exploitation";

- "The Shellcoder's Handbook: Discovering and Exploiting Security Holes" — легендарная книжка, посвященная написанию шеллкодов.

1.d Анализ вредоносных программ

- "Practical Malware Labs" — исходники к книге "Practical Malware Analysis";

- "Malware Analyst's Cookbook and DVD: Tools and Techniques for Fighting Malicious Code" — эту и предыдущую книги мы рекомендуем одним комплектом тем, кто интересуется данной темой;

- "Malware Analysis Tutorials: a Reverse Engineering Approach" (перевод) — довольно длинная серия статей, посвященная настройке окружения с последующим анализом в нем вредоносных программ;

- "Course materials for Malware Analysis by RPISEC" — ещё один курс от RPISEC, только теперь про вредоносные программы;

- "Компьютерные вирусы и антивирусы. Взгляд программиста" — хоть в книге рассматриваются вредоносные программы, начиная с времён DOS, она всё равно будет полезна, поскольку кроме анализа кода таких программ автор показывает примеры написания антивирусов под каждый конкретный случай.

2. Необходимый инструментарий

Ниже представлены популярные инструменты, применяемые при RE.

2.a IDA Pro

- "The IDA Pro Book: The Unofficial Guide to the World's Most Popular Disassembler" — книга, благодаря которой ваше знакомство с IDA Pro пройдет легко и непринужденно :)

- "TiGa's Video Tutorial Series on IDA Pro" — подборка небольших HOW-TO видео по использованию IDA Pro;

- "Open Analysis Live" — в отличие от предыдущей подборки по использованию IDA Pro, эта более новая и обновляемая. В основном, рассматривается анализ вредоносных программ.

2.b Radare2

- "The radare2 book" — основная книга по использованию фреймворка Radare2 для реверса;

- "Radare2 Cheatsheet" — "шпаргалка" по основным командам;

- "Radare Today — the blog of radare2" — блог фреймворка. В нём найдутся не только новости, но и практические примеры.

2.c WinDBG (Ollydbg / Immunity Debugger / x64dbg)

Без знания принципов работы отладчика и умения им пользоваться тоже не обойтись. Ниже мы рассмотрим отладчики для ОС Windows, а в следующем пункте уделим внимание знаменитому GDB. Итак, поехали:

- Advanced Windows Debugging: Developing and Administering Reliable, Robust, and Secure Software — в первую очередь, эта книга пригодится для понимания и "отлова" ошибок типа повреждения кучи;

- "Inside Windows Debugging: A Practical Guide to Debugging and Tracing Strategies in Windows" — это издание хорошо дополнит предыдущую книгу;

- "Введение в крэкинг с нуля, используя OllyDbg" — к сожалению, старейший ресурс wasm.ru закрылся, но подобная подборка легко ищется, поскольку была продублирована на множество ресурсов. К тому же, в сети стали появляться "форки", только в них уже используется x64dbg или IDA.

2.d GDB

- "gdb Debugging Full Example (Tutorial): ncurses" — руководство по применению GDB;

- "GEF — Multi-Architecture GDB Enhanced Features for Exploiters & Reverse-Engineers" — надстройка над GDB на языке Python, добавляет много новых полезных команд, которые пригодятся для разработки эксплоитов;

- "GEF Tutorials" — серия скринкастов по использованию GEF.

2.e DBI

Программируемая отладка — это сегодня неотъемлемый подход в арсенале любого реверсера. И DBI — один из инструментов. Подробнее:

- "Dynamic Binary Instrumentation в ИБ" — в этой статье уже собрана некоторая обобщенная информация про DBI;

- "Light And Dark Side Of Code Instrumentation" — данная презентация поможет вам ориентироваться в разновидностях различных инструментаций кода и в том, что и когда вам может помочь с анализом программ.

2.f SMT

Что такое SMT-решатель? Если кратко, SMT-решатель — это программа, которая может решать логические формулы.

Основная идея применения SMT в области безопасности ПО заключается в том, чтобы перевести программный код или алгоритм в логическую формулу, а затем с помощью SMT-решателя проверить то или иное свойство этого кода.

Другими словами, SMT предоставляет математический аппарат для семантического анализа кода.

SMT-решатели уже довольно давно применяются в нашей сфере. Они неплохо зарекомендовали себя для решения следующих задач:

- поиск багов (статический анализ/фаззинг);

- деобфускация;

- "домашний" криптоанализ;

- символьное исполнение (в качестве "движка");

- также есть определенные успехи в области автоматической генерации эксплойтов (например, генерации ROP).

За это время SMT потеряла ореол таинственности, появились более-менее работающие инструменты для "простых" людей.

Ниже приведены источники, которые помогут погрузиться в тему:

- "SMT Solvers for Software Security, Sean Heelan, Rolf Rolles" — пожалуй, первая научная работа, в которой было предложено применение SMT для решения задач в области безопасности ПО. Дает представление о том, где и как SMT может найти свое место в данной сфере;

- Z3 — один из самых популярных и эффективных SMT-решателей;

- Z3 wiki – репозиторий проекта;

- "Getting Started with Z3: A Guide" — онлайн-учебник, SMT-решатель для экспериментов;

- Z3Py — обвязка на Python для Z3;

- "Theorem prover, symbolic execution and practical reverse-engineering" — хорошая обзорная презентация, с примерами решения реальных задач и применения Z3Py;

- "Quick introduction into SAT/SMT solvers and symbolic execution" (версия на русском) – хорошая книга с интересными практическими примерами.

- "An introduction to the use SMT solvers" — обзорный материал.

2.g Python для автоматизации

Сегодня без знаний основ языка Python будет очень сложно, потому что этот язык программирования считается самым популярном средством для автоматизации различных задач в сфере ИБ (и не только). К тому же, он используется в различных утилитах (к примеру, все указанные выше утилиты позволяют дополнять функционал с помощью этого ЯП):

- "Gray Hat Python" (перевод) — отличная книга, которая расскажет, чем полезен Python в реверсе;

- "The Beginner's Guide to IDAPython" — бесплатная книга о IDAPython;

- "Python Arsenal for Reverse Engineering" — ресурс, посвященный различным утилитами и библиотекам для reverse engineering, использующим Python.

2.h BAF (Binary Analysis Frameworks)

Для немного более продвинутых мы рекомендуем обратить внимание на целые фреймворки, которые в своем составе используют ранее упомянутые механизмы и средства анализа для решения более сложных задач. Итак, вот они:

- "Overview and Usage of Binary Analysis Frameworks" — небольшой обзор BAF;

Несколько интересных фреймворков/инструментов:

3. Архитектуры

Мы рассмотрим только несколько популярных архитектур. В конце статьи в разделе с дополнительными материалами вы найдете информацию по многим другим (MIPS, PowerPC и т.д.).

3.a x86-x86_64

- "Intel 64 and IA-32 Architectures Software Developer Manuals" — раньше такие руководства отправляли на почту, но из-за большого количества материала в них печать стала дорогим удовольствием. Рекомендуется в качестве настольного справочника.

3.b ARM

- Azeria Labs (ARM Assembly Basics & ARM Exploit Development) — сайт со статьями по основам ARM-ассемблера и разработке эксплойтов под эту архитектуру;

- Курс "Introduction to ARM" — двухдневный видеокурс, посвященным ARM-разработке и эксплуатации;

- VisUAL — визуализация работы ARM-команд.

4. ОС

Знание принципов работы популярных Операционных Систем.

4.a Windows

- "Windows Internals" — основополагающая книга для понимая работы ОС Windows.

Следующие пункты хоть и связаны, в основном, с эксплуатацией уязвимостей в этой ОС, но позволяют глубже узнать внутренности Windows:

4.b Linux

- "Linux insides" — аналог книги Windows Internals, но только для ОС типа Linux.

Как и в случае с Windows, следующие темы связаны с разработкой эксплойтов:

4.c Mac OS(OSX) / iOS

- "Reverse Engineering Resources Maс и iOS" — подборка материалов по данной теме.

4.d Android

- "Android Hacker's Handbook" — наверное, самая популярная книга, посвященная безопасности ОС Android;

- "Android Internals::Power User's View" — книга, рассказывающая о внутренних механизмах этой ОС. Из-за недавних утечек материал появился в открытом доступе, о чём пишет сам автор на своём сайте и предоставляет возможность скачать прошлую версию.

5. Форматы исполняемых файлов

В этом разделе представлены ссылки, разъесняющие подробности популярных форматов исполняемых файлов.

5.a PE

- "PE секции"

- "Заголовок PE"

- "[Формат исполняемого файла ОС Windows. PE32 и PE64]"(http://web.archive.org/web/20111024201441/http://wasm.ru:80/article.php?article=green2red02)

- "Компьютерные вирусы изнутри и снаружи".

5.b ELF

5.c Mach-O

Известный исследователь corkami делает очень полезные и интересные "постеры" со схемой различных форматов файлов, в том числе, упомянутых выше. Советуем использовать их как шпаргалку.

6. Программирование

Один наш знакомый как-то сказал, что хороший реверсер это на 80% хороший программист. Умение программировать и понимание того, что и зачем делается, упрощает процесс исследования чужой программы. Поэтому без программирования в реверсе никуда. Ну и конечно автоматизация рутинной задачи, как вы уже наверняка поняли, — очень полезная вещь ;)

6.a C/C++

- Modern Memory Safety: C/C++ Vulnerability Discovery, Exploitation, Hardening — это большой курс с отличными примерами. Просто must have материал для всех.

6.b ASM

- "A Crash Course in x86 Assembly for Reverse Engineers" — "ускоренный курс" для погружения в x86 Ассемблер, позиционирующийся как специальный для RE;

- "Assembly Programming Tutorial" — руководство по программированию на Ассембере, с возможностью запуска примеров в online по ходу изучения;

- "Assembler. 2-е издание" — рекомендуется использовать как справочник;

- "x86 Assembly Guide" — online-версия.

7. Практика

В этой секции представлены ссылки на виртуальные машины и online-ресурсы, позволяющие попрактиковаться.

7.a War Games

- SmashTheStack Wargaming Network — данная сеть с несколькими wargame поддерживается волонтёрами и доступна онлайн. Мы рекомендуем начать с неё;

- BinTut — локальный wargame;

- Reversing Workshop — мастер-класс по решению заданий с ежегодного соревнования "The Flare On Challenge" за 2016 г.;

- Exploit-Challenges — подборка уязвимых ARM бинарных файлов;

- ARM Reverse Engineering Exercises — оригинальный репозиторий "пропал", но был найден один из форков на просторах github;

- CTF Time — тут вы сможете узнать расписание будущих CTF-мероприятий и прочитать решения прошедших.

Ну и напоследок несколько ссылок с большим количеством материалов по вышеуказанным темам:

- Подборка, в целом посвященная сфере ИБ

- Про эксплуатацию уязвимостей

- Про reverse engineering:

- Про эксплуатацию уязвимостей в ОС Windows

- Про фазинг

- Про анализ вредоносных программ

- И ещё много различных "awesome" подборок.

|

Метки: author dukebarman реверс-инжиниринг информационная безопасность блог компании «digital security» reverse engineering ссылки хакинг |

[Перевод] 10 шагов по решению задач в программировании |

Перевод статьи Валинды Чен.

Это сборник советов для разработчиков-новичков, которые смотрят на пустой экран и не знают, с чего начать. Нередко можно услышать от молодых разработчиков, работающих над решением каких-то задач в программировании, что они не уверены, за что нужно хвататься. Ты понимаешь саму задачу, логику, основы синтаксиса и так далее. Если ты видишь чей-то код, или тебе кто-то помогает, то можно всё сделать самому. Но бывает, что ты не уверен в своих силах, или поначалу тебе трудно реализовать свои мысли в коде, несмотря на то, что ты знаешь синтаксис и логику. Под катом — несколько советов по решению этой проблемы, которые помогут вам в повседневной работе.

1. Прочитайте условия задачи как минимум трижды (или хотя бы столько раз, сколько вам будет удобно)

Вы не сможете решить задачу, если не поймёте её. Есть разница между задачей и задачей, которую, как вам кажется, вы решаете. Можно прочитать первые несколько строк, а насчёт остального выстроить предположения, поскольку всё выглядит похожим на то, с чем вы сталкивались раньше. Даже если вы делаете популярную игру наподобие Виселицы, удостоверьтесь, что прочитали все её правила, пусть даже вы играли в неё раньше.

Иногда можно попробовать объяснить задачу другу и посмотреть, поймёт ли он ваше объяснение. Вы же не хотите пройти половину пути и обнаружить, что неправильно поняли требования. Так что лучше потратить в начале больше времени, чтобы всё прояснить. Чем лучше поймёте задачу, тем легче будет её решить.

Допустим, мы создаём простую функцию

selectEvenNumbers, которая берёт массив чисел и возвращает массив evenNumbers с одними лишь чётными числами. Если чётных чисел в исходном массиве нет, то массив evenNumbers возвращается пустым.function selectEvenNumbers() {

// здесь ваш код

}Какие вопросы можно себе задать:

- Как компьютер может сказать, что число является чётным? Разделить на 2 и проверить, чтобы результат получился целым.

- Что я передаю этой функции? Массив.

- Что содержит этот массив? Одно или несколько чисел.

- Какие типы данных у элементов массива? Числа.

- Какова цель этой функции? Что я возвращаю в конце её выполнения? Цель — получить все чётные числа и вернуть их в массиве. Если нет чётных чисел, то массив возвращается пустым.

2. Пройдите по задаче вручную как минимум с тремя наборами данных

Возьмите лист бумаги и пройдите по задаче вручную. Выберите не менее трёх наборов данных для проверки. Выберите предельно допустимые и крайние случаи.

Предельно допустимые случаи: проблема или ситуация, возникающая за пределами нормальных параметров функционирования. Например, когда одновременно несколько переменных или состояний среды имеют экстремальные значения, даже если каждый из параметров находится в своём специфическом диапазоне.

Крайние случаи: проблемы или ситуации, возникающие только при экстремальных (минимальных или максимальных) значениях параметров функционирования.

Вот, к примеру, несколько наборов данных для использования:

[1]

[1, 2]

[1, 2, 3, 4, 5, 6]

[-200.25]

[-800.1, 2000, 3.1, -1000.25, 42, 600]

Когда только начинаешь, то зачастую пренебрегаешь какими-то шагами. Поскольку наш мозг уже знаком с чётными числами, то можно просто посмотреть на набор чисел и сразу передать в массив 2, 4, 6 и так далее, не думая о том, как наш мозг выбирает конкретные числа. Если вы замечаете это за собой, то лучше взять большой набор данных, чтобы помешать мозгу решать задачу, просто глядя на числа. Это поможет придерживаться настоящего алгоритма.

Давайте пройдём по массиву

[1]- 1. Смотрим на единственный элемент массива

[1]. - 2. Определяем, является ли он чётным. Не является.

- 3. Замечаем, что других элементов в массиве нет.

- 4. Определяем, что здесь нет чётных чисел.

- 5. Возвращаем пустой массив.

Теперь пройдём по массиву

[1, 2]- Смотрим на первый элемент массива

[1, 2] - Это

1. - Определяем, является ли он чётным. Не является.

- Смотрим на следующий элемент.

- Это

2. - Определяем, является ли он чётным. Является.

- Создаём массив

evenNumbersи добавляем в него2. - Замечаем, что других элементов в массиве нет.

- Возвращаем массив evenNumbers —

[2].

Можно пройти по задаче ещё несколько раз. Обратите внимание, что количество шагов в алгоритме для

[1] отличается от алгоритма для [1, 2]. Поэтому рекомендуется проходить по нескольким наборам данных. Например, с единственным элементом; смесь целых и нецелых чисел; многоразрядные числа; наборы с отрицательными числами.3. Упрощайте и оптимизируйте свой алгоритм

Поищите подходящие паттерны, может быть, что-то удастся обобщить. Подумайте, можно ли уменьшить количество шагов.

- 1. Создадим функцию

selectEvenNumbers. - 2. Создадим новый пустой массив

evenNumbersдля хранения чётных чисел. - 3. Проходим по каждому элементу массива

[1, 2]. - 4. Находим первый элемент.

- 5. Делим его на 2 и определяем, чётный ли он. Если да, то прибавляем к

evenNumbers. - 6. Находим следующий элемент.

- 7. Повторяем шаг №4.

- 8. Повторяем шаги №5 и №4, пока не кончатся элементы в массиве.

- 9. Возвращаем массив evenNumbers вне зависимости от того, есть ли в нём что-то.

Этот подход напоминает математическую индукцию:

- 1. Доказываем истинность для

n = 1,n = 2, ... - 2. Предполагаем, что будет истинно для

n = k. - 3. Доказываем истинность для

n = k + 1.

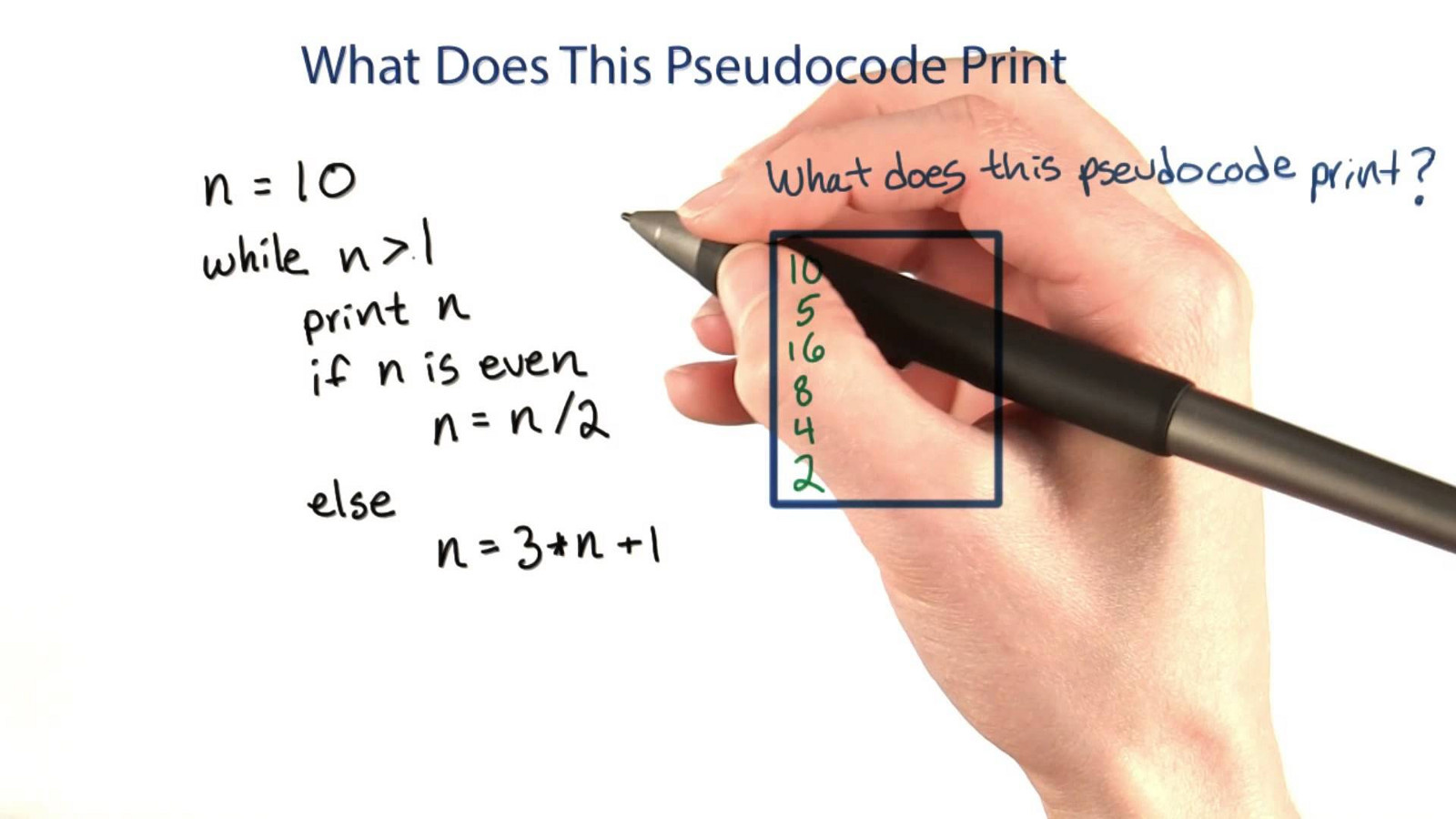

4. Пишите псевдокод

После проработки основных шагов напишите псевдокод, который можно перевести в настоящий код. Это поможет определить структуру кода, да и вообще облегчит его написание. Пишите псевдокод построчно. Это можно делать на бумаге или в виде комментариев в редакторе. Если вы только начинаете и считаете, что пустой экран выглядит жутковато или отвлекает, то лучше писать на бумаге.

В целом не существует правил для написания псевдокода, но можно включать синтаксис из вашего языка, если так будет удобнее. Но сосредотачивайтесь не на синтаксисе, а на логике и этапах алгоритма.

Применительно к нашему случаю есть много разных вариантов. Например, можно использовать

filter, но ради простоты примера воспользуемся простым циклом for (однако при последующем рефакторинге мы ещё столкнёмся с filter).Вот пример псевдокода, в основном состоящего из слов:

function selectEvenNumbers

создаём массив evenNumbers и делаем его эквивалентным пустому массиву

для каждого элемента в этом массиве

смотрим, является ли элемент чётным

если чётный (при делении на 2 результат получается нецелым)

добавляем его к массиву evenNumbers

return evenNumbersА вот псевдокод, в котором слов гораздо меньше:

function selectEvenNumbers

evenNumbers = []

for i = 0 to i = length of evenNumbers

if (element % 2 === 0)

добавляем его к массиву evenNumbers

return evenNumbersГлавное, писать код построчно и понимать логику каждой строки.

Вернитесь к задаче, чтобы удостовериться, что вы на правильном пути.

5. Преобразуйте псевдокод в нормальный код и отладьте его

Когда ваш псевдокод будет готов, преобразуйте каждую строку в реальный код на вашем языке. Здесь мы воспользуемся JavaScript.

Если вы писали на бумаге, то перенесите всё в редактор в виде комментариев, а затем замените каждую строку.

Теперь вызовите функцию и дайте ей некоторые из ранее использованных наборов данных. Так можно проверить, возвращает ли код нужный результат. Также можете написать тесты для проверки соответствия выходных данных ожидаемому результату.

selectEvenNumbers([1])

selectEvenNumbers([1, 2])

selectEvenNumbers([1, 2, 3, 4, 5, 6])

selectEvenNumbers([-200.25])

selectEvenNumbers([-800.1, 2000, 3.1, -1000.25, 42, 600])После каждой переменной или строки можно использовать

console.log(). Это поможет проверить, ведут ли себя значения и код так, как ожидается, прежде чем двигаться дальше. Таким образом вы выловите любые проблемы, не зайдя слишком далеко. Вот пример того, какие значения можно проверить при начале работы.function selectEvenNumbers(arrayofNumbers) {

let evenNumbers = []

console.log(evenNumbers) // Удаляем после проверки выходных данных

console.log(arrayofNumbers) // Удаляем после проверки выходных данных

}Ниже приведён код, полученный после обработки каждой строки псевдокода. Символы

// обозначают строки из псевдокода. Жирным выделен реальный код на JavaScript.// function selectEvenNumbers

function selectEvenNumbers(arrayofNumbers) {

// evenNumbers = []

let evenNumbers = []

// for i = 0 to i = length of evenNumbers

for (var i = 0; i < arrayofNumbers.length; i++) {

// if (element % 2 === 0)

if (arrayofNumbers[i] % 2 === 0) {

// добавляем его к массиву evenNumbers

evenNumbers.push(arrayofNumbers[i])

}

}

// return evenNumbers

return evenNumbers

}Уберём псевдокод, чтобы не путаться.

function selectEvenNumbers(arrayofNumbers) {

let evenNumbers = []

for (var i = 0; i < arrayofNumbers.length; i++) {

if (arrayofNumbers[i] % 2 === 0) {

evenNumbers.push(arrayofNumbers[i])

}

}

return evenNumbers

}Иногда разработчики-новички настолько увлекаются синтаксисом, что им трудно идти дальше. Помните, что со временем вам будет проще соблюдать синтаксис, и нет ничего стыдного в том, чтобы потом при написании кода обращаться к справочным материалам для корректного соблюдения синтаксиса.

6. Упрощайте и оптимизируйте код

Возможно, вы заметили, что упрощение и оптимизация — это повторяющиеся темы.

«Простота — предпосылка надёжности».

Эдсгер Дейкстра, нидерландский учёный и один из первопроходцев в ряде областей информатики

В нашем примере одним из путей оптимизации будет фильтрация элементов в массиве посредством возвращения нового массива с помощью

filter. В этом случае нам не нужно определять переменную evenNumbers, потому что filter вернёт новый массив с копиями элементов, которые соответствуют фильтру. При этом исходный массив не изменится. Также нам не нужно использовать цикл for. filter пройдёт по каждому элементу, и если вернёт true, то элемент попадёт в массив, а если false, то будет пропущен.function selectEvenNumbers(arrayofNumbers) {

let evenNumbers = arrayofNumbers.filter(n => n % 2 === 0)

return evenNumbers

}Может потребоваться несколько итераций упрощения и оптимизации кода, по мере того как вы будете находить новые способы.

Задавайте себе такие вопросы:

- Каковы цели упрощения и оптимизации? Цели зависят от принятого в вашей команде стиля или ваших личных предпочтений. Вы пытаетесь максимально уплотнить код? Или вы хотите сделать его более читабельным? В таком случае вы можете добавить отдельные строки с определением переменной или вычислением чего-либо, а не пытаться всё сделать в одной строке.

- Как ещё можно сделать код более читабельным?

- Можно ли ещё уменьшить количество шагов?

- Есть ли переменные или функции, которые не нужны или не используются?

- Какие-то шаги повторяются? Посмотрите, можно ли определить в другой функции.

- Существуют ли более эффективные способы обработки крайних случаев?

«Программы должны быть написаны так, чтобы люди их читали, и лишь во вторую очередь — чтобы машины их исполняли».

Джеральд Сассман и Гарольд Абельсон, авторы “Structure and Interpretation of Computer Programs”

7. Отлаживайте

Этот шаг необходимо выполнять в ходе всего процесса. Сквозная отладка поможет раньше выловить любые ошибки синтаксиса или недостатки логики. Воспользуйтесь преимуществами своего IDE (Integrated Development Environment) и отладчика. При обнаружении бага рекомендуется просматривать код построчно, стараясь найти неожиданные вещи. Несколько советов:

- Читайте, что пишется в сообщения об ошибках в консоли. Иногда в них указываются номера строк для проверки. Это даст вам исходную точку для поисков, хотя иногда проблемы могут скрываться в других строках.

- Комментируйте блоки кода или строки, а также выходные данные, чтобы быстро подмечать поведение кода. При необходимости код можно всегда раскомментировать.

- Используйте другие образцы данных, если возникают непредусмотренные сценарии.

- Сохраняйте разные версии файла, если применяете другие подходы. Не стоит терять наработанное, если захочется откатиться к прежнему решению!

«Самый эффективный инструмент отладки — тщательное продумывание в сочетании с разумно размещёнными командами вывода на экран».

Брайан Керниган, профессор информатики в Принстонском университете

8. Пишите полезные комментарии

Через месяц вы можете и не вспомнить, что означает каждая строка кода. А тот, кто будет работать с вашим кодом, вообще этого не знает. Поэтому важно писать полезные комментарии, чтобы избежать проблем и сэкономить впоследствии время, когда придётся снова вернуться к этому коду.

Избегайте таких комментариев:

// Это массив. Итерируем его.// Это переменная.Старайтесь писать короткие, высокоуровневые комментарии, которые помогут понять, что тут происходит, если это не очевидно. Это пригодится при решении сложных задач, вы сможете быстро понять, что делает конкретная функция, и почему. Благодаря использованию понятных комментариев и имён переменных и функций вы (и другие люди) сможете понять:

- Для чего этот код?

- Что он делает?

9. Получайте отзывы посредством ревизии кода

Получайте отзывы от коллег, руководителей и других разработчиков. Читайте Stack Overflow. Смотрите, как другие решали аналогичные задачи и учитесь у них. Нередко бывает несколько способов решения задачи. Узнайте, что они собой представляют, и вам будет быстрее и проще приходить к ним самостоятельно.

«Неважно, насколько медленно вы пишете чистый код, вы всегда будете тратить больше времени, если пишете грязный код».

Дядя Боб Мартин, программный инженер и соавтор манифеста Agile

10. Практикуйтесь, практикуйтесь, практикуйтесь

Даже опытные разработчики постоянно практикуются и учатся. Если вы получили полезный отклик, внедрите его. Снова решите задачу, или аналогичные задачи. Заставляйте себя. С каждой решённой задачей вы становитесь лучше как разработчик. Радуйтесь каждому успеху и не забывайте, как много вы уже прошли. Помните, что программирование, как и любая деятельность, со временем будет даваться всё проще и легче.

«Гордитесь тем, сколько вы прошли. Верьте в то, что пройдёте ещё больше. Но не забывайте наслаждаться путешествием».

Майкл Джозефсон, основатель Института этики Джозефа и Эдны Джозефсон

|

Метки: author NIX_Solutions функциональное программирование программирование анализ и проектирование систем блог компании nix solutions советы новичкам |

[Из песочницы] Подробное руководство по созданию и развертыванию чата на Tornado + Telegram |

Рис.1 UML диаграмма последовательностей

Реализация

При реализации было принято решение периодически опрашивать сервер Telegram, чтобы упростить развертывание и облегчить понимание материала, как альтернатива можно использовать WebHook.

Подготовка виртуального окружения

Если у вас не стоит virtualenv, то необходимо его установить:

pip install virtualenvСоздадим виртуальное окружение:

virtualenv --no-site-packages -p python3.4 chatАктивируем его:

source chat/bin/activateУстановим все необходимые библиотеки для работы нашего чата:

pip install tornado==4.4.2 psycopg2==2.7.3 pyTelegramBotAPI==2.2.3Для опроса сервера будем использовать библиотеку для работы с telegram.

Необходимо создать следующую файловую структуру:

Создание бота

Пришло время создать бота, данная реализация рассчитана на несколько ботов, чтобы обеспечить возможность общаться параллельно с несколькими клиентами.

Чтобы зарегистрировать бота, необходимо написать BotFather /newbot и все дальнейшие инструкции вы получите в диалоге с ним. В итоге, после успешной регистрации BotFather вернет вам токен вашего нового бота.

Теперь необходимо получить свой chat_id, чтобы бот знал, кому отправлять сообщения.

Для этого в приложении telegram находим своего бота, начинаем с ним взаимодействие командой /start, пишем ему какое-то сообщение и переходим по ссылке —

https://api.telegram.org/bot<токен_вашего_бота>/getUpdatesВидим примерно следующий ответ —

{"id":555455667,"first_name":"Иван","last_name":"Иванович","username":"kamrus","language_code":"ru-RU"}

id и есть ваш chat_idНастройка postgres

Чтобы обеспечить гибкость в работе чата и возможность его модернизации, необходимо использовать базу данных, я выбрал postgres.

Переключаемся на пользователя postgres:

sudo su - postgresВходим в CLI postgres:

psqlНеобходимо создать новую базу данных в кодировке Unicode;

CREATE DATABASE habr_chat ENCODING 'UNICODE';Создадим нового пользователя в БД:

CREATE USER habr_user WITH PASSWORD '12345';И отдадим ему все привилегии на базу:

GRANT ALL PRIVILEGES ON DATABASE habr_chat TO habr_user;Подключаемся к только что созданной базе:

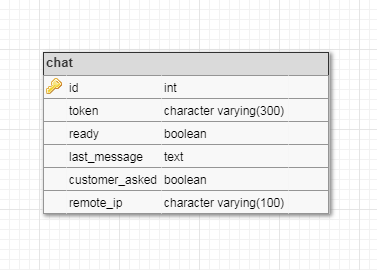

\c habr_chatСоздадим таблицу для хранения информации ботах, она будет иметь следующую модель:

Рис.2 Физическая модель таблицы chat

CREATE TABLE chat (

id SERIAL NOT NULL PRIMARY KEY,

token character varying(300) NOT NULL UNIQUE,

ready BOOLEAN NOT NULL DEFAULT True,

last_message TEXT,

customer_asked BOOLEAN NOT NULL DEFAULT False,

remote_ip character varying(100)

)И так же дадим пользователю все привилегии на таблицу:

GRANT ALL PRIVILEGES ON TABLE chat TO habr_user; Теперь необходимо добавить в нее токены ботов:

INSERT INTO chat (token) VALUES ('your_bot_token');Выходим из CLI:

\qи меняем пользователя обратно:

exitНаписание кода

Первым делом вынесем настройки для работы чата в отдельный файл.

bot_settings.py

CHAT_ID = Вставить ваш chat_id

db = {

'db_name': 'habr_chat',

'user': 'habr_user',

'password': '12345',

'host': '',

'port': ''

}

Основные функции будут находиться в файле core.py

from telebot import apihelper

from bot_settings import db

import psycopg2

import datetime

def get_updates(token, conn, cur, offset=None, limit=None, timeout=20):

''' Возвращает сообщение из телеграма '''

json_updates = apihelper.get_updates(token, offset, limit, timeout)

try:

answer = json_updates[-1]['message']['text']

except IndexError:

answer = ''

# если не проверять приходило ли сообщение от пользователя, то

# функция будет просто возвращать последнее сообщение от менеджера,

# которое в свою очередь могло предназначаться предыдущему клиенту

if is_customer_asked(conn, cur, token):

# необходимо проверять предыдущее сообщение, так как запрос к серверу

# повторяется через константное время и клиенту будет отправляться одно и тоже сообщение

if not is_last_message(conn, cur, token, answer):

# если сообщение прошло обе проверки то обновить это сообщение

# в базе данных

update_last_message(conn, cur, token, answer)

return answer

else:

# если пользователь еще ничего не спросил, то необходимо все равно обновить

# предыдущее сообщение менеджера, на случай если предыдущии пользовватель отключится,

# но менеджер все равно отправит сообщение

update_last_message(conn, cur, token, answer)

def send_message(token, chat_id, text):

'''Отправить сообщение менеджеру в телеграм'''

apihelper.send_message(token, chat_id, text)

def connect_postgres(**kwargs):

try:

conn = psycopg2.connect(dbname=db['db_name'],

user=db['user'],

password=db['password'],

host=db['host'],

port=db['port'])

except Exception as e:

print(e, 'Ошибка при подключении к posqgres')

raise e

cur = conn.cursor()

return conn, cur

def update_last_message(conn, cur, token, message, **kwargs):

''' Обновляет последнее сообщение, присланное менеджером '''

query = "UPDATE chat SET last_message = %s WHERE token = %s"

data = [message, token]

try:

cur.execute(query, data)

conn.commit()

except Exception as e:

print(e, 'Ошибка при попытке обновить последнее сообщение на %s' %message)

raise e

def add_remote_ip(conn, cur, token, ip):

''' Функция добавляет ip адрес пользователя '''

query = "UPDATE chat SET remote_ip = %s WHERE token = %s"

data = [ip, token]

try:

cur.execute(query, data)

conn.commit()

except Exception as e:

print(e, 'Ошибка при попытке добавить ip адрес')

raise e

def delete_remote_ip(conn, cur, token):

''' Удалить ip адрес у бота по переданному токену '''

query = "UPDATE chat SET remote_ip = %s WHERE token = %s"

data = ['', token]

try:

cur.execute(query, data)

conn.commit()

except Exception as e:

print(e, 'Ошибка при попытке удалить ip адрес')

raise e

def is_last_message(conn, cur, token, message, **kwargs):

''' Проверить является ли переданное сообщение последним сообщением менеджера '''

query = "SELECT last_message FROM chat WHERE token = %s"

data = [token, ]

try:

cur.execute(query, data)

last_message = cur.fetchone()

if last_message:

if last_message[0] == message:

return True

return False

except Exception as e:

print(e, 'Ошибка при определении последнего сообщения')

raise e

def update_customer_asked(conn, cur, token, to_value):

''' Обновить статус ответа клиента '''

query = "UPDATE chat SET customer_asked = %s WHERE token = %s"

# to_value = True/False

data = [to_value, token]

try:

cur.execute(query, data)

conn.commit()

except Exception as e:

print(e, 'Ошибка при попытке обновить "customer_asked" на %s' %to_value)

raise e

def is_customer_asked(conn, cur, token):

''' Если клиент уже написал сообщение, то функция вернет True '''

query = "SELECT customer_asked FROM chat WHERE token = %s"

data = [token, ]

try:

cur.execute(query, data)

customer_asked = cur.fetchone()

return customer_asked[0]

except Exception as e:

print(e, "Ошибка при попытке узнать написал ли пользователь сообщение или еще нет")

raise e

def get_bot(conn, cur):

'''

Функция берет из базы свободного бота, у которого ready = True.

Возвращает (id, token, ready, last_message, customer_asked) для свободного бота

'''

query = "SELECT * FROM chat WHERE ready = True"

try:

cur.execute(query)

bot = cur.fetchone()

if bot:

return bot

else:

return None

except Exception as e:

print(e, "Ошибка при попытке найти свободного бота")

raise e

def make_bot_busy(conn, cur, token):

''' Меняет значение ready на False, тем самым делая бота занятым '''

query = "UPDATE chat SET ready = False WHERE token = %s"

data = [token,]

try:

cur.execute(query, data)

conn.commit()

except Exception as e:

print(e, 'Ошибка при попытке изменить значение "ready" на False')

raise e

def make_bot_free(conn, cur, token):

''' Меняет значение ready на False, тем самым делая бота свободным '''

update_customer_asked(conn, cur, token, False)

delete_remote_ip(conn, cur, token)

query = "UPDATE chat SET ready = True WHERE token = %s"

data = [token,]

try:

cur.execute(query, data)

conn.commit()

except Exception as e:

print(e, 'Ошибка при попытке изменить значение "ready" на True')

raise etornadino.py

import tornado.ioloop

import tornado.web

import tornado.websocket

import core

from bot_settings import CHAT_ID

import datetime

class WSHandler(tornado.websocket.WebSocketHandler):

def __init__(self, application, request, **kwargs):

super(WSHandler, self).__init__(application, request, **kwargs)

# При создании нового подключения с пользователем подключимся к postgres

self.conn, self.cur = core.connect_postgres()

self.get_bot(self.conn, self.cur, request.remote_ip)

def get_bot(self, conn, cur, ip):

while True:

bot = core.get_bot(conn, cur)

if bot:

self.bot_token = bot[1]

self.customer_asked = bot[4]

# занять бота

core.make_bot_busy(self.conn, self.cur, self.bot_token)

# добавить боту ip адрес

core.add_remote_ip(self.conn, self.cur, self.bot_token, ip)

break

def check_origin(self, origin):

''' Дает возможность подключаться с различных адресов '''

return True

def bot_callback(self):

''' Функция вызывается PeriodicCallback и проверяет сервер Telegram на

наличие новых сообщений от менеджера

'''

ans_telegram = core.get_updates(self.bot_token, self.conn, self.cur)

if ans_telegram:

# если пришло сообщение от менеджера, то отправить его в браузер клиенту

self.write_message(ans_telegram)

def open(self):

''' Функция вызываемая при открытии сокета с клиентом '''

# Запускает опрос сервера Telegram каждые 3сек

self.telegram_loop = tornado.ioloop.PeriodicCallback(self.bot_callback, 3000)

self.telegram_loop.start()

def on_message(self, message):

''' Функция вызываемая, когда по сокету приходит сообщение '''

if not self.customer_asked:

self.customer_asked = True

# обновить значение в бд, что клиент задал вопрос

core.update_customer_asked(self.conn, self.cur, self.bot_token, True)

core.send_message(self.bot_token, CHAT_ID, message)

def on_close(self):

''' Функция вызываемая при закрытии соединения '''

core.send_message(self.bot_token, CHAT_ID, "Пользователь закрыл чат")

# остановить PeriodicCallback

self.telegram_loop.stop()

# освободить бота

core.make_bot_free(self.conn, self.cur, self.bot_token)

# WebSocket будет доступен по адресу ws://127.0.0.1:8080/ws

application = tornado.web.Application([

(r'/ws', WSHandler),

])

if __name__ == "__main__":

application.listen(8080)

tornado.ioloop.IOLoop.current().start()

Теперь создадим статические файл:

chat.html

chat.css

.chatbox {

position: fixed;

bottom: 0;

right: 30px;

height: 400px;

background-color: #fff;

font-family: Arial, sans-serif;

-webkit-transition: all 600ms cubic-bezier(0.19, 1, 0.22, 1);

transition: all 600ms cubic-bezier(0.19, 1, 0.22, 1);

display: -webkit-flex;

display: flex;

-webkit-flex-direction: column;

flex-direction: column;

}

.chatbox-down {

bottom: -350px;

}

.chatbox--closed {

bottom: -400px;

}

.chatbox .form-control:focus {

border-color: #1f2836;

}

.chatbox__title,

.chatbox__body {

border-bottom: none;

}

.chatbox__title {

min-height: 50px;

padding-right: 10px;

background-color: #1f2836;

border-top-left-radius: 4px;

border-top-right-radius: 4px;

cursor: pointer;

display: -webkit-flex;

display: flex;

-webkit-align-items: center;

align-items: center;

}

.chatbox__title h5 {

height: 50px;

margin: 0 0 0 15px;

line-height: 50px;

position: relative;

padding-left: 20px;

-webkit-flex-grow: 1;

flex-grow: 1;

}

.chatbox__title h5 a {

color: #fff;

max-width: 195px;

display: inline-block;

text-decoration: none;

white-space: nowrap;

overflow: hidden;

text-overflow: ellipsis;

}

.chatbox__title h5:before {

content: '';

display: block;

position: absolute;

top: 50%;

left: 0;

width: 12px;

height: 12px;

background: #4CAF50;

border-radius: 6px;

-webkit-transform: translateY(-50%);

transform: translateY(-50%);

}

.chatbox__title__tray,

.chatbox__title__close {

width: 24px;

height: 24px;

outline: 0;

border: none;

background-color: transparent;

opacity: 0.5;

cursor: pointer;

-webkit-transition: opacity 200ms;

transition: opacity 200ms;

}

.chatbox__title__tray:hover,

.chatbox__title__close:hover {

opacity: 1;

}

.chatbox__title__tray span {

width: 12px;

height: 12px;

display: inline-block;

border-bottom: 2px solid #fff

}

.chatbox__title__close svg {

vertical-align: middle;

stroke-linecap: round;

stroke-linejoin: round;

stroke-width: 1.2px;

}

.chatbox__body,

.chatbox__credentials {

padding: 15px;

border-top: 0;

background-color: #f5f5f5;

border-left: 1px solid #ddd;

border-right: 1px solid #ddd;

-webkit-flex-grow: 1;

flex-grow: 1;

}

.chatbox__credentials {

display: none;

}

.chatbox__credentials .form-control {

-webkit-box-shadow: none;

box-shadow: none;

}

.chatbox__body {

overflow-y: auto;

}

.chatbox__body__message {

position: relative;

}

.chatbox__body__message p {

padding: 15px;

border-radius: 4px;

font-size: 14px;

background-color: #fff;

-webkit-box-shadow: 1px 1px rgba(100, 100, 100, 0.1);

box-shadow: 1px 1px rgba(100, 100, 100, 0.1);

}

.chatbox__body__message img {

width: 40px;

height: 40px;

border-radius: 4px;

border: 2px solid #fcfcfc;

position: absolute;

top: 15px;

}

.chatbox__body__message--left p {

margin-left: 15px;

padding-left: 30px;

text-align: left;

}

.chatbox__body__message--left img {

left: -5px;

}

.chatbox__body__message--right p {

margin-right: 15px;

padding-right: 30px;

text-align: right;

}

.chatbox__body__message--right img {

right: -5px;

}

.chatbox__message {

padding: 15px;

min-height: 50px;

outline: 0;

resize: none;

border: none;

font-size: 12px;

border: 1px solid #ddd;

border-bottom: none;

background-color: #fefefe;

width: 100%;

}

.chatbox--empty {

height: 262px;

}

.chatbox--empty.chatbox-down {

bottom: -212px;

}

.chatbox--empty.chatbox--closed {

bottom: -262px;

}

.chatbox--empty .chatbox__body,

.chatbox--empty .chatbox__message {

display: none;

}

.chatbox--empty .chatbox__credentials {

display: block;

}

.description {

font-family: Arial, sans-serif;

font-size: 12px;

}

#start-ws {

margin-top: 30px;

}

.no-visible {

display: none;

}Перед написанием javascript файла необходимо определиться, как будет выглядеть код для сообщении от клиента и от менеджера.

Html код для сообщении от клиента:

Html код для сообщении от менеджера:

chat.js

(function($) {

$(document).ready(function() {

var $chatbox = $('.chatbox'),

$chatboxTitle = $('.chatbox__title'),

$chatboxTitleClose = $('.chatbox__title__close'),

$chatboxWs = $('#start-ws');

// Свернуть чат при нажатии на заголовок и наоборот

$chatboxTitle.on('click', function() {

$chatbox.toggleClass('chatbox-down');

});

// Закрыть чат

$chatboxTitleClose.on('click', function(e) {

e.stopPropagation();

$chatbox.addClass('chatbox--closed');

// Если на момент закрытия был открыт сокет, то

// следует закрыть его

if (window.sock) {

window.sock.close();

}

});

// Подключиться к сокету

$chatboxWs.on('click', function(e) {

e.preventDefault();

// сделать диалог видимым

$chatbox.removeClass('chatbox--empty');

// сделать кнопку начала чата невидимой

$chatboxWs.addClass('no-visible');

if (!("WebSocket" in window)) {

alert("Ваш браузер не поддерживает web sockets");

}

else {

alert("Начало соединения");

setup();

}

});

});

})(jQuery);

// Функция создания соединения по WebSocket

function setup(){

var host = "ws://62.109.2.175:8084/ws";

var socket = new WebSocket(host);

window.sock = socket;

var $txt = $("#message");

var $btnSend = $("#sendmessage");

// Отслеживать изменения в textarea

$txt.focus();

$btnSend.on('click',function(){

var text = $txt.val();

if(text == ""){return}

// отправить сообщение по сокету

socket.send(text);

// отобразить в дилоге сообщение

clientRequest(text);

$txt.val("");

// $('#send')

});

// отслеживать нажатие enter

$txt.keypress(function(evt){

// если был нажат enter

if(evt.which == 13){

$btnSend.click();

}

});

if(socket){

// действие на момент открытия сокета

socket.onopen = function(){

}

// действие на момент получения сообщения по сокету

socket.onmessage = function(msg){

// отобразить сообщение в диалоге

managerResponse(msg.data);

}

// действия на момент закрытия сокета

socket.onclose = function(){

webSocketClose("The connection has been closed.");

window.sock = false;

}

}else{

console.log("invalid socket");

}

}

function webSocketClose(txt){

var p = document.createElement('p');

p.innerHTML = txt;

document.getElementById('messages__box').appendChild(p);

}

//функция для ответов клиента

function clientRequest(txt) {

$("#messages__box").append("

" + txt + "

");

}

// Функция для ответов менеджера

function managerResponse(txt) {

$("#messages__box").append("

" + txt + "

");

}

Развертывание на centos7

Для начала необходимо настроить виртуальное окружение для нашего приложения, собственно, повторить то, что мы уже делали на локальной машине в пункте реализация.

После того, как мы настроили окружение, нужно перенести туда наш проект, проще всего это сделать, используя git, предварительно необходимо загрузить код в свой репозиторий и оттуда уже клонировать его на сервер.

Настраиваем postgres

Если у вас на сервере не установлен postgres, то установить его можно так:

sudo yum install postgresql-server postgresql-devel postgresql-contrib Запускаем postgres:

sudo postgresql-setup initdbsudo systemctl start postgresqlДобавляем автозапуск:

sudo systemctl enable postgresqlПосле чего необходимо перейти в psql под пользователем postgres и повторить все, что мы делали на локальной машине.

Будем запускать наше tornado приложение с помощью supervisor в фоне.

Для начала установим supervisor:

sudo yum install supervisorТеперь откроем конфигурационный файл супервизора, который будет находится в /etc/supervisor.conf

[unix_http_server]

file=/path/to/supervisor.sock ; (the path to the socket file)

[supervisord]

logfile=/var/log/supervisor/supervisord.log ; (main log file;default $CWD/supervisord.log)

logfile_maxbytes=50MB ; (max main logfile bytes b4 rotation;default 50MB)

logfile_backups=10 ; (num of main logfile rotation backups;default 10)

loglevel=error ; (log level;default info; others: debug,warn,trace)

pidfile=/path/to/supervisord.pid ; (supervisord pidfile;default supervisord.pid)

nodaemon=false ; (start in foreground if true;default false)

minfds=1024 ; (min. avail startup file descriptors;default 1024)

minprocs=200 ; (min. avail process descriptors;default 200)

user=root

childlogdir=/var/log/supervisord/ ; ('AUTO' child log dir, default $TEMP)

[rpcinterface:supervisor]

supervisor.rpcinterface_factory = supervisor.rpcinterface:make_main_rpcinterface

[supervisorctl]

serverurl=unix:///path/to/supervisor.sock ; use a unix:// URL for a unix socket

[program:tornado-8004]

environment=PATH="/path/to/chat/bin"

command=/path/to/chat/bin/python3.4 /path/to/tornadino.py --port=8084

stopsignal=KILL

stderr_logfile=/var/log/supervisord/tornado-stderr.log

stdout_logfile=/var/log/supervisord/tornado-stdout.log

[include]

files = supervisord.d/*.iniНе забудьте поменять пути в конфигурационном файле!

Перед тем, как запускать supervisor, необходимо создать папку /var/log/supervisord/ в ней будут собираться логи торнадо, так что, если supervisor запустил tornado-8004, но чат не работает, то ошибку стоит искать там.

Запускаем супервизор:

sudo supervisorctl start tornado-8004Проверяем, что все в порядке:

sudo supervisorctl statusДолжны получить что-то подобное:

tornado-8004 RUNNING pid 32139, uptime 0:08:10На локальной машине вносим изменения в chat.js:

var host = "ws://адресс_вашего_сервера:8084/ws";и открываем в браузере chat.html.

Готово!

Можно без особых телодвижений прикручивать такой чат к своим проектам, так же достаточно удобно использовать для сбора feedback.

|

Метки: author Kamrus python tornado telegram websocket supervisor |

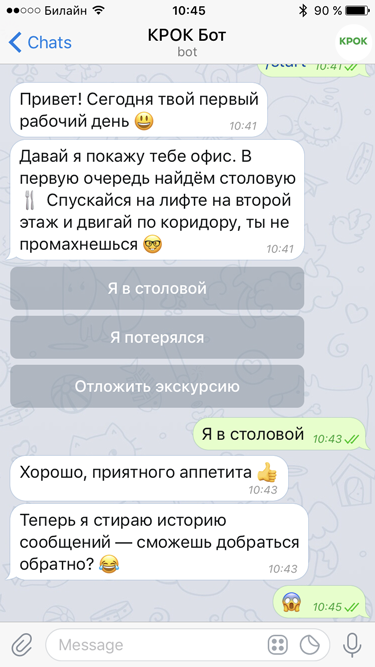

Что может чат-бот |

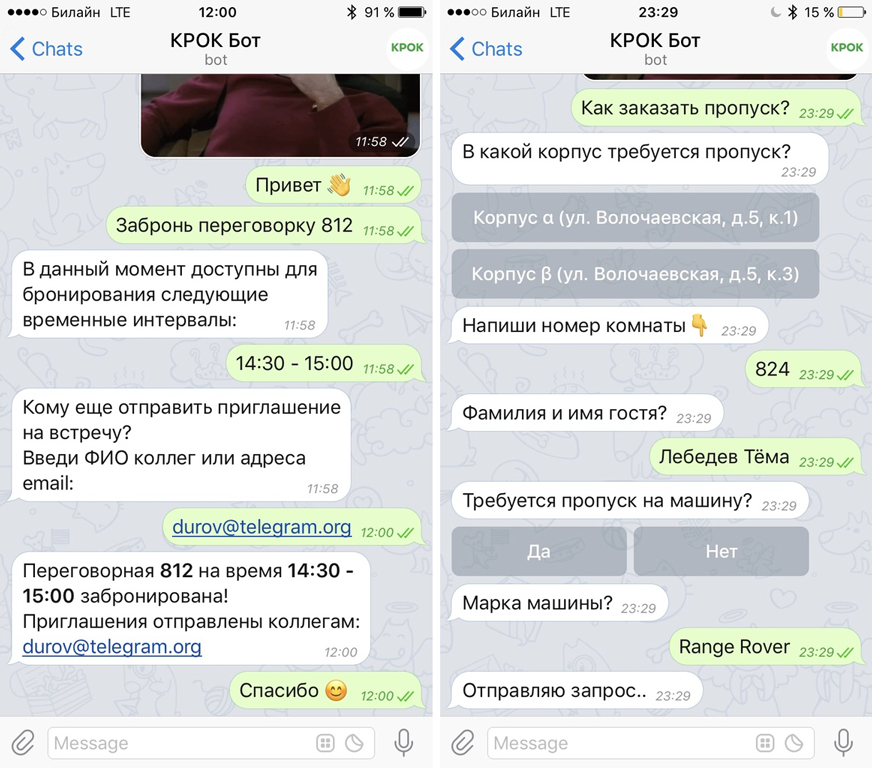

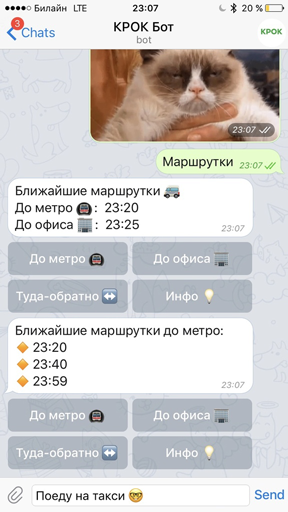

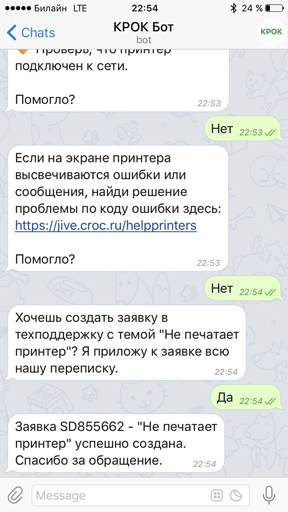

Или если нужна справка для визы, то бот постучит в шину, шина постучит в кадровую подсистему и заберёт PDF, дальше отправит его на принтер отдела кадров и напишет письмо, что туда нужна печать. Затем уведомит самого сотрудника, что можно подойти через пару часов. Если нужно оформить пропуск на гостя или забронировать переговорку для встречи, то достаточно поручить боту эту задачу, и он выполнит её.

Теперь давайте покажу пример чуть посложнее.

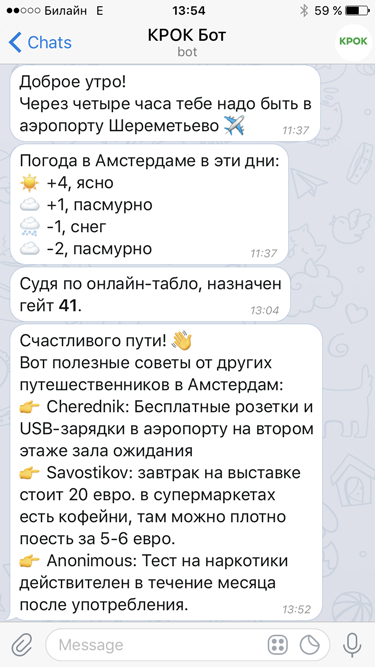

Через 3 недели:

В нашем диалоге про командировку используется типовой бизнес-процесс. Сотрудник (его Ф. И. О. есть в данных аутентификации) указывает город командировки и даты. Бот пишет тикет в бухгалтерию и письмо специалисту, отвечающему за покупку билетов и бронирование в поездках. Когда тикет закрыт, бот получает его результат и дальше обрабатывает по скрипту. Специалиста бот обрабатывает письмами или сообщениями в Телеграм, пока тот не выдаст документы с билетами и бронью. Затем он ищет пользователя по хотспоту Wi-Fi в офисе, чтобы определить ближайший доступный принтер. Отправляет документы на печать. В день вылета напоминает о поездке, забирает погоду с одного из внешних сайтов по его открытому API, затем начинает опрашивать онлайн-табло аэропорта на предмет расписания по рейсу (сам рейс есть в билетах). После поездки он попросит отчёт по средствам для бухгалтерии (пришлёт форму и расскажет, как его заполнить), плюс попросит полезные советы для базы знаний. Вдобавок он может заказать такси в аэропорт, заказать машину на месте и подобрать данные о поездках, чтобы внести суммы сразу в авансовый отчёт.