Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

[Перевод] Охота на вредоносные npm-пакеты |

|

Метки: author ru_vds node.js javascript блог компании ruvds.com npm безопасность |

DLP и Закон: как правильно оформить внедрение системы для защиты от утечек |

Сегодня хотелось бы еще раз поднять такую важную тему, как легитимность внедрения систем для защиты от утечек информации. Прекрасно, когда компания задумывается о сохранности своих информационных активов и внедряет DLP-решение. Но если этому внедрению не сопутствует юридическое оформление, часть функций DLP просто «отваливается». Компания не сможет использовать данные DLP в суде против сотрудника, виновного в разглашении конфиденциальной информации (а может и пострадать от иска самого сотрудника, например). Сегодняшний небольшой материал рассказывает, как этого избежать и где «подстелить солому».

В соответствии с ТК РФ, 98-ФЗ, 152-ФЗ и пр., функционирование DLP в организации включает несколько аспектов, требующих юридического оформления. Сразу оговоримся, что список документов, который мы даем ниже, несколько избыточен. Если каких-то регламентов у вас нет, это может быть не смертельно. Но у нас за годы работы в этой сфере сложилось мнение, что сопроводительных документов много не бывает, особенно если компании предстоит судиться с сотрудником, «слившим» конфиденциальные данные.

Еще один важны момент – большинство регламентов и положений требует подписи сотрудника, который либо выступает в качестве одной из сторон соглашения, либо подтверждает ознакомление с содержанием документа. Поэтому к работе над юридическим оформлением внедрения DLP необходимо привлекать HR-отдел и, естественно, юристов.

Информация ограниченного доступа

Прежде всего, надо понимать, что конфиденциальными данными является не то, что компания хотела бы держать в секрете, а то, что формально закреплено в качестве информации ограниченного доступа. К информации ограниченного доступа относятся персональные данные, коммерческая, служебная, профессиональная тайна, сведения о сущности изобретения и пр. Поэтому первым шагом компания должна определить и документировать перечень информации ограниченного доступа, с которым сотрудники должны быть ознакомлены под роспись. Документы, которые понадобятся на данном этапе:

- Перечень информации ограниченного доступа.

- Перечень лиц, допущенных к обработке информации ограниченного доступа.

- Положения об обработке и защите информации ограниченного доступа (ПДн, КТ и пр.).

- Приказы о введении режима защиты информации (особенно КТ).

Разглашение информации ограниченного доступа

Теперь, когда мы выяснили, какую информацию будем защищать, и кто имеет к ней легитимный доступ, можно перейти непосредственно к вопросам ее возможного разглашения. В первую очередь, необходимо сформировать документы, в явном виде запрещающие разглашение сотрудниками информации ограниченного доступа, ставшей им известной в связи с исполнением трудовых обязанностей. Такой запрет должен быть прописан в документах двух типов: общие регламенты компании и документах, касающихся режима защиты информации.

Общие:

- Трудовой договор.

- Правила внутреннего трудового распорядка.

- Должностная инструкция работника.

- Положение о подразделении работника.

- Дополнительные соглашения с работником.

Режим защиты информации:

- Документы, содержащие положения и процедуры ИБ: общая политика ИБ, парольная защита, контроль доступа, защита от вредоносного ПО, допустимое использование ИС и сервисов (в т.ч. сеть Интернет и корпоративная почта), мониторинг и контроль, управление инцидентами, обучение и повышение осведомленности и пр.

- Инструкции пользователям информационных систем, сервисов и средств защиты информации.

Этот список документов можно считать опорным и при формировании положений, перечисленных ниже в статье.

Далее, как мы понимаем, запрет ничего не стоит, если не прописана ответственность за его нарушение. Лица, разгласившие информацию ограниченного доступа, могут привлекаться к дисциплинарной, административной, гражданско-правовой, уголовной ответственности в порядке, установленном законодательством Российской Федерации. И, в частности, напомню, что разглашение охраняемой законом тайны (государственной, коммерческой, служебной и иной), ставшей известной работнику в связи с исполнением им трудовых обязанностей, в том числе разглашения персональных данных другого работника, является основанием для увольнения сотрудника по инициативе работодателя (ТК РФ, статья 81, пункт 6в).

Правила обработки/защиты информации и использование средств мониторинга

Следующим шагом необходимо составить локальные нормативные акты, определяющие правила обработки и защиты информации ограниченного доступа. Сотрудники должны быть ознакомлены с ними под роспись, и мы рекомендуем компаниям хранить копии журналов ознакомления.

Сотрудники должны знать (т.е. опять-таки расписаться в ознакомлении), что исполнение этих правил, как и использование корпоративных средств обработки информации, контролируется с использованием средств мониторинга.

Также не лишними будут следующие документы:

- Отчеты и планы по обучению/инструктажу работников.

- Копия журналов по обучению и повышению осведомленности работников по вопросам обработки и защиты информации.

Личная информация на корпоративных ресурсах

Отдельно должны быть прописаны все правила, касающиеся личной информации сотрудников, ее хранения и передачи с использованием корпоративных ресурсов.

- Запрещено хранить личную информацию на корпоративных устройствах.

- Корпоративные каналы связи и средства обработки информации должны использоваться работниками исключительно для служебных (производственных) целей.

- Работникам запрещено хранить личную информацию на корпоративных ресурсах (рабочие станции и файловые хранилища) и передавать ее по корпоративным каналам связи (корпоративная электронная почта, сеть Интернет и другие).

Подразделение информационной безопасности

Обязанности безопасников тоже должны быть регламентированы и прописаны в положении о подразделении ИБ и должностных инструкциях его сотрудников. Как минимум, в список входят контроль соблюдения правил обработки и защиты информации ограниченного доступа и реагирование на инциденты информационной безопасности.

DLP-система

Система защиты информации должна соответствовать актуальным для компании угрозам, а также требованиям и рекомендациям регулирующих органов (Роскомнадзор, ФСБ России, ФСТЭК России). Что поможет офицеру безопасности подтвердить это:

- Выписка из Модели угроз и Модели нарушителя.

- Выписка из ТЗ и ТП на систему защиты.

- Справка о DLP системе (функционал и сертификаты).

- Отчеты об аудитах и проверках ИБ, копии аттестатов соответствия.

На этом все. Если статья была полезной, можем продолжить и рассказать, как юридически корректно уволить внутреннего злоумышленника и что делать, если сотрудник разгласил информацию ограниченного доступа, и вы решили идти в суд.

|

Метки: author SolarSecurity информационная безопасность блог компании solar security dlp юридические тонкости юридические вопросы защита информации защита от утечек |

DLP и Закон: как правильно оформить внедрение системы для защиты от утечек |

Сегодня хотелось бы еще раз поднять такую важную тему, как легитимность внедрения систем для защиты от утечек информации. Прекрасно, когда компания задумывается о сохранности своих информационных активов и внедряет DLP-решение. Но если этому внедрению не сопутствует юридическое оформление, часть функций DLP просто «отваливается». Компания не сможет использовать данные DLP в суде против сотрудника, виновного в разглашении конфиденциальной информации (а может и пострадать от иска самого сотрудника, например). Сегодняшний небольшой материал рассказывает, как этого избежать и где «подстелить солому».

В соответствии с ТК РФ, 98-ФЗ, 152-ФЗ и пр., функционирование DLP в организации включает несколько аспектов, требующих юридического оформления. Сразу оговоримся, что список документов, который мы даем ниже, несколько избыточен. Если каких-то регламентов у вас нет, это может быть не смертельно. Но у нас за годы работы в этой сфере сложилось мнение, что сопроводительных документов много не бывает, особенно если компании предстоит судиться с сотрудником, «слившим» конфиденциальные данные.

Еще один важны момент – большинство регламентов и положений требует подписи сотрудника, который либо выступает в качестве одной из сторон соглашения, либо подтверждает ознакомление с содержанием документа. Поэтому к работе над юридическим оформлением внедрения DLP необходимо привлекать HR-отдел и, естественно, юристов.

Информация ограниченного доступа

Прежде всего, надо понимать, что конфиденциальными данными является не то, что компания хотела бы держать в секрете, а то, что формально закреплено в качестве информации ограниченного доступа. К информации ограниченного доступа относятся персональные данные, коммерческая, служебная, профессиональная тайна, сведения о сущности изобретения и пр. Поэтому первым шагом компания должна определить и документировать перечень информации ограниченного доступа, с которым сотрудники должны быть ознакомлены под роспись. Документы, которые понадобятся на данном этапе:

- Перечень информации ограниченного доступа.

- Перечень лиц, допущенных к обработке информации ограниченного доступа.

- Положения об обработке и защите информации ограниченного доступа (ПДн, КТ и пр.).

- Приказы о введении режима защиты информации (особенно КТ).

Разглашение информации ограниченного доступа

Теперь, когда мы выяснили, какую информацию будем защищать, и кто имеет к ней легитимный доступ, можно перейти непосредственно к вопросам ее возможного разглашения. В первую очередь, необходимо сформировать документы, в явном виде запрещающие разглашение сотрудниками информации ограниченного доступа, ставшей им известной в связи с исполнением трудовых обязанностей. Такой запрет должен быть прописан в документах двух типов: общие регламенты компании и документах, касающихся режима защиты информации.

Общие:

- Трудовой договор.

- Правила внутреннего трудового распорядка.

- Должностная инструкция работника.

- Положение о подразделении работника.

- Дополнительные соглашения с работником.

Режим защиты информации:

- Документы, содержащие положения и процедуры ИБ: общая политика ИБ, парольная защита, контроль доступа, защита от вредоносного ПО, допустимое использование ИС и сервисов (в т.ч. сеть Интернет и корпоративная почта), мониторинг и контроль, управление инцидентами, обучение и повышение осведомленности и пр.

- Инструкции пользователям информационных систем, сервисов и средств защиты информации.

Этот список документов можно считать опорным и при формировании положений, перечисленных ниже в статье.

Далее, как мы понимаем, запрет ничего не стоит, если не прописана ответственность за его нарушение. Лица, разгласившие информацию ограниченного доступа, могут привлекаться к дисциплинарной, административной, гражданско-правовой, уголовной ответственности в порядке, установленном законодательством Российской Федерации. И, в частности, напомню, что разглашение охраняемой законом тайны (государственной, коммерческой, служебной и иной), ставшей известной работнику в связи с исполнением им трудовых обязанностей, в том числе разглашения персональных данных другого работника, является основанием для увольнения сотрудника по инициативе работодателя (ТК РФ, статья 81, пункт 6в).

Правила обработки/защиты информации и использование средств мониторинга

Следующим шагом необходимо составить локальные нормативные акты, определяющие правила обработки и защиты информации ограниченного доступа. Сотрудники должны быть ознакомлены с ними под роспись, и мы рекомендуем компаниям хранить копии журналов ознакомления.

Сотрудники должны знать (т.е. опять-таки расписаться в ознакомлении), что исполнение этих правил, как и использование корпоративных средств обработки информации, контролируется с использованием средств мониторинга.

Также не лишними будут следующие документы:

- Отчеты и планы по обучению/инструктажу работников.

- Копия журналов по обучению и повышению осведомленности работников по вопросам обработки и защиты информации.

Личная информация на корпоративных ресурсах

Отдельно должны быть прописаны все правила, касающиеся личной информации сотрудников, ее хранения и передачи с использованием корпоративных ресурсов.

- Запрещено хранить личную информацию на корпоративных устройствах.

- Корпоративные каналы связи и средства обработки информации должны использоваться работниками исключительно для служебных (производственных) целей.

- Работникам запрещено хранить личную информацию на корпоративных ресурсах (рабочие станции и файловые хранилища) и передавать ее по корпоративным каналам связи (корпоративная электронная почта, сеть Интернет и другие).

Подразделение информационной безопасности

Обязанности безопасников тоже должны быть регламентированы и прописаны в положении о подразделении ИБ и должностных инструкциях его сотрудников. Как минимум, в список входят контроль соблюдения правил обработки и защиты информации ограниченного доступа и реагирование на инциденты информационной безопасности.

DLP-система

Система защиты информации должна соответствовать актуальным для компании угрозам, а также требованиям и рекомендациям регулирующих органов (Роскомнадзор, ФСБ России, ФСТЭК России). Что поможет офицеру безопасности подтвердить это:

- Выписка из Модели угроз и Модели нарушителя.

- Выписка из ТЗ и ТП на систему защиты.

- Справка о DLP системе (функционал и сертификаты).

- Отчеты об аудитах и проверках ИБ, копии аттестатов соответствия.

На этом все. Если статья была полезной, можем продолжить и рассказать, как юридически корректно уволить внутреннего злоумышленника и что делать, если сотрудник разгласил информацию ограниченного доступа, и вы решили идти в суд.

|

Метки: author SolarSecurity информационная безопасность блог компании solar security dlp юридические тонкости юридические вопросы защита информации защита от утечек |

[Из песочницы] Автоматизация рыбной ловли для World of Warcraft |

Я уже видел ботов, которые умеют ловить рыбу, работающие в свернутом режиме не перехватывая управления над компьютером. Также я знаю насколько беспощадны близард по вопросам банов читеров. Изменение данных в оперативной памяти легко определяется встроенным античитом. Ну и последнее — на мак я не нашёл ни одного бота.

Поэтому я решил закрыть все эти вопросы разом и сделать бота, который будет перехватывать управление мыши, кидать поплавок, и тыкать на него на экране когда нужно. Как я полагал python располагает широким выбором инструментов для автоматизации таких штук, и не ошибся.

Немножечко погуглив, я нашёл OpenCV, в котором есть поиск шаблону с не сложным гайдом. С помощью него мы и будем искать наш поплавок на экране.

Сперва мы должны получить саму картинку с поплавком. Ищем и находим библиотеку pyscreenshot с гайдом как делать скриншоты, немножечко редактируем:

import pyscreenshot as ImageGrab

screen_size = None

screen_start_point = None

screen_end_point = None

# Сперва мы проверяем размер экрана и берём начальную и конечную точку для будущих скриншотов

def check_screen_size():

print "Checking screen size"

img = ImageGrab.grab()

# img.save('temp.png')

global screen_size

global screen_start_point

global screen_end_point

# я так и не смог найти упоминания о коэффициенте в методе grab с параметром bbox, но на моем макбуке коэффициент составляет 2. то есть при создании скриншота с координатами x1=100, y1=100, x2=200, y2=200), размер картинки будет 200х200 (sic!), поэтому делим на 2

coefficient = 2

screen_size = (img.size[0] / coefficient, img.size[1] / coefficient)

# берем примерно девятую часть экрана примерно посередине.

screen_start_point = (screen_size[0] * 0.35, screen_size[1] * 0.35)

screen_end_point = (screen_size[0] * 0.65, screen_size[1] * 0.65)

print ("Screen size is " + str(screen_size))

def make_screenshot():

print 'Capturing screen'

screenshot = ImageGrab.grab(bbox=(screen_start_point[0], screen_start_point[1], screen_end_point[0], screen_end_point[1]))

# сохраняем скриншот, чтобы потом скормить его в OpenCV

screenshot_name = 'var/fishing_session_' + str(int(time.time())) + '.png'

screenshot.save(screenshot_name)

return screenshot_name

def main():

check_screensize()

make_screenshot()

Получаем примерно следующую картинку:

Далее — найти поплавок. Для этого у нас должен быть сам шаблон поплавка, который мы ищем. После сотни попыток я всё таки подобрал те, которые OpenCV определяет лучше всего. Вот они:

Берём код из ссылки выше, добавляем цикл и наши шаблоны:

import cv2

import numpy as np

from matplotlib import pyplot as plt

def find_float(screenshot_name):

print 'Looking for a float'

for x in range(0, 7):

# загружаем шаблон

template = cv2.imread('var/fishing_float_' + str(x) + '.png', 0)

# загружаем скриншот и изменяем его на чернобелый

src_rgb = cv2.imread(screenshot_name)

src_gray = cv2.cvtColor(src_rgb, cv2.COLOR_BGR2GRAY)

# берем ширину и высоту шаблона

w, h = template.shape[::-1]

# магия OpenCV, которая и находит наш темплейт на картинке

res = cv2.matchTemplate(src_gray, template, cv2.TM_CCOEFF_NORMED)

# понижаем порог соответствия нашего шаблона с 0.8 до 0.6, ибо поплавок шатается и освещение в локациях иногда изменяет его цвета, но не советую ставить ниже, а то и рыба будет похожа на поплавок

threshold = 0.6

# numpy фильтрует наши результаты по порогу

loc = np.where( res >= threshold)

# выводим результаты на картинку

for pt in zip(*loc[::-1]):

cv2.rectangle(src_rgb, pt, (pt[0] + w, pt[1] + h), (0,0,255), 2)

# и если результаты всё же есть, то возвращаем координаты и сохраняем картинку

if loc[0].any():

print 'Found float at ' + str(x)

cv2.imwrite('var/fishing_session_' + str(int(time.time())) + '_success.png', src_rgb)

return (loc[1][0] + w / 2) / 2, (loc[0][0] + h / 2) / 2 # опять мы ведь помним, что макбук играется с разрешениями? поэтому снова приходится делить на 2

def main():

check_screensize()

img_name = make_screenshot()

find_float(img_name)

Итак, у нас есть координаты поплавка, двигать курсор мыши умеет autopy буквально с помощью одной строки, подставляем свои координаты:

import autopy

def move_mouse(place):

x,y = place[0], place[1]

print("Moving cursor to " + str(place))

autopy.mouse.smooth_move(int(screen_start_point[0]) + x , int(screen_start_point[1]) + y)

def main():

check_screensize()

img_name = make_screenshot()

cords = find_float(img_name)

move_mouse(cords)

Курсор на поплавке и теперь самое интересное — как же узнать когда нужно нажать? Ведь в самой игре поплавок подпрыгивает и издает звук будто что-то плюхается в воду. После тестов с поиском картинки я заметил, что OpenCV приходится подумать пол секунды прежде чем он возвращает результат, а поплавок прыгает даже быстрее и изменение картинки мы врядли сможем определить с помощью OpenCV, значит будем слушать звук. Для этой задачки мне пришлось поковырять разные решения и остановился вот над этим — пример использования гугл апи для распознавания голоса, оттуда мы возьмём код, который считывает звук.

import pyaudio

import wave

import audioop

from collections import deque

import time

import math

def listen():

print 'Listening for loud sounds...'

CHUNK = 1024

FORMAT = pyaudio.paInt16

CHANNELS = 2

RATE = 18000 # битрейт звука, который мы хотим слушать

THRESHOLD = 1200 # порог интенсивности звука, если интенсивность ниже, значит звук по нашим меркам слишком тихий

SILENCE_LIMIT = 1 # длительность тишины, если мы не слышим ничего это время, то начинаем слушать заново

# открываем стрим

p = pyaudio.PyAudio()

stream = p.open(format=FORMAT,

channels=CHANNELS,

rate=RATE,

# output=True, # на мак ос нет возможности слушать output, поэтому мне пришлось прибегнуть к использованию Soundflower, который умеет перенаправлять канал output в input, таким образом мы перехватываем звук игры будто это микрофон

input=True,

frames_per_buffer=CHUNK)

cur_data = ''

rel = RATE/CHUNK

slid_win = deque(maxlen=SILENCE_LIMIT * rel)

# начинаем слушать и по истечении 20 секунд (столько максимум длится каждый заброс поплавка), отменяем нашу слушалку.

success = False

listening_start_time = time.time()

while True:

try:

cur_data = stream.read(CHUNK)

slid_win.append(math.sqrt(abs(audioop.avg(cur_data, 4))))

if(sum([x > THRESHOLD for x in slid_win]) > 0):

print 'I heart something!'

success = True

break

if time.time() - listening_start_time > 20:

print 'I don't hear anything during 20 seconds!'

break

except IOError:

break

# обязательно закрываем стрим

stream.close()

p.terminate()

return success

def main():

check_screensize()

img_name = make_screenshot()

cords = find_float(img_name)

move_mouse(cords)

listen()

Последнее, что осталось — споймать саму рыбку, когда мы услышим звук, снова используем autopy:

def snatch():

print('Snatching!')

autopy.mouse.click(autopy.mouse.RIGHT_BUTTON)

def main():

check_screensize()

img_name = make_screenshot()

cords = find_float(img_name)

move_mouse(cords)

if listen():

snatch()

По моим тестам, что я оставлял бота рыбачить по ночам, за неделю такого абуза он сделал около 7000 бросков и словил около 5000 рыб. Погрешность 30% вызвана тем, что иногда не получается отловить звук или найти поплавок из-за освещения или поворотов поплавка. Но результатом я доволен — впервые попробовал python, сделал бота и сэкономил себе кучу времени.

Полный код можно посмотреть тут, но очень советую не использовать для абуза фишинга, ибо бан — страшно.

Буду рад любым комментариям.

|

Метки: author kio_tk python world of warcraft боты opencv |

[Из песочницы] Автоматизация рыбной ловли для World of Warcraft |

Я уже видел ботов, которые умеют ловить рыбу, работающие в свернутом режиме не перехватывая управления над компьютером. Также я знаю насколько беспощадны близард по вопросам банов читеров. Изменение данных в оперативной памяти легко определяется встроенным античитом. Ну и последнее — на мак я не нашёл ни одного бота.

Поэтому я решил закрыть все эти вопросы разом и сделать бота, который будет перехватывать управление мыши, кидать поплавок, и тыкать на него на экране когда нужно. Как я полагал python располагает широким выбором инструментов для автоматизации таких штук, и не ошибся.

Немножечко погуглив, я нашёл OpenCV, в котором есть поиск шаблону с не сложным гайдом. С помощью него мы и будем искать наш поплавок на экране.

Сперва мы должны получить саму картинку с поплавком. Ищем и находим библиотеку pyscreenshot с гайдом как делать скриншоты, немножечко редактируем:

import pyscreenshot as ImageGrab

screen_size = None

screen_start_point = None

screen_end_point = None

# Сперва мы проверяем размер экрана и берём начальную и конечную точку для будущих скриншотов

def check_screen_size():

print "Checking screen size"

img = ImageGrab.grab()

# img.save('temp.png')

global screen_size

global screen_start_point

global screen_end_point

# я так и не смог найти упоминания о коэффициенте в методе grab с параметром bbox, но на моем макбуке коэффициент составляет 2. то есть при создании скриншота с координатами x1=100, y1=100, x2=200, y2=200), размер картинки будет 200х200 (sic!), поэтому делим на 2

coefficient = 2

screen_size = (img.size[0] / coefficient, img.size[1] / coefficient)

# берем примерно девятую часть экрана примерно посередине.

screen_start_point = (screen_size[0] * 0.35, screen_size[1] * 0.35)

screen_end_point = (screen_size[0] * 0.65, screen_size[1] * 0.65)

print ("Screen size is " + str(screen_size))

def make_screenshot():

print 'Capturing screen'

screenshot = ImageGrab.grab(bbox=(screen_start_point[0], screen_start_point[1], screen_end_point[0], screen_end_point[1]))

# сохраняем скриншот, чтобы потом скормить его в OpenCV

screenshot_name = 'var/fishing_session_' + str(int(time.time())) + '.png'

screenshot.save(screenshot_name)

return screenshot_name

def main():

check_screensize()

make_screenshot()

Получаем примерно следующую картинку:

Далее — найти поплавок. Для этого у нас должен быть сам шаблон поплавка, который мы ищем. После сотни попыток я всё таки подобрал те, которые OpenCV определяет лучше всего. Вот они:

Берём код из ссылки выше, добавляем цикл и наши шаблоны:

import cv2

import numpy as np

from matplotlib import pyplot as plt

def find_float(screenshot_name):

print 'Looking for a float'

for x in range(0, 7):

# загружаем шаблон

template = cv2.imread('var/fishing_float_' + str(x) + '.png', 0)

# загружаем скриншот и изменяем его на чернобелый

src_rgb = cv2.imread(screenshot_name)

src_gray = cv2.cvtColor(src_rgb, cv2.COLOR_BGR2GRAY)

# берем ширину и высоту шаблона

w, h = template.shape[::-1]

# магия OpenCV, которая и находит наш темплейт на картинке

res = cv2.matchTemplate(src_gray, template, cv2.TM_CCOEFF_NORMED)

# понижаем порог соответствия нашего шаблона с 0.8 до 0.6, ибо поплавок шатается и освещение в локациях иногда изменяет его цвета, но не советую ставить ниже, а то и рыба будет похожа на поплавок

threshold = 0.6

# numpy фильтрует наши результаты по порогу

loc = np.where( res >= threshold)

# выводим результаты на картинку

for pt in zip(*loc[::-1]):

cv2.rectangle(src_rgb, pt, (pt[0] + w, pt[1] + h), (0,0,255), 2)

# и если результаты всё же есть, то возвращаем координаты и сохраняем картинку

if loc[0].any():

print 'Found float at ' + str(x)

cv2.imwrite('var/fishing_session_' + str(int(time.time())) + '_success.png', src_rgb)

return (loc[1][0] + w / 2) / 2, (loc[0][0] + h / 2) / 2 # опять мы ведь помним, что макбук играется с разрешениями? поэтому снова приходится делить на 2

def main():

check_screensize()

img_name = make_screenshot()

find_float(img_name)

Итак, у нас есть координаты поплавка, двигать курсор мыши умеет autopy буквально с помощью одной строки, подставляем свои координаты:

import autopy

def move_mouse(place):

x,y = place[0], place[1]

print("Moving cursor to " + str(place))

autopy.mouse.smooth_move(int(screen_start_point[0]) + x , int(screen_start_point[1]) + y)

def main():

check_screensize()

img_name = make_screenshot()

cords = find_float(img_name)

move_mouse(cords)

Курсор на поплавке и теперь самое интересное — как же узнать когда нужно нажать? Ведь в самой игре поплавок подпрыгивает и издает звук будто что-то плюхается в воду. После тестов с поиском картинки я заметил, что OpenCV приходится подумать пол секунды прежде чем он возвращает результат, а поплавок прыгает даже быстрее и изменение картинки мы врядли сможем определить с помощью OpenCV, значит будем слушать звук. Для этой задачки мне пришлось поковырять разные решения и остановился вот над этим — пример использования гугл апи для распознавания голоса, оттуда мы возьмём код, который считывает звук.

import pyaudio

import wave

import audioop

from collections import deque

import time

import math

def listen():

print 'Listening for loud sounds...'

CHUNK = 1024

FORMAT = pyaudio.paInt16

CHANNELS = 2

RATE = 18000 # битрейт звука, который мы хотим слушать

THRESHOLD = 1200 # порог интенсивности звука, если интенсивность ниже, значит звук по нашим меркам слишком тихий

SILENCE_LIMIT = 1 # длительность тишины, если мы не слышим ничего это время, то начинаем слушать заново

# открываем стрим

p = pyaudio.PyAudio()

stream = p.open(format=FORMAT,

channels=CHANNELS,

rate=RATE,

# output=True, # на мак ос нет возможности слушать output, поэтому мне пришлось прибегнуть к использованию Soundflower, который умеет перенаправлять канал output в input, таким образом мы перехватываем звук игры будто это микрофон

input=True,

frames_per_buffer=CHUNK)

cur_data = ''

rel = RATE/CHUNK

slid_win = deque(maxlen=SILENCE_LIMIT * rel)

# начинаем слушать и по истечении 20 секунд (столько максимум длится каждый заброс поплавка), отменяем нашу слушалку.

success = False

listening_start_time = time.time()

while True:

try:

cur_data = stream.read(CHUNK)

slid_win.append(math.sqrt(abs(audioop.avg(cur_data, 4))))

if(sum([x > THRESHOLD for x in slid_win]) > 0):

print 'I heart something!'

success = True

break

if time.time() - listening_start_time > 20:

print 'I don't hear anything during 20 seconds!'

break

except IOError:

break

# обязательно закрываем стрим

stream.close()

p.terminate()

return success

def main():

check_screensize()

img_name = make_screenshot()

cords = find_float(img_name)

move_mouse(cords)

listen()

Последнее, что осталось — споймать саму рыбку, когда мы услышим звук, снова используем autopy:

def snatch():

print('Snatching!')

autopy.mouse.click(autopy.mouse.RIGHT_BUTTON)

def main():

check_screensize()

img_name = make_screenshot()

cords = find_float(img_name)

move_mouse(cords)

if listen():

snatch()

По моим тестам, что я оставлял бота рыбачить по ночам, за неделю такого абуза он сделал около 7000 бросков и словил около 5000 рыб. Погрешность 30% вызвана тем, что иногда не получается отловить звук или найти поплавок из-за освещения или поворотов поплавка. Но результатом я доволен — впервые попробовал python, сделал бота и сэкономил себе кучу времени.

Полный код можно посмотреть тут, но очень советую не использовать для абуза фишинга, ибо бан — страшно.

Буду рад любым комментариям.

|

Метки: author kio_tk python world of warcraft боты opencv |

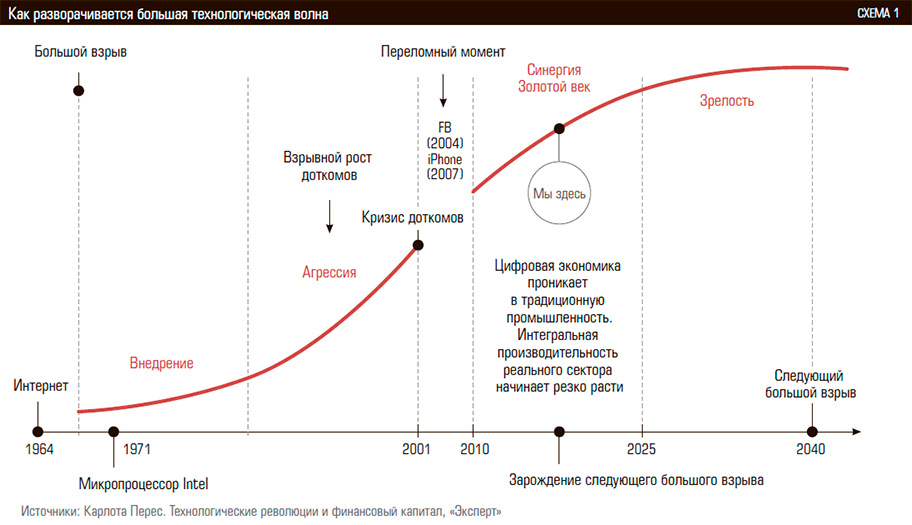

Цифровая экономика и экосистема R |

Если смотреть прессу, словосочетание «цифровая экономика» ожидается одним из популярных в ближайшие несколько лет.

Но чтобы от перейти от слов к делу и действительно совершить цифровой скачок необходимо пересмотреть подходы и используемые инструменты. В рамках настоящей публикации, являющейся продолжением предыдущих публикаций, планирую кратко проиллюстрировать, тезис о том, что применение в бизнесе R экосистемы прекрасно вписывается в задачу перехода к цифровой экономике.

Почему необходимы новые подходы и инструменты?

- Многократное увеличение объемов данных

- Многократное увеличение источников данных

- Многократное увеличение форматов обмена

- Работа с неструктурированными данными

- Смещение фокуса от исторического анализа к научному прогнозированию

- Акцент на визуализацию и удобства восприятия

- Многократное снижение времени на принятие решения вплоть до работы в режиме «реального времени»

High Level Design (HLD) аналитической системы на базе R

В эволюционного развития различных задач были пересмотрены различные методики и современные open-source средства. В результате сформировался достаточно универсальный стек общего назначения, общая архитектура которого выглядит следующим образом:

Ключевые компоненты решения

- RStudio — аналитическая экосистема (импорт, обработка, визуализация) на основе платформы R

- Yandex ClickHouse — сверхбыстрая колоночно-ориентированная БД, оптимизированная для работы с временнЫми данными

- Appache Drill — платформа для обеспечения унифицированного SQL доступа к BigData & NoSQL данным

- Appache Airflow — оркестратор

- «ETL» — платформа для приема разнообразной структурированной информации в относительно «чистой» форме с применением языка Go

В зависимости от предметной области, типов и масштабов данных могут использоваться не все элементы стека. Но какая бы задачи ни была, аналитическим ядром, а также лицом системы с точки зрения пользователя остается R & Shiny соотвественно.

Ожидаемые бизнесом выходы от аналитической системы

Как правило, большинство людей ожидают увидеть «отчеты», не детализируя, что именно они в это слово вкладывают. Экосистема R позволяет получать много больше типичных ожиданий:

- генерация штатных отчетов в виде HTML (с элементами интерактива в виде встроенных htmlWidgets);

- генерация штатных отчетов в виде PDF;

- генерация различных выгрузок в различных форматах для M2M взаимодействия;

- интерактивные аналитические приложения (дашборды);

- элементы операционной аналитики (автоматическое внесение изменений в другие ИТ системы на основе полученных вычислений).

Средой существования всех упомянутых типов отчетов и АРМ является Shiny Server\Connect Server. В платной или бесплатной редакции — зависит от требований, которые выходят за рамки аналитики и определяются требованиями по нагрузке, безопасности, централизованному управлению.

5 бизнес-аргументов в пользу приведенного HLD

- Быстрые сроки ввода в эксплуатацию и минимальная стоимость владения за счет применения передовых апробированных open-source инструментов.

- Широчайший спектр функциональных возможностей по импорту, обработке и визуализации.

- Унифицированные высокопроизводительные технологии для данных различного масштаба данных (миллионы – сотни триллионов строк\ гигабайты – петабайты данных).

- Использование открытых общедоступных пакетов (>10 тыс штук), в том числе в части:

- алгоритмической обработки, включая методы машинного обучения;

- визуализации и создания интерактивных аналитических дашбордов на базе технологий HTML5+CSS+JS.

- Наличие «enterprise compliant» коммерческих версий доступных по модели подписки для ключевых open-source компонент.

P.S.

Практика раз за разом показывает, что цифровые преобразования упираются отнюдь не в возможности инструментов (open-source), а в неготовность людей менять восприятие, изучать новое, мыслить стратегически или просто страх перемен.

Примером подобного типового пожелания является наличие «визуального» конструктора, так, чтобы только мышкой, без какого-либо программирования можно было получить результат неограниченной сложности. Однако, это красивое требование, культивируемое представителями BI визуализации, очень плохо сочетается с самим содержанием цифровых перемен которые ожидают человечество.

Парадокс этого требования вполне прозрачен. Повсеместно используя машины в качестве помощников крайне затруднительно общаться с ними с помощю ограниченного языка жестов или словаря Эллочки-людоедки. Даже из теории информации следует, что двумя-тремя кликами очень мало чего можно передать, если только это не код заранее досконально согласованного действия.

В цифровом мире язык програмимирования становится таким же важным знанием, как язык международного общения. Интересно, что в отдельных западных компаниях, воспринимавшихся ранее как классическое производство, программирование становится важным навыком даже для менеджеров. Прекрасный пример подобной трансформации — компания GE, подразделеие GE Digital. Ролик — Discover GE Digital: The Digital Industrial Company

|

Метки: author i_shutov data mining big data data science |

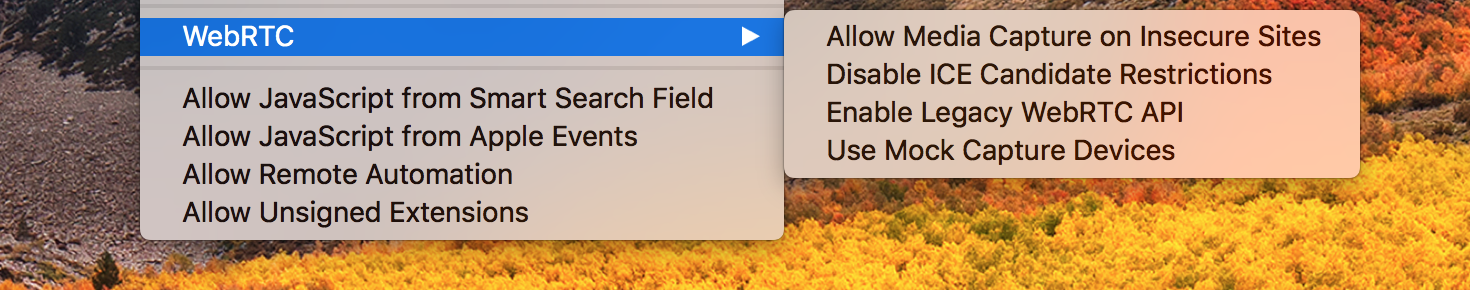

Новые инструменты Safari для отладки WebRTC |

Совсем недавно Apple анонсировала поддержку WebRTC в Safari. Слухи ходили несколько лет, и теперь мы знаем: осенью WebRTC будет доступна для всех основных браузерах: Chrome, Firefox, Safari и Edge. С подводными камнями и несовместимостями. Технология очень крутая и позволяет передавать peer-to-peer между браузерами голос, видео, экран или произвольные данные. Ее использует «Skype for Web», «Hangouts» и другие известные коммуникаторы. А в новой версии Safari кроме самой WebRTC добавилось много плюшек для пользующихся ей разработчиков, о которых я расскажу под катом.

Поддержка обеих версий API

За последние несколько лет API WebRTC полностью поменялся: старый вариант на коллбеках и с медиа потоками был объявлен устаревшим, а вместо него создателям браузеров предлагают сделать новый, на промисах и с медиа треками. Firefox полностью поддерживает как старый так и новый API, у Chrome пока не реализована часть методов по работе с меди треками. А разработчики Safari выбрали интересное решение: браузер поддерживает оба API, но в версии для конечных пользователей будет доступно только новое. А старое можно для отладки включить через специальное меню:

Только HTTPS

Начинающие разработчики WebRTC традиционно сталкиваются с «написал несколько строчек JavaScript как в примере — а оно не работает». Производители браузеров стараются защитить своих пользователей от потенциально опасного захвата голоса и видео с устройств. И вводят дополнительные ограничения на использование API. Например, WebRTC не будет работать в Chrome, если страница была загружена из файла. А разработчики Safari пошли дальше и запретили WebRTC для сайтов без поддержки HTTPS! Для локальной отладки это ограничение можно снять через то же меню.

Скандал с локальными IP адресами

Не так давно по интернету прошлась волна обсуждений найденной «уязвимости»: WebRTC позволяла получить локальный IP адрес компьютера до того, как пользователь дал доступ к камере, микрофону и вообще согласился устанавливать какие-то подключения. А локальный IP адрес — это еще одна возможность точнее таргетировать пользователей и показывать им больше рекламы.

В Safari это учли, и по умолчанию WebRTC не будет использовать локальный IP адрес для установки peer-to-peer подключения. Только «внешний», полученный после общение со STUN сервером. Ограничение снимается, если пользователь дал доступ к камере или микрофону. Что, в целом, логично и стимулирует разработчиков писать код про коммуникации, а не пытаться использовать WebRTC для получения лишних данных таргетирования. Это ограничение тоже можно отключить через меню разработчика.

Генератор видео и голоса для отладки

Отлаживаться собственным лицом с камеры ноута — то еще удовольствие. Поэтому разработчики Safari добавили в то же меню пункт включения «фейкового видео» или звука: вместо видео будет передаваться телевизионная заставка, вместо голоса — одна нота. Очень удобно для авто тестов и проверки связи. Кстати, в Firefox такой режим уже давно был и включался специальным флагом «fake» при инициализации WebRTC.

Картинка для привлечения внимания взята здесь, иллюстрация меню Safari взята здесь

|

Метки: author eyeofhell разработка веб-сайтов программирование safari javascript блог компании voximplant webrtc |

[Из песочницы] Chromebook для удаленной работы. Настраиваем VPN и RDP |

Привет! Удаленную работу часто можно описать как два технических требования от исполнителя: первое, доступ в интернет, и второе, ноутбук. А если у вас есть удаленный сервер, на котором вы работаете, то все, что вам нужно: тонкий клиент для доступа к нему. В этой статье я расскажу, как я выбирал и настраивал тонкий клиент для удаленной работы, и почему хромбук отлично справляется с этой задачей.

Требования

Итак, вот основные требования, которые я определил для себя:

- Хороший экран — в него мы будем смотреть часами

- Автономность — жизнь на батареи более 5-6 часов

- Вес — мобильность важный показатель для поездок и путешествий

- Цена — разбить или потерять ноутбук за $300 будет не так накладно/обидно как за $1500

Выбор устройства

С выбором я не заморачивался, открыл Амазон и нашел все модели хромбуков в категории до 300 долларов. Мой выбор пал на модель Acer Chromebook 14 (CB3-431). Для теста выбрал восстановленный (Refurbished) ноутбук за 185 долларов. Справедливости ради нужно отметить, что восстановленный хромбук ничем не отличался от нового, кроме как отсутствием оригинальной упаковки и 3-мя месяцами гарантии.

Настройка VPN и RDP в хром ос

Итак, красивый и тонкий ноутбук в руках, настраиваем VPN и RDP для удаленной работы.

VPN проблема

Читаем много статей по настройке VPN и понимаем, что все плохо, настроить подключение через ovpn файлы практически невозможно. Нужно разбивать ovpn файлы на части и конвертировать в особый формат, что, в итоге, тоже не сработало. Мой хромбук поддерживает андроид приложения, но оказалось, что и они не могу работать с TAP-интерфейсом, описанным в ovpn файле.

VPN решение

Для решения этой проблемы, нам нужно получить рут права и воспользоваться уже встроенным openvpn клиентом. Как получить рут права описано здесь.

Теперь, чтобы поднять наш VPN, нам нужно выполнить следующее.

Заходим в терминал: Ctrl+Alt+T, вводим команду shell. Далее нам нужны команды:

openvpn --mktun --dev tap0

openvpn --config /usr/local/vpn/openvpn.ovpn --dev tap0

openvpn --rmtun --dev tap0

Первая строка создает тоннель, вторая запускает подключение (здесь, указываем путь к вашему ovpn файлу), третья нужна после завершения подключения.

Проблема VPN решена.

RDP проблема

Для удаленного доступа можно использовать множество решений, таких как Google Remote Desktop или TeamViewer. Но для меня они не подошли, в силу разных причин, и я решил сосредоточиться на настройке RDP.

На хром ос можно запустить ChromeRDP, вроде работает, но плохо живет на медленном канале связи и настроек маловато.

RDP решение

Для решения этой задачи нам потребуется хороший RDP-клиент и линукс. Самый простой способ получить полноценный линукс на хромбуке это Crouton. Он устанавливается просто и работает параллельно с хром ос. Подробная статья о настройке Crouton хабрится здесь.

Имея доступ к apt-get в линукс, мы можем установить Remmina. Remmina — это удобный и быстрый RDP клиент.

Итак, программа минимум выполнена и мы можем работать.

Итоги

Успел поработать в таком режиме больше месяца. В целом работать достаточно удобно, хоть и понадобилось время чтобы привыкнуть к клавиатуре.

Плюсы:

- Цена вопроса, в моем случае это ~$200 (с учетом доставки из США)

- Достаточно хорошие характеристики для целевой задачи: 4gb RAM, 32gb SSD, IPS 14" FULL HD, 1.5kg

- Длительное время автономной работы, в моем случае 9-10 часов от батареи

- Возможность установки андроид приложений + полноценный линукс

- Отсутствие каких либо тормозов в хром ос и при использовании RDP

Минусы:

- Нужно инвестировать время в настройку системы

- Если нужно подключение к удаленному серверу, то без интернета — работа стоит

В целом, опыт использования хромбука для работы получился интересный, и если у вас есть время и желание, рекомендую попробовать. Я так же понял, что хром ос — идеальный вариант для дедушек и бабушек, для просмотра YouTube и погоды :)

Надеюсь, эта статья была полезна, удачи!

|

Метки: author Zin4uk системное администрирование *nix cromebook remote linux vpn remmina rdp |

[Перевод] Погружение в F#. Пособие для C#-разработчиков |

Этот пост будет не о том, как «перевести» код с C# на F#: различные парадигмы делают каждый из этих языков лучшим для своего круга задач. Однако вы сможете оценить все достоинства функционального программирования быстрее, если не будете думать о переводе кода из одной парадигмы в другую. Настало время любопытных, пытливых и готовых изучать совершенно новые вещи. Давайте начнем!

Ранее, в посте «Почему вам следует использовать F#», мы рассказали, почему F# стоит попробовать прямо сейчас. Теперь мы разберем основы, необходимые для его успешного применения. Пост предназначен для людей, знакомых с C#, Java или другими объектно-ориентированными языками. Если вы уже пишете на F#, эти понятия должны быть вам хорошо знакомы.

Сразу к различиям

Перед тем, как приступить к изучению понятий функционального программирования, давайте посмотрим на небольшой пример и определим, в чем F# отличается от C#. Это базовый пример с двумя функциями и выводом результата на экран:

let square x = x * x

let sumOfSquares n =

[1..n] // Создадим список с элементами от 1 до n

|> List.map square // Возведем в квадрат каждый элемент

|> List.sum // Просуммируем их!

printfn "Сумма квадратов первых 5 натуральных чисел равна %d" (sumOfSquares 5)Обратите внимание, что здесь нет явного указания типов, отсутствуют точки с запятой или фигурные скобки. Скобки используются в единственном месте: для вызова функции sumOfSquares с числом 5 в качестве входного значения и последующего вывода результата на экран. Конвейерный оператор |> (pipeline operator) используется так же, как конвейеры (каналы, pipes) в Unix. square — это функция, которая напрямую передается в функцию List.map как параметр (функции в F# рассматриваются как значения, first-class functions).

Хотя различий на самом деле еще много, сперва стоит разобраться с фундаментальными вещами, поскольку они — ключ к пониманию F#.

C# и F#: Соответствие ключевых понятий

Следующая таблица показывает соответствия между некоторыми ключевыми понятиями C# и F#. Это умышленно короткое и неполное описание, но так его проще запомнить в начале изучения F#.

| C# и Объектно-Ориентированное Программирование | F# и Функциональное Программирование |

|---|---|

| Переменные | Неизменяемые значения |

| Инструкции | Выражения |

| Объекты с методами | Типы и функции |

Быстрая шпаргалка по некоторым терминам:

Переменные — это значения, которые могут меняться. Это следует из их названия!

Неизменяемые значения — это значения, которые не могут быть изменены после присваивания.

Инструкции — это команды, исполняемые после запуска программы.

Выражения — это фрагменты кода, которые можно вычислить и получить значения.

- Типы — это классификация данных в программе.

Стоит отметить, что все указанное в столбце C# так же возможно в F# (и довольно легко реализуется). В столбце F# также есть вещи, которые можно сделать в C#, хотя и намного сложнее. Следует упомянуть, что элементы в левом столбце не являются "плохими" в F#, и наоборот. Объекты с методами отлично подходят для использования в F# и часто являются лучшим решением в зависимости от вашей ситуации.

Неизменяемые значения вместо переменных

Одним из наиболее непривычных понятий в функциональном программировании является неизменяемость (иммутабельность, immutability). Ему часто уделяют недостаточно внимания в сообществе любителей функционального программирования. Но если вы никогда не использовали язык, в котором значения неизменяемы по умолчанию, это часто является первым и наиболее значимым препятствием для дальнейшего изучения. Неизменяемость является фундаментальным понятием практически во всех функциональных языках.

let x = 1В предыдущем выражении значение 1 связано с именем x. В течение всего времени существования имя x теперь ссылается на значение 1 и не может быть изменено. Например, следующий код не может переназначить значение x:

let x = 1

x = x + 1 // Это выражение ничего не присваивает!Вместо этого, вторая строка является сравнением, определяющим, является ли x равным x + 1. Хотя существует способ изменить (мутировать, mutate) x с помощью использования оператора <- и модификатора mutable (см. подробности в Mutable Variables), вы быстро поймете, что проще думать о решении задач без переприсвоения значений. Если не рассматривать F# как еще один императивный язык программирования, вы сможете использовать его самые сильные стороны.

Неизменяемость существенным образом преобразует ваши привычные подходы к решению задач. Например, циклы for и другие базовые операции императивного программирования не так часто используются в F#.

Рассмотрим более конкретный пример: вы хотите возвести в квадрат числа из входного списка. Вот как это можно сделать в F#:

// Определим функцию, которая вычисляет квадрат значения

let square x = x * x

let getSquares items =

items |> List.map square

let lst = [ 1; 2; 3; 4; 5 ] // Создать список в F#

printfn "Квадрат числа %A равен %A" lst (getSquares lst)Заметим, что в этом примере нет цикла for. На концептуальном уровне это сильно отличается от императивного кода. Мы не возводим в квадрат каждый элемент списка. Мы применяем функцию square к входному списку и получаем значения, возведенные в квадрат. Это очень тонкое различие, но на практике оно может приводить к значительно отличающемуся коду. Прежде всего, функция getSquares на самом деле создает полностью новый список.

Неизменяемость — это гораздо более широкая концепция, чем просто иной способ управления данными в списках. Понятие ссылочной прозрачности (Referential Transparency) естественно для F#, и оказывает значительное влияние, как на разработку систем, так и на то, как части этих систем сочетаются. Функциональные характеристики системы становятся более предсказуемыми, когда значения не изменяются, если вы этого не ожидаете.

Более того, когда значения неизменяемы, конкурентное программирование становится проще. Некоторые сложные проблемы, возникающие в С# из-за изменяемого состояния, в F# не встречаются вообще. F# не может волшебным образом решить все ваши проблемы с многопоточностью и асинхронностью, однако он сделает многие вещи проще.

Выражения вместо инструкций

Как было упомянуто ранее, F# использует выражения (expressions). Это контрастирует с C#, где практически для всего используются инструкции (statements). Различие между ними может казаться на первый взгляд незначительным, однако есть одна вещь, о которой следует помнить: выражения производят значения. Инструкции — нет.

// 'getMessage' -- это функция, и `name` - ее входной параметр.

let getMessage name =

if name = "Phillip" then // 'if' - это выражение.

"Hello, Phillip!" // Эта строка тоже является выражением. Оно возвращает значение

else

"Hello, other person!" // То же самое с этой строкой.

let phillipMessage = getMessage "Phillip" // getMessage, при вызове, является выражением. Его значение связано с именем 'phillipMessage'.

let alfMessage = getMessage "Alf" // Это выражение связано с именем 'alfMessage'!В предыдущем примере вы можете увидеть несколько моментов, которые отличают F# от императивных языков вроде C#:

if...then...else— это выражение, а не инструкция.- Каждая ветка выражения

ifвозвращает значение, которое в данном случае будет являться возвращаемым значением функцииgetMessage. - Каждый вызов функции

getMessage— это выражение, которое принимает строку и возвращает строку.

Этот подход сильно отличается от C#, но скорее всего он покажется вам естественным при написании кода на F#.

Если копнуть немного глубже, в F# даже инструкции описываются с помощью выражений. Такие выражения возвращают значение типа unit. unit немного похож на void в C#:

let names = [ "Alf"; "Vasily"; "Shreyans"; "Jin Sun"; "Moulaye" ]

// Цикл `for`. Ключевое слово 'do' указывает, что выражение их внутренней области видимости должно иметь тип `unit`.

// Если это не так, то результат выражения неявно игнорируется.

for name in names do

printfn "My name is %s" name // printfn возвращает unit.В предыдущем примере с циклом for всё имеет тип unit. Выражения типа unit — это выражения, которые не имеют возвращаемого значения.

F#: Массивы, списки и последовательности

Предыдущие примеры кода использовали массивы и списки F#. В данном разделе разъясняются некоторые подробности.

F# предоставляет несколько типов коллекций и самые распространенные из них — это массивы, списки и последовательности.

- Массивы в F# — это массивы .NET. Они изменяемы — хранимые значения могут быть перезаписаны на месте. Они вычисляются энергично (eagerly).

- Списки в F# — это неизменяемые односвязные списки. Они могут быть использованы в виде шаблонов списков для сопоставлением с образом (pattern matching) в F#. Они вычисляются энергично.

- Последовательности в F# является неизменяемыми

IEnumerable. Они вычисляются лениво.

Массивы, списки и последовательности в F# также имеют особый синтаксис для выражений. Это очень удобно для различных задач, когда нужно генерировать данные программно.

// Создадим список квадратов первых 100 натуральных чисел

let first100Squares = [ for x in 1..100 -> x * x ]

// То же самое, но массив!

let first100SquaresArray = [| for x in 1..100 -> x * x |]

// Функция, которая генерирует бесконечную последовательность нечетных чисел

//

// Вызывать вместе с Seq.take!

let odds =

let rec loop x = // Использует рекурсивную локальную функцию

seq { yield x

yield! loop (x + 2) }

loop 1

printfn "Первые 3 нечетных числа: %A" (Seq.take 3 odds)

// Вывод: "Первые 3 нечетных числа: seq [1; 3; 5]Соответствие между функциями F# и методами LINQ

Если вы знакомы с методами LINQ, следующая таблица поможет вам понять аналогичные функции в F#.

| LINQ | F# функция |

|---|---|

Where |

filter |

Select |

map |

GroupBy |

groupBy |

SelectMany |

collect |

Aggregate |

fold или reduce |

Sum |

sum |

Вы также можете заметить, что такой же набор функций существует для модулей Seq, List и Array. Функции модуля Seq могут быть использованы для последовательностей, списков или массивов. Функции для массивов и списков могут быть использованы только для массивов и списков в F# соответственно. Также последовательности в F# ленивые, а списки и массивы — энергичные. Использование функций модуля Seq на списках или массивах влечет за собой ленивое вычисление, а тип возвращаемого значения будет последовательностью.

Предыдущий раздел содержит в себе довольно много информации, но по мере написания программ на F# она станет интуитивно понятной.

Функциональные конвейеры

Вы могли заметить, что оператор |> используется в предыдущих примерах кода. Он очень похож на конвейеры в unix: принимает что-то слева от себя и передает на вход чему-то справа. Этот оператор (называется «pipe» или «pipeline») используется для создания функциональных конвейеров. Вот пример:

let square x = x * x

let isOdd x = x % 2 <> 0

let getOddSquares items =

items

|> Seq.filter isOdd

|> Seq.map squareВ данном примере сначала items передается на вход функции Seq.filter. Затем возвращаемое значение Seq.filter (последовательность) передается на вход функции Seq.map. Результат выполнения Seq.map является выходным значением функции getOddSquares.

Конвейерный оператор очень удобно использовать, поэтому редко кто обходится без него. Возможно, это одна из самых любимых возможностей F#!

F#: типы

Поскольку F# — язык платформы .NET, в нем существуют те же примитивные типы, что и C#: string, int и так далее. Он использует объекты .NET и поддерживает четыре основных столпа объектно-ориентированного программирования. F# предоставляет кортежи (tuples), а также два основных типа, которые отсутствуют в C#: записи (records) и размеченные объединения (discriminated unions).

Запись — это группа упорядоченных именованных значений, которая автоматически реализует операцию сравнения — в самом буквальном смысле. Не нужно задумываться о том, как происходит сравнение: через равенство ссылок или с помощью пользовательского определения равенства между двумя объектами. Записи — это значения, а значения можно сравнивать. Они являются типами-произведениями, если говорить на языке теории категорий. У них есть множество применений, однако одно из самых очевидных — их можно использовать в качестве POCO или POJO.

open System

// Вот так вы можете определить тип-запись.

// Можно располагать метки на новых строках

type Person =

{ Name: string

Age: int

Birth: DateTime }

// Создать новую запись `Person` можно примерно так.

// Если метки расположены на одной строке, они разделяются точкой с запятой

let p1 = { Name="Charles"; Age=27; Birth=DateTime(1990, 1, 1) }

// Или же можно располагать метки на новых строках

let p2 =

{ Name="Moulaye"

Age=22

Birth=DateTime(1995, 1, 1) }

// Записи можно сравнивать на равенство. Не нужно определять метод Equals() и GetHasCode().

printfn "Они равны? %b" (p1 = p2) // Это выведет `false`, потому что они не равны.Другой основной тип в F# — это размеченные объединения, или РО, или DU в англоязычной литературе. РО — это типы, представляющие некоторое количество именованных вариантов. На языке теории категорий это называется типом-суммой. Они также могут быть определены рекурсивно, что значительно упрощает описание иерархических данных.

// Определим обобщенное бинарное дерево поиска.

//

// Заметим, что обобщенный тип-параметр имеет ' в начале.

type BST<'T> =

| Empty

| Node of 'T * BST<'T> * BST<'T> // Каждый узел имеет левый и правый BST<'T>

// Развернем BST с помощью сопоставления с образцом!

let rec flip bst =

match bst with

| Empty -> bst

| Node(item, left, right) -> Node(item, flip right, flip left)

// Определим пример BST

let tree =

Node(10,

Node(3,

Empty,

Node(6,

Empty,

Empty)),

Node(55,

Node(16,

Empty,

Empty),

Empty))

// Развернем его!

printfn "%A" (flip tree)Тадам! Вооружившись мощью размеченных объединений и F#, вы можете пройти любое собеседование, в котором требуется развернуть бинарное дерево поиска.

Наверняка вы увидели странный синтаксис в определении варианта Node. Это на самом деле сигнатура кортежа. Это означает, что определенное нами BST может быть или пустым, или являться кортежем (значение, левое поддерево, правое поддерево). Более подробно про это написано в разделе о сигнатурах.

Собираем всё вместе: синтаксис F# за 60 секунд

Следующий пример кода представлен с разрешения Скотта Влашина, героя сообщества F#, написавшего этот прекрасный обзор F# синтаксиса. Вы прочтете его примерно за минуту. Пример был немного отредактирован.

// Данный код представлен с разрешения автора, Скотта Влашина. Он был немного модифицирован.

// Для однострочных комментариев используется двойной слеш.

(*

Многострочные комментарии можно сделать вот так (хотя обычно используют двойной слеш).

*)

// ======== "Переменные" (на самом деле нет) ==========

// Ключевое слово "let" определяет неизменяемое (иммутабельное) значение

let myInt = 5

let myFloat = 3.14

let myString = "привет" // обратите внимание - указывать тип не нужно

// ======== Списки ============

let twoToFive = [ 2; 3; 4; 5 ] // Списки создаются с помощью квадратных скобок,

// для разделения значений используются точки с запятой.

let oneToFive = 1 :: twoToFive // оператор :: создает список с новым первым элементом

// Результат: [1; 2; 3; 4; 5]

let zeroToFive = [0;1] @ twoToFive // оператор @ объединяет два списка

// ВАЖНО: запятые никогда не используются для разделения значений, только точки с запятой!

// ======== Функции ========

// Ключевое слово "let" также определяет именованную функцию.

let square x = x * x // Обратите внимание - скобки не используются.

square 3 // А сейчас вызовем функцию. Снова никаких скобок.

let add x y = x + y // не используйте add (x,y)! Это означает

// совершенно другую вещь.

add 2 3 // Вызовем фукнкцию.

// чтобы определить многострочную функцию, просто используйте отступы.

// Точки с запятой не требуются.

let evens list =

let isEven x = x % 2 = 0 // Определет "isEven" как внутреннюю ("вложенную") функцию

List.filter isEven list // List.filter - это библиотечная функция

// с двумя параметрами: предикат

// и список, которые требуется отфильтровать

evens oneToFive // Вызовем функцию

// Вы можете использовать скобки, чтобы уточнить приоритет.

// В данном примере, сначала используем "map" с двумя аргументами,

// а потом вызываем "sum" для результата.

// Без скобок "List.map" была бы передана как аргумент в "List.sum"

let sumOfSquaresTo100 =

List.sum (List.map square [ 1 .. 100 ])

// Вы можете передать результат одной функции в следующую с помощью "|>"

// Вот та же самая функция sumOfSquares, переписанная с помощью конвейера

let sumOfSquaresTo100piped =

[ 1 .. 100 ] |> List.map square |> List.sum // "square" определена раньше

// вы можете определять лямбда-функции (анонимные функции)

// с помощью ключевого слова "fun"

let sumOfSquaresTo100withFun =

[ 1 .. 100 ] |> List.map (fun x -> x * x) |> List.sum

// В F# значения возвращаются неявно - ключевое слово "return" не используется

// Функция всегда возвращает значение последнего выражения в ее теле

// ======== Сопоставление с образцом ========

// Match..with.. - это case/switch инструкции "на стероидах".

let x = "a"

match x with

| "a" -> printfn "x - это a"

| "b" -> printfn "x - это b"

| _ -> printfn "x - это что-то другое" // подчеркивание соответствует "чему угодно"

// Some(..) и None приблизительно соответствуют оберткам Nullable

let validValue = Some(99)

let invalidValue = None

// В данном примере match..with сравнивает с "Some" и "None"

// и в то же время распаковывает значение в "Some".

let optionPatternMatch input =

match input with

| Some i -> printfn "целое число %d" i

| None -> printfn "входное значение отсутствует"

optionPatternMatch validValue

optionPatternMatch invalidValue

// ========= Сложные типы данных =========

// Кортежи - это пары, тройки значений и так далее.

// Кортежи используют запятые.

let twoTuple = (1, 2)

let threeTuple = ("a", 2, true)

// Записи имеют именованные поля. Точки с запятой являются разделителями.

type Person = { First: string; Last: string }

let person1 = { First="John"; Last="Doe" }

// Вы можете также использовать переносы на новую строку

// вместо точек с запятой.

let person2 =

{ First="Jane"

Last="Doe" }

// Объединения представляют варианты. Разделитель - вертикальная черта.

type Temp =

| DegreesC of float

| DegreesF of float

let temp = DegreesF 98.6

// Типы можно комбинировать рекурсивно различными путями.

// Например, вот тип-объединение, который содержит список

// элементов того же типа:

type Employee =

| Worker of Person

| Manager of Employee list

let jdoe = { First="John"; Last="Doe" }

let worker = Worker jdoe

// ========= Вывод на экран =========

// Функции printf/printfn схожи с функциями Console.Write/WriteLine из C#.

printfn "Вывод на экран значений типа int %i, float %f, bool %b" 1 2.0 true

printfn "Строка %s, и что-то обобщенное %A" "hello" [ 1; 2; 3; 4 ]

// все сложные типы имеют встроенный красивый вывод

printfn "twoTuple=%A,\nPerson=%A,\nTemp=%A,\nEmployee=%A"

twoTuple person1 temp worker В дополнение, в нашей официальной документации для .NET и поддерживаемых языков есть материал «Тур по F#».

Что делать дальше

Всё описанное в данном посте — лишь поверхностные возможности F#. Мы надеемся, что после прочтения этой статьи вы сможете погрузиться в F# и функциональное программирование. Вот несколько примеров того, что можно написать в качестве упражнения для дальнейшего изучения F#:

- Используйте F#, чтобы построить прекрасные фрактальные деревья.

- Используйте F# для исследования и анализа данных о вселенной Симпсонов в Azure Notebooks.

- Используйте F# и Suave для разработки веб-приложений.

- Используйте F# при разработке serverless-приложений и компонентов с помощью Azure Functions.

Есть очень много других задач, для которых можно использовать F#; предыдущий список ни в коем случае не является исчерпывающим. F# используется в различных приложениях: от простых скриптов для сборки до бэкенда интернет-магазинов с миллиардной выручкой. Нет никаких ограничений по проектам, для которых вы можете использовать F#.

Дополнительные ресурсы

Для F# существует множество самоучителей, включая материалы для тех, кто пришел с опытом C# или Java. Следующие ссылки могут быть полезными по мере того, как вы будете глубже изучать F#:

Также описаны еще несколько способов, как начать изучение F#.

И наконец, сообщество F# очень дружелюбно к начинающим. Есть очень активный чат в Slack, поддерживаемый F# Software Foundation, с комнатами для начинающих, к которым вы можете свободно присоединиться. Рекомендуем вам это сделать!

Не забудьте посетить сайт русскоязычного сообщества F#! Если у вас возникнут вопросы по изучению языка, мы будем рады обсудить их в чатах:

- комната

#ru_generalв Slack-чате F# Software Foundation - чат в Telegram

- чат в Gitter

Об авторах перевода

Статья переведена усилиями русскоязычного сообщества F#-разработчиков.

Статья переведена усилиями русскоязычного сообщества F#-разработчиков.

Мы также благодарим @schvepsss за подготовку данной статьи к публикации.

|

Метки: author Schvepsss программирование mono и moonlight c# .net блог компании microsoft microsoft f# fsharplangru microsoft research |

Дайджест свежих материалов из мира фронтенда за последнюю неделю №275 (7 — 13 августа 2017) |

| Медиа |

| Веб-разработка |

| CSS |

| Javascript |

| Браузеры |

| Занимательное |

Медиа

Медиа

Подкаст «Веб-стандарты», Выпуск №80 : Firefox 55, Samsung есть, Safari виднее, алгоритмы и паттерны, прозрачный JPG, Телеграм, приоритеты загрузки, фокусы, модули в Node.js.

Подкаст «Веб-стандарты», Выпуск №80 : Firefox 55, Samsung есть, Safari виднее, алгоритмы и паттерны, прозрачный JPG, Телеграм, приоритеты загрузки, фокусы, модули в Node.js. Подкаст «Пятиминутка React» #30 : setState и организация кода

Подкаст «Пятиминутка React» #30 : setState и организация кода Подкаст «Пятиминутка Angular» #1 : Angular 5 Beta 3, Angular CLI 1.3, CreateAngularComponents

Подкаст «Пятиминутка Angular» #1 : Angular 5 Beta 3, Angular CLI 1.3, CreateAngularComponents Подкаст «Фронтенд Юность (18+)» #14: Все секреты производительности фронтенда

Подкаст «Фронтенд Юность (18+)» #14: Все секреты производительности фронтенда Подкаст «devschacht», Выпуск №6: Готовим с фронтендером: одна часть Node.js, одна часть CSS-in-JS, густо приправить ФРП, добавить щепотку корутин и чайную ложечку зелёных тредов.

Подкаст «devschacht», Выпуск №6: Готовим с фронтендером: одна часть Node.js, одна часть CSS-in-JS, густо приправить ФРП, добавить щепотку корутин и чайную ложечку зелёных тредов. Подкаст «Drinkcast» #3: «Раньше дивы были зеленее»

Подкаст «Drinkcast» #3: «Раньше дивы были зеленее» Нужно ли фронтендеру знать алгоритмы и паттерны проектирования?. Игорь Алексеенко в HTML Шортах

Нужно ли фронтендеру знать алгоритмы и паттерны проектирования?. Игорь Алексеенко в HTML Шортах Totally Tooling Tips: Webpack Tips. Регулярное шоу от разработчиков Google Chrome, в этом выпуске советы по Webpack

Totally Tooling Tips: Webpack Tips. Регулярное шоу от разработчиков Google Chrome, в этом выпуске советы по Webpack

Веб Разработка

Веб Разработка

О чем всегда стоит помнить при локализации веб-сайта, чтобы потом не было стыдно

О чем всегда стоит помнить при локализации веб-сайта, чтобы потом не было стыдно Ускорьте ваш сайт с помощью машинного обучения

Ускорьте ваш сайт с помощью машинного обучения Календарь событий по фронтенду. Конференции, встречи и другие события по фронтенду во всём мире в одном календаре.

Календарь событий по фронтенду. Конференции, встречи и другие события по фронтенду во всём мире в одном календаре.- W3C рассматривает вопрос перевода предыдущих спецификаций HTML в разряд устаревших

- Урок-введение по WebAssembly на примере игры «Жизнь»

.NET и WebAssembly — это будущее фронтенда?

.NET и WebAssembly — это будущее фронтенда?

Какие функции Progressive Web App будет поддерживать Apple?

Какие функции Progressive Web App будет поддерживать Apple?- SEO

- Google призывает оптимизаторов помочь JS-разработчикам понять SEO

JavaScript и SEO: разница между Crawling и Indexing

JavaScript и SEO: разница между Crawling и Indexing

Разработчик из Shuvayatra делится опытом внедрения Progressive Web App в контексте SEO

Разработчик из Shuvayatra делится опытом внедрения Progressive Web App в контексте SEO

- Инструменты:

Вредоносный код в npm-пакетах и борьба с ним

Вредоносный код в npm-пакетах и борьба с ним Официальный релиз Bootstrap 4 beta наконец состоялся. Переход с Bootstrap 4 Alpha 6 на Beta

Официальный релиз Bootstrap 4 beta наконец состоялся. Переход с Bootstrap 4 Alpha 6 на Beta

JPNG.svg — прозрачный PNG с JPEG компрессией

JPNG.svg — прозрачный PNG с JPEG компрессией

- Accessibility:

- Анимация:

- Еженедельная подборка красивых эффектов на CSS/SVG/JS #48

Transitions with JavaScript: коллекция небольших Chrome-only демок от Ana Tudor (CSS переменные плюс немного JS)

Transitions with JavaScript: коллекция небольших Chrome-only демок от Ana Tudor (CSS переменные плюс немного JS) Производительные веб-анимации и интерактив: достигаем 60 FPS

Производительные веб-анимации и интерактив: достигаем 60 FPS Креативные переходы между страницами с эффектом морфинга

Креативные переходы между страницами с эффектом морфинга Руководство по покадровой анимации с помощью CSS и JavaScript

Руководство по покадровой анимации с помощью CSS и JavaScript

CSS

CSS

- Свойства для интервалов (*-gap) становятся универсальными

- Модуль CSS-изоляции (CSS Containment Level 1) стал кандидатом в рекомендации

Практическое руководство по использованию CSS Modules в React приложениях

Практическое руководство по использованию CSS Modules в React приложениях Изоляция css стилей с помощью компонентного подхода

Изоляция css стилей с помощью компонентного подхода Развенчание мифов о Hex цветах в CSS

Развенчание мифов о Hex цветах в CSS Font-size: неожиданно сложное CSS-свойство

Font-size: неожиданно сложное CSS-свойство  Shadow DOM: Быстрые и инкапсулированные стили

Shadow DOM: Быстрые и инкапсулированные стили Веб-шрифты: когда вы нуждаетесь в них, а когда нет

Веб-шрифты: когда вы нуждаетесь в них, а когда нет Наследование в CSS: введение

Наследование в CSS: введение Лучший способ сделать “Wrapper”-обертку на CSS

Лучший способ сделать “Wrapper”-обертку на CSS Flex Grow и Flex Basis: адаптивная раскладка страниц

Flex Grow и Flex Basis: адаптивная раскладка страниц- CSS Grid Layout:

- Вёрстка реальных проектов на гридах (CSS Grid Layout) уже сейчас

Разница между явными и неявными сетками

Разница между явными и неявными сетками Простые Sass миксины для улучшения браузерной совместимости для CSS Grid Layouts

Простые Sass миксины для улучшения браузерной совместимости для CSS Grid Layouts Изменения в спецификации Grid и использование многоколоночного макета

Изменения в спецификации Grid и использование многоколоночного макета Создание графиков на CSS с помощью гридов и пользовательских свойств

Создание графиков на CSS с помощью гридов и пользовательских свойств

chrome-css-grid-highlighter — Chrome-расширение для подсветки CSS Grid Layout

chrome-css-grid-highlighter — Chrome-расширение для подсветки CSS Grid Layout

JavaScript

JavaScript

ES Modules в Node уже сегодня. Анонс нового загрузчика standard/esm

ES Modules в Node уже сегодня. Анонс нового загрузчика standard/esm JavaScript для людей, которые ненавидят JavaScript

JavaScript для людей, которые ненавидят JavaScript Машинное обучение в Javascript. Слайды с обзором возможностей

Машинное обучение в Javascript. Слайды с обзором возможностей JavaScript паттерны: паттерн Observer

JavaScript паттерны: паттерн Observer Как все время быть в теме экосистемы JavaScript?

Как все время быть в теме экосистемы JavaScript? Как на самом деле работает JavaScript: часть 1

Как на самом деле работает JavaScript: часть 1- Практика:

Ленивая загрузка изображений с помощью Intersection Observer

Ленивая загрузка изображений с помощью Intersection Observer Бинарный поиск в JavaScript. Практический пример

Бинарный поиск в JavaScript. Практический пример Как мы создали наше первое full-stack JavaScript приложение за три недели. Простое пошаговое руководство от идеи до запуска

Как мы создали наше первое full-stack JavaScript приложение за три недели. Простое пошаговое руководство от идеи до запуска Улучшаем разговоры с помощью Perspective API

Улучшаем разговоры с помощью Perspective API Как создать UI поиска по GitHub за 60 минут

Как создать UI поиска по GitHub за 60 минут

VueJS:

VueJS:

Лучшие мобильные компоненты для PWA в VueJs

Лучшие мобильные компоненты для PWA в VueJs React + Webpack: замешательство, фрустрация и как Vue.js может помочь

React + Webpack: замешательство, фрустрация и как Vue.js может помочь Компонент Yandex Maps для VueJS

Компонент Yandex Maps для VueJS

React:

React:

Почему React лучше, чем Vue.js. И когда.

Почему React лучше, чем Vue.js. И когда.

React Progressive Web Apps — часть Part 1

React Progressive Web Apps — часть Part 1 Получение данных из API с React.JS

Получение данных из API с React.JS Использование Create React App с Relay Modern

Использование Create React App с Relay Modern

react-beautiful-dnd — доступные drag and drop для списков с React.js

react-beautiful-dnd — доступные drag and drop для списков с React.js

Angular:

Angular:

Как Angular защищает нас от XSS атак?

Как Angular защищает нас от XSS атак? MEAN Stack: разработка приложения с помощью Angular 2+ и Angular CLI

MEAN Stack: разработка приложения с помощью Angular 2+ и Angular CLI Избегайте общих проблем с модулями в Angular

Избегайте общих проблем с модулями в Angular

- Libs & Plugins:

js-meter — инструмент для измерения производительности времени выполнения, CPU, RAM и кучи javascript кода

js-meter — инструмент для измерения производительности времени выполнения, CPU, RAM и кучи javascript кода

posterus — компонуемые асинхронные примитивы (futures) с реальной отменой, управлением расписанием и корутинами

posterus — компонуемые асинхронные примитивы (futures) с реальной отменой, управлением расписанием и корутинами

nanoid — крошечный генератор уникальных ID, дружественный к URL

nanoid — крошечный генератор уникальных ID, дружественный к URL react-simple-maps — SVG карты с d3-geo и topojson

react-simple-maps — SVG карты с d3-geo и topojson DisplayJS — быстрый и простой JS фреймворк для создания амбициозных UI, местами похожий на jQuery

DisplayJS — быстрый и простой JS фреймворк для создания амбициозных UI, местами похожий на jQuery

Браузеры

Браузеры

У Mozilla есть план, как победить Chrome. Встречайте Firefox 57 и боевую лисичку в броне

У Mozilla есть план, как победить Chrome. Встречайте Firefox 57 и боевую лисичку в броне  Релиз Firefox 55, разбор деталей от Марата Таналина

Релиз Firefox 55, разбор деталей от Марата Таналина

Firefox 55: first desktop browser to support WebVR

Firefox 55: first desktop browser to support WebVR Фишеры уже два месяца «охотятся» на разработчиков расширений для Chrome

Фишеры уже два месяца «охотятся» на разработчиков расширений для Chrome- Выпуск web-браузера Opera 47

Релиз Safari Technology Preview Release 37

Релиз Safari Technology Preview Release 37

Занимательное

Занимательное

- Новый рубеж взят: стоимость биткоина превысила $4000

- Foursquare снова обновил Swarm. Теперь это журнал ваших путешествий

- Facebook представила похожий на YouTube видеосервис с пользовательскими и профессиональными видео

- SoundCloud нашла финансирование для дальнейшей работы и сменила гендиректора

- Криптовалюты и блокчейн: история и перспективы рынка

- Киберспорт могут включить в программу Олимпийских игр 2024 года

- «Дефейс» дорожных знаков может дезориентировать беспилотные автомобили

- Бот OpenAI победил трёх топовых профессионалов в Dota 2

- Как устроен «Яндекс.Навигатор». Как алгоритм строит маршрут, откуда берутся данные о пробках и будет ли сервис платным

Алгоритмы компрессии — введение с хорошей визуализацией

Алгоритмы компрессии — введение с хорошей визуализацией

Руководство по участию в Open Source

Руководство по участию в Open Source

Просим прощения за возможные опечатки или неработающие/дублирующиеся ссылки. Если вы заметили проблему — напишите пожалуйста в личку, мы стараемся оперативно их исправлять.

Дайджест за прошлую неделю.

Материал подготовили dersmoll и alekskorovin.

|

Метки: author alexzfort разработка веб-сайтов javascript html css дайджест фронтенд js es6 vue react angular html5 браузеры ссылки |

Цифровая экономика должна быть цифровой |

Источник

«Экономика должна быть экономной – таково требование времени»

Л.И.Брежнев (из отчетного доклада на XXVI съезде КПСС, 1981 г.)