Трёхуровневая модель сети и технологии VLAN, DHCP, OSPF, STP, SNMP, ACL, NTP на Cisco и D-Link |

Статья поможет новичкам понять как настраивать оборудование Cisco и D-Link в трёхуровневой модели сети. Конфигурация, представленная тут, не является эталонной или базовой — она для примера и понимания сути вещей, т.к. для каждого сетевого решения применяются свои параметры и технологии.

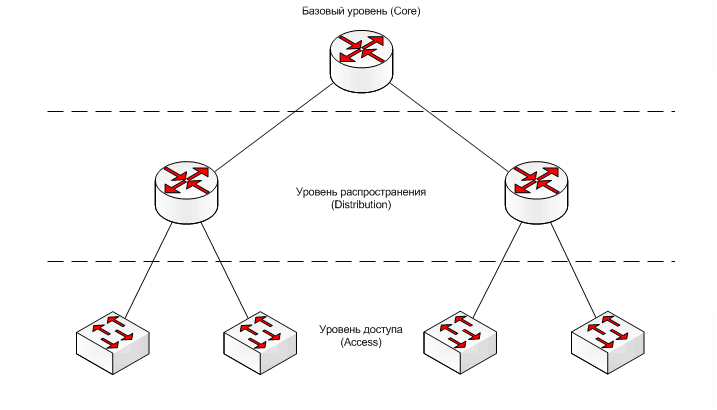

Теория трёхуровневой модели

Рассмотрим следующую схему трёхуровневой иерархической модели, которая используется во многих решениях построения сетей:

Распределение объектов сети по уровням происходит согласно функционалу, который выполняет каждый объект, это помогает анализировать каждый уровень независимо от других, т.е. распределение идёт в основном не по физическим понятиям, а по логическим.

Базовый уровень (Core)

На уровне ядра необходима скоростная и отказоустойчивая пересылка большого объема трафика без появления задержек. Тут необходимо учитывать, что ACL и неоптимальная маршрутизация между сетями может замедлить трафик.

Обычно при появлении проблем с производительностью уровня ядра приходиться не расширять, а модернизировать оборудование, и иногда целиком менять на более производительное. Поэтому лучше сразу использовать максимально лучшее оборудование не забывая о наличии высокоскоростных интерфейсов с запасом на будущее. Если применяется несколько узлов, то рекомендуется объединять их в кольцо для обеспечения резерва.

На этом уровне применяют маршрутизаторы с принципом настройки — VLAN (один или несколько) на один узел уровня Distribution.

Уровень распространения (Distribution)

Тут происходит маршрутизация пользовательского трафика между сетями VLAN’ов и его фильтрация на основе ACL. На этом уровне описывается политика сети для конечных пользователей, формируются домены broadcast и multicast рассылок. Также на этом уровне иногда используются статические маршруты для изменения в маршрутизации на основе динамических протоколов. Часто применяют оборудование с большой ёмкостью портов SFP. Большое количество портов обеспечит возможность подключения множества узлов уровня доступа, а интерфейс SFP предоставит выбор в использовании электрических или оптических связей на нижестоящий уровень. Также рекомендуется объедение нескольких узлов в кольцо.

Часто применяются коммутаторы с функциями маршрутизации (L2/3) и с принципом настройки: VLAN каждого сервиса на один узел уровня Access.

Уровень доступа (Access)

К уровню доступа непосредственно физически присоединяются сами пользователи.

Часто на этом уровне трафик с пользовательских портов маркируется нужными метками DSCP.

Тут применяются коммутаторы L2 (иногда L2/3+) с принципом настройки: VLAN услуги на порт пользователя + управляющий VLAN на устройство доступа.

Практическое применение сетевых технологий в трёхуровневой модели

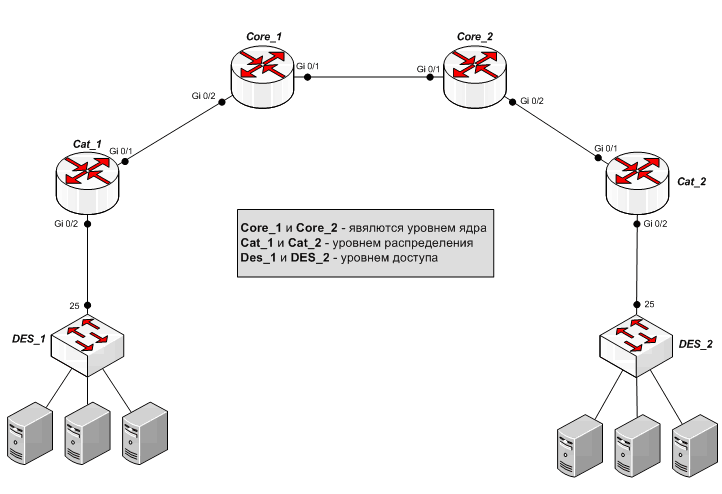

При рассмотрении следующих технологий используется оборудование уровня ядра и распределения Cisco Catalyst, а для уровня доступа — D-Link DES. На практике такое разделение брендов часто встречается из-за разницы в цене, т.к. на уровень доступа в основном необходимо ставить большое количество коммутаторов, наращивая ёмкость портов, и не все могут себе позволить, чтобы эти коммутаторы были Cisco.

Соберём следующую схему:

Схема упрощена для понимания практики: каждое ядро включает в себя только по одному узлу уровня распределения, и на каждый такой узел приходится по одному узлу уровня доступа.

На практике при больших масштабах сети смысл подобной структуры в том, что трафик пользователей с множества коммутаторов уровня доступа агрегируется на родительском узле распределения, маршрутизируется или коммутируется по необходимости на вышестоящее ядро, на соседний узел распределения или непосредственно между самими пользователями с разных узлов доступа. А каждое ядро маршрутизирует или коммутирует трафик между несколькими узлами распределения, которые непосредственно включены в него, или между соседними ядрами.

|

|

Установка, настройка и оптимизация Windows Vista - Часть I |

1.1 - Версии Vista:

Начнём знакомство с Windows Vista с выбора версии. Существует 6 изданий (+ 64-битные издания - не рекомендую ставить при объёме оперативной памяти менее 4 гигабайт): Starter (не распространяется в странах с развитым технологическим рынком - рассматривать не будем), Home Basic, Home Premium, Business, Enterprise (предназначен для крупных компаний - рассматривать не будем) и Ultimate. Далее я привожу ссылки на таблицы с возможностями всех изданий, изучив которые, Вы сможете выбрать подходящую для себя версию.

Сравнительная таблица на сайте Microsoft:

http://www.microsoft.com/rus/windows/products/windowsvista/editions/choose.mspx

Сравнительная таблица в формате Microsoft Office:

http://cp.people.overclockers.ru/cgi-bin/dl.pl?id=32170&filename=Windows_Vista.xls

Сравнительная таблица в формате OpenOffice.org:

http://cp.people.overclockers.ru/cgi-bin/dl.pl?id=32171&filename=Windows_Vista.ods

1.2 - Реестр Windows:

После того, как определились с выбором версии, мы рассмотрим анатомию реестра на примере работы во встроеном редакторе RegEdit (запускается через «Пуск > Выполнить > regedit»).

В левом окне редактора расположена древовидная панель, содержащая разделы и ветки реестра:

HKEY_CLASSES_ROOT - включает в себя информацию о зарегистрированных в системе типах файлов, порядке обработки файлов каждого типа, а также управлении основными настройками интерфейса.

HKEY_CURRENT_USER - содержит информацию об активном пользователе, а также о различных настройках системы, относящихся к текущему пользователю.

HKEY_LOCAL_MACHINE - хранит информацию об аппаратной конфигурации компьютера и установленном программном обеспечении (настройки данного раздела относятся ко всем пользователям).

HKEY_USERS - включает в себя информацию обо всех пользователях данного компьютера.

HKEY_CURRENT_CONFIG - хранит информацию о настройках оборудования, используемого компьютером.

В правом окне расположены параметры реестра, с у казанием формата данных и их значениях. Всего существует пять типов параметров:

Строковый параметр - REG_SZ (текстовая строка) - используется чаще всего.

Двоичный параметр - REG_BINARY (двоичные данные) - этот тип данных используется, например, для хранения сведений об аппаратных ресурсах.

Параметр DWORD - REG_DWORD (целое число) - может использоваться, например, в качестве переключателя (1 - включение, 0 - выключение) или для указания параметров драйверов.

Мультистроковый параметр - REG_MULTI_SZ (многострочный текст) - использыется для представления списков и иных подобных записей в удобном для чтения формате.

Расширяемый строковый параметр - REG_EXPAND_SZ (расширенная строка) - используется для ссылок на файлы.

В статье я буду приводить настройки реестра в таком виде:

[HKEY_CURRENT_USER\Control Panel\International]

"s1159"="Extreme"

"s2359"="Extreme"

"sTimeFormat"="H:mm:ss tt"

В квадратных скобках указана ветка реестра (при отсутствии нужно создать вручную). Если перед названием ветки написан минус, то для изменения настроек нужно удалить данную ветку. Например:

[-HKEY_CURRENT_USER\Control Panel\International]

Удалять нужно только последнюю ветку, написанную в пути (в данном примере удаляем ветку International).

Также можно создать текстовый файл с настройками реестра и сменить расширение .txt на .reg. Например, создаём файл Registry.reg с содержимым:

Windows Registry Editor Version 5.00

[HKEY_CURRENT_USER\Control Panel\International]

"s1159"="Extreme"

"s2359"="Extreme"

"sTimeFormat"="H:mm:ss tt"

После запуска созданного файла и перезагрузки компьютера изменения вступят в силу.

Можно скачать готовый реестровый файл, содержащий все настройки из статьи с уже вписанными рекомендованными значениями и комментариями:

http://cp.people.overclockers.ru/cgi-bin/dl.pl?id=32400&filename=Windows_Vista.reg

Внимание! Перед установкой операционной системы рекомендуется обновить и правильно настроить BIOS (отключить не используемые контроллеры, установить значения вручную, вместо «Авто»), а также скачать новые версии драйверов и прошивок на всё оборудование. Это избавит Вас от лишних проблем и увеличит производительность системы.

2.1 - Начало установки:

После запуска установки системы с загрузочного диска вы увидите окно с тремя списками:

- устанавливаемый язык (русский) - язык интерфейса операционной системы

- формат времени и денежных единиц (русский - Россия) - национальный стандарт отображения времени, даты и валют

- раскладка клавиатуры или метод ввода (русская) - указывает раскладку клавиатуры по умолчанию

Нажимаем кнопку «Далее» и видим следующее окно с предложением начать установку системы. Нажимаем кропку «Установить».

В данном окне вводим лицензионный 25-значный ключ (указан на наклейке, поставляемой с дистрибутивом операционной системы), ставим галочку «Автоматически активировать Windows при подключении к Интернету» и нажимаем кнопку «Далее».

Совет! Если вы хотите установить систему для ознакомления, пропустите ввод ключа нажав кнопку «Далее». Подтвердите свои намерения нажав кнопку «Да» в появившемся окне. В следующем окне укажите нужную версию операционной системы вручную. Поставьте галочку «Выбран приобретённый выпуск Windows» и нажмите кнопку «Далее».

В очередном окне установки вам предложат ознакомиться с текстом лицензионного соглашения корпорации Microsoft. Ознакомьтесь с ним, поставьте галочку «Я принимаю условия лицензии» и нажмите кнопку «Далее». Выбираем «Полная установка» и переходим к настройке жёсткого диска.

2.2 - Создание логических дисков:

Внимание! Все действия описанные в данном разделе, чреваты уничтожением хранящейся на жёстком диске информации.

Совет! Чтобы Windows определяла чёткое значение объёма (например, 35.0 гигабайт), при создании раздела нужно за 1 гигабайт брать 1024 мегабайта и прибавлять ещё 3 мегабайта. Например, расчёт для раздела в 35 гигабайт будет выглядеть так: 35*1024+3=35843 - система определит как 35.0 гигабайт (раздел на 30*1024+3=30723, т.е. ровно 30.0 гигабайт). Если вводить как 35*1024=35840, то система определит 34.9 гигабайта.

Начнём с удаления всех дисковых разделов (если они уже были созданы). Для этого выбираем в списке раздел и нажимаем «Удалить» (проделываем эти действия, пока не удалим все имеющиеся разделы). Теперь создадим новые:

- первый раздел под систему и установленные программы (рекомендую 35 гигабайт - этого хватит с запасом под нормально настроенную систему)

- второй (если нужно, создаём третий и т.д.) раздел под установленные игры, фильмы, музыку и прочее (отводим всё оставшееся пространство или делим на несколько разделов, как Вам удобнее)

После их успешного создания выбираем раздел и нажимаем «Форматировать» (проделаваем данную операцию со всеми созданными разделами), выбираем диск С и переходим к процессу установки (за время установки компьютер несколько раз перезагрузится) нажав кнопку «Далее».

2.3 - Завершение установки:

По завершении установки появится окно настройки пользователя. В графе «Введите имя пользователя» вводим любое название не превышающее 20 знаков, а также можно ввести пароль в графах «Введите пароль» и «Подтверждение пароля». Выбираем понравившийся значок для учётной записи и жмём кнопку «Далее».

Теперь выбираем способ защиты операционной системы и настройки автоматических обновлений из предложенных вариантов (рекомендую выбрать пункт «Отложить решение») и попадаем в окно установки времени и даты. Тут мы выбираем часовой пояс, соответствующий географической точке проживания, проверяем правильно ли указана дата и ставим галочку «Автоматический переход на летнее время и обратно».

После нажатия кнопки «Далее» установка системы будет завершена и запустится тест производительности ПК. По окончании теста перезагружаем компьютер и переходим к настройке Windows Vista.

Внимание! Перед установкой обновлений и драйверов желательно перейти в пользователя «Администратор» (т.к. возможны глюки при установке из обычного пользователя).

3.1 - Переход в пользователя «Администратор»:

Для версий Home Basic и Home Premium:

Для включения пользователя «Администратор» открываем «Пуск > Все программы > Стандартные > Командная строка (правой кнопкой мыши - «Запуск от имени администратора»)». В открывшемся окне вводим команду:

«net user Администратор /active:yes» - включает пользователя «Администратор».

«net user Администратор /active:no» - выключает пользователя «Администратор».

Перезагружаем компьютер, заходим в «Пуск > Панель управления > Учётные записи пользователей и семейная безопасность > Добавление и удаление учётных записей пользователей» и удаляем всех пользователей (нажимаем на имя пользователя, которого хотим удалить и в появившемся окне жмём строчку «Удалить»), кроме «Администратор» и «Гость» .

Далее выбираем пользователя «Администратор» и в открывшемся окне нажимаем «Изменение имени учётной записи». Вводим имя пользователя, созданного при установке (можно другое, но к примеру, при установке OpenOffice.org будет отображаться именно то имя пользователя, которое указывалось при установке) и нажимаем кнопку «Применить». Так же можно установить пароль нажав строчку «Создание пароля» и сменить иконку пользователя нажав строчку «Изменение рисунка» (в появившемся окне выбираем рисунок и жмём кнопку «Изменение рисунка»). После выполнения всех описанных действий перезагружаем компьютер.

Для версий Business и Ultimate:

Открываем «Пуск > Панель управления > Система и её обслуживание > Администрирование > Управление компьютером > Локальные пользователи и группы (в левой части окна) > Пользователи». Удаляем всех пользователей, кроме «Администратор» и «Гость». Переименовываем их (правой кнопкой мыши - «Преименовать»), например, в Admin и Guest. Устанавливаем пароли на пользователей (правой кнопкой мыши - «Задать пароль...»).

Далее открываем свойства пользователя «Администратор» (правой кнопкой мыши - «Свойства»). В открывшемся окне вводим имя пользователя, созданного при установке (можно другое, но к примеру, при установке OpenOffice.org будет отображаться именно то имя пользователя, которое указывалось при установке), убираем галочку «Отключить учётную запись» и нажимаем кнопку «Применить». Аналогичным образом задаём имя пользователю «Гость».

Перезагружаем компьютер и заходим в «Пуск > Панель управления > Учётные записи пользователей и семейная безопасность > Изменение рисунка учётной записи». В появившемся окне выбираем рисунок и жмём кнопку «Изменение рисунка»). Перезагружаем компьютер ещё раз.

3.2 - Установка обновлений:

Сразу после загрузки системы запускаем установку Service Pack 1 (если он не был интегрирован в дистрибутив). Как появится окно, сообщающее об окончании установки, запускаем установку Service Pack 2 (если он не был интегрирован в дистрибутив). По окончании его установки перезагружаем компьютер и устанавливаем дополнительные обновления (DirectX, Framework, Internet Explorer, обновления безопасности и т.п.). Перезагружаем компьютер ещё раз и переходим к установке драйверов.

3.3 - Установка драйверов:

Драйверы устанавливаются в следующем порядке - на материнскую плату (чипсет), видеокарту, звуковую карту, сетевую карту, и на всё оставшееся оборудование (после установки каждого драйвера желательно перезагружать компьютер - это избавит Вас от возможных проблем со стабильностью системы).

3.4 - Обновление «Индекс производительности Windows»:

Внимание! Обновление индекса необходимо для дальнейшей настройки интерфейса системы (если индекс производительности не обновлён, то при настройке визуальных эффектов Aero может отключиться).

После установки всех драйверов и перезагрузки компьютера заходим в «Пуск > Компьютер (правой кнопкой - свойства)». Открываем «Индекс производительности Windows» и нажимаем кнопку «Обновить». По окончании обновления индекса переходим к настройке системы.

3.5 - Механизм активации:

Если вы устанавливали систему для ознакомления без ввода ключа, то срок её работы ограничен 30 днями. Для увеличения срока работы без ключа, механизм активации позволяет выполнять сброс таймера. Для этого нужно зайти в «Пуск > Все программы > Стандартные», запустить командную строку с правами администратора (правой кнопкой - «Запуск от имени администратора») и ввести команду:

slmgr.vbs -rearm

После перезагрузки компьютера срок работы системы без ввода ключа будет составлять 30 дней.

3.6 - Реестр:

Всплывающее напоминание об активации:

[HKEY_LOCAL_MACHINE\SOFTWARE\Microsoft\Windows NT\CurrentVersion\SL\Activation]

"NotificationDisabled"=dword:00000001

NotificationDisabled - имеет значения 0 (напоминание включено) и 1 (напоминание отключено).

Отображение подробных сведений о действиях ОС при входе и выходе из системы:

[HKEY_LOCAL_MACHINE\Software\Microsoft\Windows\CurrentVersion\Policies\System]

"VerboseStatus"=dword:00000001

VerboseStatus - имеет значения 0 (сведения не отображаются) и 1 (сведения отображаются).

Читать продолжение подробнее >>>

http://stss.3dn.ru/publ/ustanovka_nastrojka_i_optimizacija_windows_vista_chast_i/1-1-0-251

|

|

Enterprise RAID дома от нечего делать |

И немножко слов про более мелкие массивы...

Однажды потеряв информацию на жестком диске не по собственной глупости или легкомыслию, а из-за причин форс-мажорных я стал параноиком. Уже много лет в корпусе моего ПК нет ни одного диска, который бы не был частью массива и ни одного массива, который не имел бы резервирования.

Сначала данное правило, написанное потом и слезами обходилось достаточно дёшево - небольшие по объёму диски, массивы без контроля четности, интегрированные или простенькие дискретные контроллеры... но с недавних пор стало откровенно не интересно апгрейдить процессор или видеокарту т.к. старых хватает для моих повседневных нужд и выходить из строя основа системы не собирается, а покупать новые железки исключительно из спортивного интереса уже просто спортивно не интересно... да и все домашние уже обеспечены моими "обносками". Старшее поколение играет в казуальные игры на разогнанном Opteron 185 с водяным охлаждением и парой 8800GTS в SLI, жена "донашивает" плоды увлечения маленькими HTPC, а младшее поколение прониклось плодами моего увлечения бесшумными ПК.

Решение проблемы оказалось на поверхности. Устраивают качественные характеристики - нужно увеличить количественные и поработать над формой.

Первым в ряду работы над формой и количеством стал монитор. Хороший матовый монитор диагональю 24" и с соотношением сторон 16х10 - вымирающий вид, но меня устраивает.

Потом был корпус, который выбирался с оглядкой на то, что дисков в нем будет много. В итоге нашлась модель с доступной ценой, компактными размерами и девятью отсеками под устройства размера 5,25". Сразу к корпусу были куплены три корзины, пара занимающих 3 отсека 5,25" и вмещающих по 5 устройств SATA/SAS 3,5" и одна занимающая 2 отсека 5,25" и вмещающая 3 устройства SATA/SAS 3,5". Итого, корпус достаточно стандартных размеров (E-ATX, но не Full Tower) позволил вместить и нормально охладить тринадцать жестких дисков и один оптический привод. Вкупе с блоком питания денег на данное решение было потрачено достаточно много, а значит и удовлетворение было большое! А тот факт, что корпус пришлось дорабатывать (спиливать ограничительные выступы между отсеками 5,25") только добавил радости.

Потратить около полутысячи долларов на нормальный аппаратный RAID контроллер с КЭШем, батарейкой и прочими пропеллерами долго не представлялось случая – либо жаба давила, либо контроллеры были так или иначе спорными. Но в один прекрасный момент стало понятно, что все мои дешевые и предсказуемые Promise TX4650/4660 массивы с контролем четности тянут откровенно плохо, а объём массива RAID10 упирается в смешную по моему мнению цифру четыре терабипа (или как их там зовут?) или в православные три целых и шестьдесят две сотых терабайта. А это во-первых мало, во-вторых, в случае наличия нескольких массивов требует обеспечения большой скорости передачи данных между ними для комфортной работы и в третьих, у меня же тринадцать дырочек под диски, это сколько ж десятых рейдов то надо? Да и не делится тринадцать на четыре..

Пробовал решать данную проблему посредством доступного, достойного и редкого в наших краях контроллера Areca ARC 1220 (на европейском и отечественном рынке доступен под брендом Tekram) в пользу которого говорят и стандартные провода и цена и компактные размеры и приличная производительность в RAID6, но с BBU под него есть некоторые проблемы, да и SAS он не умеет. Так что, этот контроллер рассматривался исключительно как запасной вариант наряду с некоторыми почти HBA контроллерами от Promise (TX8660 и пр.) и контроллерами на чипах LSI, а все аппаратные контроллеры на восемь и более портов с XOR процессором, КЭШем и BBU стоили куда дороже психологически страшной суммы 500 долларов. Именно этот факт и останавливал от покупки большого числа ёмких дисков для построения большого массива. Диски кстати тоже стоят не дёшево – прикиньте сколько стоит быстрый диск на 2 терабайта, а потом помножьте цену на 6, на 8, на 10…

Решение пришло как обычно откуда не ждали – один интернет-магазин, называть который я не считаю нужным т.к. он, во-первых и так рекламируется на данном ресурсе, а во-вторых там такого всё равно больше нет, предлагал своим посетителям купить диковинную позицию «RAID-контроллер IBM ServeRAID 8s» за смешные три с половиной тысячи рублей. Не долго думая я сделал заказ. Как потом оказалось, этот контроллер оказался перемаркированным Adaptec ASR4805SAS в варианте с объемом КЭШа 256 мегабайт. Кабелей в комплекте не было, официальным адаптеком контроллер формально не поддерживался. Серия 4ххх контроллеров вообще стала пробой пера компании в создании SAS контроллеров – относительно дорогие, относительно не быстрые, безотносительно не перекрывающие рынок (нет дешевых и многопортовых моделей) и пр. Но за сотню-то баксов и 8s – контроллер!

Провода были куплены в другом интернет магазине по цене около пятидесяти долларов за пару – приехали вместе с контроллером в одном синеньком фольфцвагене с надписью EMS на боку.

Проблема покупки жестких дисков оказалась проблемой. Брать дешевые и медленные WD Caviar Green не хотелось т.к. брендовый пожилой контроллер мог и не знать об их особенностях. Дорогие WD Caviar Black хотелось еще меньше, т.к. было решено купить разом восемь штук номер к номеру. Seagate подорвал к себе доверие известной проблемой, именуемой «Муха CC» как в одиннадцатой, так и в двенадцатой серии. Samsung тоже не рассматривался.

Теоретически отсавалось два варианта. Один, очень дорогой - Hitachi Deskstar A7K2000 был отметен сразу. Второй – доступный по цене Hitachi Deskstar 7K2000 (HDS722020ALA330) оказалось просто невозможно купить перед новым годом. Все поставщики пеняли на таможню, дилеров и др. и пр. Но в итоге буквально перед новым годом десять одинаковых дескстаров лежали у меня на столе. Вообще, было куплено двенадцать дисков… Спросите нафига? Новогодняя премия, тринадцатая зарплата, возврат НДФЛ, желание порадовать себя любимого и природное транжирство… да и вапще, прикольно же! Но два из них имели другую версию прошивки.

Какой именно RAID строить и как расположить диски по корзинам было решено давно и быстренько был построен RAID массив шестого уровня из восьми двухтерабайтных дисков, форматированная емкость которого составила чуть менее одиннадцати терабайт. Два диска из восьми используются для сохранения контрольных сумм. Массив сохранит работоспособность при выходе из строя двух дисков. Spare диска нет по причине того что во-первых закончились внутренние порты контроллера. А во-вторых корпус не резиновый. Два запечатанных диска из той же коробки что и участники массива лежат в сейфе… на всякий случай. Не зря я в начале говорил о паранойе.

Жить без BBU было в принципе можно, к тому же контроллер позволял активировать кэш записи даже без батарейки, что при наличии у меня UPS было не так рисковано, но решение проблемы опять пришло откуда не ждали! Один Русский интернет-магазин с Гонконгскими корнями, торгующий аккумуляторами для ноутбуков, телефонов, фотоаппаратов и пр. имел в разделе «Аккумуляторы для телефонов» устройство с длинным названием «Аккумулятор для adaptec 2218300-R, 4800SAS, 4805SAS, ABM-600, Serial Attached SCSI RAID Controllers» и ценой около двадцати долларов с доставкой… через неделю данное устройство лежало передо мной на столе и после имплантации его в контроллер оказалось что хоть его и не возможно закрепить в штатные отверстия, контроллер батарею видит, заряжает, а батарея держит КЭШ как минимум 4 часа. Дольше не проверял, но драйвер говорит о пяти сутках. BBU подвязал к плате на капроновые стяжки.

Когда уже казалось что больше хотеть некуда – серьезный контроллер, серьёзный массив, контроль двухбайтовых ошибок, батарея… мне стало неуютно держать системный раздел на HBA контроллере и… через один известный иностранный аукцион был куплен… второй экземпляр контроллера IBM ServeRAID 8s, да не простой, а с оригинальной батареей! Хочу заметить что и первый и второй контроллеры и оригинальная батарея были новыми в оригинальной упаковке. Цена второго контроллера почти в полтора раза превышала цену первого, но поскольку продавец оказался Россиянином, то с доставкой не было никаких проблем. Кстати, у него такие контроллеры еще есть… просто зайдите на сайт самого известного иностранного интернет аукциона, введите в поиск марку контроллера и ищите продавца – земляка наших двух последних президентов. Никакой рекламы!

В итоге хочу сказать что, проявив некоторую сноровку можно (и нужно!) обновить прошивку контроллера до последней версии с сайта IBM, драйвер тоже лучше использовать от IBM, а не от Adaptec, а вот вместо менеджера от IBM желательно использовать ASM последней версии от Adaptec.

Из отрицательных эмоций от использования данной системы хочется отметить три момента:

- Поддержка от IBM отказывается консультировать пользователя без предъявления скана гарантийного талона. В отличии от того же HP, господам (а в основном дамам) из IBM не достаточно уникального номера устройства. Базы комплектующих они не ведут, только базу номеров ПК и Серверов. Зато готовы часами говорить ни о чем по межгороду с клиентами в регионах.

- Длительная инициализация массива на используемых мной двухтерабайтных дисках. Длительная – это около пяти минут. После инициализации всё работает как часы. С другими, мене ёмкими SATA и SAS дисками такой проблемы нет. Консультацию получить не удалось (см. п.1), обновить прошивку дисков на бендированную от IBM сходу не удалось, а рисковать дисками не хочется. Так что, еженедельную перезагрузку провожу на пять минут дольше, чем раньше.

- Вентиляторы на обоих контроллерах очень быстро (в течение недели) вышли из строя. Не остановились, но начали шуметь. Понятно… контроллеры выпущены в сентябре дветысячиседьмого. Заменил на дешевенькие медные кулеры от Titan для видеокарт.

Продолжение можно прочитать тут:

http://stss.3dn.ru/publ/enterprise_raid_doma_ot_nechego_delat/1-1-0-250

|

Метки: ibm контроллер массив raid sas двухтерабайтный bbu корпус проблемы решение adaptec доллар диск |

В каталог добавлены продукты HP StorageWorks |

Каталог продуктов пополнился системами хранения данных HP StorageWorks.

Каталог пополнился продуктами HP StorageWorks:

HP StorageWorks 1/8 G2 Tape Autoloader - ленточный автозагрузчик с возможностью загрузки до 8-и кассет LTO 1-4

HP StorageWorks 2000 Modular Smart Array - дисковая система хранения с возможностью масштабирования до 48-и жестких дисков

Подробнее на нашем сайте:

|

Метки: hp storageworks |

Рабочая станция имеет непревзойденную производительность 32-х (!!!) ядер |

В связи с получением поддержки четырехядерных процессоров AMD Opteron 8347 на базе ядра Barcelona, сервер STSS Flagman QD820 и профессиональная рабочая станция STSS Flagman WD820 имеет теперь непревзойденную производительность 32-х (!!!) ядер.

Всего несколько лет назад только суперкомпьютеры стоимостью сотни тысяч и даже миллионы долларов могли похвастаться сравнимой производительностью. Теперь вычислительная мощь 32-х ядерного сервера стала доступна. Сервер STSS Flagman QD820 и рабочая станция STSS Flagman WS820 поддерживают до 256Гб оперативной памяти.

Это новость с нашего сайта http://www.stss.ru/

|

Метки: вычислительная мощь рабочая станция |

Дневник stssru |

|

|

| Страницы: [1] Календарь |