-Рубрики

- Наука (Новости) (13)

- Космос (Новости) (5)

- Наука (Статьи) (4)

- Космос (Статьи) (1)

-Поиск по дневнику

-Подписка по e-mail

-Постоянные читатели

-Сообщества

-Статистика

23.10.2006 | РБК-ТВ | 2 мин. 59 сек. | 6,01 МБ

- Nokia снижает цены на свои мобильники

- Квартальная прибыль IBM выросла на 46%

- British Telecom выходит на российский рынок

- Осенний форум “Инвестиции в цифру”

- Ультратонкие телефоны больше не в моде

- Монитор LG Flatron L60TQ

- Смартфон Motorola Q Pro

Для просмотра видео Вам потребуется Windows Media Player, а также, возможно, дополнительные кодеки

Действие наркотиков на мозг. |

|

|

Вопрос по диффурам |

1. Курс Дифференциальных Уравнений и Вариационного Исчисления В.К.Романко. Издание 2. Москва: Лаборатория Базовых Знаний, 2006.

2. Дифференциальные Уравнения Л.Э.Эльсгольц. Издание 6. Москва: УРСС, 2006

3. Дифференциальные Уравнения А.Н.Тихонов и другие. Издание 4. Москва: Физматлит, 2005.

4. Дифференциальные Уравнения Ф.Трикоми. Издание 2. Москва: УРСС, 2003.

Какой бы вы посоветовали?

|

|

Всем. |

|

|

Обнаружено новое свойство материи |

Неожиданные свойства когерентных состояний экситонов, обнаруженные американскими учеными, позволят создать новые типы микроэлектронных устройств, а также новые виды материалов со странными на первый взгляд свойствами.

Физики из калифорнийского университета в Сан-Диего впервые наблюдали спонтанное возникновение когерентных состояний у экситонов Мотта (связанных пар электронов и дырок), что позволит в будущем создавать новые полупроводниковые устройства. Кроме того, это свойство, по мнению нанотехнологов, поможет в создании материалов с новыми необычными свойствами.

Работой, опубликованной в Physical Review Letters, руководил Леонид Бутов, профессор университета в Сан-Диего (ранее он работал в американской национальной лаборатории в Беркли). Проф. Бутов объясняет, что вся современная физика родилась из представлений о двойственной природе частиц, которые ведут себя также как и волны.

Когерентность означает, что волны ведут себя согласованным образом. Самые удивительные явления в физике, такие как сверхпроводимость и лазерное излучение, также обязаны явлению когерентности. Для упрощенного понимания когерентности можно привести сравнение с волнами, которые прокатываются в рядах болельщиков на стадионе. Если зрители верхних рядов поднимаются и садятся одновременно со зрителями нижних, это и означает, что волны в разных рядах когерентны. А спонтанность - это когда такие волны возникают по инициативе самих зрителей, без участия руководителей.

Экситоны при достаточном охлаждении стремятся к самоорганизации с образованием упорядоченной сборки микроскопических капель. Самый известный пример спонтанной когерентности - это волны в конденсате Бозе-Эйнштейна (состояние, предсказанное Эйнштейном около 80 лет назад).

Экспериментальное наблюдение конденсата Бозе-Эйнштейна в 1995 г. американскими учеными из университета штата Колорадо было удостоено в 2001 г. Нобелевской премии по физике. Конденсат Бозе-Эйнштейна состоял из атомов при очень низкой температуре и высокой плотности, при этом атомы теряли свои индивидуальные свойства и вели себя как единая частица-волна.

Конденсация Бозе-Эйнштейна происходит при температурах вблизи абсолютного нуля. Однако экситоны могут проявлять подобное явления при температурах, гораздо более высоких (в абсолютной шкале температур - в несколько миллионов раз выше). Проф. Бутову и его американским коллегам удалось получить такие состоянии при сравнительно высоких температурах.

Группа Бутова получила экситоны при облучении полупроводника из арсенида галлия, при этом образуется свободный электрон и положительно заряженная дырка. Электрон и дырка, тем не менее, удерживаются рядом электростатическими силами, образуя экситон Мотта, который является квазиатомом - связанным состоянием этих двух частиц. Электрон и дырка могут далее рекомбинировать с образованием излучения.

Бутову и коллегам удалось разделить электроны и дырки с помощью квантовых ям, образумых наноструктурами. Экситоны в таких структурах могут жить в миллионы раз дольше, чем в обычных полупроводниках. Концентрацию экситонов можно очень сильно увеличить, и плотность газа из экситонов может быть высокой. Но самым важным вопросом для исследователей оставалась охлаждение, которое предотвращает рекомбинацию.

При температуре около 5 градусов Кельвина длина когерентности становится измеримой и по мере охлаждения возрастает. Длина когерентности составила около двух микрон при самой низкой температуре. Эта длина была измерена с помощью оптического излучения, возникающего при рекомбинации экситонов.

|

Экзоскелеты: новый облик пехотинца |

Быстрые успехи роботостроения позволили реализовать на практике мечту некоторых военных об экзоскелете, превращающем любого бойца в несокрушимого терминатора – по крайней мере до тех пор, пока не кончится питание. Широкое внедрение экзоскелетов – по всей видимости, уже не за горами. Со следующего года начнется их серийное производство. Вероятно, первыми и основными их покупателями станут военные.

Экзоскелеты идут на конвейер

Разнообразные варианты экзоскелетов уже не раз появлялись на публике. Однако ни один из них не был пущен в серийное производство. Причины достаточно тривиальны: высокая стоимость готовых «силовых костюмов» и несовершенство технологий, из-за чего экзоскелеты получались слишком громоздкими.

Самым оптимальным по компактности, автономности и стоимости на сегодняшний день оставался японский экзоскелет HAL-5 (Hybrid Assistive Limb), созданный инженером Йошиюки Санкая (Yoshiyuki Sankai) из университета города Цукуба. Как сообщили конструкторы университета, разрабатывавшийся ими 10 лет экзоскелет полностью готов к серийному производству. В 2007 году первые роботизованные костюмы появятся на рынке.

Первоначально планируется выпустить в 2007 году 20 экзоскелетов, в 2008 - уже от 400 до 500 их штук. Цена на HAL-5 оказалась выше ранее заявленной (около $15 тыс.) - от $42273 до $59182 в зависимости от модификаций. Однако возможна аренда экзоскелета всего за $600 в месяц.

Конструктивно HAL-5 представляет собой классический экзоскелет. Это облегченный механический костюм с многочисленными датчиками, который человек надевает на себя.

Костюм содержит ряд электрических приводов, которые позволяют поднимать до ста килограмм, при этом для человека такая нагрузка окажется незаметной – она ложится на экзоскелет, человек оказывает лишь «управляющее» воздействие. Кроме поднятия тяжестей, экзоскелет, например, помогает облегчить жизнь инвалидам.

Медицинский потенциал HAL-5 был продемонстрирован 7 августа 2006, когда прикованному к инвалидному креслу 43-летнему японцу Сэйдзи Утида (Seiji Uchida) удалось пройти полпути на вершину 4,5 километровой горы Брейтгорн (Breithorn) в швейцарских Альпах с помощью силового роботизированного костюма.

Как уже продемонстрировали ученые, экзоскелеты будут, в первую очередь, улучшить механику человеческого тела. Кроме этого они будут незаменимы в специфических областях – например, при работе в космическом пространстве.

Успехи солдатского нанотеха

Однако параллельно с разработкой «силовых» экзоскелетов учеными из Института Солдатских Нанотехнологий (Institute for Soldier Nanotechnologies) ведутся исследования с целью создать непробиваемую солдатскую броню, которая служила бы и экзоскелетом одновременно.

Так, учеными из ИСН уже созданы отдельные компоненты "динамической наноброни", - одной из основных деталей экипировки солдата 2020 года. Она должна облегать человека наподобие водолазного костюма. При этом в его тонком слое будут содержаться довольно сложные молекулярные компоненты – наноактюаторы и сенсоры, с помощью которых новая форма будет и бронежилетом, и универсальным медицинским диагностическим инструментом, и силовым экзоскелетом.

Все жизненно важные параметры солдата (пульс, кровяное давление, энцефалограмма, температура тела и др.) будут измеряться встроенными в костюм датчиками. Состояние солдата будет выведено как на проектор на шлеме, так и на медицинский компьютер, который будет принимать решения о трансформировании костюма в экзоскелет или броню мгновенно и независимо от солдата.

Ряд полимерных наноактюаторов, из которых будет состоять костюм, по сигналу от медицинского компьютера будут делать определенные его участки жестче или мягче. Если, например, солдат поломает ногу, местный экзоскелет позволит захватить ее в искусственные шины, сформированные тканью костюма.

Для обеспечения нужного быстродействия актюаторы должны быстро принимать нужное положение в зависимости от поступившего сигнала. Для этого необходимо поработать с уже имеющимися полимерами, найти методы их "быстрой" самосборки в нужные структуры, и сделать их электропроводными.

Далее необходимо узнать, будут ли эти полимерные материалы совместимы с живой тканью при длительном контакте. И, наконец, воспользовавшись математическим моделированием, вычислить наиболее оптимальные места для размещения датчиков, их количество и типы. Затем действуют программисты - они пишут программное обеспечение для медицинского компьютера.

Надежды и реалии

На мультфильме, представленном на одном из заседаний Конгресса США, политики увидели историю про солдата, потерявшего сознание от ранения. Но медицинский компьютер вовремя включил экзоскелет, и это спасло солдату жизнь.

Однако в реальности пока существует только мультфильм-анимация и ряд разработок в области наноактюаторов, МЭМС-датчиков и сверхпрочных материалов. Ученые говорят, что ожидать первые появления «суперкостюма» на публике стоит не раньше 2015 года.

P.S. Что бы посмотреть подписи к рисункам просто держите возле них курсор мышки.

|

Дэвид Дойч - Структура Реальности. Глава 1. Теория Всего. |

Если это кто-то будет читать кроме меня, и заинтересован мультиверсом, то выложу продолжение! Желаю вам приятного прочтения!

Помню, когда я был еще ребенком, мне говорили, что в древние времена очень образованный человек мог знать все, что было известно. Кроме того, мне говорили, что в наше время известно так много, что ни один человек не в состоянии изучить больше крошечной частички этого знания даже за всю свою жизнь. Последнее удивляло и разочаровывало меня. Я просто отказывался в это поверить. Вместе с тем, я не знал, как оправдать свое неверие. Но такое положение вещей меня определенно не устраивало, и я завидовал древним ученым.

Не то чтобы я хотел заучить все факты, перечисленные в мировых энциклопедиях: напротив, я ненавидел зубрежку. Не таким способом я надеялся получить возможность узнать все, что только было известно. Даже если бы мне сказали, что ежедневно появляется столько публикаций, сколько человек не сможет прочитать и за целую жизнь, или, что науке известно 600000 видов жуков, это не разочаровало бы меня. Я не горел желанием проследить за полетом каждого воробья. Более того, я никогда не считал, что древний ученый, который, как предполагалось, знал все, что было известно, стал бы занимать себя чем-то подобным. Я иначе представлял себе то, что следует считать известным. Под «известным» я подразумевал понятым.

Сама мысль о том, что один человек в состоянии понять все, что понято, может показаться фантастической, однако фантастики в ней куда меньше, чем в мысли о том, что один человек сможет запомнить все известные факты. К примеру, никто не сможет запомнить все известные результаты научных наблюдений даже в такой узкой области, как изучение движения планет, но многие астрономы понимают это движение настолько полно, насколько оно понято. Это становится возможным, потому что понимание зависит не от знания множества фактов как таковых, а от построения правильных концепций, объяснений и теорий. Одна сравнительно простая и понятная теория может охватить бесконечно много неудобоваримых фактов. Лучшей теорией планетарного движения является общая теория относительности Эйнштейна, которая в самом начале двадцатого века вытеснила теории гравитации и движения Ньютона. Теория Эйнштейна точно предсказывает не только принцип движения планет, но и любое другое влияние гравитации, причем точность этого предсказания соответствует нашим самым точным измерениям. Дело в том, что, когда теория предсказывает что-либо «в принципе», это означает, что предсказание логически истекает из теории, даже если на практике для получения некоторых таких предсказаний необходимо произвести больше вычислений, чем мы способны осуществить технологически или физически в той вселенной, которую мы себе представляем.

Способность предсказывать или описывать что-либо, даже достаточно точно, совсем не равноценна пониманию этого. В физике предсказания и описания часто выражаются в виде математических формул. Допустим, что я запомнил формулу, из которой при наличии времени и желания мог бы вычислить любое положение планет, которое когда-либо было записано в архивах астрономов. Что же я в этом случае выиграл бы по сравнению с непосредственным заучиванием архивов? Формулу проще запомнить, ну а дальше: посмотреть число в архивах может быть даже удобнее, чем вычислить его из формулы. Истинное преимущество формулы в том, что ее можно использовать в бесконечном множестве случаев помимо архивных данных, например, для предсказания результатов будущих наблюдений. С помощью формулы можно также получить более точное историческое положение планет, потому что архивные данные содержат ошибки наблюдений. Однако даже несмотря на то, что формула суммирует бесконечно большее количество фактов по сравнению с архивами, знать ее — не значит понимать движение планет. Факты невозможно понять, попросту собрав их в формулу, так же как нельзя понять их, просто записав или запомнив. Факты можно понять только после объяснения. К счастью, наши лучшие теории наряду с точными предсказаниями содержат глубокие объяснения. Например, общая теория относительности объясняет гравитацию на основе новой четырехмерной геометрии искривленного пространства и времени. Она точно объясняет, каким образом эта геометрия воздействует на материю и подвергается воздействию материи. В этом объяснении и заключается полное содержание теории; а предсказания относительно движения планет — это всего лишь некоторые умозаключения, которые мы можем сделать из объяснения.

Общая теория относительности так важна не потому, что она может чуть более точно предсказать движение планет, чем теория Ньютона, а потому, что она открывает и объясняет такие аспекты действительности, как искривление пространства и времени, о которых ранее не подозревали. Это типично для научного объяснения. Научные теории объясняют объекты и явления в нашей жизни на основе скрытой действительности, которую мы непосредственно не ощущаем. Тем не менее, способность теории объяснить то, что мы ощущаем, — не самое ценное ее качество. Самое ценное ее качество заключается в том, что она объясняет саму структуру реальности. Как мы увидим, одно из самых ценных, значимых и полезных качеств человеческой мысли — ее способность открывать и объяснять структуру реальности.

Однако некоторые философы, и даже ученые, недооценивают роль объяснения в науке. Для них основная цель научной теории заключается не в объяснении чего-либо, а в предсказании результатов экспериментов: все содержание теории заключено в формуле предсказания. Они считают, что теория может дать своим предсказаниям любое не противоречащее ей объяснение, а может и вовсе не давать такового до тех пор, пока ее предсказания верны. Такой взгляд называется инструментализмом (поскольку в этом случае теория — всего лишь «инструмент» для предсказания). Саму мысль о том, что наука может помочь нам понять скрытую реальность, объясняющую наши наблюдения, инструменталисты считают ложной и тщеславной. Они не понимают, каким образом то, о чем говорит научная теория помимо предсказания результатов экспериментов, может быть чем-то большим, чем пустые слова. Объяснения, в частности, они считают простой психологической опорой: чем-то вроде художественных вкраплений, которые мы включаем в теории, чтобы сделать их более занимательными и легко запоминающимися. Лауреат Нобелевской премии, физик Стивен Вайнберг, явно говорил с позиций инструментализма, когда следующим образом прокомментировал объяснение гравитации Эйнштейном:

«Важно иметь возможность предсказать картины звездного неба на фотоснимках астрономов, частоту спектральных линий и т. п., а то, припишем ли мы эти прогнозы физическому воздействию гравитационных полей на движение планет и фотонов [как это было в физике до Эйнштейна] или искривлению пространства и времени, просто не имеет значения.» (Gravitation and Cosmology, с . 147).

Вайнберг и другие инструменталисты ошибаются. То, чему мы приписываем изображения на фотошаблонах астрономов, имеет значение, и не только для физиков-теоретиков вроде меня, у которых желание в большей степени понять мир становится мотивацией для выражения теорий в виде формул и их изучения. (Я уверен, что эта мотивация присуща и Вайнбергу: вряд ли его стимулирует одно лишь желание предсказать изображения и спектры!) Дело в том, что даже для чисто практического применения прежде всего важны объяснительные возможности теории, а уж потом, в качестве дополнения, — ее предсказательные возможности. Если это вас удивляет, представьте, что на Земле появился инопланетный ученый и преподнес нам ультратехнологичный «предсказатель», который может предсказать результат любого эксперимента, но без каких-либо объяснений. Если верить инструменталистам, то как только мы получим этот предсказатель, наши научные теории нам будут нужны разве что для развлечения. Но так ли это? Каким образом предсказатель можно было бы использовать практически? В некотором смысле предсказатель содержал бы знания, необходимые для того, чтобы построить, скажем, космический корабль. Но насколько он бы пригодился нам при строительстве этого корабля, или при создании другого подобного предсказателя, или даже при усовершенствовании мышеловки? Предсказатель всего лишь предсказывает результаты экспериментов. Следовательно, чтобы получить возможность пользоваться предсказателем, нам, прежде всего, нужно знать, о результатах каких экспериментов его можно спрашивать. Если бы мы задали предсказателю чертеж космического корабля и информацию о предполагаемом испытательном полете, он мог бы сказать нам, как поведет себя корабль во время этого полета. Но спроектировать космический корабль предсказатель не смог бы. И даже если бы он сообщил нам, что спроектированный нами космический корабль взорвется при запуске, он не смог бы сказать нам, как предотвратить этот взрыв. Эту проблему снова пришлось бы решать нам. А прежде чем ее решить, прежде чем приступить хоть к какому-то усовершенствованию конструкции, нам пришлось бы понять, кроме всего прочего, принцип работы космического корабля. И только тогда у нас появилась бы возможность выяснить причину взрыва при запуске. Предсказание — пусть даже самое совершенное, универсальное предсказание — не способно заменить объяснение.

Точно так же предсказатель не смог бы предоставить нам ни одной новой теории и в научных исследованиях. Вот если бы у нас уже была теория, и мы придумали бы эксперимент для ее проверки, тогда можно было бы спросить предсказатель, что произойдет, если подвергнуть теорию этому испытанию. Таким образом, предсказатель заменил бы вовсе не теории — он заменил бы эксперименты. Он избавил бы нас от затрат на испытательные лаборатории и ускорители частиц. Вместо того чтобы строить опытные образцы космических кораблей и рисковать жизнью летчиков-испытателей, все испытания мы могли бы проводить на земле, посадив летчиков в пилотажные тренажеры, управляемые предсказателем.

Предсказатель мог бы быть весьма полезен в различных ситуациях, но его полезность всегда бы зависела от способности людей решать научные задачи точно так же, как они вынуждены делать это сейчас, а именно, изобретая объяснительные теории. Он даже не заменил бы все эксперименты, поскольку на практике его способность предсказать результат какого-то частного эксперимента зависела бы от того, что проще: достаточно точно описать этот эксперимент, чтобы предсказатель дал пригодный ответ, или провести эксперимент в действительности. В конце концов, для связи с предсказателем понадобился бы своего рода «пользовательский интерфейс». Возможно, описание изобретения пришлось бы вводить в предсказатель на каком-то стандартном языке. Некоторые эксперименты с трудом можно было бы описать на этом языке. На практике описание многих экспериментов оказалось бы слишком сложным для ввода. Таким образом, предсказатель имел бы те же основные преимущества и недостатки, что и любой другой источник экспериментальных данных, и был бы полезен только в тех случаях, когда обращение к нему оказывалось бы удобнее, чем к другим источникам. Кроме того, такой предсказатель уже существует совсем рядом, — это физический мир. Он сообщает нам результат любого возможного эксперимента, если мы спрашиваем его на правильном языке (т.е. если мы проводим эксперимент), хотя в некоторых случаях нам не очень удобно «вводить описание эксперимента» в требуемой форме (т.е. создавать некий аппарат и управлять им). Однако мир не дает объяснений.

В некоторых практических случаях, например, при прогнозе погоды, предсказатель, обладающий исключительно предсказательной функцией, устроил бы нас не меньше, чем объяснительная теория. Но даже в этом случае для целесообразного использования предсказателя предсказанный прогноз погоды должен быть полным и совершенным. На практике прогнозы погоды неполны и несовершенны, и, чтобы скомпенсировать неточность, в них включают объяснения того, как метеорологи получили тот или иной прогноз. Объяснения позволяют нам судить о надежности прогноза и вывести дальнейший прогноз для нашего места расположения или наших нужд. К примеру, для меня есть разница, чем будет вызвана ветреная погода, которую прогнозируют на завтра: близостью района с высоким атмосферным давлением или более отдаленным ураганом. В последнем случае я бы предпринял больше предосторожностей. Метеорологам самим необходимы объяснительные теории о погоде, чтобы они могли предположить, какие приближения можно допустить при компьютерном моделировании погоды, какие дополнительные наблюдения обеспечат более точный и своевременный прогноз погоды и т. п.

Таким образом, идеал инструменталистов, представленный в виде нашего воображаемого предсказателя, а именно, научной теории, лишенной своего объяснительного содержания, будет полезен в строго ограниченном числе случаев. Так будем благодарны, что реальные научные теории не похожи на этот идеал и что, в действительности, ученые к нему не стремятся.

Крайняя форма инструментализма, называемая позитивизм (или логический позитивизм), утверждает, что все положения, отличные от тех, которые описывают или предсказывают наблюдения, не только излишни, но и бессмысленны. И хотя в соответствии со своими же критериями в этой доктрине отсутствует смысл, она, тем не менее, господствовала в науке всю первую половину двадцатого столетия! Идеи инструменталистов и позитивистов широко распространены даже сегодня. Причина такой их убедительности заключается в том, что, хотя предсказание не является целью науки, оно является частью характеристического метода науки. Этот научный метод включает теоретическое принятие новой теории для объяснения некоторого класса явлений, затем проведение решающего экспериментального исследования, эксперимента, для которого старая теория предсказывает один видимый результат, а новая теория — другой. Затем теорию, предсказания которой оказались ложными, отвергают. Таким образом, результат решающего эксперимента, который позволяет сделать выбор между двумя теориями, зависит от предсказания теорий, а не от их объяснения. Именно отсюда истекает ошибочное представление, что в научной теории нет ничего, кроме предсказаний. Однако экспериментальное исследование — это далеко не единственный процесс, связанный с ростом научного знания. Подавляющее большинство теорий отвергли не потому, что их не подтвердили экспериментальные исследования, а потому, что у них были плохие объяснения. Мы отвергаем такие теории, даже не проверяя их. Например, рассмотрим следующую теорию: съев килограмм травы, можно вылечиться от простуды. Эта теория делает предсказание, которое можно проверить на опыте: если люди попробуют лечиться травой и найдут это неэффективным, появятся доказательства ложности этой теории. Но эту теорию никогда не проверяли на опыте и, возможно, никогда не проверят, потому что она не дает объяснений: она не объясняет ни процесс лечения, ни что бы то ни было еще. Мы абсолютно правильно считаем ее ложной. Всегда есть бесконечно много возможных теорий такого рода, совместимых с существующими наблюдениями и предлагающих новые предсказания, и у нас не хватило бы ни времени, ни средств, чтобы проверить их все. Мы проверяем новые теории, которые выглядят более обещающими для объяснения чего-либо, чем те, которые широко распространены сегодня.

Сказать, что предсказание — цель научной теории, значит перепутать средства и цели. Точно так же можно сказать, что цель космического корабля — сжигать топливо. На самом деле, горение топлива — это лишь один из многих процессов, которые корабль должен выполнить для достижения своей действительной цели, то есть транспортировки полезной нагрузки из одной точки космического пространства в другую. Проведение экспериментальных исследований — это лишь один из многих процессов, которые должна осуществить теория для достижения истинной цели науки, которая заключается в объяснении мира.

Как я уже сказал, частично объяснения составляются на основе того, что мы непосредственно не наблюдаем: атомы и силы; внутренние области звезд и вращение галактик; прошлое и будущее; законы природы. Чем глубже объяснение, тем к более отдаленным от настоящего опыта категориям оно должно обращаться. Однако эти категории не вымышлены: напротив, они являются частью самой структуры реальности.

Объяснения часто порождают предсказания, по крайней мере, в принципе. В самом деле, если что-то, в принципе, можно предсказать, то достаточно полное объяснение должно, в принципе, предсказать это полностью (помимо всего прочего). Однако можно объяснить и понять многие изначально непредсказуемые вещи. Например, вы не можете предсказать, какие номера выпадут на честной (т.е. беспристрастной) рулетке. Но если вы поймете, что в конструкции и действии рулетки делает ее беспристрастной, то вы сможете объяснить, почему невозможно предсказать номера. И опять: простое знание того, что рулетка беспристрастна, не равноценно пониманию того, что делает ее беспристрастной.

И я говорю именно о понимании, а не просто о знании (или описании, или предсказании). Поскольку понимание приходит через объяснительные теории, а эти теории могут быть схожи, быстрое увеличение количества записанных фактов не обязательно усложняет понимание всего, что понято. Тем не менее, большинство людей считает (и именно это говорили мне тогда, в детстве), что с ошеломляющей скоростью растет не только количество записанных фактов, но и количество и сложность теорий, через которые мы познаем мир. Следовательно (говорят они), не важно, было или нет такое время, когда один человек мог понять все, что было понято, в наше время это точно невозможно, и это становится все более и более невозможным по мере роста нашего знания. Может показаться, что каждый раз, когда появляется новое объяснение или методика, существенная для данного предмета, к списку, который должен выучить любой желающий понять этот предмет, следует добавить еще одну теорию; когда же количество таких теорий в любом предмете становится слишком большим, появляются специализации. Физика, к примеру, разделилась на астрофизику, термодинамику, физику частиц, теорию квантового поля и многие другие науки. Теоретическая основа каждой из этих наук, по крайней мере, так же обширна, как вся физика сто лет назад, и многие науки уже распадаются на подспециализации. Кажется, что, чем больше открытий мы делаем, тем дальше и безвозвратнее нас уносит в век специалистов, и тем больше удаляются от нас те предполагаемые древние времена, когда понимание обычного человека могло охватить все, что только было понято.

Человека, столкнувшегося с этим огромным и быстро растущим меню теорий, созданных человеческой расой, можно простить за его сомнения в том, что один индивидуум способен за свою жизнь отведать каждое блюдо и самостоятельно, как это могло быть когда-то, оценить все известные рецепты. Однако объяснение — необычная пища: большую порцию не обязательно труднее проглотить. Теорию может вытеснить новая теория, более точная, с большим количеством объяснений, но и более простая для понимания. В этом случае старая теория становится лишней, и мы понимаем больше, а учим меньше, чем раньше. Именно это и произошло, когда теория Николая Коперника о том, что Земля движется вокруг Солнца, вытеснила сложную систему Птолемея, которая помещала Землю в центр Вселенной. Иногда новая теория может упрощать существующую, как в случае, когда арабские (десятичные) цифры заменили римские. (В данном случае теория выражена неявно. Каждое обозначение определяет конкретные операции, положения и мысли о числах проще других и, следовательно, воплощает теорию, по которой операции с числами становятся более простыми и эффективными). Новая теория может объединять две старые теории, обеспечивая большее понимание, чем при отдельном использовании старых теорий, как это произошло, когда Майкл Фарадей и Джеймс Кларк Максвелл объединили теории электричества и магнетизма в одну теорию электромагнетизма. Косвенно, более полные объяснения, в любом предмете направлены на усовершенствование методов, понятий и языка, с помощью которых мы пытаемся понять другие предметы, и, таким образом, наше знание в целом может стать более простым для понимания.

Общеизвестно, что часто, когда новые теории таким образом заменяют старые, последние не забываются навсегда. Даже римские цифры все еще используют сегодня в определенных случаях. Громоздкие методы, с помощью которых люди когда-то вычисляли, что XIX , умноженное на XVII , равно CCCXXIII , уже не применяются всерьез, но даже сейчас они несомненно известны и понятны кому-то, например, историкам математики. Означает ли это, что человек не может понять «все, что понято», не зная римских цифр и их загадочной арифметики? Совсем нет. Современный математик, который по какой-то причине никогда не слышал о римских цифрах, тем не менее, уже обладает полным пониманием связанной с ними математики. Узнав о римских цифрах, этот математик приобретет не новое понимание, а всего лишь новые факты — исторические факты, факты о свойствах каких-то произвольно обозначенных символов, а не новое знание о самих числах. Он уподобится зоологу, который учится переводить названия видов на иностранный язык, или астрофизику, который узнает, каким образом люди различных культур распределяют звезды по созвездиям.

Необходимо ли знание арифметики римских цифр для понимания истории — отдельный вопрос. Допустим, что какая-то историческая теория — какое-то объяснение — зависела от определенных методов, которые древние римляне использовали для умножения (так же, как, например, оказалось, что их особые методы создания водопроводов из свинцовых груб, отравлявших питьевую воду, внесли свой вклад в падение Римской Империи). Затем, если мы хотим понять историю, а следовательно, и все, что понято, то нам следует узнать, какие это были методы. Но дело в том, что ни одно современное историческое объяснение не связано с методикой умножения чисел, так что наши записи относительно этих методов — не более чем констатация фактов. Все, что понято, может быть понято и без заучивания этих фактов. Мы в любое время можем посмотреть их в справочнике, если, например, расшифровываем древний текст, в котором они упоминаются.

Постоянно разграничивая понимание и «просто» знание, я не хочу преуменьшить важность записанной, но не объясненной информации. Такая информация безусловно важна для всего: от размножения микроорганизма (который содержит такую информацию в молекулах ДНК) до самого абстрактного человеческого мышления. Чем же тогда отличается понимание от простого знания? Что есть объяснение, в отличие от простой формулировки факта, коей являются правильное описание или предсказание? На практике мы обычно достаточно быстро чувствуем разницу. Мы осознаем, когда чего-то не понимаем, даже если мы можем точно описать это и дать этому точное предсказание (например, течение известной болезни неизвестного происхождения), и также мы знаем, что объяснение поможет нам лучше понять это. Но дать точное определение понятий «объяснение» или «понимание» сложно. Грубо говоря, они скорее отвечают на вопрос «почему», чем на вопрос «что»; затрагивают внутреннюю суть дел; описывают реальное, а не кажущееся состояние вещей; говорят о том, что должно быть, а не что случается: определяют законы природы, а не эмпирические зависимости. Эти понятия можно отнести к связности, утонченности и простоте в противоположность произвольности и сложности, хотя ни одному из этих понятий также нельзя дать простое определение. Но в любом случае, понимание — это одна из высших функций человеческого мозга и разума, и эта функция уникальна. Многие другие физические системы, например, мозг животных, компьютеры и другие машины, могут сравнивать факты и действовать в соответствии с ними. Но в настоящее время мы не знаем ничего, кроме человеческого разума, что было бы способно понять объяснение или желало бы получить его прежде всего. Каждое открытие нового объяснения и каждое понимание существующего объяснения зависит от уникальной человеческой способности мыслить творчески.

Можно считать, что теория римских цифр утратила свое объяснительное значение и превратилась в простое описание фактов. Подобное устаревание теорий происходит постоянно по мере роста нашего знания. Изначально римская система цифр действительно формировала часть концептуальной и теоретической системы взглядов, которая помогала людям, использующим эти цифры, понимать мир. Но сейчас то понимание, которое когда-то достигалось таким образом, — не более чем крошечный аспект гораздо более глубокого понимания, воплощенного в современных математических теориях и неявно в современных условных обозначениях.

Это иллюстрирует еще одно свойство понимания. Возможно понять что-то, не осознавая, что понимаешь это, или даже не уделяя этому особого внимания. Возможно, это звучит парадоксально, но смысл глубоких обобщенных объяснений состоит в том, что они охватывают не только знакомые ситуации, но и незнакомые. Если бы вы были современным математиком и впервые столкнулись с римскими цифрами, возможно, вы бы сразу не осознали, что уже поняли их. Сначала вам бы пришлось выучить факты относительно того, что это такое, а потом поразмышлять над этими фактами в свете вашего настоящего понимания математики. Но завершив это, вы могли бы, оглянувшись назад, сказать: «Да, в римской системе цифр для меня нет ничего нового, кроме фактов». Именно это мы имеем в виду, когда говорим, что объяснительная роль римских цифр полностью устарела.

Точно также, когда я говорю, что понимаю, каким образом кривизна пространства и времени влияет на движение планет даже в других солнечных системах, о которых я, возможно, никогда не слышал, я не утверждаю, что могу вспомнить без дальнейших размышлений объяснение всех подробностей вращения и колебаний орбиты любой планеты. Я имею в виду, что понимаю теорию, содержащую все эти объяснения, и поэтому могу точно вывести любое из них, если получу некоторые факты о конкретной планете. Сделав это, я, оглянувшись назад, смогу сказать в прошлое: «Да, в движении этой планеты я не вижу ничего, кроме фактов, которые не объясняет общая теория относительности». Мы понимаем структуру реальности, только понимая теории, объясняющие ее. А поскольку они объясняют больше, чем мы непосредственно осознаем, мы можем понять больше, чем непосредственно осознаем, что поняли.

Я не утверждаю, что, когда мы понимаем теорию, мы обязательно понимаем все, что она может объяснить. В очень глубокой теории осознание того, что она объясняет данное явление, само по себе может быть значительным открытием, требующим независимого объяснения. Например, квазары — чрезвычайно яркие источники излучения в центре некоторых галактик — в течение многих лет были одной из загадок астрофизики. Когда-то даже полагали, что для того, чтобы их объяснить, потребуется новая физика, но сейчас мы считаем, что их объясняет как общая теория относительности, так и другие теории, которые были известны еще до открытия квазаров. Мы полагаем, что квазары состоят из горячей материи в процессе падения в черные дыры (разрушенные звезды с таким мощным гравитационным полем, что ничто не может избежать его). Однако потребовались многие годы наблюдений и теоретических исследований, прежде чем мы пришли к этому выводу. Теперь, когда мы считаем, что нашли меру понимания квазаров, мы не думаем, что и раньше обладали этим пониманием. Хотя мы и объяснили квазары через существующие теории, мы получили абсолютно новое понимание. Насколько сложно дать определение объяснению, настолько же сложно определить, считать ли вспомогательное объяснение независимой составляющей того, что понято, или относить его к более глубокой теории. Это сложно определить, но не так сложно осознать: на практике, когда нам дают новое объяснение, мы понимаем, что оно новое. И снова: разница связана с творческими способностями. Объяснить движение какой-то планеты человеку, который понимает общую теорию относительности, — чисто механическая задача, хотя она может оказаться очень сложной. Но, чтобы использовать существующую теорию для объяснения квазаров, необходимо творческое мышление. Таким образом, чтобы понять все, что понято в астрофизике на сегодняшний день, вам придется подробно изучить теорию квазаров. Но вам не придется изучать орбиту какой-то конкретной планеты.

Таким образом, несмотря на то, что количество известных нам теорий, да и записанных фактов растет как снежный ком, сама структура не становится более сложной для понимания. Дело в том, что, становясь более подробными и многочисленными, отдельные теории постепенно «теряют актуальность», так как понимание, которое они содержат, переходит к глубоким обобщенным теориям. А количество последних все уменьшается, но они становятся более глубокими и более обобщенными. Под «более обобщенными» я подразумеваю, что каждая из этих теорий приводит больше доводов, охватывает большее количество ситуаций, чем несколько отдельных теорий ранее. Под «более глубокими» я понимаю, что каждая из них объясняет больше (охватывает большее понимание), чем ее предшественники, вместе взятые.

Если бы вы захотели построить большое сооружение, мост или собор, несколько веков назад, вам понадобился бы проектировщик. Он бы знал, что необходимо сделать, чтобы обеспечить прочность и устойчивость конструкции с минимальными возможными усилиями и затратами. Он не смог бы выразить большую часть этого знания на языке математики и физики, как мы можем сделать это сегодня. Вместо этого он положился бы, главным образом, на свою интуицию, навыки и эмпирические зависимости, которые узнал во времена своего ученичества, а впоследствии, возможно, усовершенствовал, руководствуясь догадками и долгим опытом работы. Но даже эта интуиция, эти навыки и эмпирические зависимости на самом деле были явными и неявными теориями, содержавшими реальное знание предметов, которые сегодня мы называем инженерным делом и архитектурой. Именно из-за знания этих теорий, пусть очень неточных по сравнению с существующими сегодня и применимых в небольшом числе случаев, вы и наняли бы этого проектировщика. Восхищаясь строениями, простоявшими века, люди часто забывают, что видят лишь то, что уцелело. Подавляющее большинство сооружений, построенных в средние века и раньше, давно развалилось, часто вскоре после того, как они были построены. Особенно это касалось новых сооружений. Считалось доказанным, что любое нововведение может стать причиной катастрофы, и строители редко отступали от традиционных конструкций и методов. В наши дни, напротив, большая редкость, если какое-то строение (пусть даже непохожее ни на что, построенное раньше) развалится из-за неправильной конструкции. Все, что мог построить древний квалифицированный строитель, его современные коллеги могут построить лучше и с меньшими усилиями. Они также могут соорудить такие строения, о которых он вряд ли мечтал, например, небоскребы или космические станции. Они могут использовать такие материалы, как стекловолокно или железобетон, о которых он никогда не слышал и которые вряд ли смог бы использовать, даже если бы они каким-то образом у него появились, т. к. он имел весьма смутные и неточные представления о поведении материалов.

Мы достигли настоящего уровня знаний не потому, что собрали много теорий, подобных той, что была известна древнему строителю. Наше знание, явное и неявное, не просто больше, оно отличается по своей структуре. Как я уже сказал, современных теорий меньше, но они более обобщенные и более глубокие. В каждой ситуации, с которой сталкивался проектировщик, выполняя какую-то работу, — к примеру, выбирая толщину несущей стены, — он пользовался довольно специфической интуицией или эмпирической зависимостью, которая применительно к нестандартным случаям могла дать безнадежно неправильные ответы. В наше время проектировщик принимает такие решения, используя теорию, обобщенную настолько, что ее можно применить к стенам, сделанным из любых материалов, в любой среде: на Луне, под водой и где угодно еще. Эта теория настолько обобщена, потому что основана на достаточно глубоких объяснениях принципа поведения материалов и конструкций. Чтобы найти оптимальную толщину стены из незнакомого материала, используют ту же теорию, что и для любой другой стены, но расчеты начинают, принимая различные факты — используя различные численные значения разных параметров. Приходится смотреть в справочнике такие факты, как предел прочности на растяжение и упругость материала, но в дополнительном понимании нет необходимости.

Именно поэтому современный архитектор не нуждается в более длительной или трудоемкой подготовке, даже несмотря на то, что понимает гораздо больше, чем древний строитель. Возможно, типичную теорию из учебной программы современного студента понять сложнее, чем любую из эмпирических зависимостей древнего строителя; но современных теорий гораздо меньше, а их объяснительная способность придает им такие качества, как красота, внутренняя логика и связь с другими предметами, благодаря которым эти теории проще изучать. Сейчас мы знаем, что некоторые древние эмпирические зависимости были ошибочными, другие — истинными или близкими к истине, и мы знаем причины этого. Некоторыми эмпирическими правилами мы до сих пор пользуемся, но ни на одном из них уже не основывается понимание того, почему конструкции не рушатся.

Я, конечно, не отрицаю, что во многих предметах, где увеличивается знание, включая архитектуру, появляются специализации. Однако это не односторонний процесс, т. к. специализации часто исчезают: колеса уже не проектируют и не изготавливают колесные мастера, плуги — мастера по плугам, а письма уже не пишут писцы. Тем не менее, достаточно очевидно, что тенденция углубления и объединения, которую я описывал, не единственная: параллельно ей происходит непрерывное расширение. Поясню: новые идеи часто не просто вытесняют, упрощают или объединяют существующие. Они также расширяют человеческое понимание до областей, которые раньше не были поняты совсем или о существовании которых даже не догадывались. Они могут открывать новые возможности, новые проблемы, новые специализации и даже новые предметы. И когда это происходит, мы можем получить. по крайней мере на время, больше информации для изучения, чтобы понять все это.

Возможно, медицина — наиболее распространенный пример растущей специализации, которая кажется неизбежным следствием роста знания, когда открывают новые способы лечения многих болезней. Но даже в медицине присутствует противоположная тенденция объединения, которая непрерывно усиливается. Общеизвестно, что многие функции тела, как, впрочем, и механизмы многих болезней, еще мало изучены. Следовательно, некоторые области медицинского знания все еще состоят, главным образом, из собрания записанных фактов, навыков и интуиции врачей, имеющих опыт в лечении определенных болезней и передающих эти навыки и интуицию из поколения в поколение. Другими словами, большая часть медицины все еще не вышла из эпохи эмпирических правил, и вновь обнаруженные эмпирические правила стимулируют появление специализаций. Но когда в результате медицинских и биохимических исследований появляются более глубокие объяснения процессов болезни (и здоровых процессов) в теле, увеличивается и понимание. Когда в различных частях тела, в основе разных болезней обнаруживают общие молекулярные механизмы, на смену узким теориям приходят более обобщенные. Как только болезнь понимают настолько, что могут вписать ее в общую структуру, роль специалиста уменьшается. Вместо этого врачи, столкнувшись с незнакомой болезнью или редким осложнением, могут положиться на объяснительные теории. Они могут посмотреть эти факты в справочнике. Но затем они смогут применить обобщенную теорию, чтобы разработать необходимое лечение и ожидать, что оно будет эффективным, даже если никогда раньше оно не применялось.

Таким образом, вопрос о том, сложнее или проще становится понять все, что понято, зависит от равновесия двух противоположных результатов роста знания: расширения и углубления наших теорий. Из-за расширения наших теорий понять их сложнее, из-за углубления — проще. Одно из положений этой книги состоит в том, что углубление медленно, но уверенно побеждает. Другими словами, утверждение, в которое я отказывался поверить, будучи ребенком, в самом деле ложно, а истинно практически противоположное. Мы не удаляемся от состояния, когда один человек способен понять все, что понято, мы приближаемся к нему.

Я не утверждаю, что скоро мы поймем все. Это совсем другой вопрос. Я не верю, что сейчас мы близки или когда-то приблизимся к пониманию всего, что существует. Я говорю о возможности понимания всего, что понято. Это скорее зависит не от содержания нашего знания, а от его структуры. Но структура нашего знания — независимо от возможности его выражения в теориях, составляющих понятное целое — безусловно зависит от самой структуры реальности. Если свободный рост знания должен продолжаться и если мы, несмотря ни на что приближаемся к тому состоянию, когда один человек сможет понять все, что понято, значит, глубина наших теорий должна увеличиваться достаточно быстро, чтобы обеспечить эту возможность. Это может произойти, если только сама структура реальности настолько едина, что по мере роста нашего знания мы сможем понимать ее все больше и больше. Если это произойдет, то в конечном итоге наши теории станут настолько общими, глубокими и составляющими друг с другом единое целое, что превратятся в единственную теорию единой структуры реальности. Эта теория не объяснит все аспекты реальности: это недостижимо. Но она охватит все известные объяснения и будет применима ко всей структуре реальности настолько, насколько последняя будет понята. В то время как все предыдущие теории относились к конкретным предметам, это будет теория всех предметов: Теория Всего.

Эта теория, безусловно, не будет последней в своем роде, она будет первой. В науке считается доказанным, что даже наши лучшие теории обречены быть в некотором роде несовершенными и проблематичными, и мы ожидаем, что в свое время их вытеснят более глубокие и точные теории. И этот прогресс не остановится, когда мы откроем универсальную теорию. Например, Ньютон дал нам первую универсальную теорию тяготения и объединил, помимо всего прочего, небесную и земную механику. Но его теории вытеснила общая теория относительности Эйнштейна, которая включает еще и геометрию (которую раньше считали отраслью математики) в физике, и поэтому наряду с большей точностью дает более глубокие объяснения. Первая универсальная теория — которую я буду называть Теорией Всего — подобно всем нашим теориям, которые были до нее и будут после нее, не будет ни абсолютно истинной, ни бесконечно глубокой, а потому, в конечном итоге, ее заменит другая теория. Но эта замена произойдет не через объединение с теориями других предметов, ибо она сама будет теорией всех предметов. В прошлом значительный прогресс в понимании иногда имел место при значительных объединениях. Иногда прогресс был вызван структурными изменениями в понимании конкретного предмета, как, например, когда мы перестали считать Землю центром Вселенной. После первой Теории Всего уже не будет значительных объединений. Все последующие великие открытия будут переменами в понимании мира в целом: изменениями в нашем мировоззрении. Создание Теории Всего будет последним большим объединением и в то же время первым шагом к возникновению нового мировоззрения. Я считаю, что именно такое объединение и изменение происходят сейчас. Подобное мировоззрение и является темой этой книги.

Считаю своей обязанностью сразу подчеркнуть, что я говорю не просто о «теории всего», которую в ближайшее время надеются открыть специалисты в области физики элементарных частиц. Их «теория всего» стала бы объединенной теорией всех основных сил, известных физике, а именно: гравитационных, электромагнитных и ядерных сил. Она также описала бы все типы существующих дробноатомных частиц, их массы, спины, электрические заряды и другие свойства, а также принцип их взаимодействия. При наличии достаточно точного описания начального состояния любой изолированной физической системы, такая теория сможет предсказать будущее поведение системы в принципе. В случае, когда точное поведение системы предсказать невозможно, теория опишет все возможные варианты поведения системы и предскажет вероятность их возникновения. На практике нередки случаи, когда начальные состояния интересующих нас систем невозможно определить точно, да и предсказать их слишком сложно во всех случаях, кроме простейших. Тем не менее, такая объединенная теория частиц и сил вместе с определением начального состояния Вселенной к моменту Большого Взрыва (сильный взрыв, от которого произошла Вселенная), в принципе, содержала бы всю информацию, необходимую для предсказания всего, что можно предсказать (рисунок 1.1).

|

|

|

Рис. 1.1. Неадекватное понимание «теории всего» |

Но предсказание — еще не объяснение. «Теория всего», на которую так надеются, даже совместно с теорией начального состояния, в лучшем случае представит лишь крошечную грань истинной Теории Всего. Эта теория сможет предсказать все (в принципе). Но нельзя ожидать, что она объяснит гораздо больше, чем существующие теории, за исключением нескольких явлений, вызванных особенностями внутриатомных взаимодействий, как-то: столкновения внутри ускорителей частиц и необычная история трансмутаций частиц во время Большого Взрыва. Что побуждает ученых использовать термин «теория всего» для названия столь малого, хотя и захватывающего отрезка знания? Я полагаю, еще один ошибочный взгляд на природу науки, который не одобряют многие научные критики, но (увы!) одобряют многие ученые: наука по существу является редукционной . Это все равно, что сказать, что наука сомнительно упрощает все объяснения, раскладывая их на составляющие. Например, сопротивление стены проникновению или сбиванию объясняется тем, что стена — это огромное скопление взаимодействующих молекул. Свойства этих молекул объясняют на основе составляющих их атомов, взаимодействия этих атомов друг с другом и так далее до мельчайших частиц и самых основных сил. Редукционисты считают, что все научные объяснения и, возможно, любые достаточно глубокие объяснения принимают именно такую форму.

Концепция редукционистов естественно приводит к созданию иерархии предметов и теорий в соответствии с тем, насколько они близки к «самому низкому уровню» известных предсказательных теорий. В этой иерархии логика и математика образуют непоколебимые принципы, на которых строится система научных взглядов. Фундаментом станет упрощенная «теория всего», универсальная теория частиц, сил, пространства и времени вместе с некоторой теорией начального состояния Вселенной. Остальная физика образует первые несколько этажей. Астрофизика и химия займут более высокий уровень, геология — еще более высокий и т. д. Здание разделяется на множество башен — предметов еще более высокого уровня: биохимию, биологию и генетику. В нетвердых слоях стратосферы примостились такие предметы, как теория эволюции, экономика, психология и вычислительная техника, которые на этой картине почти немыслимо вторичны.

В настоящее время у нас есть только приближения к упрощенной «теории всего». Они уже достаточно точно могут предсказывать законы движения отдельных дробноатомных частиц. Используя эти законы, современные компьютеры могут рассчитать движение любой изолированной группы из нескольких взаимодействующих частиц некоторого элемента, если известно их начальное состояние. Но даже мельчайшая частичка материи, видимая невооруженным глазом, содержит триллионы атомов, каждый из которых состоит из множества дробноатомных частиц и непрерывно взаимодействует с внешним миром, так что предсказать поведение этой частички не представляется возможным. Дополняя точные законы движения различными приближениями, мы можем предсказать некоторые аспекты общего поведения достаточно крупных объектов, например, температуру плавления или кипения данного химического соединения. Большая часть основной химии была таким образом сведена к физике. Для наук более высокого уровня программа редукционистов — всего лишь дело принципа. Никто на самом деле не собирается выводить принципы биологии, психологии или политики из принципов физики. Причина, по которой предметы более высокого уровня вообще поддаются изучению, состоит в том, что в определенных условиях непостижимо сложное поведение огромного количества частиц становится мерой простоты и удобопонятности. Это называется исходом: простота высокого уровня «исходит» из сложности низкого уровня. Явления высокого уровня с понятными фактами, которые нельзя просто вывести из теорий низкого уровня, называются исходящими явлениями. Например, стена могла быть крепкой, потому что те, кто ее строил, боялись, что их враги могут попытаться преодолеть эту стену. Это объяснение прочности стены высокого уровня невыводимо из объяснения низкого уровня, которое я привел выше (хотя и сопоставимо с ним). «Строители», «враги», «страх», «пытаться» — это исходящие явления. Цель наук высокого уровня — дать нам возможность понять исходящие явления, самыми важными из которых, как мы увидим, являются жизнь, мысль и вычисление.

Кстати, противоположность редукционизма — холизм, идея о том, что единственно правильные объяснения составлены на основе систем высокого уровня, — еще более ошибочна, чем редукционизм. Чего ожидают от нас холисты? Того, что мы прекратим наши поиски молекулярного происхождения болезней? Что мы откажемся от того, что люди состоят из дробноатомных частиц? Там, где существуют упрощенные объяснения, они столь же желанны, как любые другие. Там, где целые науки упрощаются до наук низкого уровня, мы, ученые, обязаны найти эти упрощения, так же как обязаны открывать любое знание.

Редукционист считает, что наука заключается в том, чтобы разложить все на составляющие. Инструменталист считает, что цель науки — предсказывать события. Для каждого из них существование наук высокого уровня — вопрос удобства. Сложность мешает нам использовать элементарную физику для получения предсказаний высокого уровня, поэтому мы гадаем, каковы были бы эти предсказания, если бы мы могли их получить, — исход дает нам возможность преуспеть в этом — именно в этом предположительно заключается смысл наук высокого уровня. Таким образом, для редукционистов и инструменталистов, которые проигнорировали как истинную структуру, так и истинную цель научного знания, основой предсказывающей иерархии физики является, по определению, «теория всего». Но для всех остальных научное знание состоит из объяснений, а структура научного объяснения не отражает иерархию редукционистов. Объяснения существуют на каждом уровне иерархии. Многие из них независимы и относятся только к понятиям конкретного уровня (например, «медведь съел мед, потому что был голоден»). Многие объяснения содержат логические выводы, противоположные направлению упрощенных объяснений. То есть они объясняют вещи, не разделяя их на более маленькие, простейшие, а рассматривают их как составляющие более крупных и сложных вещей, о которых у нас, тем не менее, есть объяснительные теории. Например, рассмотрим конкретный атом меди на кончике носа статуи сэра Уинстона Черчилля, которая находится на Парламентской Площади в Лондоне. Я попытаюсь объяснить, почему этот атом меди находится там. Это произошло потому, что Черчилль был премьер-министром в палате общин, которая расположена неподалеку; и потому, что его идеи и руководство способствовали победе Объединенных сил во Второй Мировой войне; и потому, что принято чествовать таких людей, ставя им памятники; и потому, что бронза, традиционный материал для таких памятников, содержит медь и т.д. Таким образом, мы объясним физическое наблюдение низкого уровня — присутствие атома меди в определенном месте — через теории чрезвычайно высокого уровня о таких исходящих явлениях, как идеи, руководство, война и традиция.

Нет такой причины, почему должно существовать, даже в принципе, какое-либо более низкоуровневое объяснение присутствия этого атома меди, чем то, которое я только что привел. Предположим, что упрощенная «теория всего» в принципе сделала бы низкоуровневое предсказание вероятности, что такая статуя будет существовать, если известно состояние (скажем) солнечной системы в какое-то более раннее время. Точно также эта теория в принципе описала бы, как эта статуя могла туда попасть. Но такие описания и предсказания (конечно же, абсолютно нереальные) ничего бы не объясняли. Они просто описывали бы траекторию движения каждого атома меди от медного рудника через плавильную печь, мастерскую скульптора и т.д. Они также могли бы сформулировать, какое влияние на эти траектории оказывают силы от окружающих атомов, например, тех, из которых состоят тела шахтеров и скульптора, и, таким образом, предсказать существование и форму статуи. В действительности, такое предсказание следовало бы отнести к атомам по всей планете, вовлеченным, кроме всего прочего, в сложное движение, которое мы называем Второй Мировой войной. Но даже если бы вы обладали сверхчеловеческой способностью следовать таким многословным предсказаниям нахождения атома меди в том месте, вы все равно не смогли бы сказать: «Да, я понимаю, почему он там находится». Вы просто знали бы, что его попадание туда таким образом неизбежно (или вероятно, или что угодно еще), если известны начальные конфигурации атомов и законы физики. Если бы вы захотели понять, почему он там находится, у вас по-прежнему не было бы другого выбора, кроме как сделать следующий шаг. Вам пришлось бы выяснить все, что касается этой конфигурации атомов и их траекторий, из-за которых атом меди оказался именно в этом месте. Такое исследование стало бы творческой задачей, какой всегда является открытие новых объяснений. Вам пришлось бы обнаружить, что определенные конфигурации атомов подтверждают такие исходящие явления, как руководство и война, связанные друг с другом объяснительными теориями высокого уровня. И только узнав все эти теории, вы смогли бы полностью понять, почему этот атом меди находится именно там.

Редукционисты уверены, что законы, управляющие взаимодействием дробноатомных частиц, имеют первостепенную важность, поскольку они являются основой иерархии всего знания. Но в реальной структуре научного знания и в структуре нашего знания в целом такие законы играют гораздо более скромную роль.

Какова же эта роль? Мне кажется, что ни одна из рассмотренных теорий, претендующих на звание «теории всего», не содержит много нового в способе объяснения. Возможно, самый передовой подход с объяснительной точки зрения — это теория суперструн, в которой элементарными строительными блоками материи являются удлиненные объекты, «струны», а не точечные частицы. Но ни один существующий подход не предлагает нового способа объяснения — нового в смысле объяснения Эйнштейном сил притяжения на основе искривленного пространства и времени. В действительности, ожидается, что «теория всего» унаследует практически всю объяснительную структуру существующих теорий электромагнетизма, ядерных сил и гравитации: их физические концепции, их язык, их математический формализм и форму их объяснений. Значит, мы можем рассчитывать, что эта структура основной физики, которая нам уже известна из существующих теорий, внесет вклад в наше общее понимание.

В физике существует две теории, значительно более глубокие, чем остальные. Первая — это общая теория относительности, по-моему, наша лучшая теория пространства, времени и гравитации. Вторая — еще более глубокая — квантовая теория. Эти две теории (а никакая другая существующая или ныне рассматриваемая теория дробноатомных частиц) предоставляют подробную объяснительную и формальную систему взглядов, в которой выражаются все остальные теории современной физики, и содержат основные физические принципы, которым подчиняются все остальные теории. Объединение общей теории относительности и квантовой теории — с целью получения квантовой теории относительности — стало в последние десятилетия основным предметом поисков физиков-теоретиков и должно было бы стать частью любой теории всего, как в узком, так и в широком смысле этого термина. Как мы увидим в следующей главе, квантовая теория, как и относительность, предоставляет революционно новый способ объяснения физической реальности. Причина, по которой квантовая теория глубже теории относительности, лежит большей частью не в физике, а вне ее, поскольку ее отрасли простираются далеко за пределы физики и даже за пределы самой науки в привычном ее понимании. Квантовая теория является одной из четырех основных нитей , образующих наше настоящее понимание структуры реальности .

Прежде чем назвать три других нити, я должен упомянуть еще один способ искаженного представления структуры научного знания редукционизмом. Редукционизм принимает не только то, что объяснение всегда состоит из разделения системы на более маленькие и простые системы, но и то, что все поздние события объясняются на основе ранних; другими словами, единственный способ что-то объяснить — сформулировать причины этого. А это подразумевает, что, чем раньше произошли события, на основе которых мы что-то объясняем, тем лучше объяснение, так что, в конечном счете, все лучше объяснять на основе первоначального состояния Вселенной.

«Теория всего», исключающая определение первоначального состояния Вселенной, не является полным описанием физической реальности, потому что она содержит только законы движения; а законы движения сами по себе делают лишь условные предсказания. То есть они формулируют не то, что происходит, а только то, что произойдет в какое-то время, если известно, что это происходило раньше. Только если известно полное определение начального состояния, в принципе можно вывести полное описание физической реальности. Существующие космологические теории не обеспечивают полного определения начального состояния даже в принципе, но они утверждают, что изначально Вселенная была очень маленькой, очень горячей и имела однородную структуру. Но мы также знаем, что Вселенная не могла иметь абсолютно однородную структуру, потому что в соответствии с теорией это будет несовместимо с россыпью галактик, которые мы наблюдаем сегодня в небе. На первоначальные изменения плотности, «неоднородность распределения материи», значительное влияние оказало гравитационное сжатие (то есть относительно плотные участки притянули бы больше материи и стали бы более плотными), так что сначала эти изменения, должно быть, были совсем небольшими. Но какими бы маленькими они ни были, они имеют огромное значение для любых описаний реальности редукционистами, потому что почти все, что мы наблюдаем вокруг от россыпи звезд и галактик в небе до появления бронзовых статуй на планете Земля, с точки зрения основной физики является следствием этих изменений. Если наше редукционное описание стремится охватить нечто большее, чем самые крупные свойства наблюдаемой Вселенной, нам нужна теория, определяющая те важнейшие первоначальные отклонения от однородности.

Я попытаюсь заново сформулировать последнее требование, не принимая во внимание предубеждения редукционистов. Законы движения любой физической системы дают только условные предсказания и, следовательно, совместимы со многими возможными вариантами развития этой системы. (Это не зависит от ограничений предсказания, которые накладывает квантовая теория и о которых я расскажу в следующей главе). Например, законы движения, которым подчиняется ядро, выпущенное из пушки, совместимы с многими возможными траекториями, каждая из которых соответствует одному из возможных направлений и подъемов ствола пушки при выстреле (рис. 1.2).

|

|

|

Рис. 1.2. Некоторые возможные траектории движения пушечного ядра. Каждая траектория совместима с законами движения, но только одна из траекторий относится к конкретному случаю |

Математически законы движения можно выразить системой уравнений, которые называют уравнениями движения. Существует много различных решений этих уравнений, каждое из которых описывает какую-то возможную траекторию. Чтобы определить, какое решение описывает действительную траекторию, необходимо обеспечить дополнительные данные - некоторую информацию о том, что происходит в действительности. Один из способов осуществить это заключается в определении начального состояния, в данном случае направления ствола пушки. Однако существуют и другие способы. Например, мы точно также могли бы определить конечное состояние — положение и направление движения пушечного ядра в момент его приземления. Или мы могли бы определить положение самой высокой точки траектории. Мы можем давать любые дополнительные данные, если они помогают выбрать одно конкретное решение системы уравнений движения. Объединение любых дополнительных данных такого рода с законами движения равноценно теории, которая описывает все, что происходит с пушечным ядром с момента выстрела до удара.

Точно также законы движения для физической реальности в целом будут иметь много решений, каждое из которых соответствует конкретному случаю. Для завершения описания нам придется определить, какой случай произошел в действительности, предоставляя достаточно дополнительных данных для получения одного из многих решений уравнений движения. В простых космологических моделях, по крайней мере одним из способов получения таких данных является определение начального состояния Вселенной. Но, кроме того, мы могли бы определить конечное состояние или состояние в любой другой момент времени: или мы могли бы предоставить некоторую информацию о начальном состоянии, какую-то информацию о конечном состоянии и о промежуточных состояниях. В общем, объединив достаточное количество дополнительных данных разного рода с законами движения, мы, в принципе, получили бы описание физической реальности.

Как только мы определим, скажем, конечное состояние пушечного ядра, мы сможем непосредственно вычислить его начальное состояние, и наоборот, поэтому между различными методами определения дополнительных данных не существует практической разницы. Однако большую часть таких вычислений для Вселенной трудно обработать. Я сказал, что мы делаем вывод о существовании «неоднородности распределения материи» в начальных состояниях из сегодняшних наблюдений этой «неоднородности». Но это исключение: большая часть нашего знания о дополнительных данных — о том, что конкретно происходит, — существует в форме теорий высокого уровня об исходящих явлениях и, следовательно, по определению практически не поддается выражению в виде формулировок начального состояния. Например, в большей части решений уравнений движения Вселенная в своем начальном состоянии не обладает свойствами, необходимыми для появления жизни. Следовательно, наше знание того, что жизнь появилась, — значительная часть дополнительных данных. Возможно, мы никогда не узнаем, что это ограничение значит для подробной структуры Большого Взрыва, но мы можем сделать выводы непосредственно из него. Например, первая точная оценка возраста Земли была сделана на основе биологической теории эволюции, которая противоречила самым выдающимся достижениям физики того времени. Только предубеждение редукционистов могло заставить нас считать, что эти доказательства были по какой-то причине менее вескими или, в общем, теории о начальном состоянии были более «фундаментальны», чем теории об исходящих особенностях реальности.

Даже в области основной физики идея о том, что теории начального состояния содержат наши самые глубокие знания, весьма ошибочна. Одна из причин этого состоит в том, что она логически исключает возможность объяснения самого начального состояния: почему было начальное состояние, каким оно было, — однако в действительности у нас есть объяснения многих аспектов начального состояния. В общем, ни одна теория времени не способна давать объяснения на основе чего-то «более раннего»; тем не менее, благодаря общей теории относительности, а также квантовой теории (см. главу 2) у нас есть глубокие объяснения природы времени.

Таким образом, характер многих наших описаний, предсказаний и объяснений реальности не имеет ничего общего с теорией «начального состояния в совокупности с законами движения», к которой приводит редукционизм. Не существует причины рассматривать теории высокого уровня как «второсортные». Наши теории дробноатомной физики и даже квантовая теория относительности не имеют никаких преимуществ перед теориями об исходящих свойствах. Ни одну из этих областе

|

B-мезоны. |

С недавних пор в центре внимания многих специалистов по квантовой хромодинамике находится некоторая аномалия, выявляемая в ходе экспериментов на "B-мезонных фабриках". Первоначально она была замечена исследователями Стэнфордского центра линейного ускорителя SLAC (Stanford Linear Accelerator Center) Министерства энергетики США, ну а затем тот же феномен проявился и на ускорителе KEK японской Организации исследований в области ускорителей высоких энергий (High Energy Accelerator Research Organization) в Цукубе (эксперимент Belle). Сообщения об этом феномене, в частности, можно было услышать и на конференции по физике высоких энергий, организованной этим летом в Москве.

Стандартная модель физики элементарных частиц (Standard Model - SM) предсказывает, что два пути (канала) распада B-мезона (мезона, состоящего из тяжелого анти-b-кварка и другого легкого кварка) должны иметь примерно одинаковую вероятность, однако регистрируемые в эксперименте продукты распада в разных ветвях демонстрируют неожиданно большую диспропорцию. И теперь вот индийские физики-теоретики из Института математических проблем (Institute of Mathematical Sciences - IMSc) опубликовали в журнале Physical Review Letters (PRL, vol 97, p 131802) статью, где показали, что объяснить новое несоответствие в рамках Стандартной модели уже не представляется возможным (текст вышеупомянутой статьи доступен также и на arXiv.org - Has New Physics already been seen in B_d meson decays?). То есть, если верить этой статье, выходит, уже теперь в экспериментах можно наблюдать проявления так называемой Новой Физики (New Physics - NP).

Рахул Синха (Rahul Sinha), Басудха Мисра (Basudha Misra) и Вей-Шу Хоу (Wei-Shu Hou, Физический факультет Национального тайваньского университета) пробовали сначала "честно" объяснить несоответствие с использованием Стандартной модели, но у них ничего не вышло. После этого они склонились к альтернативному объяснению. "В настоящее время еще невозможно выявить точный вид Новой Физики, которая могла бы стоять за этими данными, - поясняет Синха. - Мы теперь нуждаемся не только в большем количестве статистических данных распадов B-мезонов, но и в большем количестве теоретических исследований. Это может оказаться проявлением суперсимметрии, а может - чем-то иным".

Две различные моды распада B-мезона приводят к появлению странного кварка (strange quark, s-кварк) наряду с двумя другими частицами - либо чармированного и античармированного кварков (другое название - "очарованный" кварк, charm, c-кварк), либо "q" и анти-"q" кварков, где q может быть верхним, нижним, либо странным кварком (u, d, s). В целом нейтральный, B-мезон имеет очень интересное свойство: он может смешиваться со своей античастицей, анти-B-мезоном (осцилляции, знакомые нам по осцилляциям разных "сортов" нейтрино, переходящих одно в другое), что приводит к появлению фазы, именуемой "B-мезоном смешанной фазы". Согласно Стандартной модели, B-мезоны распадаются через слабые взаимодействия, и распады, которые приводят к появлению странных кварков, имеют два различных вклада от двух различных (вышеупомянутых) слабых фаз. Только в первом случае все более-менее просто (нет эффектов квантовых флуктуаций от тяжелых частиц), а вот распад на "q" и анти-"q" проходит через так называемый "пингвиний" процесс ("пингвинный", penguin process), в результате которого частица на мгновение преобразуется в "истинный" кварк (самый тяжелый truth или, иначе говоря, top quark). И вот в этих-то "пингвиньих животах", вызывающих регистрируемую экспериментально асимметрию распадов, физики и надеются отловить еще какие-нибудь неизвестные миру частицы, появление которых необъяснимо с точки зрения Стандартной модели.

В принципе, некоторое отклонение при сравнении смешивающихся фаз B-мезона от двух различных мод распада ожидаемо и в случае "старой физики". Однако Стандартная модель предсказывает отклонение лишь в пределах нескольких градусов, в то время как измеренное отклонение значительно больше - приблизительно 13 градусов. Кроме того, направление этого отклонения прямо противоположно теоретически предсказанному с помощью СМ.

Чтобы объяснить несоответствие между предсказываемым и наблюдаемым распадами, Синха и его группа, как мы уже упоминали, первоначально изучили возможности, которые может предоставить для объяснений Стандартная модель. Используя модельно независимый подход, они показали (в цифровой форме и геометрически), что отклонение смешиваемой фазы не может превышать слабой фазы одного из вкладов.

"Исключив какие-либо предположения, задействовавшие адроны, мы показали, что в рамках Стандартной модели объяснить наблюдаемое несоответствие при смешивании фаз B-мезонов невозможно, измерения включают лишь эти две известные моды", - пишут Синха и его коллеги. Однако чтобы подтвердить вывод о том, что большое отклонение действительно свидетельствует о проявлении Новой Физики, требуется гораздо больше наблюдений: "Мы должны собрать большие наборы данных по B-мезонам на B-мезонных фабриках* SLAC и KEK, и надеяться на то, что будущие модернизации оборудования позволят улучшить статистическое значение стандартного отклонения, - говорит Синха. - Маленькая фаза (названная в статье 'beta_s') могла бы быть измерена в будущем непосредственным образом".

Если Стандартная модель не сможет объяснить эти наблюдения, то физики-ядерщики начнут прокладывать путь к Новой Физике - физике, описывающей явления за пределами Стандартной модели. Ведь хотя Стандартная модель в свое время и оказала физикам много неоценимых услуг (так, со времен ее бурного расцвета в 1970-х гг. последовали точные объяснения и предсказания существования нескольких ранее неизвестных частиц), в настоящее время эта модель достигла своих пределов и не в состоянии объяснить новые явления, открываемые в самых разных областях (например, присутствие во Вселенной темного вещества, природу гравитации и наличие масс у частиц), и поэтому в дальнейших открытиях большой помощи уже не оказывает. Даже самая маленькая погрешность вроде этого неправильного предсказания смешивания B-фаз теперь может привести к новому пониманию частиц и сил, которые царят во Вселенной.

В интервью, данном PhysOrg.com, индийский теоретик упоминает о потенциальных кандидатах на роль этой самой Новой Физики. В частности, речь идет о суперсимметрии - самом популярном сценарии для дальнейшего развития Новой Физики (согласно предсказаниям этой теории, все частицы из Стандартной модели на самом деле имеют еще и так называемых суперпартнеров, при этом "темное вещество" - то есть материя, которая никак не поддается обнаружению, хотя во много раз перевешивает обычное вещество в космосе, - может как раз состоять из огромных роев таких суперсимметричных частиц, пронизывающих пространство). К сожалению, никаких экспериментальных данных в пользу суперсимметричных построений пока еще не получено. Конечно, можно уже считать установленным, что нейтрино обладает ненулевой массой покоя, однако для того, чтобы этот факт стал совместим со Стандартной моделью, требуются всего лишь небольшие "косметические" вставки, и всерьез выйти за пределы Стандартной модели таким образом не получается. Казалось также, что признаки Новой Физики проявились в ходе измерений магнитного момента мюона (там возникали небольшие несоответствия между теорией и экспериментом). Однако, из-за неуверенности в оценке влияния со стороны адронов, эффектов, вызванных сильными взаимодействиями (то есть родственных тем силам, что склеивают воедино ядра химических элементов), мы не можем говорить с полной уверенностью о том, что данные несоответствия действительно определяются присутствием Новой Физики.

"При применении нашего метода (который пока работает очень хорошо) при изучении слабых распадов мезонов нет никакой неуверенности, связанной с возможным влиянием адронной природы частиц [и, стало быть, сильными взаимодействиями], - говорит Синха. - Единственной причиной, по которой это несоответствие может не оказаться Новой Физикой, было бы исчезновение эффекта по мере дальнейшего набора статистики. Экспериментаторы делают такие оценки в терминах статистической значимости результатов. Указывается значение порядка 2,6 сигмы (среднеквадратичного отклонения), а это означает не менее чем однопроцентный шанс на то, что это несоответствие является лишь статистическим выбросом". Так что все-таки не исключено, что авторы статьи в очередной раз поторопились отыскать "Новую Физику" там, где ее еще нет.

На иллюстрации:

Это так называемая "пингвинья диаграмма". Она показывает, в частности, возможный путь взаимодействия с top-кварком - в нижней части петли (формирующей этакий "живот" пингвина). Новая Физика подразумевает ко всему прочему и участие в этих процессах (вот в этой самой "петле") каких-то совершенно новых частиц. Изображение с сайта Wikipedia (en.wikipedia.org). Между прочим, там же говорится о том, что термин "пингвиновые диаграммы" ввел Дж. Эллис, после того, как однажды проиграл в дартс. Условием игры было, что проигравший обязан употребить слово "пингвин" в своей следующей статье.

Источники:

Particle decay may point to New Physics - PhysOrg.com

Has New Physics already been seen in B_d meson decays? - arXiv.org - hep-ph

|

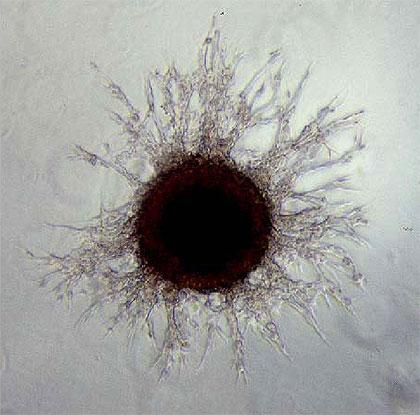

Получена формула развития раковой опухоли |

Анализируя сходство между процессом разбрызгивания капель воды и ростом раковых клеток, ученые США и Италии научились предсказывать возможный сценарий развития опухоли.