Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Проекции? Hет, спасибо |

Проекции? Hет, спасибо

Под катом будет небольшая заметка о применении пространственного индекса

на основе zcurve для индексации точечных данных, расположенных на сфере.

А так же bencmark-и для PostgreSQL и сравнение с таким же (но совсем другим)

индексом на R-дереве.

В развитие темы (1, 2, 3, 4, 5, 6).

Собственно, возвращаемся к самому началу — идее индексировать географические координаты, размещая их на поверхности сферы. Обычная индексация пары широта/долгота приводит к искажениям вдали от экватора, работа с проекциями не универсальна. Поэтому мысль переводить географические координаты в трехмерное пространство выглядит довольно изящно.

Сама по себе идея эта не нова, аналогично работает, например, расширение PostgreSQL — PGSphere, которое использует для индексации 3-мерное R-дерево. С ним и будем сравнивать.

Подготовка данных.

PGSphere

- Для начала придётся выкачать, собрать и инсталлировать расширение (автор использовал текущую версию 1.1.5)

gmake USE_PGXS=1 PG_CONFIG=/usr/bin/pg_config sudo gmake USE_PGXS=1 PG_CONFIG=/usr/bin/pg_config install - Далее загрузить его (psql)

CREATE EXTENSION pg_sphere; - Создадим таблицу для тестовых данных

CREATE TABLE spoint_data (sp spoint); - Нам потребуется источник случайных данных.

Первый параметр программы — радиус, второй — число результатов.

Единственная тонкость — данные равномерно распределены внутри шара с заданным радиусом, иначе не получится равномерного распределения на сфере - Случайные данные пропустим через скрипт awk чтобы превратить в геокоординаты

# --- gendata.awk ------ BEGIN{ pi=3.1415926535897932; degra=pi/180.0; rad=180.0/pi; Grad = 1000000.; } { x = $1; y = $2; z = $3; r3 = sqrt(x*x + y*y + z*z); x *= Grad / r3; y *= Grad / r3; z *= Grad / r3; r2 = sqrt(x*x + y*y); lat = atan2(z, r2) * rad; lon = 180. + atan2(y, x) * rad; printf ("(%14.10fd, %14.10fd)\n", lon, lat); } - Собственно создание данных, здесь радиус не важен, важно чтобы и pgsphere и zcurve получили одни и те же данные. Сортировка весьма желательна для ускорения индексации.

./random 1000000 100000000 | gawk -f gendata.awk | sort > pgsphere.txt - Заливаем данные в нашу таблицу

COPY spoint_data (sp) FROM '/home/.../pgsphere.txt'; - Индексируем

CREATE INDEX sp_idx ON spoint_data USING gist (sp);

ZORDER

- Для начала придётся выкачать, собрать и инсталлировать расширение

gmake USE_PGXS=1 PG_CONFIG=/usr/bin/pg_config sudo gmake USE_PGXS=1 PG_CONFIG=/usr/bin/pg_config install - Создадим таблицу для тестовых данных

create table test_points_3d (x integer,y integer, z integer); - Нам потребуется тот же источник случайных данных.

- Случайные данные пропустим через скрипт awk чтобы разместить их внутри куба со стороной в 2 000 000

#--- gendata2.awk ------ BEGIN{ pi=3.1415926535897932; degra=pi/180.0; rad=180.0/pi; Grad = 1000000.; } { x = $1; y = $2; z = $3; r3 = sqrt(x*x + y*y + z*z); x *= Grad / r3; y *= Grad / r3; z *= Grad / r3; ix = int(x+0.5+Grad); iy = int(y+0.5+Grad); iz = int(z+0.5+Grad); print ix"\t"iy"\t"iz; } - Собственно создание данных, здесь радиус важен. Сортировка не обязательна.

./random 1000000 100000000 | gawk -f gendata2.awk > zcurve.txt - Заливаем данные в нашу таблицу

COPY test_points_3d FROM '/home/.../zcurve.txt'; - Индексируем

create index zcurve_test_points_3d on test_points_3d(zcurve_num_from_xyz(x,y,z));

Подготовка тестов

PGSphere

Для тестирования потребуется вот такой awk скрипт

#--- gentest.awk -------

BEGIN{

pi=3.1415926535897932;

degra=pi/180.0;

rad=180.0/pi;

Grad = 1000000.;

}

{

x = $1; y = $2; z = $3;

r3 = sqrt(x*x + y*y + z*z);

x *= Grad / r3;

y *= Grad / r3;

z *= Grad / r3;

r2 = sqrt(x*x + y*y);

lat = atan2(z, r2) * rad;

lon = 180. + atan2(y, x) * rad;

# EXPLAIN (ANALYZE,BUFFERS)

printf ("select count(1) from spoint_data where sp @'<(%14.10fd,%14.10fd),.316d>'::scircle;\n", lon, lat);

}Этот скрипт вполне симметричен тому, с помощью которого мы подготавливали данные. Стоит обратить внимание на число .316, это радиус сферы с центром в вычисленной случайной точке, в которой мы ищем данные

Подготовка серии запросов делается так:

./random 1000000 100 1023 | gawk -f gentest.awk >tests1.sqlЗдесь 100 — размер тестовой серии, 1023 — seed рандомизатора.

ZCURVE

Для тестирования тоже потребуется awk скрипт

#--- gentest2.awk -------

BEGIN{

pi=3.1415926535897932;

degra=pi/180.0;

rad=180.0/pi;

Grad = 1000000.;

}

{

x = $1; y = $2; z = $3;

r3 = sqrt(x*x + y*y + z*z);

x *= Grad / r3;

y *= Grad / r3;

z *= Grad / r3;

ix = int(x+0.5+Grad);

iy = int(y+0.5+Grad);

iz = int(z+0.5+Grad);

# EXPLAIN (ANALYZE,BUFFERS)

lrad = int(0.5 + Grad * sin(.316 * degra));

print "select count(1) from zcurve_3d_lookup_tidonly('zcurve_test_points_3d', "ix-lrad","iy-lrad","iz-lrad","ix+lrad","iy+lrad","iz+lrad");";

}Этот скрипт вполне симметричен тому, с помощью которого мы подготавливали данные. Опять же, обращаем внимание на число .316, это половина стороны куба с центром в вычисленной случайной точке, в котором мы ищем данные.

Подготовка серии запросов делается так:

./random 1000000 100 1023 | gawk -f gentest2.awk >tests2.sqlЗдесь 100 — размер тестовой серии, 1023 — seed рандомизатора, лучше, если он совпадает с оным от pgsphere.

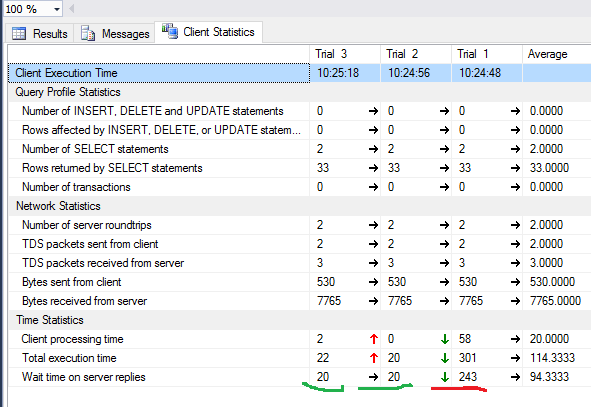

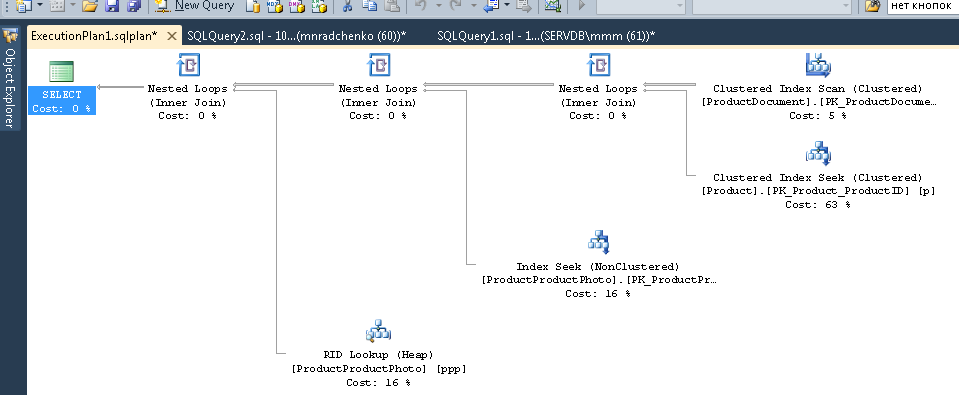

Benchmark

Как и раньше, замеры проводились на скромной виртуальной машине с двумя ядрами и 4 Гб ОЗУ, поэтому времена не имеют абсолютной ценности, а вот числам прочитанных страниц по прежнему можно доверять.

Времена показаны на вторых прогонах, на разогретом сервере и виртуальной машине. Количества прочитанных буферов — на свеже-поднятом сервере.

| Radius | AVG NPoints | Nreq | Type | Time(ms) | Reads | Hits |

|---|---|---|---|---|---|---|

| .01° | 1.17 0.7631 (0.7615) |

10 000 | zcurve rtree |

.37 .46 |

1.4397 2.1165 |

9.5647 3.087 |

| .0316° | 11.6 7.6392 (7.6045) |

10 000 | zcurve rtree |

.39 .67 |

2.0466 3.0944 |

20.9707 2.7769 |

| .1° | 115.22 76.193 (76.15) |

1 000 | zcurve rtree |

.44 2.75 * |

4.4184 6.073 |

82.8572 2.469 |

| .316° | 1145.3 758.37 (760.45) |

1 000 | zcurve rtree |

.59 18.3 * |

15.2719 21.706 |

401.791 1.62 |

| 1.° | 11310 7602 (7615) |

100 | zcurve rtree |

7.2 94.5 * |

74.9544 132.15 |

1651.45 1.12 |

Radius — размер поисковой области в градусах

Npoints — среднее число точек в выдаче, в скобках — теоретически ожидаемое число

(в сфере 41252.96 кв. градусов, 100 000 000 точек, ~2424 точки на кв. градус)

Nreq — число запросов в серии

Type —

‘zcurve’ — оно и есть

’rtree’- PGSphere

Time(ms) — среднее время выполнения запроса

Reads — среднее число чтений на запрос

Hits — число обращений к буферам

* в какой-то момент производительность R-tree начинает резко

проседать, связано это с тем, это дерево читает заметно больше

страниц и его рабочий набор перестаёт помещаться в кэше (по-видимому).

Отметим, что zcurve находит больше данных, что логично т.к. он ищет внутри куба, а не сферы как PGSphere. Поэтому требуется пост-фильтрация в духе HAVERSINE. Но здесь мы сравниваем только производительности индексов.

Попробуем оценить разницу. Вообще, задача найти площадь куска сферы, попавшей внутрь куба нетривиальна. Попробуем сделать оценку.

- Предположим, что наш куб в среднем вырезает из сферы ту же площадь, что и сфера равного объема

- Объем единичной сферы 1.33*3.14=4.19

- Объем куба со стороной 2 = 8.

- Тогда корень третьей степени из 8/4.19 = 1.24 — это отношение радиусов мнимой сферы к настоящей

- соотношение площадей мнимой сферы к настоящей 1.24*1.24=1.54

- имеем из экспериментальных данных 1.17/0.7631= 1.5332

Bingo!

|

Метки: author zzeng геоинформационные сервисы алгоритмы postgresql open source spatial index r-tree zorder spi субд |

Тянем ролик с YouTube и раздаем по WebRTC в реалтайме |

- Разработка систем связи,

- Разработка веб-сайтов,

- Программирование,

- Браузеры,

- Блог компании Flashphoner

Тянем ролик с YouTube и раздаем по WebRTC в реалтайме

- Разработка систем связи,

- Разработка веб-сайтов,

- Программирование,

- Браузеры,

- Блог компании Flashphoner

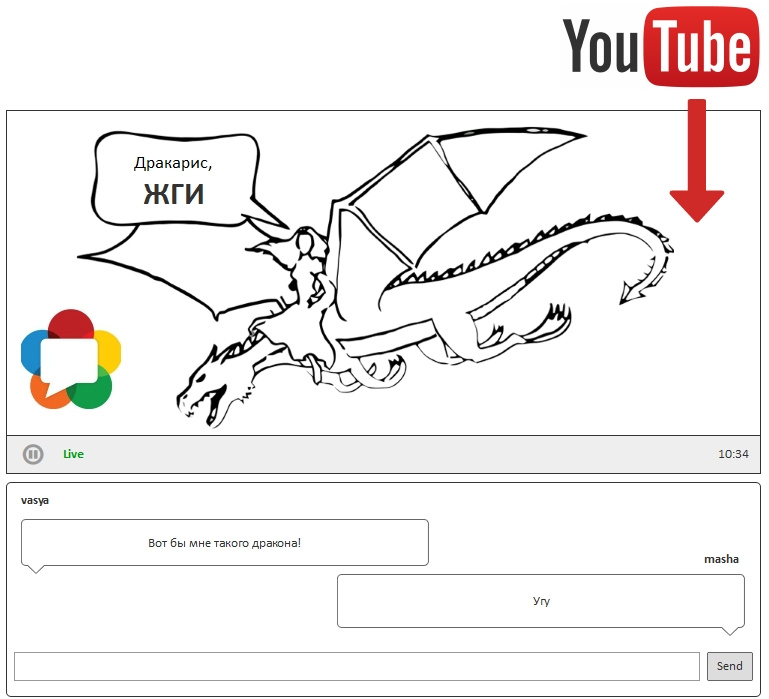

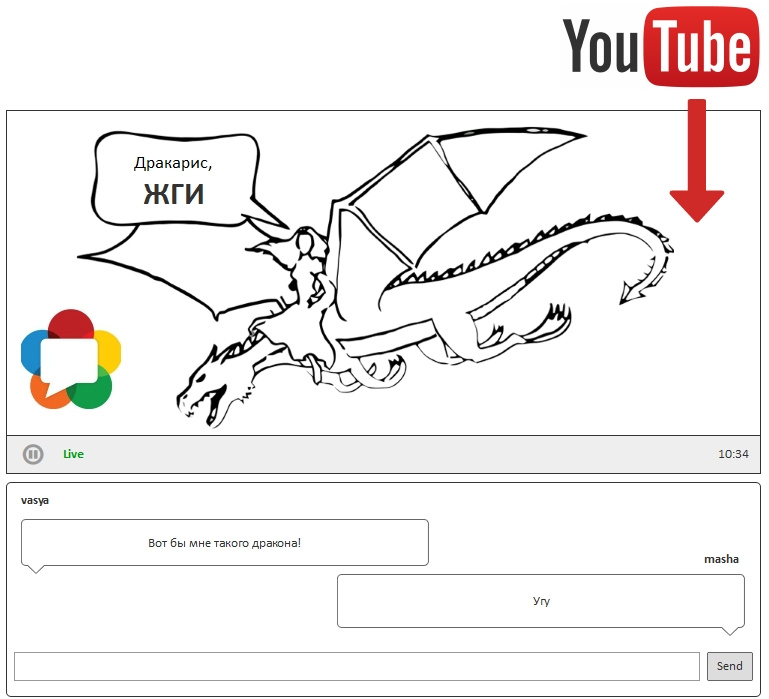

Задача следующая. Провести совместный просмотр ролика с YouTube в реальном времени несколькими пользователями. Зрители должны получать видео одновременно, с минимальной задержкой.

Ролик как стрим

Понятно, что если каждый из зрителей просто начнет играть ролик, цель не будет достигнута, т.к. один будет получать видео быстрее, другой медленнее. Возникнет неконтролируемый разброс.

Для того, чтобы разброса не было, нужно раздавать этот ролик всем одновременно. Это можно реализовать, если обернуть ролик в Live-stream. Покажем как это сделать с помощью связки этой библиотеки с ffmpeg.

Нам нужно реализовать схему, описанную выше. А именно, ydl подключается к YouTube и начинает скачивать ролик. FFmpeg подхватывает скачивающийся ролик, оборачивает его в RTMP поток и отправляет на сервер. Сервер раздает полученный поток как WebRTC в реальном времени.

Установка youtube-dl

Начинаем с установки youtube-dl. Процесс установки на Linux предельно простой и подробно описан в Readme под Lin и под Win.

1. Скачиваем.

curl -L https://yt-dl.org/downloads/latest/youtube-dl -o /usr/local/bin/youtube-dl2. Даем права на запуск

chmod a+rx /usr/local/bin/youtube-dlНа этом все. YouTube скачивалка готова к работе.

Возьмем ролик с YouTube и посмотрим на его мета-данные:

youtube-dl --list-formats https://www.youtube.com/watch?v=9cQT4urTlXMРезультат будет таким:

[youtube] 9cQT4urTlXM: Downloading webpage

[youtube] 9cQT4urTlXM: Downloading video info webpage

[youtube] 9cQT4urTlXM: Extracting video information

[youtube] 9cQT4urTlXM: Downloading MPD manifest

[info] Available formats for 9cQT4urTlXM:

format code extension resolution note

171 webm audio only DASH audio 8k , vorbis@128k, 540.24KiB

249 webm audio only DASH audio 10k , opus @ 50k, 797.30KiB

250 webm audio only DASH audio 10k , opus @ 70k, 797.30KiB

251 webm audio only DASH audio 10k , opus @160k, 797.30KiB

139 m4a audio only DASH audio 53k , m4a_dash container, mp4a.40.5@ 48k (22050Hz), 10.36MiB

140 m4a audio only DASH audio 137k , m4a_dash container, mp4a.40.2@128k (44100Hz), 27.56MiB

278 webm 256x144 144p 41k , webm container, vp9, 30fps, video only, 6.54MiB

242 webm 426x240 240p 70k , vp9, 30fps, video only, 13.42MiB

243 webm 640x360 360p 101k , vp9, 30fps, video only, 20.55MiB

160 mp4 256x144 DASH video 123k , avc1.4d400c, 15fps, video only, 24.83MiB

134 mp4 640x360 DASH video 138k , avc1.4d401e, 30fps, video only, 28.07MiB

244 webm 854x480 480p 149k , vp9, 30fps, video only, 30.55MiB

135 mp4 854x480 DASH video 209k , avc1.4d401f, 30fps, video only, 42.42MiB

133 mp4 426x240 DASH video 274k , avc1.4d4015, 30fps, video only, 57.63MiB

247 webm 1280x720 720p 298k , vp9, 30fps, video only, 59.25MiB

136 mp4 1280x720 DASH video 307k , avc1.4d401f, 30fps, video only, 62.58MiB

17 3gp 176x144 small , mp4v.20.3, mp4a.40.2@ 24k

36 3gp 320x180 small , mp4v.20.3, mp4a.40.2

43 webm 640x360 medium , vp8.0, vorbis@128k

18 mp4 640x360 medium , avc1.42001E, mp4a.40.2@ 96k

22 mp4 1280x720 hd720 , avc1.64001F, mp4a.40.2@192k (best)Установка ffmpeg

Далее устанавливаем ffmpeg стандартными заклинаниями:

wget http://ffmpeg.org/releases/ffmpeg-3.3.4.tar.bz2

tar -xvjf ffmpeg-3.3.4.tar.bz2

cd ffmpeg-3.3.4

./configure --enable-shared --disable-logging --enable-gpl --enable-pthreads --enable-libx264 --enable-librtmp

make

make installПроверяем что получилось

ffmpeg -vТеперь самое интересное. Библиотека youtube-dl предназначена для скачивания. Она так и называется YouTube Download. Т.е. Можно скачать youtube ролик полностью и уже после этого застримить его через ffmpeg как файл.

Но представим такой юзеркейс. Сидят в веб-конференции маркетолог, менеджер и программист. Маркетолог хочет показать всем в реальном времени ролик с YouTube, который весит, скажем 300 мегабайт. Согласитесь, возникнет некая неловкость, если нужно будет выкачать весь ролик перед тем, как начать его показ.

- Маркетолог говорит — «А теперь, коллеги, давайте посмотрим этот ролик с котиками, он полностью отвечает нашей стратегии выхода на рынок», и жмет кнопку «показать всем ролик».

- На экране появляется прелоадер: «Подождите, ролик с котиками скачивается. Это займет не более 10 минут».

- Менеджер идет пить кофе, а программист — читать хабр.

Чтобы не заставлять людей ждать, нужен реалтайм. Нужно подхватывать ролик прямо во время скачивания, на лету оборачивать в стрим и раздавать в реальном времени. Далее мы покажем как это сделать.

Передача данных из youtube-dl в ffmpeg

Граббер youtube-dl сохраняет поток в файловой системе. Нужно подключиться к этому потоку и организовать зачитку из файла ffmpeg-ом по мере его скачивания с помощью youtube-dl.

Чтобы объединить эти два процесса: скачивание и стриминг ffmpeg, нам потребуется небольшой связывающий скрипт.

#!/usr/bin/python

import subprocess

import sys

def show_help():

print 'Usage: '

print './streamer.py url streamName destination'

print './streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM streamName rtmp://192.168.88.59:1935/live'

return

def streamer() :

url = sys.argv[1]

if not url :

print 'Error: url is empty'

return

stream_id = sys.argv[2]

if not stream_id:

print 'Error: stream name is empty'

return

destination = sys.argv[3]

if not destination:

print 'Error: destination is empty'

return

_youtube_process = subprocess.Popen(('youtube-dl','-f','','--prefer-ffmpeg', '--no-color', '--no-cache-dir', '--no-progress','-o', '-', '-f', '22/18', url, '--reject-title', stream_id),stdout=subprocess.PIPE)

_ffmpeg_process = subprocess.Popen(('ffmpeg','-re','-i', '-','-preset', 'ultrafast','-vcodec', 'copy', '-acodec', 'copy','-threads','1', '-f', 'flv',destination + "/" + stream_id), stdin=_youtube_process.stdout)

return

if len(sys.argv) < 4:

show_help()

else:

streamer()Этот питон-скрипт делает следующее:

- Создает подпроцесс _youtube_process зачитки ролика библиотекой youtube-dl

- Создает второй подпроцесс _ffmpeg_process, которому передаются данные из первого через pipe. Этот процесс уже создает RTMP поток и отправляет его на сервер по указанному адресу.

Тестирование скрипта

Для запуска скрипта нужно установить python. Скачать можно здесь.

Мы при тестировании использовали версию 2.6.6. Скорее всего подойдет любая версия, т.к. скрипт достаточно простой и его задача — передать из одного процесса в другой.

Запуск скрипта:

python streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM stream1 rtmp://192.168.88.59:1935/liveКак видите, передается три аргумента:

- Адрес youtube ролика.

www.youtube.com/watch?v=9cQT4urTlXM - Имя потока, с которым будет проходить RTMP-трансляция.

stream1 - Адрес RTMP-сервера.

rtmp://192.168.88.59:1935/live

Для тестирования мы будем использовать Web Call Server. Он умеет принимать RTMP потоки и раздавать их по WebRTC. Здесь можно скачать и установить WCS5 на свой VPS или локальный тестовый сервер под управлением Linux.

Схема тестирования с Web Call Server:

Ниже мы задействуем для теста один из демо-серверов:

rtmp://wcs5-eu.flashphoner.com:1935/liveЭто RTMP адрес, который нужно передать скрипту streamer.py чтобы быстро протестировать трансляцию с нашим демо-сервером.

Запуск должен выглядеть так:

python streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM stream1 rtmp://wcs5-eu.flashphoner.com:1935/liveВ консоли stdout увидим следующий вывод:

# python streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM stream1 rtmp://wcs5-eu.flashphoner.com:1935/live

ffmpeg version 3.2.3 Copyright (c) 2000-2017 the FFmpeg developers

built with gcc 4.4.7 (GCC) 20120313 (Red Hat 4.4.7-11)

configuration: --enable-shared --disable-logging --enable-gpl --enable-pthreads --enable-libx264 --enable-librtmp --disable-yasm

libavutil 55. 34.101 / 55. 34.101

libavcodec 57. 64.101 / 57. 64.101

libavformat 57. 56.101 / 57. 56.101

libavdevice 57. 1.100 / 57. 1.100

libavfilter 6. 65.100 / 6. 65.100

libswscale 4. 2.100 / 4. 2.100

libswresample 2. 3.100 / 2. 3.100

libpostproc 54. 1.100 / 54. 1.100

]# [youtube] 9cQT4urTlXM: Downloading webpage

[youtube] 9cQT4urTlXM: Downloading video info webpage

[youtube] 9cQT4urTlXM: Extracting video information

[youtube] 9cQT4urTlXM: Downloading MPD manifest

[download] Destination: -

Input #0, mov,mp4,m4a,3gp,3g2,mj2, from 'pipe:':

Metadata:

major_brand : mp42

minor_version : 0

compatible_brands: isommp42

creation_time : 2016-08-23T12:21:06.000000Z

Duration: 00:29:59.99, start: 0.000000, bitrate: N/A

Stream #0:0(und): Video: h264 (Main) (avc1 / 0x31637661), yuv420p, 1280x720 [SAR 1:1 DAR 16:9], 288 kb/s, 30 fps, 30 tbr, 90k tbn, 60 tbc (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Stream #0:1(und): Audio: aac (LC) (mp4a / 0x6134706D), 44100 Hz, stereo, fltp, 125 kb/s (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Output #0, flv, to 'rtmp://192.168.88.59:1935/live/stream1':

Metadata:

major_brand : mp42

minor_version : 0

compatible_brands: isommp42

encoder : Lavf57.56.101

Stream #0:0(und): Video: h264 (Main) ([7][0][0][0] / 0x0007), yuv420p, 1280x720 [SAR 1:1 DAR 16:9], q=2-31, 288 kb/s, 30 fps, 30 tbr, 1k tbn, 90k tbc (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Stream #0:1(und): Audio: aac (LC) ([10][0][0][0] / 0x000A), 44100 Hz, stereo, 125 kb/s (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Stream mapping:

Stream #0:0 -> #0:0 (copy)

Stream #0:1 -> #0:1 (copy)

frame= 383 fps= 30 q=-1.0 size= 654kB time=00:00:12.70 bitrate= 421.8kbits/s speed= 1xЕсли бегло пробежать по этому логу, то можно понять, что происходит следующее:

- Открывается страница с видеороликом.

- Извлекаются данные о видео форматах.

- Скачивается mp4 ролик 1280x720, H.264+AAC

- Запускается ffmpeg, подхватывает скачиваемые данные и стримит по RTMP с битрейтом 421 kbps. Такой скудный битрейт объясняется выбранным роликом с таймером. Нормальный видеоролик даст на порядок большее значение битрейта.

После того, как процесс стриминга запустился, пытаемся проиграть поток в WebRTC плеере. Имя потока задается в поле Stream, а адрес сервера в поле Server. Подключение к серверу происходит по протоколу Websocket (wss), а поток приходит на плеер по WebRTC (UDP).

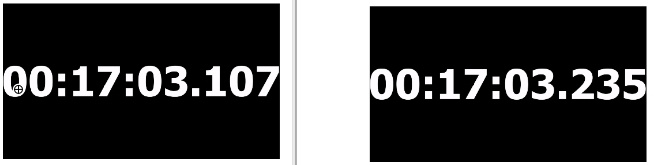

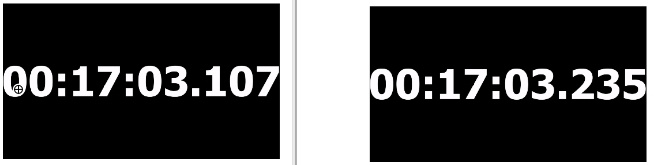

Мы специально взяли именно этот ролик на YouTube, чтобы иметь возможность протестировать реалтаймовость потока, ведь нашей конечной целью было доставить поток с YouTube ко всем зрителям одновременно, с минимальной задержкой и разбросом во времени. Ролик с миллисекундным таймером, как нельзя более подходит для такого теста.

Сам тест очень простой. Открываем две вкладки браузера (моделируем двух зрителей), играем этот поток с таймером по нашей схеме, и делаем несколько скриншотов, чтобы запечатлеть разницу во времени прибытия видео. Далее сравниваем миллисекунды и видим кто получил видео раньше, а кто позже и на сколько.

Получаем следующие результаты:

Test 1

Test 2

Test 3

Как видите, каждый из зрителей видит одно и то же видео, с разбросом не более 130 миллисекунд.

Таким образом задача реалтаймовой трансляции ролика с YouTube на WebRTC решена. Зрители получили поток практически одновременно. Менеджер не ушел пить кофе, программист — читать хабр, а маркетолог успешно показал всем ролик с котиками.

Хорошего стриминга!

Ссылки

youtube-dl — библиотека для скачивания видео с YouTube

ffmpeg — RTMP encoder

Web Call Server — сервер, умеющий раздвать RTMP поток по WebRTC

streamer.py — скрипт для интеграции youtube-dl и ffmpeg с отправкой RTMP потока

|

|

Тянем ролик с YouTube и раздаем по WebRTC в реалтайме |

- Разработка систем связи,

- Разработка веб-сайтов,

- Программирование,

- Браузеры,

- Блог компании Flashphoner

Тянем ролик с YouTube и раздаем по WebRTC в реалтайме

- Разработка систем связи,

- Разработка веб-сайтов,

- Программирование,

- Браузеры,

- Блог компании Flashphoner

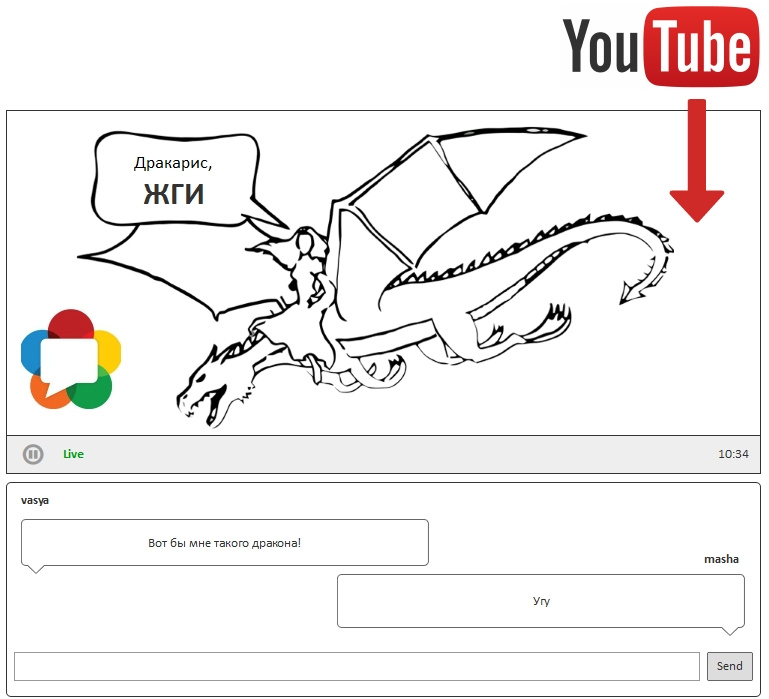

Задача следующая. Провести совместный просмотр ролика с YouTube в реальном времени несколькими пользователями. Зрители должны получать видео одновременно, с минимальной задержкой.

Ролик как стрим

Понятно, что если каждый из зрителей просто начнет играть ролик, цель не будет достигнута, т.к. один будет получать видео быстрее, другой медленнее. Возникнет неконтролируемый разброс.

Для того, чтобы разброса не было, нужно раздавать этот ролик всем одновременно. Это можно реализовать, если обернуть ролик в Live-stream. Покажем как это сделать с помощью связки этой библиотеки с ffmpeg.

Нам нужно реализовать схему, описанную выше. А именно, ydl подключается к YouTube и начинает скачивать ролик. FFmpeg подхватывает скачивающийся ролик, оборачивает его в RTMP поток и отправляет на сервер. Сервер раздает полученный поток как WebRTC в реальном времени.

Установка youtube-dl

Начинаем с установки youtube-dl. Процесс установки на Linux предельно простой и подробно описан в Readme под Lin и под Win.

1. Скачиваем.

curl -L https://yt-dl.org/downloads/latest/youtube-dl -o /usr/local/bin/youtube-dl2. Даем права на запуск

chmod a+rx /usr/local/bin/youtube-dlНа этом все. YouTube скачивалка готова к работе.

Возьмем ролик с YouTube и посмотрим на его мета-данные:

youtube-dl --list-formats https://www.youtube.com/watch?v=9cQT4urTlXMРезультат будет таким:

[youtube] 9cQT4urTlXM: Downloading webpage

[youtube] 9cQT4urTlXM: Downloading video info webpage

[youtube] 9cQT4urTlXM: Extracting video information

[youtube] 9cQT4urTlXM: Downloading MPD manifest

[info] Available formats for 9cQT4urTlXM:

format code extension resolution note

171 webm audio only DASH audio 8k , vorbis@128k, 540.24KiB

249 webm audio only DASH audio 10k , opus @ 50k, 797.30KiB

250 webm audio only DASH audio 10k , opus @ 70k, 797.30KiB

251 webm audio only DASH audio 10k , opus @160k, 797.30KiB

139 m4a audio only DASH audio 53k , m4a_dash container, mp4a.40.5@ 48k (22050Hz), 10.36MiB

140 m4a audio only DASH audio 137k , m4a_dash container, mp4a.40.2@128k (44100Hz), 27.56MiB

278 webm 256x144 144p 41k , webm container, vp9, 30fps, video only, 6.54MiB

242 webm 426x240 240p 70k , vp9, 30fps, video only, 13.42MiB

243 webm 640x360 360p 101k , vp9, 30fps, video only, 20.55MiB

160 mp4 256x144 DASH video 123k , avc1.4d400c, 15fps, video only, 24.83MiB

134 mp4 640x360 DASH video 138k , avc1.4d401e, 30fps, video only, 28.07MiB

244 webm 854x480 480p 149k , vp9, 30fps, video only, 30.55MiB

135 mp4 854x480 DASH video 209k , avc1.4d401f, 30fps, video only, 42.42MiB

133 mp4 426x240 DASH video 274k , avc1.4d4015, 30fps, video only, 57.63MiB

247 webm 1280x720 720p 298k , vp9, 30fps, video only, 59.25MiB

136 mp4 1280x720 DASH video 307k , avc1.4d401f, 30fps, video only, 62.58MiB

17 3gp 176x144 small , mp4v.20.3, mp4a.40.2@ 24k

36 3gp 320x180 small , mp4v.20.3, mp4a.40.2

43 webm 640x360 medium , vp8.0, vorbis@128k

18 mp4 640x360 medium , avc1.42001E, mp4a.40.2@ 96k

22 mp4 1280x720 hd720 , avc1.64001F, mp4a.40.2@192k (best)Установка ffmpeg

Далее устанавливаем ffmpeg стандартными заклинаниями:

wget http://ffmpeg.org/releases/ffmpeg-3.3.4.tar.bz2

tar -xvjf ffmpeg-3.3.4.tar.bz2

cd ffmpeg-3.3.4

./configure --enable-shared --disable-logging --enable-gpl --enable-pthreads --enable-libx264 --enable-librtmp

make

make installПроверяем что получилось

ffmpeg -vТеперь самое интересное. Библиотека youtube-dl предназначена для скачивания. Она так и называется YouTube Download. Т.е. Можно скачать youtube ролик полностью и уже после этого застримить его через ffmpeg как файл.

Но представим такой юзеркейс. Сидят в веб-конференции маркетолог, менеджер и программист. Маркетолог хочет показать всем в реальном времени ролик с YouTube, который весит, скажем 300 мегабайт. Согласитесь, возникнет некая неловкость, если нужно будет выкачать весь ролик перед тем, как начать его показ.

- Маркетолог говорит — «А теперь, коллеги, давайте посмотрим этот ролик с котиками, он полностью отвечает нашей стратегии выхода на рынок», и жмет кнопку «показать всем ролик».

- На экране появляется прелоадер: «Подождите, ролик с котиками скачивается. Это займет не более 10 минут».

- Менеджер идет пить кофе, а программист — читать хабр.

Чтобы не заставлять людей ждать, нужен реалтайм. Нужно подхватывать ролик прямо во время скачивания, на лету оборачивать в стрим и раздавать в реальном времени. Далее мы покажем как это сделать.

Передача данных из youtube-dl в ffmpeg

Граббер youtube-dl сохраняет поток в файловой системе. Нужно подключиться к этому потоку и организовать зачитку из файла ffmpeg-ом по мере его скачивания с помощью youtube-dl.

Чтобы объединить эти два процесса: скачивание и стриминг ffmpeg, нам потребуется небольшой связывающий скрипт.

#!/usr/bin/python

import subprocess

import sys

def show_help():

print 'Usage: '

print './streamer.py url streamName destination'

print './streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM streamName rtmp://192.168.88.59:1935/live'

return

def streamer() :

url = sys.argv[1]

if not url :

print 'Error: url is empty'

return

stream_id = sys.argv[2]

if not stream_id:

print 'Error: stream name is empty'

return

destination = sys.argv[3]

if not destination:

print 'Error: destination is empty'

return

_youtube_process = subprocess.Popen(('youtube-dl','-f','','--prefer-ffmpeg', '--no-color', '--no-cache-dir', '--no-progress','-o', '-', '-f', '22/18', url, '--reject-title', stream_id),stdout=subprocess.PIPE)

_ffmpeg_process = subprocess.Popen(('ffmpeg','-re','-i', '-','-preset', 'ultrafast','-vcodec', 'copy', '-acodec', 'copy','-threads','1', '-f', 'flv',destination + "/" + stream_id), stdin=_youtube_process.stdout)

return

if len(sys.argv) < 4:

show_help()

else:

streamer()Этот питон-скрипт делает следующее:

- Создает подпроцесс _youtube_process зачитки ролика библиотекой youtube-dl

- Создает второй подпроцесс _ffmpeg_process, которому передаются данные из первого через pipe. Этот процесс уже создает RTMP поток и отправляет его на сервер по указанному адресу.

Тестирование скрипта

Для запуска скрипта нужно установить python. Скачать можно здесь.

Мы при тестировании использовали версию 2.6.6. Скорее всего подойдет любая версия, т.к. скрипт достаточно простой и его задача — передать из одного процесса в другой.

Запуск скрипта:

python streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM stream1 rtmp://192.168.88.59:1935/liveКак видите, передается три аргумента:

- Адрес youtube ролика.

www.youtube.com/watch?v=9cQT4urTlXM - Имя потока, с которым будет проходить RTMP-трансляция.

stream1 - Адрес RTMP-сервера.

rtmp://192.168.88.59:1935/live

Для тестирования мы будем использовать Web Call Server. Он умеет принимать RTMP потоки и раздавать их по WebRTC. Здесь можно скачать и установить WCS5 на свой VPS или локальный тестовый сервер под управлением Linux.

Схема тестирования с Web Call Server:

Ниже мы задействуем для теста один из демо-серверов:

rtmp://wcs5-eu.flashphoner.com:1935/liveЭто RTMP адрес, который нужно передать скрипту streamer.py чтобы быстро протестировать трансляцию с нашим демо-сервером.

Запуск должен выглядеть так:

python streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM stream1 rtmp://wcs5-eu.flashphoner.com:1935/liveВ консоли stdout увидим следующий вывод:

# python streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM stream1 rtmp://wcs5-eu.flashphoner.com:1935/live

ffmpeg version 3.2.3 Copyright (c) 2000-2017 the FFmpeg developers

built with gcc 4.4.7 (GCC) 20120313 (Red Hat 4.4.7-11)

configuration: --enable-shared --disable-logging --enable-gpl --enable-pthreads --enable-libx264 --enable-librtmp --disable-yasm

libavutil 55. 34.101 / 55. 34.101

libavcodec 57. 64.101 / 57. 64.101

libavformat 57. 56.101 / 57. 56.101

libavdevice 57. 1.100 / 57. 1.100

libavfilter 6. 65.100 / 6. 65.100

libswscale 4. 2.100 / 4. 2.100

libswresample 2. 3.100 / 2. 3.100

libpostproc 54. 1.100 / 54. 1.100

]# [youtube] 9cQT4urTlXM: Downloading webpage

[youtube] 9cQT4urTlXM: Downloading video info webpage

[youtube] 9cQT4urTlXM: Extracting video information

[youtube] 9cQT4urTlXM: Downloading MPD manifest

[download] Destination: -

Input #0, mov,mp4,m4a,3gp,3g2,mj2, from 'pipe:':

Metadata:

major_brand : mp42

minor_version : 0

compatible_brands: isommp42

creation_time : 2016-08-23T12:21:06.000000Z

Duration: 00:29:59.99, start: 0.000000, bitrate: N/A

Stream #0:0(und): Video: h264 (Main) (avc1 / 0x31637661), yuv420p, 1280x720 [SAR 1:1 DAR 16:9], 288 kb/s, 30 fps, 30 tbr, 90k tbn, 60 tbc (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Stream #0:1(und): Audio: aac (LC) (mp4a / 0x6134706D), 44100 Hz, stereo, fltp, 125 kb/s (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Output #0, flv, to 'rtmp://192.168.88.59:1935/live/stream1':

Metadata:

major_brand : mp42

minor_version : 0

compatible_brands: isommp42

encoder : Lavf57.56.101

Stream #0:0(und): Video: h264 (Main) ([7][0][0][0] / 0x0007), yuv420p, 1280x720 [SAR 1:1 DAR 16:9], q=2-31, 288 kb/s, 30 fps, 30 tbr, 1k tbn, 90k tbc (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Stream #0:1(und): Audio: aac (LC) ([10][0][0][0] / 0x000A), 44100 Hz, stereo, 125 kb/s (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Stream mapping:

Stream #0:0 -> #0:0 (copy)

Stream #0:1 -> #0:1 (copy)

frame= 383 fps= 30 q=-1.0 size= 654kB time=00:00:12.70 bitrate= 421.8kbits/s speed= 1xЕсли бегло пробежать по этому логу, то можно понять, что происходит следующее:

- Открывается страница с видеороликом.

- Извлекаются данные о видео форматах.

- Скачивается mp4 ролик 1280x720, H.264+AAC

- Запускается ffmpeg, подхватывает скачиваемые данные и стримит по RTMP с битрейтом 421 kbps. Такой скудный битрейт объясняется выбранным роликом с таймером. Нормальный видеоролик даст на порядок большее значение битрейта.

После того, как процесс стриминга запустился, пытаемся проиграть поток в WebRTC плеере. Имя потока задается в поле Stream, а адрес сервера в поле Server. Подключение к серверу происходит по протоколу Websocket (wss), а поток приходит на плеер по WebRTC (UDP).

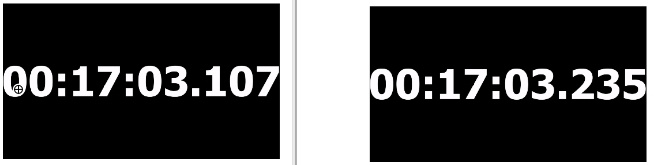

Мы специально взяли именно этот ролик на YouTube, чтобы иметь возможность протестировать реалтаймовость потока, ведь нашей конечной целью было доставить поток с YouTube ко всем зрителям одновременно, с минимальной задержкой и разбросом во времени. Ролик с миллисекундным таймером, как нельзя более подходит для такого теста.

Сам тест очень простой. Открываем две вкладки браузера (моделируем двух зрителей), играем этот поток с таймером по нашей схеме, и делаем несколько скриншотов, чтобы запечатлеть разницу во времени прибытия видео. Далее сравниваем миллисекунды и видим кто получил видео раньше, а кто позже и на сколько.

Получаем следующие результаты:

Test 1

Test 2

Test 3

Как видите, каждый из зрителей видит одно и то же видео, с разбросом не более 130 миллисекунд.

Таким образом задача реалтаймовой трансляции ролика с YouTube на WebRTC решена. Зрители получили поток практически одновременно. Менеджер не ушел пить кофе, программист — читать хабр, а маркетолог успешно показал всем ролик с котиками.

Хорошего стриминга!

Ссылки

youtube-dl — библиотека для скачивания видео с YouTube

ffmpeg — RTMP encoder

Web Call Server — сервер, умеющий раздвать RTMP поток по WebRTC

streamer.py — скрипт для интеграции youtube-dl и ffmpeg с отправкой RTMP потока

|

|

Тянем ролик с YouTube и раздаем по WebRTC в реалтайме |

- Разработка систем связи,

- Разработка веб-сайтов,

- Программирование,

- Браузеры,

- Блог компании Flashphoner

Тянем ролик с YouTube и раздаем по WebRTC в реалтайме

- Разработка систем связи,

- Разработка веб-сайтов,

- Программирование,

- Браузеры,

- Блог компании Flashphoner

Задача следующая. Провести совместный просмотр ролика с YouTube в реальном времени несколькими пользователями. Зрители должны получать видео одновременно, с минимальной задержкой.

Ролик как стрим

Понятно, что если каждый из зрителей просто начнет играть ролик, цель не будет достигнута, т.к. один будет получать видео быстрее, другой медленнее. Возникнет неконтролируемый разброс.

Для того, чтобы разброса не было, нужно раздавать этот ролик всем одновременно. Это можно реализовать, если обернуть ролик в Live-stream. Покажем как это сделать с помощью связки этой библиотеки с ffmpeg.

Нам нужно реализовать схему, описанную выше. А именно, ydl подключается к YouTube и начинает скачивать ролик. FFmpeg подхватывает скачивающийся ролик, оборачивает его в RTMP поток и отправляет на сервер. Сервер раздает полученный поток как WebRTC в реальном времени.

Установка youtube-dl

Начинаем с установки youtube-dl. Процесс установки на Linux предельно простой и подробно описан в Readme под Lin и под Win.

1. Скачиваем.

curl -L https://yt-dl.org/downloads/latest/youtube-dl -o /usr/local/bin/youtube-dl2. Даем права на запуск

chmod a+rx /usr/local/bin/youtube-dlНа этом все. YouTube скачивалка готова к работе.

Возьмем ролик с YouTube и посмотрим на его мета-данные:

youtube-dl --list-formats https://www.youtube.com/watch?v=9cQT4urTlXMРезультат будет таким:

[youtube] 9cQT4urTlXM: Downloading webpage

[youtube] 9cQT4urTlXM: Downloading video info webpage

[youtube] 9cQT4urTlXM: Extracting video information

[youtube] 9cQT4urTlXM: Downloading MPD manifest

[info] Available formats for 9cQT4urTlXM:

format code extension resolution note

171 webm audio only DASH audio 8k , vorbis@128k, 540.24KiB

249 webm audio only DASH audio 10k , opus @ 50k, 797.30KiB

250 webm audio only DASH audio 10k , opus @ 70k, 797.30KiB

251 webm audio only DASH audio 10k , opus @160k, 797.30KiB

139 m4a audio only DASH audio 53k , m4a_dash container, mp4a.40.5@ 48k (22050Hz), 10.36MiB

140 m4a audio only DASH audio 137k , m4a_dash container, mp4a.40.2@128k (44100Hz), 27.56MiB

278 webm 256x144 144p 41k , webm container, vp9, 30fps, video only, 6.54MiB

242 webm 426x240 240p 70k , vp9, 30fps, video only, 13.42MiB

243 webm 640x360 360p 101k , vp9, 30fps, video only, 20.55MiB

160 mp4 256x144 DASH video 123k , avc1.4d400c, 15fps, video only, 24.83MiB

134 mp4 640x360 DASH video 138k , avc1.4d401e, 30fps, video only, 28.07MiB

244 webm 854x480 480p 149k , vp9, 30fps, video only, 30.55MiB

135 mp4 854x480 DASH video 209k , avc1.4d401f, 30fps, video only, 42.42MiB

133 mp4 426x240 DASH video 274k , avc1.4d4015, 30fps, video only, 57.63MiB

247 webm 1280x720 720p 298k , vp9, 30fps, video only, 59.25MiB

136 mp4 1280x720 DASH video 307k , avc1.4d401f, 30fps, video only, 62.58MiB

17 3gp 176x144 small , mp4v.20.3, mp4a.40.2@ 24k

36 3gp 320x180 small , mp4v.20.3, mp4a.40.2

43 webm 640x360 medium , vp8.0, vorbis@128k

18 mp4 640x360 medium , avc1.42001E, mp4a.40.2@ 96k

22 mp4 1280x720 hd720 , avc1.64001F, mp4a.40.2@192k (best)Установка ffmpeg

Далее устанавливаем ffmpeg стандартными заклинаниями:

wget http://ffmpeg.org/releases/ffmpeg-3.3.4.tar.bz2

tar -xvjf ffmpeg-3.3.4.tar.bz2

cd ffmpeg-3.3.4

./configure --enable-shared --disable-logging --enable-gpl --enable-pthreads --enable-libx264 --enable-librtmp

make

make installПроверяем что получилось

ffmpeg -vТеперь самое интересное. Библиотека youtube-dl предназначена для скачивания. Она так и называется YouTube Download. Т.е. Можно скачать youtube ролик полностью и уже после этого застримить его через ffmpeg как файл.

Но представим такой юзеркейс. Сидят в веб-конференции маркетолог, менеджер и программист. Маркетолог хочет показать всем в реальном времени ролик с YouTube, который весит, скажем 300 мегабайт. Согласитесь, возникнет некая неловкость, если нужно будет выкачать весь ролик перед тем, как начать его показ.

- Маркетолог говорит — «А теперь, коллеги, давайте посмотрим этот ролик с котиками, он полностью отвечает нашей стратегии выхода на рынок», и жмет кнопку «показать всем ролик».

- На экране появляется прелоадер: «Подождите, ролик с котиками скачивается. Это займет не более 10 минут».

- Менеджер идет пить кофе, а программист — читать хабр.

Чтобы не заставлять людей ждать, нужен реалтайм. Нужно подхватывать ролик прямо во время скачивания, на лету оборачивать в стрим и раздавать в реальном времени. Далее мы покажем как это сделать.

Передача данных из youtube-dl в ffmpeg

Граббер youtube-dl сохраняет поток в файловой системе. Нужно подключиться к этому потоку и организовать зачитку из файла ffmpeg-ом по мере его скачивания с помощью youtube-dl.

Чтобы объединить эти два процесса: скачивание и стриминг ffmpeg, нам потребуется небольшой связывающий скрипт.

#!/usr/bin/python

import subprocess

import sys

def show_help():

print 'Usage: '

print './streamer.py url streamName destination'

print './streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM streamName rtmp://192.168.88.59:1935/live'

return

def streamer() :

url = sys.argv[1]

if not url :

print 'Error: url is empty'

return

stream_id = sys.argv[2]

if not stream_id:

print 'Error: stream name is empty'

return

destination = sys.argv[3]

if not destination:

print 'Error: destination is empty'

return

_youtube_process = subprocess.Popen(('youtube-dl','-f','','--prefer-ffmpeg', '--no-color', '--no-cache-dir', '--no-progress','-o', '-', '-f', '22/18', url, '--reject-title', stream_id),stdout=subprocess.PIPE)

_ffmpeg_process = subprocess.Popen(('ffmpeg','-re','-i', '-','-preset', 'ultrafast','-vcodec', 'copy', '-acodec', 'copy','-threads','1', '-f', 'flv',destination + "/" + stream_id), stdin=_youtube_process.stdout)

return

if len(sys.argv) < 4:

show_help()

else:

streamer()Этот питон-скрипт делает следующее:

- Создает подпроцесс _youtube_process зачитки ролика библиотекой youtube-dl

- Создает второй подпроцесс _ffmpeg_process, которому передаются данные из первого через pipe. Этот процесс уже создает RTMP поток и отправляет его на сервер по указанному адресу.

Тестирование скрипта

Для запуска скрипта нужно установить python. Скачать можно здесь.

Мы при тестировании использовали версию 2.6.6. Скорее всего подойдет любая версия, т.к. скрипт достаточно простой и его задача — передать из одного процесса в другой.

Запуск скрипта:

python streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM stream1 rtmp://192.168.88.59:1935/liveКак видите, передается три аргумента:

- Адрес youtube ролика.

www.youtube.com/watch?v=9cQT4urTlXM - Имя потока, с которым будет проходить RTMP-трансляция.

stream1 - Адрес RTMP-сервера.

rtmp://192.168.88.59:1935/live

Для тестирования мы будем использовать Web Call Server. Он умеет принимать RTMP потоки и раздавать их по WebRTC. Здесь можно скачать и установить WCS5 на свой VPS или локальный тестовый сервер под управлением Linux.

Схема тестирования с Web Call Server:

Ниже мы задействуем для теста один из демо-серверов:

rtmp://wcs5-eu.flashphoner.com:1935/liveЭто RTMP адрес, который нужно передать скрипту streamer.py чтобы быстро протестировать трансляцию с нашим демо-сервером.

Запуск должен выглядеть так:

python streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM stream1 rtmp://wcs5-eu.flashphoner.com:1935/liveВ консоли stdout увидим следующий вывод:

# python streamer.py https://www.youtube.com/watch?v=9cQT4urTlXM stream1 rtmp://wcs5-eu.flashphoner.com:1935/live

ffmpeg version 3.2.3 Copyright (c) 2000-2017 the FFmpeg developers

built with gcc 4.4.7 (GCC) 20120313 (Red Hat 4.4.7-11)

configuration: --enable-shared --disable-logging --enable-gpl --enable-pthreads --enable-libx264 --enable-librtmp --disable-yasm

libavutil 55. 34.101 / 55. 34.101

libavcodec 57. 64.101 / 57. 64.101

libavformat 57. 56.101 / 57. 56.101

libavdevice 57. 1.100 / 57. 1.100

libavfilter 6. 65.100 / 6. 65.100

libswscale 4. 2.100 / 4. 2.100

libswresample 2. 3.100 / 2. 3.100

libpostproc 54. 1.100 / 54. 1.100

]# [youtube] 9cQT4urTlXM: Downloading webpage

[youtube] 9cQT4urTlXM: Downloading video info webpage

[youtube] 9cQT4urTlXM: Extracting video information

[youtube] 9cQT4urTlXM: Downloading MPD manifest

[download] Destination: -

Input #0, mov,mp4,m4a,3gp,3g2,mj2, from 'pipe:':

Metadata:

major_brand : mp42

minor_version : 0

compatible_brands: isommp42

creation_time : 2016-08-23T12:21:06.000000Z

Duration: 00:29:59.99, start: 0.000000, bitrate: N/A

Stream #0:0(und): Video: h264 (Main) (avc1 / 0x31637661), yuv420p, 1280x720 [SAR 1:1 DAR 16:9], 288 kb/s, 30 fps, 30 tbr, 90k tbn, 60 tbc (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Stream #0:1(und): Audio: aac (LC) (mp4a / 0x6134706D), 44100 Hz, stereo, fltp, 125 kb/s (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Output #0, flv, to 'rtmp://192.168.88.59:1935/live/stream1':

Metadata:

major_brand : mp42

minor_version : 0

compatible_brands: isommp42

encoder : Lavf57.56.101

Stream #0:0(und): Video: h264 (Main) ([7][0][0][0] / 0x0007), yuv420p, 1280x720 [SAR 1:1 DAR 16:9], q=2-31, 288 kb/s, 30 fps, 30 tbr, 1k tbn, 90k tbc (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Stream #0:1(und): Audio: aac (LC) ([10][0][0][0] / 0x000A), 44100 Hz, stereo, 125 kb/s (default)

Metadata:

creation_time : 2016-08-23T12:21:06.000000Z

handler_name : ISO Media file produced by Google Inc.

Stream mapping:

Stream #0:0 -> #0:0 (copy)

Stream #0:1 -> #0:1 (copy)

frame= 383 fps= 30 q=-1.0 size= 654kB time=00:00:12.70 bitrate= 421.8kbits/s speed= 1xЕсли бегло пробежать по этому логу, то можно понять, что происходит следующее:

- Открывается страница с видеороликом.

- Извлекаются данные о видео форматах.

- Скачивается mp4 ролик 1280x720, H.264+AAC

- Запускается ffmpeg, подхватывает скачиваемые данные и стримит по RTMP с битрейтом 421 kbps. Такой скудный битрейт объясняется выбранным роликом с таймером. Нормальный видеоролик даст на порядок большее значение битрейта.

После того, как процесс стриминга запустился, пытаемся проиграть поток в WebRTC плеере. Имя потока задается в поле Stream, а адрес сервера в поле Server. Подключение к серверу происходит по протоколу Websocket (wss), а поток приходит на плеер по WebRTC (UDP).

Мы специально взяли именно этот ролик на YouTube, чтобы иметь возможность протестировать реалтаймовость потока, ведь нашей конечной целью было доставить поток с YouTube ко всем зрителям одновременно, с минимальной задержкой и разбросом во времени. Ролик с миллисекундным таймером, как нельзя более подходит для такого теста.

Сам тест очень простой. Открываем две вкладки браузера (моделируем двух зрителей), играем этот поток с таймером по нашей схеме, и делаем несколько скриншотов, чтобы запечатлеть разницу во времени прибытия видео. Далее сравниваем миллисекунды и видим кто получил видео раньше, а кто позже и на сколько.

Получаем следующие результаты:

Test 1

Test 2

Test 3

Как видите, каждый из зрителей видит одно и то же видео, с разбросом не более 130 миллисекунд.

Таким образом задача реалтаймовой трансляции ролика с YouTube на WebRTC решена. Зрители получили поток практически одновременно. Менеджер не ушел пить кофе, программист — читать хабр, а маркетолог успешно показал всем ролик с котиками.

Хорошего стриминга!

Ссылки

youtube-dl — библиотека для скачивания видео с YouTube

ffmpeg — RTMP encoder

Web Call Server — сервер, умеющий раздвать RTMP поток по WebRTC

streamer.py — скрипт для интеграции youtube-dl и ffmpeg с отправкой RTMP потока

|

|

Легкая работа со списками — RendererRecyclerViewAdapter (часть 2) |

Легкая работа со списками — RendererRecyclerViewAdapter (часть 2)

В прошлый раз мы оптимизировали работу с RecyclerView, а так же научились переиспользовать ячейки в разных списках и легко добавлять новые.

Сегодня мы разберем:

Если прошлая статья тебе пришлась по душе, думаю, понравится и эта.

Что такое DiffUtil, я думаю разбирать не стоит. Наверное, уже каждый разработчик опробовал его в своем проекте и получил приятные плюшки в виде анимации и производительности.

В первые дни после публикации первой статьи я получил пулл реквест с реализацией DiffUtil, давайте посмотрим как это реализовано. Напомню, что в результате оптимизации у нас получился адаптер с публичным методом setItems(ArrayList items). В данном виде не очень удобно использовать DiffUtil, нам необходимо где-то дополнительно сохранять старую копию списка, в результате мы получим что-то вроде этого:

И расширенный интерфейс ItemModel:

В общем-то реализуемо и не сложно, но если это делать в нескольких местах, то стоит задуматься зачем столько много одинакового кода. Попробуем вынести общие моменты в свою реализацию DiffUtil.Callback:

В общем получилось достаточно универсально, мы избавились от рутинны и сосредоточились на главных методах — areItemsTheSame() и areContentsTheSame(), которые обязательны к реализации и могут отличаться.

Реализация метода getChangePayload() намеренно пропущена, её реализацию можно посмотреть в исходниках.

Теперь мы можем добавить еще один метод с поддержкой DiffUtil в наш адаптер:

В общем то с DiffUtil это все, теперь при необходимости мы используем наш абстрактный класс — DiffCallback, и реализуем всего два метода.

Я думаю теперь мы разогрелись и освежили память, значит, можно перейти к более интересным вещам.

Часто по воле заказчика или веянию дизайнеров в нашем приложении появляются вложенные списки. До недавних пор я недолюбливал их, я сталкивался с такими проблемами:

Некоторые из этих проблем сомнительны и легко решаемы, а некоторые уйдут, если подключить наш оптимизированный адаптер из первой статьи :). Но, как минимум, сложность реализации у нас останется. Давайте сформулируем наши требования:

Важно заметить, что здесь я разделил понятие ячейка и элемент списка:

элемент списка — сущность используемая в RecyclerView.

ячейка — набор классов, позволяющих отобразить один тип элемента списка, в нашем случае это реализация ранее известных классов и интерфейсов: ViewRenderer, ItemModel, ViewHolder.

И так, что мы имеем. Ключевым интерфесом у нас является ItemModel, очевидно что нам удобно будет далее с ним и работать. Наша композитная модель должна содержать в себе дочерние модели, добавляем новый интерфейс:

Выглядит неплохо, соответсвенно, композитный ViewRenderer должен знать о дочерних рендерерах — добавляем:

Здесь я добавил два способа добавления дочерних рендереров, уверен, они нам пригодятся.

Так же обратите внимание на генерик CompositeViewHolder — это будет тоже отдельный класс для композитного ViewHolder, что там будет пока не знаю. А сейчас продолжим работу с CompositeViewRenderer, у нас осталось два обязательных метода — bindView(), createViewHolder(). В createViewHolder() нужно инициализировать адаптер и познакомить его с рендерами, а в bindView() сделаем простое, дефолтное обновление элементов:

Почти получилось, как оказалось, для такой реализации в методе createViewHolder() нам нужен сам viewHolder, инициализировать мы его тут не можем — создаем отдельный абстрактный метод, заодно хотелось бы тут познакомить наш адаптер с RecyclerView, который мы можем взять у нереализованного CompositeViewHolder — реализуем:

Да, верно! Я добавил дефолтную реализацию с LinearLayoutManager :( посчитал что это принесет больше пользы, а при необходимости можно метод перегрузить и выставить другой LayoutManager.

Похоже что это все, осталось реализовать конкретные классы и посмотреть что получилось:

Регистрируем наш композитный рендерер:

Как видно из последнего семпла, для подписки на клики мы просто передаем необходимый интерфейс в конструктор рендерера, таким образом наше корневое место реализует этот интерфейс и знает о всех необходимых кликах

Заключение

Мы добились достаточной универсальности и гибкости при работе с вложенными списками, максимально упростили процесс добавления композитных ячеек. Теперь мы легко можем добавлять новые композитные ячейки и легко комбинировать одиночные ячейки во вложенных и основных списках.

Демонстрация, более детальная реализация и решения некоторых проблем доступны по ссылке.

Сегодня мы разберем:

- как можно упростить поддержку DiffUtil в этой реализации;

- как добавить поддержку вложенных RecyclerView.

Если прошлая статья тебе пришлась по душе, думаю, понравится и эта.

DiffUtil

Что такое DiffUtil, я думаю разбирать не стоит. Наверное, уже каждый разработчик опробовал его в своем проекте и получил приятные плюшки в виде анимации и производительности.

В первые дни после публикации первой статьи я получил пулл реквест с реализацией DiffUtil, давайте посмотрим как это реализовано. Напомню, что в результате оптимизации у нас получился адаптер с публичным методом setItems(ArrayList

...

final MyDiffCallback diffCallback = new MyDiffCallback(getOldItems(), getNewItems());

final DiffUtil.DiffResult diffResult = DiffUtil.calculateDiff(diffCallback);

mRecyclerViewAdapter.setItems(getNewItems());

diffResult.dispatchUpdatesTo(mRecyclerViewAdapter);

...

Классическая реализация DiffUtil.Callback

public class MyDiffCallback extends DiffUtil.Callback {

private final List mOldList;

private final List mNewList;

public MyDiffCallback(List oldList, List newList) {

mOldList = oldList;

mNewList = newList;

}

@Override

public int getOldListSize() {

return mOldList.size();

}

@Override

public int getNewListSize() {

return mNewList.size();

}

@Override

public boolean areItemsTheSame(int oldItemPosition, int newItemPosition) {

return mOldList.get(oldItemPosition).getID() == mNewList.get(

newItemPosition).getID();

}

@Override

public boolean areContentsTheSame(int oldItemPosition, int newItemPosition) {

BaseItemModel oldItem = mOldList.get(oldItemPosition);

BaseItemModel newItem = mNewList.get(newItemPosition);

return oldItem.equals(newItem);

}

@Nullable

@Override

public Object getChangePayload(int oldItemPosition, int newItemPosition) {

return super.getChangePayload(oldItemPosition, newItemPosition);

}

}

И расширенный интерфейс ItemModel:

public interface BaseItemModel extends ItemModel {

int getID();

}

В общем-то реализуемо и не сложно, но если это делать в нескольких местах, то стоит задуматься зачем столько много одинакового кода. Попробуем вынести общие моменты в свою реализацию DiffUtil.Callback:

public abstract static class DiffCallback extends DiffUtil.Callback {

private final List mOldItems = new ArrayList<>();

private final List mNewItems = new ArrayList<>();

void setItems(List oldItems, List newItems) {

mOldItems.clear();

mOldItems.addAll(oldItems);

mNewItems.clear();

mNewItems.addAll(newItems);

}

@Override

public int getOldListSize() {

return mOldItems.size();

}

@Override

public int getNewListSize() {

return mNewItems.size();

}

@Override

public boolean areItemsTheSame(int oldItemPosition, int newItemPosition) {

return areItemsTheSame(

mOldItems.get(oldItemPosition),

mNewItems.get(newItemPosition)

);

}

public abstract boolean areItemsTheSame(BM oldItem, BM newItem);

@Override

public boolean areContentsTheSame(int oldItemPosition, int newItemPosition) {

return areContentsTheSame(

mOldItems.get(oldItemPosition),

mNewItems.get(newItemPosition)

);

}

public abstract boolean areContentsTheSame(BM oldItem, BM newItem);

...

}

В общем получилось достаточно универсально, мы избавились от рутинны и сосредоточились на главных методах — areItemsTheSame() и areContentsTheSame(), которые обязательны к реализации и могут отличаться.

Реализация метода getChangePayload() намеренно пропущена, её реализацию можно посмотреть в исходниках.

Теперь мы можем добавить еще один метод с поддержкой DiffUtil в наш адаптер:

public void setItems(List items, DiffCallback diffCallback) {

diffCallback.setItems(mItems, items);

final DiffUtil.DiffResult diffResult = DiffUtil.calculateDiff(diffCallback);

mItems.clear();

mItems.addAll(items);

diffResult.dispatchUpdatesTo(this);

}

В общем то с DiffUtil это все, теперь при необходимости мы используем наш абстрактный класс — DiffCallback, и реализуем всего два метода.

Я думаю теперь мы разогрелись и освежили память, значит, можно перейти к более интересным вещам.

Вложенные RecyclerView

Часто по воле заказчика или веянию дизайнеров в нашем приложении появляются вложенные списки. До недавних пор я недолюбливал их, я сталкивался с такими проблемами:

- сложность реализации ячейки, которая содержит RecyclerView;

- сложность обновление данных во вложенных ячейках;

- непереиспользуемость вложенных ячеек;

- дублирование кода;

- запутанность проброса кликов от вложенных ячеек в корневое место — Fragment/Activity;

Некоторые из этих проблем сомнительны и легко решаемы, а некоторые уйдут, если подключить наш оптимизированный адаптер из первой статьи :). Но, как минимум, сложность реализации у нас останется. Давайте сформулируем наши требования:

- возможность легко добавлять новые типы вложенных ячеек;

- переиспользуемость типа ячейки как для вложенного так и для основного элемента списка;

- простота реализации;

Важно заметить, что здесь я разделил понятие ячейка и элемент списка:

элемент списка — сущность используемая в RecyclerView.

ячейка — набор классов, позволяющих отобразить один тип элемента списка, в нашем случае это реализация ранее известных классов и интерфейсов: ViewRenderer, ItemModel, ViewHolder.

И так, что мы имеем. Ключевым интерфесом у нас является ItemModel, очевидно что нам удобно будет далее с ним и работать. Наша композитная модель должна содержать в себе дочерние модели, добавляем новый интерфейс:

public interface CompositeItemModel extends ItemModel {

List getItems();

}

Выглядит неплохо, соответсвенно, композитный ViewRenderer должен знать о дочерних рендерерах — добавляем:

public abstract class CompositeViewRenderer extends ViewRenderer {

private final ArrayList mRenderers = new ArrayList<>();

public CompositeViewRenderer(int viewType, Context context) {

super(viewType, context);

}

public CompositeViewRenderer(int viewType, Context context, ViewRenderer... renderers) {

super(viewType, context);

Collections.addAll(mRenderers, renderers);

}

public CompositeViewRenderer registerRenderer(ViewRenderer renderer) {

mRenderers.add(renderer);

return this;

}

public void bindView(M model, VH holder) {}

public VH createViewHolder(ViewGroup parent) { return ...; }

...

}

Здесь я добавил два способа добавления дочерних рендереров, уверен, они нам пригодятся.

Так же обратите внимание на генерик CompositeViewHolder — это будет тоже отдельный класс для композитного ViewHolder, что там будет пока не знаю. А сейчас продолжим работу с CompositeViewRenderer, у нас осталось два обязательных метода — bindView(), createViewHolder(). В createViewHolder() нужно инициализировать адаптер и познакомить его с рендерами, а в bindView() сделаем простое, дефолтное обновление элементов:

public abstract class CompositeViewRenderer extends ViewRenderer {

private final ArrayList mRenderers = new ArrayList<>();

private RendererRecyclerViewAdapter mAdapter;

...

public void bindView(M model, VH holder) {

mAdapter.setItems(model.getItems());

mAdapter.notifyDataSetChanged();

}

public VH createViewHolder(ViewGroup parent) {

mAdapter = new RendererRecyclerViewAdapter();

for (final ViewRenderer renderer : mRenderers) {

mAdapter.registerRenderer(renderer);

}

return ???;

}

...

}

Почти получилось, как оказалось, для такой реализации в методе createViewHolder() нам нужен сам viewHolder, инициализировать мы его тут не можем — создаем отдельный абстрактный метод, заодно хотелось бы тут познакомить наш адаптер с RecyclerView, который мы можем взять у нереализованного CompositeViewHolder — реализуем:

public abstract class CompositeViewHolder extends RecyclerView.ViewHolder {

public RecyclerView mRecyclerView;

public CompositeViewHolder(View itemView) {

super(itemView);

}

}

public abstract class CompositeViewRenderer extends ViewRenderer {

public VH createViewHolder(ViewGroup parent) {

mAdapter = new RendererRecyclerViewAdapter();

for (final ViewRenderer renderer : mRenderers) {

mAdapter.registerRenderer(renderer);

}

VH viewHolder = createCompositeViewHolder(parent);

viewHolder.mRecyclerView.setLayoutManager(createLayoutManager());

viewHolder.mRecyclerView.setAdapter(mAdapter);

return viewHolder;

}

public abstract VH createCompositeViewHolder(ViewGroup parent);

protected RecyclerView.LayoutManager createLayoutManager() {

return new LinearLayoutManager(getContext(), LinearLayoutManager.HORIZONTAL, false);

}

...

}

Да, верно! Я добавил дефолтную реализацию с LinearLayoutManager :( посчитал что это принесет больше пользы, а при необходимости можно метод перегрузить и выставить другой LayoutManager.

Похоже что это все, осталось реализовать конкретные классы и посмотреть что получилось:

SomeCompositeItemModel

public class SomeCompositeItemModel implements CompositeItemModel {

public static final int TYPE = 999;

private int mID;

private final List mItems;

public SomeCompositeItemModel(final int ID, List items) {

mID = ID;

mItems = items;

}

public int getID() {

return mID;

}

public int getType() {

return TYPE;

}

public List getItems() {

return mItems;

}

}

SomeCompositeViewHolder

public class SomeCompositeViewHolder extends CompositeViewHolder {

public SomeCompositeViewHolder(View view) {

super(view);

mRecyclerView = (RecyclerView) view.findViewById(R.id.composite_recycler_view);

}

}

SomeCompositeViewRenderer

public class SomeCompositeViewRenderer extends CompositeViewRenderer {

public SomeCompositeViewRenderer(int viewType, Context context) {

super(viewType, context);

}

public SomeCompositeViewHolder createCompositeViewHolder(ViewGroup parent) {

return new SomeCompositeViewHolder(inflate(R.layout.item_composite, parent));

}

}

Регистрируем наш композитный рендерер:

public class SomeActivity extends AppCompatActivity {

protected void onCreate(final Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

...

SomeCompositeViewRenderer composite = new SomeCompositeViewRenderer(

SomeCompositeItemModel.TYPE,

this,

new SomeViewRenderer(SomeModel.TYPE, this, mListener)

);

mRecyclerViewAdapter.registerRenderer(composite);

...

}

...

}

Как видно из последнего семпла, для подписки на клики мы просто передаем необходимый интерфейс в конструктор рендерера, таким образом наше корневое место реализует этот интерфейс и знает о всех необходимых кликах

Пример проброса кликов

public class SomeViewRenderer extends ViewRenderer {

private final Listener mListener;

public SomeViewRenderer(int type, Context context, Listener listener) {

super(type, context);

mListener = listener;

}

public void bindView(SomeModel model, SomeViewHolder holder) {

...

holder.itemView.setOnClickListener(new View.OnClickListener() {

public void onClick(final View view) {

mListener.onSomeItemClicked(model);

}

});

}

...

public interface Listener {

void onSomeItemClicked(SomeModel model);

}

}

Заключение

Мы добились достаточной универсальности и гибкости при работе с вложенными списками, максимально упростили процесс добавления композитных ячеек. Теперь мы легко можем добавлять новые композитные ячейки и легко комбинировать одиночные ячейки во вложенных и основных списках.

Демонстрация, более детальная реализация и решения некоторых проблем доступны по ссылке.

|

Метки: author vivchar разработка под android разработка мобильных приложений android android development recyclerview adapter composite nested recyclerview |

Легкая работа со списками — RendererRecyclerViewAdapter (часть 2) |

Легкая работа со списками — RendererRecyclerViewAdapter (часть 2)

В прошлый раз мы оптимизировали работу с RecyclerView, а так же научились переиспользовать ячейки в разных списках и легко добавлять новые.

Сегодня мы разберем:

Если прошлая статья тебе пришлась по душе, думаю, понравится и эта.

Что такое DiffUtil, я думаю разбирать не стоит. Наверное, уже каждый разработчик опробовал его в своем проекте и получил приятные плюшки в виде анимации и производительности.

В первые дни после публикации первой статьи я получил пулл реквест с реализацией DiffUtil, давайте посмотрим как это реализовано. Напомню, что в результате оптимизации у нас получился адаптер с публичным методом setItems(ArrayList items). В данном виде не очень удобно использовать DiffUtil, нам необходимо где-то дополнительно сохранять старую копию списка, в результате мы получим что-то вроде этого:

И расширенный интерфейс ItemModel:

В общем-то реализуемо и не сложно, но если это делать в нескольких местах, то стоит задуматься зачем столько много одинакового кода. Попробуем вынести общие моменты в свою реализацию DiffUtil.Callback:

В общем получилось достаточно универсально, мы избавились от рутинны и сосредоточились на главных методах — areItemsTheSame() и areContentsTheSame(), которые обязательны к реализации и могут отличаться.

Реализация метода getChangePayload() намеренно пропущена, её реализацию можно посмотреть в исходниках.

Теперь мы можем добавить еще один метод с поддержкой DiffUtil в наш адаптер:

В общем то с DiffUtil это все, теперь при необходимости мы используем наш абстрактный класс — DiffCallback, и реализуем всего два метода.

Я думаю теперь мы разогрелись и освежили память, значит, можно перейти к более интересным вещам.

Часто по воле заказчика или веянию дизайнеров в нашем приложении появляются вложенные списки. До недавних пор я недолюбливал их, я сталкивался с такими проблемами:

Некоторые из этих проблем сомнительны и легко решаемы, а некоторые уйдут, если подключить наш оптимизированный адаптер из первой статьи :). Но, как минимум, сложность реализации у нас останется. Давайте сформулируем наши требования:

Важно заметить, что здесь я разделил понятие ячейка и элемент списка:

элемент списка — сущность используемая в RecyclerView.

ячейка — набор классов, позволяющих отобразить один тип элемента списка, в нашем случае это реализация ранее известных классов и интерфейсов: ViewRenderer, ItemModel, ViewHolder.

И так, что мы имеем. Ключевым интерфесом у нас является ItemModel, очевидно что нам удобно будет далее с ним и работать. Наша композитная модель должна содержать в себе дочерние модели, добавляем новый интерфейс:

Выглядит неплохо, соответсвенно, композитный ViewRenderer должен знать о дочерних рендерерах — добавляем:

Здесь я добавил два способа добавления дочерних рендереров, уверен, они нам пригодятся.

Так же обратите внимание на генерик CompositeViewHolder — это будет тоже отдельный класс для композитного ViewHolder, что там будет пока не знаю. А сейчас продолжим работу с CompositeViewRenderer, у нас осталось два обязательных метода — bindView(), createViewHolder(). В createViewHolder() нужно инициализировать адаптер и познакомить его с рендерами, а в bindView() сделаем простое, дефолтное обновление элементов:

Почти получилось, как оказалось, для такой реализации в методе createViewHolder() нам нужен сам viewHolder, инициализировать мы его тут не можем — создаем отдельный абстрактный метод, заодно хотелось бы тут познакомить наш адаптер с RecyclerView, который мы можем взять у нереализованного CompositeViewHolder — реализуем:

Да, верно! Я добавил дефолтную реализацию с LinearLayoutManager :( посчитал что это принесет больше пользы, а при необходимости можно метод перегрузить и выставить другой LayoutManager.

Похоже что это все, осталось реализовать конкретные классы и посмотреть что получилось:

Регистрируем наш композитный рендерер:

Как видно из последнего семпла, для подписки на клики мы просто передаем необходимый интерфейс в конструктор рендерера, таким образом наше корневое место реализует этот интерфейс и знает о всех необходимых кликах

Заключение

Мы добились достаточной универсальности и гибкости при работе с вложенными списками, максимально упростили процесс добавления композитных ячеек. Теперь мы легко можем добавлять новые композитные ячейки и легко комбинировать одиночные ячейки во вложенных и основных списках.

Демонстрация, более детальная реализация и решения некоторых проблем доступны по ссылке.

Сегодня мы разберем:

- как можно упростить поддержку DiffUtil в этой реализации;

- как добавить поддержку вложенных RecyclerView.

Если прошлая статья тебе пришлась по душе, думаю, понравится и эта.

DiffUtil

Что такое DiffUtil, я думаю разбирать не стоит. Наверное, уже каждый разработчик опробовал его в своем проекте и получил приятные плюшки в виде анимации и производительности.

В первые дни после публикации первой статьи я получил пулл реквест с реализацией DiffUtil, давайте посмотрим как это реализовано. Напомню, что в результате оптимизации у нас получился адаптер с публичным методом setItems(ArrayList

...

final MyDiffCallback diffCallback = new MyDiffCallback(getOldItems(), getNewItems());

final DiffUtil.DiffResult diffResult = DiffUtil.calculateDiff(diffCallback);

mRecyclerViewAdapter.setItems(getNewItems());

diffResult.dispatchUpdatesTo(mRecyclerViewAdapter);

...

Классическая реализация DiffUtil.Callback

public class MyDiffCallback extends DiffUtil.Callback {

private final List mOldList;

private final List mNewList;

public MyDiffCallback(List oldList, List newList) {

mOldList = oldList;

mNewList = newList;

}

@Override

public int getOldListSize() {

return mOldList.size();

}

@Override

public int getNewListSize() {

return mNewList.size();

}

@Override

public boolean areItemsTheSame(int oldItemPosition, int newItemPosition) {

return mOldList.get(oldItemPosition).getID() == mNewList.get(

newItemPosition).getID();

}

@Override

public boolean areContentsTheSame(int oldItemPosition, int newItemPosition) {

BaseItemModel oldItem = mOldList.get(oldItemPosition);

BaseItemModel newItem = mNewList.get(newItemPosition);

return oldItem.equals(newItem);

}

@Nullable

@Override

public Object getChangePayload(int oldItemPosition, int newItemPosition) {

return super.getChangePayload(oldItemPosition, newItemPosition);

}

}

И расширенный интерфейс ItemModel:

public interface BaseItemModel extends ItemModel {

int getID();

}

В общем-то реализуемо и не сложно, но если это делать в нескольких местах, то стоит задуматься зачем столько много одинакового кода. Попробуем вынести общие моменты в свою реализацию DiffUtil.Callback:

public abstract static class DiffCallback extends DiffUtil.Callback {

private final List mOldItems = new ArrayList<>();

private final List mNewItems = new ArrayList<>();

void setItems(List oldItems, List newItems) {

mOldItems.clear();

mOldItems.addAll(oldItems);

mNewItems.clear();

mNewItems.addAll(newItems);

}

@Override

public int getOldListSize() {

return mOldItems.size();

}

@Override

public int getNewListSize() {

return mNewItems.size();

}

@Override

public boolean areItemsTheSame(int oldItemPosition, int newItemPosition) {

return areItemsTheSame(

mOldItems.get(oldItemPosition),

mNewItems.get(newItemPosition)

);

}

public abstract boolean areItemsTheSame(BM oldItem, BM newItem);

@Override

public boolean areContentsTheSame(int oldItemPosition, int newItemPosition) {

return areContentsTheSame(

mOldItems.get(oldItemPosition),

mNewItems.get(newItemPosition)

);

}

public abstract boolean areContentsTheSame(BM oldItem, BM newItem);

...

}

В общем получилось достаточно универсально, мы избавились от рутинны и сосредоточились на главных методах — areItemsTheSame() и areContentsTheSame(), которые обязательны к реализации и могут отличаться.

Реализация метода getChangePayload() намеренно пропущена, её реализацию можно посмотреть в исходниках.

Теперь мы можем добавить еще один метод с поддержкой DiffUtil в наш адаптер:

public void setItems(List items, DiffCallback diffCallback) {

diffCallback.setItems(mItems, items);

final DiffUtil.DiffResult diffResult = DiffUtil.calculateDiff(diffCallback);

mItems.clear();

mItems.addAll(items);

diffResult.dispatchUpdatesTo(this);

}

В общем то с DiffUtil это все, теперь при необходимости мы используем наш абстрактный класс — DiffCallback, и реализуем всего два метода.

Я думаю теперь мы разогрелись и освежили память, значит, можно перейти к более интересным вещам.

Вложенные RecyclerView

Часто по воле заказчика или веянию дизайнеров в нашем приложении появляются вложенные списки. До недавних пор я недолюбливал их, я сталкивался с такими проблемами:

- сложность реализации ячейки, которая содержит RecyclerView;

- сложность обновление данных во вложенных ячейках;

- непереиспользуемость вложенных ячеек;

- дублирование кода;

- запутанность проброса кликов от вложенных ячеек в корневое место — Fragment/Activity;

Некоторые из этих проблем сомнительны и легко решаемы, а некоторые уйдут, если подключить наш оптимизированный адаптер из первой статьи :). Но, как минимум, сложность реализации у нас останется. Давайте сформулируем наши требования:

- возможность легко добавлять новые типы вложенных ячеек;

- переиспользуемость типа ячейки как для вложенного так и для основного элемента списка;

- простота реализации;

Важно заметить, что здесь я разделил понятие ячейка и элемент списка:

элемент списка — сущность используемая в RecyclerView.

ячейка — набор классов, позволяющих отобразить один тип элемента списка, в нашем случае это реализация ранее известных классов и интерфейсов: ViewRenderer, ItemModel, ViewHolder.

И так, что мы имеем. Ключевым интерфесом у нас является ItemModel, очевидно что нам удобно будет далее с ним и работать. Наша композитная модель должна содержать в себе дочерние модели, добавляем новый интерфейс:

public interface CompositeItemModel extends ItemModel {

List getItems();

}

Выглядит неплохо, соответсвенно, композитный ViewRenderer должен знать о дочерних рендерерах — добавляем:

public abstract class CompositeViewRenderer extends ViewRenderer {

private final ArrayList mRenderers = new ArrayList<>();

public CompositeViewRenderer(int viewType, Context context) {

super(viewType, context);

}

public CompositeViewRenderer(int viewType, Context context, ViewRenderer... renderers) {

super(viewType, context);

Collections.addAll(mRenderers, renderers);

}

public CompositeViewRenderer registerRenderer(ViewRenderer renderer) {

mRenderers.add(renderer);

return this;

}

public void bindView(M model, VH holder) {}

public VH createViewHolder(ViewGroup parent) { return ...; }

...

}

Здесь я добавил два способа добавления дочерних рендереров, уверен, они нам пригодятся.

Так же обратите внимание на генерик CompositeViewHolder — это будет тоже отдельный класс для композитного ViewHolder, что там будет пока не знаю. А сейчас продолжим работу с CompositeViewRenderer, у нас осталось два обязательных метода — bindView(), createViewHolder(). В createViewHolder() нужно инициализировать адаптер и познакомить его с рендерами, а в bindView() сделаем простое, дефолтное обновление элементов:

public abstract class CompositeViewRenderer extends ViewRenderer {

private final ArrayList mRenderers = new ArrayList<>();

private RendererRecyclerViewAdapter mAdapter;

...

public void bindView(M model, VH holder) {

mAdapter.setItems(model.getItems());

mAdapter.notifyDataSetChanged();

}

public VH createViewHolder(ViewGroup parent) {

mAdapter = new RendererRecyclerViewAdapter();

for (final ViewRenderer renderer : mRenderers) {

mAdapter.registerRenderer(renderer);

}

return ???;

}

...

}

Почти получилось, как оказалось, для такой реализации в методе createViewHolder() нам нужен сам viewHolder, инициализировать мы его тут не можем — создаем отдельный абстрактный метод, заодно хотелось бы тут познакомить наш адаптер с RecyclerView, который мы можем взять у нереализованного CompositeViewHolder — реализуем:

public abstract class CompositeViewHolder extends RecyclerView.ViewHolder {

public RecyclerView mRecyclerView;

public CompositeViewHolder(View itemView) {

super(itemView);

}

}

public abstract class CompositeViewRenderer extends ViewRenderer {

public VH createViewHolder(ViewGroup parent) {

mAdapter = new RendererRecyclerViewAdapter();

for (final ViewRenderer renderer : mRenderers) {

mAdapter.registerRenderer(renderer);

}

VH viewHolder = createCompositeViewHolder(parent);

viewHolder.mRecyclerView.setLayoutManager(createLayoutManager());

viewHolder.mRecyclerView.setAdapter(mAdapter);

return viewHolder;

}

public abstract VH createCompositeViewHolder(ViewGroup parent);

protected RecyclerView.LayoutManager createLayoutManager() {

return new LinearLayoutManager(getContext(), LinearLayoutManager.HORIZONTAL, false);

}

...

}

Да, верно! Я добавил дефолтную реализацию с LinearLayoutManager :( посчитал что это принесет больше пользы, а при необходимости можно метод перегрузить и выставить другой LayoutManager.

Похоже что это все, осталось реализовать конкретные классы и посмотреть что получилось:

SomeCompositeItemModel

public class SomeCompositeItemModel implements CompositeItemModel {

public static final int TYPE = 999;

private int mID;

private final List mItems;

public SomeCompositeItemModel(final int ID, List items) {

mID = ID;

mItems = items;

}

public int getID() {

return mID;

}

public int getType() {

return TYPE;

}

public List getItems() {