Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Firebase на I/O 2017: новые возможности |

Привет Хабр! Совсем недавно в Маунтин-Вью, Калифорния прошла очередная международная конференция, посвященная технологиям Google — I/O 2017. Кто-то ездил на нее в Калифорнию, кто-то приходил на I/O Extended организованные региональными отделениями GDG комьюнити, кто-то смотрел трансляцию самостоятельно, а кто-то не смотрел вовсе (На всякий случай оставлю это тут: все сессии I/O 2017 в записи). О том насколько была хороша или не очень хороша конференция в этом году, мнения противоречивы, я могу сказать только лично от себя, мне очень понравилось.

Еще в прошлом году я сильно заинтересовался тем, что делают ребята из команды Firebase, и я даже писал об этом статью, по этому мне хочется рассказать вам, что нового появилось в экосистеме Firebase, и каким образом это можно использовать.

Интеграция с Fabric

О том что Google приобрел Fabric у Twitter я слышал уже некоторое время назад, но на I/O я воочию увидел групп менеджера из Fabric Рича Пэрета из Fabric и кофаундера Firebase Эндрю Ли на одной сцене, обсуждающих перспективы объединения команд и дружески подкалывающих друг друга.

Итак, что же мы получили в результате этого слияния? Во-первых, Crahslytics в скором времени будет интегрирован в Firebase как основное решение для crash reporting! Уже сейчас в консоли Crash Reporting мы видим приглашение установить сервис Crashlytics и поучаствовать в его тестировании, а в скором времени он полностью заменит Firebase Crash Reporting.

Во-вторых, интеграция с сервисом Digits теперь позволяет аутентификацию по номеру телефона! Бесплатно можно будет осуществлять 10 тысяч аутентификаций в месяц, что вполне должно покрыть нужды разработчиков. А Digits SDK как самостоятельный продукт в ближайшее время получит статус deprecated.

Я немедленно захотел прикрутить авторизацию по телефону к своему приложению и показать, как же просто это сделать, но как выяснилось сервис сейчас доступен только для iOS и WEB разработчиков, Android версию придется подождать еще пару недель.

Динамический хостинг с Firebase Cloud Functions

Еще в марте, на Google NEXT’17, ребята из команды Firebase рассказали о запуске нового сервиса Cloud Functions for Firebase. Сервис предоставляет возможность размещать небольшие JavaScript функции непосредственно в Google Cloud инфраструктуре, и исполнять их в качестве реакции на события, вызванные сервисами Firebase или HTTP запросами.

Это позволяет кастомизировать или расширять стандартную работу сервисов Firebase своими фичами, такими как отправка welcome email каждому новому пользователю (Authentication), отслеживать и удалять ненормативную лексику в постах или чатах (Realtime Database), конвертировать изображения при загрузке в хранилище (Storage) и тп.

Для тех кто не пробовал, покажу пример применения Cloud Functions. Возьмем из GitHub исходники FriendlyChat, приложения создание которого я описывал в прошлогодней статье. Привяжем его к чистому Firebase проекту и добавим Cloud Function, которая будет автоматически приветствовать всех новых пользователей в чате.

Первым делом придется установить Node.js, а затем установить Firebase Command Line Interface (CLI) командой:

npm -g install firebase-toolsавторизоваться в интерфейсе командой

firebase loginсоздать папку для своего проекта, перейти в нее и создать сам проект командой

firebase init functionsВ результате в папке создастся структура проекта, заходим в папку functions и находим index.js, здесь и будут хранится наши функции. Если открыть файл, то в нем будет только одна строчка — const functions = require('firebase-functions'); — это собственно подключение Firebase SDK. Добавим туда подключение Admin SDK:

const admin = require('firebase-admin');

admin.initializeApp(functions.config().firebase);

Приготовления закончены, теперь имплементируем саму функцию, она будет срабатывать на событие создания нового пользователя в сервисе Authentication, то-есть когда пользователь заходит в чат в первый раз:

exports.addWelcomeMessages = functions.auth.user().onCreate(event => {

const user = event.data;

console.log('A new user signed in for the first time.');

const fullName = user.displayName || 'Anonymous';

// В базу данных будет положено сообщение от файрбез бота о добавлении нового пользователя

return admin.database().ref('messages').push({

name: 'Firebase Bot',

photoUrl: 'https://image.ibb.co/b7A7Sa/firebase_logo.png', // Firebase logo выгружен на первый попавшийся image hosting

text: '${fullName} signed in for the first time! Welcome!'

});

});

Осталось выгрузить функцию в облако и все:

firebase deploy --only functions

можно запускать приложение, и после авторизации бот радостно приветствует нового пользователя в чате.

Но все это было представлено еще до I/O! Непосредственно на нем, Firebase представил новинку, которая должна порадовать сообщество веб-разработчиков. Сервис Firebase Hosting, который раньше позволял работать только со статическим контентом, был расширен интеграцией с Cloud Functions, и теперь работает с динамическим контентом, формируемым сервисом Cloud Functions.

Теперь разработчики занимающиеся progressive web приложениями, смогут полностью отказаться от своего сервера и использовать только Firebase.

Очень хочется привести примеры, но я еще не писал про Web разработку с помощью Firebase, и статья получилась бы слишком большой, поэтому ожидайте следующую, полностью посвященную разработке под Web и использованию Cloud Functions статью.

Firebase Performance Monitoring

Часто недостаточная производительность и/или стабильность приложения являются главной причиной недовольства пользователей. Но не всегда просто понять, почему приложение недостаточно производительно или стабильно, для помощи в этом нелегком деле, команда Firebase запустила в бета тестирование новый сервис Performance Monitoring. Firebase Performance Monitoring — это новый бесплатный инструмент, который поможет вам понять, когда плохой код или сложные сетевые условия влияют на ваш пользовательский интерфейс.

Для того чтоб сервис начал собирать данные о производительности вашего приложения, необходимо подключить Performance Monitoring SDK, после этого сервис сразу начнет собирать данные. Сервис будет предоставлять отчеты в виде так называемых трейсов (trace) — отчетов о производительности между двумя событиями в вашем приложении. Сразу после подключения начнут собираться данные для автоматических трейсов:

- App start trace — измеряет время между тем когда пользователь запустил приложение и тем когда приложение отозвалось

- App in background trace — измеряет время нахождения приложения в бекграунде

- App in foreground trace — измеряет время активности приложения

Подключим сервис к приложению, чтобы посмотреть как это выглядит. Я взял стандартное приложение из google codelabs — FriendlyChat и подключил его к своей базе. Теперь подключим Performance Monitoring, для этого добавим в project-level build.gradle в секцию buildscript -> repositories:

jcenter() и в секцию buildscript -> dependencies

classpath 'com.google.firebase:firebase-plugins:1.1.0'затем в app-level build.gradle в секцию dependencies

compile 'com.google.firebase:firebase-perf:10.2.6'и под apply plugin: 'com.android.application'

apply plugin: 'com.google.firebase.firebase-perf'Вуаля, сервис подключен, теперь автоматических трейсы запускаются при старте приложения.

Так как автоматических трейсов явно недостаточно, предоставлена возможность создавать кастомные трейсы, используя API предоставленное SDK. Их можно дополнять счетчиками событий, связанными с производительностью, например количество раз, когда UI был недоступен дольше чем заданный промежуток времени.

Кастомные трейсы добавляются предельно просто, перед участком кода, который мы хотим трассировать добавим:

Trace myTrace = FirebasePerformance.getInstance().newTrace("test_trace");

myTrace.start();

а после участка

myTrace.stop();Я добавил трассировку загрузки изображения в чат, ну и ради интереса добавим счетчик

myTrace.incrementCounter("storage_load");Но результаты в консоли доступны не сразу, они появятся там в течении 12-ти часов.

Усовершенствованная аналитика

Начну с того, что Firebase Analytics больше не существует, теперь сервис называется Google Analytics for Firebase, и это неспроста. Сервис был разработан совместно командами Firebase и Google Analytics, а все отчеты теперь доступны не только в консоли Firebase, но и в интерфейсе Google Analytics.

Новые типы отчетов StreamView и DebugView были представлены еще в начале года, но это не умаляет степень их полезности. StreamView визуализирует события по мере их поступления в Firebase Analytics и дает общее представление о том, как ваши пользователи взаимодействуют с вашим приложением в реальном времени, а не с задержкой до 12ти часов. А с помощью DebugView вы можете сразу увидеть, какие события регистрируются.

И еще одна новость, которую все так долго ждали, теперь аналитическую информацию по пользовательским событиям и параметрам можно будет посмотреть в отчетах непосредственно в консоли, а не выгружать данные в BigQuery, как это было необходимо ранее. Для этого нужно всего лишь настроить параметры отчета там же в консоли.

Добавилось еще много всяких интересных фич, интеграция с AdMob, автоматический Screen Tracking, бесплатный Storage Tier в BigQuery…. так что полагаю, что для аналитики все-таки тоже придется писать отдельную статью.

Firebase SDK — теперь в опенсорсе

Да, это именно так. Исходный код Firebase SDK теперь доступен для изучения на GitHub. Не весь конечно, на данный момент доступны исходники Firebase iOS SDK 4.0, Firebase JavaScript SDK 4.0 и Firebase Admin SDKs (Node.js, Java и Python). Следующим обещают выложить Android SDK, будем ждать с нетерпением.

Теперь можно будет поправлять Google, если что-то в коде вам не понравится! То есть теперь, если вы найдете какие-то, с вашей точки зрения, баги — можно будет просто создать issue через стандартный GitHub issue tracker и Firebase команда рассмотрит ее. Весь проект можно так же найти в Google Open Source Directory.

Приятные мелочи

И напоследок я вкратце расскажу о всяких приятных мелочах, которые были добавлены в уже существующие сервисы.

Realtime Database:

- Расширены возможности, теперь доступно до 100000 одновременных подключений

- Добавлена возможность профилирования, profiler позволяет анализировать скорость работы с данными, пропускную способность и время задержки в зависимости от уровня

Storage:

- Добавлен мапинг на уже существующие cloud storage bucket’ы, теперь можно работать с ними через Firebase

- Появилась возможность выбора региона, в котором будут хранится ваши данные. Это может быть полезно как с юридической точки зрения, так и с точки зрения производительности

Cloud Messaging:

- Добавлена поддержка аутентификации на токенах для APN, и значительно упрощена логика соединения и регистрации в клиентском SDK.

TestLab:

- Добавлены Game Loop support и FPS мониторинг, что в сочетании с Unity SDK и C++ SDK, представленными ранее, должно сделать Firebase привлекательной для разработчиков игр.

- Добавлена возможность симуляции уровня сети, можно выбрать скорость подключения 4G, 3G и т.п.

- В датацентре появились Google Pixel и Galaxy S7 для тестирования приложений на реальных устройствах последнего поколения

- Появился доступ к Android O

А также, не привязываясь ни к какому из сервисов, еще добавлю что в iOS SDK была реализована поддержка Swift, что должно порадовать разработчиков под iOS работающих с Firebase.

Итак, какие можно сделать выводы? Ничего супер неожиданного и сногсшибательного на I/O представлено не было. Но Firebase растет, растет медленно и уверенно. Используя ее сервисы в качестве бэкэнда уже можно создавать вполне конкурентноспособные приложения, анализировать их работу, управлять их продвижением и монетизировать. И чем дальше, тем больше интересных инструментов появляется у пользователей.

P.S: На I/O было озвучено интересное предложение от от Firebase — программа Альфа (без VPN не откроется). У тех кто зарегистрируется и выразит свое желание участвовать в программе, будет возможность проверить обновления сервисов Firebase до их релиза. Они будут не идеальные (думаю, что местами совсем сырые), но, приняв участие в Альфа-сообществе, формируя фидбэки на еще не выпущенные продукты, вы поможете определить будущее Firebase!

|

Метки: author Developers_Relations разработка под ios разработка под android разработка мобильных приложений google api блог компании google google io firebase |

Firebase на I/O 2017: новые возможности |

Привет Хабр! Совсем недавно в Маунтин-Вью, Калифорния прошла очередная международная конференция, посвященная технологиям Google — I/O 2017. Кто-то ездил на нее в Калифорнию, кто-то приходил на I/O Extended организованные региональными отделениями GDG комьюнити, кто-то смотрел трансляцию самостоятельно, а кто-то не смотрел вовсе (На всякий случай оставлю это тут: все сессии I/O 2017 в записи). О том насколько была хороша или не очень хороша конференция в этом году, мнения противоречивы, я могу сказать только лично от себя, мне очень понравилось.

Еще в прошлом году я сильно заинтересовался тем, что делают ребята из команды Firebase, и я даже писал об этом статью, по этому мне хочется рассказать вам, что нового появилось в экосистеме Firebase, и каким образом это можно использовать.

Интеграция с Fabric

О том что Google приобрел Fabric у Twitter я слышал уже некоторое время назад, но на I/O я воочию увидел групп менеджера из Fabric Рича Пэрета из Fabric и кофаундера Firebase Эндрю Ли на одной сцене, обсуждающих перспективы объединения команд и дружески подкалывающих друг друга.

Итак, что же мы получили в результате этого слияния? Во-первых, Crahslytics в скором времени будет интегрирован в Firebase как основное решение для crash reporting! Уже сейчас в консоли Crash Reporting мы видим приглашение установить сервис Crashlytics и поучаствовать в его тестировании, а в скором времени он полностью заменит Firebase Crash Reporting.

Во-вторых, интеграция с сервисом Digits теперь позволяет аутентификацию по номеру телефона! Бесплатно можно будет осуществлять 10 тысяч аутентификаций в месяц, что вполне должно покрыть нужды разработчиков. А Digits SDK как самостоятельный продукт в ближайшее время получит статус deprecated.

Я немедленно захотел прикрутить авторизацию по телефону к своему приложению и показать, как же просто это сделать, но как выяснилось сервис сейчас доступен только для iOS и WEB разработчиков, Android версию придется подождать еще пару недель.

Динамический хостинг с Firebase Cloud Functions

Еще в марте, на Google NEXT’17, ребята из команды Firebase рассказали о запуске нового сервиса Cloud Functions for Firebase. Сервис предоставляет возможность размещать небольшие JavaScript функции непосредственно в Google Cloud инфраструктуре, и исполнять их в качестве реакции на события, вызванные сервисами Firebase или HTTP запросами.

Это позволяет кастомизировать или расширять стандартную работу сервисов Firebase своими фичами, такими как отправка welcome email каждому новому пользователю (Authentication), отслеживать и удалять ненормативную лексику в постах или чатах (Realtime Database), конвертировать изображения при загрузке в хранилище (Storage) и тп.

Для тех кто не пробовал, покажу пример применения Cloud Functions. Возьмем из GitHub исходники FriendlyChat, приложения создание которого я описывал в прошлогодней статье. Привяжем его к чистому Firebase проекту и добавим Cloud Function, которая будет автоматически приветствовать всех новых пользователей в чате.

Первым делом придется установить Node.js, а затем установить Firebase Command Line Interface (CLI) командой:

npm -g install firebase-toolsавторизоваться в интерфейсе командой

firebase loginсоздать папку для своего проекта, перейти в нее и создать сам проект командой

firebase init functionsВ результате в папке создастся структура проекта, заходим в папку functions и находим index.js, здесь и будут хранится наши функции. Если открыть файл, то в нем будет только одна строчка — const functions = require('firebase-functions'); — это собственно подключение Firebase SDK. Добавим туда подключение Admin SDK:

const admin = require('firebase-admin');

admin.initializeApp(functions.config().firebase);

Приготовления закончены, теперь имплементируем саму функцию, она будет срабатывать на событие создания нового пользователя в сервисе Authentication, то-есть когда пользователь заходит в чат в первый раз:

exports.addWelcomeMessages = functions.auth.user().onCreate(event => {

const user = event.data;

console.log('A new user signed in for the first time.');

const fullName = user.displayName || 'Anonymous';

// В базу данных будет положено сообщение от файрбез бота о добавлении нового пользователя

return admin.database().ref('messages').push({

name: 'Firebase Bot',

photoUrl: 'https://image.ibb.co/b7A7Sa/firebase_logo.png', // Firebase logo выгружен на первый попавшийся image hosting

text: '${fullName} signed in for the first time! Welcome!'

});

});

Осталось выгрузить функцию в облако и все:

firebase deploy --only functions

можно запускать приложение, и после авторизации бот радостно приветствует нового пользователя в чате.

Но все это было представлено еще до I/O! Непосредственно на нем, Firebase представил новинку, которая должна порадовать сообщество веб-разработчиков. Сервис Firebase Hosting, который раньше позволял работать только со статическим контентом, был расширен интеграцией с Cloud Functions, и теперь работает с динамическим контентом, формируемым сервисом Cloud Functions.

Теперь разработчики занимающиеся progressive web приложениями, смогут полностью отказаться от своего сервера и использовать только Firebase.

Очень хочется привести примеры, но я еще не писал про Web разработку с помощью Firebase, и статья получилась бы слишком большой, поэтому ожидайте следующую, полностью посвященную разработке под Web и использованию Cloud Functions статью.

Firebase Performance Monitoring

Часто недостаточная производительность и/или стабильность приложения являются главной причиной недовольства пользователей. Но не всегда просто понять, почему приложение недостаточно производительно или стабильно, для помощи в этом нелегком деле, команда Firebase запустила в бета тестирование новый сервис Performance Monitoring. Firebase Performance Monitoring — это новый бесплатный инструмент, который поможет вам понять, когда плохой код или сложные сетевые условия влияют на ваш пользовательский интерфейс.

Для того чтоб сервис начал собирать данные о производительности вашего приложения, необходимо подключить Performance Monitoring SDK, после этого сервис сразу начнет собирать данные. Сервис будет предоставлять отчеты в виде так называемых трейсов (trace) — отчетов о производительности между двумя событиями в вашем приложении. Сразу после подключения начнут собираться данные для автоматических трейсов:

- App start trace — измеряет время между тем когда пользователь запустил приложение и тем когда приложение отозвалось

- App in background trace — измеряет время нахождения приложения в бекграунде

- App in foreground trace — измеряет время активности приложения

Подключим сервис к приложению, чтобы посмотреть как это выглядит. Я взял стандартное приложение из google codelabs — FriendlyChat и подключил его к своей базе. Теперь подключим Performance Monitoring, для этого добавим в project-level build.gradle в секцию buildscript -> repositories:

jcenter() и в секцию buildscript -> dependencies

classpath 'com.google.firebase:firebase-plugins:1.1.0'затем в app-level build.gradle в секцию dependencies

compile 'com.google.firebase:firebase-perf:10.2.6'и под apply plugin: 'com.android.application'

apply plugin: 'com.google.firebase.firebase-perf'Вуаля, сервис подключен, теперь автоматических трейсы запускаются при старте приложения.

Так как автоматических трейсов явно недостаточно, предоставлена возможность создавать кастомные трейсы, используя API предоставленное SDK. Их можно дополнять счетчиками событий, связанными с производительностью, например количество раз, когда UI был недоступен дольше чем заданный промежуток времени.

Кастомные трейсы добавляются предельно просто, перед участком кода, который мы хотим трассировать добавим:

Trace myTrace = FirebasePerformance.getInstance().newTrace("test_trace");

myTrace.start();

а после участка

myTrace.stop();Я добавил трассировку загрузки изображения в чат, ну и ради интереса добавим счетчик

myTrace.incrementCounter("storage_load");Но результаты в консоли доступны не сразу, они появятся там в течении 12-ти часов.

Усовершенствованная аналитика

Начну с того, что Firebase Analytics больше не существует, теперь сервис называется Google Analytics for Firebase, и это неспроста. Сервис был разработан совместно командами Firebase и Google Analytics, а все отчеты теперь доступны не только в консоли Firebase, но и в интерфейсе Google Analytics.

Новые типы отчетов StreamView и DebugView были представлены еще в начале года, но это не умаляет степень их полезности. StreamView визуализирует события по мере их поступления в Firebase Analytics и дает общее представление о том, как ваши пользователи взаимодействуют с вашим приложением в реальном времени, а не с задержкой до 12ти часов. А с помощью DebugView вы можете сразу увидеть, какие события регистрируются.

И еще одна новость, которую все так долго ждали, теперь аналитическую информацию по пользовательским событиям и параметрам можно будет посмотреть в отчетах непосредственно в консоли, а не выгружать данные в BigQuery, как это было необходимо ранее. Для этого нужно всего лишь настроить параметры отчета там же в консоли.

Добавилось еще много всяких интересных фич, интеграция с AdMob, автоматический Screen Tracking, бесплатный Storage Tier в BigQuery…. так что полагаю, что для аналитики все-таки тоже придется писать отдельную статью.

Firebase SDK — теперь в опенсорсе

Да, это именно так. Исходный код Firebase SDK теперь доступен для изучения на GitHub. Не весь конечно, на данный момент доступны исходники Firebase iOS SDK 4.0, Firebase JavaScript SDK 4.0 и Firebase Admin SDKs (Node.js, Java и Python). Следующим обещают выложить Android SDK, будем ждать с нетерпением.

Теперь можно будет поправлять Google, если что-то в коде вам не понравится! То есть теперь, если вы найдете какие-то, с вашей точки зрения, баги — можно будет просто создать issue через стандартный GitHub issue tracker и Firebase команда рассмотрит ее. Весь проект можно так же найти в Google Open Source Directory.

Приятные мелочи

И напоследок я вкратце расскажу о всяких приятных мелочах, которые были добавлены в уже существующие сервисы.

Realtime Database:

- Расширены возможности, теперь доступно до 100000 одновременных подключений

- Добавлена возможность профилирования, profiler позволяет анализировать скорость работы с данными, пропускную способность и время задержки в зависимости от уровня

Storage:

- Добавлен мапинг на уже существующие cloud storage bucket’ы, теперь можно работать с ними через Firebase

- Появилась возможность выбора региона, в котором будут хранится ваши данные. Это может быть полезно как с юридической точки зрения, так и с точки зрения производительности

Cloud Messaging:

- Добавлена поддержка аутентификации на токенах для APN, и значительно упрощена логика соединения и регистрации в клиентском SDK.

TestLab:

- Добавлены Game Loop support и FPS мониторинг, что в сочетании с Unity SDK и C++ SDK, представленными ранее, должно сделать Firebase привлекательной для разработчиков игр.

- Добавлена возможность симуляции уровня сети, можно выбрать скорость подключения 4G, 3G и т.п.

- В датацентре появились Google Pixel и Galaxy S7 для тестирования приложений на реальных устройствах последнего поколения

- Появился доступ к Android O

А также, не привязываясь ни к какому из сервисов, еще добавлю что в iOS SDK была реализована поддержка Swift, что должно порадовать разработчиков под iOS работающих с Firebase.

Итак, какие можно сделать выводы? Ничего супер неожиданного и сногсшибательного на I/O представлено не было. Но Firebase растет, растет медленно и уверенно. Используя ее сервисы в качестве бэкэнда уже можно создавать вполне конкурентноспособные приложения, анализировать их работу, управлять их продвижением и монетизировать. И чем дальше, тем больше интересных инструментов появляется у пользователей.

P.S: На I/O было озвучено интересное предложение от от Firebase — программа Альфа (без VPN не откроется). У тех кто зарегистрируется и выразит свое желание участвовать в программе, будет возможность проверить обновления сервисов Firebase до их релиза. Они будут не идеальные (думаю, что местами совсем сырые), но, приняв участие в Альфа-сообществе, формируя фидбэки на еще не выпущенные продукты, вы поможете определить будущее Firebase!

|

Метки: author Developers_Relations разработка под ios разработка под android разработка мобильных приложений google api блог компании google google io firebase |

Firebase на I/O 2017: новые возможности |

Привет Хабр! Совсем недавно в Маунтин-Вью, Калифорния прошла очередная международная конференция, посвященная технологиям Google — I/O 2017. Кто-то ездил на нее в Калифорнию, кто-то приходил на I/O Extended организованные региональными отделениями GDG комьюнити, кто-то смотрел трансляцию самостоятельно, а кто-то не смотрел вовсе (На всякий случай оставлю это тут: все сессии I/O 2017 в записи). О том насколько была хороша или не очень хороша конференция в этом году, мнения противоречивы, я могу сказать только лично от себя, мне очень понравилось.

Еще в прошлом году я сильно заинтересовался тем, что делают ребята из команды Firebase, и я даже писал об этом статью, по этому мне хочется рассказать вам, что нового появилось в экосистеме Firebase, и каким образом это можно использовать.

Интеграция с Fabric

О том что Google приобрел Fabric у Twitter я слышал уже некоторое время назад, но на I/O я воочию увидел групп менеджера из Fabric Рича Пэрета из Fabric и кофаундера Firebase Эндрю Ли на одной сцене, обсуждающих перспективы объединения команд и дружески подкалывающих друг друга.

Итак, что же мы получили в результате этого слияния? Во-первых, Crahslytics в скором времени будет интегрирован в Firebase как основное решение для crash reporting! Уже сейчас в консоли Crash Reporting мы видим приглашение установить сервис Crashlytics и поучаствовать в его тестировании, а в скором времени он полностью заменит Firebase Crash Reporting.

Во-вторых, интеграция с сервисом Digits теперь позволяет аутентификацию по номеру телефона! Бесплатно можно будет осуществлять 10 тысяч аутентификаций в месяц, что вполне должно покрыть нужды разработчиков. А Digits SDK как самостоятельный продукт в ближайшее время получит статус deprecated.

Я немедленно захотел прикрутить авторизацию по телефону к своему приложению и показать, как же просто это сделать, но как выяснилось сервис сейчас доступен только для iOS и WEB разработчиков, Android версию придется подождать еще пару недель.

Динамический хостинг с Firebase Cloud Functions

Еще в марте, на Google NEXT’17, ребята из команды Firebase рассказали о запуске нового сервиса Cloud Functions for Firebase. Сервис предоставляет возможность размещать небольшие JavaScript функции непосредственно в Google Cloud инфраструктуре, и исполнять их в качестве реакции на события, вызванные сервисами Firebase или HTTP запросами.

Это позволяет кастомизировать или расширять стандартную работу сервисов Firebase своими фичами, такими как отправка welcome email каждому новому пользователю (Authentication), отслеживать и удалять ненормативную лексику в постах или чатах (Realtime Database), конвертировать изображения при загрузке в хранилище (Storage) и тп.

Для тех кто не пробовал, покажу пример применения Cloud Functions. Возьмем из GitHub исходники FriendlyChat, приложения создание которого я описывал в прошлогодней статье. Привяжем его к чистому Firebase проекту и добавим Cloud Function, которая будет автоматически приветствовать всех новых пользователей в чате.

Первым делом придется установить Node.js, а затем установить Firebase Command Line Interface (CLI) командой:

npm -g install firebase-toolsавторизоваться в интерфейсе командой

firebase loginсоздать папку для своего проекта, перейти в нее и создать сам проект командой

firebase init functionsВ результате в папке создастся структура проекта, заходим в папку functions и находим index.js, здесь и будут хранится наши функции. Если открыть файл, то в нем будет только одна строчка — const functions = require('firebase-functions'); — это собственно подключение Firebase SDK. Добавим туда подключение Admin SDK:

const admin = require('firebase-admin');

admin.initializeApp(functions.config().firebase);

Приготовления закончены, теперь имплементируем саму функцию, она будет срабатывать на событие создания нового пользователя в сервисе Authentication, то-есть когда пользователь заходит в чат в первый раз:

exports.addWelcomeMessages = functions.auth.user().onCreate(event => {

const user = event.data;

console.log('A new user signed in for the first time.');

const fullName = user.displayName || 'Anonymous';

// В базу данных будет положено сообщение от файрбез бота о добавлении нового пользователя

return admin.database().ref('messages').push({

name: 'Firebase Bot',

photoUrl: 'https://image.ibb.co/b7A7Sa/firebase_logo.png', // Firebase logo выгружен на первый попавшийся image hosting

text: '${fullName} signed in for the first time! Welcome!'

});

});

Осталось выгрузить функцию в облако и все:

firebase deploy --only functions

можно запускать приложение, и после авторизации бот радостно приветствует нового пользователя в чате.

Но все это было представлено еще до I/O! Непосредственно на нем, Firebase представил новинку, которая должна порадовать сообщество веб-разработчиков. Сервис Firebase Hosting, который раньше позволял работать только со статическим контентом, был расширен интеграцией с Cloud Functions, и теперь работает с динамическим контентом, формируемым сервисом Cloud Functions.

Теперь разработчики занимающиеся progressive web приложениями, смогут полностью отказаться от своего сервера и использовать только Firebase.

Очень хочется привести примеры, но я еще не писал про Web разработку с помощью Firebase, и статья получилась бы слишком большой, поэтому ожидайте следующую, полностью посвященную разработке под Web и использованию Cloud Functions статью.

Firebase Performance Monitoring

Часто недостаточная производительность и/или стабильность приложения являются главной причиной недовольства пользователей. Но не всегда просто понять, почему приложение недостаточно производительно или стабильно, для помощи в этом нелегком деле, команда Firebase запустила в бета тестирование новый сервис Performance Monitoring. Firebase Performance Monitoring — это новый бесплатный инструмент, который поможет вам понять, когда плохой код или сложные сетевые условия влияют на ваш пользовательский интерфейс.

Для того чтоб сервис начал собирать данные о производительности вашего приложения, необходимо подключить Performance Monitoring SDK, после этого сервис сразу начнет собирать данные. Сервис будет предоставлять отчеты в виде так называемых трейсов (trace) — отчетов о производительности между двумя событиями в вашем приложении. Сразу после подключения начнут собираться данные для автоматических трейсов:

- App start trace — измеряет время между тем когда пользователь запустил приложение и тем когда приложение отозвалось

- App in background trace — измеряет время нахождения приложения в бекграунде

- App in foreground trace — измеряет время активности приложения

Подключим сервис к приложению, чтобы посмотреть как это выглядит. Я взял стандартное приложение из google codelabs — FriendlyChat и подключил его к своей базе. Теперь подключим Performance Monitoring, для этого добавим в project-level build.gradle в секцию buildscript -> repositories:

jcenter() и в секцию buildscript -> dependencies

classpath 'com.google.firebase:firebase-plugins:1.1.0'затем в app-level build.gradle в секцию dependencies

compile 'com.google.firebase:firebase-perf:10.2.6'и под apply plugin: 'com.android.application'

apply plugin: 'com.google.firebase.firebase-perf'Вуаля, сервис подключен, теперь автоматических трейсы запускаются при старте приложения.

Так как автоматических трейсов явно недостаточно, предоставлена возможность создавать кастомные трейсы, используя API предоставленное SDK. Их можно дополнять счетчиками событий, связанными с производительностью, например количество раз, когда UI был недоступен дольше чем заданный промежуток времени.

Кастомные трейсы добавляются предельно просто, перед участком кода, который мы хотим трассировать добавим:

Trace myTrace = FirebasePerformance.getInstance().newTrace("test_trace");

myTrace.start();

а после участка

myTrace.stop();Я добавил трассировку загрузки изображения в чат, ну и ради интереса добавим счетчик

myTrace.incrementCounter("storage_load");Но результаты в консоли доступны не сразу, они появятся там в течении 12-ти часов.

Усовершенствованная аналитика

Начну с того, что Firebase Analytics больше не существует, теперь сервис называется Google Analytics for Firebase, и это неспроста. Сервис был разработан совместно командами Firebase и Google Analytics, а все отчеты теперь доступны не только в консоли Firebase, но и в интерфейсе Google Analytics.

Новые типы отчетов StreamView и DebugView были представлены еще в начале года, но это не умаляет степень их полезности. StreamView визуализирует события по мере их поступления в Firebase Analytics и дает общее представление о том, как ваши пользователи взаимодействуют с вашим приложением в реальном времени, а не с задержкой до 12ти часов. А с помощью DebugView вы можете сразу увидеть, какие события регистрируются.

И еще одна новость, которую все так долго ждали, теперь аналитическую информацию по пользовательским событиям и параметрам можно будет посмотреть в отчетах непосредственно в консоли, а не выгружать данные в BigQuery, как это было необходимо ранее. Для этого нужно всего лишь настроить параметры отчета там же в консоли.

Добавилось еще много всяких интересных фич, интеграция с AdMob, автоматический Screen Tracking, бесплатный Storage Tier в BigQuery…. так что полагаю, что для аналитики все-таки тоже придется писать отдельную статью.

Firebase SDK — теперь в опенсорсе

Да, это именно так. Исходный код Firebase SDK теперь доступен для изучения на GitHub. Не весь конечно, на данный момент доступны исходники Firebase iOS SDK 4.0, Firebase JavaScript SDK 4.0 и Firebase Admin SDKs (Node.js, Java и Python). Следующим обещают выложить Android SDK, будем ждать с нетерпением.

Теперь можно будет поправлять Google, если что-то в коде вам не понравится! То есть теперь, если вы найдете какие-то, с вашей точки зрения, баги — можно будет просто создать issue через стандартный GitHub issue tracker и Firebase команда рассмотрит ее. Весь проект можно так же найти в Google Open Source Directory.

Приятные мелочи

И напоследок я вкратце расскажу о всяких приятных мелочах, которые были добавлены в уже существующие сервисы.

Realtime Database:

- Расширены возможности, теперь доступно до 100000 одновременных подключений

- Добавлена возможность профилирования, profiler позволяет анализировать скорость работы с данными, пропускную способность и время задержки в зависимости от уровня

Storage:

- Добавлен мапинг на уже существующие cloud storage bucket’ы, теперь можно работать с ними через Firebase

- Появилась возможность выбора региона, в котором будут хранится ваши данные. Это может быть полезно как с юридической точки зрения, так и с точки зрения производительности

Cloud Messaging:

- Добавлена поддержка аутентификации на токенах для APN, и значительно упрощена логика соединения и регистрации в клиентском SDK.

TestLab:

- Добавлены Game Loop support и FPS мониторинг, что в сочетании с Unity SDK и C++ SDK, представленными ранее, должно сделать Firebase привлекательной для разработчиков игр.

- Добавлена возможность симуляции уровня сети, можно выбрать скорость подключения 4G, 3G и т.п.

- В датацентре появились Google Pixel и Galaxy S7 для тестирования приложений на реальных устройствах последнего поколения

- Появился доступ к Android O

А также, не привязываясь ни к какому из сервисов, еще добавлю что в iOS SDK была реализована поддержка Swift, что должно порадовать разработчиков под iOS работающих с Firebase.

Итак, какие можно сделать выводы? Ничего супер неожиданного и сногсшибательного на I/O представлено не было. Но Firebase растет, растет медленно и уверенно. Используя ее сервисы в качестве бэкэнда уже можно создавать вполне конкурентноспособные приложения, анализировать их работу, управлять их продвижением и монетизировать. И чем дальше, тем больше интересных инструментов появляется у пользователей.

P.S: На I/O было озвучено интересное предложение от от Firebase — программа Альфа (без VPN не откроется). У тех кто зарегистрируется и выразит свое желание участвовать в программе, будет возможность проверить обновления сервисов Firebase до их релиза. Они будут не идеальные (думаю, что местами совсем сырые), но, приняв участие в Альфа-сообществе, формируя фидбэки на еще не выпущенные продукты, вы поможете определить будущее Firebase!

|

Метки: author Developers_Relations разработка под ios разработка под android разработка мобильных приложений google api блог компании google google io firebase |

Побеждаем Android Camera2 API с помощью RxJava2 (часть 1) |

Как известно, RxJava идеально подходит для решения двух задач: обработки потоков событий и работы с асинхронными методами. В одном из предыдущих постов я показал, как можно построить цепочку операторов, обрабатывающую поток событий от сенсора. А сегодня я хочу продемонстрировать, как RxJava применяется для работы с существенно асинхронным API. В качестве такого API я выбрал Camera2 API.

Ниже будет показан пример использования Camera2 API, который пока довольно слабо задокументирован и изучен сообществом. Для его укрощения будет использована RxJava2. Вторая версия этой популярной библиотеки вышла сравнительно недавно, и примеров на ней тоже немного.

Для кого этот пост? Я рассчитываю, что читатель – умудрённый опытом, но всё ещё любознательный Android-разработчик. Очень желательны базовые знания о реактивном программировании (хорошее введение – здесь) и понимание Marble Diagrams. Пост будет полезен тем, кто хочет проникнуться реактивным подходом, а также тем, кто хочет использовать Camera2 API в своих проектах. Предупреждаю, будет много кода!

Исходники проекта можно найти на GitHub.

Подготовка проекта

Добавим сторонние зависимости в наш проект.

Retrolambda

При работе с RxJava совершенно необходима поддержка лямбд – иначе код будет выглядеть просто ужасно. Так что если вы ещё не перешли на Android Studio 3.0, добавим Retrolambda в наш проект.

buildscript {

dependencies {

classpath 'me.tatarka:gradle-retrolambda:3.6.0'

}

}

apply plugin: 'me.tatarka.retrolambda'Теперь можно поднять версию языка до 8, что обеспечит поддержку лямбд.

android {

compileOptions {

sourceCompatibility JavaVersion.VERSION_1_8

targetCompatibility JavaVersion.VERSION_1_8

}

}Полные инструкции.

RxJava2

compile "io.reactivex.rxjava2:rxjava:2.1.0"Актуальную версию, полные инструкции и документацию ищите тут.

RxAndroid

Полезная библиотека при использовании RxJava на Android. В основном используется ради AndroidSchedulers. Репозиторий.

compile 'io.reactivex.rxjava2:rxandroid:2.0.1'Camera2 API

В своё время я участвовал в code review модуля, написанного с использованием Camera1 API, и был неприятно удивлён неизбежными в силу дизайна API concurrency issues. Видимо, в Google тоже осознали проблему и задепрекейтили первую версию API. Взамен предлагается использовать Camera2 API. Вторая версия доступна на Android Lollipop и новее.

Давайте же на него посмотрим.

Первые впечатления

Google проделал хорошую работу над ошибками в плане организации потоков. Все операции выполняются асинхронно, уведомляя о результатах через колбеки. Причём, передавая соответствующий Handler, можно выбрать поток, в котором будут вызываться методы колбеков.

Референсная имплементация

Google предлагает пример приложения Camera2Basic.

Это довольно наивная реализация, но помогает начать разбираться с API. Посмотрим, сможем ли мы сделать более изящное решение, используя реактивный подход.

Шаги для получения снимка

Если кратко, то последовательность действий для получения снимка такова:

- выбрать устройство,

- открыть устройство,

- открыть сессию,

- запустить превью,

- по нажатию на кнопку сделать снимок,

- закрыть сессию,

- закрыть устройство.

Выбор устройства

Прежде всего нам понадобится CameraManager.

mCameraManager = (CameraManager) mContext.getSystemService(Context.CAMERA_SERVICE);Этот класс позволяет получать информацию о существующих в системе камерах и подключаться к ним. Камер может быть несколько, в смартфонах обычно их две: фронтальная и тыловая.

Получаем список камер.

String[] cameraIdList = mCameraManager.getCameraIdList();Вот так сурово – просто список строковых айдишников.

Теперь получим список характеристик для каждой камеры.

for (String cameraId : cameraIdList) {

CameraCharacteristics characteristics = mCameraManager.getCameraCharacteristics(cameraId);

...

}CameraCharacteristics содержит огромное количество ключей, по которым можно получать информацию о камере.

Чаще всего на этапе выбора камеры смотрят на то, куда направлена камера. Для этого необходимо получить значение по ключу CameraCharacteristics.LENS_FACING.

Integer facing = characteristics.get(CameraCharacteristics.LENS_FACING);Камера может быть фронтальной (CameraCharacteristics.LENS_FACING_FRONT), тыловой (CameraCharacteristics.LENS_FACING_BACK) или подключаемой (CameraCharacteristics.LENS_FACING_EXTERNAL).

Функция выбора камеры с предпочтением по ориентации может выглядеть примерно так:

@Nullable

private static String getCameraWithFacing(@NonNull CameraManager manager, int lensFacing) throws CameraAccessException {

String possibleCandidate = null;

String[] cameraIdList = manager.getCameraIdList();

if (cameraIdList.length == 0) {

return null;

}

for (String cameraId : cameraIdList) {

CameraCharacteristics characteristics = manager.getCameraCharacteristics(cameraId);

StreamConfigurationMap map = characteristics.get(CameraCharacteristics.SCALER_STREAM_CONFIGURATION_MAP);

if (map == null) {

continue;

}

Integer facing = characteristics.get(CameraCharacteristics.LENS_FACING);

if (facing != null && facing == lensFacing) {

return cameraId;

}

//just in case device don't have any camera with given facing

possibleCandidate = cameraId;

}

if (possibleCandidate != null) {

return possibleCandidate;

}

return cameraIdList[0];

}Отлично, теперь у нас есть id камеры нужной ориентации (или любой другой, если нужной не нашлось). Пока всё довольно просто, никаких асинхронных действий.

Создаем Observable

Мы подходим к асинхронным методам API. Каждый из них мы превратим в Observable с помощью метода create.

openCamera

Устройство перед использованием нужно открыть с помощью метода CameraManager.openCamera.

void openCamera (String cameraId,

CameraDevice.StateCallback callback,

Handler handler)В этот метод передаём id выбранной камеры, колбек для получения асинхронного результата и Handler, если мы хотим, чтобы методы колбека вызывались в потоке этого Handler.

Вот мы и столкнулись с первым асинхронным методом. Оно и понятно, ведь инициализация устройства – длительный и дорогой процесс.

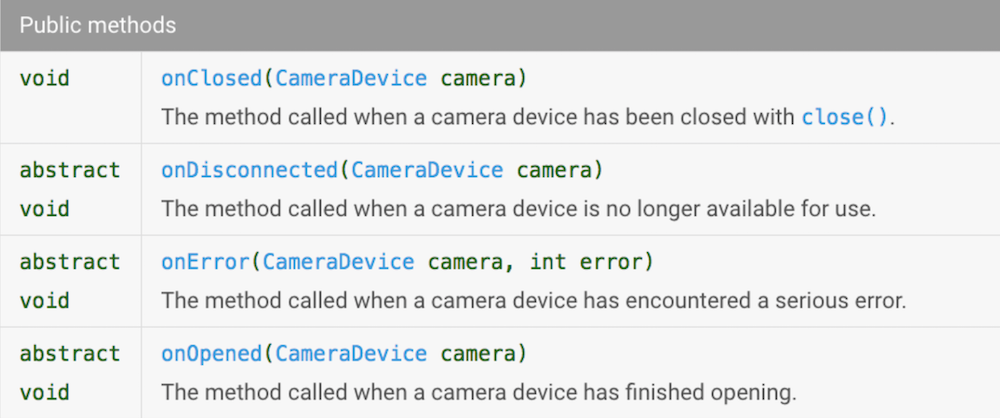

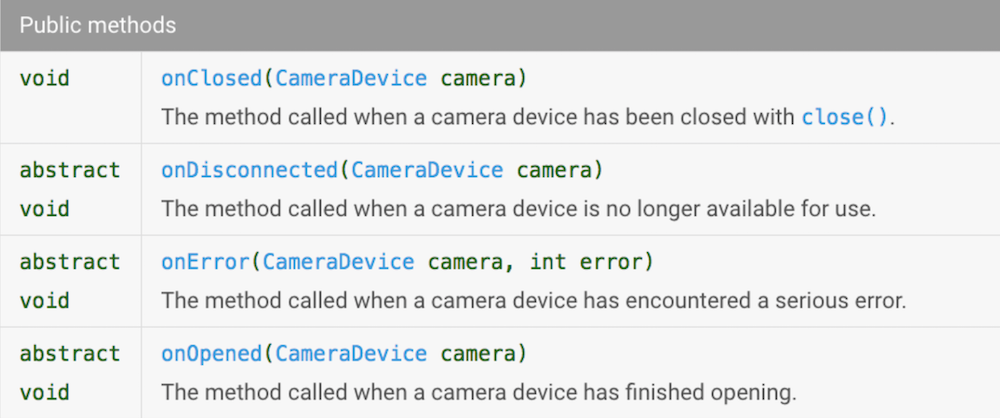

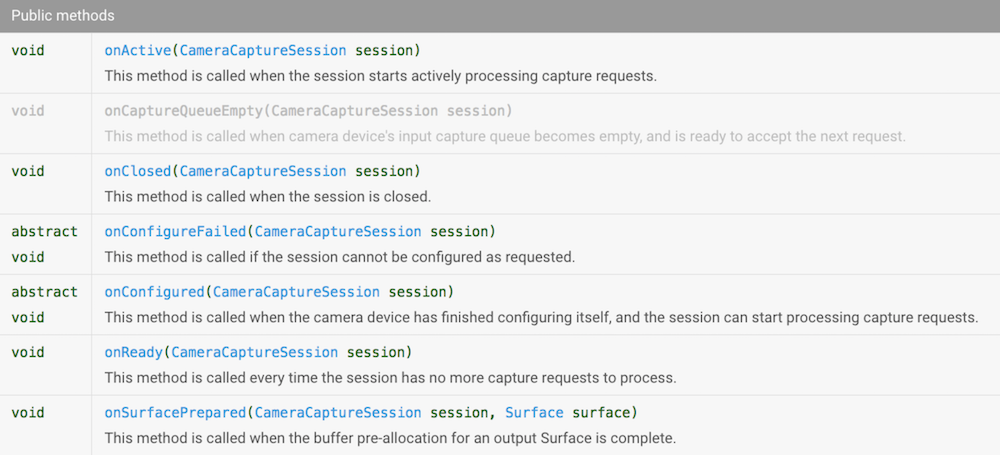

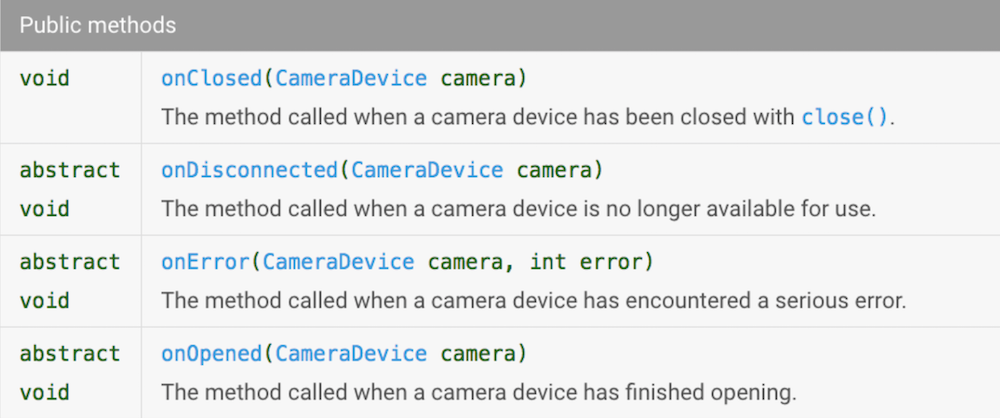

Давайте взглянем на CameraDevice.StateCallback.

В реактивном мире эти методы будут соответствовать событиям. Давайте сделаем Observable, который будет генерировать события, когда API камеры будет вызывать onOpened, onClosed, onDisconnected. Чтобы мы могли различать эти события, создадим enum:

public enum DeviceStateEvents {

ON_OPENED,

ON_CLOSED,

ON_DISCONNECTED

}А чтобы в реактивном потоке (тут и далее я буду называть реактивным потоком последовательность реактивных операторов – не путать со Thread) была возможность что-то сделать с устройством, мы добавим в генерируемое событие ссылку на CameraDevice. Самый простой способ – генерировать Pair. Для создания Observable воспользуемся методом create (напомню, мы используем RxJava2, так что теперь нам совсем не стыдно это делать).

Вот сигнатура метода create:

public static Observable create(ObservableOnSubscribe source) То есть нам нужно передать в него объект, реализующий интерфейс ObservableOnSubscribe. Этот интерфейс содержит всего один метод

void subscribe(@NonNull ObservableEmitter e) throws Exception; который вызывается каждый раз, когда Observer подписывается (subscribe) на наш Observable.

Посмотрим, что такое ObservableEmitter.

public interface ObservableEmitter extends Emitter {

void setDisposable(@Nullable Disposable d);

void setCancellable(@Nullable Cancellable c);

boolean isDisposed();

ObservableEmitter serialize();

} Уже хорошо. С помощью методов setDisposable/setCancellable можно задать действие, которое будет выполнено, когда от нашего Observable отпишутся. Это крайне полезно, если при создании Observable мы открывали ресурс, который надо закрывать. Мы могли бы создать Disposable, в котором закрывать устройство при unsubscribe, но мы хотим реагировать на событие onClosed, поэтому делать этого не будем.

Метод isDisposed позволяет проверять, подписан ли кто-то ещё на наш Observable.

Заметим, что ObservableEmitter расширяет интерфейс Emitter.

public interface Emitter {

void onNext(@NonNull T value);

void onError(@NonNull Throwable error);

void onComplete();

} Вот эти методы нам и нужны! Мы будем вызывать onNext каждый раз, когда Camera API будет вызывать колбеки интерфейса CameraDevice.StateCallback onOpened / onClosed / onDisconnected; и мы будем вызывать onError, когда Camera API будет вызывать колбек onError.

Итак, применим наши знания. Mетод, создающий Observable, может выглядеть так (ради читабельности я убрал проверки на isDisposed(), полный код со скучными проверками смотрите на GitHub):

public static Observable> openCamera(

@NonNull String cameraId,

@NonNull CameraManager cameraManager

) {

return Observable.create(observableEmitter -> {

cameraManager.openCamera(cameraId, new CameraDevice.StateCallback() {

@Override

public void onOpened(@NonNull CameraDevice cameraDevice) {

observableEmitter.onNext(new Pair<>(DeviceStateEvents.ON_OPENED, cameraDevice));

}

@Override

public void onClosed(@NonNull CameraDevice cameraDevice) {

observableEmitter.onNext(new Pair<>(DeviceStateEvents.ON_CLOSED, cameraDevice));

observableEmitter.onComplete();

}

@Override

public void onDisconnected(@NonNull CameraDevice cameraDevice) {

observableEmitter.onNext(new Pair<>(DeviceStateEvents.ON_DISCONNECTED, cameraDevice));

observableEmitter.onComplete();

}

@Override

public void onError(@NonNull CameraDevice camera, int error) {

observableEmitter.onError(new OpenCameraException(OpenCameraException.Reason.getReason(error)));

}

}, null);

});

}Супер! Мы только что стали чуть более реактивными!

Как я уже говорил, все методы Camera2 API принимают Handler как один из параметров. Передавая null, мы будем получать вызовы колбеков в текущем потоке. В нашем случае это поток, в котором был вызван subscribe, то есть Main Thread.

createCaptureSession

Теперь, когда у нас есть CameraDevice, можно открыть CaptureSession. Не будем медлить!

Для этого воспользуемся методом CameraDevice.createCaptureSession. Вот его сигнатура:

public abstract void createCaptureSession(@NonNull List outputs,

@NonNull CameraCaptureSession.StateCallback callback, @Nullable Handler handler)

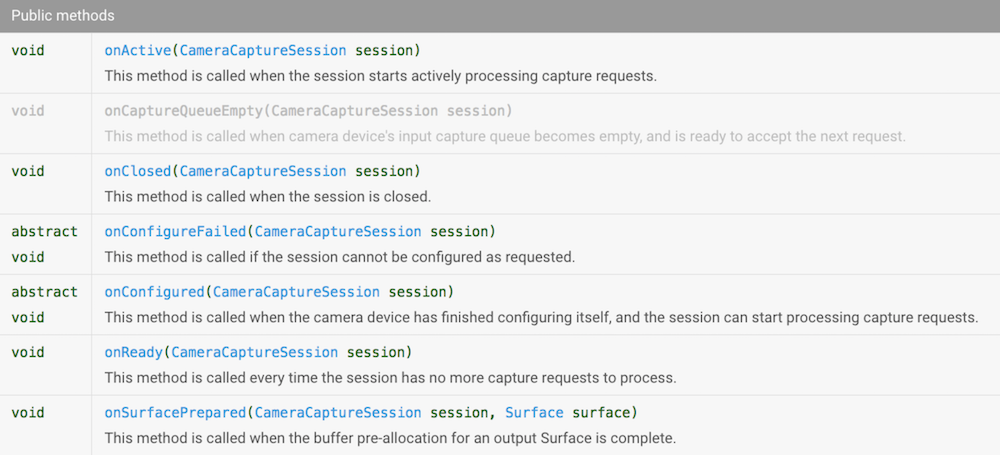

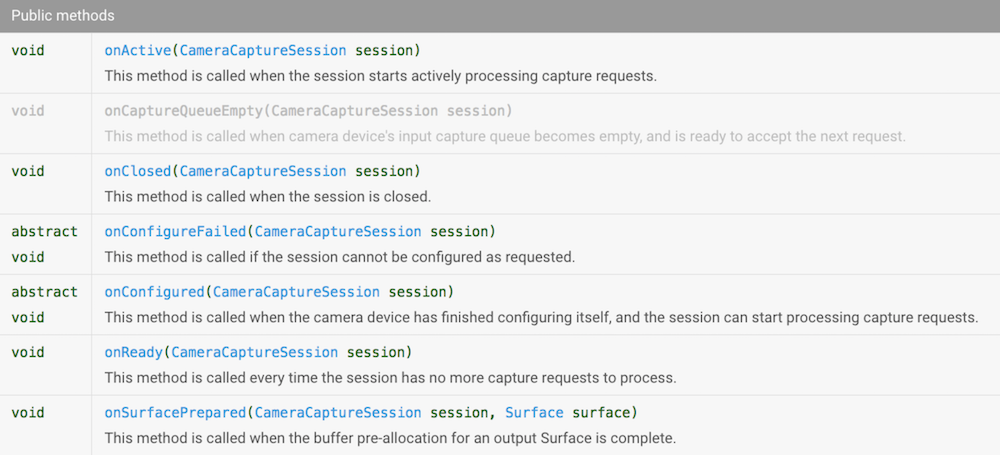

throws CameraAccessException; На вход подаётся список Surface (где его взять, разберёмся чуть позже) и CameraCaptureSession.StateCallback. Давайте посмотрим, какие в нём есть методы.

Богато! Но мы уже знаем, как побеждать колбеки. Создадим Observable, который будет генерировать события, когда Camera API будет вызывать эти методы. Чтобы их различать, создадим enum.

public enum CaptureSessionStateEvents {

ON_CONFIGURED,

ON_READY,

ON_ACTIVE,

ON_CLOSED,

ON_SURFACE_PREPARED

}А чтобы в реактивном потоке был объект CameraCaptureSession, будем генерировать не просто CaptureSessionStateEvent, а Pair. Вот как может выглядеть код метода, создающего такой Observable (проверки снова убраны для читабельности):

@NonNull

public static Observable> createCaptureSession(

@NonNull CameraDevice cameraDevice,

@NonNull List surfaceList

) {

return Observable.create(observableEmitter -> {

cameraDevice.createCaptureSession(surfaceList, new CameraCaptureSession.StateCallback() {

@Override

public void onConfigured(@NonNull CameraCaptureSession session) {

observableEmitter.onNext(new Pair<>(CaptureSessionStateEvents.ON_CONFIGURED, session));

}

@Override

public void onConfigureFailed(@NonNull CameraCaptureSession session) {

observableEmitter.onError(new CreateCaptureSessionException(session));

}

@Override

public void onReady(@NonNull CameraCaptureSession session) {

observableEmitter.onNext(new Pair<>(CaptureSessionStateEvents.ON_READY, session));

}

@Override

public void onActive(@NonNull CameraCaptureSession session) {

observableEmitter.onNext(new Pair<>(CaptureSessionStateEvents.ON_ACTIVE, session));

}

@Override

public void onClosed(@NonNull CameraCaptureSession session) {

observableEmitter.onNext(new Pair<>(CaptureSessionStateEvents.ON_CLOSED, session));

observableEmitter.onComplete();

}

@Override

public void onSurfacePrepared(@NonNull CameraCaptureSession session, @NonNull Surface surface) {

observableEmitter.onNext(new Pair<>(CaptureSessionStateEvents.ON_SURFACE_PREPARED, session));

}

}, null);

});

} setRepeatingRequest

Для того чтобы на экране появилась живая картинка с камеры, необходимо постоянно получать новые изображения с устройства и передавать их для отображения. Для этого в API есть удобный метод CameraCaptureSession.setRepeatingRequest.

int setRepeatingRequest(@NonNull CaptureRequest request,

@Nullable CaptureCallback listener, @Nullable Handler handler)

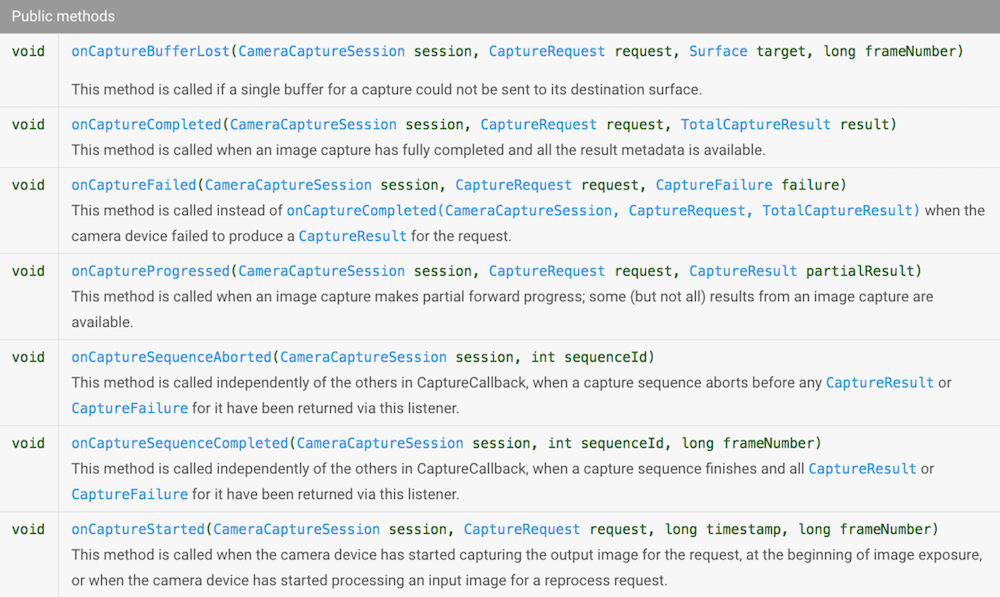

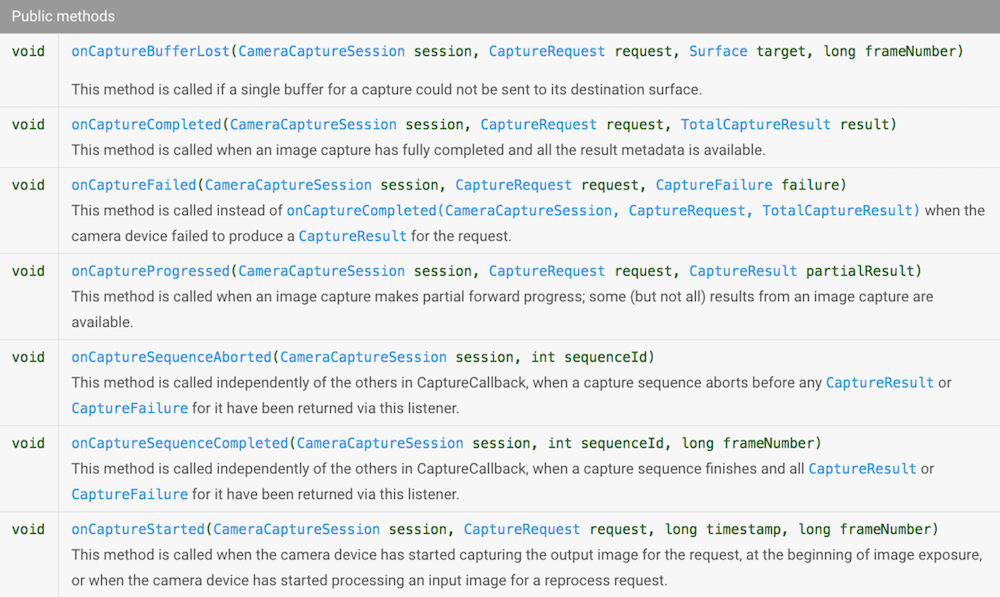

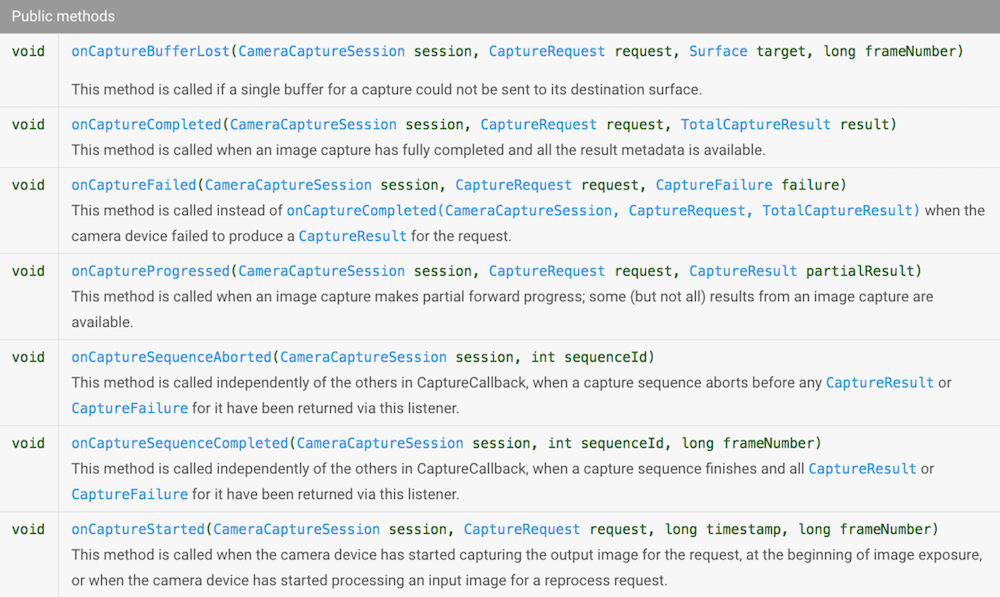

throws CameraAccessException;Применяем уже знакомый нам приём, чтобы сделать эту операцию реактивной. Смотрим на интерфейс CameraCaptureSession.CaptureCallback.

Опять же, мы хотим различать генерируемые события и для этого создадим enum.

public enum CaptureSessionEvents {

ON_STARTED,

ON_PROGRESSED,

ON_COMPLETED,

ON_SEQUENCE_COMPLETED,

ON_SEQUENCE_ABORTED

}Мы видим, что в методы передаётся достаточно много информации, которую мы хотим иметь в реактивном потоке, в том числе CameraCaptureSession, CaptureRequest, CaptureResult, поэтому просто Pair<> нам уже не подойдёт – создадим POJO:

public static class CaptureSessionData {

final CaptureSessionEvents event;

final CameraCaptureSession session;

final CaptureRequest request;

final CaptureResult result;

CaptureSessionData(CaptureSessionEvents event, CameraCaptureSession session, CaptureRequest request, CaptureResult result) {

this.event = event;

this.session = session;

this.request = request;

this.result = result;

}

}

Создание CameraCaptureSession.CaptureCallback вынесем в отдельный метод.

@NonNull

private static CameraCaptureSession.CaptureCallback createCaptureCallback(final ObservableEmitter observableEmitter) {

return new CameraCaptureSession.CaptureCallback() {

@Override

public void onCaptureStarted(@NonNull CameraCaptureSession session, @NonNull CaptureRequest request, long timestamp, long frameNumber) {

}

@Override

public void onCaptureProgressed(@NonNull CameraCaptureSession session, @NonNull CaptureRequest request, @NonNull CaptureResult partialResult) {

}

@Override

public void onCaptureCompleted(@NonNull CameraCaptureSession session, @NonNull CaptureRequest request, @NonNull TotalCaptureResult result) {

if (!observableEmitter.isDisposed()) {

observableEmitter.onNext(new CaptureSessionData(CaptureSessionEvents.ON_COMPLETED, session, request, result));

}

}

@Override

public void onCaptureFailed(@NonNull CameraCaptureSession session, @NonNull CaptureRequest request, @NonNull CaptureFailure failure) {

if (!observableEmitter.isDisposed()) {

observableEmitter.onError(new CameraCaptureFailedException(failure));

}

}

@Override

public void onCaptureSequenceCompleted(@NonNull CameraCaptureSession session, int sequenceId, long frameNumber) {

}

@Override

public void onCaptureSequenceAborted(@NonNull CameraCaptureSession session, int sequenceId) {

}

};

} Из всех этих сообщений нам интересны onCaptureCompleted/onCaptureFailed, остальные события игнорируем. Если они понадобятся вам в ваших проектах, их несложно добавить.

Теперь всё готово для создания Observable.

static Observable fromSetRepeatingRequest(@NonNull CameraCaptureSession captureSession, @NonNull CaptureRequest request) {

return Observable

.create(observableEmitter -> captureSession.setRepeatingRequest(request, createCaptureCallback(observableEmitter), null));

} capture

На самом деле, этот шаг полностью аналогичен предыдущему, только мы делаем не повторяющийся запрос, а единичный. Для этого воспользуемся методом CameraCaptureSession.capture.

public abstract int capture(@NonNull CaptureRequest request,

@Nullable CaptureCallback listener, @Nullable Handler handler)

throws CameraAccessException;Он принимает точно такие же параметры, так что мы сможем использовать функцию, определённую выше, для создания CaptureCallback.

static Observable fromCapture(@NonNull CameraCaptureSession captureSession, @NonNull CaptureRequest request) {

return Observable

.create(observableEmitter -> captureSession.capture(request, createCaptureCallback(observableEmitter), null));

} Подготовка Surface

Cameara2 API позволяет в запросе передавать список Surface, которые будут использованы для записи данных с устройства. Нам потребуются два Surface:

- для отображения preview на экране,

- для записи снимка в JPEG-файл.

TextureView

Для отображения preview на экране мы воспользуемся TextureView. Для того чтобы получить Surface из TextureView, предлагается воспользоваться методом TextureView.setSurfaceTextureListener.

TextureView уведомит listener, когда Surface будет готов к использованию.

Давайте на этот раз создадим PublishSubject, который будет генерировать события, когда TextureView вызывает методы listener.

private final PublishSubject mOnSurfaceTextureAvailable = PublishSubject.create();

@Override

public void onCreate(@Nullable Bundle saveState){

mTextureView.setSurfaceTextureListener(new TextureView.SurfaceTextureListener(){

@Override

public void onSurfaceTextureAvailable(SurfaceTexture surface,int width,int height){

mOnSurfaceTextureAvailable.onNext(surface);

}

});

...

} Используя PublishSubject, мы избегаем возможных проблем с множественным subscribe. Мы устанавливаем SurfaceTextureListener один раз в onCreate и дальше живём спокойно. PublishSubject позволяет подписываться на него сколько угодно раз и раздает события всем подписавшимся.

При использовании Camera2 API существует тонкость, связанная с невозможностью явно задать размер изображения, – камера сама выбирает одно из поддерживаемых ею разрешений на основании размеров, переданных ей Surface. Поэтому придётся пойти на такой трюк: выясняем список поддерживаемых камерой размеров изображения, выбираем наиболее приглянувшийся и затем устанавливаем размер буфера в точности таким же.

private void setupSurface(@NonNull SurfaceTexture surfaceTexture) {

surfaceTexture.setDefaultBufferSize(mCameraParams.previewSize.getWidth(), mCameraParams.previewSize.getHeight());

mSurface = new Surface(surfaceTexture);

}При этом, если мы хотим видеть изображение с сохранением пропорций, необходимо задать нужные пропорции нашему TextureView. Для этого мы его расширим и переопределим метод onMeasure:

public class AutoFitTextureView extends TextureView {

private int mRatioWidth = 0;

private int mRatioHeight = 0;

...

public void setAspectRatio(int width, int height) {

mRatioWidth = width;

mRatioHeight = height;

requestLayout();

}

@Override

protected void onMeasure(int widthMeasureSpec, int heightMeasureSpec) {

int width = MeasureSpec.getSize(widthMeasureSpec);

int height = MeasureSpec.getSize(heightMeasureSpec);

if (0 == mRatioWidth || 0 == mRatioHeight) {

setMeasuredDimension(width, height);

} else {

if (width < height * mRatioWidth / mRatioHeight) {

setMeasuredDimension(width, width * mRatioHeight / mRatioWidth);

} else {

setMeasuredDimension(height * mRatioWidth / mRatioHeight, height);

}

}

}

}Запись в файл

Для того чтобы сохранить изображение из Surface в файл, воспользуемся классом ImageReader.

Несколько слов о выборе размера для ImageReader. Во-первых, мы должны выбрать его из поддерживаемых камерой. Во-вторых, соотношение сторон должно совпадать с тем, что мы выбрали для preview.

Чтобы мы могли получать уведомления от ImageReader о готовности изображения, воспользуемся методом setOnImageAvailableListener

void setOnImageAvailableListener (ImageReader.OnImageAvailableListener listener, Handler handler)Передаваемый listener реализует всего один метод onImageAvailable.

Каждый раз, когда Camera API будет записывать изображение в Surface, предоставленную нашим ImageReader, он будет вызывать этот колбек.

Сделаем эту операцию реактивной: создадим Observable, который будет генерировать сообщение каждый раз, когда ImageReader будет готов предоставить изображение.

@NonNull

public static Observable createOnImageAvailableObservable(@NonNull ImageReader imageReader) {

return Observable.create(subscriber -> {

ImageReader.OnImageAvailableListener listener = reader -> {

if (!subscriber.isDisposed()) {

subscriber.onNext(reader);

}

};

imageReader.setOnImageAvailableListener(listener, null);

subscriber.setCancellable(() -> imageReader.setOnImageAvailableListener(null, null)); //remove listener on unsubscribe

});

} Обратите внимание, тут мы воспользовались методом ObservableEmitter.setCancellable, чтобы удалять listener, когда от Observable отписываются.

Запись в файл – длительная операция, сделаем её реактивной с помощью метода fromCallable.

@NonNull

public static Single save(@NonNull Image image, @NonNull File file) {

return Single.fromCallable(() -> {

try (FileChannel output = new FileOutputStream(file).getChannel()) {

output.write(image.getPlanes()[0].getBuffer());

return file;

}

finally {

image.close();

}

});

} Теперь мы можем задать такую последовательность действий: когда в ImageReader появляется готовое изображение, мы записываем его в файл в рабочем потоке Schedulers.io(), затем переключаемся в UI thread и уведомляем UI о готовности файла.

private void initImageReader() {

Size sizeForImageReader = CameraStrategy.getStillImageSize(mCameraParams.cameraCharacteristics, mCameraParams.previewSize);

mImageReader = ImageReader.newInstance(sizeForImageReader.getWidth(), sizeForImageReader.getHeight(), ImageFormat.JPEG, 1);

mCompositeDisposable.add(

ImageSaverRxWrapper.createOnImageAvailableObservable(mImageReader)

.observeOn(Schedulers.io())

.flatMap(imageReader -> ImageSaverRxWrapper.save(imageReader.acquireLatestImage(), mFile).toObservable())

.observeOn(AndroidSchedulers.mainThread())

.subscribe(file -> mCallback.onPhotoTaken(file.getAbsolutePath(), getLensFacingPhotoType()))

);

}

Запускаем preview

Итак, мы основательно подготовились. Мы уже можем создавать Observable для основных асинхронных действий, которые требуются для работы приложения. Впереди самое интересное – конфигурирование реактивных потоков.

Для разминки давайте сделаем так, чтобы камера открывалась после того, как SurfaceTexture готов к использованию.

Observable> cameraDeviceObservable = mOnSurfaceTextureAvailable

.firstElement()

.doAfterSuccess(this::setupSurface)

.doAfterSuccess(__ -> initImageReader())

.toObservable()

.flatMap(__ -> CameraRxWrapper.openCamera(mCameraParams.cameraId, mCameraManager))

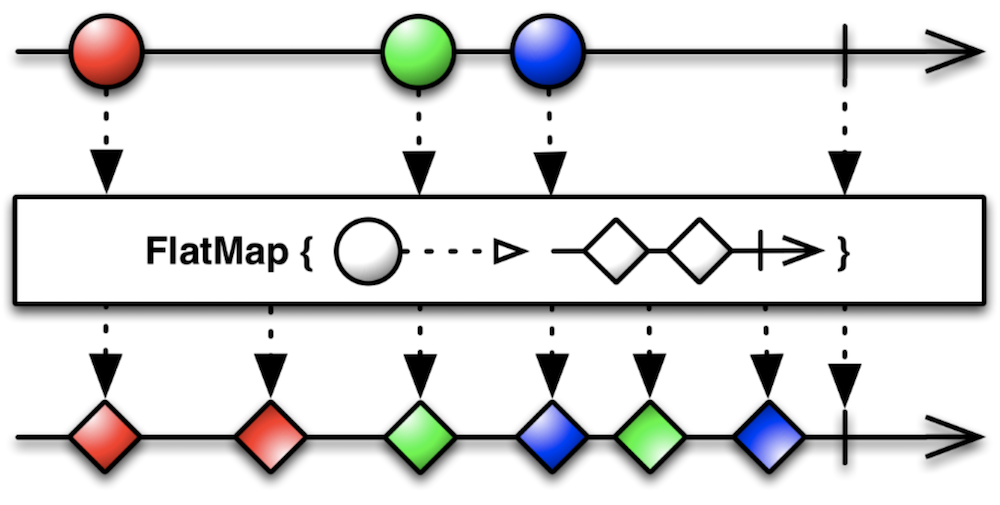

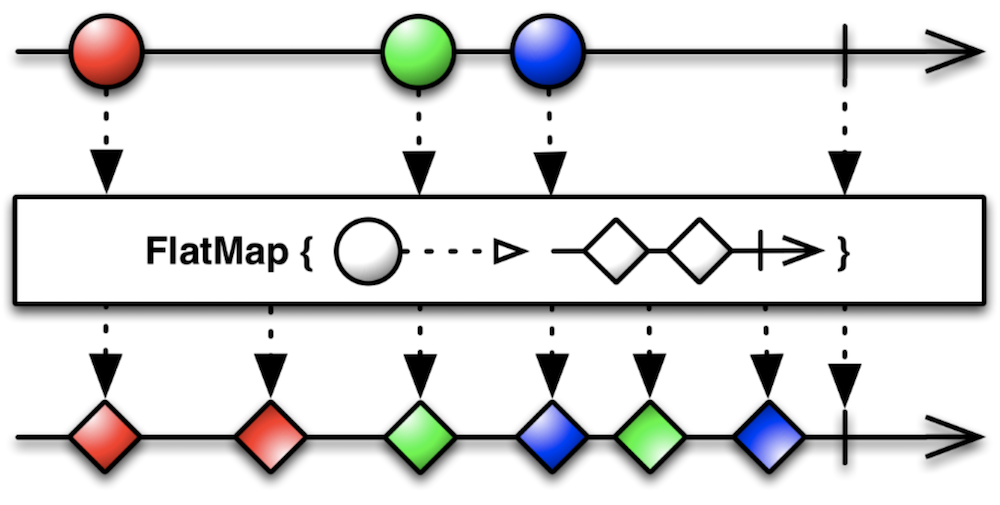

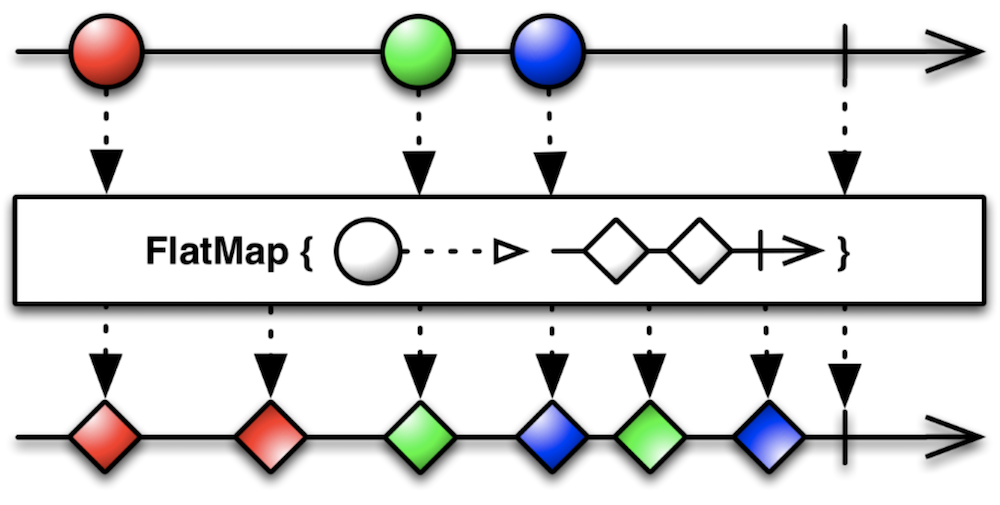

.share();Ключевым оператором здесь выступает flatMap.

В нашем случае при получении события о готовности SurfaceTexture он выполнит функцию openCamera и пустит события от созданного ей Observable дальше в реактивный поток.

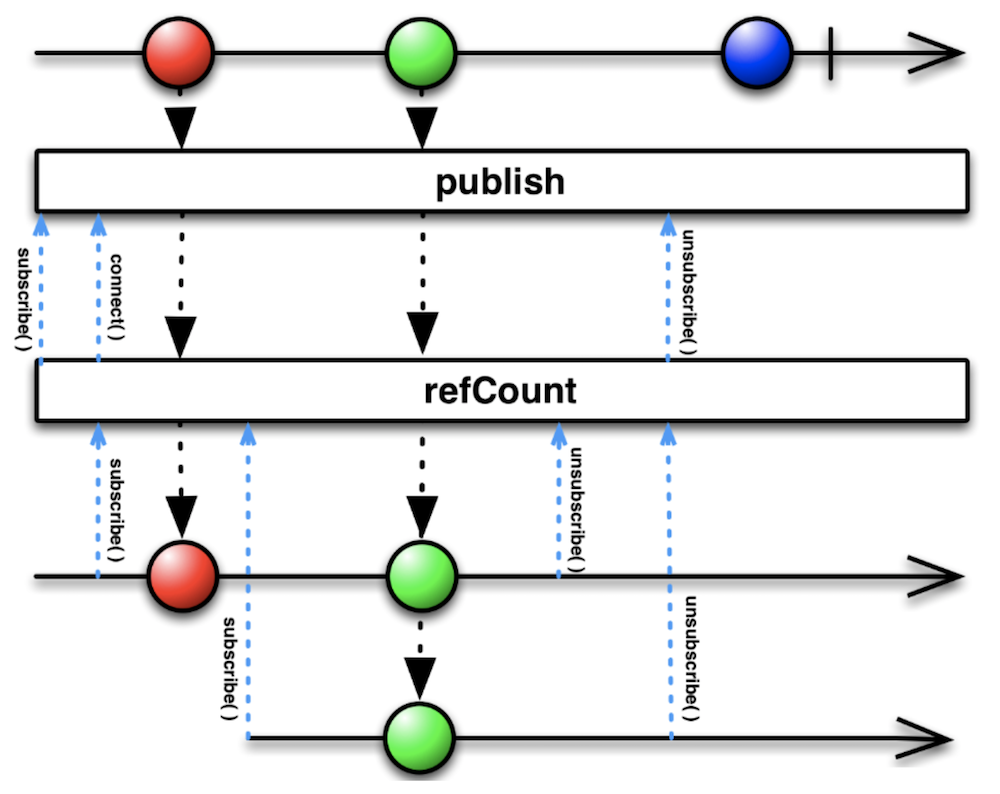

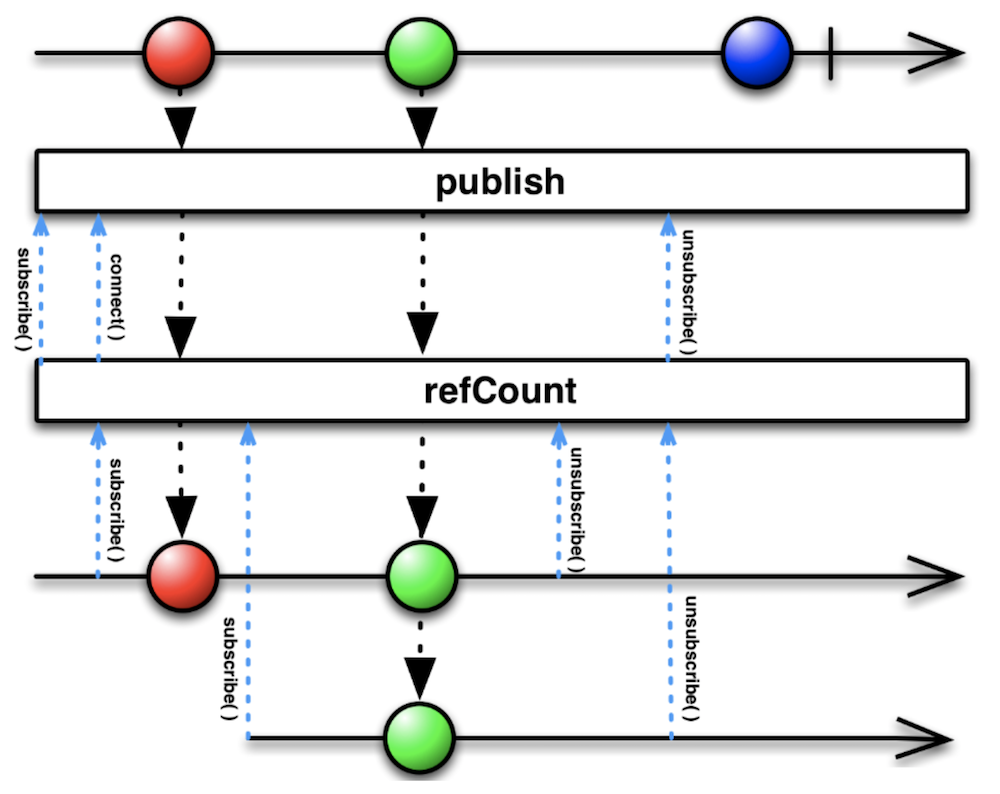

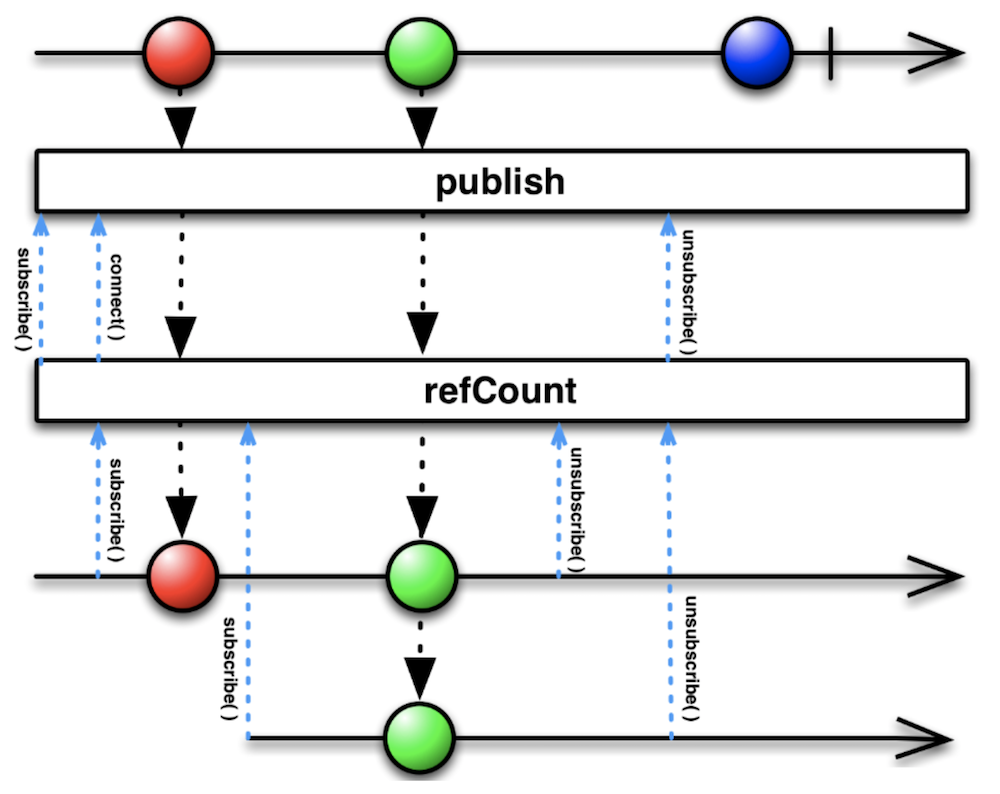

Важно также понять, зачем в конце цепочки используется оператор share. Он эквивалентен цепочке операторов publish().refCount().

Если долго смотреть на эту Marble Diagram, то можно заметить, что результат весьма похож на результат использования PublishSubject. Действительно, мы решаем похожую проблему: если на наш Observable подпишутся несколько раз, мы не хотим каждый раз открывать камеру заново.

Для удобства давайте введём ещё пару Observable.

Observable openCameraObservable = cameraDeviceObservable

.filter(pair -> pair.first == CameraRxWrapper.DeviceStateEvents.ON_OPENED)

.map(pair -> pair.second)

.share();

Observable closeCameraObservable = cameraDeviceObservable

.filter(pair -> pair.first == CameraRxWrapper.DeviceStateEvents.ON_CLOSED)

.map(pair -> pair.second)

.share(); openCameraObservable будет генерировать события, когда камера будет успешно открыта, а closeCameraObservable – когда она будет закрыта.

Сделаем ещё один шаг: после успешного открытия камеры откроем сессию.

Observable> createCaptureSessionObservable = openCameraObservable

.flatMap(cameraDevice -> CameraRxWrapper

.createCaptureSession(cameraDevice, Arrays.asList(mSurface, mImageReader.getSurface()))

)

.share();И по аналогии создадим ещё пару Observable, сигнализирующих об успешном открытии или закрытии сессии.

Observable captureSessionConfiguredObservable = createCaptureSessionObservable

.filter(pair -> pair.first == CameraRxWrapper.CaptureSessionStateEvents.ON_CONFIGURED)

.map(pair -> pair.second)

.share();

Observable captureSessionClosedObservable = createCaptureSessionObservable

.filter(pair -> pair.first == CameraRxWrapper.CaptureSessionStateEvents.ON_CLOSED)

.map(pair -> pair.second)

.share(); Наконец, мы можем задать повторяющийся запрос для отображения preview.

Observable previewObservable = captureSessionConfiguredObservable

.flatMap(cameraCaptureSession -> {

CaptureRequest.Builder previewBuilder = createPreviewBuilder(cameraCaptureSession, mSurface);

return CameraRxWrapper.fromSetRepeatingRequest(cameraCaptureSession, previewBuilder.build());

})

.share(); Теперь достаточно выполнить previewObservable.subscribe() — и на экране появится живая картинка с камеры!

Небольшое отступление. Если схлопнуть все промежуточные Observable, то получится вот такая цепочка операторов:

mOnSurfaceTextureAvailable

.firstElement()

.doAfterSuccess(this::setupSurface)

.toObservable()

.flatMap(__ -> CameraRxWrapper.openCamera(mCameraParams.cameraId, mCameraManager))

.filter(pair -> pair.first == CameraRxWrapper.DeviceStateEvents.ON_OPENED)

.map(pair -> pair.second)

.flatMap(cameraDevice -> CameraRxWrapper

.createCaptureSession(cameraDevice, Arrays.asList(mSurface, mImageReader.getSurface()))

)

.filter(pair -> pair.first == CameraRxWrapper.CaptureSessionStateEvents.ON_CONFIGURED)

.map(pair -> pair.second)

.flatMap(cameraCaptureSession -> {

CaptureRequest.Builder previewBuilder = createPreviewBuilder(cameraCaptureSession, mSurface);

return CameraRxWrapper.fromSetRepeatingRequest(cameraCaptureSession, previewBuilder.build());

})

.subscribe();И этого достаточно для показа preview. Впечатляет, не так ли?

На самом деле, у этого решения есть проблемы с закрытием ресурсов, да и снимки пока делать нельзя. Я привёл его, чтобы была видна цепочка целиком. Все промежуточные Observable понадобятся нам при составлении более сложных сценариев поведения в будущем.

Для того чтобы у нас была возможность отписаться, необходимо сохранять возвращаемое методом subscribe Disposable. Удобнее всего пользоваться CompositeDisposable.

private final CompositeDisposable mCompositeDisposable = new CompositeDisposable();

private void unsubscribe() {

mCompositeDisposable.clear();

}В реальном коде я везде делаю mCompositeDisposable.add(...subscribe()), но сейчас я эти вызовы опускаю, чтобы вам было легче читать.

Как составлять запросы CaptureRequest

Внимательный читатель, конечно, уже заметил, что мы использовали метод createPreviewBuilder, который ещё не описывался. Давайте же посмотрим, что у него внутри.

@NonNull

CaptureRequest.Builder createPreviewBuilder(CameraCaptureSession captureSession, Surface previewSurface) throws CameraAccessException {

CaptureRequest.Builder builder = captureSession.getDevice().createCaptureRequest(CameraDevice.TEMPLATE_PREVIEW);

builder.addTarget(previewSurface);

setup3Auto(builder);

return builder;

}

Здесь мы пользуемся любезно предоставленным нам шаблоном запроса для preview, добавляем в него нашу Surface и говорим, что хотим Auto Focus, Auto Exposure и Auto White Balance (три A). Чтобы этого добиться, достаточно установить несколько флагов.

private void setup3Auto(CaptureRequest.Builder builder) {

// Enable auto-magical 3A run by camera device

builder.set(CaptureRequest.CONTROL_MODE, CaptureRequest.CONTROL_MODE_AUTO);

Float minFocusDist = mCameraParams.cameraCharacteristics.get(CameraCharacteristics.LENS_INFO_MINIMUM_FOCUS_DISTANCE);

// If MINIMUM_FOCUS_DISTANCE is 0, lens is fixed-focus and we need to skip the AF run.

boolean noAFRun = (minFocusDist == null || minFocusDist == 0);

if (!noAFRun) {

// If there is a "continuous picture" mode available, use it, otherwise default to AUTO.

int[] afModes = mCameraParams.cameraCharacteristics.get(CameraCharacteristics.CONTROL_AF_AVAILABLE_MODES);

if (contains(afModes, CaptureRequest.CONTROL_AF_MODE_CONTINUOUS_PICTURE)) {

builder.set(CaptureRequest.CONTROL_AF_MODE, CaptureRequest.CONTROL_AF_MODE_CONTINUOUS_PICTURE);

}

else {

builder.set(CaptureRequest.CONTROL_AF_MODE, CaptureRequest.CONTROL_AF_MODE_AUTO);

}

}

// If there is an auto-magical flash control mode available, use it, otherwise default to

// the "on" mode, which is guaranteed to always be available.

int[] aeModes = mCameraParams.cameraCharacteristics.get(CameraCharacteristics.CONTROL_AE_AVAILABLE_MODES);

if (contains(aeModes, CaptureRequest.CONTROL_AE_MODE_ON_AUTO_FLASH)) {

builder.set(CaptureRequest.CONTROL_AE_MODE, CaptureRequest.CONTROL_AE_MODE_ON_AUTO_FLASH);

}

else {

builder.set(CaptureRequest.CONTROL_AE_MODE, CaptureRequest.CONTROL_AE_MODE_ON);

}

// If there is an auto-magical white balance control mode available, use it.

int[] awbModes = mCameraParams.cameraCharacteristics.get(CameraCharacteristics.CONTROL_AWB_AVAILABLE_MODES);

if (contains(awbModes, CaptureRequest.CONTROL_AWB_MODE_AUTO)) {

// Allow AWB to run auto-magically if this device supports this

builder.set(CaptureRequest.CONTROL_AWB_MODE, CaptureRequest.CONTROL_AWB_MODE_AUTO);

}

}Делаем снимок

Для того чтобы получать события по нажатиям кнопок, можно воспользоваться прекрасной библиотекой RxBinding, но мы сделаем проще.

private final PublishSubject mOnShutterClick = PublishSubject.create();

public void takePhoto() {

mOnShutterClick.onNext(this);

}Теперь набросаем план действий. Прежде всего мы хотим делать снимок тогда, когда уже начался preview (это значит, что всё готово для снимка). Для этого воспользуемся оператором combineLatest.

Observable.combineLatest(previewObservable, mOnShutterClick, (captureSessionData, o) -> captureSessionData)Но он будет генерировать события постоянно при получении свежих событий от previewObservable, поэтому ограничимся первым событием.

.firstElement().toObservable()Дождёмся, пока сработают автофокус и автоэкспозиция.

.flatMap(this::waitForAf)

.flatMap(this::waitForAe)И, наконец, сделаем снимок.

.flatMap(captureSessionData -> captureStillPicture(captureSessionData.session))Цепочка операторов целиком выглядит так:

Observable.combineLatest(previewObservable, mOnShutterClick, (captureSessionData, o) -> captureSessionData)

.firstElement().toObservable()

.flatMap(this::waitForAf)

.flatMap(this::waitForAe)

.flatMap(captureSessionData -> captureStillPicture(captureSessionData.session))

.subscribe(__ -> {

}, this::onError)Посмотрим, что внутри captureStillPicture.

@NonNull

private Observable captureStillPicture(@NonNull CameraCaptureSession cameraCaptureSession) {

return Observable

.fromCallable(() -> createStillPictureBuilder(cameraCaptureSession.getDevice()))

.flatMap(builder -> CameraRxWrapper.fromCapture(cameraCaptureSession, builder.build()));

} Здесь нам всё уже довольно знакомо: создаём запрос, запускаем capture – и ждём результат. Запрос конструируется из шаблона STILL_PICTURE, в него добавляется Surface для записи в файл, а также несколько волшебных флагов, сообщающих камере, что это ответственный запрос для сохранения изображения. Также задаётся информация о том, как ориентировать изображение в JPEG.

@NonNull

private CaptureRequest.Builder createStillPictureBuilder(@NonNull CameraDevice cameraDevice) throws CameraAccessException {

final CaptureRequest.Builder builder;

builder = cameraDevice.createCaptureRequest(CameraDevice.TEMPLATE_STILL_CAPTURE);

builder.set(CaptureRequest.CONTROL_CAPTURE_INTENT, CaptureRequest.CONTROL_CAPTURE_INTENT_STILL_CAPTURE);

builder.set(CaptureRequest.CONTROL_AE_PRECAPTURE_TRIGGER, CameraMetadata.CONTROL_AE_PRECAPTURE_TRIGGER_IDLE);

builder.addTarget(mImageReader.getSurface());

setup3Auto(builder);

int rotation = mWindowManager.getDefaultDisplay().getRotation();

builder.set(CaptureRequest.JPEG_ORIENTATION, CameraOrientationHelper.getJpegOrientation(mCameraParams.cameraCharacteristics, rotation));

return builder;

}Закрываем ресурсы

Хорошие приложения всегда закрывают ресурсы, особенно такие дорогие, как камера. Давайте тоже по событию onPause будем всё закрывать.

Observable.combineLatest(previewObservable, mOnPauseSubject, (state, o) -> state)

.firstElement().toObservable()

.doOnNext(captureSessionData -> captureSessionData.session.close())

.flatMap(__ -> captureSessionClosedObservable)

.doOnNext(cameraCaptureSession -> cameraCaptureSession.getDevice().close())

.flatMap(__ -> closeCameraObservable)

.doOnNext(__ -> closeImageReader())

.subscribe(__ -> unsubscribe(), this::onError);Здесь мы поочерёдно закрываем сессию и устройство, дожидаясь подтверждения от API.

Выводы

Мы создали приложение, которое умеет показывать живую картинку preview и делать снимки. То есть получили вполне рабочее приложение камеры. Нераскрытыми остались вопросы ожидания срабатывания автофокуса и автовыбора экспозиции и выбора ориентации файла. Ответы на них обязательно появятся в следующей части.

С появлением RxJava разработчики получили в свои руки могучий инструмент по обузданию асинхронных API. Используя его грамотно, можно избежать Callback Hell и получить чистый, легко читаемый и расширяемый код. Делитесь вашими мыслями в комментариях!

|

Метки: author ArkadyGamza разработка под android разработка мобильных приложений блог компании badoo java rxjava2 android camera2 api |

Побеждаем Android Camera2 API с помощью RxJava2 (часть 1) |

Как известно, RxJava идеально подходит для решения двух задач: обработки потоков событий и работы с асинхронными методами. В одном из предыдущих постов я показал, как можно построить цепочку операторов, обрабатывающую поток событий от сенсора. А сегодня я хочу продемонстрировать, как RxJava применяется для работы с существенно асинхронным API. В качестве такого API я выбрал Camera2 API.

Ниже будет показан пример использования Camera2 API, который пока довольно слабо задокументирован и изучен сообществом. Для его укрощения будет использована RxJava2. Вторая версия этой популярной библиотеки вышла сравнительно недавно, и примеров на ней тоже немного.

Для кого этот пост? Я рассчитываю, что читатель – умудрённый опытом, но всё ещё любознательный Android-разработчик. Очень желательны базовые знания о реактивном программировании (хорошее введение – здесь) и понимание Marble Diagrams. Пост будет полезен тем, кто хочет проникнуться реактивным подходом, а также тем, кто хочет использовать Camera2 API в своих проектах. Предупреждаю, будет много кода!

Исходники проекта можно найти на GitHub.

Подготовка проекта

Добавим сторонние зависимости в наш проект.

Retrolambda

При работе с RxJava совершенно необходима поддержка лямбд – иначе код будет выглядеть просто ужасно. Так что если вы ещё не перешли на Android Studio 3.0, добавим Retrolambda в наш проект.

buildscript {

dependencies {

classpath 'me.tatarka:gradle-retrolambda:3.6.0'

}

}

apply plugin: 'me.tatarka.retrolambda'Теперь можно поднять версию языка до 8, что обеспечит поддержку лямбд.

android {

compileOptions {

sourceCompatibility JavaVersion.VERSION_1_8

targetCompatibility JavaVersion.VERSION_1_8

}

}Полные инструкции.

RxJava2

compile "io.reactivex.rxjava2:rxjava:2.1.0"Актуальную версию, полные инструкции и документацию ищите тут.

RxAndroid

Полезная библиотека при использовании RxJava на Android. В основном используется ради AndroidSchedulers. Репозиторий.

compile 'io.reactivex.rxjava2:rxandroid:2.0.1'Camera2 API

В своё время я участвовал в code review модуля, написанного с использованием Camera1 API, и был неприятно удивлён неизбежными в силу дизайна API concurrency issues. Видимо, в Google тоже осознали проблему и задепрекейтили первую версию API. Взамен предлагается использовать Camera2 API. Вторая версия доступна на Android Lollipop и новее.

Давайте же на него посмотрим.

Первые впечатления

Google проделал хорошую работу над ошибками в плане организации потоков. Все операции выполняются асинхронно, уведомляя о результатах через колбеки. Причём, передавая соответствующий Handler, можно выбрать поток, в котором будут вызываться методы колбеков.

Референсная имплементация

Google предлагает пример приложения Camera2Basic.

Это довольно наивная реализация, но помогает начать разбираться с API. Посмотрим, сможем ли мы сделать более изящное решение, используя реактивный подход.

Шаги для получения снимка

Если кратко, то последовательность действий для получения снимка такова:

- выбрать устройство,

- открыть устройство,

- открыть сессию,

- запустить превью,

- по нажатию на кнопку сделать снимок,

- закрыть сессию,

- закрыть устройство.

Выбор устройства

Прежде всего нам понадобится CameraManager.

mCameraManager = (CameraManager) mContext.getSystemService(Context.CAMERA_SERVICE);Этот класс позволяет получать информацию о существующих в системе камерах и подключаться к ним. Камер может быть несколько, в смартфонах обычно их две: фронтальная и тыловая.

Получаем список камер.

String[] cameraIdList = mCameraManager.getCameraIdList();Вот так сурово – просто список строковых айдишников.

Теперь получим список характеристик для каждой камеры.

for (String cameraId : cameraIdList) {

CameraCharacteristics characteristics = mCameraManager.getCameraCharacteristics(cameraId);

...

}CameraCharacteristics содержит огромное количество ключей, по которым можно получать информацию о камере.

Чаще всего на этапе выбора камеры смотрят на то, куда направлена камера. Для этого необходимо получить значение по ключу CameraCharacteristics.LENS_FACING.

Integer facing = characteristics.get(CameraCharacteristics.LENS_FACING);Камера может быть фронтальной (CameraCharacteristics.LENS_FACING_FRONT), тыловой (CameraCharacteristics.LENS_FACING_BACK) или подключаемой (CameraCharacteristics.LENS_FACING_EXTERNAL).

Функция выбора камеры с предпочтением по ориентации может выглядеть примерно так:

@Nullable