Случайные эволюционные стратегии в машинном обучении |

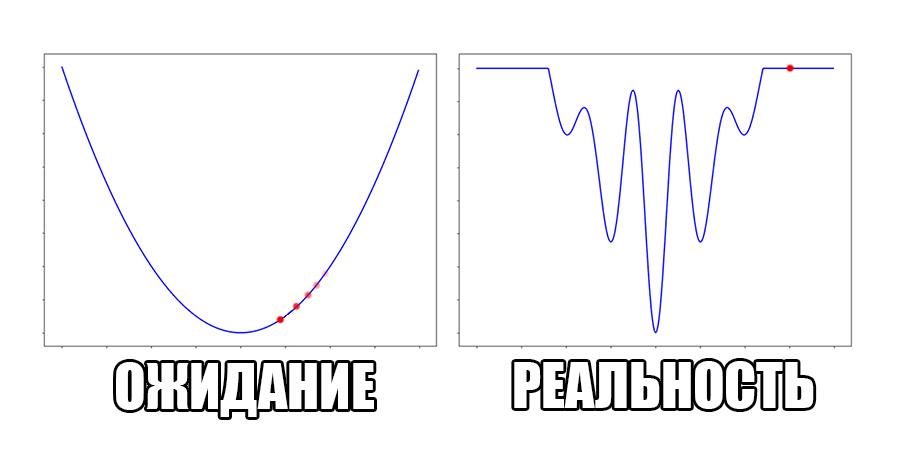

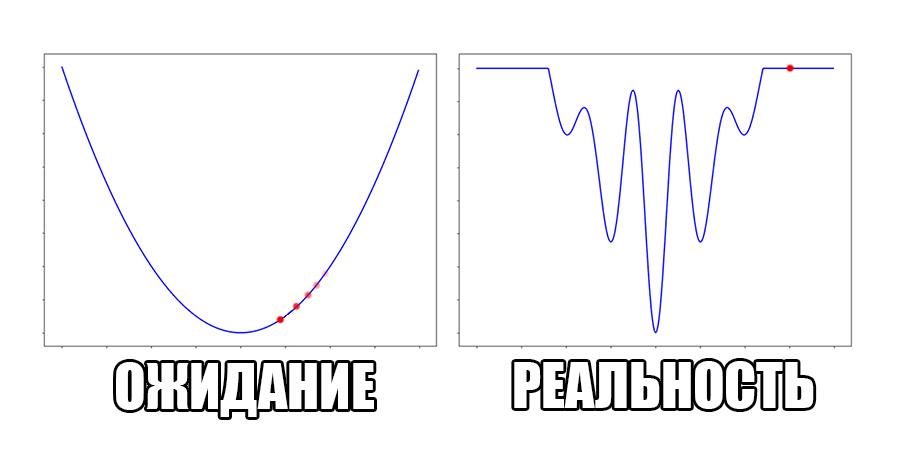

Нейронные сети учатся совсем не так как люди. Оптимизация нейронной сети — на самом деле градиентный спуск по некоторой функции потерь , где переменными являются веса слоёв . Это очень мощный подход к подстройке системы, который применяется также в физике, экономике и многих других областях. На данный момент предложено немало конкретных методов градиентного спуска, но все они предполагают, что градиент хорошо себя ведёт: нет обрывов, где он скачкообразно возрастает, или плато, где он обращается в ноль. С первой проблемой можно разобраться при помощи gradient clipping, но вторая заставляет тщательно подумать. Кусочно-линейную или дискретную функцию нетривиально ограничить более приятной функцией

Как поступать в таких ситуациях?

Под катом много формул и гифок.

Читать дальше →

- во многих областях reinforcement learning (далее RL)

- в VAE с дискретными латентными переменными

- в GAN с дискретными генераторами

Как поступать в таких ситуациях?

Под катом много формул и гифок.

Читать дальше →

| Комментировать | « Пред. запись — К дневнику — След. запись » | Страницы: [1] [Новые] |