Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/new/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-new-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Продвинутое конфигурирование Docker Compose (перевод) |

Продвинутое конфигурирование Docker Compose (перевод)

Контроль порядка запуска

Docker Compose запускает контейнеры в порядке зависимостей, используя опцию depends_on, чтобы указывать, когда запускается сервис. Для определения порядка запуска Compose применяет depends_on, links, volumes_from и network_mode: «service: ...».

Если контейнер должен дождаться состояния “ready” другого контейнера, можно использовать инструменты wait-for-it или dockerize. Они будут проверять хосты и порты до тех пор, пока TCP соединение не будет подтверждено. Для включения принудительного ожидания в композицию необходимо добавить entrypoint:

version: '2'

services:

web:

build: .

ports:

- "80:8000"

depends_on:

- db

entrypoint: "./wait-for-it.sh db:5432"

db:

image: postgresВы всегда можете самостоятельно написать скрипт-обёртку, если возникнет необходимость в усилении контроля.

Запуск нескольких копий Compose проекта

Если вам понадобится несколько копий окружений с одинаковой композицией (или docker-compose.yml файлом), просто запустите docker-compose up -p new_project_name.

Переменные среды

Переменные среды оболочки могут быть использованы для установки значений в композициях:

Установить переменные среды:

$ TAG="latest"

$ echo $TAG

latest

$ DB="postgres"

$ echo $DB

postgresИспользовать переменную среды в Docker Compose файле:

db:

image: "${DB}:$TAG"Docker Compose принимает и ${DB}, и $TAG. Также можно задать переменные среды в контейнерах:

web:

environment:

- PRODUCTION=1Можно даже передать переменные среды внутрь контейнеров:

$ PRODUCTION=1

$ echo $PRODUCTION

1Файл окружения

Для гарантии передачи переменной среды, необходимо хранить её в файле среды. Назовите файл .env и сохраните в рабочей директории. Docker Compose игнорирует пустые строки (используйте их для лучшей читаемости) и код, начинающийся с # (то есть комментарии). Вы можете присвоить переменные для дальнейшей подстановки, а также задать переменные Compose CLI:

COMPOSE_API_VERSION

COMPOSE_FILE

COMPOSE_HTTP_TIMEOUT

COMPOSE_PROJECT_NAME

DOCKER_CERT_PATH

DOCKER_HOST

DOCKER_TLS_VERIFYПример файла среды:

# ./.env

# для нашей промежуточной среды

COMPOSE_API_VERSION=2

COMPOSE_HTTP_TIMEOUT=45

DOCKER_CERT_PATH=/mycerts/docker.crt

EXTERNAL_PORT=5000Использование нескольких файлов Docker Compose

Используйте несколько файлов Docker Compose, если необходимо изменять приложение под разные среды (разработка, промежуточная среда и продакшн) или запускать задачи администрирования через Compose приложение. Это предоставляет способ совместного использования общих конфигов.

Docker Compose по умолчанию читает два файла: docker-compose.yml и docker-compose.override.yml. В файле docker-compose-override.yml можно хранить переопределения для существующих сервисов или определять новые. Чтобы использовать несколько файлов (или файл переопределения с другим именем), необходимо передать -f в docker-compose up (порядок имеет значение):

$ docker-compose up -f my-override-1.yml my-overide-2.ymlКогда две опции конфигурации совпадают, новое значение заменяет или расширяет первоначальное.

В этом примере новое значение переписывает старое и command запускает my_new_app.py:

# оригинальный сервис

command: python my_app.py

# новый сервис

command: python my_new_app.py

При использовании опции с несколькими значениями (ports, expose, external_links, dns, dns_search и tmpfs), Docker Compose объединяет значения (в примере ниже Compose открывает порты 5000 и 8000):

# оригинальный сервис

expose:

- 5000

# новый сервис

expose:

- 8000Если используются environment, labels, volumes, или devices, Docker Compose объединяет результаты. В следующем примере три переменные среды становятся FOO=Hello и BAR=«Python Dev!»:

# оригинальный сервис

environment:

- FOO=Hello

- BAR=World

# новый сервис

environment:

- BAR="Python Dev!"

Различные среды

Начнём с базового Docker Compose файла для приложения (docker-compose.yml):

web:

image: "my_dockpy/my_django_app:latest"

links:

- db

- cache

db:

image: "postgres:latest"

cache:

image: "redis:latest"

На сервере разработки мы хотим открыть порты, смонтировать код как том и создать веб-изображение (docker-compose.override.yml):

web:

build: .

volumes:

- ".:/code"

ports:

- "8883:80"

environment:

DEBUG: "true"

db:

command: "-d"

ports:

- "5432:5432"

cache:

ports:

- "6379:6379"docker-compose up автоматически читает файл переопределения и применяет его. Также понадобится продакшн версия Docker Compose приложения, которую назовём docker-compose.production.yml:

web:

ports:

- "80:80"

environment:

PRODUCTION: "true"

cache:

environment:

TTL: "500"

Когда понадобится развернуть продакшн файл, просто запустим следующее:

$ docker-compose -f docker-compose.yml -f docker-compose.production.yml up -dПримечание: Docker Compose читает docker-compose.production.yml, но не docker-compose.override.yml.

Задачи администрирования

Необходимо запустить административную копию приложения, чтобы иметь возможность выполнять определённые задачи, например, бэкапить базу данных. Используя уже упомянутый файл docker-compose.yml, создадим файл docker-compose.admin.yml:

dbadmin:

build: database_admin/

links:

- dbА затем, выполним следующую команду:

$ docker-compose -f docker-compose.yml -f docker-compose.admin.yml run dbadmin db-backupРасширение сервисов

Совместно использовать конфигурации можно с помощью поля extends. Также оно позволяет делиться опциями между разными проектами.

Создать common-services.yml (можно назвать его как угодно):

webapp:

build: .

ports:

- "8000:8000"

volumes:

- "/data"Создать базовый docker-compose.yml. Например:

web:

extends:

file: common-services.yml

service: webappКроме этого, определить (или переопределить) конфигурацию и добавить другие сервисы можно локально:

web:

extends:

file: common-services.yml

service: webapp

environment:

- DEBUG=1

cpu_shares: 5

links:

- db

important_web:

extends: web

cpu_shares: 10

db:

image: postgres

Распространённые проблемы

Контроль порядка запуска

Docker Compose ждёт только запуска контейнера перед тем, как перейти к следующему. В случае, если одна часть приложения становится недоступна, Docker Compose рассчитывает на гибкость оставшейся части приложения.

Файл окружения

Если вы определяете переменные среды в оболочке или через командную строку во время работы docker-compose, эти переменные будут иметь приоритет над .env файлом.

Не стоит хранить переменные среды в системе контроля версии. Если вы используете файл среды, добавьте его в локальный файл игнорирования и создайте образец env.sample, похожий на следующий пример (если предполагается, что используется файл .env, описанный выше):

COMPOSE_API_VERSION= # должно быть 2

COMPOSE_HTTP_TIMEOUT= # мы используем 30 на продакшне и 120 в разработке

DOCKER_CERT_PATH= # храните путь сертификации здесь

EXTERNAL_PORT= # установите внешний порт здесь (запомните, 5000 для Flask и 8000 для Django)Использование нескольких файлов Docker Compose

Обратите внимание, Docker Compose объединяет файлы в заданном вами порядке.

Расширение сервисов

Сервисы никогда не делят links, volumes_from или depends_on, используя extends; links и volumes_from всегда должны быть определены локально.

The end

С вопросами, предложениями и замечаниями — welcome в комментарии. А если хочется похоливарить в режиме реального времени — присоединяйтесь к нам на Дне открытых дверей курса.

|

Метки: author Tully серверное администрирование виртуализация devops *nix блог компании отус otus docker-compose |

Oracle фактически ликвидирует Sun |

Oracle фактически ликвидирует Sun

Избегайте этой ловушки, не следует придавать антропоморфные черты Ларри Эллисону.

Брайэн Кантрилл

Похоже, что в Oracle приняли решение окончательно избавиться от трудовых ресурсов, составляющих костяк Sun Microsystems. Массовые увольнения затронули около 2500 сотрудников, работающих над операционной системой Solaris, платформой SPARC и системами хранения данных ZFS Storage Appliance.

Это не рядовая трансформация — оптимизация, а настоящая бойня. По мнению создателя системы динамической отладки Dtrace Брайэна Кантрилла (Bryan Cantrill) на сей раз нанесен непоправимый ущерб, в результате потери 90% производственных кадров подразделения Solaris, включая все руководство.

От Solaris до illumos

В 2009 г. Oracle приобрел испытывающую серьезнейшие трудности на рынке Sun Microsystems за 5.6 млрд. долларов США. Компания теряла позиции на рынке вследствие лавинообразного распространения Linux в качестве серверной ОС, успеха платформы amd64 и невнятной стратегии по взаимоотношениям с сообществом открытого ПО. Solaris стал открытым слишком поздно — лишь в 2005 г., причем открытым не полностью, отдельные элементы ОС, такие как локализация и некоторые драйвера, оставались проприетарными. Затем появился OpenSolaris, однако точкой сбора сообщества он не сумел стать. То ли дело была в лицензии CDDL, то ли проблема была в том, что Sun пыталась манипулировать проектом. Трудно сказать почему именно, но не взлетел.

Kicked butt, had fun, didn't cheat, loved our customers, changed computing forever. Scott McNealy

Эпитафия Скота МакНили как нельзя лучше отражает жизненный путь компании — отлично развлекались, не дурили головы своим заказчикам и навсегда изменили ИТ. Довольно быстро стало очевидно, что Solaris Ораклу попросту не нужен, и развивать его он не намерен. Затем 13 августе 2010 г. случилось одно из самых позорных событий в истории открытого ПО — компания втихую закрыла исходный код OS Solaris. Никаких официальных заявлений на сей счет не последовало.

We will distribute updates to approved CDDL or other open source-licensed code following full releases of our enterprise Solaris operating system. In this manner, new technology innovations will show up in our releases before anywhere else. We will no longer distribute source code for the entirety of the Solaris operating system in real-time while it is developed, on a nightly basis.

Это всего лишь отрывок из внутреннего циркуляра для сотрудников компании, который естественно сразу же просочился в прессу. Тут речь идет о том, что исходный код будут выкладывать только во время релиза новой версии ОС, а обновления будут только бинарными. Но это оказалось неправдой, после выхода Solaris 11 исходный код не выложили.

Для тех, кто владеет английским очень рекомендую посмотреть выступление Брайэна Кантрилла на конференции Usenix. Эпиграф к статье — одна из его цитат, вот еще несколько.

О принципах руководства компании. Оставшись без мудрого руководства манагеров инженеры выдали гору инноваций: ZFS, DTrace, Zones и много других.

Sun управлялась со стороны враждующих группировок во главе с атаманами, как Сомали.

О закрытии исходного кода OpenSolaris.

Это ОТВРАТИТЕЛЬНАЯ выходка со стороны корпорации. Вот из-за такого поведения мы становимся циничными и подозрительными.

О последствиях закрытия исходников OpenSolaris для нового проекта ОС illumos — полностью открытого форка OpenSolaris.

Мы готовимся к моменту Судного Дня в лицензиях открытого исходного кода, у нас есть такие сценарии, они работают и это здорово.

Вскоре после этого из Oracle ушли все разработчики DTrace, создатели ZFS, команда zones и сетевики. Вся разработка и инновация на этих направлениях далее происходила операционной системе illumos, где осела диаспора программистов из Sun Solaris. Благодаря особенностям открытых лицензий, в том числе CDDL, в рамках которой шла разработка OpenSolaris, Oracle не может претендовать на все последующие улучшения в коде illumos. То есть может, но только в рамках своего же проекта с открытым кодом. Сценарии Судного Дня работают как надо.

Для полноты картины стоит добавить, что Oracle активно участвует в разработке ядра Linux, где традиционно входит в десятку наиболее активных компаний.

Факты россыпью

- Главная цель: выдоить патентные отчисления и штрафы у Google за использование Java в ОС Андроид, ставки были крупные — $8 млрд. Не срослось.

- В целом монетизация Java не удалась, Oracle передает

NetBeansApache Foundation, верное решение. - Также решено не запускать платформу Sun Cloud.

- Из-за бюрократических проволочек вокруг заплаток безопасности для MySQL, появился форк MariaDB, куда перешло значительное число разработчиков и часть сообщества. Их оказалось достаточно для новой компании.

Выводы

Sun Microsystems еще недавно — живая легенда и лучшее, что когда-либо было в Unix. Вот лишь небольшая часть их наследия.

- NFS

- RPC

- ZFS

- DTrace

- Zones

- Fault Management Architecture

- Service Management Facility

Компания Oracle имела все возможности для того, чтобы развивать и поддерживать OpenSolaris, но вместо этого закрыла исходники и с тех пор Solaris уже не имел будущего. Когда тяжба с компанией Google за использования Java в мобильной ОС Андроид закончилась пшиком в Oracle потеряли к активам Sun Microsystems всякий интерес. Вместо этого компания будет продавать ПО на основе собственной операционной системы — Unbreakable Linux.

Материалы по теме

|

Метки: author temujin управление сообществом управление разработкой управление проектами oracle sun microsystems solaris opensolaris illumos |

Микросервисы — MIF на C++ |

Микросервисы — MIF на C++

Около трех лет назад у меня была идея создания небольшого каркаса для разработки небольших сервисов, которые могли бы как-то взаимодействовать между собой, предоставлять API во вне, работать с базами данных и кое-что по мелочи еще. Во время решения некоторых рабочих задач, окончательно сформировалась идея своего проекта, близкого к решению рабочих задач. Примерно год назад все это сформировалось в проект MIF (MetaInfo Framework). Предполагалось, что с его помощью можно будет решать такие задачи, как:

Около трех лет назад у меня была идея создания небольшого каркаса для разработки небольших сервисов, которые могли бы как-то взаимодействовать между собой, предоставлять API во вне, работать с базами данных и кое-что по мелочи еще. Во время решения некоторых рабочих задач, окончательно сформировалась идея своего проекта, близкого к решению рабочих задач. Примерно год назад все это сформировалось в проект MIF (MetaInfo Framework). Предполагалось, что с его помощью можно будет решать такие задачи, как:- Разработка легковесных HTTP сервисов

- Коммуникация микросервисов через передаваемые между процессами интерфейсы

- Сериализация и десериализация на базе рефлексии структур данных в разные форматы

- Работа с базами данных

- Некоторые вспомогательные компоненты для создания каркасов сервисов

Все это ориентировано на разработку backend сервисов для веба, но может использоваться и в других системах.

Введение

Выход нового стандарта C++, подготовка следующего. Проходят года, а рефлексии в C++ нет. Обсуждалась возможность появления рефлексии в C++, и казалось, что в очередной стандарт она будет включена. Нет… Может быть рефлексия и не нужна? Может быть… Но есть задачи, где она могла бы быть полезна: межпроцессное взаимодействие (IPC, RPC, REST API, микросервисы), работа с базами данных (ORM), различные (де)сериализаторы и т.д. — в общем есть пространство для применения.

Компилятор имеет всю информацию о типах, и почему бы ему не поделиться ей с разработчиками? Попробую предположить, что всего лишь нет документа, по которому разработчики компиляторов должны отпускать честным разработчикам прочего программного обеспечения эту информацию. Такой документ — это стандарт C++, в котором никак не появится регламент «отоваривания».

Во многих языках рефлексия есть. C++ считается языком для разработки программ, где важна производительность и, казалось бы, одна из его сфер применения — это веб-разработка. Разработка backend сервисов. В этой отрасли есть и REST API, и ORM и всевозможная сериализация во что угодно (часто угодно в json). Для решения этих задач приходится использовать готовые библиотеки или писать свои, в которых данные C++ связываются вручную с другими сущностями, например, отображение структур в C++ в формат json. Иногда с помощью макросов добавляется метаинформация о типе, которая используется в дальнейшем при построении REST API, ORM и т.д. Есть даже решения с плагинами для компилятора, например, odb.

Хотелось бы иметь что-то более естественное, без кодогенерации внешними утилитами, нагромождения макросов и шаблонов или ручного «мапинга». Этого пока нет и для решения приведенных задач нужно выбирать какой-то из приведенных подходов.

Предлагаемое решение основано на добавлении метаинформации к C++ типам с последующим ее использованием при решении разных задач. Можно сказать, что «тип нужно обуть в метаинформацию о нем» после чего он сможет смело шагать через границы процессов и датацентров и иметь возможность представляться по разному (binary, json, xml, text, etc) с минимальным вмешательством разработчика.

Часто подобные задачи решаются с применением кодогенерации, например, thrift, gSOAP, protobuf и т.д. Мне хотелось получить свое решение, которое исключит внешнюю кодогенерацию, а все необходимое будет добавлено к типу в момент компиляции, и при этом есть желание максимально сохранить естественный синтаксис языка C++, не создавая новый язык в существующем языке.

MIF в примерах

Хотелось бы показать некоторые возможности проекта MIF. А по обратной связи на пост, возможно, подготовлю и пост о реализации со всеми ее занудствами, тонкостями и объяснениями почему было выбрано то или иное решение.

Перечисленные в начале поста задачи предполагают, что будет какая-то возможность отображать C++ типы данных для сериализации, объектно-ориентированного межпроцессного взаимодействия, реализации REST API и т.д. С этого предлагаю и начать…

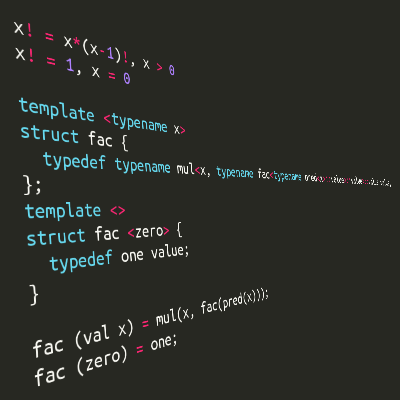

Рефлексия

Рефлексия — основа всего проекта, позволяющая решать мои прикладные задачи.

Пример, как можно получить название C++ структуры данных, количество ее полей и обратиться к одному из полей по его номеру.

struct Data

{

int field1 = 0;

std::string field2;

};

Решение поставленной задачи могло выглядеть так:

int main()

{

Data data;

data.field1 = 100500;

data.field2 = "Text";

using Meta = Mif::Reflection::Reflect;

std::cout << "Struct name: " << Meta::Name::GetString() << std::endl;

std::cout << "Field count: " << Meta::Fields::Count << std::endl;

std::cout << "Field1 value: " << data.field1 << std::endl;

std::cout << "Field2 value: " << data.field2 << std::endl;

std::cout << "Modify fields." << std::endl;

data.*Meta::Fields::Field<0>::Access() = 500100;

data.*Meta::Fields::Field<1>::Access() = "New Text.";

std::cout << "Field1 value: " << data.field1 << std::endl;

std::cout << "Field2 value: " << data.field2 << std::endl;

return 0;

}

Все примерно так бы и было, немного по другому записано, но стандарт не дает возможности так просто отображать C++ типы данных. А чтобы приведенный код работал, нужно добавить к структуре Data метаинформацию

MIF_REFLECT_BEGIN(Data)

MIF_REFLECT_FIELD(field1)

MIF_REFLECT_FIELD(field2)

MIF_REFLECT_END()

MIF_REGISTER_REFLECTED_TYPE(Data)

Метаинформацию о типе можно было бы добавить и в сам тип, расширив его. От такого решения хотелось отказаться чтобы иметь возможность отображать типы, вмешиваться в код которых нет возможности (типы сторонних библиотек). Несколько макросов позволяют добавить всю нужную для дальнейшей работы информацию. Так же есть возможность наследования, но об этом позже …

// STD

#include

#include

// MIF

#include Немного усложненный пример: попробовать написать обобщенный код вывода на консоль всех полей структуры и ее базовых структур.

// STD

#include

#include Результат

Struct name: Base1

field1 = 1

field2 = true

Struct name: Base2

field3 = Text

Struct name: Data

field4 = 100

field5 = String

field6 = key1

Struct name: Nested

field = 100

key2

Struct name: Nested

field = 200

Пример является прототипом для полноценного сериализатора, т.к. на основе добавленной метаинформации сериализует структуру в поток (в примере в стандартный поток вывода). Для определения является ли тип контейнером используется функция из пространства имен Serialization. В этом пространстве имен собраны готовые сериализаторы в json и boost.archives (xml, text, binary). Построены они по принципу близкому к приведенному в примере. Если нет необходимости расширить фреймворк своим сериализатором, то писать подобный код нет необходимости.

Вместо использования класса Printer можно воспользоваться готовым сериализатором, например, в json, и количество кода сильно сократится.

#include {

"Base1" :

{

"field1" : 1,

"field2" : true

},

"Base2" :

{

"field3" : "Text"

},

"field4" : 100,

"field5" : "String",

"field6" :

[

{

"id" : "key1",

"val" :

{

"field" : 100

}

},

{

"id" : "key2",

"val" :

{

"field" : 200

}

}

]

}

Для разнообразия можно попробовать воспользоваться сериализацией boost.archives в формате xml.

// BOOST

#include

1

1

Text

100

String

2

0

-

key1

100

-

key2

200

Из примера видно, что кроме вызова конкретного сериализатора ничего не меняется. Используется одна и та же метаинфомация. Она же будет использоваться и в других местах при реализации межпроцессного взаимодействия.

Сериализации и десериализаторы нескольких форматов реализованы в каркасе. А при необходимости добавить поддержку нового формата можно сделать на примере класса Printer или взяв за основу (де)сериализатор формата json, используя предложенное API для обхода C++ структур данных. Есть некоторые ограничения на типы (куда же без них), но об этом позже.

Далее предлагаю перейти к более интересным вещам — реализации межпроцессного взаимодействия на базе передаваемых между процессами интерфейсов (C++ структур данных с чисто виртуальными методами).

Межпроцессное взаимодействие

С чего начинался проект MIF — это реализация межпроцессного взаимодействия. В ней была первоочередная потребность. На одной из первых реализаций этого механизма был разработан один из сервисов, который на момент написания этих строк поста отработал стабильно более полугода без падений и перезагрузок.

Имелась потребность сделать коммуникацию сервисов, расположенных на нескольких машинах, с помощью интерфейсов. Хотелось работать с сервисами как будто они все находятся в одном процессе.

Пример показывает насколько близко удалось приблизиться к желаемому результату.

Задача: разработать сервер и клиент для обмена информацией о сотрудниках вымышленной компании.

Решение подобных задач сводится к нескольким однотипным шагам

- Определить интерфейс(ы) взаимодействия компонент

- Определить пользовательские структуры данных (если в этом есть необходимость) для параметров методов или как возвращаемые значения

- Добавить метаинформацию

- Реализовать серверное приложение

- Реализовать клиентское приложение

Пример complex_type

Общая часть

Структуры данных

// data.h

namespace Service

{

namespace Data

{

using ID = std::string;

struct Human

{

std::string name;

std::string lastName;

std::uint32_t age = 0;

};

enum class Position

{

Unknown,

Developer,

Manager

};

struct Employee

: public Human

{

Position position = Position::Unknown;

};

using Employees = std::map;

} // namespace Data

} // namespace Service

Метаинформация

// meta/data.h

namespace Service

{

namespace Data

{

namespace Meta

{

using namespace ::Service::Data;

MIF_REFLECT_BEGIN(Human)

MIF_REFLECT_FIELD(name)

MIF_REFLECT_FIELD(lastName)

MIF_REFLECT_FIELD(age)

MIF_REFLECT_END()

MIF_REFLECT_BEGIN(Position)

MIF_REFLECT_FIELD(Unknown)

MIF_REFLECT_FIELD(Developer)

MIF_REFLECT_FIELD(Manager)

MIF_REFLECT_END()

MIF_REFLECT_BEGIN(Employee, Human)

MIF_REFLECT_FIELD(position)

MIF_REFLECT_END()

} // namespace Meta

} // namespace Data

} // namespace Service

MIF_REGISTER_REFLECTED_TYPE(::Service::Data::Meta::Human)

MIF_REGISTER_REFLECTED_TYPE(::Service::Data::Meta::Position)

MIF_REGISTER_REFLECTED_TYPE(::Service::Data::Meta::Employee)

Интерфейс

// imy_company.h

namespace Service

{

struct IMyCompany

: public Mif::Service::Inherit

{

virtual Data::ID AddEmployee(Data::Employee const &employee) = 0;

virtual void RemoveAccount(Data::ID const &id) = 0;

virtual Data::Employees GetEmployees() const = 0;

};

} // namespace Service

Метаинформация

// ps/imy_company.h

namespace Service

{

namespace Meta

{

using namespace ::Service;

MIF_REMOTE_PS_BEGIN(IMyCompany)

MIF_REMOTE_METHOD(AddEmployee)

MIF_REMOTE_METHOD(RemoveAccount)

MIF_REMOTE_METHOD(GetEmployees)

MIF_REMOTE_PS_END()

} // namespace Meta

} // namespace Service

MIF_REMOTE_REGISTER_PS(Service::Meta::IMyCompany)

Определение структуры данных и добавление метаинформации к ней такое же, как и в примерах с рефлексией, за исключением того, что все разнесено по пространствам имен.

Определение интерфейса — это определение C++ структуры данных, содержащей только чисто виртуальные методы.

Для интерфейсов было другое пожелание — возможность запрашивать из одного интерфейса другие, содержащиеся в реализации, и, возможно, не связанные в единую иерархию. Поэтому определяемый интерфейс всегда должен наследовать Mif::Service::IService или любой другой, наследуемый от Mif::Service::IService. Есть множественное наследование. Наследование делается через промежуточную сущность Mif::Service::Inherit. Это шаблон с переменным числом параметров. Его параметрами служат наследуемые интерфейсы или реализации (inheritance). Это необходимо для реализации механизма запроса интерфейсов такого же, как dynamic_cast, но работающего и за границами процесса.

Добавление метаинформации к интерфейсу особо не отличается от добавления метаинформации для структур данных. Это другой, но аналогичный, набор макросов. Возможно позднее все же все будет сведено к единому набору макросов для определения структур данных и интерфейсов. Пока они разные. Так сложилось в ходе развития проекта.

Указывать при добавлении метаинформации к интерфейсу его базовые интерфейсы не надо. Вся иерархия будет найдена в момент компиляции. Здесь небольшая вспомогательная сущность Mif::Service::Inherit играет свою основную роль в поиске наследников и связанной с ними метаинформации.

При добавлении метаинформации к интерфейсам указывается только интерфейс и его методы без указания параметров, возвращаемых значений и cv-квалификаторов. Было желание сделать добавление метаинформации к интерфейсам в духе минимализма. Отсутствие перегрузки стало платой за минимализм. Считаю это малой ценой за возможность не перечислять все параметры и возвращаемые типы значений для каждого метода и не править их при небольших правках в интерфейсе.

Определив общие сущности, осталось реализовать серверное и клиентское приложения.

У каждого интерфейса может быть множество реализаций. Их как-то нужно отличать. При создании объекта нужно явно указывать желаемую реализацию. Для этого нужны идентификаторы реализаций интерфейсов и их связь с реализациями.

Для удобства и отказа от «магических значений в коде» идентификаторы реализаций лучше вынести в один или несколько заголовочных файлов. В проекте MIF в качестве идентификатора используются числа. Чтобы им как-то придать уникальность при этом не городить какие-то счетчики или все не помещать в один единый enum и иметь возможность логически разнести идентификаторы по разным файлам и пространствам имен, предлагается в качестве идентификаторов использовать crc32 от строки, с придумыванием уникальности которой проблем у разработчика должно быть меньше.

Для реализации интерфейса IMyCompany нужен идентификатор

// id/service.h

namespace Service

{

namespace Id

{

enum

{

MyCompany = Mif::Common::Crc32("MyCompany")

};

} // namespace Id

} // namespace Service

Серверное приложение

Реализация IMyCompany

// service.cpp

// MIF

#include

{

public:

// …

private:

// …

// IMyCompany

virtual Data::ID AddEmployee(Data::Employee const &employee) override final

{

// ...

}

virtual void RemoveAccount(Data::ID const &id) override final

{

// ... }

}

virtual Data::Employees GetEmployees() const override final

{

// ...

}

};

} // namespace

} // namespace Detail

} // namespace Service

MIF_SERVICE_CREATOR

(

::Service::Id::MyCompany,

::Service::Detail::MyCompany

)

Есть несколько моментов, на которые хотелось бы обратить внимание:

- Наследование в реализации так же через Mif::Service::Inherit. Это не обязательно, но можно считать хорошим тоном и будет полезно при реализации нескольких интерфейсов с наследованием части ранее уже реализованных интерфейсов.

- Вся реализация может и, предпочтительно, должна быть сделана в одном cpp-файле, без разделения на h и cpp файлы. Что позволяет усилить инкапсуляцию и в больших проектах уменьшить время компиляции за счет того, что все необходимые включаемые файлы реализации находятся в файле с реализацией. При их модификации перекомпиляции подвергается меньшее число зависимых cpp-файлов.

- Каждая реализация имеет точку входа — MIF_SERVICE_CREATOR, что является фабрикой реализации. Параметрами являются класс-реализация, идентификатор и при необходимости переменное количество параметров, передаваемых в конструктор реализации.

Для завершения серверного приложения осталось добавить точку входа — функцию main.

// MIF

#include (argc, argv);

}

При создании точки входа нужно реализовать свой класс приложения — наследник от базового класса приложений или от одного из предопределенных шаблонов приложений. В переопределенном методе Init нужно добавить к фабрике все существующие реализации интерфейсов, которые будет экспортировать сервис (factory->AddClass). В метод AddClass можно передавать параметры конструктора реализации.

Сервис использует предопределенный транспорт tcp, сериализацию на базе boost.archive в бинарном формате со сжатием gzip данных для обмена информацией об интерфейсах, методах, параметрах, возвращаемых результатах, исключениях и экземплярах объектов.

Можно использовать другой вид транспорта (например, http, который так же доступен в MIF или реализовать свой), сериализации и собрать свою уникальную цепочку обработки данных (определение границ пакета, сжатие, шифрование, многопоточную обработку и т.д.). Для этого нужно воспользоваться уже не шаблоном приложения, а базовым классом приложений (Mif::Application::Application), определить самостоятельно нужные части цепочки обработки данных или транспорт.

В первой версии проекта MIF не было предопределенных шаблонов приложений. Примеры выглядели не такими короткими, но показывали весь путь, который нужно проделать для полного контроля над потоком обработки данных. Вся цепочка показана в примерах первой версии проекта (MIF 1.0).

Клиентское приложение

На стороне клиента используется все, что было определено в общей части.

Клиент — это такой же каркас приложения (в примере используется предопределенный шаблон приложения), в котором запрашивается удаленная фабрика классов / сервисов, через которую создается нужный объект и вызываются его методы.

// MIF

#include (argc, argv);

}

Результат

2017-08-09T14:01:23.404663 [INFO]: Starting network application on 0.0.0.0:55555

2017-08-09T14:01:23.404713 [INFO]: Starting server on 0.0.0.0:55555

2017-08-09T14:01:23.405442 [INFO]: Server is successfully started.

2017-08-09T14:01:23.405463 [INFO]: Network application is successfully started.

Press 'Enter' for quit.

2017-08-09T14:01:29.032171 [INFO]: MyCompany

2017-08-09T14:01:29.041704 [INFO]: AddEmployee. Name: Ivan LastName: Ivanov Age: 25 Position: Manager

2017-08-09T14:01:29.042948 [INFO]: AddEmployee. Name: Petr LastName: Petrov Age: 30 Position: Developer

2017-08-09T14:01:29.043616 [INFO]: GetEmployees.

2017-08-09T14:01:29.043640 [INFO]: Id: 0 Name: Ivan LastName: Ivanov Age: 25 Position: Manager

2017-08-09T14:01:29.043656 [INFO]: Id: 1 Name: Petr LastName: Petrov Age: 30 Position: Developer

2017-08-09T14:01:29.044481 [INFO]: Removed employee account for Id: 0 Name: Ivan LastName: Ivanov Age: 25 Position: Manager

2017-08-09T14:01:29.045121 [INFO]: GetEmployees.

2017-08-09T14:01:29.045147 [INFO]: Id: 1 Name: Petr LastName: Petrov Age: 30 Position: Developer

2017-08-09T14:01:29.045845 [WARNING]: RemoveAccount. Employee with id 0 not found.

2017-08-09T14:01:29.046652 [INFO]: ~MyCompany

2017-08-09T14:02:05.766072 [INFO]: Stopping network application ...

2017-08-09T14:02:05.766169 [INFO]: Stopping server ...

2017-08-09T14:02:05.767180 [INFO]: Server is successfully stopped.

2017-08-09T14:02:05.767238 [INFO]: Network application is successfully stopped.

2017-08-09T14:01:29.028821 [INFO]: Starting network application on 0.0.0.0:55555

2017-08-09T14:01:29.028885 [INFO]: Starting client on 0.0.0.0:55555

2017-08-09T14:01:29.042510 [INFO]: Employee Id: 0

2017-08-09T14:01:29.043296 [INFO]: Employee Id: 1

2017-08-09T14:01:29.044082 [INFO]: Employee. Id: 0 Name: Ivan LastName: Ivanov Age: 25 Position: Manager

2017-08-09T14:01:29.044111 [INFO]: Employee. Id: 1 Name: Petr LastName: Petrov Age: 30 Position: Developer

2017-08-09T14:01:29.044818 [INFO]: Removed account 0

2017-08-09T14:01:29.045517 [INFO]: Employee. Id: 1 Name: Petr LastName: Petrov Age: 30 Position: Developer

2017-08-09T14:01:29.045544 [INFO]: Removed again account 0

2017-08-09T14:01:29.046357 [WARNING]: Error: [Mif::Remote::Proxy::RemoteCall] Failed to call remote method "IMyCompany::RemoveAccount" for instance with id "411bdde0-f186-402e-a170-4f899311a33d". Error: RemoveAccount. Employee with id 0 not found.

2017-08-09T14:01:29.046949 [INFO]: Client is successfully started.

2017-08-09T14:01:29.047311 [INFO]: Network application is successfully started.

Press 'Enter' for quit.

2017-08-09T14:02:02.901773 [INFO]: Stopping network application ...

2017-08-09T14:02:02.901864 [INFO]: Stopping client ...

2017-08-09T14:02:02.901913 [INFO]: Client is successfully stopped.

2017-08-09T14:02:02.901959 [INFO]: Network application is successfully stopped.

Да, исключения так же преодолевают границы процессов…

[WARNING]: Error: [Mif::Remote::Proxy::RemoteCall] Failed to call remote method "IMyCompany::RemoveAccount" for instance with id "411bdde0-f186-402e-a170-4f899311a33d". Error: RemoveAccount. Employee with id 0 not found.

Из сообщения видно, что был повторно вызван метод удаления информации о сотруднике с идентификатором 0. На стороне сервера уже такой записи нет, о чем сервер сообщил исключением с текстом «Employee with id 0 not found»/

Пример продемонстрировал межпроцессное взаимодействие клиента с сервером, максимально скрывая все детали связанные с транспортом и форматом передаваемых данных.

Этот пример завершает показ базы, лежащей в основе проекта MIF. К дополнительным возможностям можно отнести

- Возможность запрашивать интерфейсы у реализации не объединенные в единую иерархию (не считая наследования от Mif::Service::IService).

- Передавать указатели и умные указатели на интерфейсы между сервисами. Что может пригодиться для разных реализаций сервисов с обратными вызовами. Например, сервис на базе publish/subscribe. В качестве примера приведена реализация паттерна visitor, части которого находятся в разных процессах и взаимодействуют по tcp.

HTTP

В примере межпроцессного взаимодействия можно легко заменить существующий TCP -транспорт, на HTTP -транспорт. Появится возможность обращаться к сервисам с помощью привычных средств, например, curl или из браузера.

Поддержка HTTP дает возможность строить сервисы, которые одновременно могут являться и web-сервером с каким-нибудь json REST API, и в то же время поддерживать ранее продемонстрированное взаимодействие через C++ интерфейсы.

Комфорт часто связан с ограничениями. Таким ограничением при использовании HTTP-транспорта является отсутствие возможности обратного вызова методов, передаваемых интерфейсов. Решение на базе HTTP-транспорта не ориентировано на построение приложений publish / subscribe. Это связано с тем, что работа по HTTP предполагает подход «запрос-ответ». Клиент посылает запросы серверу и ждет ответа.

Предложенный в MIF TCP-транспорт такого ограничения не имеет. Вызвать методы может как клиент, так и сервер. В этом случае размываются разграничения клиента и сервера. Появляется канал, по которому объекты могут общаться друг с другом, вызывая методы с любой его стороны. Это дает возможность двустороннего взаимодействия для построения архитектуры publish / subscribe, что было продемонстрировано в примере межпроцессным посетителем.

В MIF HTTP уделено особое внимание, т.к. изначально направленность была на разработку backend сервисов для веба. Нужно было создавать небольшие HTTP веб-сервисы, получать данные от поставщиков по HTTP и только после этого была добавлена возможность использования HTTP в качестве транспорта при маршалинге интерфейсов между процессами. Поэтому хотелось бы в начале продемонстрировать примеры создания простых web-сервисов, клиентов, а в конце привести пример web-сервера с поддержкой передачи интерфейсов между процессами.

Простой HTTP web-сервер

// MIF

#include (argc, argv);

}

Для проверки работы можно воспользоваться командой

curl -iv -X POST "http://localhost:55555/" -d 'Test data'

Всего около трех десятков строк кода и многопоточный HTTP эхо-сервер на базе каркаса приложений MIF готов. В качестве backend используется libevent. Простое тестирование с помощью утилиты ab выдает средний результат до 160K запросов в секунду. Конечно все зависит от «железа», на котором проводится тестирование, операционной системы, сети и т.д. Но для сравнения что-то подобное было сделано на Python и Go. Сервер на Python отработал в 2 раза медленнее, а на Go результат был лучше в среднем на 10% от результата сервера из примера. Так что, если Вы C++ разработчик и Python и Go Вам чужды или есть иные, возможно официально закрепленные внутренними распоряжениями в рамках проекта, причины любить только C++, то можно воспользоваться предложенным решением и получить неплохие результаты по скорости работы и срокам разработки …

HTTP клиент

Клиентская часть представлена классом Mif::Net::Http::Connection. Это основа HTTP-транспорта маршалинга C++ интерфейсы в MIF. Но пока не про маршалинг… Класс может использоваться отдельно от всей инфраструктуры межпроцессного взаимодействия MIF-микросервисов, например, для скачивания данных поставщиков, например, медиаконтента, прогноза погоды, биржевых котировок и т.д.

Запустив приведенный выше эхо-сервис, можно к нему обратиться таким клиентом:

// STD

#include

#include

#include

#include

// MIF

#include Это базовый пример без учета особого внимания на обработку ошибок. Он демонстрирует возможность разработки простого клиента. Конечно лучше использовать что-то иное, например, на базе библиотеки curl, но иногда в простых случаях вполне может быть достаточно приведенного выше кода.

HTTP web-сервер с двойным интерфейсом

Пример подводит итог по поддержке HTTP в проекте MIF. В примере показан HTTP web-сервер, к которому можно обращаться из браузера или с помощью curl, а так же клиентом, работающим через C++ интерфейсы и не желающего знать ничего о транспорте и формате данных. Используется тот же каркас приложения Mif::Application::HttpServer, что и ранее. Ниже приведены необходимые для демонстрации фрагменты кода. Целиком пример доступен на github в примере http.

Общая часть

Интерфейс

namespace Service

{

struct IAdmin

: public Mif::Service::Inherit

{

virtual void SetTitle(std::string const &title) = 0;

virtual void SetBody(std::string const &body) = 0;

virtual std::string GetPage() const = 0;

};

} // namespace Service

Добавление метаинформации к интерфейсу, идентификатор сервиса-реализации — все, аналогично приведенным ранее примерам межпроцессного взаимодействия.

Серверная часть

Каркас приложения

class Application

: public Mif::Application::HttpServer

{

//...

private:

// Mif.Application.HttpService

virtual void Init(Mif::Net::Http::ServerHandlers &handlers) override final

{

std::string const adminLocation = "/admin";

std::string const viewLocation = "/view";

auto service = Mif::Service::Create(viewLocation);

auto webService = Mif::Service::Cast(service);

auto factory = Mif::Service::Make();

factory->AddInstance(Service::Id::Service, service);

std::chrono::microseconds const timeout{10000000};

auto clientFactory = Service::Ipc::MakeClientFactory(timeout, factory);

handlers.emplace(adminLocation, Mif::Net::Http::MakeServlet(clientFactory));

handlers.emplace(viewLocation, Mif::Net::Http::MakeWebService(webService));

}

};

Обработчик ресурса задается уже не напрямую, а через дополнительную обертку, которая позволяет:

- Добавлять к ресурсу разные обработчики

- Автоматически делать разбор параметров запроса и данных из тела запроса

- Автоматически сериализовать ответ в выбранный формат

- Объединять два подхода: работу по HTTP через, возможно, REST API и работу с клиентом с поддержкой маршалинга C++ интерфейсов

Все эти возможности реализованы в базовом классе Mif::Net::Http::WebService. Пользовательский класс должен наследовать его. Т.к. это уже сервис, который содержит чисто виртуальные методы, реализация которых скрыта в сервисном коде каркаса, то экземпляры классов-наследников должны создаваться так же как и все сервисы — фабричным методом. Чтобы сервис можно было использовать как обработчик HTTP web-сервера нужно создать обертку функцией Mif::Net::Http::MakeServlet.

Сервисы MIF и веб-сервисы — это разные сервисы. Под MIF сервисами стоит понимать только классы-реализации интерфейсов, которые не обязаны заниматься только обработкой HTTP-запросов или иных сетевых запросов. Веб-сервисы уже более привычное понятие. Но при необходимости в MIF это все легко объединяется в единое целое и приведенный пример этому подтверждение.

Сервис-обработчик

namespace Service

{

namespace Detail

{

namespace

{

class WebService

: public Mif::Service::Inherit

<

IAdmin,

Mif::Net::Http::WebService

>

{

public:

WebService(std::string const &pathPrefix)

{

AddHandler(pathPrefix + "/stat", this, &WebService::Stat);

AddHandler(pathPrefix + "/main-page", this, &WebService::MainPage);

}

private:

// …

// IAdmin

virtual void SetTitle(std::string const &title) override final

{

// ...

}

// …

// Web hadlers

Result Stat()

{

// ...

std::map resp;

// Fill resp

return resp;

}

Result

MainPage(Prm const &format)

{

// ...

}

};

} // namespace

} // namespace Detail

} // namespace Service

MIF_SERVICE_CREATOR

(

::Service::Id::Service,

::Service::Detail::WebService,

std::string

)

Хотелось бы обратить внимание на несколько моментов:

- Выше уже упоминалась необходимость использования Mif::Service::Inherit при написании реализаций. Здесь как раз роль Mif::Service::Inherit полностью оправдана. С одной стороны класс наследует интерфейс IAdmin и реализует все его методы, а с другой наследует реализацию интерфейса IWebService в виде базового класса Mif::Net::Http::WebService, которая делает работу с HTTP проще.

- В конструкторе добавляются обработчики ресурсов. Полный путь строится из пути ресурса, с которым связан класс-наследник Mif::Net::Http::WebService и пути, который указан при вызове AddHandler. В примере путь для получения статистики по выполненным запросам будет выглядеть, как /view/stat

- Возвращаемый тип обработчика может быть любым, который можно вывести в поток. Кроме того в качестве возвращаемого типа можно использовать обертку-сериализатор. Она сериализует переданный встроенный или пользовательский тип в свой формат. В этом случае для сериализации пользовательских типов используется добавленная к ним метаинформация.

- Методы-обработчики могут принимать параметры. Для описания параметров используется сущность Prm. Класс Prm принимает тип параметра, его имя. При необходимости пользовательская реализация разбора параметров может быть передана в Prm. Поддерживается конвертация параметров запроса к интегральным типам, типам с плавающей точкой, множества параметров с разделителем в виде точки с запятой (некоторые stl контейнеры, например, list, vector, set). Так же дата, время и timestamp целиком, которые можно привести к типам boost::posix_time. Десериализация данных тела запроса производится классом Content. Класс использует метаинформацию и преданный десериализатор. При необходимости получить доступ к заголовкам запроса или ко всей карте параметров, в качестве параметра обработчика можно указать Headers и / или Params. Одновременно можно использовать все указанные классы. Подробная работа с параметрами показана в примере http_crud

- При определении фабричного метода для создания класса реализации в макрос MIF_SERVICE_CREATOR передается дополнительный параметр, который должен быть передан в конструктор реализации. Использование макроса MIF_SERVICE_CREATOR упоминалось выше.

Клиент

Клиент не имеет особых отличий от ранее приведенных примеров. Исключением является отсутствие предопределенной цепочки обработки запросов. Она формируется разработчиком самостоятельно. Для работы по HTTP в MIF нет предопределенных цепочек обработки запросов. Особенности реализации… О причинах, возможно, что-то в последующих постах будет написано. Полный код клиента — это пример http.

Результаты

Для тестирования собранный сервер нужно запустить и попробовать обратиться к нему, например, с использованием команды curl или из браузера

curl "http://localhost:55555/view/main-page?format=text"

curl "http://localhost:55555/view/main-page?format=html"

curl "http://localhost:55555/view/main-page?format=json"

После чего запустить клиентское приложение, которое обращается через интерфейс администратора и меняет данные и повторно попробовать выполнить приведенные curl команды. Можно заметить, что внесенные клиентом изменения были успешно применены и выдаваемый по HTTP результат изменился.

Работа с базами данных

Backedn без БД? Как же без них? Не обязательно, но и не редко…

На текущий момент работа с базами данных в MIF реализована без опоры на метаинформацию. Пока что почти классика работы с БД. Эта часть была нужна для разработки сервисов, которые что-то должны были хранить в БД. Но разработка этой части велась с прицелом на то, что она станет основой для ORM, где уже в полной мере будет использована вся метаинформация, добавляемая к типам. С ORM как-то пока не сложилось. Было несколько попыток реализовать. Получалось или сильно громоздко, или не гибко. Думаю, что компромисс между лаконичностью и гибкостью скоро будет достигнут и в ближайших версиях ORM все же появится, т.к. уж очень хочется иметь возможность какие-то проверки переложить на компилятор, а не ловить в момент исполнения программы ошибки, связанные с простейшими ошибками и опечатками в сырых строках SQL-запросов.

Пока ORM нет, немного классики …

Работа с БД содержит несколько шагов:

- Создание объекта-подключения к БД

- Выполнение запросов, через полученное подключение

- Обработка результатов

- Транзакции

Кто работал с какими-нибудь обертками такими, как JDBC (в Java) или что-то подобное для C++ ничего нового для себя тут не откроют.

В примере db_client показана работа с двумя СУБД: PostgreSQL и SQLite.

HTTP CRUD сервер

Пример http_crud является логическим завершением демонстрации работы с HTTP и БД — классика простых микросервисов для веба, которые не взаимодействуют непосредственно друг с другом.

Класс web-сервера содержит обработчики всех базовых операций CRUD. Работа с БД ведется в обработчиках. Такой код можно нередко встретить в разных успешно работающих сервисах. Но не смотря на его изначальную простору, в нем есть недостаток — зависимость от СУБД. А при желании отказаться от реляционной БД и перейти к NoSQL базе данных код всех обработчиков почти полностью будет переписан. Во многих реальных проектах стараюсь избегать подобной работы с БД. Выносить в отдельные фасады высокоуровневые функции логики. Фасады — это как правило C++ интерфейсы с конкретными реализациями. А замена БД сводится к очередной реализации интерфейса и запросу у фабрики реализации с новым идентификатором. Играя капитана очевидности, можно сказать, что такой подход себя не раз оправдал.

Заключение

Все, что рассмотрено выше: рефлексия, сериализация, межпроцессное взаимодействие, маршалинг интерфейсов, работа с БД, поддержка HTTP — все нашло свое отражение в итоговом примере построения небольшой системы на микросервисах. Пример демонстрирует небольшой сервис, состоящий из двух микросервисов, взаимодействующих между собой. Один сервис является фасадом к БД, а второй предоставляет Json API для внешних клиентов. Пример является модифицированной версией рассмотренного примера http_crud и является логическим завершением (объединением) всему, о чем шла речь в рамках поста.

Некоторые части MIF, не были рассмотрены, например, db_client, но работа с БД показана в других примера. Работа с сервисами (реализациями интерфейсов) так же частично затронута в примерах. Некоторые части MIF, такие как сериализация, работа с БД и поддержка HTTP уже неоднократно проверены. Межпроцессному взаимодействию пока было уделено меньше времени на проверку и отладку, несмотря на то, что некоторым частям в разработке было уделено много времени. Например, к таким можно отнести поддержку передачи интерфейсов как параметров в другой процесс и обратный вызов их методов. Что является по сути «эго-фичей». Хотелось попробовать реализовать подобный механизм, показанный в примере visitor, но в дальнейшем есть желание довести эту часть до полноценного проверенного и отлаженного решения.

В дальнейшем, возможно, при наличии интереса к изложенному материалу, пост будет иметь продолжение с тем, что не вошло в этот, например, что «под капотом» MIF, почему приняты те или иные решения, какие задачи пришлось решить, чем не подошел thrift или иные подобные решения, какие недочеты вижу и что хотелось бы поменять и усовершенствовать и т.д. Проект появился, как «home project» и, к моему же удивлению, является проектом, которому я уделяю внимание уже почти год, то не должно возникнуть проблем с тем, о чем можно еще написать.

Подводя итог, продублирую ссылку на проект MIF on C++.

Спасибо за внимание.

|

Метки: author NYM программирование c++ web-services c++11 microservices reflection rpc web-backend |

[Из песочницы] Простой WebScraping на R через API hh.ru |

Простой WebScraping на R через API hh.ru

Доброго времени суток, уважаемые читатели

Не так давно преподаватель дал задание: cкачать данные с некоторого сайта на выбор. Не знаю почему, но первое, что пришло мне в голову — это hh.ru.

Далее встал вопрос: "А что же собственно будем выкачивать?", ведь на сайте порядка 5 млн. резюме и 100.000 вакансий.

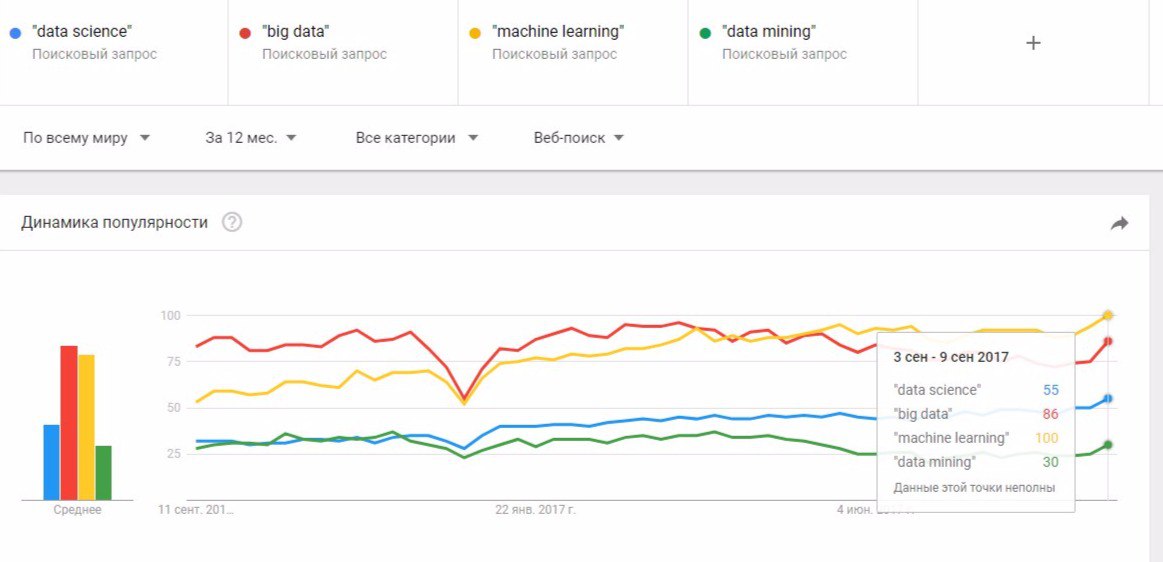

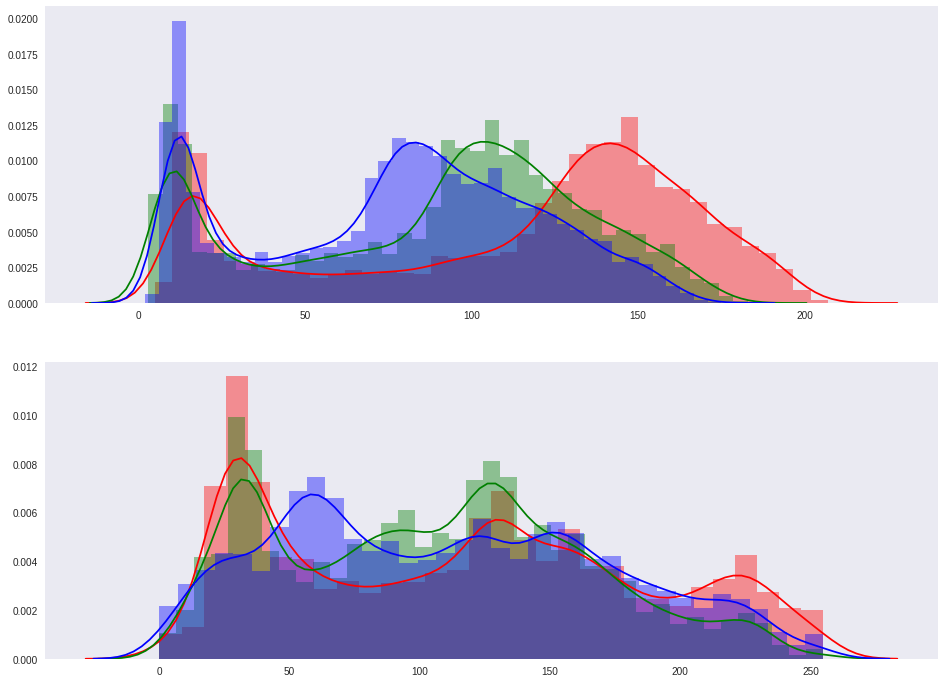

Решив посмотреть, какими навыками мне придется овладеть в будущем, я набрал в поисковой строке "data science" и призадумался. Может быть по синонимичному запросу найдется больше вакансий и резюме? Нужно узнать, какие формулировки популярны в данный момент. Для этого удобно использовать сервис GoogleTrends.

Отсюда видно, что выгоднее всего искать по запросу "machine learning". Кстати, это действительно так.

Соберем вначале вакансии. Их довольно мало, всего 411. API hh.ru поддерживает поиск по вакансиям, поэтому задача становится тривиальной. Единственное, нам необходимо работать с JSON. Для этой цели я использовал пакет jsonlite и его метод fromJSON() принимающий на вход URL и возвращающий разобранную структуру данных.

data <- fromJSON(paste0("https://api.hh.ru/vacancies?text=\"machine+learning\"&page=", pageNum) # Здесь pageNum - номер страницы. На странице отображается 20 вакансий.# Scrap vacancies

vacanciesdf <- data.frame(

Name = character(), # Название компании

Currency = character(), # Валюта

From = character(), # Минимальная оплата

Area = character(), # Город

Requerement = character(), stringsAsFactors = T) # Требуемые навыки

for (pageNum in 0:20) { # Всего страниц

data <- fromJSON(paste0("https://api.hh.ru/vacancies?text=\"machine+learning\"&page=", pageNum))

vacanciesdf <- rbind(vacanciesdf, data.frame(

data$items$area$name, # Город

data$items$salary$currency, # Валюта

data$items$salary$from, # Минимальная оплата

data$items$employer$name, # Название компании

data$items$snippet$requirement)) # Требуемые навыки

print(paste0("Upload pages:", pageNum + 1))

Sys.sleep(3)

}Записав все данные в DataFrame, давайте немного его почистим. Переведем все зарплаты в рубли и избавимся от столбца Currency, так же заменим NA значения в Salary на нулевые.

# Сделаем приличные названия столбцов

names(vacanciesdf) <- c("Area", "Currency", "Salary", "Name", "Skills")

# Вместо зарплаты NA будет нулевая

vacanciesdf[is.na(vacanciesdf$Salary),]$Salary <- 0

# Переведем зарплаты в рубли

vacanciesdf[!is.na(vacanciesdf$Currency) & vacanciesdf$Currency == 'USD',]$Salary <- vacanciesdf[!is.na(vacanciesdf$Currency) & vacanciesdf$Currency == 'USD',]$Salary * 57

vacanciesdf[!is.na(vacanciesdf$Currency) & vacanciesdf$Currency == 'UAH',]$Salary <- vacanciesdf[!is.na(vacanciesdf$Currency) & vacanciesdf$Currency == 'UAH',]$Salary * 2.2

vacanciesdf <- vacanciesdf[, -2] # Currency нам больше не нужна

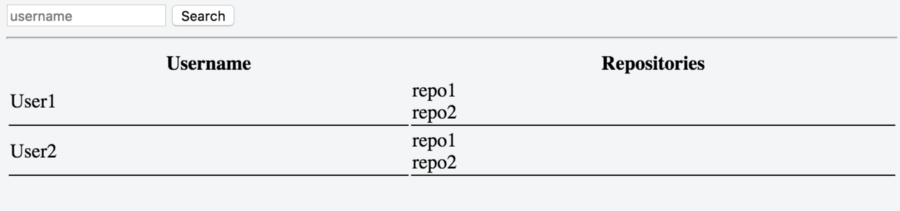

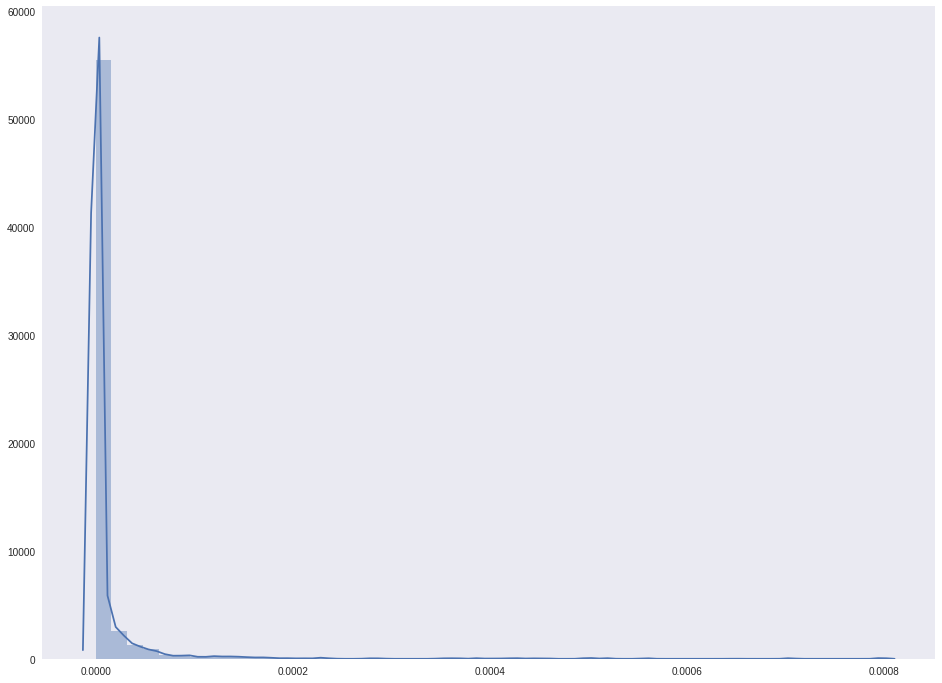

vacanciesdf$Area <- as.character(vacanciesdf$Area)После этого имеем DataFrame вида:

Пользуясь случаем, посмотрим сколько вакансий в городах и какая у них средняя зарплата.

vacanciesdf %>% group_by(Area) %>% filter(Salary != 0) %>%

summarise(Count = n(), Median = median(Salary), Mean = mean(Salary)) %>%

arrange(desc(Count))

Для scraping`a в R обычно используется пакет rvest, имеющий два ключевых метода read_html() и html_nodes(). Первый позволяет скачивать страницы из интернета, а второй обращаться к элементам страницы с помощью xPath и CSS-селектора. API не поддерживает возможность поиска по резюме, но дает возможность получить информацию о нем по id. Будем выгружать все id, а затем уже через API получать данные из резюме. Всего резюме на сайте по данному запросу — 1049.

hhResumeSearchURL <- 'https://hh.ru/search/resume?exp_period=all_time&order_by=relevance&text=machine+learning&pos=full_text&logic=phrase&clusters=true&page=';

# Загрузим очередную страницу с номером pageNum

hDoc <- read_html(paste0(hhResumeSearchURL, as.character(pageNum)))

# Выделим все аттрибуты ссылок на странице

ids <- html_nodes(hDoc, css = 'a') %>% as.character()

# Выделим из ссылок необходимые id ( последовательности букв и цифр длины 38 )

ids <- as.vector(ids) %>% `[`(str_detect(ids, fixed('/resume/'))) %>%

str_extract(pattern = '/resume/.{38}') %>% str_sub(str_count('/resume/') + 1)

ids <- ids[4:length(ids)] # В первых 3х мусорПосле этого уже известным нам методом fromJSON получим информацию, содержащуюся в резюме.

resumes <- fromJSON(paste0("https://api.hh.ru/resumes/", id))hhResumeSearchURL <- 'https://hh.ru/search/resume?exp_period=all_time&order_by=relevance&text=machine+learning&pos=full_text&logic=phrase&clusters=true&page=';

for (pageNum in 0:51) { # Всего 51 страница

#Вытащим id резюме

hDoc <- read_html(paste0(hhResumeSearchURL, as.character(pageNum)))

ids <- html_nodes(hDoc, css = 'a') %>% as.character()

# Выделим все аттрибуты ссылок на странице

ids <- as.vector(ids) %>% `[`(str_detect(ids, fixed('/resume/'))) %>%

str_extract(pattern = '/resume/.{38}') %>% str_sub(str_count('/resume/') + 1)

ids <- ids[4:length(ids)] # В первых 3х мусор

Sys.sleep(1) # Подождем на всякий случай

for (id in ids) {

resumes <- fromJSON(paste0("https://api.hh.ru/resumes/", id))

skills <- if (is.null(resumes$skill_set)) "" else resumes$skill_set

buffer <- data.frame(

Age = if(is.null(resumes$age)) 0 else resumes$age, # Возраст

if (is.null(resumes$area$name)) "NoCity" else resumes$area$name,# Город

if (is.null(resumes$gender$id)) "NoGender" else resumes$gender$id, # Пол

if (is.null(resumes$salary$amount)) 0 else resumes$salary$amount, # Зарплата

if (is.null(resumes$salary$currency)) "NA" else resumes$salary$currency, # Валюта

# Список навыков одной строкой через ,

str_c(if (!length(skills)) "" else skills, collapse = ","))

write.table(buffer, 'resumes.csv', append = T, fileEncoding = "UTF-8",col.names = F)

Sys.sleep(1) # Подождем на всякий случай

}

print(paste("Скачал страниц:", pageNum))

}Также почистим получившийся DataFrame, конвертируя валюты в рубли и удалив NA из столбцов.

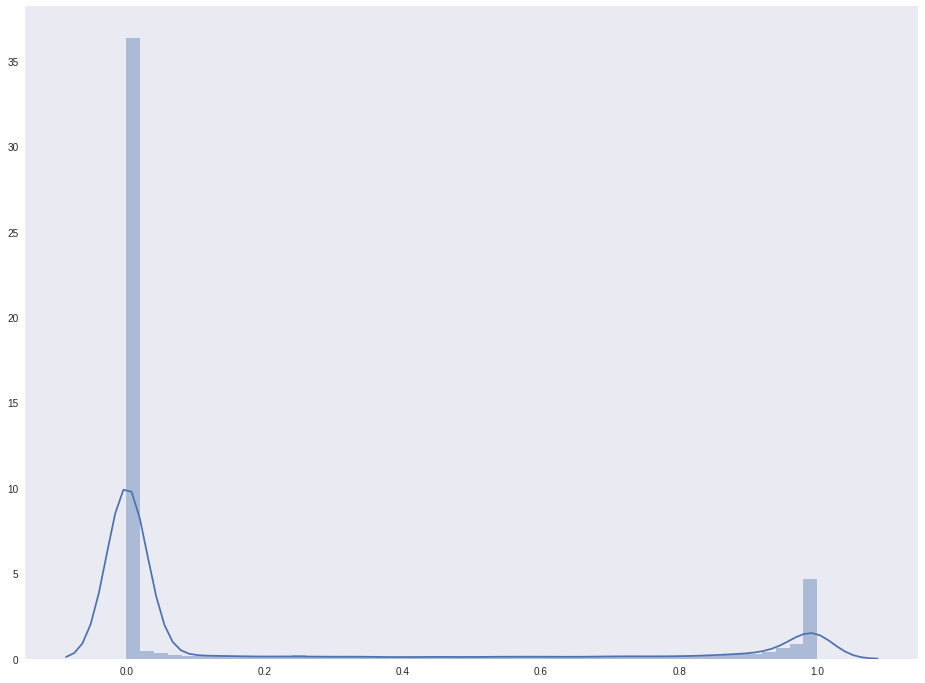

Найдем топ — 15 навыков, чаще остальных встречающихся в резюме

SkillNameDF <- data.frame(SkillName = str_split(str_c(

resumes$Skills, collapse = ','), ','), stringsAsFactors = F)

names(SkillNameDF) <- 'SkillName'

mostSkills <- head(SkillNameDF %>% group_by(SkillName) %>%

summarise(Count = n()) %>% arrange(desc(Count)), 15 )

Посмотрим, сколько женщин и мужчин знают machine learning, а так же на какую зарплату претендуют

resumes %>% group_by(Gender) %>% filter(Salary != 0) %>%

summarise(Count = n(), Median = median(Salary), Mean = mean(Salary)

И напоследок, топ — 10 самых популярных возрастов специалистов по машинному обучению

resumes %>% filter(Age!=0) %>% group_by(Age) %>%

summarise(Count = n()) %>% arrange(desc(Count))

|

Метки: author pdepdepde программирование data mining api scraping data science |

Blockchain Life 2017: от золотой пиццы к криптовалютной лихорадке |

|

Метки: author megapost финансы в it биткоины |

Архитектурная пирамида приложения |

- Совершенный код,

- Проектирование и рефакторинг,

- Программирование,

- ООП,

- Анализ и проектирование систем

Архитектурная пирамида приложения

- Совершенный код,

- Проектирование и рефакторинг,

- Программирование,

- ООП,

- Анализ и проектирование систем

Разбираясь со всем этим по отдельности, меня заинтересовал вопрос — как они взаимосвязаны?

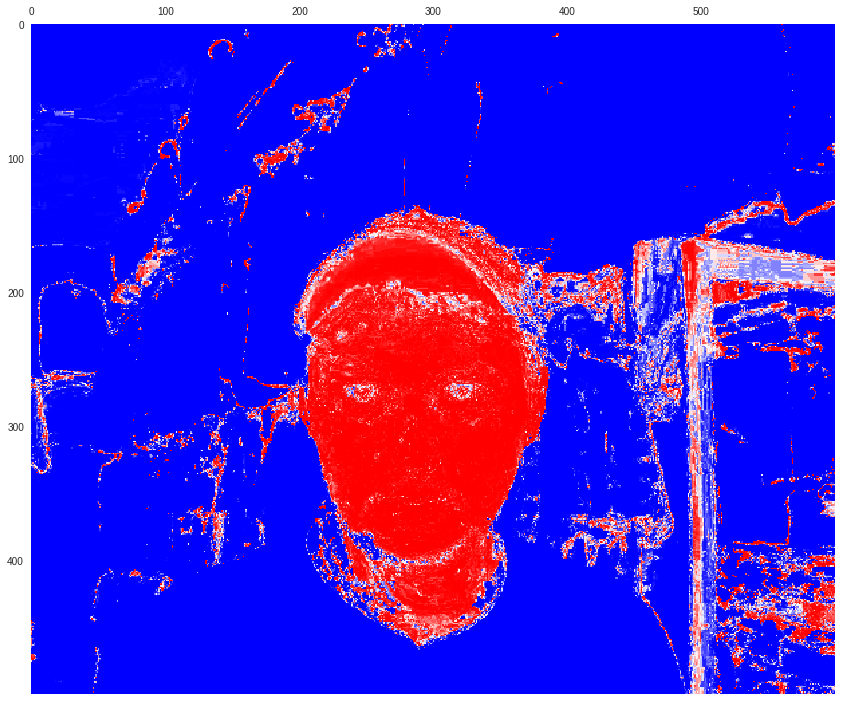

Пытаясь выстроить иерархию и вдохновившись небезызвестной пирамидой Маслоу, я построил свою пирамиду «архитектуры приложения».

О том, что из этого вышло — читайте под катом.

О пирамиде

Пирамида — всего лишь удобная визуализация для наглядного представления иерархии различных принципов, стилей и методологий. Пирамида состоит из уровней, а уровни из элементов. Каждый уровень дополнительно имеет свое обобщающее название. Пирамиду следует читать снизу-вверх, от наиболее базовых и общих понятий внизу, к более частным и конкретным вверху. Порядок следования элементов, расположенных на одном уровне, не имеет значения. Элементы одного уровня рассматриваются как «равноценные» или «равноправные».

Уровни пирамиды

Рассмотрим каждый из уровней пирамиды, последовательно поднимаясь от ее основания к вершине. Каждый из упомянутых в статье принципов подробно описан множество раз в книгах и статьях. Поэтому я не буду подробно их описывать, давая лишь краткую цитату и ссылку. Вместо этого я попытаюсь объяснить — почему уровни расположены именно так и как все это можно использовать.

Безусловные ограничения

Основанием пирамиды служат объективные (физические) ограничения для приложения. Это может быть что угодно: размер команды, бюджет, срок сдачи, законодательство страны и даже текущий уровень развития технологий. Основной отличительный признак такого рода ограничений — вы не можете на них повлиять.

Очевидно, что такие ограничения влияют на весь проект — на его архитектуру, выбор технологий и способ управления командой.

Бизнес требования

Выше безусловных ограничений расположились бизнес требования: функциональное и/или техническое задание, пожелания клиента, явные и неявные функции, которые конечный пользователь ожидает получить.

Бизнес требования вносят дополнительное (а зачастую и основные) ограничения на архитектуру приложения. Но они не могут противоречить

Сложность: KISS, YAGNI

Вряд ли кто-то будет спорить, что сложность системы является одним из самых важных факторов, влияющих на все остальные аспекты и, в конечном счете, на успех проекта.

Принципами, направленными на борьбу со сложностью в разработке приложений, являются KISS (Keep it simple, stupid) и YAGNI (You aren't gonna need it).

Принцип KISS призывает упрощать:

большинство систем работают лучше всего, если они остаются простыми, а не усложняютсяА YAGNI не проектировать наперед сверх меры:

Вам это не понадобитсяОба они очень абстрактны и годятся для любого приложения, что делает их основополагающими.

Эти принципы очень важны, но в то же время вам никто не заплатит, если в погоне за простотой вы проигнорировали половину требований клиента. Поэтому принципы, относящиеся к простоте заняли почетное место прямо над бизнес требованиями клиента.

Связность: DRY, SRP, ISP, high cohesion

Старая шутка про слона, которого нужно есть по частям в полной мере годится для любой сложной задачи. В том числе, и для разработки крупных приложений. За корректное разделение

Принцип DRY гласит:

Каждая часть знания должна иметь единственное, непротиворечивое и авторитетное представление в рамках системыА принцип SRP:

каждый объект должен иметь одну ответственность

Может показаться, что оба принципа — это одно и то же, только разными словами, но это не так. На самом деле они дополняют друг друга. Например, руководствуясь только DRY, вы можете создать один объект, рассылающий почту и рассчитывающий налог. Если нигде больше в коде нет других объектов, с аналогичной функциональностью — условие удовлетворено. SRP же заставит вас разделить ответственности, возложив их на разные объекты.

Принцип ISP (Interface segregation principle) утверждает, что:

Клиенты не должны зависеть от методов, которые они не используют.Неожиданно, с этим принципом у меня возникли самые большие проблемы. Он чем-то похож на YAGNI — «клиенту могут и не понадобятся эти методы интерфейса». С другой стороны у него очень много и от SRP — «один интерфейс для одной задачи». Его можно было бы отнести к обобщению «Сложность» и поставить на один уровень с YAGNI и KISS, но эти два принципа более абстрактны.

SRP и ISP являются частью другого известного принципа — SOLID и по началу меня волновало, что в моей пирамиде эти принципы оказались отделены от остальных. Однако в конечном итоге я решил, что не все

Сильная связанность или зацепление (high cohesion) — это метрика, показывающая, насколько хорошо код сгруппирован по функционалу. Выполнение принципов DRY и SRP ведет к коду с сильной связностью, в котором части, выполняющие одну и ту же задачу расположены «близко» друг к другу, а разные — изолированы. Выполнение ISP тоже ведет к сильной связности, хотя это и не так очевидно. Разделяя один интерфейс на более мелкие части вы группируете их по функционалу, оставляя в каждом интерфейсе только наиболее связанные между собой методы.

Зависимости: IoC, DIP, loose coupling

После того, как мы разделили систему на достаточно простые компоненты, мы можем перейти к отношениям между этими компонентами — к зависимостям. Сложность и количество связей между различными компонентами приложения так же во многом влияет на ее архитектуру. Для управления зависимостями между компонентами тоже существуют свои принципы.

IoC (Inversion of control) предполагает наличие некоторого фреймворка, который будет передавать управление компонентам нашей программы в нужный момент. При этом компоненты могут ничего не знать друг о друге.

DIP (Dependency inversion principle) гласит:

Модули верхних уровней не должны зависеть от модулей нижних уровней. Оба типа модулей должны зависеть от абстракций. Абстракции не должны зависеть от деталей. Детали должны зависеть от абстракций.Слабая связность (loose coupling) — это не принцип, а метрика, показывающая, насколько компоненты системы независимы друг от друга. Слабо связанные компоненты не зависят от внешних изменений и легко могут быть использованы повторно. IoC и DIP являются средствами для достижения слабой связности компонентов в системе.

Расширение: OCP, LSP

Требования к разрабатываемой системе со временем могут меняться и дополняться, поэтому необходимо закладывать возможность расширения функционала с самого начала. Но при этом не следует слишком увлекаться, так как нам требуется выполнить базовый принцип YAGNI. То есть необходимо найти некоторый баланс между возможностью будущего расширения и текущей сложности реализации.

Принципами, относящимися к расширению функционала, являются OCP (Open/closed principle) и LSP (Liskov substitution principle).

OCP определяет, что

программные сущности (классы, модули, функции и т. п.) должны быть открыты для расширения, но закрыты для измененияА LSP:

Функции, которые используют базовый тип, должны иметь возможность использовать подтипы базового типа, не зная об этом.Грамотная реализация этих принципов позволит в будущем изменять (расширять) функционал приложения не изменяя уже написанный код, а создавая новый.

Методологии: TDD, DDD, BDD

Помимо принципов, существует еще довольно большой набор методологий, например BDD (Behavior-driven development) и TDD (Test-driven development). В общем случае методология, в отличие от принципа, определяет некоторый процесс, применяемый к разработке приложения.

Методологии очень разнообразны, решают разные задачи и часто, при разработке приложения, используется их комбинация. Но какую бы из них вы ни выбрали, у вас возникнут серьезные проблемы, если попытаться применить их к коду, нарушающему предыдущие принципы. Например: легко ли будет применить TDD и писать тесты для кода, который нарушает DIP и содержит ссылки на конкретные реализации?

Архитектурные стили и фреймворки

Чтобы было понятно — о чем здесь идет речь, неплохой, но далеко не исчерпывающий список архитектурных стилей можно найти в документации Microsoft. Часто они довольно ортогональны друг другу и могут быть использованы совместно. Каждый из них обычно представляет собой проверенный временем и множество раз с успехом реализованный подход к построению архитектуры.

Фреймворки упомянуты здесь потому, что они заставляют вас использовать определенный архитектурный стиль, хотите вы этого или нет. Собственно, это и отличает фреймворк от прикладной библиотеки. Многие хорошие фреймворки построены на принципах IoC, упрощают тестирование и содержат возможности расширения собственного функционала. То есть, по сути, они располагаются «поверх» всех предыдущих уровней и должны поддерживать и соответствовать им.

Библиотеки и инструменты

На самой вершине пирамиды располагаются конкретные прикладные библиотеки и инструменты, которые вы используете каждый день для логирования, операций над матрицами и вывода красивых всплывающих окон. Эти библиотеки решают конкретные подзадачи и не должны влиять на архитектуру в целом. Выбор той или иной библиотеки должен основываться на предыдущих уровнях пирамиды, а не наоборот.

Чисто геометрически этот уровень самый маленький по размеру, но по иронии именно он зачастую вызывает больше всего споров, обсуждений и статей.

Зачем все это нужно?

На мой взгляд пирамида может помочь при проектировании системы с нуля или внесении изменений в существующую. Для себя я представляю это в виде некоторого чек-листа с вопросами для каждого уровня пирамиды, на которые нужно ответить последовательно.

Если изменения вносятся в существующую систему, то он примерно таков:

1. Реализуемы ли мои изменения с учетом отведенного мне бюджета, времени и прочих объективных ограничений?

2. Не противоречат ли они бизнес-требованиям?

3. Достаточно ли просто то, что я собираюсь сделать? Есть ли более простые способы сделать это?

4. Как мне разделить мою задачу на компоненты (подзадачи) так, чтобы каждый из компонентов выполнял только одно действие? Не дублирую ли я уже существующий функционал?

5. Как мои компоненты будут связаны с остальной программой? Как уменьшить количество связей? Буду ли я иметь возможность использовать мои компоненты повторно или заменить один компонент на другой в будущем?

6. Смогу ли я расширить функционал моих компонентов, не изменяя их? Заложил ли я возможности расширения в те компоненты, вероятность изменения которых в будущем особенно велика?

7. Не противоречат ли мои изменения выбранной мной методологии?

8. Соотносятся ли мои изменения с лучшими практиками используемого мной фреймворка? Не нарушают ли они общий архитектурный стиль моего кода?

9. Могут ли использованные мной библиотеки решить поставленную подзадачу?

Каждый пункт списка соотносится с определенным уровнем пирамиды. При этом выбор, сделанный на каждом уровне не должен противоречить выбору, сделанному на предыдущих уровнях. Это особенно важно при проектировании системы с нуля, когда «неопределенность» в плане будущей архитектуры гораздо выше и шире возможный выбор.

Так, например, выбранная вами библиотека не должна конфликтовать с используемым фреймворком. Если это происходит — вы меняете библиотеку, а не фреймворк. Фреймворк должен поддерживать (или хотя бы делать возможным) использование выбранной на предыдущем этапе методологии и так далее.

В целом понимание иерархии фокусирует вас на более базовых принципах (нижних ступенях). Кроме того изучение связей между элементами пирамиды позволяет лучше понять картину «в целом», обобщить и систематизировать свои знания. Для более глубокого понимания какого-либо нового принципа его будет полезно попытаться включить в эту систему, понять — на каком уровне он должен располагаться.

Заключение

Эта статья достаточно субъективна и не претендует на исчерпывающее описание всех существующих принципов и методологий. Более того, уже во время написания первого черновика, пара принципов переместилась со своих насиженных мест на другие уровни. Возможно, со временем пирамида будет дополнена новыми элементами или даже уровнями. Если вам кажется, что в ней что-то находится не на своем месте или вы хотите дополнить ее — буду рад конструктивной критике и предложениям в комментариях.

|

|

[Из песочницы] Plugin for HANA Database project in Visual Studio |

|

Метки: author Peiman visual studio .net hana tfs |

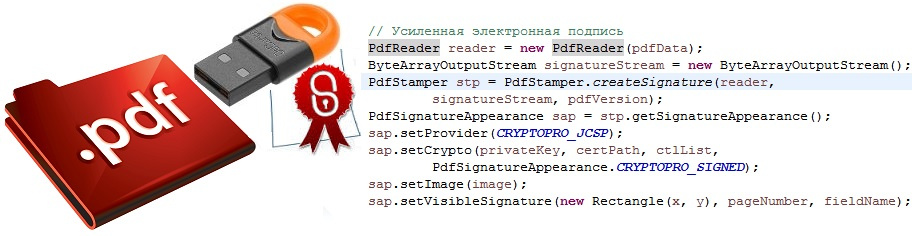

Как на Java c помощью КриптоПро подписать документ PDF |

Как на Java c помощью КриптоПро подписать документ PDF

Привет! Я сотрудник Альфа-Банка и занимаюсь разработкой программного обеспечения со встроенными средствами криптографической защиты информации.

В данной статье хочу рассказать о следующих вещах:

- преимуществах формата PDF в качестве документа с электронной подписью;

- платформе Java, библиотеке itextpdf и СКЗИ КриптоПро CSP, как инструментах подписи;

- о том, с какими трудностями пришлось столкнуться, о доработке itextpdf;

- привести пример кода, выполняющего несколько подписей;

- поговорить о целесообразности использования формата PDF в качестве документа с подписью.

В современном информационном мире значимость электронной подписи и предоставляемых ею основных сервисов (целостность данных, и неотрекаемость авторства) сложно переоценить. Государственные органы, физические и юридические лица широко применяют электронную подпись в потоках обмена информацией между собой.

Согласно законодательству, электронная подпись может придать документам юридическую силу, равную по значимости бумажному носителю, подписанному собственноручной подписью и скрепленного печатью правомочного лица.

Преимущества PDF

В качестве контейнера для хранения разнообразной информации в дружественном для человека представлении формат PDF по праву завоевал свою популярность. Его получится открыть в любой ОС. Документ PDF может содержать не только текстовые и табличные данные, но и аудио и видеозаписи, инженерную графику, трехмерные модели. Для дополнительной обработки PDF-документов в данный формат включен такой мощный инструмент как поддержка JavaScript для изменения содержимого в формах и полях по наступлению какого-то события или выполнению действия пользователя.

Инструменты Adobe Systems (разработчика формата PDF) поддерживают использование электронной подписи. В отличие от сообщений с присоединенной усиленной электронной подписью стандарта PKCS#7 и его усовершенствования CAdES, для просмотра документа PDF с подписью не требуется дополнительное специальное ПО. Кроме криптографического провайдера, который требуется во всех случаях.

Т.е. инструменты Adobe позволяют визуализировать электронную подпись в документе.

При подписании документа PDF можно задать параметры визуализации, указать номер страницы, размер блока с подписью, имя поля, куда ее поместить, добавить графическое изображение, например, логотип компании, скан собственноручной подписи руководителя и печати организации.

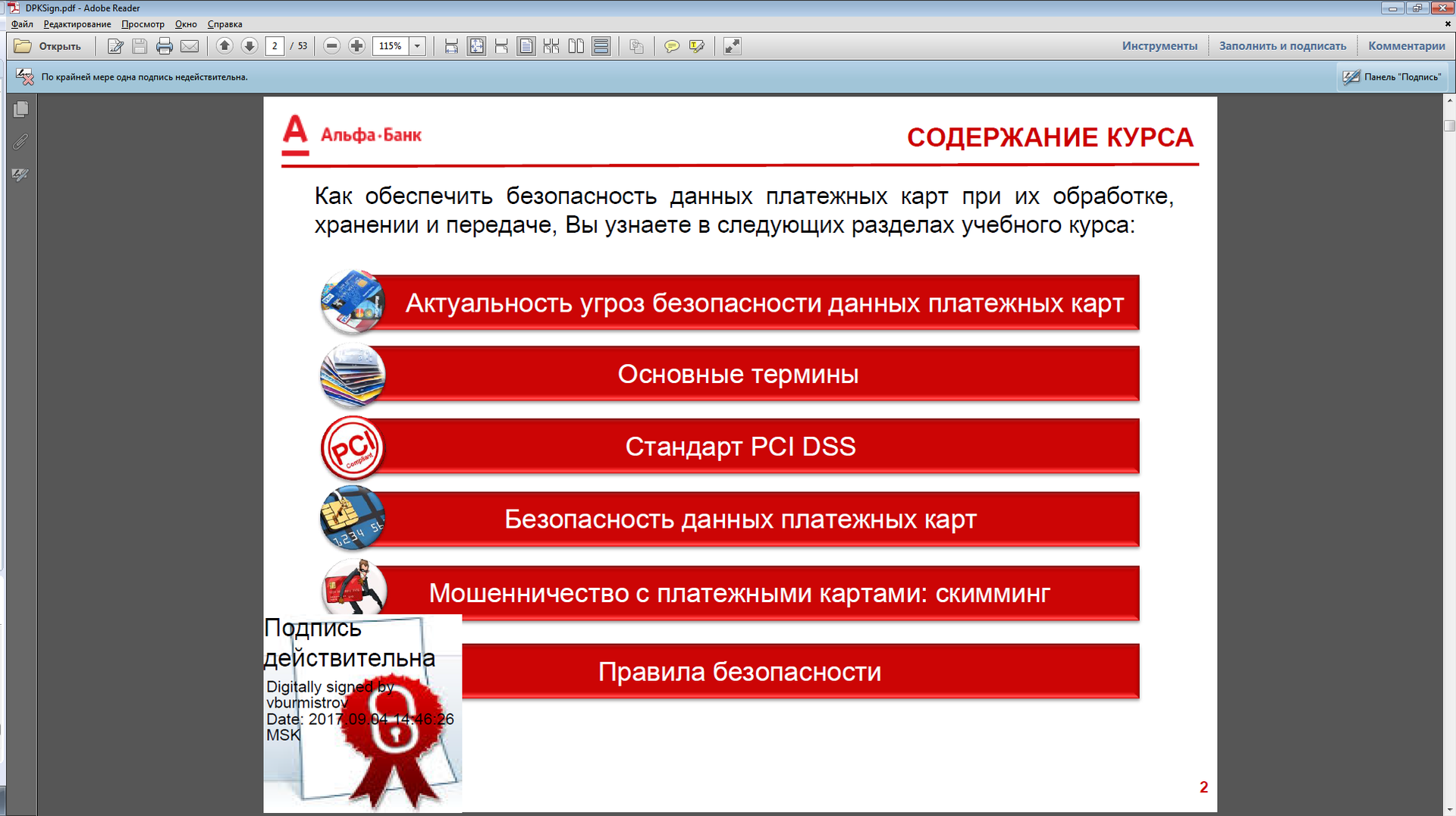

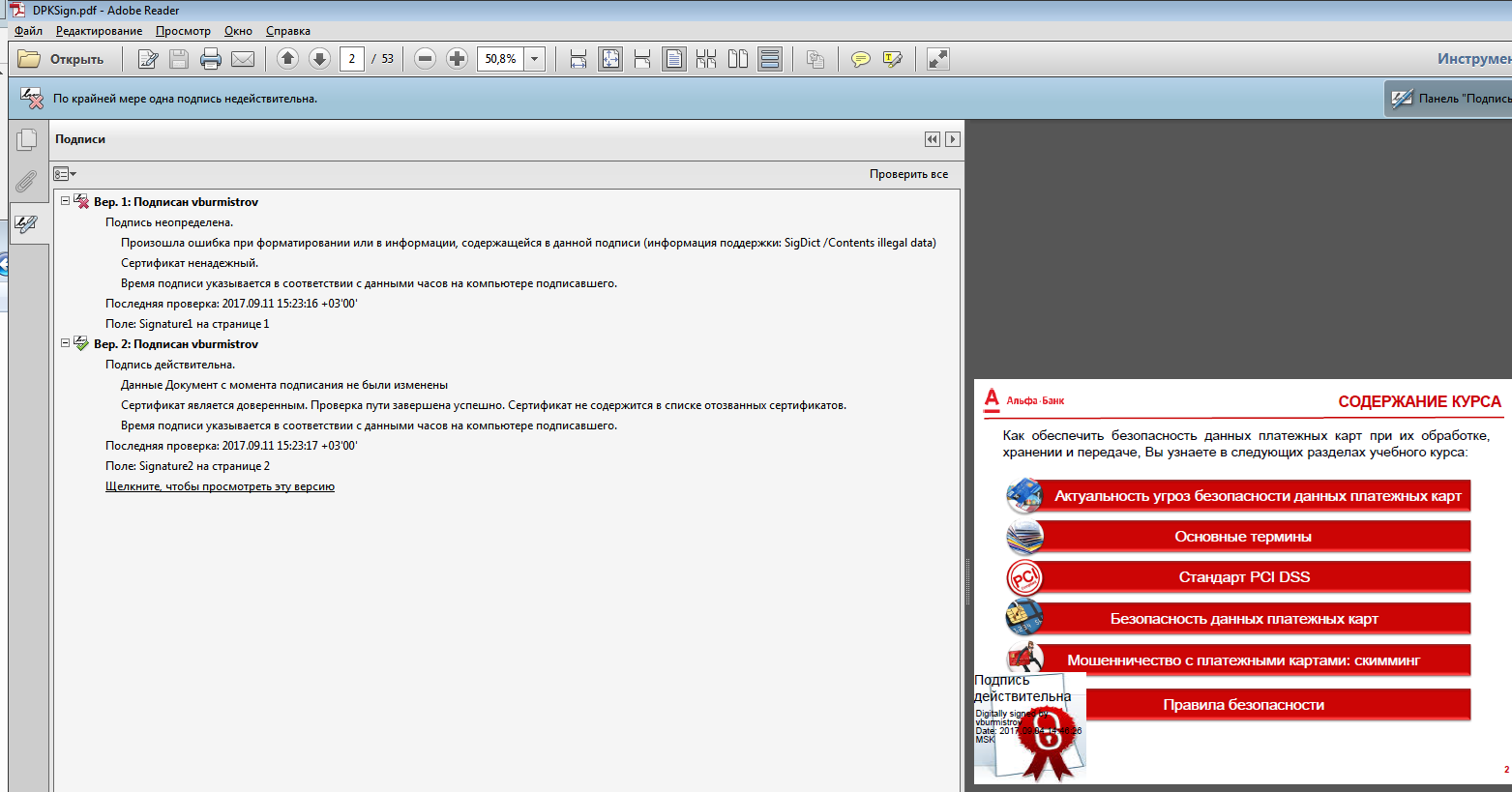

При просмотре таких документов, кроме визуализации в теле документа, программы Acrobat и Adobe Reader отображают вкладку «Подписи» с сопутствующей информацией: значок, показывающий статус проверки подписи, сведения о том, был ли изменен документ, результат проверки сертификата открытого ключа, время последней проверки, страницу и поле, содержащие электронную подпись.

Инструменты подписи

Использовалась версия Java: «1.8.0_111» HotSpot(TM) 64-Bit Server VM (build 25.111-b14).

В качестве сертифицированного средства защиты информации от лицензированного разработчика применяем криптографический провайдер КриптоПро CSP v4.0 и КриптоПро JCP – v.2.0, с установкой модуля КриптоПро Java CSP v.4.0

Почему КриптоПро JCP – v.2.0, с модулем КриптоПро Java CSP v.4.0?

Потому, что провайдер КриптоПро JCP после длительного несертифицированного периода получил сертификат соответствия от регулятора до 31.12.2018, а дальше, по информации от разработчика, с сертификацией может вновь возникнуть неопределенность. Модуль КриптоПро Java CSP v.4.0 не выполняет в себе криптографических преобразований и является по сути API к провайдеру КриптоПро CSP, с очередной сертификацией которого вопросов нет. Здесь нужно сказать, что действующий сертификат на СКЗИ не обязателен при условии использования криптографического провайдера исключительно для внутренних целей.

В соответствии со спецификацией Java Cryptography Architecture (JCA), в своем приложении я указываю и использую функции криптографического провайдера: JCSP. После установки КриптоПро, данный провайдер отображается в списке всех доступных в файле ../java/jdk1.8.x_xxx/jre/lib/security/java.security, где можно настраивать, который из них предпочтительнее для использования по умолчанию, если явно не указано в приложении:

#

# List of providers and their preference orders (see above):

#

security.provider.1=ru.CryptoPro.JCSP.JCSPНе забываем, что должны быть сняты экспортные ограничения платформы Java, которые блокируют работу криптографических провайдеров с российскими алгоритмами шифрования.

Для этого в ../java/jdk1.8.x_xxx/jre/lib/security необходимо заменить файлы local_policy.jar и US_export_policy.jar на предоставленные по адресу: Java Cryptography Extension (JCE) Unlimited Strength Jurisdiction Policy Files 8 Download

и содержащие в default_local.policy и default_US_export.policy:

grant {

// There is no restriction to any algorithms.

permission javax.crypto.CryptoAllPermission;

};

Применение библиотеки iText itextpdf.com для работы с PDF документами на Java было продиктовано провайдером КриптоПро.

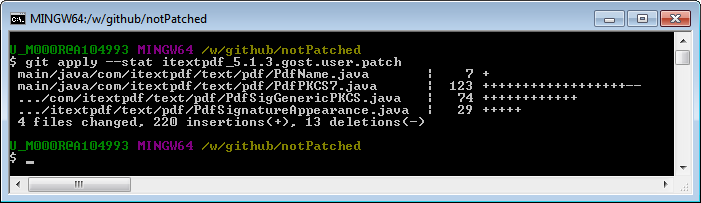

В составе КриптоПро JCP поставляется файл Git patch для библиотеки iTextpdf версии 5.1.3 —

jcp-2.0.xxxxx\Doc\itextpdf\ itextpdf_5.1.3.gost.user.patch

Патч адаптирует itextpdf к работе с провайдером КриптоПро. Необходимо скачать исходный код библиотеки версии 5.1.3, затем с помощью командной строки Bash системы управления версиями Git применить патч: git apply --stat itextpdf_5.1.3.gost.user.patch

Далее нужно собрать полученную библиотеку из обновленного исходного кода и подключить к приложению.