Добавить любой RSS - источник (включая журнал LiveJournal) в свою ленту друзей вы можете на странице синдикации.

Исходная информация - http://habrahabr.ru/rss/.

Данный дневник сформирован из открытого RSS-источника по адресу http://feeds.feedburner.com/xtmb/hh-full, и дополняется в соответствии с дополнением данного источника. Он может не соответствовать содержимому оригинальной страницы. Трансляция создана автоматически по запросу читателей этой RSS ленты.

По всем вопросам о работе данного сервиса обращаться со страницы контактной информации.

[Обновить трансляцию]

Intel научит дроны самостоятельности |

Intel научит дроны самостоятельности

28 августа компания Intel представила визуальный процессор (VPU) Myriad X, который разработан специально для автономных интеллектуальных устройств. Главная особенность чипа — встроенный аппаратный ускоритель для нейросетей (Neural Compute Engine). Он отвечает за обучение искусственного интеллекта на периферийных устройствах, имея при этом низкое энергопотребление. Среди предложенных Intel сфер применения чипа числятся дроны, системы безопасности и наблюдения, VR/AR и другие устройства.

/ Flickr / Bidgee / CC

По словам разработчиков, Myriad X — первая в мире однокристальная система, специально «заточенная» под ускоренное глубокое обучение. Neural Compute Engine помогает устройствам видеть, интерпретировать и реагировать на окружающую среду в реальном времени. С ускорителем производительность Myriad X достигает триллиона операций в секунду (TOPS).

«Мы близки к тому, чтобы машинное зрение и глубокое обучение вошли в число стандартных требований к миллиардам ежедневно окружающих нас устройств», — сказал Реми Эль-Уаззани (Remi El-Ouazzane), вице-президент и генеральный менеджер Movidius, компании-разработчика чипов семейства Myriad.

Архитектура VPU-чипа Movidius Myriad X VPU состоит из нескольких специализированных вычислительных устройств. Это несколько процессоров общего назначения, наряду с 16 процессорами SHAVE (Streaming Hybrid Architecture Vector Engine). Последние работают совместно с нейронным вычислительным движком.

Процессоры SHAVE состоят из шестнадцати программируемых 128-битных векторных процессоров VLIW, конфигурируемых шин MIPI, аппаратных ускорителей и централизованной архитектуры встроенной памяти.

В своем личном обращении Эль-Уаззани рассказывает, как устройства, наделенные искусственным интеллектом, сделают «наш мир безопаснее и продуктивнее». Автономные дроны-курьеры, камеры безопасности с полным пониманием происходящего и роботы с расширенным спектром реакций — в теории это возможно с Myriad X, поскольку глубокое обучение выполняется на уровне устройства без связи с облаком.

«В этом и заключается мощь визуального процессора — платформы, специально разработанной для решения задач автономных устройств. VPU обеспечивает высокую вычислительную мощность там, где раньше она была недостижима», — заключает Реми.

Применение VPU

Однако наиболее вероятной сферой применения нового чипа в Intel видят беспилотники. Дроны становятся умнее. Например, Spark — мини-дрон от DJI — оборудован набором из камер и датчиков и процессором Vision Movivius Myriad 2, который помогает интеллектуальной системе бортового зрения обнаруживать и избегать столкновения с объектами, создавать 3D-карты, распознавать лица и жесты.

И достигнутый уровень развития — не предел. По словам Кормака Брика (Cormac Brick), руководителя по бортовым системам искусственно интеллекта в Movidius, дроны учатся думать и реагировать.

«В будущем вы сможете достать дрон из кармана, запустить его в воздух и оставить летать вокруг двора, пока вы жарите барбекю, — рассказывает Брик, — а через час он отправит на ваш телефон 45-секундный видеоклип или 10 лучших снимков, чтобы вы могли поделиться ими в социальных сетях».

Movidius видят применение своим чипам и в сфере безопасности. В этом году их процессор Myriad 2 уже был интегрирован в камеры видеонаблюдения Dahua. Эти камеры далеко шагнули от традиционных технологий мониторинга и записи. Они обладают расширенными функциями анализа видео: мониторят плотность толпы, распознают лица, имеют стереоскопическое зрение, могут обнаруживать неправильно припаркованные автомобили.

Есть и еще одно применение VPU нового поколения. В июле Intel представили мобильный модуль Movidius Neural Compute Stick с разъемом USB 3.0. Его задача — обучение искусственного интеллекта на различных устройствах. Характеристики и особенности те же: низкое энергопотребление при высокой производительности, компактность, офлайн-режим работы, нацеленность на приложения машинного зрения.

Акцент на AI

По данным Accenture, рынок AI в 12 развитых странах удвоит темпы роста к 2035 году. Например, только в Китае к 2020 году собираются установить 450 млн новых камер видеонаблюдения с системами распознавания лиц. К слову, компания Dahua Technology, которая уже экспериментировала с процессором Myriad 2, занимает второе место на рынке камер наблюдения и базируется в Ханчжоу.

На AI-рынке у Intel до выхода Myriad X было несколько серьезных противников: Qualcomm Neural Processing Engine, процессор Google TPU 2.0, предназначенный для обучения нейронных сетей, и NVIDIA Tesla V100. По мнению аналитиков Seeking Alpha, самую серьезную конкуренцию Intel на рынке машинного обучения, который достигнет $5 млрд к 2021 году, составляет именно NVIDIA.

Однако вскоре могут появиться и другие сильные конкуренты. В августе компания Microsoft представила проект Brainwave. Это платформа для глубокого обучения AI в реальном времени с низкой задержкой в обработке запросов. Архитектура Brainwave поддерживает выполнение более 130 тыс. вычислений за цикл. Работа в этом направлении вскоре позволит применять нейронные сети для выполнения бытовых задач.

О компании Movidius

Компания Movidius разрабатывает визуальные процессоры для интернета вещей. Штаб-квартира располагается в Сан-Матео, Калифорния. В сентябре 2016 года была приобретена компанией Intel.

P.S. А вот еще несколько статей из нашего блога:

|

Метки: author 1cloud разработка для интернета вещей блог компании 1cloud.ru 1cloud myriad x intel movidius |

[Перевод] Spring: ваш следующий Java микрофреймворк |

Spring: ваш следующий Java микрофреймворк

- Перевод

В этой статье мы поговорим о новой концепции в готовящемся к выходу Spring Framework 5 которая называется функциональный веб-фреймворк и посмотрим, как она может помочь при разработке легковесных приложений и микросервисов.

Вы, возможно, удивлены видеть Spring и микрофреймворк в одном предложении. Но все верно, Spring вполне может стать вашим следующим Java микрофреймворком. Чтобы избежать недоразумений, давайте определим, что им имеем в виду под микро:

- Лаконичный — минимум бойлерплейта, минимум настройки

- Простой — без магии

- Простой в деплойменте — один артефакт для деплоймента

- Простой в запуске — без дополнительных зависимостей

- Легковесный — минимальное использование памяти / CPU

- Неблокирующий — для написания конкуррентных неблокирующих приложений

Несмотря на то, что некоторые из этих пунктов актуальны при использовании Spring Boot, он сам по себе добавляет дополнительную магию поверх самого Spring Framework. Даже такие базовые аннотации, как @Controller не совсем прямолинейны, что уж говорить про авто-конфигурации и сканирование компонентов. В общем-то, для крупномасштабных приложений, просто незаменимо то, что Spring берет на себя заботу о DI, роутинге, конфигурации и т.п. Однако, в мире микросервисов, где приложения это просто шестеренки в одной больной машине, вся мощь Spring Boot может быть немного лишней.

Для решения этой проблемы, команда Spring представила новую фичу, которая называется функциональный веб-фреймворк — и именно о ней мы и будем говорить. В целом, это часть большего под-проекта Spring WebFlux, который раньше назывался Spring Reactive Web.

Для начала, давайте вернемся к основам и посмотрим, что такое веб-приложение и какие компоненты мы ожидаем иметь в нем. Несомненно, есть базовая вещь — веб-сервер. Чтобы избежать ручной обработки запросов и вызова методов приложения, нам пригодится роутер. И, наконец, нам нужен обработчик — кусок кода, который принимает запрос и отдает ответ. По сути, это все, что нужно! И именно эти компоненты предоставляет функциональный веб-фреймворк Spring, убирая всю магию и фокусируясь на фундаментальном минимуме. Отмечу, что это вовсе не значит, что Spring резко меняет направление и уходит от Spring MVC, функциональный веб просто дает еще одну возможность создавать приложения на Spring.

Обработчик

Давайте рассмотрим пример. Для начала, пойдем на Spring Initializr и создадим новый проект используя Spring Boot 2.0 и Reactive Web как единственную зависимость. Теперь мы можем написать наш первый обработчик — функцию которая принимает запрос и отдает ответ.

HandlerFunction hello = new HandlerFunction() {

@Override

public Mono handle(ServerRequest request) {

return ServerResponse.ok().body(fromObject("Hello"));

}

};Итак, наш обработчик это просто реализация интерфейса HandlerFunction который принимает параметр request (типа ServerRequest) и возвращает объект типа ServerResponse с текстом "Hello". Spring так же предоставляет удобные билдеры чтобы создать ответ от сервера. В нашем случае, мы используем ok() которые автоматически возвращают HTTP код ответа 200. Чтобы вернуть ответ, нам потребуется еще один хелпер — fromObject, чтобы сформировать ответ из предоставленного объекта.

Мы так же можем сделать код немного более лаконичным и использовать лямбды из Java 8 и т.к. HandlerFunction это интерфейс одного метода (single abstract method interface, SAM), мы можем записать нашу функцию как:

HandlerFunction hello = request -> ServerResponse.ok().body(fromObject("Hello"));Роутер

Теперь, когда у нас есть хендлер, пора определить роутер. Например, мы хотим вызвать наш обработчик когда URL "/" был вызван с помощью HTTP метода GET. Чтобы этого добиться, определим объект типа RouterFunction который мапит функцию-обработчик, на маршрут:

RouterFunction router = route(GET("/"), hello);route и GET это статические методы из классов RequestPredicates и RouterFunctions, они позволяют создать так называемую RouterFunction. Такая функция принимает запрос, проверяет, соответствует ли он все предикатам (URL, метод, content type, etc) и вызывает нужную функцию-обработчик. В данном случае, предикат это http метод GET и URL '/', а функция обработчик это hello, которая определена выше.

Веб-сервер

А сейчас пришло время собрать все вместе в единое приложение. Мы используем легковесный и простой сервер Reactive Netty. Чтобы интегрировать наш роутер с веб-сервером, необходимо превратить его в HttpHandler. После этого можно запустить сервер:

HttpServer

.create("localhost", 8080)

.newHandler(new ReactorHttpHandlerAdapter(httpHandler))

.block();ReactorHttpHandlerAdapter это класс предоставленный Netty, который принимает HttpHandler, остальной код, думаю, не требует пояснений. Мы создаем новые веб-сервер привязанный к хосту localhost и на порту 8080 и предоставляем httpHandler созданный из нашего роутера.

И это все, приложение готово! И его полный код:

public static void main(String[] args)

throws IOException, LifecycleException, InterruptedException {

HandlerFunction hello = request -> ServerResponse.ok().body(fromObject("Hello"));

RouterFunction router = route(GET("/"), hello);

HttpHandler httpHandler = RouterFunctions.toHttpHandler(router);

HttpServer

.create("localhost", 8080)

.newHandler(new ReactorHttpHandlerAdapter(httpHandler))

.block();

Thread.currentThread().join();

}Последняя строчка нужна только чтобы держать JVM процесс живым, т.к. сам HttpServer его не блокирует. Вы возможно сразу обратите внимание, что приложение стартует мгновенно — там нет ни сканирования компонентов, ни авто-конфигурации.

Мы так же может запустить это приложение как обычное Java приложение, не требуется никаких контейнеров приложений и прочего.

Чтобы запаковать приложение для деплоймента, мы можем воспользоваться преимуществами Maven плагина Spring и просто вызвать

./mvnw package

Эта команда создаст так называемый fat JAR со всеми зависимостями, включенными в JAR. Это файл может быть задеплоен и запущен не имея ничего, кроме установленной JRE

java -jar target/functional-web-0.0.1-SNAPSHOT.jar

Так же, если мы проверим использование памяти приложением, то увидим, что оно держится примерно в районе 32 Мб — 22 Мб использовано на metaspace (классы) и около 10 Мб занято непосредственно в куче. Разумеется, наше приложение ничего и не делает — но тем не менее, это просто показатель, что фреймворк и рантайм сами по себе требуют минимум системных ресурсов.

Поддержка JSON

В нашем примере, мы возвращали строку, но вернуть JSON ответ так же просто. Давайте расширим наше приложение новым endpoint-ом, который вернет JSON. Наша модель будет очень простой — всего одно строковое поле под названием name. Чтобы избежать ненужного boilerplate кода, мы воспользуемся фичей из проекта Lombok, аннотацией @Data. Наличие этой аннотации автоматически создаст геттеры, сеттеры, методы equals и hashCode, так что нам не придется релизовывать их вручную.

@Data

class Hello {

private final String name;

}Теперь, нам нужно расширить наш роутер чтобы вернуть JSON ответ при обращении к URL /json. Это можно сделать вызвав andRoute(...) метод на существующем роуте. Также, давайте вынесем код роутер в отдельную функцию, чтобы отделить его от кода приложения и позволить использовать позже в тестах.

static RouterFunction getRouter() {

HandlerFunction hello = request -> ok().body(fromObject("Hello"));

return

route(

GET("/"), hello)

.andRoute(

GET("/json"), req ->

ok()

.contentType(APPLICATION_JSON)

.body(fromObject(new Hello("world")));

}После перезапуска, приложение вернет { "name": "world" } при обращении к URL /json при запросе контента с типом application/json.

Контекст приложения

Вы, возможно, заметили, что мы не определили контекст приложения — он нам просто не нужен! Несмотря на то, что мы можем объявить RouterFunction как бин (bean) в контексте Spring WebFlux приложения, и он точно так же будет обрабатывать запросы на определенные URL, роутер можно запустить просто поверх Netty Server чтобы создавать простые и легковесные JSON сервисы.

Тестирование

Для тестирования реактивных приложений, Spring предоставляет новый клиент под названием WebTestClient (подобно MockMvc). Его можно создать для существующего контекста приложения, но так же можно определить его и для RouterFunction.

public class FunctionalWebApplicationTests {

private final WebTestClient webTestClient =

WebTestClient

.bindToRouterFunction(

FunctionalWebApplication.getRouter())

.build();

@Test

public void indexPage_WhenRequested_SaysHello() {

webTestClient.get().uri("/").exchange()

.expectStatus().is2xxSuccessful()

.expectBody(String.class)

.isEqualTo("Hello");

}

@Test

public void jsonPage_WhenRequested_SaysHello() {

webTestClient.get().uri("/json").exchange()

.expectStatus().is2xxSuccessful()

.expectHeader().contentType(APPLICATION_JSON)

.expectBody(Hello.class)

.isEqualTo(new Hello("world"));

}

}WebTestClient включает ряд assert-ов, которые можно применить к полученному ответу, чтобы провалидировать HTTP код, содержимое ответа, тип ответа и т.п.

В заключение

Spring 5 представляет новую парадигму для разработки маленьких и легковесных microservice-style веб-приложений. Такие приложения могут работать без контекста приложений, автоконфигурации и в целом использовать подход микрофреймворков, когда роутер и функции-обработчики и веб-сервер опеределены явно в теле приложения.

Код

Доступен на GitHub

Ссылки

- New in Spring 5: Functional Web Framework

- Notes on Reactive Programming Part II: Writing Some Code

- Very nice intro into Spring Functional Web from Baeldung — Introduction to the Functional Web Framework in Spring 5

- Reactive Programming with Spring 5.0 M1

- Обсуждение оригинальной статьи на Reddit

От переводчика

Я так же являюсь и автором оригинальной статьи, так что вопросы можно задавать в комментариях.

|

Метки: author alek_sys java spring spring 5 |

[Перевод] Spring: ваш следующий Java микрофреймворк |

Spring: ваш следующий Java микрофреймворк

- Перевод

В этой статье мы поговорим о новой концепции в готовящемся к выходу Spring Framework 5 которая называется функциональный веб-фреймворк и посмотрим, как она может помочь при разработке легковесных приложений и микросервисов.

Вы, возможно, удивлены видеть Spring и микрофреймворк в одном предложении. Но все верно, Spring вполне может стать вашим следующим Java микрофреймворком. Чтобы избежать недоразумений, давайте определим, что им имеем в виду под микро:

- Лаконичный — минимум бойлерплейта, минимум настройки

- Простой — без магии

- Простой в деплойменте — один артефакт для деплоймента

- Простой в запуске — без дополнительных зависимостей

- Легковесный — минимальное использование памяти / CPU

- Неблокирующий — для написания конкуррентных неблокирующих приложений

Несмотря на то, что некоторые из этих пунктов актуальны при использовании Spring Boot, он сам по себе добавляет дополнительную магию поверх самого Spring Framework. Даже такие базовые аннотации, как @Controller не совсем прямолинейны, что уж говорить про авто-конфигурации и сканирование компонентов. В общем-то, для крупномасштабных приложений, просто незаменимо то, что Spring берет на себя заботу о DI, роутинге, конфигурации и т.п. Однако, в мире микросервисов, где приложения это просто шестеренки в одной больной машине, вся мощь Spring Boot может быть немного лишней.

Для решения этой проблемы, команда Spring представила новую фичу, которая называется функциональный веб-фреймворк — и именно о ней мы и будем говорить. В целом, это часть большего под-проекта Spring WebFlux, который раньше назывался Spring Reactive Web.

Для начала, давайте вернемся к основам и посмотрим, что такое веб-приложение и какие компоненты мы ожидаем иметь в нем. Несомненно, есть базовая вещь — веб-сервер. Чтобы избежать ручной обработки запросов и вызова методов приложения, нам пригодится роутер. И, наконец, нам нужен обработчик — кусок кода, который принимает запрос и отдает ответ. По сути, это все, что нужно! И именно эти компоненты предоставляет функциональный веб-фреймворк Spring, убирая всю магию и фокусируясь на фундаментальном минимуме. Отмечу, что это вовсе не значит, что Spring резко меняет направление и уходит от Spring MVC, функциональный веб просто дает еще одну возможность создавать приложения на Spring.

Обработчик

Давайте рассмотрим пример. Для начала, пойдем на Spring Initializr и создадим новый проект используя Spring Boot 2.0 и Reactive Web как единственную зависимость. Теперь мы можем написать наш первый обработчик — функцию которая принимает запрос и отдает ответ.

HandlerFunction hello = new HandlerFunction() {

@Override

public Mono handle(ServerRequest request) {

return ServerResponse.ok().body(fromObject("Hello"));

}

};Итак, наш обработчик это просто реализация интерфейса HandlerFunction который принимает параметр request (типа ServerRequest) и возвращает объект типа ServerResponse с текстом "Hello". Spring так же предоставляет удобные билдеры чтобы создать ответ от сервера. В нашем случае, мы используем ok() которые автоматически возвращают HTTP код ответа 200. Чтобы вернуть ответ, нам потребуется еще один хелпер — fromObject, чтобы сформировать ответ из предоставленного объекта.

Мы так же можем сделать код немного более лаконичным и использовать лямбды из Java 8 и т.к. HandlerFunction это интерфейс одного метода (single abstract method interface, SAM), мы можем записать нашу функцию как:

HandlerFunction hello = request -> ServerResponse.ok().body(fromObject("Hello"));Роутер

Теперь, когда у нас есть хендлер, пора определить роутер. Например, мы хотим вызвать наш обработчик когда URL "/" был вызван с помощью HTTP метода GET. Чтобы этого добиться, определим объект типа RouterFunction который мапит функцию-обработчик, на маршрут:

RouterFunction router = route(GET("/"), hello);route и GET это статические методы из классов RequestPredicates и RouterFunctions, они позволяют создать так называемую RouterFunction. Такая функция принимает запрос, проверяет, соответствует ли он все предикатам (URL, метод, content type, etc) и вызывает нужную функцию-обработчик. В данном случае, предикат это http метод GET и URL '/', а функция обработчик это hello, которая определена выше.

Веб-сервер

А сейчас пришло время собрать все вместе в единое приложение. Мы используем легковесный и простой сервер Reactive Netty. Чтобы интегрировать наш роутер с веб-сервером, необходимо превратить его в HttpHandler. После этого можно запустить сервер:

HttpServer

.create("localhost", 8080)

.newHandler(new ReactorHttpHandlerAdapter(httpHandler))

.block();ReactorHttpHandlerAdapter это класс предоставленный Netty, который принимает HttpHandler, остальной код, думаю, не требует пояснений. Мы создаем новые веб-сервер привязанный к хосту localhost и на порту 8080 и предоставляем httpHandler созданный из нашего роутера.

И это все, приложение готово! И его полный код:

public static void main(String[] args)

throws IOException, LifecycleException, InterruptedException {

HandlerFunction hello = request -> ServerResponse.ok().body(fromObject("Hello"));

RouterFunction router = route(GET("/"), hello);

HttpHandler httpHandler = RouterFunctions.toHttpHandler(router);

HttpServer

.create("localhost", 8080)

.newHandler(new ReactorHttpHandlerAdapter(httpHandler))

.block();

Thread.currentThread().join();

}Последняя строчка нужна только чтобы держать JVM процесс живым, т.к. сам HttpServer его не блокирует. Вы возможно сразу обратите внимание, что приложение стартует мгновенно — там нет ни сканирования компонентов, ни авто-конфигурации.

Мы так же может запустить это приложение как обычное Java приложение, не требуется никаких контейнеров приложений и прочего.

Чтобы запаковать приложение для деплоймента, мы можем воспользоваться преимуществами Maven плагина Spring и просто вызвать

./mvnw package

Эта команда создаст так называемый fat JAR со всеми зависимостями, включенными в JAR. Это файл может быть задеплоен и запущен не имея ничего, кроме установленной JRE

java -jar target/functional-web-0.0.1-SNAPSHOT.jar

Так же, если мы проверим использование памяти приложением, то увидим, что оно держится примерно в районе 32 Мб — 22 Мб использовано на metaspace (классы) и около 10 Мб занято непосредственно в куче. Разумеется, наше приложение ничего и не делает — но тем не менее, это просто показатель, что фреймворк и рантайм сами по себе требуют минимум системных ресурсов.

Поддержка JSON

В нашем примере, мы возвращали строку, но вернуть JSON ответ так же просто. Давайте расширим наше приложение новым endpoint-ом, который вернет JSON. Наша модель будет очень простой — всего одно строковое поле под названием name. Чтобы избежать ненужного boilerplate кода, мы воспользуемся фичей из проекта Lombok, аннотацией @Data. Наличие этой аннотации автоматически создаст геттеры, сеттеры, методы equals и hashCode, так что нам не придется релизовывать их вручную.

@Data

class Hello {

private final String name;

}Теперь, нам нужно расширить наш роутер чтобы вернуть JSON ответ при обращении к URL /json. Это можно сделать вызвав andRoute(...) метод на существующем роуте. Также, давайте вынесем код роутер в отдельную функцию, чтобы отделить его от кода приложения и позволить использовать позже в тестах.

static RouterFunction getRouter() {

HandlerFunction hello = request -> ok().body(fromObject("Hello"));

return

route(

GET("/"), hello)

.andRoute(

GET("/json"), req ->

ok()

.contentType(APPLICATION_JSON)

.body(fromObject(new Hello("world")));

}После перезапуска, приложение вернет { "name": "world" } при обращении к URL /json при запросе контента с типом application/json.

Контекст приложения

Вы, возможно, заметили, что мы не определили контекст приложения — он нам просто не нужен! Несмотря на то, что мы можем объявить RouterFunction как бин (bean) в контексте Spring WebFlux приложения, и он точно так же будет обрабатывать запросы на определенные URL, роутер можно запустить просто поверх Netty Server чтобы создавать простые и легковесные JSON сервисы.

Тестирование

Для тестирования реактивных приложений, Spring предоставляет новый клиент под названием WebTestClient (подобно MockMvc). Его можно создать для существующего контекста приложения, но так же можно определить его и для RouterFunction.

public class FunctionalWebApplicationTests {

private final WebTestClient webTestClient =

WebTestClient

.bindToRouterFunction(

FunctionalWebApplication.getRouter())

.build();

@Test

public void indexPage_WhenRequested_SaysHello() {

webTestClient.get().uri("/").exchange()

.expectStatus().is2xxSuccessful()

.expectBody(String.class)

.isEqualTo("Hello");

}

@Test

public void jsonPage_WhenRequested_SaysHello() {

webTestClient.get().uri("/json").exchange()

.expectStatus().is2xxSuccessful()

.expectHeader().contentType(APPLICATION_JSON)

.expectBody(Hello.class)

.isEqualTo(new Hello("world"));

}

}WebTestClient включает ряд assert-ов, которые можно применить к полученному ответу, чтобы провалидировать HTTP код, содержимое ответа, тип ответа и т.п.

В заключение

Spring 5 представляет новую парадигму для разработки маленьких и легковесных microservice-style веб-приложений. Такие приложения могут работать без контекста приложений, автоконфигурации и в целом использовать подход микрофреймворков, когда роутер и функции-обработчики и веб-сервер опеределены явно в теле приложения.

Код

Доступен на GitHub

Ссылки

- New in Spring 5: Functional Web Framework

- Notes on Reactive Programming Part II: Writing Some Code

- Very nice intro into Spring Functional Web from Baeldung — Introduction to the Functional Web Framework in Spring 5

- Reactive Programming with Spring 5.0 M1

- Обсуждение оригинальной статьи на Reddit

От переводчика

Я так же являюсь и автором оригинальной статьи, так что вопросы можно задавать в комментариях.

|

Метки: author alek_sys java spring spring 5 |

[Из песочницы] Stateless аутентификация при помощи Spring Security и JWT |

Stateless аутентификация при помощи Spring Security и JWT

Я не буду рассказывать, что это за «волшебные» токены, как они работают и зачем они нужны. Я хочу сосредоточиться на вопросах, которые встают перед многими, но не имеют однозначного правильного ответа. Мое решение не претендует на лучшее и эта статья не является пошаговым руководством, я просто хочу поделиться своим опытом и постараться обьяснить, почему я сделал именно так и никак иначе.

Для работы с токенами я выбрал библиотеку JJWT, хотя в принципе все реализации библиотек довольно похожи по своей функциональности. Также было решено не создавать сервер авторизации, а выдавать/обновлять/проверять токены непосредственно из приложения. Кстати немного о приложении, это одностраничное приложение (AngularJS) с RESTful Web-сервисом (Spring) в back-end.

Выдавать токены на долгий срок не хотелось, так как в случае с JWT права пользователя хранятся в токене, и изменения в правах пользователя не подействуют до повторной авторизации и получения нового токена. Можно конечно хранить в токене только идентификатор пользователя, а остальные данные читать из базы данных при каждом запросе, но это повлечет слишком большое количество лишних запросов к базе данных, поэтому от этого варианта я сразу отказался. Нужно было задуматься об обновлении короткоживущих токенов.

Для обновления access токена можно использовать refresh токен с более длительным временем до истечения, который получает новые данные пользователя по его идентификатору из базы данных и создает новый access токен на их основе. Но как быть с refresh токеном, если он также выдан на не очень долгое время и истечет во время сеанса пользователя? Повторный запрос авторизационных данных во время сеанса не очень хорошее решение в плане UX, а обновление истекшего токена плохо скажется на безопастности. Нужно было найти другое решение, но к этому вопросу я вернусь немного позже. Для начала нужно определиться с временем «жизни» для токенов и я остановился на 10 минутах для access токена и 60 минутах, с возможностью продления в перспективе, для refresh токена.

С хранением и обновлением токенов на стороне пользователя, тоже все неоднозначно. Обычно для их хранения используeтся локальное хранилище или cookies. У каждого из этих вариантов есть свои плюсы и минусы, каждый из них подвержен разного вида уязвимостям, но мой выбор остановился на втором варианте.

В случае с локальным хранилищем, обычно способом передачи токенов между back-end и front-end является добавление их в header или в тело запроса/ответа. То есть, мне пришлось бы вносить изминения и во front-end, для получения токенов, сохранения их в локальное хранилище, добавления к запросам, обновления и т.д., тогда как в случае с cookies их можно добавлять/изменять/удалять непосредственно из back-end.

Думаю, самое время перейти от теории к практике и показать, как это все реализовано у меня. Не хочу загружать статью лишним кодом, выкладывая все классы полностью, поэтому постараюсь выделить только самое важное. Если вас заинтересуют какие-либо подробности, которые остались «за кадром», спрашивайте, и я с радостью отвечу вам в комментариях или дополню статью.

Естественно, взаимодействие с приложением начинается с авторизации. Пользователь авторизуется с помощью метода в @RestController, в котором вызывается метод из TokenAuthenticationService для создания токенов и добавления их в ответ сервера в виде cookies (access_token и refresh_token).

@RequestMapping(value = "/login", produces = "application/json", method = RequestMethod.GET)

@ResponseStatus(value = HttpStatus.NO_CONTENT)

public void login(HttpServletResponse response) {

SessionUser user = (SessionUser) SecurityContextHolder.getContext().getAuthentication().getPrincipal();

tokenAuthenticationService.addAuthentication(response, user);

SecurityContextHolder.getContext().setAuthentication(null);

}SessionUser — реализация UserDetails*

Так выглядит этот метод в TokenAuthenticationService:

public void addAuthentication(HttpServletResponse response, SessionUser user) {

Cookie access = new Cookie("access_token", tokenHandler.createAccessToken(user));

access.setPath("/");

access.setHttpOnly(true);

response.addCookie(access);

Cookie refresh = new Cookie("refresh_token", tokenHandler.createRefreshToken(user));

refresh.setPath("/");

refresh.setHttpOnly(true);

response.addCookie(refresh);

}TokenHandler содержит стандартные методы для работы c JWT с использованием Jwts.builder() и Jwts.parser() из указанной выше библиотеки, поэтому не вижу смысла занимать место их кодом, но для ясности напишу что делает каждый из них:

public String createRefreshToken(SessionUser user) {

//возвращает токен, в котором хранится только username

}

public SessionUser parseRefreshToken(String token) {

//парсит username из токена и получает данные пользователя из реализации UserDetailsService

}

public String createAccessToken(SessionUser user) {

//возвращает токен, в котором хранятся все данные для воссоздания SessionUser

}

public SessionUser parseAccessToken(String token) {

//использует данные из токена для создания нового SessionUser

}UserDetailsService*

Теперь немного о том, как происходит обработка последующих запросов. В конфигурационном файле, наследованном от WebSecurityConfigurerAdapter, я добавил два известных вам bean-a:

@Bean

public TokenAuthenticationService tokenAuthenticationService() {

return new TokenAuthenticationService();

}

@Bean

public TokenHandler tokenHandler() {

return new TokenHandler();

}Запретил создание/использование сессий и добавил фильтр для аутентификации с помощью токенов:

@Override

protected void configure(HttpSecurity http) throws Exception {

http.authorizeRequests()

//Ресурсы доступные анонимным пользователям

.antMatchers("/", "/login").permitAll()

//Все остальные доступны только после аутентификации

.anyRequest().authenticated()

.and()

.sessionManagement().sessionCreationPolicy(SessionCreationPolicy.STATELESS)

.and()

.addFilterBefore(new StatelessAuthenticationFilter(tokenAuthenticationService()), UsernamePasswordAuthenticationFilter.class)

}При каждом запросе фильтр получает аутентификацию из токенов, обрабатывает запрос и обнуляет аутентификацию:

public class StatelessAuthenticationFilter extends GenericFilterBean {

private final TokenAuthenticationService tokenAuthenticationService;

public StatelessAuthenticationFilter(TokenAuthenticationService tokenAuthenticationService) {

this.tokenAuthenticationService= tokenAuthenticationService;

}

@Override

public void doFilter(ServletRequest request, ServletResponse response, FilterChain filterChain)

throws IOException, ServletException {

HttpServletRequest httpRequest = (HttpServletRequest) request;

HttpServletResponse httpResponse = (HttpServletResponse) response;

Authentication authentication = tokenAuthenticationService.getAuthentication(httpRequest, httpResponse);

SecurityContextHolder.getContext().setAuthentication(authentication);

filterChain.doFilter(request, response);

SecurityContextHolder.getContext().setAuthentication(null);

}

}Как происходит создание аутентификации:

— Присутствует access токен?За это отвечает еще один метод из уже известного вам TokenAuthenticationService:

— Нет? Отклонить запрос.

— Да?

— — Действительный и не истек?

— — Да? Разрешить запрос.

— — Нет? Попробовать получить новый access токен при помощи refresh токена.

— — — Получилось?

— — — Да? Разрешить запрос, и добавить новый access токен к ответу.

— — — Нет? Отклонить запрос.

public Authentication getAuthentication(HttpServletRequest request, HttpServletResponse response) {

Cookie[] cookies = request.getCookies();

String accessToken = null;

String refreshToken = null;

if (cookies != null) {

for (Cookie cookie : cookies) {

if (("access_token").equals(cookie.getName())) {

accessToken = cookie.getValue();

}

if (("refresh_token").equals(cookie.getName())) {

refreshToken = cookie.getValue();

}

}

}

if (accessToken != null && !accessToken.isEmpty()) {

try {

SessionUser user = tokenHandler.parseAccessToken(accessToken);

return new UserAuthentication(user);

} catch (ExpiredJwtException ex) {

if (refreshToken != null && !refreshToken.isEmpty()) {

try {

SessionUser user = tokenHandler.parseRefreshToken(refreshToken);

Cookie access = new Cookie("access_token", tokenHandler.createAccessToken(user));

access.setPath("/");

access.setHttpOnly(true);

response.addCookie(access);

return new UserAuthentication(user);

} catch (JwtException e) {

return null;

}

}

return null;

} catch (JwtException ex) {

return null;

}

}

return null;

} UserAuthentication — реализация Authentication*

Вот и все, что требуется для совместной работы Spring Security и JWT.

Но если вы не забыли, я собирался придумать что-то для продления refresh токенов. Как я уже говорил, я не хотел выдавать токены на долгий срок и в любом случае, это не спасло бы от истечения токена во время сеанса пользователя, будь это через час, день или месяц.

Первое, что пришло в голову, убрать из токена время истечения, а так как в моем случае cookies хранятся только до закрытия браузера, то токен бы просто удалялся и больше не использовался. Но здесь были свои «подводные камни», во первых в случае кражи токен мог бы использоваться неограниченное количество времени и не было бы возможности его отозвать, во вторых я хотел продлевать токен только для активного пользователя, а если пользователь просто оставит окно браузера открытым, то токен должен был истечь спустя некоторое время.

Чтобы обезопасить токен от кражи, нужно было реализовать возможность отзыва токена, поэтому я решил хранить все refresh токены в базе данных и перед выдачей новых access токенов, проверять наличие refresh токена в ней. Тогда в случае отзыва токена, достаточно удалить его из базы данных. Но это не решало моей проблемы с продлением токенов. И тогда я подумал, а что если хранить время до истечения токена не в самом токене, а в базе данных? И отодвигать это время на 60 минут вперед от каждого использования токена. Мне это показалось довольно не плохой идеей и я хотел бы поделиться с вами ее реализацией.

Я создал таблицу (refresh_token) в базе данных для хранения refresh токенов со следующими столбцами:

1. id (BIGINT)И создал класс RefreshTokenDao с двумя методами использующими JdbcTemplate для общения с этой таблицей:

2. username (VARCHAR)

3. token (VARCHAR)

4. expires (TIMESTAMP)

public void insert(String username, String token, long expires) {

String sql = "INSERT INTO refresh_token "

+ "(username, token, expires) VALUES (?, ?, ?)";

jdbcTemplate.update(sql, username, token, new Timestamp(expires));

}

public int updateIfNotExpired(String username, String token, long expiration) {

String sql = "UPDATE refresh_token "

+ "SET expires = ? "

+ "WHERE username = ? "

+ "AND token = ? "

+ "AND expires > ?";

Timestamp now = new Timestamp(System.currentTimeMillis());

Timestamp newExpirationTime = new Timestamp(now.getTime() + expiration);

return jdbcTemplate.update(sql, newExpirationTime, username, token, now);

}Методы довольно простые. Первый используется для добавления токена в базу данных при его создании. Второй для обновления токена, если он не истек и возвращения количества обновленных полей, в моем случае это количество всегда будет 0 или 1.

Используются они в классе TokenHandler. При создании токена (createRefreshToken()) я добавляю запись о нем с помощью метода insert(). А в случае когда мне нужно получить информацию из токена (parseRefreshToken()), я сначала пытаюсь вызвать updateIfNotExpired() и если в ответе получаю значение не равное 0, значит токен валиден и его дата обновилась, можно продолжать выполнение метода; а в случае, если возвращенное значение равно 0, из чего следует что токен не найден или истек, я просто выбрасываю исключение (new JwtException(«Token is expired or missing»)).

Это все что касалось продления refresh токенов. На просторах интернета я нигде не встречал такого способа (может плохо искал) и надеюсь что он будет кому-то полезен, как и вся статья в целом.

Спасибо за внимание!

|

Метки: author AnarSultanov java spring security jwt |

[Из песочницы] Stateless аутентификация при помощи Spring Security и JWT |

Stateless аутентификация при помощи Spring Security и JWT

Я не буду рассказывать, что это за «волшебные» токены, как они работают и зачем они нужны. Я хочу сосредоточиться на вопросах, которые встают перед многими, но не имеют однозначного правильного ответа. Мое решение не претендует на лучшее и эта статья не является пошаговым руководством, я просто хочу поделиться своим опытом и постараться обьяснить, почему я сделал именно так и никак иначе.

Для работы с токенами я выбрал библиотеку JJWT, хотя в принципе все реализации библиотек довольно похожи по своей функциональности. Также было решено не создавать сервер авторизации, а выдавать/обновлять/проверять токены непосредственно из приложения. Кстати немного о приложении, это одностраничное приложение (AngularJS) с RESTful Web-сервисом (Spring) в back-end.

Выдавать токены на долгий срок не хотелось, так как в случае с JWT права пользователя хранятся в токене, и изменения в правах пользователя не подействуют до повторной авторизации и получения нового токена. Можно конечно хранить в токене только идентификатор пользователя, а остальные данные читать из базы данных при каждом запросе, но это повлечет слишком большое количество лишних запросов к базе данных, поэтому от этого варианта я сразу отказался. Нужно было задуматься об обновлении короткоживущих токенов.

Для обновления access токена можно использовать refresh токен с более длительным временем до истечения, который получает новые данные пользователя по его идентификатору из базы данных и создает новый access токен на их основе. Но как быть с refresh токеном, если он также выдан на не очень долгое время и истечет во время сеанса пользователя? Повторный запрос авторизационных данных во время сеанса не очень хорошее решение в плане UX, а обновление истекшего токена плохо скажется на безопастности. Нужно было найти другое решение, но к этому вопросу я вернусь немного позже. Для начала нужно определиться с временем «жизни» для токенов и я остановился на 10 минутах для access токена и 60 минутах, с возможностью продления в перспективе, для refresh токена.

С хранением и обновлением токенов на стороне пользователя, тоже все неоднозначно. Обычно для их хранения используeтся локальное хранилище или cookies. У каждого из этих вариантов есть свои плюсы и минусы, каждый из них подвержен разного вида уязвимостям, но мой выбор остановился на втором варианте.

В случае с локальным хранилищем, обычно способом передачи токенов между back-end и front-end является добавление их в header или в тело запроса/ответа. То есть, мне пришлось бы вносить изминения и во front-end, для получения токенов, сохранения их в локальное хранилище, добавления к запросам, обновления и т.д., тогда как в случае с cookies их можно добавлять/изменять/удалять непосредственно из back-end.

Думаю, самое время перейти от теории к практике и показать, как это все реализовано у меня. Не хочу загружать статью лишним кодом, выкладывая все классы полностью, поэтому постараюсь выделить только самое важное. Если вас заинтересуют какие-либо подробности, которые остались «за кадром», спрашивайте, и я с радостью отвечу вам в комментариях или дополню статью.

Естественно, взаимодействие с приложением начинается с авторизации. Пользователь авторизуется с помощью метода в @RestController, в котором вызывается метод из TokenAuthenticationService для создания токенов и добавления их в ответ сервера в виде cookies (access_token и refresh_token).

@RequestMapping(value = "/login", produces = "application/json", method = RequestMethod.GET)

@ResponseStatus(value = HttpStatus.NO_CONTENT)

public void login(HttpServletResponse response) {

SessionUser user = (SessionUser) SecurityContextHolder.getContext().getAuthentication().getPrincipal();

tokenAuthenticationService.addAuthentication(response, user);

SecurityContextHolder.getContext().setAuthentication(null);

}SessionUser — реализация UserDetails*

Так выглядит этот метод в TokenAuthenticationService:

public void addAuthentication(HttpServletResponse response, SessionUser user) {

Cookie access = new Cookie("access_token", tokenHandler.createAccessToken(user));

access.setPath("/");

access.setHttpOnly(true);

response.addCookie(access);

Cookie refresh = new Cookie("refresh_token", tokenHandler.createRefreshToken(user));

refresh.setPath("/");

refresh.setHttpOnly(true);

response.addCookie(refresh);

}TokenHandler содержит стандартные методы для работы c JWT с использованием Jwts.builder() и Jwts.parser() из указанной выше библиотеки, поэтому не вижу смысла занимать место их кодом, но для ясности напишу что делает каждый из них:

public String createRefreshToken(SessionUser user) {

//возвращает токен, в котором хранится только username

}

public SessionUser parseRefreshToken(String token) {

//парсит username из токена и получает данные пользователя из реализации UserDetailsService

}

public String createAccessToken(SessionUser user) {

//возвращает токен, в котором хранятся все данные для воссоздания SessionUser

}

public SessionUser parseAccessToken(String token) {

//использует данные из токена для создания нового SessionUser

}UserDetailsService*

Теперь немного о том, как происходит обработка последующих запросов. В конфигурационном файле, наследованном от WebSecurityConfigurerAdapter, я добавил два известных вам bean-a:

@Bean

public TokenAuthenticationService tokenAuthenticationService() {

return new TokenAuthenticationService();

}

@Bean

public TokenHandler tokenHandler() {

return new TokenHandler();

}Запретил создание/использование сессий и добавил фильтр для аутентификации с помощью токенов:

@Override

protected void configure(HttpSecurity http) throws Exception {

http.authorizeRequests()

//Ресурсы доступные анонимным пользователям

.antMatchers("/", "/login").permitAll()

//Все остальные доступны только после аутентификации

.anyRequest().authenticated()

.and()

.sessionManagement().sessionCreationPolicy(SessionCreationPolicy.STATELESS)

.and()

.addFilterBefore(new StatelessAuthenticationFilter(tokenAuthenticationService()), UsernamePasswordAuthenticationFilter.class)

}При каждом запросе фильтр получает аутентификацию из токенов, обрабатывает запрос и обнуляет аутентификацию:

public class StatelessAuthenticationFilter extends GenericFilterBean {

private final TokenAuthenticationService tokenAuthenticationService;

public StatelessAuthenticationFilter(TokenAuthenticationService tokenAuthenticationService) {

this.tokenAuthenticationService= tokenAuthenticationService;

}

@Override

public void doFilter(ServletRequest request, ServletResponse response, FilterChain filterChain)

throws IOException, ServletException {

HttpServletRequest httpRequest = (HttpServletRequest) request;

HttpServletResponse httpResponse = (HttpServletResponse) response;

Authentication authentication = tokenAuthenticationService.getAuthentication(httpRequest, httpResponse);

SecurityContextHolder.getContext().setAuthentication(authentication);

filterChain.doFilter(request, response);

SecurityContextHolder.getContext().setAuthentication(null);

}

}Как происходит создание аутентификации:

— Присутствует access токен?За это отвечает еще один метод из уже известного вам TokenAuthenticationService:

— Нет? Отклонить запрос.

— Да?

— — Действительный и не истек?

— — Да? Разрешить запрос.

— — Нет? Попробовать получить новый access токен при помощи refresh токена.

— — — Получилось?

— — — Да? Разрешить запрос, и добавить новый access токен к ответу.

— — — Нет? Отклонить запрос.

public Authentication getAuthentication(HttpServletRequest request, HttpServletResponse response) {

Cookie[] cookies = request.getCookies();

String accessToken = null;

String refreshToken = null;

if (cookies != null) {

for (Cookie cookie : cookies) {

if (("access_token").equals(cookie.getName())) {

accessToken = cookie.getValue();

}

if (("refresh_token").equals(cookie.getName())) {

refreshToken = cookie.getValue();

}

}

}

if (accessToken != null && !accessToken.isEmpty()) {

try {

SessionUser user = tokenHandler.parseAccessToken(accessToken);

return new UserAuthentication(user);

} catch (ExpiredJwtException ex) {

if (refreshToken != null && !refreshToken.isEmpty()) {

try {

SessionUser user = tokenHandler.parseRefreshToken(refreshToken);

Cookie access = new Cookie("access_token", tokenHandler.createAccessToken(user));

access.setPath("/");

access.setHttpOnly(true);

response.addCookie(access);

return new UserAuthentication(user);

} catch (JwtException e) {

return null;

}

}

return null;

} catch (JwtException ex) {

return null;

}

}

return null;

} UserAuthentication — реализация Authentication*

Вот и все, что требуется для совместной работы Spring Security и JWT.

Но если вы не забыли, я собирался придумать что-то для продления refresh токенов. Как я уже говорил, я не хотел выдавать токены на долгий срок и в любом случае, это не спасло бы от истечения токена во время сеанса пользователя, будь это через час, день или месяц.

Первое, что пришло в голову, убрать из токена время истечения, а так как в моем случае cookies хранятся только до закрытия браузера, то токен бы просто удалялся и больше не использовался. Но здесь были свои «подводные камни», во первых в случае кражи токен мог бы использоваться неограниченное количество времени и не было бы возможности его отозвать, во вторых я хотел продлевать токен только для активного пользователя, а если пользователь просто оставит окно браузера открытым, то токен должен был истечь спустя некоторое время.

Чтобы обезопасить токен от кражи, нужно было реализовать возможность отзыва токена, поэтому я решил хранить все refresh токены в базе данных и перед выдачей новых access токенов, проверять наличие refresh токена в ней. Тогда в случае отзыва токена, достаточно удалить его из базы данных. Но это не решало моей проблемы с продлением токенов. И тогда я подумал, а что если хранить время до истечения токена не в самом токене, а в базе данных? И отодвигать это время на 60 минут вперед от каждого использования токена. Мне это показалось довольно не плохой идеей и я хотел бы поделиться с вами ее реализацией.

Я создал таблицу (refresh_token) в базе данных для хранения refresh токенов со следующими столбцами:

1. id (BIGINT)И создал класс RefreshTokenDao с двумя методами использующими JdbcTemplate для общения с этой таблицей:

2. username (VARCHAR)

3. token (VARCHAR)

4. expires (TIMESTAMP)

public void insert(String username, String token, long expires) {

String sql = "INSERT INTO refresh_token "

+ "(username, token, expires) VALUES (?, ?, ?)";

jdbcTemplate.update(sql, username, token, new Timestamp(expires));

}

public int updateIfNotExpired(String username, String token, long expiration) {

String sql = "UPDATE refresh_token "

+ "SET expires = ? "

+ "WHERE username = ? "

+ "AND token = ? "

+ "AND expires > ?";

Timestamp now = new Timestamp(System.currentTimeMillis());

Timestamp newExpirationTime = new Timestamp(now.getTime() + expiration);

return jdbcTemplate.update(sql, newExpirationTime, username, token, now);

}Методы довольно простые. Первый используется для добавления токена в базу данных при его создании. Второй для обновления токена, если он не истек и возвращения количества обновленных полей, в моем случае это количество всегда будет 0 или 1.

Используются они в классе TokenHandler. При создании токена (createRefreshToken()) я добавляю запись о нем с помощью метода insert(). А в случае когда мне нужно получить информацию из токена (parseRefreshToken()), я сначала пытаюсь вызвать updateIfNotExpired() и если в ответе получаю значение не равное 0, значит токен валиден и его дата обновилась, можно продолжать выполнение метода; а в случае, если возвращенное значение равно 0, из чего следует что токен не найден или истек, я просто выбрасываю исключение (new JwtException(«Token is expired or missing»)).

Это все что касалось продления refresh токенов. На просторах интернета я нигде не встречал такого способа (может плохо искал) и надеюсь что он будет кому-то полезен, как и вся статья в целом.

Спасибо за внимание!

|

Метки: author AnarSultanov java spring security jwt |

[Перевод] ggplot2: как легко совместить несколько графиков в одном, часть 2 |

ggplot2: как легко совместить несколько графиков в одном, часть 2

- Перевод

- Tutorial

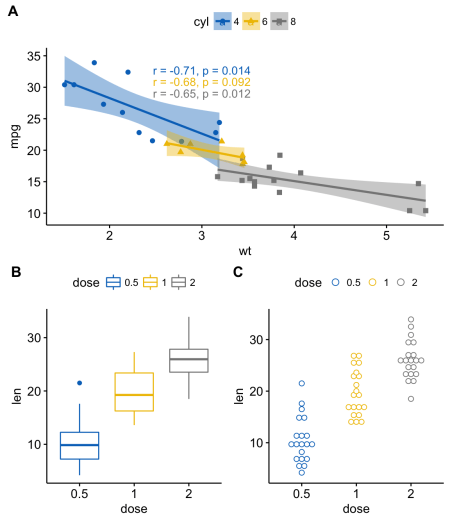

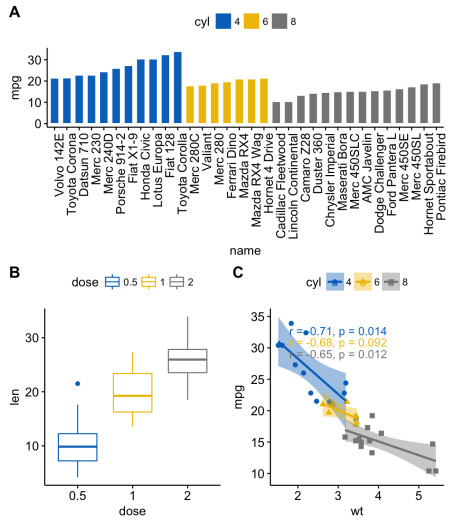

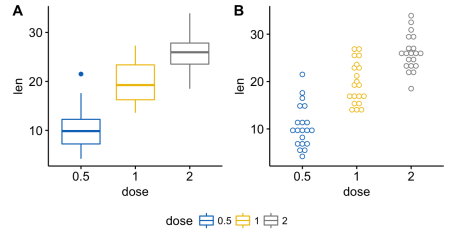

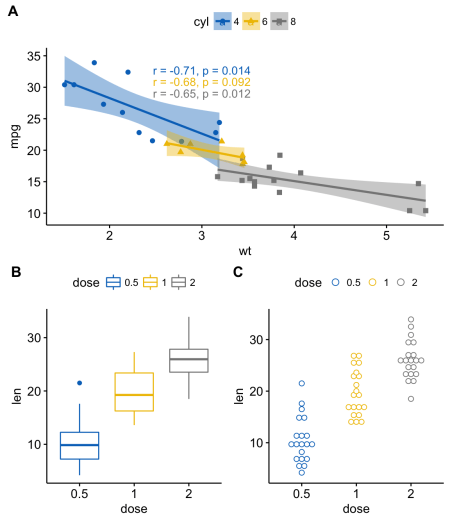

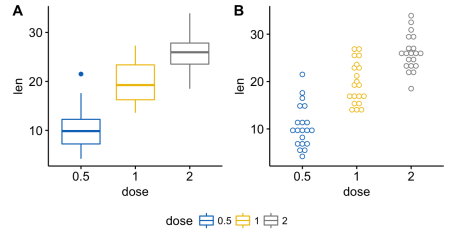

Изменение расположения по строкам или столбцам

Используем пакет ggpubr

Воспользуемся вложенными функциями

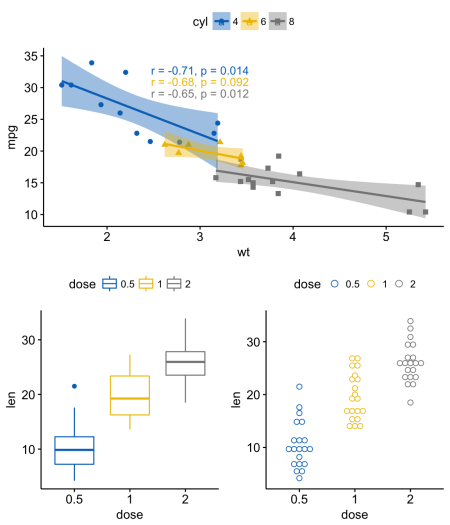

ggarrange() для изменения расположения графиков по строкам или столбцам.Например, код ниже делает следующее:

- диаграмма разброса (sp) будет находиться в первой строке и занимать две колонки

- диаграмма рассеивания (bxp) и точечная диаграмма (dp) будут занимать вторую строку и две разных колонки

ggarrange(sp, # Первая строка с диаграммой разброса

ggarrange(bxp, dp, ncol = 2, labels = c("B", "C")), # Вторая строка с диаграммой рассеивания и точечной диаграммой

nrow = 2,

labels = "A" # Метки диаграммы разброса

)

Используем пакет cowplot

Следующую комбинацию функций [из пакета cowplot] можно использовать, чтобы расположить графики в определенных местах заданного размера:

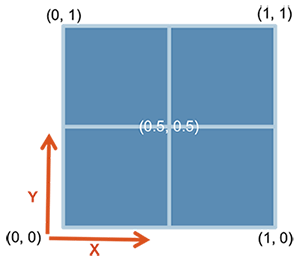

ggdraw() + draw_plot() + draw_plot_label().ggdraw(). Инициализируем пустое полотно:

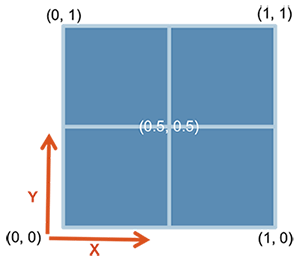

ggdraw()Обратите внимание, что по умолчанию координаты изменяются от 0 до 1, и точка (0, 0) находится в нижнем левом углу полотна (см. иллюстрацию ниже).

draw_plot(). Располагает график где-то на полотне:

draw_plot(plot, x = 0, y = 0, width = 1, height = 1)plot: график для размещения (ggplot2 или gtable)x, y: координаты x/y левого нижнего угла графикаwidth, height: ширина и высота графика

draw_plot_label(). Добавляет метку в правом верхнем углу графика

Может работать с векторами меток с ассоциированными координатами.

draw_plot_label(label, x = 0, y = 1, size = 16, ...)label: вектор метокx, y: вектор с х/у координатами каждой метки соответственноsize: размер шрифта метки

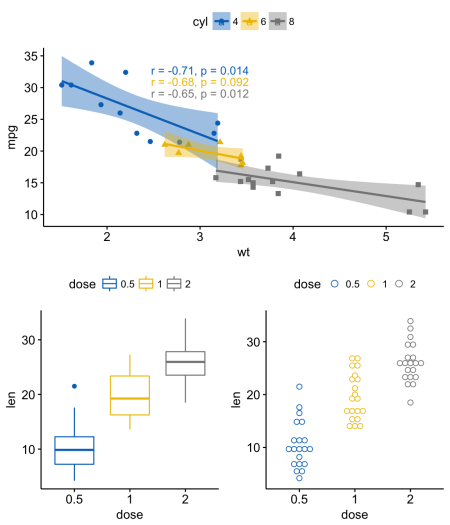

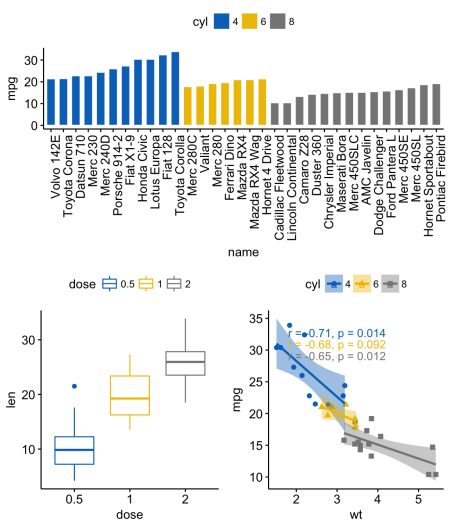

Например, так можно комбинировать несколько графиков разного размера с определенным расположением:

library("cowplot")

ggdraw() +

draw_plot(bxp, x = 0, y = .5, width = .5, height = .5) +

draw_plot(dp, x = .5, y = .5, width = .5, height = .5) +

draw_plot(bp, x = 0, y = 0, width = 1, height = 0.5) +

draw_plot_label(label = c("A", "B", "C"), size = 15,

x = c(0, 0.5, 0), y = c(1, 1, 0.5))

Используем пакет gridExtra

Функция

arrangeGrop() [в gridExtra] помогает изменить расположение графиков по строкам или столбцам.Например, код ниже делает следующее:

- диаграмма разброса (sp) будет находиться в первой строке и занимать две колонки

- диаграмма рассеивания (bxp) и точечная диаграмма (dp) будут занимать вторую строку и две разных колонки

library("gridExtra")

grid.arrange(sp, # Первая строка с одним графиком на две колонки

arrangeGrob(bxp, dp, ncol = 2),# Вторая строка с двумя графиками в двух колонках

nrow = 2) # Количество строк

В функции

grid.arrange() можно также использовать аргумент layout_matrix для создания сложного взаимного расположения графиков.В коде ниже

layout_matrix — матрица 2х2 (2 строки и 2 столбца). Первая строка — все единицы, там, где первый график, занимающий две колонки; вторая строка содержит графики 2 и 3, каждый из которых занимает свою колонку.grid.arrange(bp, # столбчатая диаграмма на две колонки

bxp, sp, # диаграммы рассеивания и разброса

ncol = 2, nrow = 2,

layout_matrix = rbind(c(1,1), c(2,3)))

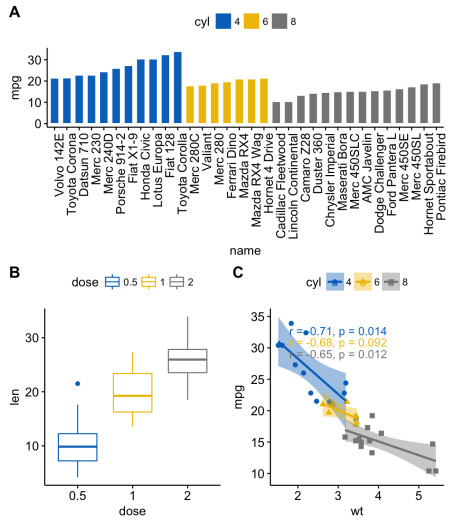

Также можно добавить аннотацию к выводу функции

grid.arrange(), используя вспомогательную функцию draw_plot_label() [в cowplot].Для того, чтобы легко добавлять аннотации к выводам функций

grid.arrange() или arrangeGrob() (тип gtable), сначала нужно преобразовать их в тип ggplot с помощью функции as_ggplot() [в ggpubr]. После можно применять к ним фунцию draw_plot_label() [в cowplot].library("gridExtra")

library("cowplot")

# Упорядочиваем графики с arrangeGrob

# возвращает тип gtable (gt)

gt <- arrangeGrob(bp, # столбчатая диаграмма на две колонки

bxp, sp, # диаграммы рассеивания и разброса

ncol = 2, nrow = 2,

layout_matrix = rbind(c(1,1), c(2,3)))

# Добавляем метки к упорядоченным графикам

p <- as_ggplot(gt) + # преобразуем в ggplot

draw_plot_label(label = c("A", "B", "C"), size = 15,

x = c(0, 0, 0.5), y = c(1, 0.5, 0.5)) # Добавляем метки

p

В коде выше мы использовали

arrangeGrob() вместо grid.arrange(). Основное отличие этих двух функций состоит в том, что grid.arrange() автоматически выводит упорядоченные графики. Поскольку мы хотели добавить аннотацию к графикам до того, как их нарисовать, предпочтительно в таком случае использовать функцию arrangeGrob().Используем пакет grid

Пакет grid позволяет задать сложное взаимное расположение графиков с помощью функции

grid.layout(). Он также предоставляет вспомогательную функцию viewport()для задания региона, или области видимости. Функция print() применяется для размещения графиков в заданном регионе.Шаги можно описать так:

- Создать графики: p1, p2, p3, ….

- Перейти на новую страницу с помощью функции

grid.newpage() - Создать расположение 2X2 — количество столбцов = 2; количество строк = 2

- Задать область видимости: прямоугольная область на графическом устройстве

- Напечатать график в области видимости

library(grid)

# Перейти на новую страницу

grid.newpage()

# Создать расположение: nrow = 3, ncol = 2

pushViewport(viewport(layout = grid.layout(nrow = 3, ncol = 2)))

# Вспомогательная функция для задания области в расположении

define_region <- function(row, col){

viewport(layout.pos.row = row, layout.pos.col = col)

}

# Упорядочить графики

print(sp, vp = define_region(row = 1, col = 1:2)) # Расположить в двух колонках

print(bxp, vp = define_region(row = 2, col = 1))

print(dp, vp = define_region(row = 2, col = 2))

print(bp + rremove("x.text"), vp = define_region(row = 3, col = 1:2))

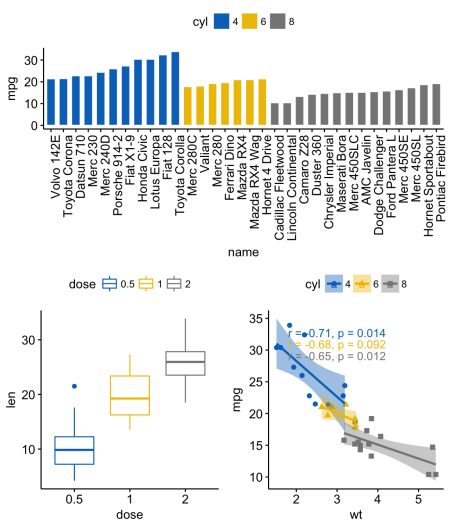

Использование общей легенды для совмещенных ggplot-графиков

Чтобы задать общую легенду для нескольких упорядоченных графиков, можно использовать функцию

ggarrange() [в ggpubr] с такими аргументами:common.legend = TRUE: сделать общую легендуlegend: задать положение легенды. Разрешенное значение — одно из c(“top”, “bottom”, “left”, “right”)

ggarrange(bxp, dp, labels = c("A", "B"),

common.legend = TRUE, legend = "bottom")

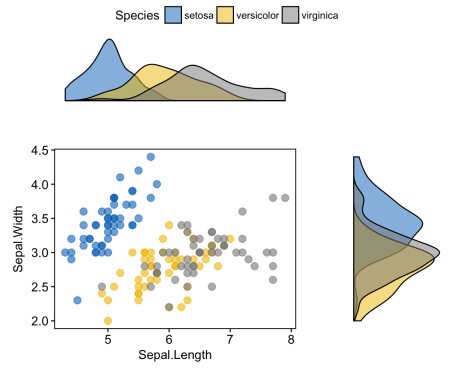

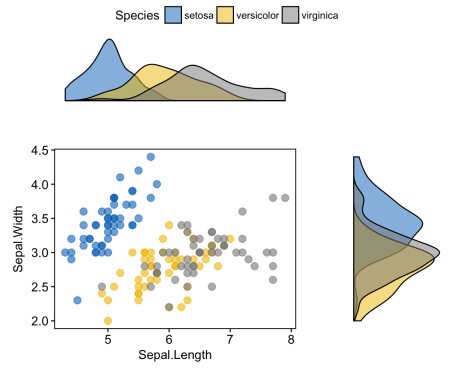

Диаграмма разброса с графиками плотности безусловного распределения

# Диаграмма разброса, цвет по группе ("Species")

sp <- ggscatter(iris, x = "Sepal.Length", y = "Sepal.Width",

color = "Species", palette = "jco",

size = 3, alpha = 0.6)+

border()

# График плотности безусловного распределения по x (панель сверху) и по y (панель справа)

xplot <- ggdensity(iris, "Sepal.Length", fill = "Species",

palette = "jco")

yplot <- ggdensity(iris, "Sepal.Width", fill = "Species",

palette = "jco")+

rotate()

# Почистить графики

yplot <- yplot + clean_theme()

xplot <- xplot + clean_theme()

# Упорядочить графики

ggarrange(xplot, NULL, sp, yplot,

ncol = 2, nrow = 2, align = "hv",

widths = c(2, 1), heights = c(1, 2),

common.legend = TRUE)

В следующей части:

- смешиваем таблицу, текст и ggplot2-графики

- добавляем графический элемент в ggplot (таблицу, диаграмму рассеивания, фоновое изображение)

- располагаем графики на нескольких страницах

- вложенное взаиморасположение

- экспорт графиков

|

Метки: author qc-enior визуализация данных визуализация ggplot2 |

[Перевод] ggplot2: как легко совместить несколько графиков в одном, часть 2 |

ggplot2: как легко совместить несколько графиков в одном, часть 2

- Перевод

- Tutorial

Изменение расположения по строкам или столбцам

Используем пакет ggpubr

Воспользуемся вложенными функциями

ggarrange() для изменения расположения графиков по строкам или столбцам.Например, код ниже делает следующее:

- диаграмма разброса (sp) будет находиться в первой строке и занимать две колонки

- диаграмма рассеивания (bxp) и точечная диаграмма (dp) будут занимать вторую строку и две разных колонки

ggarrange(sp, # Первая строка с диаграммой разброса

ggarrange(bxp, dp, ncol = 2, labels = c("B", "C")), # Вторая строка с диаграммой рассеивания и точечной диаграммой

nrow = 2,

labels = "A" # Метки диаграммы разброса

)

Используем пакет cowplot

Следующую комбинацию функций [из пакета cowplot] можно использовать, чтобы расположить графики в определенных местах заданного размера:

ggdraw() + draw_plot() + draw_plot_label().ggdraw(). Инициализируем пустое полотно:

ggdraw()Обратите внимание, что по умолчанию координаты изменяются от 0 до 1, и точка (0, 0) находится в нижнем левом углу полотна (см. иллюстрацию ниже).

draw_plot(). Располагает график где-то на полотне:

draw_plot(plot, x = 0, y = 0, width = 1, height = 1)plot: график для размещения (ggplot2 или gtable)x, y: координаты x/y левого нижнего угла графикаwidth, height: ширина и высота графика

draw_plot_label(). Добавляет метку в правом верхнем углу графика

Может работать с векторами меток с ассоциированными координатами.

draw_plot_label(label, x = 0, y = 1, size = 16, ...)label: вектор метокx, y: вектор с х/у координатами каждой метки соответственноsize: размер шрифта метки

Например, так можно комбинировать несколько графиков разного размера с определенным расположением:

library("cowplot")

ggdraw() +

draw_plot(bxp, x = 0, y = .5, width = .5, height = .5) +

draw_plot(dp, x = .5, y = .5, width = .5, height = .5) +

draw_plot(bp, x = 0, y = 0, width = 1, height = 0.5) +

draw_plot_label(label = c("A", "B", "C"), size = 15,

x = c(0, 0.5, 0), y = c(1, 1, 0.5))

Используем пакет gridExtra

Функция

arrangeGrop() [в gridExtra] помогает изменить расположение графиков по строкам или столбцам.Например, код ниже делает следующее:

- диаграмма разброса (sp) будет находиться в первой строке и занимать две колонки

- диаграмма рассеивания (bxp) и точечная диаграмма (dp) будут занимать вторую строку и две разных колонки

library("gridExtra")

grid.arrange(sp, # Первая строка с одним графиком на две колонки

arrangeGrob(bxp, dp, ncol = 2),# Вторая строка с двумя графиками в двух колонках

nrow = 2) # Количество строк

В функции

grid.arrange() можно также использовать аргумент layout_matrix для создания сложного взаимного расположения графиков.В коде ниже

layout_matrix — матрица 2х2 (2 строки и 2 столбца). Первая строка — все единицы, там, где первый график, занимающий две колонки; вторая строка содержит графики 2 и 3, каждый из которых занимает свою колонку.grid.arrange(bp, # столбчатая диаграмма на две колонки

bxp, sp, # диаграммы рассеивания и разброса

ncol = 2, nrow = 2,

layout_matrix = rbind(c(1,1), c(2,3)))

Также можно добавить аннотацию к выводу функции

grid.arrange(), используя вспомогательную функцию draw_plot_label() [в cowplot].Для того, чтобы легко добавлять аннотации к выводам функций

grid.arrange() или arrangeGrob() (тип gtable), сначала нужно преобразовать их в тип ggplot с помощью функции as_ggplot() [в ggpubr]. После можно применять к ним фунцию draw_plot_label() [в cowplot].library("gridExtra")

library("cowplot")

# Упорядочиваем графики с arrangeGrob

# возвращает тип gtable (gt)

gt <- arrangeGrob(bp, # столбчатая диаграмма на две колонки

bxp, sp, # диаграммы рассеивания и разброса

ncol = 2, nrow = 2,

layout_matrix = rbind(c(1,1), c(2,3)))

# Добавляем метки к упорядоченным графикам

p <- as_ggplot(gt) + # преобразуем в ggplot

draw_plot_label(label = c("A", "B", "C"), size = 15,

x = c(0, 0, 0.5), y = c(1, 0.5, 0.5)) # Добавляем метки

p

В коде выше мы использовали

arrangeGrob() вместо grid.arrange(). Основное отличие этих двух функций состоит в том, что grid.arrange() автоматически выводит упорядоченные графики. Поскольку мы хотели добавить аннотацию к графикам до того, как их нарисовать, предпочтительно в таком случае использовать функцию arrangeGrob().Используем пакет grid

Пакет grid позволяет задать сложное взаимное расположение графиков с помощью функции

grid.layout(). Он также предоставляет вспомогательную функцию viewport()для задания региона, или области видимости. Функция print() применяется для размещения графиков в заданном регионе.Шаги можно описать так:

- Создать графики: p1, p2, p3, ….

- Перейти на новую страницу с помощью функции

grid.newpage() - Создать расположение 2X2 — количество столбцов = 2; количество строк = 2

- Задать область видимости: прямоугольная область на графическом устройстве

- Напечатать график в области видимости

library(grid)

# Перейти на новую страницу

grid.newpage()

# Создать расположение: nrow = 3, ncol = 2

pushViewport(viewport(layout = grid.layout(nrow = 3, ncol = 2)))

# Вспомогательная функция для задания области в расположении

define_region <- function(row, col){

viewport(layout.pos.row = row, layout.pos.col = col)

}

# Упорядочить графики

print(sp, vp = define_region(row = 1, col = 1:2)) # Расположить в двух колонках

print(bxp, vp = define_region(row = 2, col = 1))

print(dp, vp = define_region(row = 2, col = 2))

print(bp + rremove("x.text"), vp = define_region(row = 3, col = 1:2))

Использование общей легенды для совмещенных ggplot-графиков

Чтобы задать общую легенду для нескольких упорядоченных графиков, можно использовать функцию

ggarrange() [в ggpubr] с такими аргументами:common.legend = TRUE: сделать общую легендуlegend: задать положение легенды. Разрешенное значение — одно из c(“top”, “bottom”, “left”, “right”)

ggarrange(bxp, dp, labels = c("A", "B"),

common.legend = TRUE, legend = "bottom")

Диаграмма разброса с графиками плотности безусловного распределения

# Диаграмма разброса, цвет по группе ("Species")

sp <- ggscatter(iris, x = "Sepal.Length", y = "Sepal.Width",

color = "Species", palette = "jco",

size = 3, alpha = 0.6)+

border()

# График плотности безусловного распределения по x (панель сверху) и по y (панель справа)

xplot <- ggdensity(iris, "Sepal.Length", fill = "Species",

palette = "jco")

yplot <- ggdensity(iris, "Sepal.Width", fill = "Species",

palette = "jco")+

rotate()

# Почистить графики

yplot <- yplot + clean_theme()

xplot <- xplot + clean_theme()

# Упорядочить графики

ggarrange(xplot, NULL, sp, yplot,

ncol = 2, nrow = 2, align = "hv",

widths = c(2, 1), heights = c(1, 2),

common.legend = TRUE)

В следующей части:

- смешиваем таблицу, текст и ggplot2-графики

- добавляем графический элемент в ggplot (таблицу, диаграмму рассеивания, фоновое изображение)

- располагаем графики на нескольких страницах

- вложенное взаиморасположение

- экспорт графиков

|

Метки: author qc-enior визуализация данных визуализация ggplot2 |

Открытые проблемы в области распознавания речи. Лекция в Яндексе |

Открытые проблемы в области распознавания речи. Лекция в Яндексе

— Сегодня я расскажу об открытых проблемах в области речевых технологий. Но прежде всего давайте поймем, что речевые технологии стали неотъемлемой частью нашей жизни. Идем ли мы по улице или едем в автомобиле — когда хочется нам задать тот или иной запрос в поисковую систему, естественно сделать это голосом, а не печатать или еще что-либо.

Сегодня я поговорю в основном о распознавании речи, хотя есть множество других интересных задач. Рассказ мой будет состоять из трех частей. Для начала напомню в целом, как работает распознавание речи. Дальше расскажу, как люди стараются его улучшить и о том, какие в Яндексе стоят задачи, с которыми обычно не сталкиваются в научных статьях.

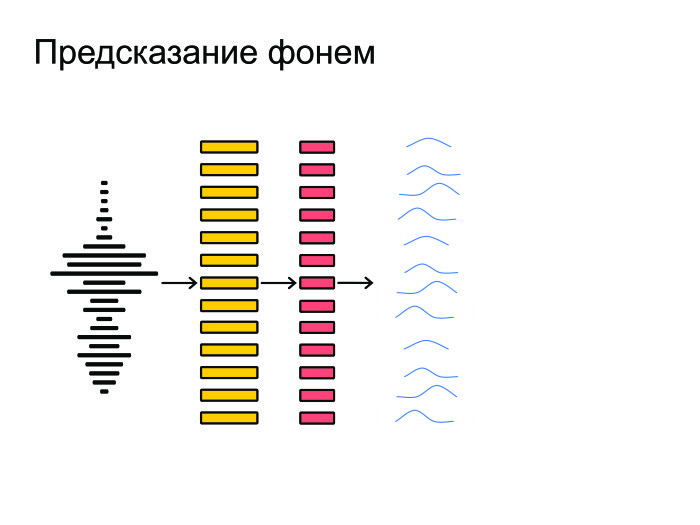

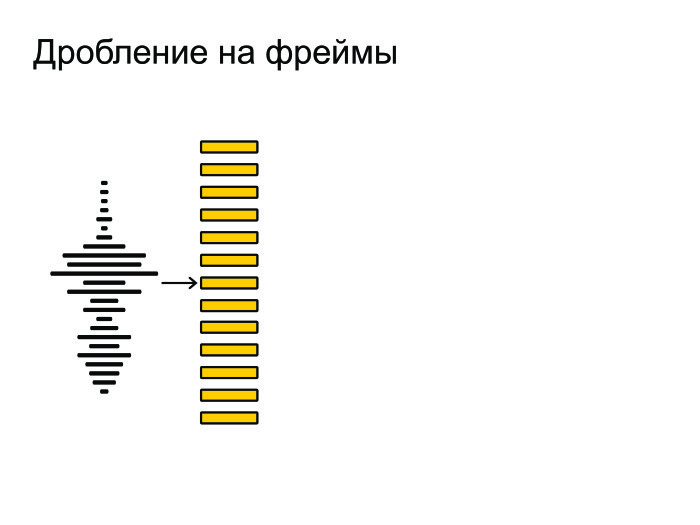

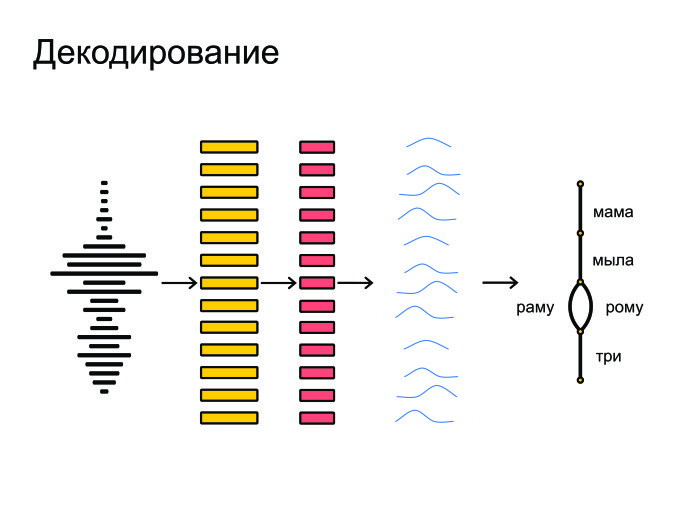

Общая схема распознавания речи. Изначально на вход нам поступает звуковая волна.

Ее мы дробим на маленькие кусочки, фреймы. Длина фрейма — обычно 25 мс, шаг — 10 мс. Они идут с некоторым захлестом.

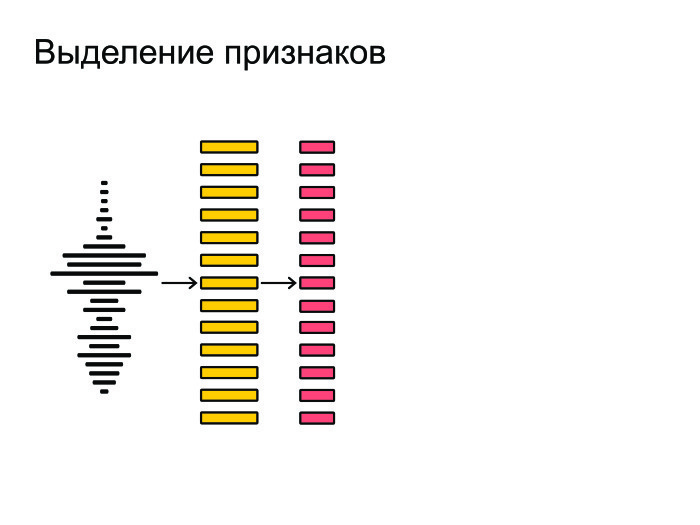

После этого из фреймов мы извлекаем наиболее важные признаки. Допустим, нам не важен тембр голоса или пол человека. Мы хотим распознавать речь вне зависимости от этих факторов, так что мы извлекаем самые важные признаки.

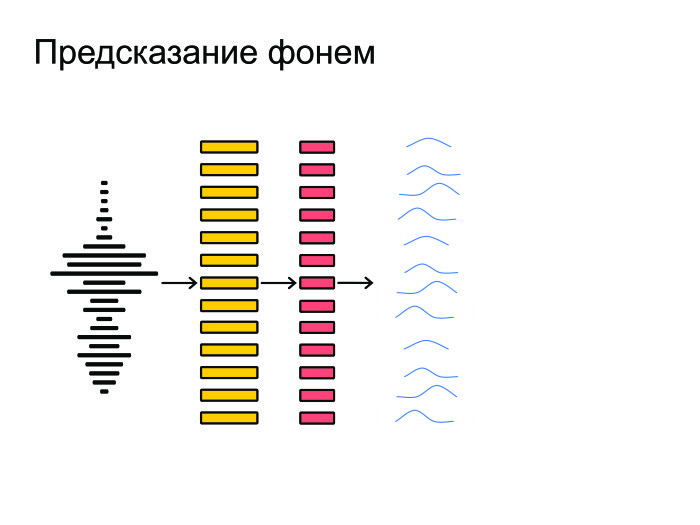

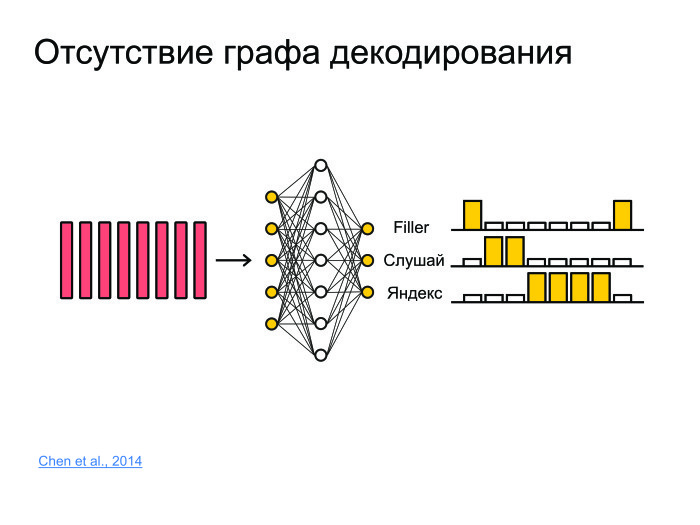

Затем нейронная сеть натравливается на все это и выдает на каждом фрейме предсказание, распределение вероятностей по фонемам. Нейронка старается угадать, какая именно фонема была сказана на том или ином фрейме.

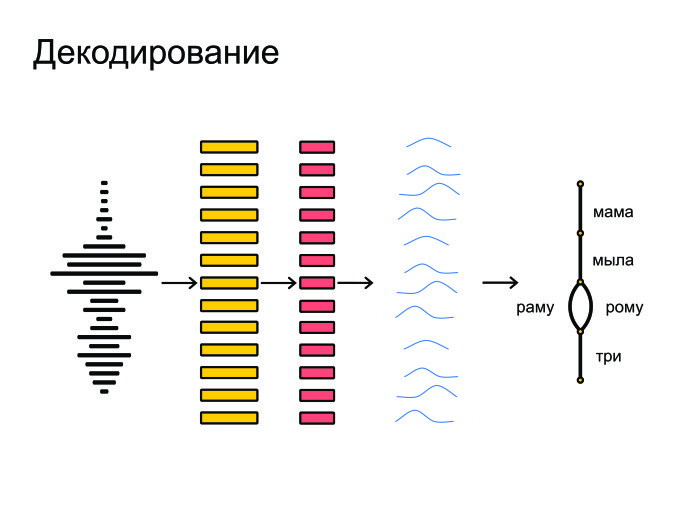

Под конец все это запихивается в граф-декодирование, которое получает распределение вероятностей и учитывает языковую модель. Допустим, «Мама мыла раму» — более популярная фраза в русском языке, чем «Мама мыла Рому». Также учитывается произношение слов и выдаются итоговые гипотезы.

В целом, именно так и происходит распознавание речи.

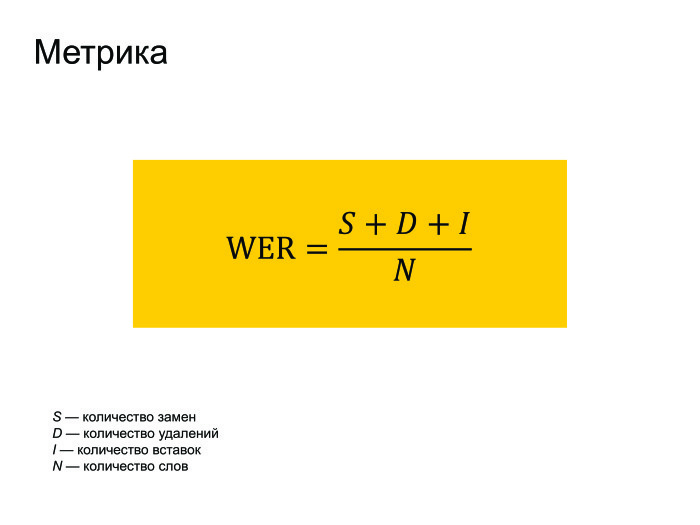

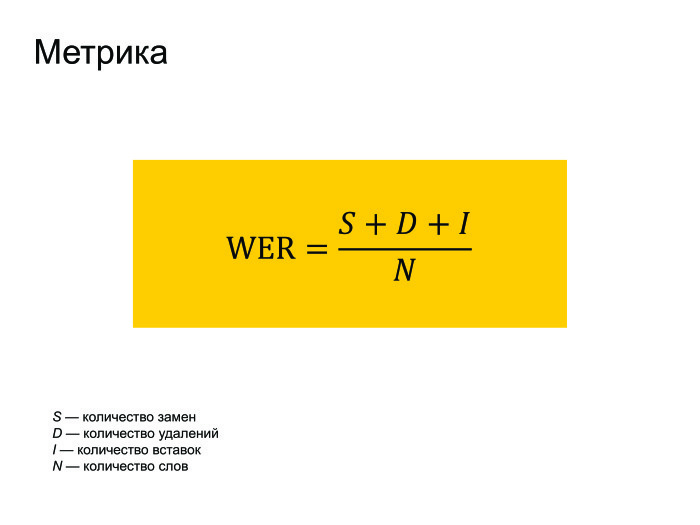

Естественно, о метрике нужно пару слов сказать. Все используют метрику WER в распознавании речи. Она переводится как World Error Rate. Это просто расстояние по Левенштейну от того, что мы распознали, до того, что реально было сказано в фразе, поделить на количество слов, реально сказанных во фразе.

Можно заметить, что если у нас было много вставок, то ошибка WER может получиться больше единицы. Но никто на это не обращает внимания, и все работают с такой метрикой.

Как мы будем это улучшать? Я выделил четыре основных подхода, которые пересекаются друг с другом, но на это не стоит обращать внимания. Основные подходы следующие: улучшим архитектуру нейронных сетей, попробуем изменить Loss-функцию, почему бы не использовать подходы End to end, модные в последнее время. И в заключение расскажу про другие задачи, для которых, допустим, не нужно декодирование.

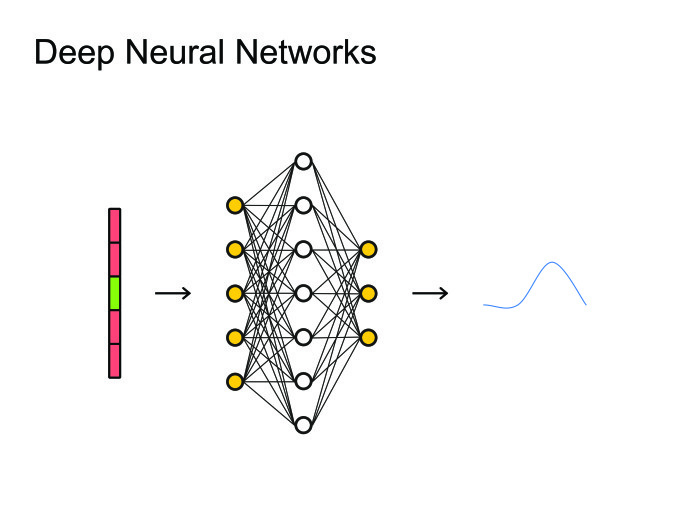

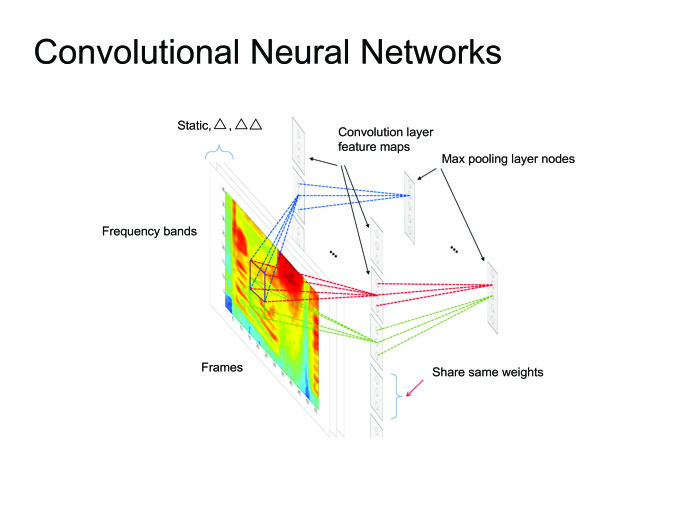

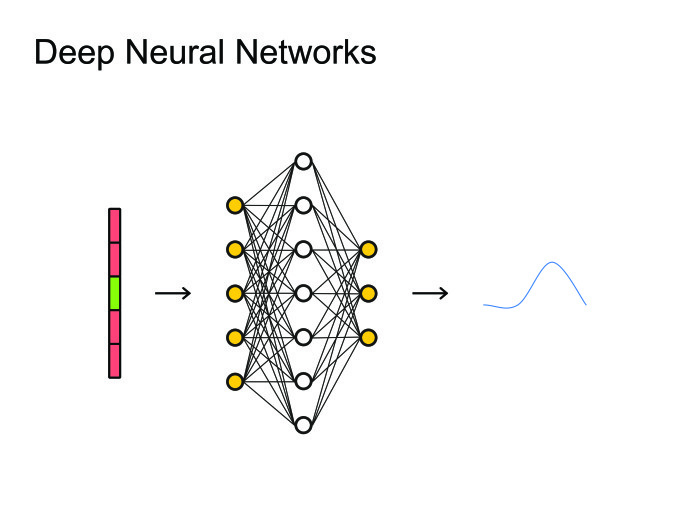

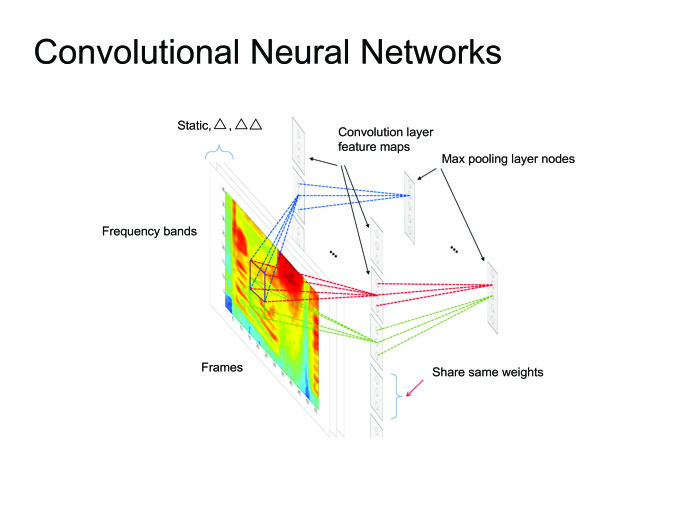

Когда люди придумали использовать нейронные сети, естественным решением было использовать самое простое: нейронные сетки feed forward. Берем фрейм, контекст, сколько-то фреймов слева, сколько-то справа, и предсказываем, какая фонема была сказана на данном фрейме. После чего можно посмотреть на все это как на картинку и применить всю артиллерию, уже использованную для обработки изображений, всевозможные сверточные нейронные сети.

Вообще многие статьи state of the art получены именно с помощью сверточных нейронных сетей, но сегодня я расскажу больше о рекуррентных нейронных сетях.

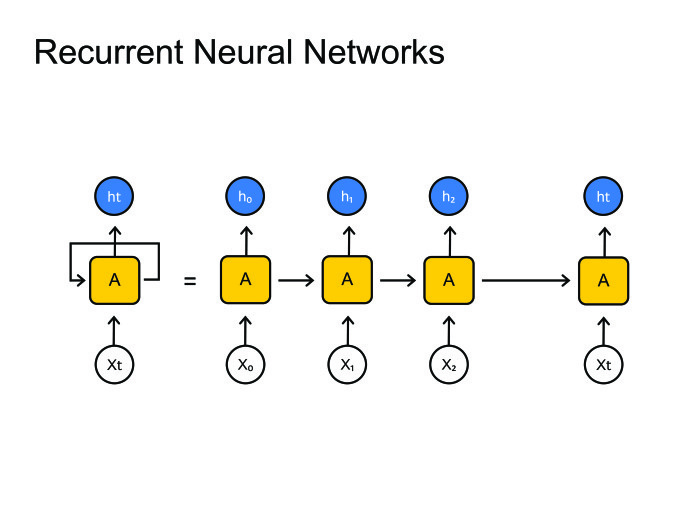

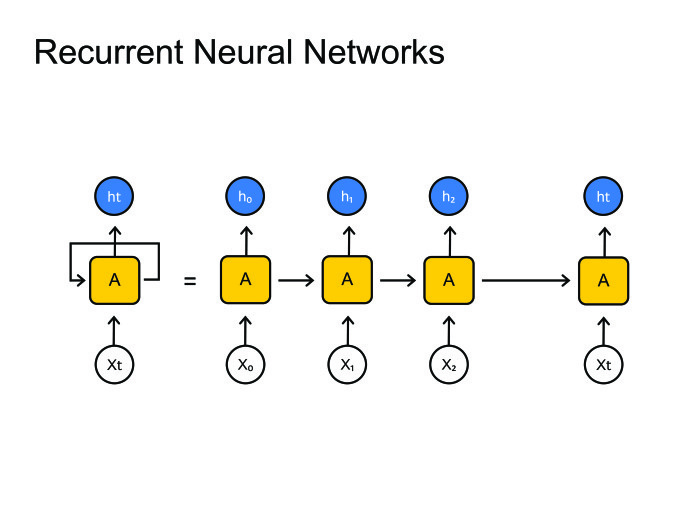

Рекуррентные нейронные сети. Все знают, как они работают. Но возникает большая проблема: обычно фреймов намного больше, чем фонем. На одну фонему приходится 10, а то и 20 фреймов. С этим нужно как-то бороться. Обычно это зашивается в граф-декодирование, где мы остаемся в одном состоянии много шагов. В принципе, с этим можно как-то бороться, есть парадигма encoder-decoder. Давайте сделаем две рекуррентных нейронных сетки: одна будет кодировать всю информацию и выдавать скрытое состояние, а декодер будет брать это состояние и выдавать последовательность фонем, букв или, может быть, слов — это как вы натренируете нейронную сеть.

Обычно в распознавании речи мы работаем с очень большими последовательностями. Там спокойно бывает 1000 фреймов, которые нужно закодировать одним скрытым состоянием. Это нереально, ни одна нейронная сеть с этим не справится. Давайте использовать другие методы.

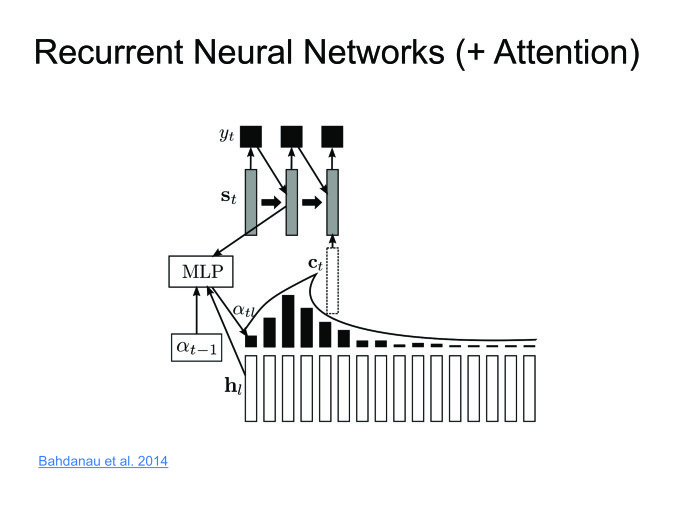

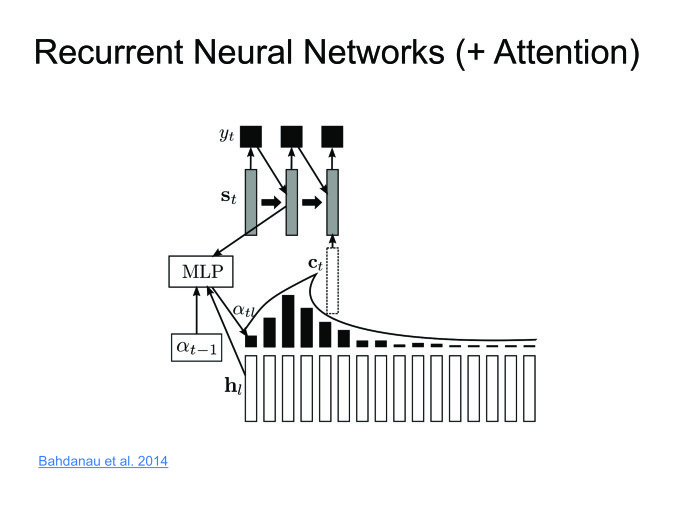

Димой Богдановым, выпускником ШАД, был придуман метод Attention. Давайте encoder будет выдавать скрытые состояния, и мы их не будем выкидывать, а оставим только последнее. Возьмем взвешенную сумму на каждом шаге. Декодер будет брать взвешенную сумму скрытых состояний. Таким образом, мы будем сохранять контекст, то, на что мы в конкретном случае смотрим.

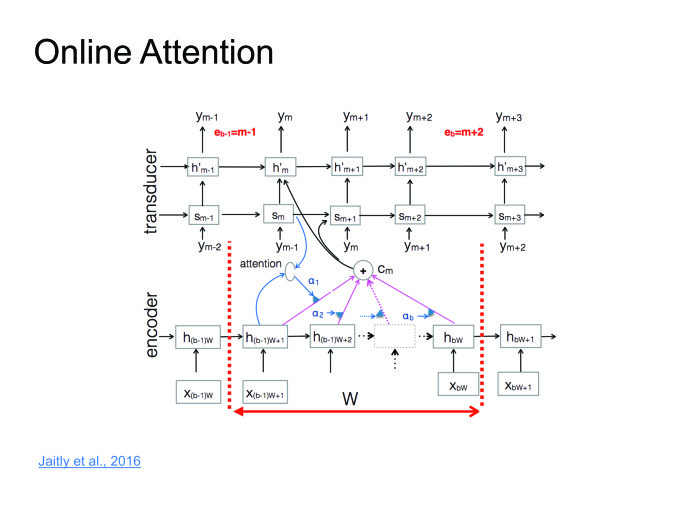

Подход прекрасный, работает хорошо, на некоторых датасетах дает результаты state of the art, но есть один большой минус. Мы хотим распознавать речь в онлайне: человек сказал 10-секундную фразу, и мы сразу ему выдали результат. Но Attention требует знать фразу целиком, в этом его большая проблема. Человек скажет 10-секундную фразу, 10 секунд мы ее будем распознавать. За это время он удалит приложение и никогда больше не установит. Нужно с этим бороться. Совсем недавно с этим поборолись в одной из статей. Я назвал это online attention.

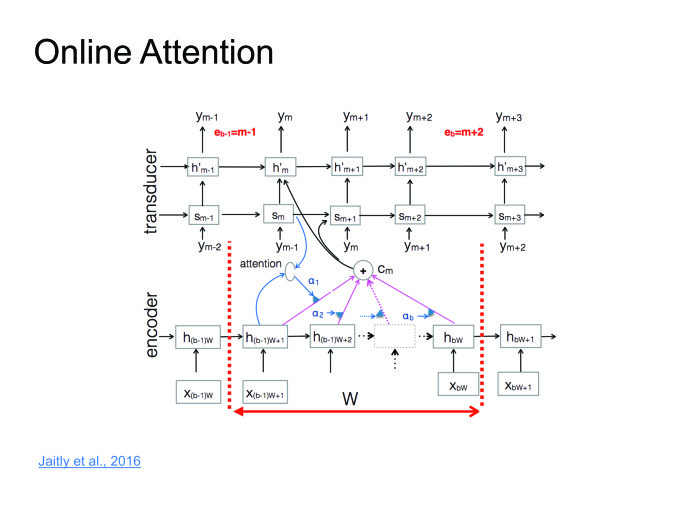

Давайте поделим входную последовательность на блоки какой-то небольшой фиксированной длины, внутри каждого блока устроим Attention, затем будет декодер, который выдает на каждом блоке соответствующие символы, после чего в какой-то момент выдает символ end of block, перемещается к следующему блоку, поскольку мы тут исчерпали всю информацию.

Тут можно серию лекций прочитать, я постараюсь просто сформулировать идею.

Когда начали тренировать нейронные сети для распознавания речи, старались угадывать фонему. Для этого использовали обычную кросс-энтропийную функцию потерь. Проблема в том, что даже если мы соптимизируем кросс-энтропию, это еще не будет значить, что мы хорошо соптимизировали WER, потому что у этих метрик корреляция не 100%.

Чтобы с этим побороться, были придуманы функции Sequence Based Loss: давайте саккумулируем всю информацию на всех фреймах, посчитаем один общий Loss и пропустим градиент обратно. Не буду вдаваться в детали, можете прочитать про CTC или SNBR Loss, это очень специфичная тема для распознавания речи.

В подходах End to end два пути. Первый — делать более «сырые» фичи. У нас был момент, когда мы извлекали из фреймов фичи, и обычно они извлекаются, стараясь эмулировать ухо человека. А зачем эмулировать ухо человека? Пусть нейронка сама научится и поймет, какие фичи ей полезны, а какие бесполезны. Давайте в нейронку подавать все более сырые фичи.

Второй подход. Мы пользователям выдаем слова, буквенное представление. Так зачем нам предсказывать фонемы? Хотя их предсказывать очень естественно, человек говорит в фонемах, а не буквах, — но итоговый результат мы должны выдать именно в буквах. Поэтому давайте предсказывать буквы, слоги или пары символов.

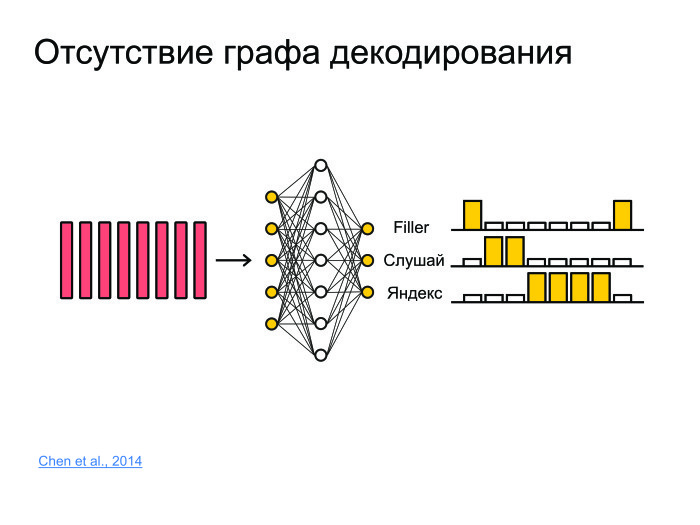

Какие еще есть задачи? Допустим, задача фреймспоттинга. Есть какой-нибудь кусок звука, откуда надо извлечь информацию о том, была ли сказана фраза «Слушай, Яндекс» или не была. Для этого можно фразу распознать и грепнуть «Слушай, Яндекс», но это очень брутфорсный подход, причем распознавание обычно работает на серверах, модели очень большие. Обычно звук отсылается на сервер, распознается, и распознанная форма высылается обратно. Грузить 100 тыс. юзеров каждую секунду, слать звук на сервер — ни одни сервера не выдержат.

Надо придумать решение, которое будет маленьким, сможет работать на телефоне и не будет жрать батарейку. И будет обладать хорошим качеством.

Для этого давайте всё запихнем в нейронную сеть. Она просто будет предсказывать, к примеру, не фонемы и не буквы, а целые слова. И сделаем просто три класса. Сеть будет предсказывать слова «слушай» и «Яндекс», а все остальные слова замапим в филлер.

Таким образом, если в какой-то момент сначала шли большие вероятности для «слушай», потом большие вероятности для «Яндекс», то с большой вероятностью тут была ключевая фраза «Слушай, Яндекс».

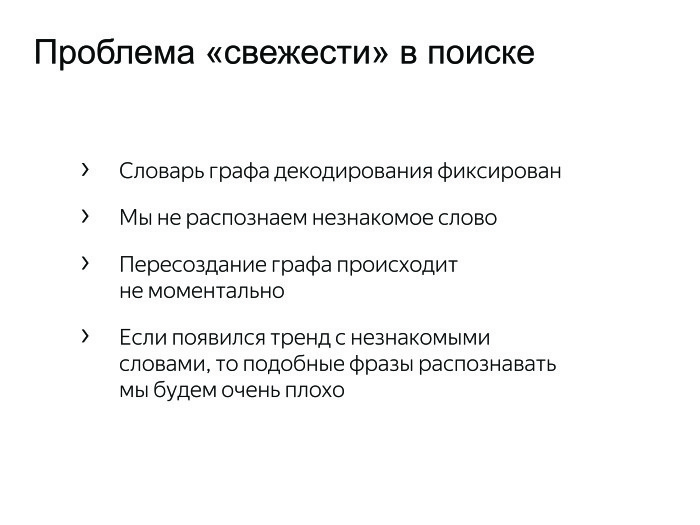

Задача, которая не сильно исследуется в статьях. Обычно, когда пишутся статьи, берется какой-то датасет, на нем получаются хорошие результаты, бьется state of the art — ура, печатаем статью. Проблема этого подхода в том, что многие датасеты не меняются в течение 10, а то и 20 лет. И они не сталкиваются с проблемами, с которыми сталкиваемся мы.

Иногда возникают тренды, хочется распознавать, и если этого слова нет в нашем графе декодирования в стандартном подходе, то мы никогда его не распознаем. Нужно с этим бороться. Мы можем взять и переварить граф декодирования, но это трудозатратный процесс. Может, утром одни трендовые слова, а вечером другие. Держать утренний и вечерний граф? Это очень странно.

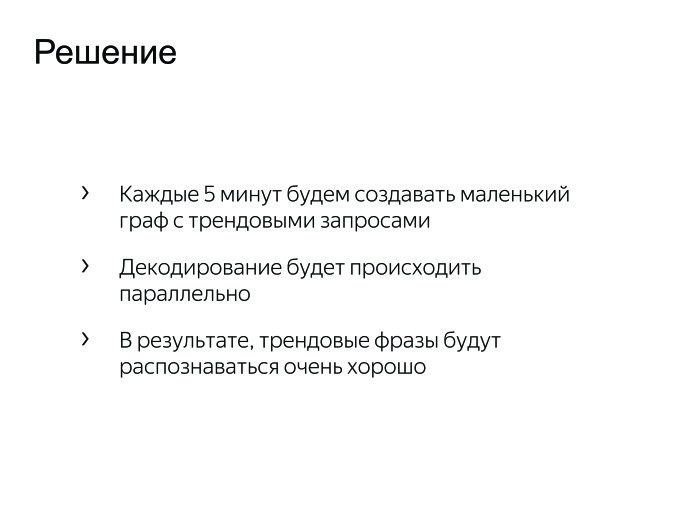

Был придуман простой подход: давайте к большому графу декодирования добавим маленький граф декодирования, который будет пересоздаваться каждые пять минут из тысячи самых лучших и трендовых фраз. Мы просто будем параллельно декодировать по этим двум графам и выбирать наилучшую гипотезу.

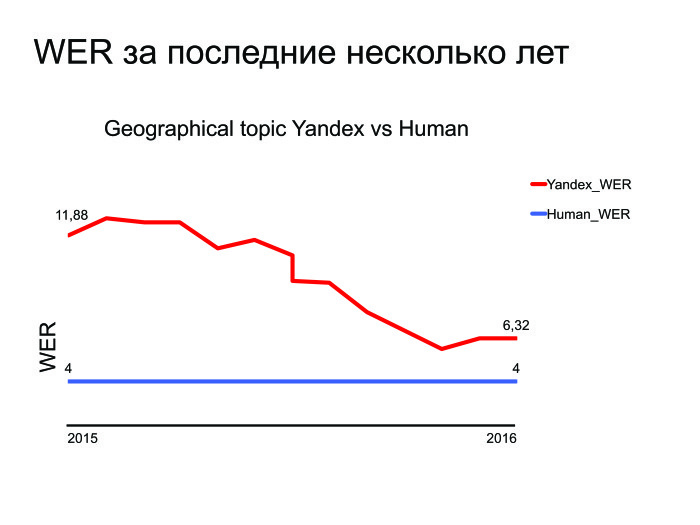

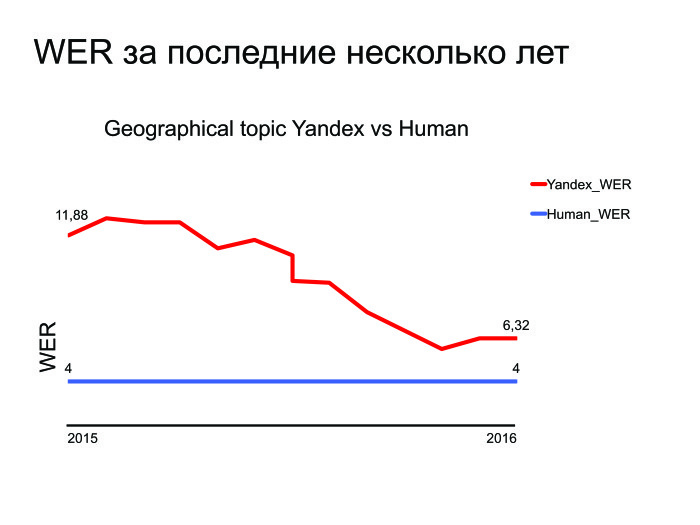

Какие задачи остались? Там state of the art побили, тут задачи решили… Приведу график WER за последние несколько лет.

Как видите, Яндекс улучшился за последние несколько лет, и тут приводится график для лучшей тематики — геопоиска. Вы можете понять, что мы стараемся и улучшаемся, но есть тот маленький разрыв, который нужно побить. И даже если мы сделаем распознавание речи — а мы его сделаем, — которое сравнится со способностями человека, то возникнет другая задача: это сделалось на сервере, но давайте перенесем это на устройство. Речь идет об отдельной, сложной и интересной задаче.

У нас есть и множество других задач, о которых меня можно спросить. Спасибо за внимание.

|

|

Открытые проблемы в области распознавания речи. Лекция в Яндексе |

Открытые проблемы в области распознавания речи. Лекция в Яндексе

— Сегодня я расскажу об открытых проблемах в области речевых технологий. Но прежде всего давайте поймем, что речевые технологии стали неотъемлемой частью нашей жизни. Идем ли мы по улице или едем в автомобиле — когда хочется нам задать тот или иной запрос в поисковую систему, естественно сделать это голосом, а не печатать или еще что-либо.

Сегодня я поговорю в основном о распознавании речи, хотя есть множество других интересных задач. Рассказ мой будет состоять из трех частей. Для начала напомню в целом, как работает распознавание речи. Дальше расскажу, как люди стараются его улучшить и о том, какие в Яндексе стоят задачи, с которыми обычно не сталкиваются в научных статьях.

Общая схема распознавания речи. Изначально на вход нам поступает звуковая волна.

Ее мы дробим на маленькие кусочки, фреймы. Длина фрейма — обычно 25 мс, шаг — 10 мс. Они идут с некоторым захлестом.

После этого из фреймов мы извлекаем наиболее важные признаки. Допустим, нам не важен тембр голоса или пол человека. Мы хотим распознавать речь вне зависимости от этих факторов, так что мы извлекаем самые важные признаки.

Затем нейронная сеть натравливается на все это и выдает на каждом фрейме предсказание, распределение вероятностей по фонемам. Нейронка старается угадать, какая именно фонема была сказана на том или ином фрейме.