Пишем XGBoost с нуля — часть 2: градиентый бустинг |

Всем привет!

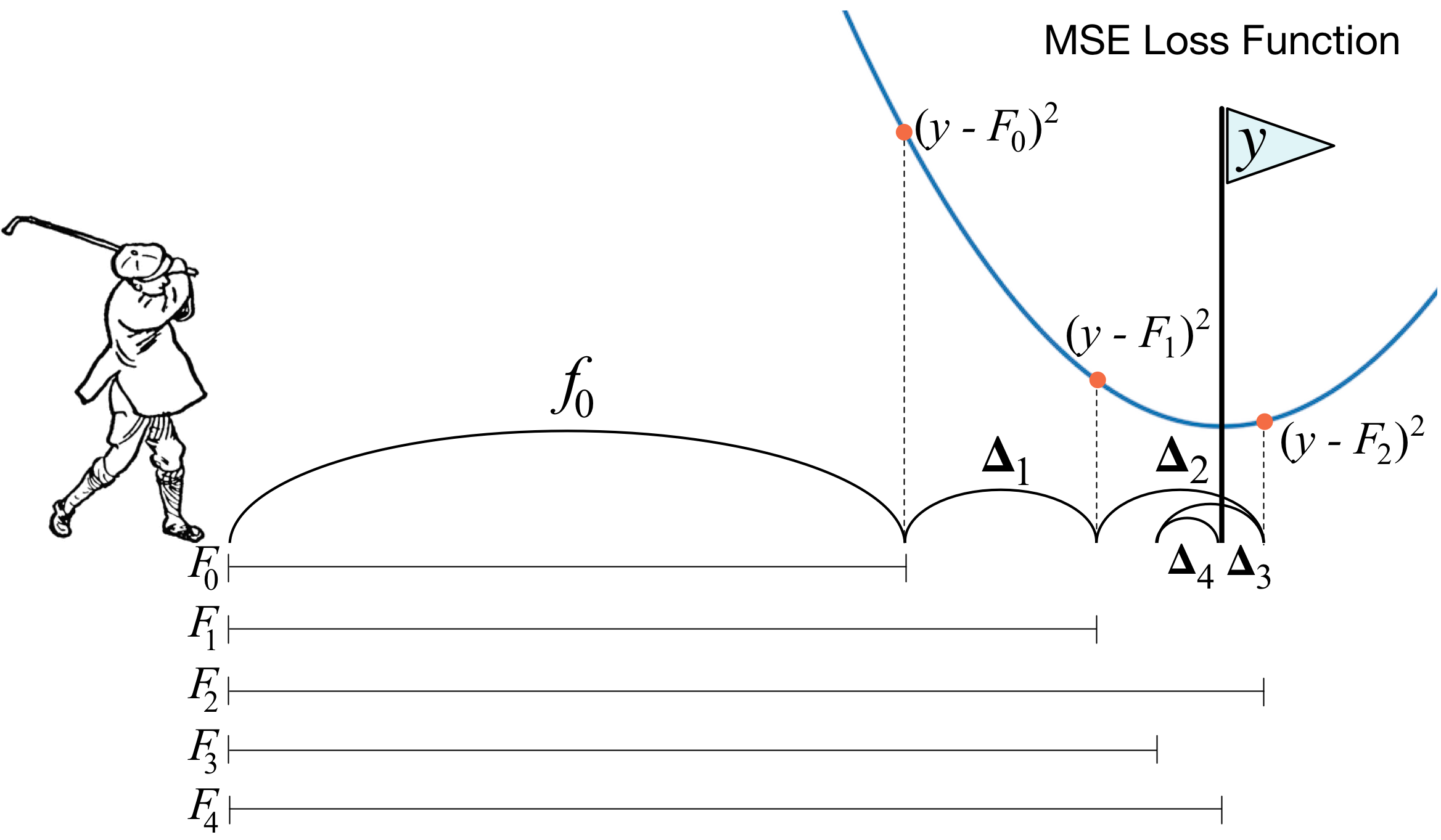

В прошлой статье мы разбирались, как устроены решающие деревья, и с нуля реализовали

алгоритм построения, попутно оптимизируя и улучшая его. В этой статье мы реализуем алгоритм градиентого бустинга и в конце создадим свой собственный XGBoost. Повествование будет идти по той же схеме: пишем алгоритм, описываем его, в заверешение подводим итоги, сравнивая результаты работы с аналогами из Sklearn'а.

В этой статье упор тоже будет сделан на реализацию в коде, поэтому всю теорию лучше почитать в другом вместе (например, в курсе ODS), и уже со знанием теории можно переходить к этой статье, так как тема достаточно сложная.

Итак, поехали!

https://habr.com/ru/post/438562/?utm_source=habrahabr&utm_medium=rss&utm_campaign=438562

| Комментировать | « Пред. запись — К дневнику — След. запись » | Страницы: [1] [Новые] |